1. 首先,下载IKAnalyzer ,下载

2. 将ik的相关文件 拷贝到 webapps\solr\WEB-INF\lib 目录下

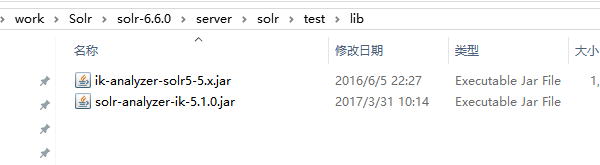

或者存放solr-6.6.0\server\solr\test\lib下面,就是在核test下面建立lib文件夹,把对应组件放在lib下面

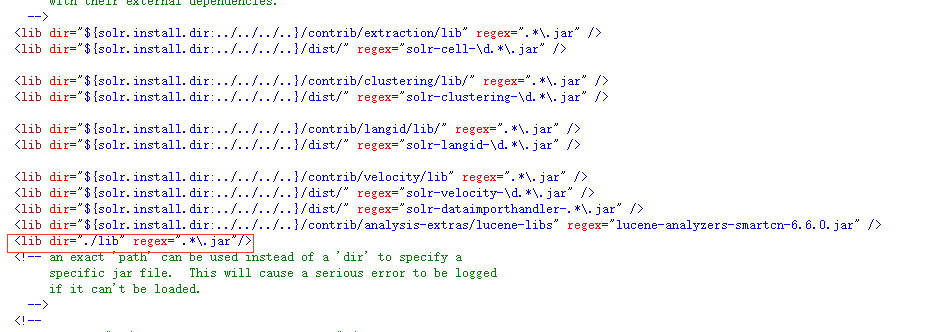

修改solrconfig.xml,增加如下:

<lib dir="./lib" regex=".*\.jar"/>

3. 在 solr-6.6.0\server\solr\test\conf\managed-schema增加如下配置

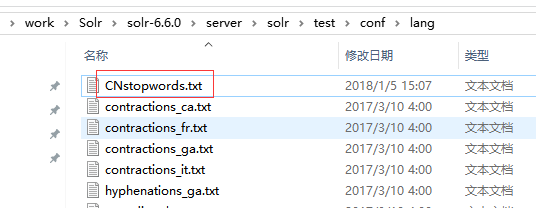

<fieldType name="text_ik" class="solr.TextField"> <analyzer type="index" > <tokenizer class="org.wltea.analyzer.lucene.IKTokenizerFactory" useSmart="false" conf="ik.conf"/> <filter class="solr.StopFilterFactory" ignoreCase="true" words="lang/CNstopwords.txt" /> </analyzer> <analyzer type="query"> <tokenizer class="org.wltea.analyzer.lucene.IKTokenizerFactory" useSmart="false" conf="ik.conf"/> <filter class="solr.StopFilterFactory" ignoreCase="true" words="lang/CNstopwords.txt" /> </analyzer> </fieldType>

CNstopwords.txt为通用词文件

或

<!-- 我添加的IK分词 --> <fieldType name="text_ik" class="solr.TextField"> <analyzer type="index" isMaxWordLength="false" class="org.wltea.analyzer.lucene.IKAnalyzer"/> <analyzer type="query" isMaxWordLength="true" class="org.wltea.analyzer.lucene.IKAnalyzer"/> </fieldType>

同时,把需要分词的字段,设置为text_ik,

<field name="pathsummary" type="text_ik" indexed="true" stored="true" multiValued="false" /> <field name="attr_content" type="text_ik" indexed="true" stored="true" multiValued="false" />

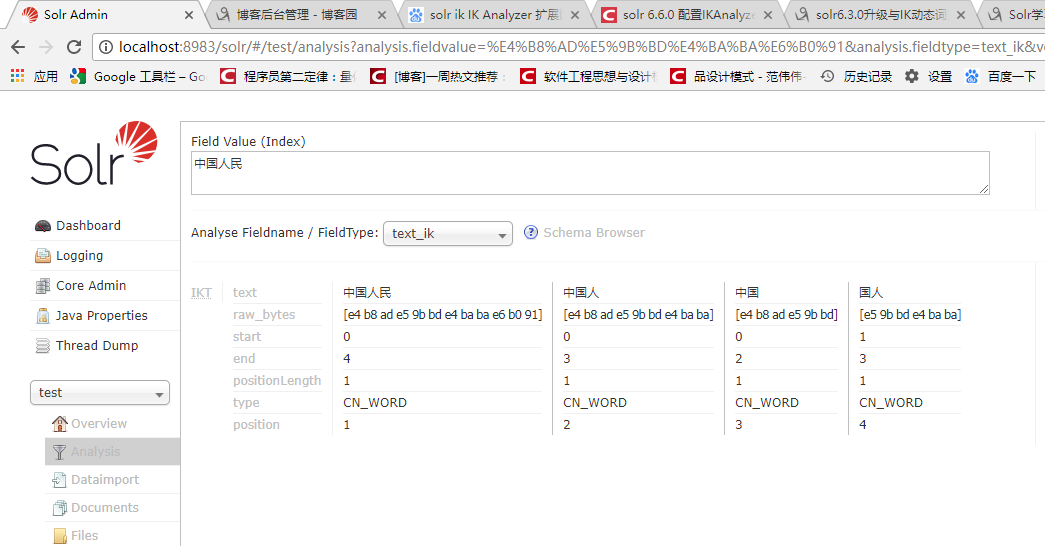

4、在admin后台, analysis 下查看分词效果

本文档详细介绍了如何在Solr中配置IKAnalyzer进行中文分词,包括下载IKAnalyzer、配置相关文件路径、修改solrconfig.xml及managed-schema文件等步骤。

本文档详细介绍了如何在Solr中配置IKAnalyzer进行中文分词,包括下载IKAnalyzer、配置相关文件路径、修改solrconfig.xml及managed-schema文件等步骤。

8154

8154

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?