Runtime

1.定义:代表java程序的运行环境

2. 每个java程序都有一个与之对应的Runtime实例,应用程序通过该对象与其运行时环境相连

3.应该程序不能创建自己的Runtime实例,但可以通过getRuntime方法获取与之相关联的Runtime对象

测试:

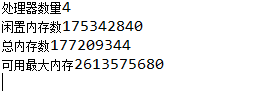

package com.oracle.demo; public class RuntimeTest { public static void main(String[] args) { Runtime rt=Runtime.getRuntime(); System.out.println("处理器数量"+rt.availableProcessors()); System.out.println("闲置内存数"+rt.freeMemory()); System.out.println("总内存数"+rt.totalMemory()); System.out.println("可用最大内存"+rt.maxMemory()); } }

测试结果:

四:exec方法启动一个进程执行操作系统

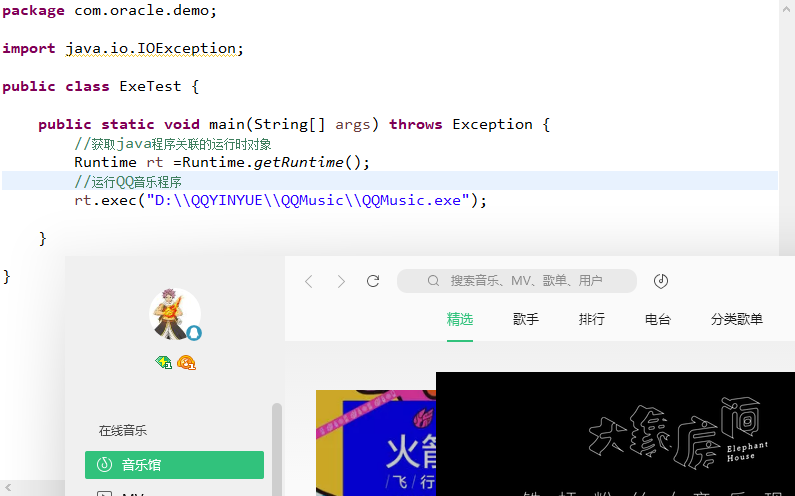

例子:

package com.oracle.demo; import java.io.IOException; public class ExeTest { public static void main(String[] args) throws Exception { /*exec(String command) * String command是要运行程序所在的本地位置*/ //获取java程序关联的运行时对象 Runtime rt =Runtime.getRuntime(); //运行QQ音乐程序 rt.exec("D:\\QQYINYUE\\QQMusic\\QQMusic.exe"); } }

效果显示例子:

本文深入解析Java Runtime环境,包括其定义、如何获取Runtime实例以及通过实例进行系统资源查询和进程操作的方法。通过实例代码展示了处理器数量、内存使用情况的获取,并演示了如何使用exec方法启动外部进程。

本文深入解析Java Runtime环境,包括其定义、如何获取Runtime实例以及通过实例进行系统资源查询和进程操作的方法。通过实例代码展示了处理器数量、内存使用情况的获取,并演示了如何使用exec方法启动外部进程。

2725

2725

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?