启动hiveserver2:

hiveserver2 --hiveconf hive.execution.engine=spark spark.master=yarn

使用beeline连接hiveserver2:

beeline -u jdbc:hive2://hadoop000:10000 -n spark

注意:每个beeline对应一个SparkContext,而在Spark thriftserver中,多个beeline共享一个SparkContext

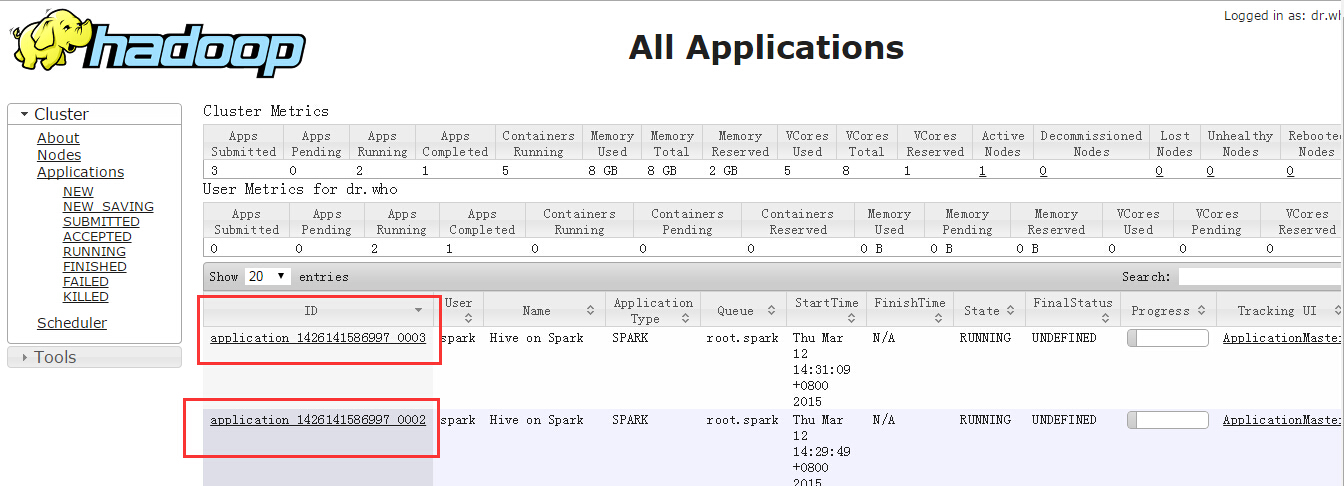

可以通过YARN监控页面观察到:分别执行了两个beeline

在刚启动hive时,执行第一个sql语句会比较慢。

本文介绍如何启动HiveServer2并使用Beeline进行连接,特别指出每个Beeline对应一个SparkContext,在SparkThriftServer中多个Beeline共享一个SparkContext的特点,并提到首次执行SQL语句可能会较慢。

本文介绍如何启动HiveServer2并使用Beeline进行连接,特别指出每个Beeline对应一个SparkContext,在SparkThriftServer中多个Beeline共享一个SparkContext的特点,并提到首次执行SQL语句可能会较慢。

4588

4588

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?