说明:与apache一样,nginx同样可以实现禁用user_agent功能,当网站访问量大,资源有限时,限制不太重要的搜索引擎的蜘蛛爬虫

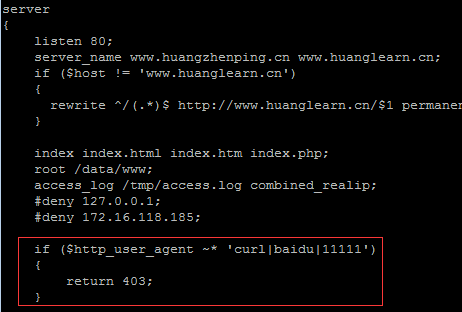

1. 修改虚拟主机配置文件/usr/local/nginx/conf/vhosts/huangzhenping.conf

说明:拒绝掉curl、baidu、111111等这样的user_agent,匹配时,加上~*,可以忽略掉大小写

if ($http_user_agent ~* 'curl|baidu|11111')

{

return 403;

}

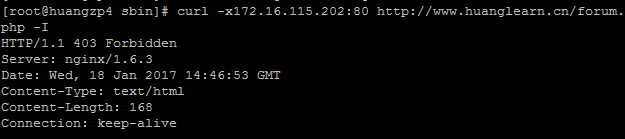

2. 检查配置文件,并重新启动,测试

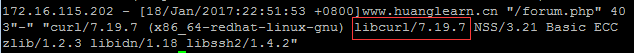

说明:用curl测试,不加user_agent,默认为curl/7. ,结果forbidden,通过日志查看

tail /tmp/access.log

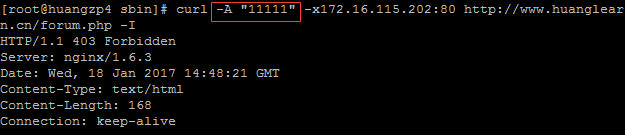

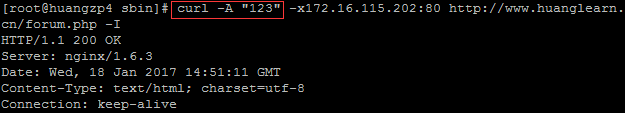

自定义user_agent,访问正常

转载于:https://blog.51cto.com/huangzp/1900651

本文介绍如何使用Nginx禁用特定User-Agent访问,包括配置文件的修改方法及测试验证过程。

本文介绍如何使用Nginx禁用特定User-Agent访问,包括配置文件的修改方法及测试验证过程。

642

642

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?