Flume采集日志的时候报hadoop的datanode为0。(具体报错语句忘了......)

在hadoop目录下输入jps,发现datanode没启动。只有namenode等。

这是因为之前format过namenode导致的(调试的过程中瞎搞结果造成了后遗症。),不知道是否还会有其他情况造成datanode不启动。

解决教程:http://jingyan.baidu.com/article/3c343ff7e75e9e0d36796347.html

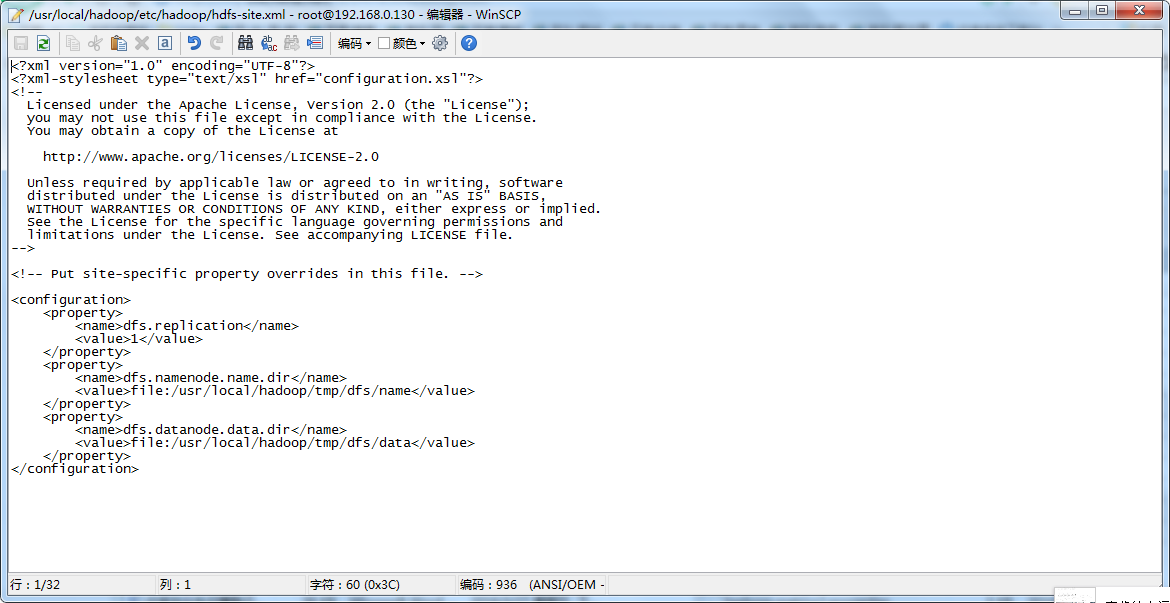

在部署hadoop过程中自己配置过的hdfs-site.xml中找到配置的目录:如下图

找到namenode.name.dir和datanode.name.dir的路径中的dfs目录下的name和data中current目录下的VERSION下的clusterID统一即可,将namenode的clusterID复制给datanode。

本文解决了一个在使用Flume采集日志时遇到的问题:Hadoop的datanode未启动。通过调整hdfs-site.xml配置文件中的namenode.name.dir和datanode.name.dir路径设置,确保两个路径下的clusterID一致来解决此问题。

本文解决了一个在使用Flume采集日志时遇到的问题:Hadoop的datanode未启动。通过调整hdfs-site.xml配置文件中的namenode.name.dir和datanode.name.dir路径设置,确保两个路径下的clusterID一致来解决此问题。

1389

1389

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?