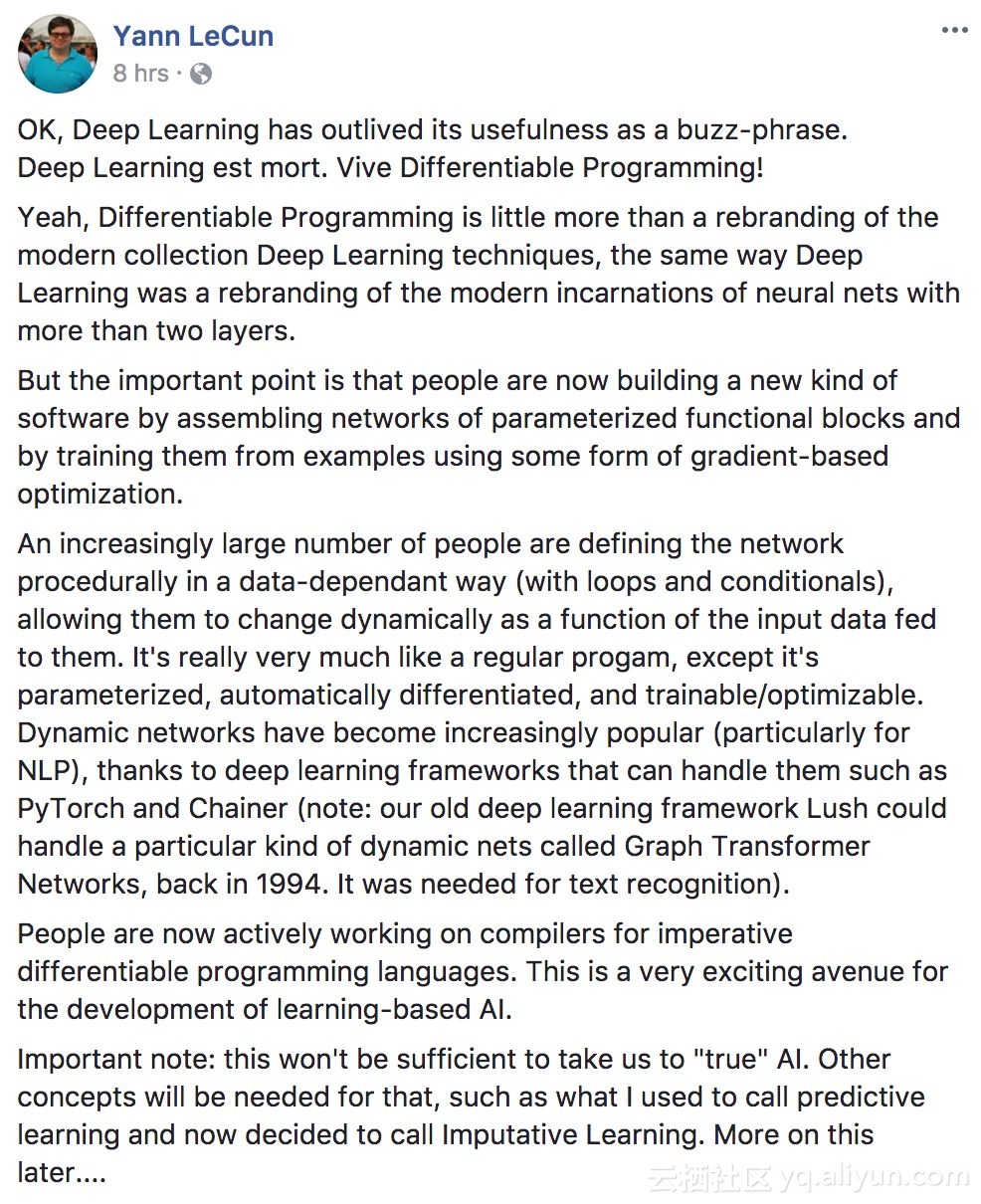

Deep Learning est mort. Vive Differentiable Programming!

这句英法混合的话,翻译成汉语,就是“深度学习已死,可微分编程万岁”。说这话的,正是深度学习三巨头之一:Yann LeCun。

纳尼?

无论是上个月Ali Rahimi的“炼金术说”,还是前些天Gary Marcus对深度学习的质疑,LeCun老师都挺身而出强硬回怼,今天何出此言?

嗯……LeCun在Facebook上的文章里,宣称深度学习已死之前还有一句,说“深度学习作为一个流行词活得太久了,已经没什么用了。”

只是换个说法么?“可微分编程”又是什么?

LeCun承认,“可微分编程”只不过是对现代深度学习技术体系的重新命名,和当年给神经网络里有两个以上隐藏层的变体起名叫“深度学习”差不多。

他还说:

但是重点是,人们现在正通过组装参数化功能模块网络,并用某种基于梯度的优化方法训练它们,来构建一类新软件。

越来越多的人正在以一种依赖于数据的方式(用循环和条件)来程序化地定义网络,让它们随着输入数据的动态变化而变化。除了参数化、自动微分和可训练/可优化的特性之外,这非常像一个普通程序。

动态网络已经变得越来越流行(尤其是对于NLP来说),这要归功于PyTorch和Chainer等深度学习框架(注意:以前的深度学习框架Lush,可以处理一种名叫Graph Transformer Networks的特殊动态网络,用于文本识别)。

现在,人们正在积极研究命令式可微分编程语言的编译器,对开发基于学习的AI来说,这是一种非常激动人心的途径。

除了认为深度学习应该改名叫可微分编程之外,LeCun还说他决定将自己最近特别推崇的“预测性学习”,改名叫做“Imputative Learning”,我们暂时叫“归责学习”好了。

他最后还发了个小预告,说稍后会谈更多,不过量子位从早上等到中午,也还没等到……

只好一起持续关注他的Facebook啦~

https://www.facebook.com/yann.lecun

对于LeCun的新想法,国外论坛上不少人都嫌弃这个新名字太长太难叫,不过也有人说“编程”的确比“学习”贴切。

你怎么看呢?

深度学习三巨头之一Yann LeCun提出深度学习已死的观点,建议将其替换为可微分编程,强调现代深度学习技术体系的本质是通过参数化功能模块网络构建新软件,并利用基于梯度的优化方法进行训练。

深度学习三巨头之一Yann LeCun提出深度学习已死的观点,建议将其替换为可微分编程,强调现代深度学习技术体系的本质是通过参数化功能模块网络构建新软件,并利用基于梯度的优化方法进行训练。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?