一、大数据概述

二、视频大客户对于数据中心的需求

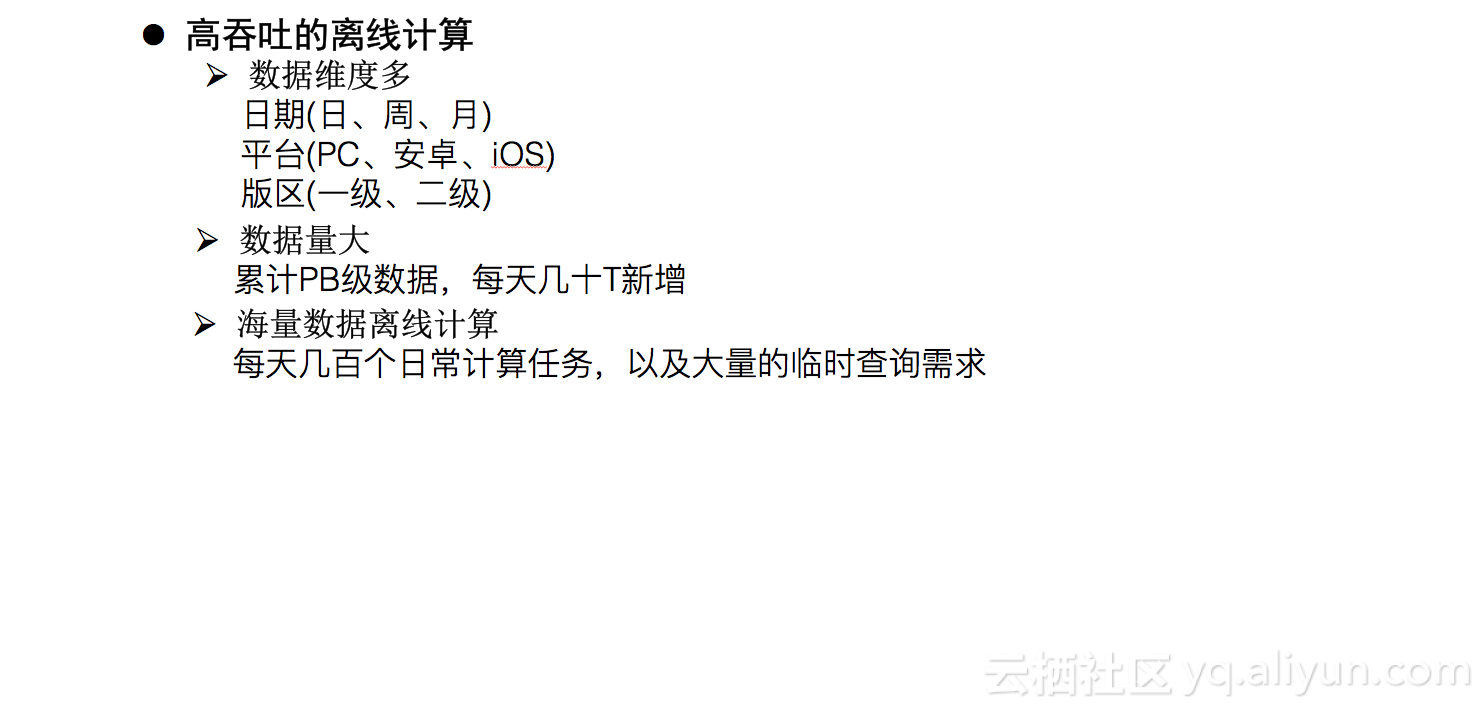

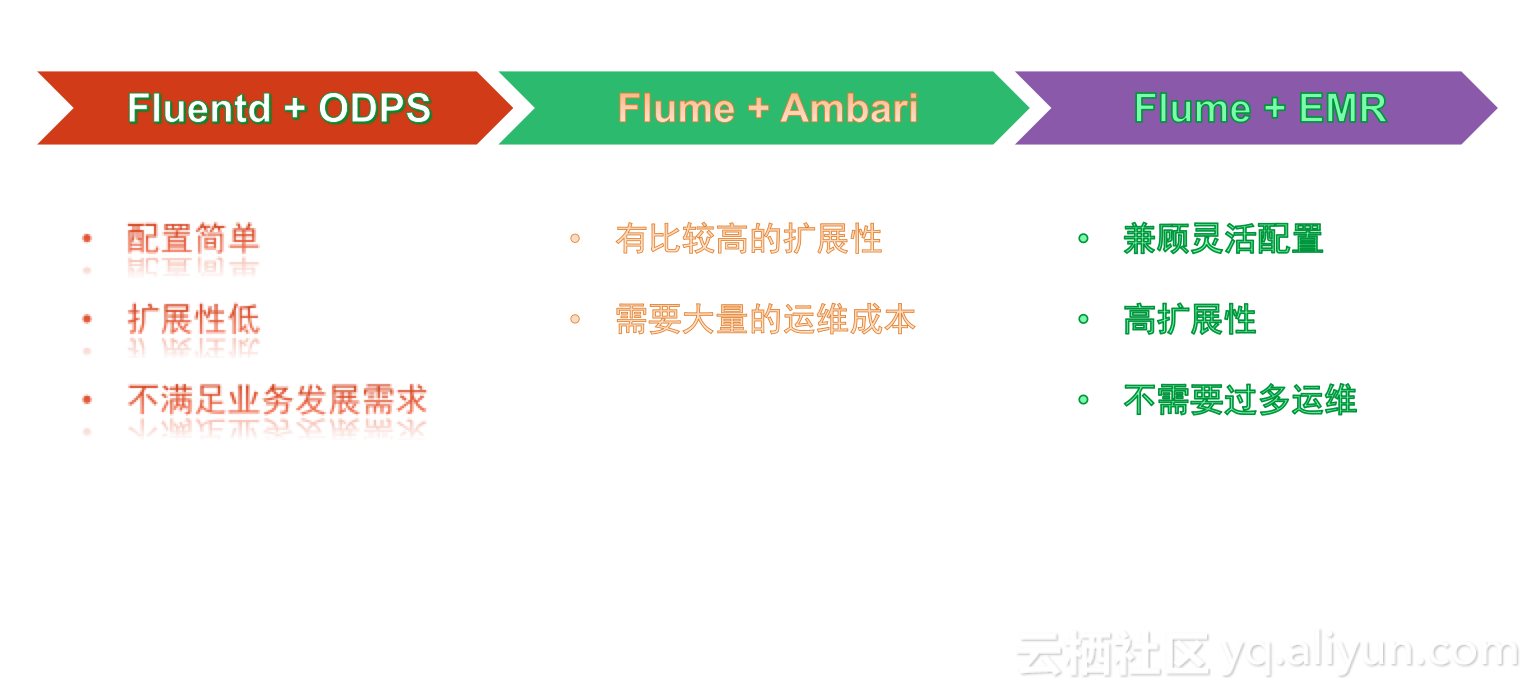

三、传统大数据技术演进

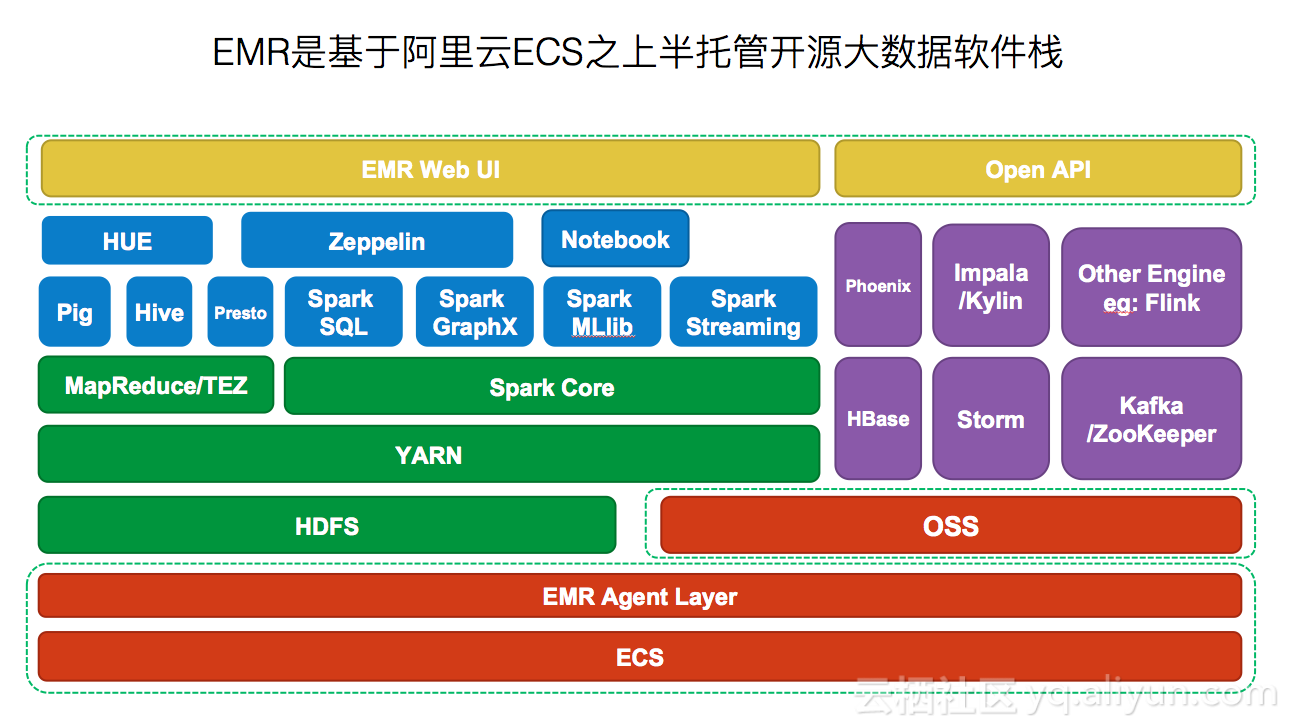

四、EMR介绍

五、为什么选择EMR

弹性动态伸缩

基于ECS之上,快捷的扩容、缩容EMR Hadoop集群。

灵活软件栈选择

灵活、快速部署开源大数据服务(HBase、Kafka、Impala、Flink等)。

数据存储成本低

D1机型使用本地盘,价格远低于云盘;OSS低成本存储冷数据。

运维机制

钉钉群支持,快速解决集群使用问题。减少运维工作,更专注于业务。

六、典型问题及解决方案

数据迁移问题

Hive,HBase数据库结构同步,HDFS数据PB级历史数据同步。如何保证线上实时任务不受影响?

元数据库同步:Hadoop distcp filter (Hadoop 2.8之后支持)。Flume配置双写,多个sink。

数据倾斜问题

现象:MapReduce任务卡在最后一个或几个Reduce。

原因:数据分布不均匀,导致大量的数据分配到了一个节点。

问题:

执行Hive任务时,Flume刚好rename文件,会提示文件不存在的错误。

解决办法:hdfs.inUsePrefix=.生成的文件名增加前缀。

问题:

多台服务器同时写入,默认的文件名重复。

解决办法:修改HDFS sink源码,生成的文件默认增加当前服务器的hostname。

问题:

实时性与小文件过多。

解决办法:离线insert overwrite table,重新生成文件。通过MapReduce 在map之后生成新文件的特性,合并小文件。

本文介绍了EMR在大数据处理中的优势,包括弹性动态伸缩、灵活软件栈选择、低成本数据存储及运维机制。同时探讨了大数据处理中常见的问题如数据迁移、数据倾斜等,并提供了具体的解决方案。

本文介绍了EMR在大数据处理中的优势,包括弹性动态伸缩、灵活软件栈选择、低成本数据存储及运维机制。同时探讨了大数据处理中常见的问题如数据迁移、数据倾斜等,并提供了具体的解决方案。

878

878

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?