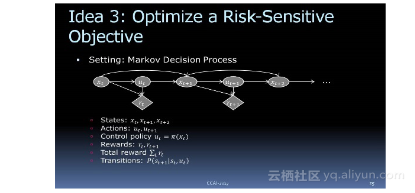

3. 优化对风险敏感的目标

现在,让我们考虑一下,如何利用马尔科夫决策过程(Markov decision process)来对风险敏感的目标进行优化。用这种方法来决策流程的最大问题是,必须先观察这世界找到策略设定回馈,要设定最终的目标、反馈。

想像一下标准的马尔科夫决策问题过程,我们通过代理(agent)来观察这个世界的状态,这个代理会根据一些政策来采取行动,并收到回馈(reward)。比如,下围棋时一直到游戏结束才能得到reward;但是在驾驶汽车时,每做一次正确决定就会得到一次reward,或者至少免受惩罚。

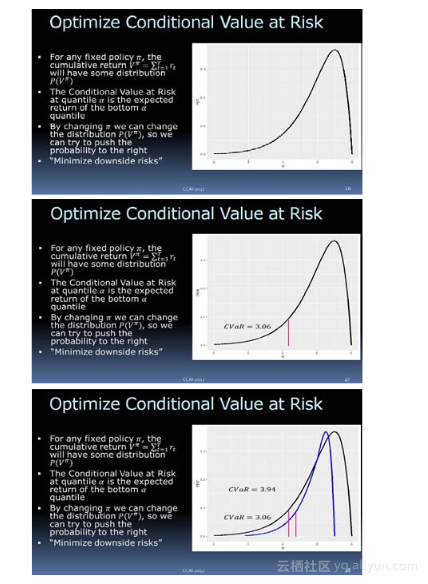

另外,我们还需要一个总回馈参数。我们来看一下,如果策略是固定的,要执行它,你可能要调整其他的一些参数,可以想像我们所收到的回馈参数会有这样的概率分布,可以看到,它有一个下行的风险。我们要优化这个目标,让它尽可能避免下行的风险。我们现在使用的是CVaR(Conditional Value at Risk),如上图所示。

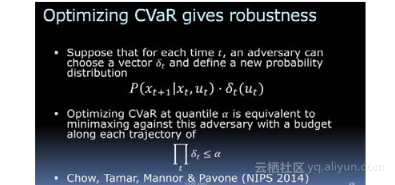

这里可以得出一个结论:优化CVaR,对模型的错误有更好的鲁棒性。

其实还有很多的例子,我就不谈了,因为时间的关系我们看下一部分。

本文探讨了如何利用马尔科夫决策过程(Markov decision process)来优化风险敏感的目标。文章解释了代理(agent)如何根据策略采取行动并接收反馈(reward),并通过CVaR(Conditional Value at Risk)来优化目标,减少下行风险。

本文探讨了如何利用马尔科夫决策过程(Markov decision process)来优化风险敏感的目标。文章解释了代理(agent)如何根据策略采取行动并接收反馈(reward),并通过CVaR(Conditional Value at Risk)来优化目标,减少下行风险。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?