Q

请问老师,切分文本中的数学公式没有标注样本怎么破?

陈新驰

可以人工标注一些,或者先用匹配的方法把一些模式很强的公式分出来。

Q

看起来神经网络的分词,较少考虑了时间性能,但是作为 NLP 的基础模块如果做工业产品这个时间代价会比较突出,博士怎么看这个问题?

陈新驰

神经网络的话一般来说只是训练的时候比较慢,因为它的过程会比较长一点,那么它在 test 的时候其实效率和速度还是可以的,再加上我们用 GPU 的话可以快速的矩阵运算,所以它不会在 test 的时候输于传统的方法。

Q

字标注的也有缺陷,有些分词是基于词的角度,还有一些联合模型,陈博士能发表下您的看法吗?谢谢!

陈新驰

是的,各有优缺点吧。我们做的以基于字的为主,基于词的方法鲜有使用。

Q

不管是传统方法还是 DL 的中文分词的效果已经相当好了,这个方向未来会有什么进一步发展变化吗?

陈新驰

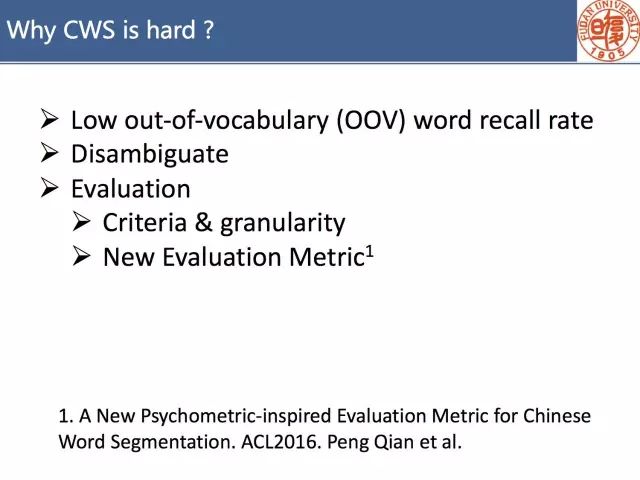

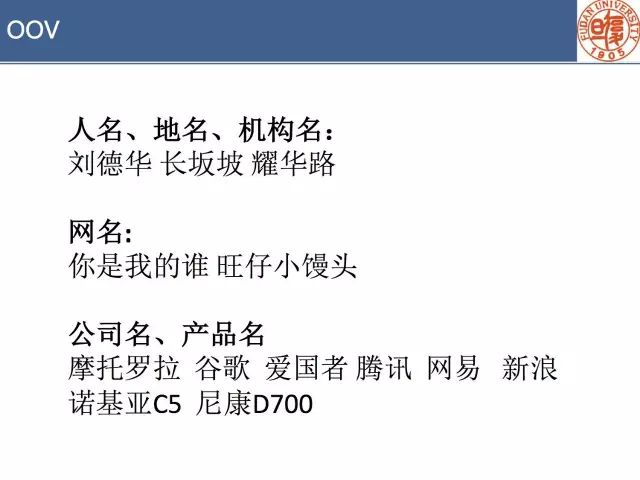

目前在 Benchmarks 上的结果是很好了,但是换一个 Domain 就下去了,OOV 也是一个很大的问题,还有就是分词的粒度问题,能不能去更好地定义分词问题。

Q

分词实践时候,有一个观察。不管是 CRF/struct perceptron/DNN 的方法,如果是在标准语料上训练的模型毕竟还是较小的模型,去切分其他 domain 语料(比如搜索引擎的 query,或者微博),效果都不太理想。特别多特征和 embedding 都会 oov;针对这个问题有什么好的解决方法吗?

陈新驰

这是一个很好的问题,我们也在寻求更好的解决方法。业界的方法往往比较暴力。我们现在一般都是关注在模型本身,往往看在 benchmark 上的结果。

Q

在特定领域中往往没有标注语料,是不是神经分词方法就不太可行了?

陈新驰

如果没有标注语料,监督的方法都会有问题。要试试无监督的方法等。

Q

请问您有没有试着在神经网络中结合之前的特征工程或者其它先验知识来提高分词准确率呢?

陈新驰

这是一个很常用的方法,我记得 Meishan Zhang 在 16ACL 论文中就用过。

Q

中文自然语言处理深度学习,有 Python 示例代码嘛?

陈新驰

有的,我们后续会把我们的分词代码放到 FudanNLP 官方的 Github 上。

来源:paperweekly

本文探讨了中文分词在不同领域的应用挑战,包括缺乏标注数据的问题及解决方案,如人工标注和无监督方法的应用。同时讨论了现有技术如神经网络在实际部署中的考量,并提出了面对新领域时的OOV(未登录词)处理策略。

本文探讨了中文分词在不同领域的应用挑战,包括缺乏标注数据的问题及解决方案,如人工标注和无监督方法的应用。同时讨论了现有技术如神经网络在实际部署中的考量,并提出了面对新领域时的OOV(未登录词)处理策略。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?