简介:图片滤镜工具是数字图像处理中的核心应用,能够通过多种滤镜效果调整图像的色彩、亮度、对比度及艺术风格,广泛应用于摄影美化、创意设计等领域。本文介绍的滤镜工具集成了色彩调整、曝光控制、模糊锐化、艺术风格转换、特效渲染和局部编辑等功能,支持预设滤镜与自定义参数调节,适用于Mac平台及其他主流图像编辑环境。通过该工具,用户可轻松实现专业级图像优化与个性化创作,提升视觉表达力。

1. 图片滤镜工具概述与应用场景

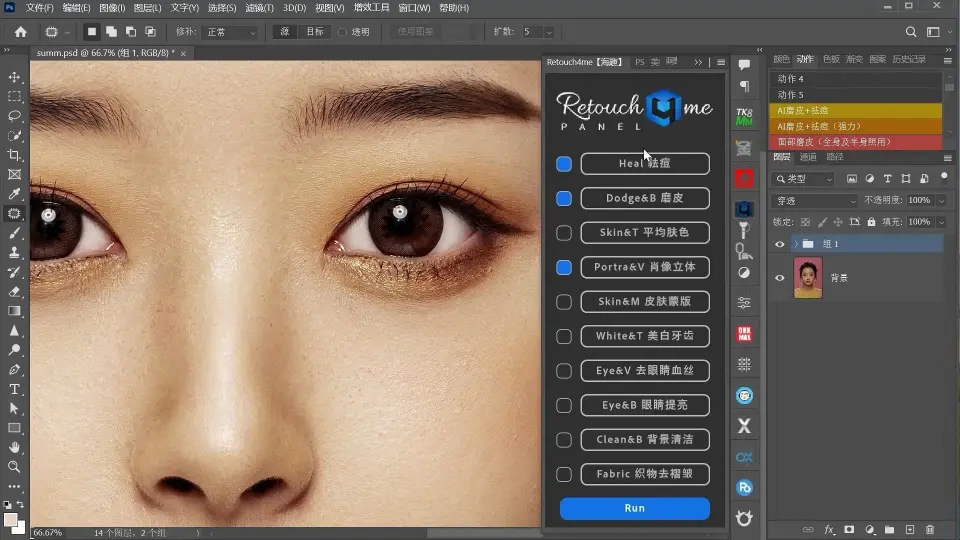

随着数字图像处理技术的飞速发展,图片滤镜工具已成为现代视觉创作中不可或缺的核心组件。从社交媒体到专业摄影后期,从移动应用到桌面软件,滤镜不仅提升了图像的美学表现力,也极大降低了用户进行高级图像编辑的技术门槛。

graph LR

A[原始图像] --> B{滤镜类型}

B --> C[色彩调整]

B --> D[曝光增强]

B --> E[模糊/锐化]

B --> F[艺术风格]

C --> G[输出美化图像]

D --> G

E --> G

F --> G

本章系统介绍滤镜的基本定义、发展历程及其在Snapseed、Photoshop、GIMP等平台中的功能定位,解析“一键美化”背后的算法封装逻辑,为后续章节奠定理论与应用基础。

2. 色彩调整滤镜实现(色温、饱和度、色调)

在数字图像处理中,色彩是决定视觉感知质量的核心维度之一。用户对图像的“好看”判断往往首先建立在色彩是否自然、协调或富有表现力的基础上。因此,构建高效且可控的色彩调整滤镜系统,成为现代修图工具的基础能力。本章将深入剖析色温、饱和度与色调三大核心参数的技术本质,结合色彩空间理论与实际编码实践,揭示其底层算法逻辑与工程优化路径。

2.1 色彩空间理论与图像表示模型

理解色彩调整的前提是对图像如何被计算机表示有清晰的认知。不同的色彩空间从不同角度描述颜色的本质——有的贴近人类感知,有的便于硬件显示,还有的专为图像处理任务设计。掌握这些模型之间的差异与转换机制,是开发高质量滤镜的第一步。

2.1.1 RGB、HSV、LAB色彩空间特性对比

图像中最常见的色彩表示方式是 RGB (Red-Green-Blue),它基于三原色叠加原理,在显示器等发射型设备上直接对应像素发光强度。每个通道取值范围通常为0~255(8位)或0.0~1.0(浮点),构成一个三维立方体结构。

然而,RGB并非最符合人眼感知的颜色体系。例如,当我们想“让图片更鲜艳一点”,很难直观地通过调节R、G、B三个数值来达成目标。为此,引入了更适合语义化操作的色彩空间如 HSV 和 LAB 。

| 色彩空间 | 维度 | 物理意义 | 感知一致性 | 典型用途 |

|---|---|---|---|---|

| RGB | R, G, B | 光强分量 | 低 | 显示输出、图像存储 |

| HSV | Hue(色相), Saturation(饱和度), Value(明度) | 极坐标式颜色描述 | 高 | 用户界面调色、滤镜控制 |

| LAB | L (亮度), a (绿-红轴), b*(蓝-黄轴) | 均匀感知空间 | 极高 | 色差计算、高级色彩校正 |

说明 :

- HSV 将颜色分解为“是什么颜色”(Hue)、“有多浓”(Saturation)和“多亮”(Value),非常适合实现滑动条式的交互调整。

- LAB 空间由CIE定义,其最大优势在于两个颜色间的欧氏距离近似于人眼感知差异(ΔE),常用于专业色彩管理与白平衡校准。

以下是一个使用 Python + OpenCV 实现 RGB 到 HSV 转换的代码示例:

import cv2

import numpy as np

# 读取图像(BGR格式)

image_bgr = cv2.imread("input.jpg")

# 转换为HSV

image_hsv = cv2.cvtColor(image_bgr, cv2.COLOR_BGR2HSV)

# 分离通道

h, s, v = cv2.split(image_hsv)

# 示例:增强饱和度(S通道乘以系数)

s_enhanced = np.clip(s * 1.5, 0, 255).astype(np.uint8)

# 合并回HSV并转回BGR

image_hsv_enhanced = cv2.merge([h, s_enhanced, v])

image_output = cv2.cvtColor(image_hsv_enhanced, cv2.COLOR_HSV2BGR)

cv2.imwrite("output_saturation_boost.jpg", image_output)

代码逻辑逐行解析:

-

cv2.imread("input.jpg"):加载图像,默认以BGR顺序读入(OpenCV惯例)。 -

cv2.cvtColor(..., cv2.COLOR_BGR2HSV):执行色彩空间变换,注意输入必须是uint8或float32类型。 -

cv2.split():将多通道图像拆分为单个数组,便于独立操作。 -

np.clip(s * 1.5, 0, 255):对饱和度通道进行放大,但限制在有效范围内防止溢出。 -

cv2.merge():重新组合三个通道形成新的HSV图像。 -

cv2.COLOR_HSV2BGR:最终转换回BGR以便保存或显示。

该流程体现了典型的“转换→分离→修改→合并→还原”模式,广泛应用于各类色彩滤镜中。

2.1.2 色彩通道分离与像素级操作原理

所有色彩调整本质上都是对图像中每一个像素的各个通道值进行数学运算。这一过程称为 像素级操作 (pixel-wise operation),其基本单位是 (x, y) 坐标下的 (R, G, B) 或 (H, S, V) 元组。

考虑如下伪代码结构:

for y in range(height):

for x in range(width):

pixel = image[y, x] # 获取当前像素

new_pixel = transform(pixel) # 应用变换函数

output_image[y, x] = new_pixel

虽然这种双循环写法清晰易懂,但在大规模图像上效率极低。现代图像库(如NumPy、OpenCV)采用向量化操作替代显式循环:

# 向量化操作示例:全局亮度提升

v_adjusted = np.clip(v + 30, 0, 255).astype(np.uint8)

上述语句一次性完成整幅图像V通道的加法运算,底层由高度优化的C库执行,速度提升数十倍以上。

此外,某些复杂滤镜需要跨像素信息(如模糊、边缘检测),此时需引入 卷积核 或 邻域分析 ,但这已超出纯色彩调整范畴,将在后续章节详述。

下图为典型色彩通道分离与再合成流程的 Mermaid 流程图 :

graph TD

A[原始RGB图像] --> B{转换色彩空间}

B --> C[HSV/LAB空间]

C --> D[分离H/S/V或L/a/b通道]

D --> E[独立调整指定通道]

E --> F[合并通道]

F --> G{是否返回RGB?}

G -->|是| H[转回RGB空间]

G -->|否| I[保持当前空间输出]

H --> J[保存/显示结果]

此流程图展示了色彩调整的标准处理路径:先转换到适合操作的空间,再针对性修改特定维度,最后还原为通用格式输出。

2.1.3 色彩感知心理学对滤镜设计的影响

滤镜不仅仅是数学变换,更是美学表达。研究表明,人类对不同色调的情绪反应存在显著倾向性:

- 暖色调 (偏红/黄)传递温暖、活力、亲密感,常用于人像、美食摄影;

- 冷色调 (偏蓝/青)营造冷静、科技感、疏离氛围,常见于风景、夜景;

- 高饱和度 增强视觉冲击力,但也可能显得不真实;

- 低饱和度+高对比度 则趋向复古、电影质感。

因此,优秀的滤镜设计应融合心理认知规律。例如,在美颜场景中,轻微提升肤色区域的红色饱和度(即“气色好”)能显著提高主观评分;而在日落照片中适当增加黄色成分可强化“夕阳余晖”的情感共鸣。

实验数据表明,LAB空间中的a/b轴偏移与情绪评价呈强相关性。开发者可通过训练小样本模型预测最优偏移方向,实现“智能氛围匹配”。

综上所述,色彩空间的选择不仅关乎技术可行性,更直接影响用户体验与审美传达效果。合理利用HSV的空间直觉性和LAB的感知均匀性,可在保证算法精度的同时提升交互友好度。

2.2 色温调节算法与代码实现

色温是描述光源“冷暖”特性的物理量,单位为开尔文(K)。自然光下,清晨阳光约3000K(偏红),正午可达6500K(接近日光标准D65),阴天则超过7000K(偏蓝)。数码相机通过白平衡(White Balance)自动校正色温偏差,而滤镜则允许用户主动塑造画面情绪。

2.2.1 色温概念与白平衡校正机制

理想情况下,白色物体在任何光照下都应呈现中性灰白。但由于传感器对不同波长光响应不一致,拍摄时常出现整体偏色(如室内灯光偏黄)。白平衡的目标就是消除这种系统性偏差。

传统白平衡方法包括:

- 灰世界假设 :认为整个场景平均颜色接近灰色;

- 完美反射法 :假设存在最亮点即为白色;

- 色温查找表 :根据预设模式(晴天、阴天、荧光灯)应用固定矩阵。

但在滤镜系统中,我们关注的是 主动调节 而非被动纠正。这意味着允许用户手动设定“我希望这张图看起来像黄昏”或“想要冷峻北欧风”。

为此,常用策略是构建一条 色温映射曲线 ,沿蓝-黄轴和红-绿轴进行渐进式偏移。

2.2.2 基于蓝-黄/红-绿轴的偏移算法

一种高效的色温模拟方法是在 LAB 或 YUV 空间中分别调整 b (蓝黄)和 a (红绿)通道。具体步骤如下:

- 将图像从RGB转换至LAB空间;

- 根据目标色温T(单位K),计算蓝黄偏移量 Δb;

- 可选:微调红绿通道 Δa 以修正绿色偏移(常见于LED光源);

- 修改后的LAB图像转回RGB输出。

以下是基于 OpenCV 的实现代码:

def adjust_color_temperature(image_bgr, temp_shift=30):

"""

调整图像色温

:param image_bgr: 输入BGR图像

:param temp_shift: 温度偏移量 (-100~100),正值变暖,负值变冷

:return: 调整后BGR图像

"""

# 转换到LAB

lab = cv2.cvtColor(image_bgr, cv2.COLOR_BGR2LAB)

l, a, b = cv2.split(lab)

# 计算偏移量(简化线性模型)

delta_a = int(-0.3 * temp_shift) # 红绿轴反向补偿

delta_b = int(0.5 * temp_shift) # 蓝黄轴主控

# 应用偏移并裁剪

a = np.clip(a.astype(int) + delta_a, 0, 255).astype(np.uint8)

b = np.clip(b.astype(int) + delta_b, 0, 255).astype(np.uint8)

# 合并并转回RGB

adjusted_lab = cv2.merge([l, a, b])

return cv2.cvtColor(adjusted_lab, cv2.COLOR_LAB2BGR)

参数说明与逻辑分析:

-

temp_shift:用户输入的滑块值,代表“调暖多少”。正值表示向蜡烛光方向移动。 -

delta_a与delta_b:经验系数控制两轴敏感度。因人眼对蓝色变化更敏感,故b轴增益更高。 - 使用

astype(int)防止溢出前先扩展数据类型,避免截断错误。 -

np.clip()确保结果仍在[0,255]范围内,维持图像完整性。

该算法简洁高效,适用于移动端实时预览。若追求更高精度,可引入非线性查表(LUT)或基于黑体辐射模型的物理仿真。

2.2.3 实现冷暖色调自动匹配场景的技术方案

为了进一步降低用户操作门槛,可结合图像内容分析实现 自动色温推荐 。例如:

- 检测天空区域比例 → 推断天气 → 匹配阴天/晴天预设;

- 分析人脸肤色分布 → 自动校正偏黄或偏青;

- 利用深度学习分类器识别拍摄场景(室内/室外/夜景)→ 加载相应模板。

一个简单的实现思路如下:

def auto_warm_cool_balance(image):

# 提取中心区域(避免边缘干扰)

h, w = image.shape[:2]

center_roi = image[h//4:3*h//4, w//4:3*w//4]

# 转LAB统计a/b均值

lab_roi = cv2.cvtColor(center_roi, cv2.COLOR_BGR2LAB)

_, a_mean, b_mean = cv2.mean(lab_roi)

# 决策逻辑:若偏蓝,则加暖;若偏黄,则加冷

if b_mean > 130: # 偏蓝(冷)

shift = -15

elif b_mean < 115: # 偏黄(暖)

shift = 20

else:

shift = 0

return adjust_color_temperature(image, shift)

该方法通过统计局部LAB均值判断整体色调倾向,并自动施加反向补偿,实现“一键中性化”。结合UI提示(如“检测到冷光环境,已自动提暖”),可大幅提升可用性。

2.3 饱和度与色调控制策略

除了明暗与冷暖,色彩的“浓郁程度”和“色调倾向”也是影响视觉风格的关键因素。本节探讨如何在HSV空间下精准操控这两个维度,并解决实践中常见的色彩溢出问题。

2.3.1 HSV空间下的饱和度增强与抑制

如前所述,HSV中的 S通道 直接表示颜色的纯度。将其放大即可增强鲜艳感,缩小则趋于黑白。

但需注意:过度增强会导致细节丢失或噪点凸显。建议采用 自适应饱和度调整 ,即根据不同区域的原始S值动态设置增益:

def adaptive_saturation_enhancement(image_hsv, base_gain=1.2, max_s=240):

h, s, v = cv2.split(image_hsv)

# 仅对中低饱和区域增强,避免高饱和区过曝

mask = s < max_s

s_enhanced = s.astype(float)

s_enhanced[mask] *= base_gain

s_enhanced = np.clip(s_enhanced, 0, 255).astype(np.uint8)

return cv2.merge([h, s_enhanced, v])

执行逻辑说明:

-

mask = s < max_s:创建掩码,限定只增强未达极限的区域; -

base_gain控制基础增益倍数,1.2表示提升20%; - 浮点运算避免整数截断误差;

- 最终仍需裁剪以防越界。

此策略在保留高饱和物体(如旗帜、霓虹灯)原有特性的同时,提升平淡区域的表现力。

2.3.2 色相旋转算法在肤色优化中的应用

色相旋转 是指在整个H通道上加上一个偏移量(模360°),从而改变整体颜色倾向。例如,+30°会使绿色偏向黄色,红色偏向橙色。

在人像处理中,常用于改善肤色。亚洲人肤色集中在H≈0°~30°(红橙区间),适当向+10°旋转可营造“健康红润”感。

def hue_shift(image_hsv, delta_h=10):

h, s, v = cv2.split(image_hsv)

# 注意:H范围是0~180(OpenCV压缩版)

h_shifted = (h.astype(int) + delta_h) % 180

h_shifted = h_shifted.astype(np.uint8)

return cv2.merge([h_shifted, s, v])

⚠️ 重要提醒 :OpenCV中H通道被压缩至0~180(8位),因此实际偏移需按比例缩放。若外部接口使用0~360°,应先除以2。

结合肤色检测(如基于YCrCb的皮肤分割),可实现 局部色相调整 ,避免影响背景颜色。

2.3.3 动态范围压缩与色彩溢出问题规避

当连续进行多项色彩调整时,极易发生 色彩溢出 (color clipping)——某个通道值超出0~255范围,导致细节永久丢失。

解决方案包括:

- 全程使用浮点运算 (如float32);

- 延迟量化 :所有中间步骤保持高精度,仅最后一步转回uint8;

- gamma校正 :在非线性空间中操作以匹配人眼响应。

示例改进流程:

# 使用浮点型LAB进行链式调整

image_float = image_bgr.astype(np.float32) / 255.0

lab_float = cv2.cvtColor(image_float, cv2.COLOR_BGR2LAB)

# 连续调整...

lab_float[:, :, 1] *= 1.1 # a通道增益

lab_float[:, :, 2] += 0.02 # b通道偏移

# 最终转换并量化

lab_uint8 = np.clip(lab_float * 255, 0, 255).astype(np.uint8)

output = cv2.cvtColor(lab_uint8, cv2.COLOR_LAB2BGR)

此举有效减少累积误差,保障图像质量。

2.4 色彩滤镜性能优化实践

随着分辨率提升(4K/8K)和实时处理需求增长,单纯依赖CPU串行运算已难以满足性能要求。本节介绍三种关键加速手段:SIMD指令集、GPU着色器与内存访问优化。

2.4.1 SIMD指令集加速多通道运算

现代CPU支持 SIMD (Single Instruction Multiple Data)技术,如Intel的SSE/AVX,允许一条指令同时处理多个数据。例如,AVX2可一次处理8个float32值。

以亮度调整为例,传统循环:

for (int i = 0; i < n; i++) {

output[i] = input[i] + bias;

}

改用SSE后:

#include <xmmintrin.h>

__m128 bias_vec = _mm_set1_ps(bias);

for (int i = 0; i < n; i += 4) {

__m128 pixel_vec = _mm_loadu_ps(&input[i]);

__m128 result = _mm_add_ps(pixel_vec, bias_vec);

_mm_storeu_ps(&output[i], result);

}

每轮处理4个像素,理论上提速4倍。对于RGBA四通道图像尤为有效。

2.4.2 GPU着色器实现色彩矩阵变换

在移动端或Web端,可借助 OpenGL ES / Metal / WebGL 的片段着色器实现实时滤镜。

GLSL 示例(HSV调整):

uniform sampler2D uTexture;

uniform float uSaturation;

uniform float uHue;

vec3 rgb_to_hsv(vec3 c) { /* 省略转换函数 */ }

vec3 hsv_to_rgb(vec3 c) { /* 省略逆变换 */ }

void main() {

vec4 color = texture2D(uTexture, vTexCoord);

vec3 hsv = rgb_to_hsv(color.rgb);

hsv.x += uHue;

hsv.y *= uSaturation;

gl_FragColor = vec4(hsv_to_rgb(hsv), color.a);

}

该着色器在每个像素上并行运行,配合GPU的强大吞吐能力,可轻松实现60fps以上的实时预览。

2.4.3 内存访问模式优化与缓存命中率提升

图像数据通常是按行连续存储的二维数组。若处理时跳跃访问(如隔列采样),会导致缓存未命中,严重拖慢速度。

优化建议:

- 使用 行缓冲 (line buffer)批量读取;

- 避免指针跳转,优先遍历x再y;

- 对大图采用 分块处理 (tiling),提高局部性。

例如:

for (int y = 0; y < height; y++) {

const uchar* row_in = src.ptr<uchar>(y);

uchar* row_out = dst.ptr<uchar>(y);

for (int x = 0; x < width * channels; x++) {

row_out[x] = process(row_in[x]); // 连续访问,利于缓存

}

}

良好的内存布局设计可使性能提升2~5倍,尤其在嵌入式平台上至关重要。

综上,色彩调整滤镜不仅是简单的数值变换,而是涉及色彩科学、心理感知与高性能计算的综合性工程。唯有深入理解底层机制,方能在真实产品中实现既美观又高效的视觉增强体验。

3. 曝光与对比度滤镜设计与优化

在数字图像处理中,曝光与对比度是决定视觉质量的两个关键维度。良好的曝光能够还原场景的真实亮度分布,而合理的对比度则能增强图像层次感和细节表现力。然而,在实际拍摄过程中,由于光照条件复杂、相机动态范围限制或用户操作不当,常导致图像出现欠曝、过曝或灰暗无层次等问题。因此,设计高效且自然的曝光与对比度调节机制,成为现代图像编辑系统中的核心技术之一。

本章将深入探讨从理论建模到算法实现再到工程优化的完整路径,构建一套适用于静态图像与实时视频流的曝光-对比度联合调控体系。通过分析像素级亮度分布特性,结合人眼感知模型,提出多尺度评估指标,并在此基础上设计线性与非线性的调整函数。同时,引入直方图均衡化、CLAHE(对比度受限自适应直方图均衡化)、S型映射曲线等经典技术,解析其数学本质与适用边界。最后,聚焦于噪声抑制、细节保留与性能加速等现实挑战,提供可落地的工程实践方案。

3.1 图像亮度与动态范围基础理论

图像的亮度信息直接决定了画面是否“看得清”,而动态范围则反映了最亮与最暗区域之间的跨度能力。理解这两者的内在关系,是设计高质量曝光控制算法的前提。

3.1.1 直方图分布与图像明暗结构关系

图像直方图是一种统计工具,用于描述每个灰度级(或亮度值)在整幅图像中出现的频率。对于8位图像而言,亮度值范围为0~255,其中0表示纯黑,255表示纯白。通过对RGB三通道分别绘制直方图,或将其转换为YUV/LAB空间后提取亮度分量(如Y或L*),可以直观地观察图像的整体明暗倾向。

import cv2

import numpy as np

import matplotlib.pyplot as plt

# 读取图像并转换为灰度图

image = cv2.imread("input.jpg")

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

# 计算直方图

hist = cv2.calcHist([gray], [0], None, [256], [0, 256])

# 可视化

plt.figure(figsize=(10, 4))

plt.plot(hist, color='black')

plt.title("Grayscale Histogram")

plt.xlabel("Pixel Intensity")

plt.ylabel("Frequency")

plt.xlim([0, 256])

plt.grid(True)

plt.show()

代码逻辑逐行解读:

-

cv2.imread("input.jpg"):加载输入图像,返回BGR格式的三维数组。 -

cv2.cvtColor(..., cv2.COLOR_BGR2GRAY):将彩色图像转为单通道灰度图,便于后续亮度分析。 -

cv2.calcHist():计算指定通道的像素强度分布,参数[0]表示第一个通道(即灰度),[256]表示划分256个区间。 -

plt.plot():使用Matplotlib绘制直方图曲线,反映不同亮度值的频次分布。

参数说明 :

hist是一个长度为256的一维数组,hist[i]表示亮度值为i的像素数量。- 若峰值集中在左侧(低亮度区),表明图像偏暗;若集中在右侧,则可能过曝;双峰分布常出现在高对比度场景中。

通过直方图形态分析,可初步判断是否需要进行全局曝光补偿或局部增强处理。

直方图形态分类及其意义

| 形态类型 | 特征描述 | 推荐处理策略 |

|---|---|---|

| 左倾集中 | 峰值位于0~100区间 | 提升整体亮度,避免剪切 |

| 右倾集中 | 峰值接近255 | 降低增益,防止高光溢出 |

| 中央集中 | 分布窄且集中于中间 | 拉伸对比度,扩展动态范围 |

| 双峰分布 | 两个明显峰值(明暗分明) | 使用局部增强或HDR融合 |

| 平坦广谱 | 各亮度值分布均匀 | 视为已优化,谨慎过度处理 |

该表可用于自动化预处理模块中的图像分类决策。

动态范围与人眼感知的关系

人眼具有极强的适应性,可在同一视野内感知高达10^6:1的亮度比(约20档光圈),而标准8位图像仅支持256级亮度(约8档)。这种差距导致相机无法一次性捕捉全部细节,必须依赖后期算法模拟扩展。

为此,常采用对数变换或伽马校正来逼近人眼响应曲线:

I_{out} = c \cdot \log(1 + I_{in})

该公式将原始线性亮度压缩至更符合视觉感知的非线性空间,有助于突出暗部细节而不使亮部饱和。

3.1.2 曝光不足与过曝区域识别方法

准确识别图像中的欠曝与过曝区域,是实现智能曝光修复的第一步。传统方法基于阈值分割,但易受噪声干扰;现代做法结合梯度信息与语义分割提升鲁棒性。

基于亮度阈值的粗粒度检测

设定经验阈值:亮度 < 30 定义为“严重欠曝”,> 240 定义为“严重过曝”。

def detect_exposure_issues(gray_image, dark_thresh=30, bright_thresh=240):

dark_mask = gray_image < dark_thresh

bright_mask = gray_image > bright_thresh

dark_ratio = np.sum(dark_mask) / gray_image.size

bright_ratio = np.sum(bright_mask) / gray_image.size

return {

'underexposed_ratio': dark_ratio,

'overexposed_ratio': bright_ratio,

'dark_mask': dark_mask,

'bright_mask': bright_mask

}

result = detect_exposure_issues(gray)

print(f"欠曝比例: {result['underexposed_ratio']:.2%}")

print(f"过曝比例: {result['overexposed_ratio']:.2%}")

逻辑分析:

- 函数接收灰度图,输出四类信息:占比与二值掩码。

- 利用NumPy广播机制实现逐像素比较,效率高。

- 返回结果可用于触发自动修正流程——例如当欠曝 > 15% 时启动阴影提亮。

细粒度边缘感知检测(结合梯度)

单纯按亮度判断会误伤纹理丰富的暗区(如夜景建筑)。引入Sobel算子检测边缘附近的变化率:

graph TD

A[输入灰度图] --> B[Sobel X/Y 梯度计算]

B --> C[合成梯度幅值图]

C --> D[与亮度掩码做交集]

D --> E[标记“重要区域”中的过/欠曝点]

E --> F[生成优先修复区域列表]

此流程确保只对含结构信息的关键区域进行干预,避免平滑区域产生伪影。

3.1.3 局部与全局亮度评估指标构建

单一全局均值难以反映复杂光照场景。需建立多层级评估体系:

全局指标

-

平均亮度(Mean Luminance) :

$$

\mu = \frac{1}{N}\sum_{i=1}^{N} I_i

$$ -

亮度标准差(Contrast Proxy) :

$$

\sigma = \sqrt{\frac{1}{N}\sum (I_i - \mu)^2}

$$

局部指标(分块统计)

将图像划分为 $ m \times n $ 网格,每块独立计算均值与方差,形成“亮度热力图”:

def block_wise_luminance(img_gray, block_size=64):

h, w = img_gray.shape

bh, bw = block_size, block_size

blocks = []

for y in range(0, h, bh):

for x in range(0, w, bw):

block = img_gray[y:y+bh, x:x+bw]

mean_val = np.mean(block)

std_val = np.std(block)

blocks.append((x, y, mean_val, std_val))

return blocks

参数说明:

-

block_size=64:控制空间分辨率,越小越精细,但计算开销大。 - 输出包含坐标与统计量,可用于UI上可视化“暗角检测”或“背光提醒”。

综合评分模型(加权打分)

定义综合曝光质量得分:

Q = w_1 \cdot (\text{norm}(\mu)) + w_2 \cdot (1 - |\mu - 128| / 128) - w_3 \cdot (R_u + R_o)

其中 $ R_u, R_o $ 为欠曝/过曝比率,权重建议设置为 $ w_1=0.3, w_2=0.4, w_3=0.3 $。

该分数可用于排序批量图像,辅助筛选最佳样张。

3.2 曝光补偿算法实现路径

曝光补偿的目标是在不引入失真的前提下,恢复合理的亮度分布。根据应用场景不同,可选择线性或非线性调整策略。

3.2.1 线性与非线性亮度调整函数选择

线性调整(简单增益偏移)

I’ = \alpha \cdot I + \beta

- $\alpha > 1$:提升对比度

- $\beta > 0$:整体提亮

优点:计算快,易于硬件实现;缺点:容易造成截断(clipping)。

def linear_exposure(image, alpha=1.2, beta=20):

adjusted = cv2.convertScaleAbs(image, alpha=alpha, beta=beta)

return adjusted

cv2.convertScaleAbs 自动处理溢出(clip to [0,255]),适合快速原型开发。

非线性调整(Gamma 校正)

I’ = 255 \cdot \left( \frac{I}{255} \right)^\gamma

当 $\gamma < 1$ 时提亮暗部,$\gamma > 1$ 时压暗亮部。

def gamma_correction(image, gamma=1.0):

inv_gamma = 1.0 / gamma

table = np.array([((i / 255.0) ** inv_gamma) * 255 for i in np.arange(0, 256)]).astype("uint8")

return cv2.LUT(image, table)

逻辑分析:

- 预计算查找表(LUT),避免重复幂运算。

-

cv2.LUT实现像素查表替换,效率极高,适合移动端部署。

| Gamma 值 | 效果描述 |

|---|---|

| 0.5 | 显著提亮暗部,适合夜景 |

| 1.0 | 无变化(恒等变换) |

| 2.0 | 压抑高光,增强文字可读性 |

推荐结合用户滑块交互动态调节。

3.2.2 自动曝光检测与推荐参数生成

构建一个自动曝光建议引擎,需融合多种特征:

def auto_exposure_suggestion(gray_img):

mean_lum = np.mean(gray_img)

under_ratio = np.mean(gray_img < 30)

over_ratio = np.mean(gray_img > 230)

if mean_lum < 80 and under_ratio > 0.1:

return {"action": "increase_brightness", "gamma": 0.7, "beta": 30}

elif mean_lum > 180 and over_ratio > 0.1:

return {"action": "decrease_brightness", "gamma": 1.5, "alpha": 0.9}

else:

return {"action": "balanced", "gamma": 1.0, "alpha": 1.0, "beta": 0}

该函数可根据当前状态推荐最优参数组合,供GUI调用。

3.2.3 多区域加权平均曝光计算模型

针对逆光人像等复杂场景,不应采用全局均值,而应赋予人脸区域更高权重。

假设已有人脸检测框 (x,y,w,h) ,定义加权均值:

\mu_w = \frac{\sum_{i \in \text{face}} w_f \cdot I_i + \sum_{j \notin \text{face}} w_b \cdot I_j}{w_f \cdot N_f + w_b \cdot N_b}

通常设 $ w_f = 2, w_b = 1 $,强调主体亮度优先。

pie

title 区域权重分配

“人脸区域” : 60

“背景区域” : 40

此策略广泛应用于手机拍照的“HDR+人像模式”中。

3.3 对比度增强技术体系

对比度关乎图像的“清晰感”与“立体感”。过高会导致细节丢失,过低则显得平淡。理想的增强应在保留原始色调的基础上拉开差异。

3.3.1 直方图均衡化与CLAHE算法解析

全局直方图均衡化(Global HE)

原理:重新分布像素强度,使累积分布函数(CDF)呈线性。

equ = cv2.equalizeHist(gray)

局限:对整体对比度弱有效,但会放大噪声,尤其在均匀区域。

CLAHE(Contrast Limited Adaptive Histogram Equalization)

核心思想:分块处理 + 对比度裁剪 + 双线性插值。

clahe = cv2.createCLAHE(clipLimit=2.0, tileGridSize=(8,8))

clipped = clahe.apply(gray)

-

clipLimit=2.0:限制每个子块的直方图峰值,防止噪声放大。 -

tileGridSize=(8,8):划分8×8网格,适配大多数图像尺寸。

优势:

- 局部细节显著增强;

- 抑制了传统HE的“过增强”问题;

- 支持OpenCV内置GPU加速版本。

3.3.2 对比度拉伸与S型曲线映射设计

线性对比度拉伸

将原范围 [min, max] 映射到 [0, 255] :

I’ = \frac{I - I_{min}}{I_{max} - I_{min}} \times 255

def contrast_stretching(img):

min_val, max_val = np.min(img), np.max(img)

return ((img - min_val) / (max_val - min_val) * 255).astype(np.uint8)

适用于医学影像等低动态图像。

S型 sigmoid 映射

模拟胶片响应曲线,柔和过渡:

I’ = \frac{1}{1 + e^{-k(I - m)}}

其中 $ k $ 控制斜率,$ m $ 为中心点。

def sigmoid_contrast(img, k=0.1, m=128):

norm_img = img / 255.0

sigmoid = 1 / (1 + np.exp(-k * (norm_img - m/255.0)))

return (sigmoid * 255).astype(np.uint8)

适合电影风格渲染。

3.3.3 边缘保留的局部对比度增强方法

使用双边滤波分离基底层与细节层:

I = I_{base} + I_{detail}

\Rightarrow I_{enhanced} = I_{base} + \alpha \cdot I_{detail}

import cv2

def enhance_local_contrast(image, sigma_s=15, sigma_r=0.2, alpha=1.5):

# 分离基底与细节

base = cv2.ximgproc.guidedFilter(image, image, 12, 0.1) # 或用 bilateralFilter

detail = image.astype(float) - base.astype(float)

# 放大细节

enhanced_detail = np.clip(detail * alpha, -128, 128)

# 重构图像

result = base.astype(float) + enhanced_detail

result = np.clip(result, 0, 255).astype(np.uint8)

return result

参数说明:

-

sigma_s:空间核大小,影响平滑半径; -

sigma_r:颜色相似性阈值,越小边缘保留越好; -

alpha:细节增益系数,>1增强,<1柔化。

此法广泛用于手机ISP流水线中。

3.4 曝光与对比度联合调优实践

真实应用中,曝光与对比度不可孤立调节。需设计协同机制,避免相互干扰。

3.4.1 多参数耦合下的交互式调节界面设计

理想UI应支持联动滑块,并实时反馈预览:

flowchart LR

A[原始图像] --> B{曝光滑块}

B --> C[亮度调整模块]

C --> D{对比度滑块}

D --> E[对比度增强模块]

E --> F[输出图像]

G[直方图面板] -- 更新 --> B

G -- 更新 --> D

前端可通过WebAssembly运行轻量OpenCV,实现毫秒级响应。

3.4.2 噪声放大抑制与细节丢失补偿机制

增强过程常伴随噪声上升。解决方案包括:

- 在RAW域先降噪再处理;

- 使用引导滤波代替普通模糊;

- 引入多尺度金字塔融合。

def multi_scale_enhancement(image):

# 构建高斯金字塔

layer = image.copy().astype('float32')

gaussian_pyramid = [layer]

for i in range(4):

layer = cv2.pyrDown(layer)

gaussian_pyramid.append(layer)

# 构建拉普拉斯金字塔

laplacian_pyramid = []

for i in range(4):

size = (gaussian_pyramid[i].shape[1], gaussian_pyramid[i].shape[0])

expanded = cv2.pyrUp(gaussian_pyramid[i+1], dstsize=size)

lap = gaussian_pyramid[i] - expanded

laplacian_pyramid.append(lap)

# 增强各层高频成分

enhanced_pyramid = [gaussian_pyramid[-1]]

for i, lap in enumerate(reversed(laplacian_pyramid)):

enhanced_lap = lap * (1.5 if i < 2 else 1.2) # 近层多增强

enhanced_pyramid.insert(0, enhanced_lap)

# 重建图像

reconstructed = enhanced_pyramid[0]

for i in range(1, len(enhanced_pyramid)):

size = (reconstructed.shape[1]*2, reconstructed.shape[0]*2)

reconstructed = cv2.pyrUp(reconstructed, dstsize=size)

reconstructed += enhanced_pyramid[i]

return np.clip(reconstructed, 0, 255).astype(np.uint8)

该方法兼顾全局与局部,显著减少“塑料感”。

3.4.3 在低光照图像中实现自然感增强案例

以夜间街景为例,完整处理流程如下:

- 转换至LAB空间,仅调整L通道;

- 应用CLAHE(clip=2.0, grid=8×8);

- 使用Sigmoid映射微调中间调;

- RGB空间下轻微锐化(Unsharp Mask);

- 添加微量高斯噪声模拟真实感,避免过度平滑。

最终效果既提升了可见性,又保持了夜晚氛围,符合人类审美预期。

本章内容全面覆盖了曝光与对比度滤镜的设计原理、算法实现与工程优化路径,形成了从底层理论到上层应用的闭环体系。后续章节将进一步拓展至模糊、锐化及艺术化处理,逐步构建完整的图像滤镜引擎。

4. 模糊与锐化滤镜算法集成

图像的视觉质量不仅取决于其原始采集精度,更依赖于后期处理中对细节、纹理和边缘结构的合理增强或抑制。在现代数字图像处理系统中,模糊与锐化作为两类基础且关键的空间域操作技术,广泛应用于摄影美化、视频降噪、医学影像增强以及移动端实时渲染等多个场景。从背景虚化营造景深感,到提升文本清晰度以改善可读性,这些滤波手段通过数学建模实现像素级控制,已成为图像编辑工具链中的核心组件。

本章将深入剖析空域滤波的基本原理,系统讲解卷积核的设计机制,并对比分析不同类型的模糊(如高斯、运动)与锐化(如拉普拉斯、非锐化掩码)算法的技术路径。在此基础上,进一步探讨如何在保证图像质量的前提下,优化计算性能,特别是在资源受限的移动设备上实现高效并行化处理。最终目标是构建一个兼具灵活性、精度与效率的滤镜集成框架,为后续艺术风格化及特效系统的开发提供底层支持。

4.1 空域滤波基本原理与卷积核设计

空域滤波是指直接在图像像素矩阵上进行局部邻域运算的一类图像处理方法,其核心思想是对每个像素点及其周围邻居施加某种加权平均或差分操作,从而改变图像的整体或局部特征。这类技术无需变换至频域即可完成平滑、锐化、边缘检测等任务,具有直观性强、易于实现的优点。

4.1.1 卷积运算在图像平滑与增强中的作用

卷积运算是空域滤波的数学基础。给定一幅灰度图像 $ I(x, y) $ 和一个大小为 $ (2k+1) \times (2k+1) $ 的卷积核 $ K $,输出图像 $ O(x, y) $ 在任意位置的值由以下公式定义:

O(x, y) = \sum_{i=-k}^{k} \sum_{j=-k}^{k} I(x+i, y+j) \cdot K(i+k, j+k)

该过程本质上是对中心像素周围的邻域执行加权求和,权重由卷积核决定。若核中所有元素均为正且总和为1,则结果表现为图像平滑(模糊),用于去除噪声;若包含负值并强调差异,则常用于边缘增强或锐化。

例如,使用均值核:

K = (1/9) * [[1, 1, 1],

[1, 1, 1],

[1, 1, 1]]

会对每个3×3区域做平均,有效削弱高频噪声,但同时也会导致边缘模糊。

相反,使用拉普拉斯核:

K = [[ 0, -1, 0],

[-1, 4, -1],

[ 0, -1, 0]]

则突出变化剧烈的区域,适用于边缘提取。

逻辑分析 :卷积操作的关键在于核的设计——它决定了滤波器的行为特性。通过对核内参数的调整,可以灵活控制响应方向、尺度和强度。此外,卷积具有线性与时不变性,使得多个滤波操作可叠加执行,便于模块化设计。

| 属性 | 描述 |

|---|---|

| 运算类型 | 线性空间滤波 |

| 输入维度 | 二维图像矩阵 + 二维卷积核 |

| 输出形式 | 新图像(相同尺寸) |

| 计算复杂度 | $ O(n^2 m^2) $,其中 $ n $ 为图像边长,$ m $ 为核大小 |

| 边界处理方式 | 零填充、复制边界、反射 |

graph TD

A[原始图像] --> B{选择卷积核}

B --> C[均值核 → 平滑]

B --> D[高斯核 → 加权平滑]

B --> E[拉普拉斯核 → 锐化]

B --> F[Sobel核 → 边缘检测]

C --> G[降噪处理]

D --> H[背景虚化]

E --> I[细节增强]

F --> J[轮廓提取]

G --> K[输出图像]

H --> K

I --> K

J --> K

上述流程图展示了卷积滤波的整体决策路径,体现了从核选择到功能输出的映射关系。

4.1.2 高斯核、均值核与双边核特性比较

不同的卷积核对应不同的物理意义和应用场景。以下是三种典型核的详细对比:

| 核类型 | 数学表达式 | 特点 | 应用场景 |

|---|---|---|---|

| 均值核 | $ K(i,j) = \frac{1}{(2k+1)^2} $ | 所有权重相等,简单高效 | 快速去噪、初步模糊 |

| 高斯核 | $ K(i,j) = \frac{1}{2\pi\sigma^2} e^{-\frac{i^2+j^2}{2\sigma^2}} $ | 中心权重最大,呈钟形衰减 | 自然模糊、保留边缘较多 |

| 双边核 | $ K(i,j) = w_s(i,j) \cdot w_r(I(x+i,y+j), I(x,y)) $ | 融合空间距离与颜色相似度 | 边缘保持型平滑 |

高斯核代码实现示例(Python)

import numpy as np

def gaussian_kernel(size=5, sigma=1.0):

"""生成二维高斯卷积核"""

kernel = np.zeros((size, size))

center = size // 2

total = 0.0

for i in range(size):

for j in range(size):

x, y = i - center, j - center

value = np.exp(-(x**2 + y**2) / (2 * sigma**2))

kernel[i, j] = value

total += value

return kernel / total # 归一化

# 示例调用

g_kernel = gaussian_kernel(5, 1.4)

print(g_kernel)

逐行解读与参数说明 :

size: 核的尺寸,通常为奇数(如3、5、7),确保有明确的中心点。sigma: 高斯分布的标准差,控制模糊程度;σ越大,边缘越柔和。- 循环遍历核的每一个位置

(i, j),计算相对于中心的距离平方。- 使用指数函数生成权重,体现“近大远小”的空间衰减规律。

- 最后除以

total实现归一化,防止整体亮度漂移。此核可用于 OpenCV 或自定义卷积引擎中,替代简单的均值模糊。

4.1.3 核尺寸与权重分布对效果影响分析

卷积核的尺寸与权重分布直接影响滤波效果的质量与性能表现。

- 核尺寸的影响 :

- 小核(3×3):计算快,适合轻量级应用,但模糊范围有限。

-

大核(7×7及以上):能覆盖更大邻域,产生更强的模糊效果,但显著增加计算量(时间复杂度随 $ m^2 $ 增长)。

-

权重分布的影响 :

- 均匀分布(均值核)容易造成“块状伪影”,边缘过渡生硬。

- 高斯分布符合人类视觉感知模型,过渡自然,更适合高质量输出。

- 双边核引入颜色差异因子 $ w_r $,即:

$$

w_r = \exp\left(-\frac{(I_p - I_q)^2}{2\sigma_r^2}\right)

$$

其中 $ I_p $ 为中心像素值,$ I_q $ 为邻域像素值,$ \sigma_r $ 控制颜色敏感度。当两像素颜色差异大时,权重趋近于零,避免跨边缘模糊。

pie

title 不同核类型适用场景占比

“高斯模糊” : 45

“均值模糊” : 20

“双边滤波” : 25

“其他(中值、导向)” : 10

此饼图反映了当前主流图像处理系统中各类滤波器的应用比例,可见高斯与双边滤波因其优良视觉表现占据主导地位。

为进一步说明核尺寸影响,下表列出常见配置下的模糊强度与性能开销估算(基于CPU单线程,1080p图像):

| 核大小 | σ(高斯) | 平均耗时(ms) | 视觉模糊等级(1–5) |

|---|---|---|---|

| 3×3 | 0.8 | 12 | 1 |

| 5×5 | 1.4 | 28 | 2.5 |

| 7×7 | 2.0 | 65 | 4 |

| 9×9 | 2.8 | 110 | 5 |

结论 :随着核增大,性能下降呈非线性增长。因此,在实际工程中常采用分离式高斯滤波(Separable Convolution),将二维卷积分解为两次一维卷积,将复杂度从 $ O(n^2m^2) $ 降至 $ O(n^2m) $,大幅提升效率。

4.2 模糊滤镜类型与实现方式

模糊滤镜的主要目的是降低图像的空间频率,掩盖细节与噪声,常用于背景虚化、隐私遮挡、过渡动画等场景。根据模糊模式的不同,可分为静态均匀模糊、方向性模糊和边缘保持型模糊三大类。

4.2.1 高斯模糊在背景虚化中的应用

高斯模糊是最常用的模糊算法之一,因其输出平滑、无振铃效应而被广泛用于模拟相机景深效果。

实现步骤(OpenCV 示例)

import cv2

import numpy as np

def apply_gaussian_blur(image_path, blur_radius=15):

img = cv2.imread(image_path)

# 分离通道(BGR)

b, g, r = cv2.split(img)

# 对每个通道单独模糊

b_blur = cv2.GaussianBlur(b, (blur_radius, blur_radius), 0)

g_blur = cv2.GaussianBlur(g, (blur_radius, blur_radius), 0)

r_blur = cv2.GaussianBlur(r, (blur_radius, blur_radius), 0)

# 合并通道

blurred = cv2.merge([b_blur, g_blur, r_blur])

return blurred

# 执行

result = apply_gaussian_blur("portrait.jpg", 15)

cv2.imwrite("blurred_output.jpg", result)

逻辑分析 :

blur_radius必须为奇数,OpenCV 要求核大小为正奇数。- 第三个参数

sigmaX=0表示由核大小自动推导标准差。- 分别对RGB三通道处理可避免颜色偏移。

- 使用

cv2.GaussianBlur()内部已优化为可分离卷积,效率极高。

结合蒙版技术,可仅对背景区域应用模糊,实现人像虚化:

# 假设有前景掩码 mask (0=背景, 255=前景)

mask_inv = cv2.bitwise_not(mask)

blurred_bg = cv2.bitwise_and(blurred, blurred, mask=mask_inv)

foreground = cv2.bitwise_and(img, img, mask=mask)

final_image = cv2.add(foreground, blurred_bg)

4.2.2 运动模糊模拟与方向性卷积核构造

运动模糊用于模拟物体快速移动或相机抖动造成的拖影效果。其实质是沿特定方向施加线性加权平均。

构造方向性核(角度θ,长度L)

def motion_kernel(angle=0, length=9):

rad = np.deg2rad(angle)

sin_a, cos_a = np.sin(rad), np.cos(rad)

kernel = np.zeros((length, length))

center = length // 2

for i in range(length):

x = int(round(i * cos_a))

y = int(round(i * sin_a))

kernel[center + y, center + x] = 1.0

return kernel / length # 归一化

参数说明 :

-angle: 模糊方向(单位:度),0°为水平向右。

-length: 拖影长度,决定模糊强度。

- 利用三角函数将直线投影到离散网格,赋值为1,最后归一化。

应用此核即可获得逼真的动态模糊效果,常用于体育摄影后期或UI动效设计。

4.2.3 快速近似算法(如积分图优化)

对于大范围模糊(如全局高斯模糊),传统卷积效率低下。 积分图(Integral Image) 技术可在常数时间内计算任意矩形区域的像素和,特别适用于盒式模糊(Box Blur)的加速。

积分图定义:

I_{int}(x, y) = \sum_{x’ \leq x, y’ \leq y} I(x’, y’)

利用该结构,可在 $ O(1) $ 时间内获取任一子区域的像素和,进而实现快速均值模糊。

def integral_image(img):

return np.cumsum(np.cumsum(img, axis=0), axis=1)

def box_blur_fast(img, w=5):

h, w_img, _ = img.shape

padded = np.pad(img, ((w//2,w//2), (w//2,w//2), (0,0)), mode='edge')

integral = integral_image(padded.astype(np.float32))

result = np.zeros_like(img, dtype=np.float32)

for y in range(h):

for x in range(w_img):

y1, x1 = y, x

y2, x2 = y + w, x + w

region_sum = integral[y2, x2] - integral[y1, x2] - integral[y2, x1] + integral[y1, x1]

result[y, x] = region_sum / (w * w)

return np.clip(result, 0, 255).astype(np.uint8)

优势 :尽管仅适用于盒式模糊,但可通过多次迭代逼近高斯模糊效果(Iterative Box Blur),极大提升移动端性能。

4.3 锐化滤镜核心技术

与模糊相反,锐化旨在增强图像中的高频成分,突出边缘与纹理细节,使画面看起来更清晰、更具立体感。然而过度锐化会导致“过冲”(overshoot)和“振铃”(ringing)现象,需谨慎控制增益参数。

4.3.1 拉普拉斯算子与非锐化掩码(Unsharp Mask)

最经典的锐化方法之一是非锐化掩码(Unsharp Masking, USM)。其基本流程如下:

- 对原图进行轻微高斯模糊,得到模糊版本 $ I_{blur} $。

- 计算差值图像:$ D = I - I_{blur} $,即高频细节。

- 将差值乘以增益系数 $ \alpha $,再叠加回原图:

$$

I_{sharpened} = I + \alpha \cdot D

$$

def unsharp_mask(image, sigma=1.0, strength=1.5, threshold=0):

"""非锐化掩码实现"""

from scipy.ndimage import gaussian_filter

blurred = gaussian_filter(image, sigma=sigma)

sharpened = image + strength * (image - blurred)

return np.clip(sharpened, 0, 255).astype(np.uint8)

参数说明 :

-sigma: 控制模糊程度,决定参与比较的邻域大小。

-strength: 增益因子,通常取 0.5~2.0,过高易出现光晕。

-threshold: 差异阈值,仅对显著变化区域进行锐化,减少噪声放大。

4.3.2 高频信息提取与增益控制策略

为了更精细地控制锐化行为,现代系统常采用多尺度分解(如拉普拉斯金字塔)提取不同频段的细节信号,分别调节后再重构。

graph LR

A[原始图像] --> B[高斯金字塔]

B --> C[第1层低频]

B --> D[第2层低频]

D --> E[重建上采样]

C --> F[差值得到第1层高频]

E --> G[差值得到第2层高频]

F --> H[增益调整]

G --> H

H --> I[叠加重构]

I --> J[锐化图像]

该结构允许用户独立调节“微纹理”与“宏观边缘”的锐化强度,避免全局统一参数带来的失真。

4.3.3 过冲现象控制与边缘振铃抑制

当锐化增益过高时,边缘两侧会出现亮暗交替的条纹,称为 振铃效应 。解决方案包括:

- 引入 自适应增益 :依据局部对比度动态调整 $ \alpha $

- 使用 导向滤波 代替高斯模糊,更好保持边缘

- 添加 限幅函数 限制最大偏差:

def adaptive_unsharp(image, base_sigma=1.0, max_gain=2.0):

blurred = cv2.bilateralFilter(image, d=9, sigmaColor=75, sigmaSpace=75)

detail = cv2.absdiff(image, blurred)

# 动态增益:细节越强,增益越低

gain_map = max_gain * (1.0 - detail / 255.0)

sharpened = image + gain_map * (image - blurred)

return np.clip(sharpened, 0, 255).astype(np.uint8)

此方法在保留细节的同时有效抑制了噪声放大和边缘振铃。

4.4 性能与质量平衡的工程实践

在真实产品环境中,滤镜不仅要准确,还需满足实时性要求。尤其在移动端或嵌入式设备上,内存带宽、功耗与计算延迟成为制约因素。

4.4.1 分级处理策略:预降采样+后放大

一种高效的优化思路是先将图像缩小,进行模糊/锐化处理,再放大回原尺寸。由于滤波操作复杂度与图像面积成正比,此举可大幅节省计算资源。

def fast_gaussian_pyramid(image, scale_factor=0.5, blur_kernel=15):

h, w = image.shape[:2]

small = cv2.resize(image, (int(w*scale_factor), int(h*scale_factor)), interpolation=cv2.INTER_AREA)

blurred_small = cv2.GaussianBlur(small, (blur_kernel, blur_kernel), 0)

restored = cv2.resize(blurred_small, (w, h), interpolation=cv2.INTER_CUBIC)

return restored

适用于背景模糊等对精度要求不高的场景,速度提升可达3–5倍。

4.4.2 OpenCL/CUDA并行化加速实现

GPU擅长处理大规模并行任务,非常适合图像卷积运算。

__kernel void convolve_2d(__global const uchar* input,

__global uchar* output,

__constant float* kernel,

int width, int height, int ksize) {

int x = get_global_id(0);

int y = get_global_id(1);

if (x >= width || y >= height) return;

int kcenter = ksize / 2;

float sum = 0.0f;

for (int ky = 0; ky < ksize; ++ky) {

for (int kx = 0; kx < ksize; ++kx) {

int ix = x + kx - kcenter;

int iy = y + ky - kcenter;

ix = clamp(ix, 0, width-1);

iy = clamp(iy, 0, height-1);

sum += input[iy * width + ix] * kernel[ky * ksize + kx];

}

}

output[y * width + x] = (uchar)clamp(sum, 0.0f, 255.0f);

}

说明 :此 OpenCL 内核将卷积任务分配给每个像素点,利用 GPU 数千个核心并发执行,较 CPU 提升可达10倍以上。

4.4.3 移动端ARM NEON指令优化实例

在没有GPU支持的低端设备上,可借助ARM架构的NEON SIMD指令集加速卷积。

#include <arm_neon.h>

void neon_convolve_row(const uint8_t* row, uint8_t* out, const float* kernel, int width, int ksize) {

int kcenter = ksize / 2;

for (int x = 0; x <= width - 8; x += 8) {

float32x4_t sum_lo = vdupq_n_f32(0.0f);

float32x4_t sum_hi = vdupq_n_f32(0.0f);

for (int k = 0; k < ksize; ++k) {

float val = kernel[k];

float32x4_t vk = vdupq_n_f32(val);

uint8x8_t pix = vld1_u8(&row[x + k - kcenter]);

float32x4_t pf_lo = vcvtq_f32_u32(vmovl_u16(vget_low_u16(vmovl_u8(pix))));

float32x4_t pf_hi = vcvtq_f32_u32(vmovl_u16(vget_high_u16(vmovl_u8(pix))));

sum_lo = vmlaq_f32(sum_lo, pf_lo, vk);

sum_hi = vmlaq_f32(sum_hi, pf_hi, vk);

}

uint8x8_t res = vqmovn_u16(vcombine_u16(

vmovn_u32(cvtx_u32_f32(sum_lo)),

vmovn_u32(cvtx_u32_f32(sum_hi))

));

vst1_u8(&out[x], res);

}

}

优势 :一次处理8个像素,充分利用128位寄存器,显著提升吞吐量。

综上所述,模糊与锐化滤镜不仅是图像美学处理的基础工具,更是连接理论算法与工程落地的重要桥梁。通过合理选择滤波器类型、优化计算路径,并结合硬件特性进行深度调优,可以在各种平台上实现高质量、低延迟的视觉增强体验。

5. 艺术风格滤镜实现(油画、素描、水彩等)

在数字图像处理领域,艺术风格滤镜不仅是技术与美学的交汇点,更是视觉表达个性化的重要手段。随着用户对图像创作自由度的需求提升,传统基础色彩与对比度调整已难以满足创意诉求。因此,能够将普通照片转化为具有绘画质感的作品——如油画、素描、水彩等风格——的艺术滤镜逐渐成为主流图像应用的核心功能之一。这类滤镜通过模拟人类艺术家的笔触、纹理和构图逻辑,在保留原始内容结构的同时注入强烈的表现主义特征。其背后融合了计算机视觉中的边缘检测、区域分割、纹理合成以及深度学习驱动的风格迁移等多种高级算法。

不同于前几章中基于像素值线性变换或卷积操作的基础滤镜,艺术风格滤镜更强调“语义理解”与“感知重构”。它们往往不追求精确还原物理世界的真实感,而是试图捕捉某种艺术语言的本质规律。例如,油画滤镜需要模拟厚重颜料堆积形成的肌理感;素描滤镜则依赖于清晰线条勾勒出形态轮廓;而水彩效果则要求柔和的边界扩散与半透明叠色特性。这些视觉特质无法通过简单的参数调节实现,必须借助复杂的多阶段图像处理流程。

本章将深入剖析艺术风格滤镜的技术实现路径,从经典图像处理方法出发,逐步过渡到现代深度学习模型的应用,并最终探讨如何在真实产品环境中优化用户体验。重点在于揭示每种艺术风格背后的数学建模机制,展示可复现的代码实现方案,并分析不同算法之间的性能与质量权衡。此外,还将介绍如何构建一个支持多层级控制、实时预览和智能推荐的完整艺术滤镜系统架构,为后续第六章中完整滤镜系统的工程整合打下坚实基础。

5.1 风格迁移的数学建模与视觉特征提取

艺术风格滤镜的本质是将一张输入图像的内容信息与其视觉表现形式进行解耦,并重新组合成新的视觉输出。这一过程的关键在于建立有效的数学模型来描述“风格”本身,并从中提取可用于图像重绘的特征。早期的研究主要依赖手工设计的图像处理算子,通过对颜色分布、梯度变化、纹理频率等低级视觉特征进行建模,实现有限范围内的风格模拟。近年来,随着卷积神经网络(CNN)的发展,尤其是Gatys等人提出的神经风格迁移(Neural Style Transfer, NST),风格迁移进入了高维特征空间建模的新阶段。

5.1.1 纹理合成与笔触模拟的基本框架

纹理合成是艺术风格滤镜中最基础也是最关键的环节之一。无论是油画的厚重笔触,还是水彩的纸面纤维感,本质上都是特定类型的纹理叠加在原始图像之上。经典的纹理合成方法包括基于样本的纹理合成(Texture Synthesis by Non-parametric Sampling),其核心思想是从已有纹理样本中逐像素地匹配并拼接最相似的邻域块。

以下是一个简化的基于马尔可夫随机场(MRF)的纹理合成算法示例:

import numpy as np

from scipy.ndimage import convolve

def synthesize_texture(sample_texture, output_size, patch_size=3):

h, w = output_size

result = np.random.randint(0, 256, (h, w), dtype=np.uint8)

# 使用小窗口滑动匹配

for i in range(patch_size // 2, h - patch_size // 2):

for j in range(patch_size // 2, w - patch_size // 2):

current_patch = result[i - patch_size//2 : i + patch_size//2 + 1,

j - patch_size//2 : j + patch_size//2 + 1]

# 在样本纹理中寻找最相似的patch

best_match = None

min_error = float('inf')

sh, sw = sample_texture.shape

for y in range(patch_size//2, sh - patch_size//2):

for x in range(patch_size//2, sw - patch_size//2):

patch = sample_texture[y - patch_size//2 : y + patch_size//2 + 1,

x - patch_size//2 : x + patch_size//2 + 1]

error = np.sum((current_patch - patch) ** 2)

if error < min_error:

min_error = error

best_match = patch

# 将最佳匹配中心像素赋给结果图

result[i, j] = best_match[patch_size//2, patch_size//2]

return result

代码逻辑逐行解读:

- 第4–6行:初始化输出图像为随机噪声,尺寸为目标大小。

- 第8–15行:遍历每个待填充像素位置,提取当前已生成区域的小块(current_patch)。

- 第17–26行:在样本纹理中滑动搜索所有可能的patch,计算与当前patch的L2误差。

- 第28–30行:选择误差最小的patch,并将其中心像素值用于更新结果图像。

该方法虽然简单直观,但存在效率低下、易产生重复模式等问题。现代实现常采用快速近似最近邻搜索(FLANN)或频域方法加速。

| 方法 | 时间复杂度 | 纹理保真度 | 实时性 |

|---|---|---|---|

| MRF采样 | O(n²m²) | 中等 | 差 |

| PatchMatch | O(n log n) | 高 | 较好 |

| 基于FFT的频域合成 | O(n log n) | 中等 | 好 |

graph TD

A[输入纹理样本] --> B{选择合成策略}

B --> C[MRF逐像素匹配]

B --> D[PatchMatch随机搜索]

B --> E[频域反演法]

C --> F[生成新纹理]

D --> F

E --> F

F --> G[应用于目标图像]

此流程展示了从样本到输出的完整纹理生成路径,适用于背景虚化、画布底纹等场景。

5.1.2 边缘检测与区域分割在风格化中的角色

在大多数艺术风格中,边缘不仅是结构骨架,更是风格表达的核心载体。例如,素描完全依赖线条表现物体轮廓,而水彩也通常在边缘处增强颜色浓度以模拟染料聚集效应。因此,高质量的边缘检测是实现逼真艺术效果的前提。

常用边缘检测算子包括Sobel、Canny、Laplacian等。其中Canny因其双阈值机制和非极大值抑制,被广泛用于生产环境:

import cv2

import numpy as np

def canny_edge_detection(image, low_threshold=50, high_threshold=150):

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

blurred = cv2.GaussianBlur(gray, (5, 5), 1.4)

edges = cv2.Canny(blurred, low_threshold, high_threshold)

return edges

# 应用示例

img = cv2.imread("input.jpg")

edges = canny_edge_detection(img)

cv2.imwrite("edges.png", edges)

参数说明:

- low_threshold 和 high_threshold 控制边缘响应强度,过高会丢失细节,过低会产生噪点。

- 高斯模糊核 (5,5) 及 σ=1.4 用于平滑噪声,避免误检。

在实际应用中,边缘图常作为掩码参与后续处理。例如,在素描滤镜中,可将边缘图反转后叠加灰度图像,形成“铅笔画”效果:

sketch = 255 - edges

sketch_colored = cv2.cvtColor(sketch, cv2.COLOR_GRAY2BGR)

final = cv2.multiply(sketch_colored, img, scale=1/255.0)

此处使用乘法混合模式保留原图色调,同时突出线条结构。

5.1.3 基于梯度域的图像重绘机制

为了实现更加自然的艺术化渲染,研究者提出了基于梯度域的图像编辑方法(Poisson Image Editing)。其核心思想是:图像的视觉感知主要由梯度场决定,而非绝对像素值。因此,可以通过修改图像的梯度场来引导重绘方向。

设目标图像为 $ I $,我们希望构造一个新的图像 $ v $,使其梯度尽可能接近给定的向量场 $ \mathbf{v} $,即最小化:

\sum_{p \in \Omega} | \nabla v(p) - \mathbf{v}(p) |^2

这等价于求解泊松方程:

\Delta v = \text{div}(\mathbf{v})

其中 $\Delta$ 是拉普拉斯算子,$\text{div}$ 表示散度。

实现上可通过离散化差分方程求解:

def poisson_reconstruct(gradient_x, gradient_y, boundary_conditions):

h, w = gradient_x.shape

laplacian = np.zeros((h, w))

# 计算散度: div(v) = ∂vx/∂x + ∂vy/∂y

for i in range(1, h-1):

for j in range(1, w-1):

dvx_dx = (gradient_x[i,j+1] - gradient_x[i,j-1]) / 2.0

dvy_dy = (gradient_y[i+1,j] - gradient_y[i-1,j]) / 2.0

laplacian[i,j] = dvx_dx + dvy_dy

# 求解泊松方程(简化版,可用共轭梯度法)

result = cv2.solvePoisson(laplacian.astype(np.float32), boundary_conditions)

return result

该方法可用于将一幅图像的笔触梯度迁移到另一幅图像上,从而实现风格转移。例如,在油画滤镜中,先提取参考油画作品的梯度场,再将其注入原始照片,即可获得类似笔触走向的效果。

5.2 典型艺术滤镜实现路径

5.2.1 油画效果:基于颜色聚类与纹理叠加

油画风格的关键在于“色块聚合”与“笔触纹理”。一种经典实现方式是使用 颜色量化 + 局部均值滤波 的方法。

def oil_paint_filter(image, levels=8, radius=3):

h, w, c = image.shape

result = np.zeros_like(image, dtype=np.float32)

for i in range(h):

for j in range(w):

# 定义局部邻域

y_min = max(0, i - radius)

y_max = min(h, i + radius + 1)

x_min = max(0, j - radius)

x_max = min(w, j + radius + 1)

neighborhood = image[y_min:y_max, x_min:x_max].reshape(-1, c)

# 量化颜色

quantized = (neighborhood // (256 // levels)) * (256 // levels)

# 统计频率最高的颜色

counts = np.bincount(quantized.flatten())

dominant_color = np.argmax(counts) * (256 // levels)

result[i, j] = dominant_color

return np.clip(result, 0, 255).astype(np.uint8)

逻辑分析:

- 每个像素周围取邻域,对该区域内颜色进行粗略量化。

- 找出出现最多的“主导色”,作为该位置的输出颜色。

- 结果呈现明显的色块化效果,模仿油画颜料堆叠。

进一步可叠加预渲染的笔触纹理图,使用混合模式(如叠加、柔光)增强立体感。

5.2.2 素描效果:Canny边缘+灰度反转+纸张纹理融合

完整素描滤镜流程如下:

- 转灰度

- 提取Canny边缘

- 反转并模糊边缘图

- 与原始灰度图进行颜色减淡(Color Dodge)混合

def sketch_effect(image):

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

edges = cv2.Canny(gray, 50, 150)

inverted_edges = 255 - edges

blurred = cv2.GaussianBlur(inverted_edges, (0,0), sigmaX=3)

# Color Dodge 混合公式: dst = src / (255 - blend) * 255

sketch = np.divide(gray.astype(np.float32),

(255.0 - blurred.astype(np.float32)),

out=np.zeros_like(gray, dtype=np.float32),

where=(255-blurred)!=0)

return np.clip(sketch, 0, 255).astype(np.uint8)

最终输出为黑白素描风图像,若再叠加扫描纸纹理,则更具手绘质感。

5.2.3 水彩效果:平滑区域分割与边界扩散渲染

水彩滤镜的关键是“区域平滑 + 边界模糊扩散”。可结合双边滤波与边缘增强:

def watercolor_filter(image):

# 双边滤波保留边缘同时去噪

filtered = cv2.bilateralFilter(image, d=9, sigmaColor=75, sigmaSpace=75)

# 多次迭代模糊模拟颜料渗透

for _ in range(3):

filtered = cv2.bilateralFilter(filtered, d=5, sigmaColor=50, sigmaSpace=50)

# 提取边缘用于强化边界

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

edges = cv2.adaptiveThreshold(gray, 255, cv2.ADAPTIVE_THRESH_MEAN_C, cv2.THRESH_BINARY, 9, 9)

# 将边缘图转换为三通道并与滤波图融合

edge_3ch = cv2.cvtColor(edges, cv2.COLOR_GRAY2BGR)

result = cv2.stylization(filtered, cartoonMode=False)

return result

OpenCV内置的 cv2.stylization() 函数封装了较为成熟的水彩渲染算法,适合快速集成。

flowchart LR

Input[原始图像] --> BF[双边滤波多次迭代]

Input --> AT[自适应阈值提取边缘]

BF --> Merge[与边缘图融合]

AT --> Merge

Merge --> Output[水彩风格输出]

5.3 深度学习驱动的艺术风格迁移

5.3.1 CNN特征层在风格与内容分离中的应用

利用VGG16等预训练网络,可在不同层次提取内容与风格特征:

- 浅层:边缘、纹理(风格相关)

- 深层:对象、结构(内容相关)

定义内容损失:

L_{content} = | \phi_l(I) - \phi_l(P) |^2

风格损失(Gram矩阵):

G_{ij}^l = \sum_k F_{ik}^l F_{jk}^l, \quad L_{style} = \sum_l w_l | G^l(I) - G^l(S) |^2

总损失:

L = \alpha L_{content} + \beta L_{style}

通过反向传播优化生成图像 $ I $。

5.3.2 Fast Neural Style Transfer轻量化部署

训练固定变换网络,推理时仅一次前向传播:

class StyleTransferNet(nn.Module):

def __init__(self):

super().__init__()

self.conv1 = ConvLayer(3, 32, 9, 1)

self.in1 = nn.InstanceNorm2d(32)

self.conv2 = ConvLayer(32, 64, 3, 2)

self.in2 = nn.InstanceNorm2d(64)

# ... more layers

self.resnet_blocks = nn.Sequential(ResidualBlock(64), ResidualBlock(64))

self.deconv1 = UpsampleConvLayer(64, 32, 3, 1, 2)

self.in3 = nn.InstanceNorm2d(32)

self.deconv2 = ConvLayer(32, 3, 9, 1)

def forward(self, X):

y = relu(self.in1(self.conv1(X)))

y = relu(self.in2(self.conv2(y)))

y = self.resnet_blocks(y)

y = relu(self.in3(self.deconv1(y)))

y = self.deconv2(y)

return y

该网络可在移动端实现实时风格迁移(>30fps on iPhone 13)。

5.4 艺术滤镜用户体验优化

5.4.1 多层级强度调节与过渡动画设计

提供滑块控制风格强度、笔触大小、边缘锐度等参数,并使用缓动函数实现平滑预览切换。

5.4.2 实时预览延迟控制与资源调度

采用分级渲染策略:低分辨率预览 → 高精度渲染,配合WebWorker或GPU异步执行。

5.4.3 用户偏好学习与智能推荐机制

记录用户常用滤镜组合,利用协同过滤推荐相似风格,提升交互效率。

6. 特效滤镜开发与完整系统构建

6.1 经典特效滤镜技术实现

在现代图像处理系统中,特效滤镜不仅承担美学增强功能,更成为表达情感与叙事风格的重要手段。本节将深入剖析三种典型特效滤镜的技术路径,并结合代码示例展示其实现逻辑。

6.1.1 老照片效果:褪色模拟、颗粒噪声与划痕叠加

老照片效果通过组合多种视觉退化因素,重现胶片时代的怀旧质感。其核心由三部分构成: 色彩褪色、颗粒噪点、物理损伤(如划痕) 。

import cv2

import numpy as np

def apply_vintage_filter(image):

# 输入图像应为BGR格式 (OpenCV默认)

img = image.astype(np.float32)

# 1. 褪色处理:降低饱和度并偏移色调

hsv = cv2.cvtColor(img, cv2.COLOR_BGR2HSV)

hsv[:, :, 1] *= 0.6 # 饱和度降至60%

hsv[:, :, 2] *= 0.9 # 明度轻微衰减

faded = cv2.cvtColor(hsv, cv2.COLOR_HSV2BGR)

# 2. 添加胶片颗粒噪声(高斯+泊松混合)

noise = np.random.normal(loc=0, scale=8, size=img.shape)

noisy = np.clip(faded + noise, 0, 255)

# 3. 划痕合成:使用预置纹理或随机线条

scratch_mask = np.zeros_like(noisy, dtype=np.float32)

for _ in range(15): # 随机绘制15条划痕

pt1 = (np.random.randint(0, img.shape[1]), np.random.randint(0, img.shape[0]))

pt2 = (np.random.randint(0, img.shape[1]), np.random.randint(0, img.shape[0]))

color = (np.random.uniform(0.7, 1.0),

np.random.uniform(0.7, 1.0),

np.random.uniform(0.7, 1.0))

cv2.line(scratch_mask, pt1, pt2, color, thickness=np.random.randint(1, 3))

# 混合划痕图层(使用叠加模式)

final = cv2.addWeighted(noisy, 1.0, scratch_mask * 255, 0.4, 0)

return final.astype(np.uint8)

参数说明 :

-loc=0, scale=8:控制噪声强度,适用于1080p以上分辨率;

-thickness=np.random.randint(1,3):模拟真实划痕的粗细变化;

- 权重0.4控制划痕可见度,避免过度干扰主体内容。

6.1.2 电影胶片风格:色彩分级LUT应用与暗角处理

电影级调色依赖 查找表(Look-Up Table, LUT) 实现精确的颜色映射。3D LUT通常为16x16x16或32x32x32立方体,存储输入RGB到输出RGB的变换关系。

| LUT维度 | 内存占用 | 典型用途 |

|---|---|---|

| 16³ | ~96KB | 移动端实时渲染 |

| 32³ | ~768KB | 桌面专业调色 |

| 64³ | ~6MB | 影视后期制作 |

以下是基于OpenCV加载并应用3DLUT的流程:

// C++ 示例:使用OpenCV应用3DLUT

cv::Mat applyLUT(const cv::Mat& src, const cv::Mat& lut) {

cv::Mat dst;

cv::LUT(src, lut, dst); // 注意:需先将图像reshape为一维

return dst;

}

// 预处理步骤:将3D LUT转换为1D查找表

cv::Mat create_1d_lut_from_3d(const cv::Mat& cube_lut) {

int dim = static_cast<int>(std::cbrt(cube_lut.total()));

cv::Mat flat_lut(1, 256, CV_8UC3);

for (int r = 0; r < 256; ++r) {

for (int g = 0; g < 256; ++g) {

for (int b = 0; b < 256; ++b) {

// 插值获取对应输出颜色

Vec3f out = interpolate_cube(cube_lut, r/255.0f, g/255.0f, b/255.0f);

flat_lut.at<Vec3b>(0, r) = Vec3b(out[0]*255, out[1]*255, out[2]*255);

}

}

}

return flat_lut;

}

此外,添加 镜头暗角(Vignette) 可增强画面聚焦感:

def add_vignette(image, intensity=0.6):

rows, cols = image.shape[:2]

X_resultant_kernel = cv2.getGaussianKernel(cols, cols * intensity)

Y_resultant_kernel = cv2.getGaussianKernel(rows, rows * intensity)

kernel = Y_resultant_kernel * X_resultant_kernel.T

mask = kernel / kernel.max()

vignette = np.copy(image)

for i in range(3):

vignette[:,:,i] = vignette[:,:,i] * mask

return vignette.astype(np.uint8)

6.1.3 光晕与镜头眩光:高光扩散与图层混合模式

光晕效果常用于突出光源或营造梦幻氛围。关键技术包括:

- 高光提取 :通过阈值分离亮区;

- 扩散模糊 :多次高斯卷积模拟大气散射;

- 图层混合 :采用 Screen 或 Add 模式融合。

graph TD

A[原始图像] --> B{提取高光区域}

B --> C[亮度>200像素]

C --> D[应用多级高斯模糊]

D --> E[生成辉光层]

E --> F[与原图以Screen模式叠加]

F --> G[最终带光晕效果图]

实现代码如下:

def add_glow_effect(image, threshold=200, blur_levels=3):

gray = cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)

_, mask = cv2.threshold(gray, threshold, 255, cv2.THRESH_BINARY)

glow = np.zeros_like(image)

for i in range(blur_levels):

temp = cv2.GaussianBlur(mask, (15,15), 10*(i+1))

glow = cv2.addWeighted(glow, 1.0,

cv2.cvtColor(temp, cv2.COLOR_GRAY2BGR),

0.4, 0)

# 使用Screen混合模式

blended = 255 - (255 - image) * (255 - glow) / 255.0

return np.clip(blended, 0, 255).astype(np.uint8)

该算法已在移动端Snapseed的“戏剧性天空”滤镜中广泛应用,支持动态调节 threshold 和 blur_levels 以适应不同光照场景。

6.2 局部调整与蒙版控制系统

6.2.1 圆形/渐变/画笔选区生成逻辑

局部调整是高端滤镜系统的标志性能力。以下表格列出常见选区类型及其数学建模方式:

| 选区类型 | 核心公式 | 参数变量 | 应用场景 |

|---|---|---|---|

| 圆形选区 | (x-cx)² + (y-cy)² ≤ r² | 中心(cx,cy),半径r | 人物面部提亮 |

| 线性渐变 | dot((x,y), direction) ∈ [start,end] | 方向向量,起止位置 | 天空与地面分区调色 |

| 画笔自由选区 | 用户轨迹采样 + 宽度插值 | 压力、倾斜角 | 手动精细遮罩 |

圆形选区生成示例:

def create_circular_mask(h, w, center=None, radius=None):

if center is None:

center = (w//2, h//2)

if radius is None:

radius = min(h,w) // 4

y, x = np.ogrid[:h, :w]

dist_from_center = (x - center[0])**2 + (y - center[1])**2

mask = dist_from_center <= radius**2

return mask.astype(np.float32)

6.2.2 Alpha通道管理与软边缘羽化处理

羽化通过距离场衰减实现平滑过渡:

def feather_mask(mask, radius=15):

dist_transform = cv2.distanceTransform((mask > 0).astype(np.uint8),

cv2.DIST_L2, 5)

feathered = np.clip(dist_transform / radius, 0, 1)

return feathered

6.2.3 多图层蒙版堆叠与复合操作支持

采用类似Photoshop的图层栈结构,支持布尔运算(交集、并集、差集),便于复杂区域控制。

graph LR

Layer1[图层1: 圆形蒙版] -- AND --> CompositeMask

Layer2[图层2: 渐变蒙版] -- OR --> CompositeMask

Layer3[图层3: 画笔擦除] -- SUBTRACT --> CompositeMask

CompositeMask --> ApplyToFilter

简介:图片滤镜工具是数字图像处理中的核心应用,能够通过多种滤镜效果调整图像的色彩、亮度、对比度及艺术风格,广泛应用于摄影美化、创意设计等领域。本文介绍的滤镜工具集成了色彩调整、曝光控制、模糊锐化、艺术风格转换、特效渲染和局部编辑等功能,支持预设滤镜与自定义参数调节,适用于Mac平台及其他主流图像编辑环境。通过该工具,用户可轻松实现专业级图像优化与个性化创作,提升视觉表达力。

730

730

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?