LangFlow:让AI工作流设计像搭积木一样简单

在今天的AIGC浪潮中,我们正见证一个根本性的转变——人工智能不再只是算法工程师的专属领域。越来越多的产品经理、教育工作者、业务分析师甚至学生,都希望借助大语言模型(LLM)来构建智能应用。但现实是,LangChain这样的强大框架虽然功能丰富,却对使用者提出了极高的技术门槛:你需要熟悉Python、理解链式结构、掌握提示工程,还要能调试复杂的调用栈。

有没有一种方式,能让人们专注于“我想做什么”,而不是“该怎么写代码”?

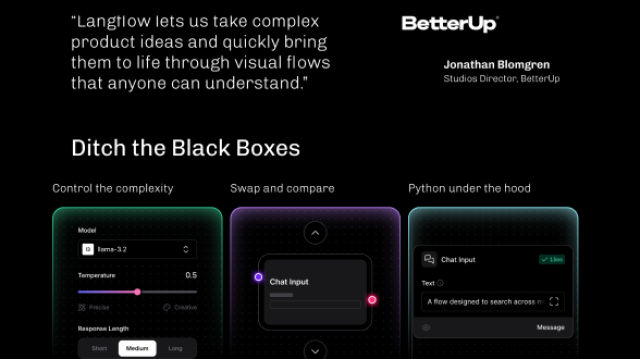

这正是LangFlow诞生的意义所在。它没有重新发明轮子,而是巧妙地将LangChain的能力封装成一个个可拖拽的模块,让你像拼乐高一样搭建AI流程。你不需要成为编程高手,也能快速验证一个创意是否可行。

从代码到画布:重新定义AI开发体验

想象这样一个场景:你的团队正在讨论是否要上线一个基于LLM的客服助手。过去的做法可能是安排一名工程师花几天时间写原型,而现在,你们可以在会议室里打开LangFlow,半小时内就跑通整个流程。

它的核心思路其实很直观——把每个LangChain组件变成图形界面上的一个“节点”。比如OpenAI模型是一个节点,PromptTemplate是一个节点,整个LLMChain也可以是一个节点。你只需要把这些方块拖到画布上,用鼠标连线指定数据流向,系统就会自动帮你生成背后的执行逻辑。

这种“声明式+可视化”的模式带来了几个关键变化:

- 开发不再是线性的编码过程,而变成了空间化的思维组织;

- 调试不再是读日志猜问题,你可以直接点击某个节点查看它的输入输出;

- 协作不再局限于开发者之间,产品人员可以参与流程设计,教师可以直接调整提示词看效果。

更妙的是,LangFlow并不是完全脱离代码的存在。当你完成原型后,它可以一键导出为标准的Python脚本,无缝衔接到后续的工程化部署中。这意味着你既享受了低代码带来的效率提升,又不会被锁定在特定工具里。

它是怎么做到的?背后的技术架构解析

LangFlow的实现本质上是一套“前端建模 + 后端执行”的协同系统。我们可以把它拆解为三层来看:

+----------------------------+

| 前端界面层 |

| - React 图形编辑器 |

| - 节点画布、属性面板、调试区 |

+------------+---------------+

|

HTTP/API ↓

+----------------------------+

| 后端服务层 |

| - FastAPI 服务器 |

| - Flow 解析引擎 |

| - LangChain 动态实例化 |

| - 组件注册与校验 |

+------------+---------------+

|

Python SDK ↓

+----------------------------+

| LangChain & LLM 层 |

| - 第三方 LLM 接口(OpenAI)|

| - 向量数据库(Pinecone) |

| - 工具集(Wikipedia, Google)|

+----------------------------+

当你在界面上连接两个节点时,前端会把整个工作流保存为一个结构化的JSON文件。这个文件描述了所有节点的类型、参数配置以及它们之间的连接关系。当你点击“运行”,这份JSON被发送到后端,由FastAPI服务接收并解析。

真正的魔法发生在后端:LangFlow会根据JSON中的定义,动态导入对应的LangChain类,传入配置参数,实例化对象,并按照连接顺序组织调用链。整个过程就像是在实时编译一段Python程序,只不过源码不是文本,而是你在画布上的操作。

举个例子,如果你拖了一个PromptTemplate节点和一个OpenAI节点,并把前者连到后者,系统实际上会生成类似这样的代码逻辑:

prompt = PromptTemplate(input_variables=["topic"], template="请写一篇关于 {topic} 的科普文章摘要。")

llm = OpenAI(model_name="text-davinci-003", temperature=0.7)

chain = LLMChain(llm=llm, prompt=prompt)

result = chain.run(topic="量子计算")

但这一切对你来说是透明的。你看到的只是一个模板输入框、一个模型设置面板,和一条连接线。

实战中的价值:不只是“玩具级”工具

有人可能会质疑:这不就是个图形化玩具吗?真能解决实际问题?

恰恰相反,LangFlow已经在多个真实场景中展现出惊人的生产力提升。

快速验证AI客服可行性

一家电商公司想评估能否用LLM自动回答用户咨询。传统做法需要立项、排期、开发、测试,至少一周起步。而现在,他们的产品经理自己动手,在LangFlow中搭建了这样一个简单流程:

[用户输入] → [定制化Prompt] → [GPT-4] → [输出回复]

五分钟内完成配置,输入几条典型问题试跑,立刻就能判断回复质量是否达标。结果不满意?直接修改提示词再试一次。整个过程无需打扰任何工程师,决策效率提升了数十倍。

教育领域的非技术人员赋能

某高校教师希望让学生练习阅读理解题,但手动出题耗时费力。他和助教合作使用LangFlow设计了一个自动化流程:

[课文段落] → [Prompt: "生成5道选择题"] → [LLM] → [格式化输出]

老师不懂代码,但他清楚什么样的题目才符合教学要求。通过反复调整提示词并实时查看输出,他最终得到了满意的题目模板。更重要的是,这套流程可以复用——下次换一篇课文,只需替换输入内容即可。

团队协作标准化

在研发团队中,不同成员往往有自己的编码风格,导致项目交接困难。某AI创业公司将常用的工作流(如RAG检索增强生成)统一做成LangFlow模板,新成员入职时只需加载.json文件,就能直观理解系统的运作机制。所有流程还能一键导出为标准化代码,确保开发一致性。

这些案例说明了一个趋势:未来的AI开发,将是“可视化设计 + 精细化编码”的混合模式。LangFlow并不取代工程师,而是让他们从繁琐的原型搭建中解放出来,专注于更高价值的任务。

使用建议与边界认知

当然,任何工具都有其适用范围。我在实践中总结了几点关键经验:

别把画布变成“面条图”

我见过一些用户试图在一个流程里塞进二十多个节点,结果画布密密麻麻全是交叉线,比代码还难懂。记住:可视化的优势在于清晰表达逻辑关系,而不是容纳更多组件。合理的做法是按功能划分模块,必要时封装成自定义节点。

安全永远第一

虽然在节点中直接填写API Key很方便,但绝不能把这些包含密钥的.json文件提交到Git仓库。推荐做法是通过环境变量注入敏感信息,或者使用外部密钥管理系统。LangFlow支持从.env文件读取变量,合理利用这一特性可以大幅提升安全性。

成本意识不能丢

图形界面降低了使用门槛,但也容易让人忽略底层消耗。一次粗心的循环或不当的temperature设置,可能导致token用量激增。建议结合日志监控工具定期审查调用记录,特别是在接入计费API时。

生产环境仍需代码化

LangFlow最适合的阶段是探索、实验和原型验证。当流程稳定后,应导出为Python脚本,纳入CI/CD流程进行版本控制、自动化测试和灰度发布。你可以把它看作“草图工具”,最终交付物还是需要正规工程化处理。

为什么说它是AI时代的“Scratch”?

如果我们回顾编程教育的发展史,会发现Scratch这类图形化编程工具极大地推动了儿童编程普及。孩子们不用记忆语法,就能通过拼接积木块理解循环、条件、事件等核心概念。

LangFlow正在扮演类似的启蒙角色。很多初学者通过它第一次真正理解了什么是“提示模板注入”,什么是“链式调用”,什么是“代理决策流程”。他们在拖拽中学会了抽象,在调试中掌握了结构。

更重要的是,它打破了“只有会写代码的人才能驾驭AI”的固有认知。当一位语文老师能独立构建作文批改机器人,当一位市场专员能快速搭建竞品分析工具,我们才真正接近AI普惠的理想状态。

未来,随着对分支判断、循环控制、异步任务等高级特性的逐步支持,LangFlow有望成为AI工程的标准交互范式。它不一定出现在最终产品中,但一定会出现在每一个有价值想法的起点。

技术的终极目标从来不是制造更复杂的系统,而是让更多人有能力创造。在这个意义上,LangFlow不仅是一款工具,更是一种信念的体现:让创造力回归本质,让技术服务于思想。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?