LangFlow深度解析:为什么它是大模型开发者的新宠?

在构建一个能自动回答企业内部文档问题的AI助手时,你是否经历过这样的场景:刚写完一段LangChain代码,还没来得及测试,产品经理就发来新需求——“能不能换个提示词?再加个知识库检索?”于是你不得不再次修改函数调用、调整链式结构、重新运行脚本……这种高频迭代下的“编码疲劳”,正是当前大模型应用开发的真实缩影。

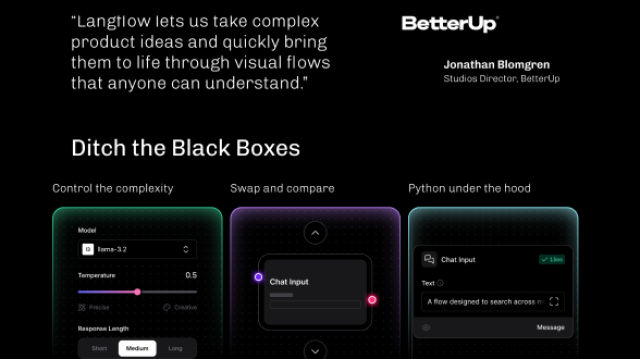

正是在这种背景下,LangFlow 悄然走红。它没有试图取代LangChain,而是换了一种方式与之共舞:把原本藏在代码里的工作流逻辑,变成一张可以拖拽、连线、实时预览的“思维导图”。越来越多开发者发现,他们可以在一杯咖啡的时间内,完成过去需要半天才能调试好的RAG原型。

这不仅仅是一个工具的进化,更是一种开发范式的迁移——从“写代码驱动AI”转向“设计流程驱动AI”。

LangFlow本质上是LangChain的图形化前端抽象层。它将LangChain中那些复杂的组件——比如LLM、提示模板、向量检索器、记忆机制等——封装成一个个可视化的节点(Node),用户只需通过浏览器界面拖拽和连接这些节点,就能构建出完整的AI工作流。整个过程无需编写任何Python代码,却又能生成与手写代码功能完全对等的执行逻辑。

它的运行机制分为三层:

-

前端交互层:所有操作都在Web界面完成。你可以从左侧组件库中选择“Chat Model”、“Prompt Template”或“Document Loader”,拖到画布上,设置参数,再用鼠标连线表示数据流向。

-

中间配置层:当你点击保存时,LangFlow会把整个流程的拓扑结构和参数配置序列化为一个

flow.json文件。这个JSON文件就像一份“蓝图”,记录了每个节点的位置、输入输出、连接关系以及具体配置。 -

后端执行层:当触发运行时,LangFlow服务端会解析这份JSON蓝图,动态实例化对应的LangChain对象,并按照依赖顺序执行节点。最终结果返回前端展示。

整个流程实现了“声明式定义 → 动态实例化 → 流程化执行”的闭环,既保留了LangChain的灵活性,又极大降低了使用门槛。

举个例子,下面是一个典型的检索增强生成(RAG)流程的数据流动示意:

[输入组件] → [提示模板] → [LLM模型] → [输出解析] → [响应展示]

↘ ↗

[向量数据库检索]

在传统开发模式下,你需要手动组合Retriever、PromptTemplate和LLM,处理上下文拼接、异步调用等问题;而在LangFlow中,只需要五个节点拖拽连接即可完成搭建,连非技术人员也能看懂其逻辑脉络。

LangFlow之所以能在短时间内赢得大量开发者青睐,关键在于它精准击中了现有开发模式中的几个痛点。

首先是开发门槛过高。LangChain虽然功能强大,但要求开发者熟悉Python语法、掌握其API层级结构,甚至要理解“链”、“代理”、“回调处理器”等抽象概念。而LangFlow通过可视化封装,让产品经理、学生、研究员也能快速上手,真正实现“所见即所得”。

其次是原型验证效率低下。在探索性项目中,团队往往需要快速尝试不同的模型组合、提示工程策略或数据源接入方式。传统编码方式每次变更都需重启服务、重新加载环境,反馈周期长。LangFlow支持实时预览每个节点的输入输出,修改后立即生效,A/B测试变得轻而易举。

再者是协作沟通成本高。工程师写的代码对非技术成员来说如同天书,而一张清晰的工作流图则能让所有人达成共识。某初创公司在开发智能客服系统时,产品经理直接用LangFlow搭建了一个初步流程原型,贴在会议室白板上作为讨论依据,大幅减少了需求误解。

更重要的是,LangFlow并不是一个“玩具级”工具。它支持将整个工作流导出为标准的Python脚本,这意味着你可以先在图形界面上完成快速验证,再一键迁移到生产环境中进行工程优化。这种“低代码原型 + 高代码部署”的混合开发路径,正成为许多团队的标准实践。

LangFlow还具备良好的扩展能力。如果你有自定义组件需求,可以通过继承基类注册新节点,例如封装公司内部的认证API或私有NLP服务。此外,它完全支持本地部署,不依赖云端服务,确保敏感数据不出内网,适用于金融、医疗等对安全性要求较高的行业场景。

下面是两种开发方式的对比,可以看出LangFlow在多个维度上的优势:

| 对比维度 | 传统LangChain开发 | LangFlow方案 |

|---|---|---|

| 开发门槛 | 高(需熟悉Python和API) | 低(图形化操作为主) |

| 原型迭代速度 | 慢(需反复修改代码) | 快(拖拽即时生效) |

| 团队协作效率 | 中等(依赖文档说明) | 高(流程可视,逻辑透明) |

| 调试便利性 | 依赖print/log | 支持节点级输入输出查看 |

| 生产集成能力 | 直接可用 | 可导出为Python代码无缝迁移 |

值得注意的是,LangFlow并未脱离LangChain生态。相反,它建立在其之上,共享同一套组件体系。以下是一段典型RAG流程的手动Python实现,实际上就是LangFlow背后可能自动生成的逻辑:

from langchain_community.chat_models import ChatOllama

from langchain.prompts import PromptTemplate

from langchain.schema import StrOutputParser

# 1. 定义LLM模型(例如使用本地Ollama运行的Llama3)

llm = ChatOllama(model="llama3")

# 2. 定义提示模板

prompt = PromptTemplate.from_template(

"你是一位助手,请根据以下上下文回答问题:\n{context}\n问题:{question}"

)

# 3. 构建链式流程

rag_chain = prompt | llm | StrOutputParser()

# 4. 执行调用

response = rag_chain.invoke({

"context": "LangFlow是一款可视化LangChain应用构建工具。",

"question": "LangFlow是什么?"

})

print(response)

代码说明:

上述代码展示了“提示模板→LLM→输出解析”这一核心链路的手动实现方式。在LangFlow界面中,这三个组件分别对应三个独立节点,用户只需填写参数并连线即可完成相同功能,系统会自动生成功能等价的执行逻辑。

不仅如此,LangFlow还提供了REST API接口,可用于程序化控制流程加载与执行,便于集成到自动化测试或CI/CD流程中:

# 启动LangFlow服务

uvicorn langflow.main:app --host 0.0.0.0 --port 7860

# 调用指定flow执行

curl -X POST http://localhost:7860/api/v1/process \

-H "Content-Type: application/json" \

-d '{

"flow_id": "my_rag_flow",

"inputs": {"question": "LangFlow有什么用?"}

}'

这让它不仅能作为开发工具,还可嵌入企业级AI平台,承担流程编排与调度的角色。

在整体AI开发架构中,LangFlow处于“开发设计层”,位于LangChain框架之上、应用系统之下,扮演着“配置管理中心”和“流程编排器”的角色。它的典型系统架构如下:

+---------------------+

| 最终用户 / 开发者 |

+----------+----------+

|

v

+----------+----------+

| LangFlow GUI | ← 可视化编辑、调试、导出

+----------+----------+

|

v

+----------+----------+

| LangChain Runtime | ← 执行实际逻辑(LLM调用、链执行等)

+----------+----------+

|

v

+----------+----------+ +-------------------+

| 外部资源集成 +<--> 向量数据库、APIs、文件系统等

+---------------------+

它并不直接参与模型推理或数据存储,而是协调各组件协同工作的“指挥官”。

在一个典型的使用流程中,开发者通常经历以下几个阶段:

- 启动服务:通过

langflow run命令启动本地服务,默认打开Web界面; - 创建新流程:在空白画布上开始添加节点;

- 配置组件:选择LLM模型(如GPT-4或本地Ollama)、设置提示词、接入知识库;

- 连接节点:按数据流向建立连接;

- 运行调试:输入测试问题,观察各节点输出;

- 导出部署:将流程导出为JSON或Python脚本,用于后续集成。

在这个过程中,有几个关键的设计考量值得特别注意:

- 模块粒度要合理:避免在一个画布上堆积上百个节点。建议按功能拆分为多个子流程(Sub-flow),提升可维护性。

- 关注组件兼容性:并非所有LangChain组件都已完整支持,某些高级特性如流式输出、异步处理可能受限,需确认版本匹配。

- 性能监控不可忽视:图形化界面容易让人忽略延迟问题。可在关键节点插入计时器,评估整体响应时间。

- 安全配置必须到位:若部署在公网,务必启用身份认证,防止未授权访问导致信息泄露。

- 版本管理要配套:

flow.json文件应纳入Git管理,配合注释记录变更内容,便于团队协作与回溯。

在实际应用中,LangFlow已在多个场景中展现出强大的问题解决能力。

比如,在一家企业尝试构建基于私有文档的智能客服时,面临频繁更换模型、调整提示词和测试不同检索策略的需求。传统方式下每次变更都要修改代码、重启服务,耗时且易出错。借助LangFlow,团队仅用30分钟就搭建出完整RAG原型:拖入“Document Loader”读取PDF,连接“Text Splitter”切分文本,接入“Embedding Model”和“FAISS Vector Store”建立索引,最后与“LLM”组合生成答案。整个过程支持实时切换模型和提示词进行A/B测试,极大提升了实验效率。

另一个典型场景是跨职能团队协作。以往产品经理提出AI功能设想,常因表达不清导致工程师实现偏离预期。现在,产品经理可以直接使用LangFlow搭建一个初步流程原型,直观展示期望的行为逻辑。这张可视化流程图成为技术与业务之间的共同语言,显著减少沟通成本。

在教学培训领域,LangFlow也表现出色。学生初学LangChain时常陷入API细节,难以把握整体架构。教师可通过LangFlow演示“链如何传递数据”、“代理如何决策”、“记忆如何维持状态”,并通过颜色标记、动画播放等方式增强理解。学生无需编码即可动手实验,快速建立对AI工作流的整体认知。

LangFlow的兴起,标志着AI开发正在经历一场静默的革命。它没有颠覆LangChain,也没有否定代码的价值,而是提供了一种更高效、更直观的方式来组织复杂逻辑。对于个人开发者而言,它是提升生产力的利器;对于企业来说,它是加速AI创新节奏的战略工具。

未来,随着AI原生应用的不断涌现,类似LangFlow的可视化编排平台有望成为AI时代的“IDE”,正如Visual Studio之于传统软件开发。它们不会替代程序员,但会重新定义“编程”的边界——从逐行书写代码,转向更高层次的流程设计与系统思考。

掌握这类工具,不仅是掌握一种技能,更是拥抱下一代人机协作方式的关键一步。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?