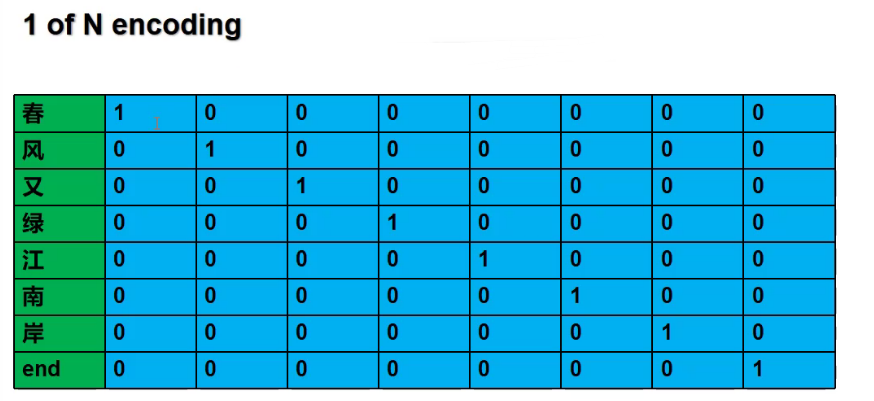

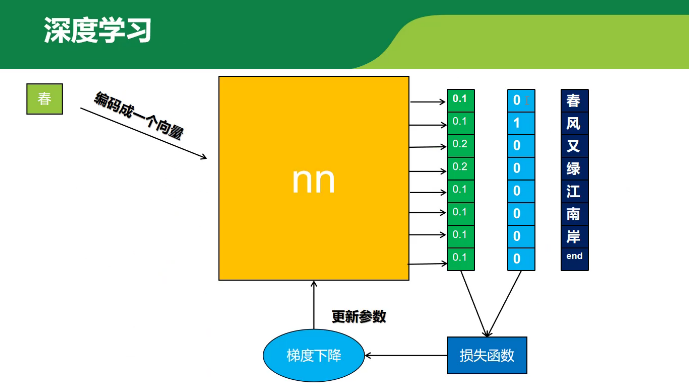

要先将字编码成向量

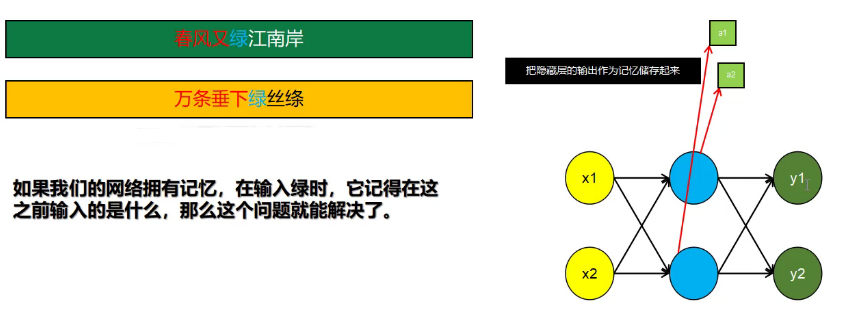

要对之前的信息有记忆

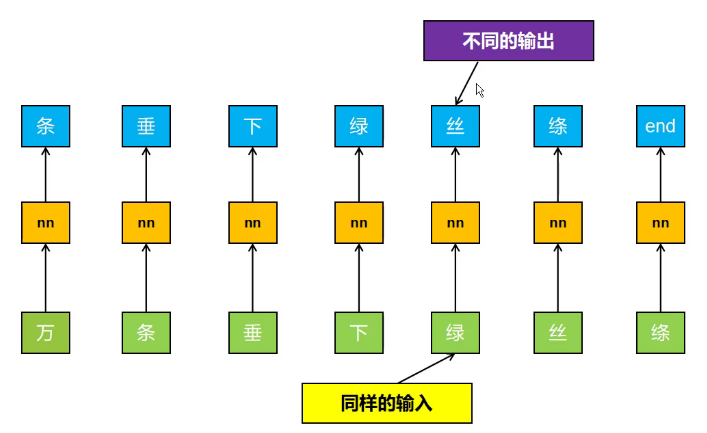

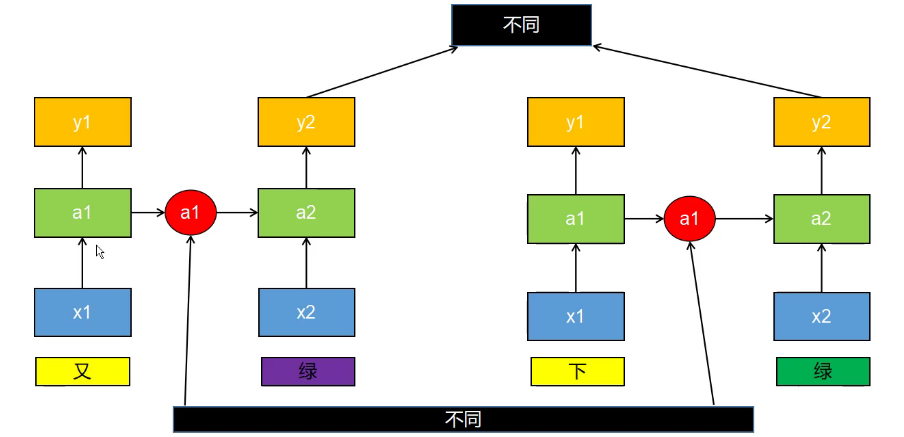

相同的输入,写诗,可能有不同的输出。

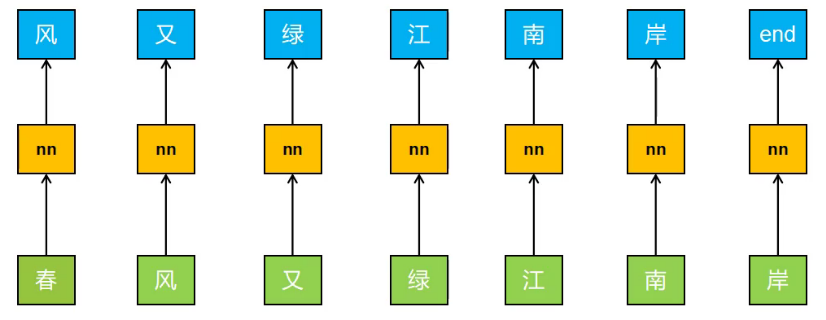

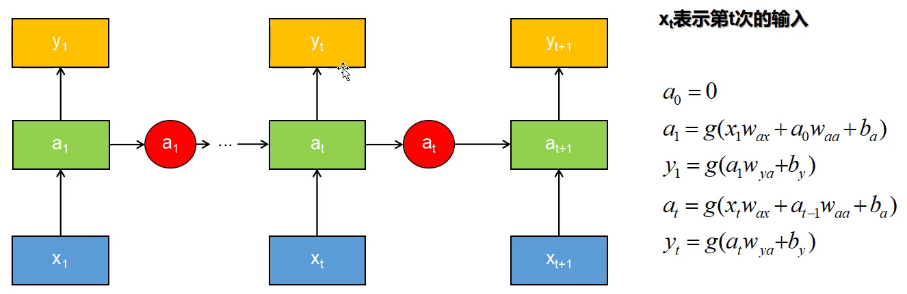

可以发现,输入不止与当前输入有关,还和之前的输入有关。要有记忆!

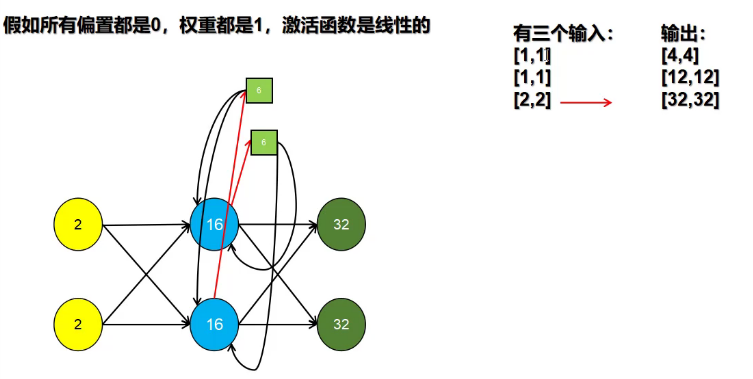

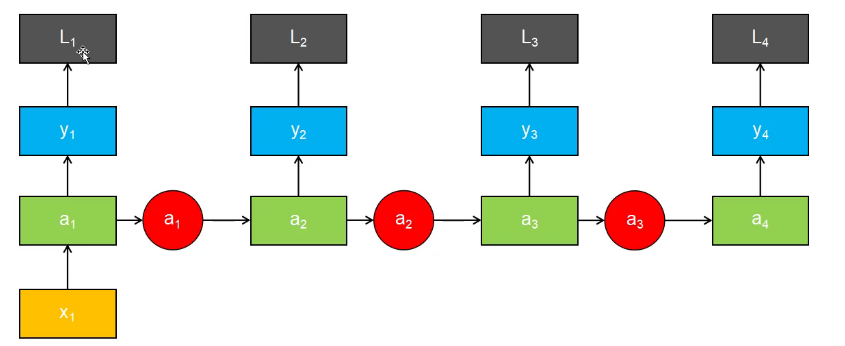

将隐藏层的激活值利用

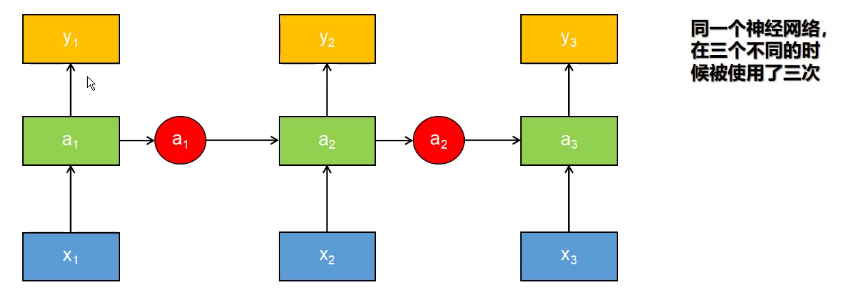

循环神经网络

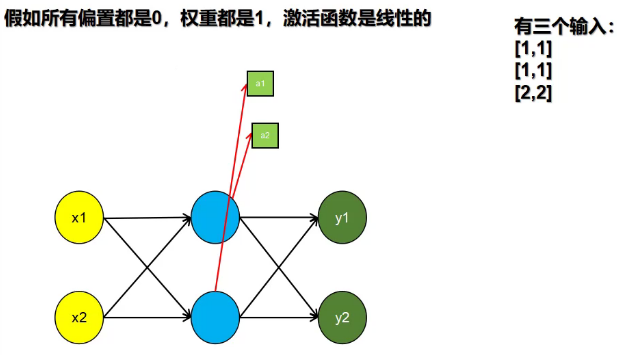

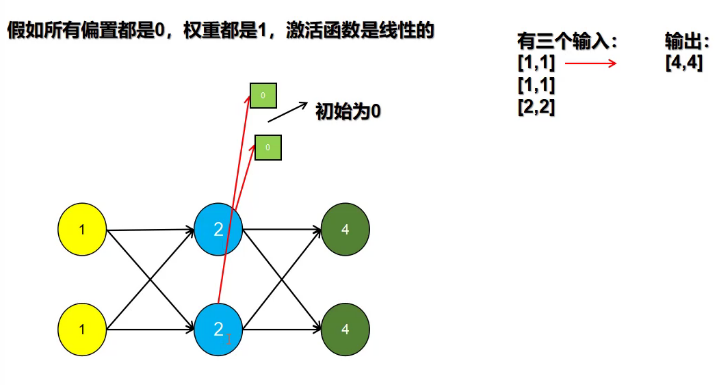

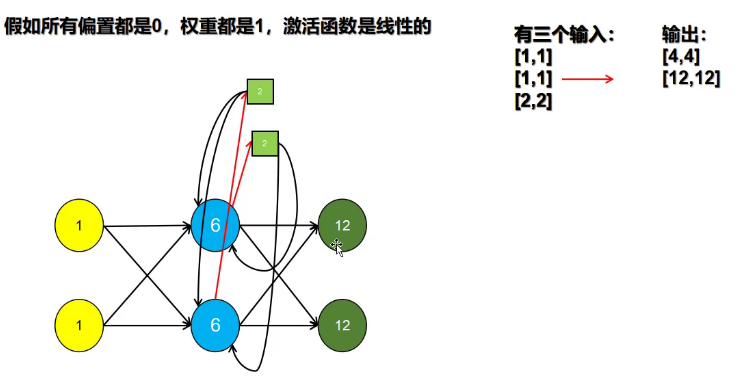

a0=0,初始值=0

上次输入的不同,记忆值不同,使得现在相同的输入可以得到不同的输出。

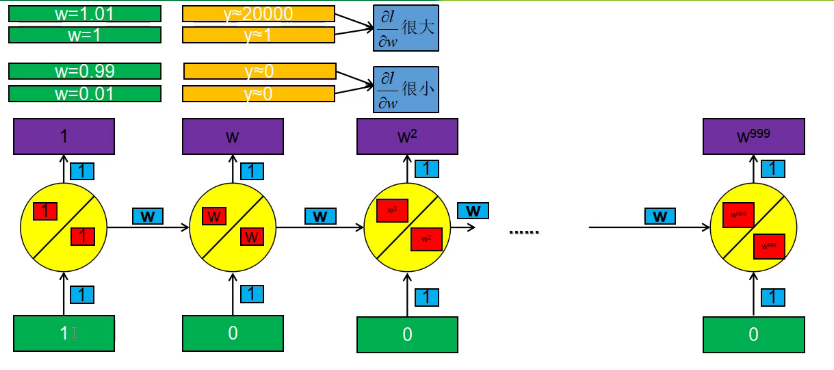

缺点:梯度爆炸和梯度消失

记忆值不断相乘累加。w^n

梯度爆炸和梯度消失:wn(w>1和w<1)。

w'=w-a*Δ

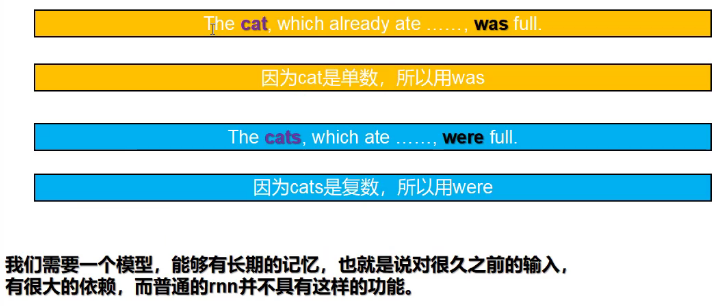

需要一个模型,能够记忆久远输入和近期遗忘。

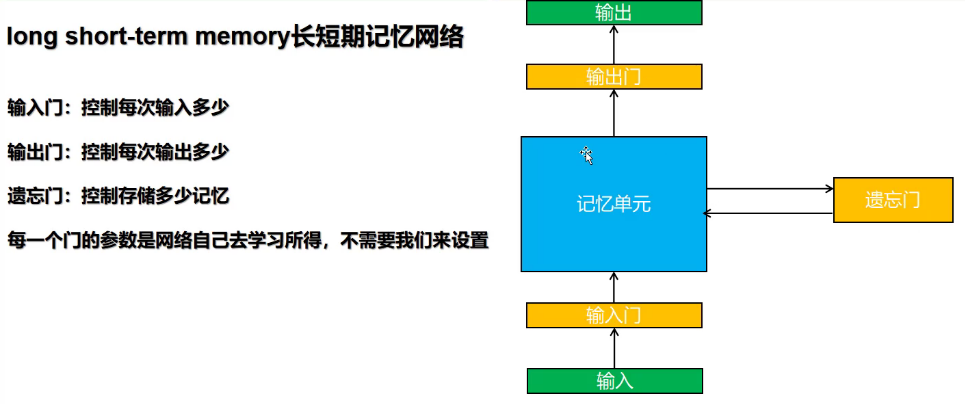

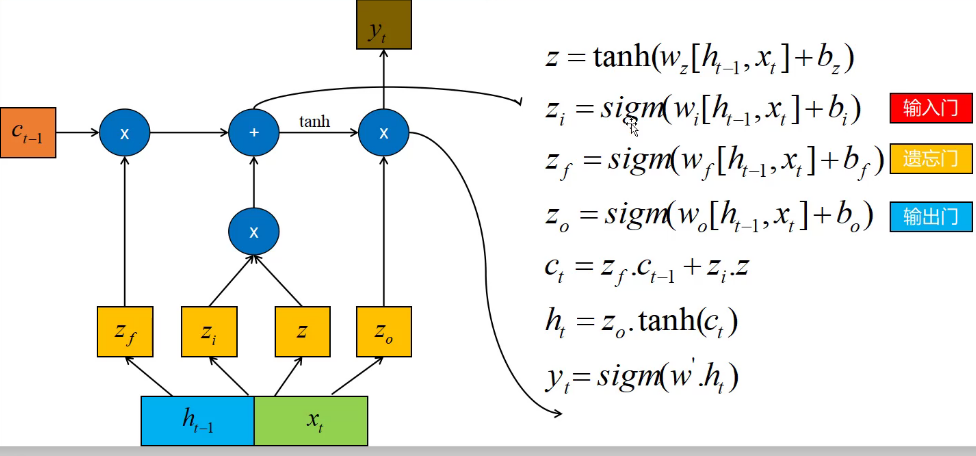

LSTM::long short-term memory长短期记忆网络

加入输入门、输出门和遗忘门。使用sigmod函数。

sigmod函数:0-1之间。中点0.5

LSTM:

f:遗忘门,forget gate

循环神经网络分类概述:

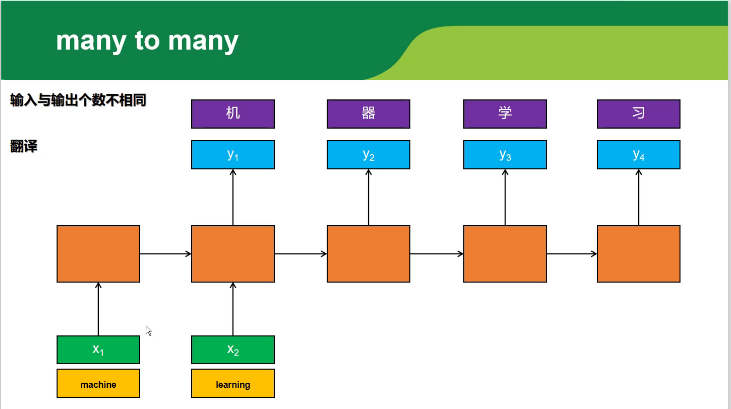

many to many:

- 有多少输入,就多少输出

- 输入输出数目不等

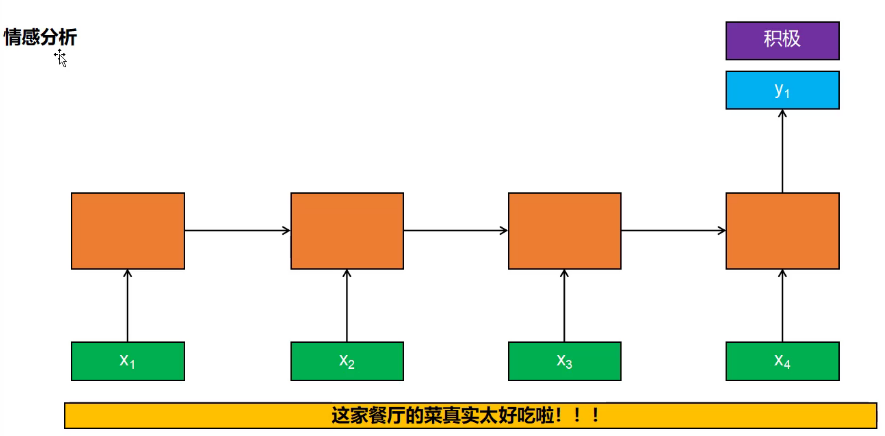

many to one

情感分析,差评还是好评。

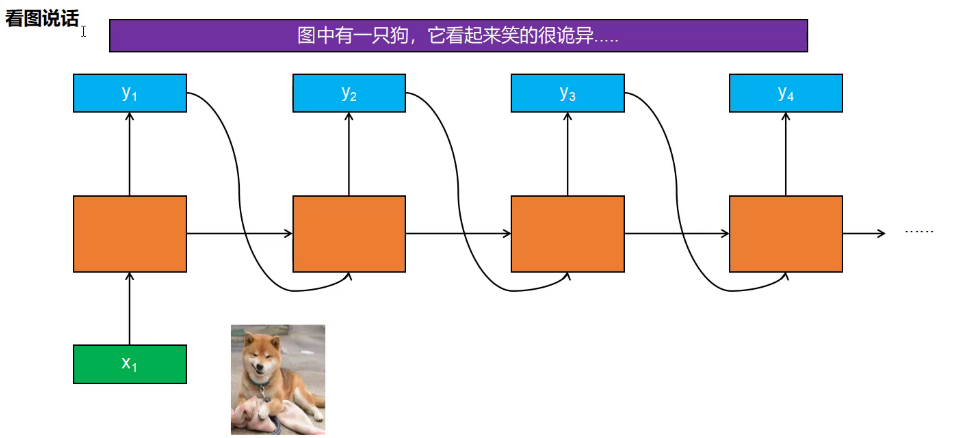

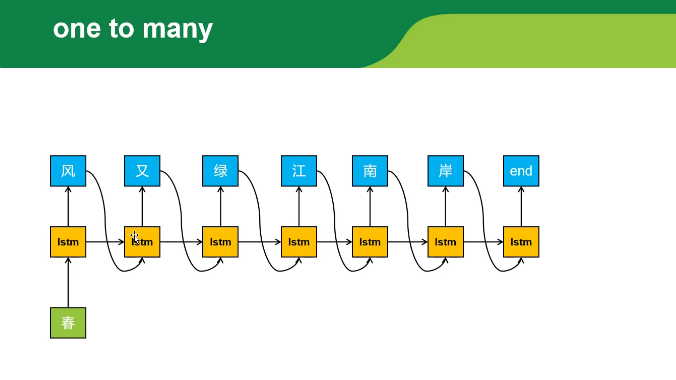

one to many

看图说话,写诗就是这个模型。

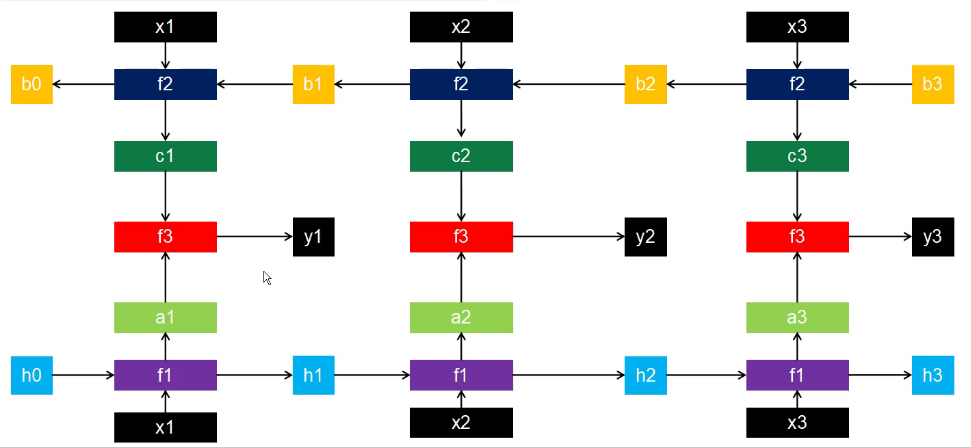

双向循环网络:

不止和之前输入有关,还和之后的输入相关。

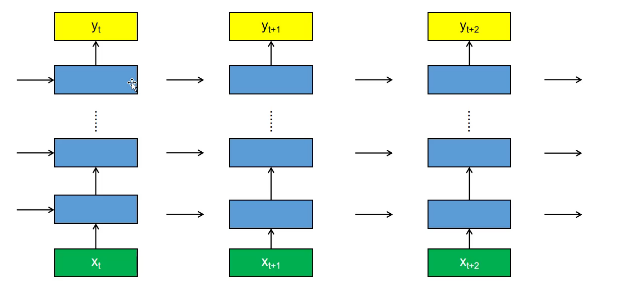

深度循环神经网络:

很多隐藏层

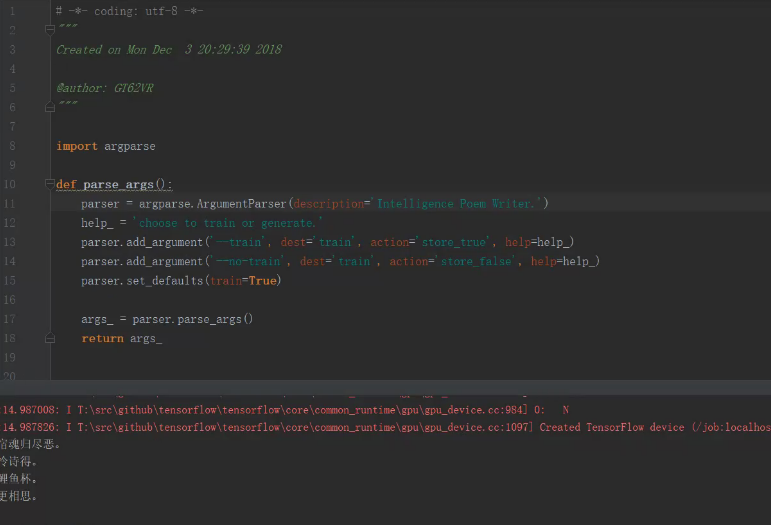

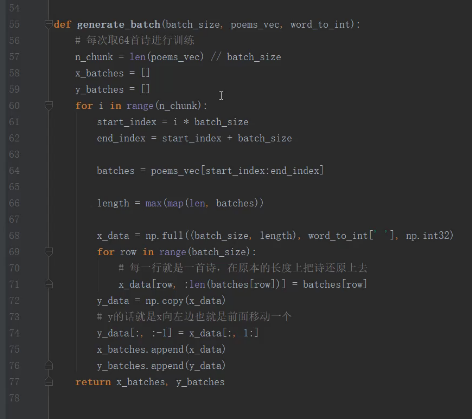

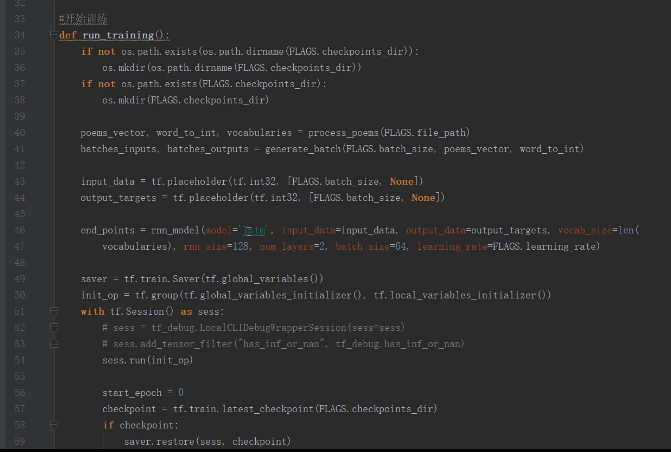

作诗用的是lstm:只输入第一个字,一个一个输出接着作诗。

L1+L2+...+Ln

再求梯度。

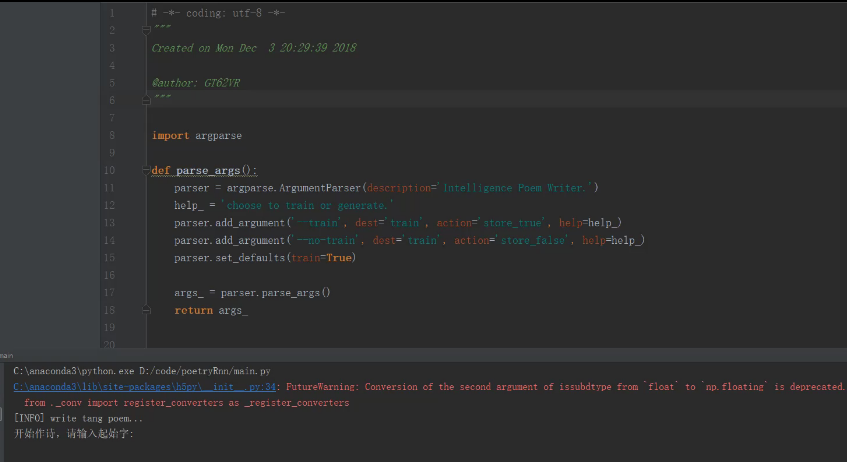

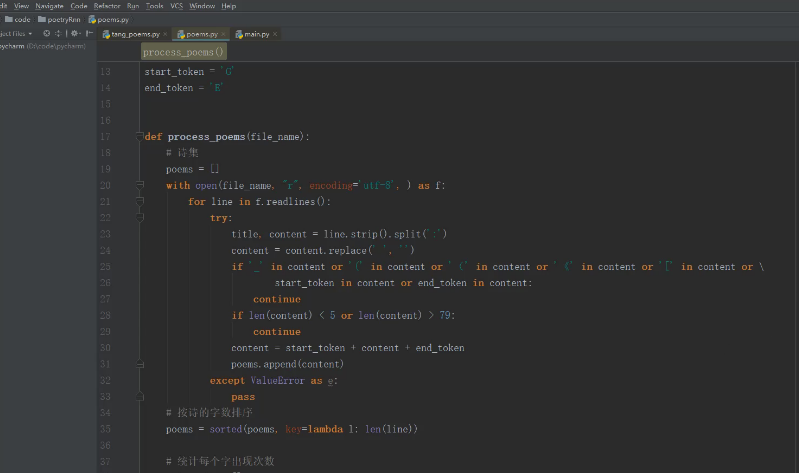

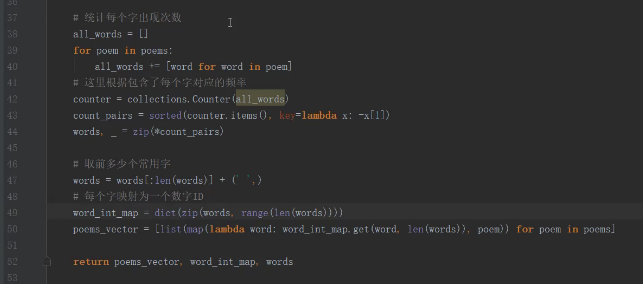

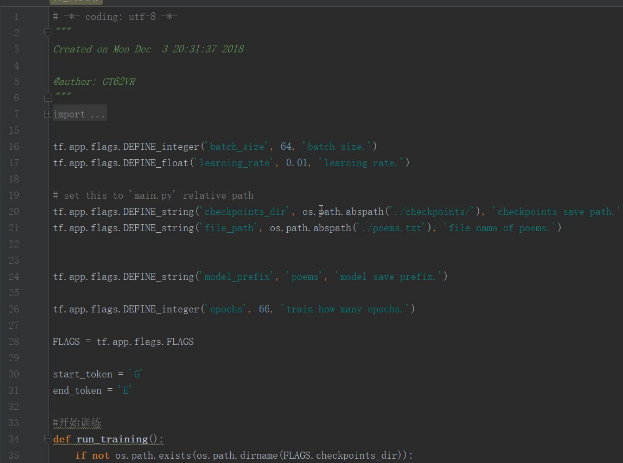

代码:

本文深入探讨了循环神经网络(RNN)的工作原理,强调其记忆特性在处理序列数据时的重要性,同时揭示了RNN面临的梯度消失与爆炸问题。文章详细介绍了LSTM(长短期记忆网络)作为解决方案,通过输入门、输出门和遗忘门机制,有效解决了长期依赖问题,使网络能够记住更久远的输入并适时遗忘不相关信息。

本文深入探讨了循环神经网络(RNN)的工作原理,强调其记忆特性在处理序列数据时的重要性,同时揭示了RNN面临的梯度消失与爆炸问题。文章详细介绍了LSTM(长短期记忆网络)作为解决方案,通过输入门、输出门和遗忘门机制,有效解决了长期依赖问题,使网络能够记住更久远的输入并适时遗忘不相关信息。

1772

1772

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?