一.前言

Hadoop是一个由Apache基金会所开发的分布式系统基础架构,说白了就是一个庞大的任务,一台机器处理不过来,就分割成若干个子任务,让若干个机器来处理,最后将结果汇总。刚接触hadoop可能理解的不透彻,但是这都不重要,先把它安装下来再说,这里把我的整个安装步骤纪录下来。

二.安装Hadoop

1.创建一个专门的hadoop管理员用户

命令行执行:

//创建组用户

sudo addgroup hadoop

sudo adduser -ingroup hadoop hadoop

//配置权限

sudo vim /etc/sudoers

文件内添加 hadoop ALL=(ALL:ALL) ALL

//创建hadoop文件夹并将属主用户改为hadoop

sudo mkdir /hadoop

sudo chown -R hadoop:hadoop hadoop

2.配置hadoop用户ssh无密码登录

命令行执行:

su hadoop

ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

用ssh localhost测试一下是否还需输密码登录,如果还要密码,可能是根目录的权限问题。

3.安装jdk

首先java -version看一下是否安装java环境,如出现jvm版本号信息,则表示已有java环境,我的是会出现系统默认安装的openjdk,这里我把它卸载重新安装了jdk,步骤如下:

卸载自带的openjdk:

sudo apt-get purge openjdk*

进入oracle官网http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html下载适合版本的jdk

将安装包jdk-8u45-linux-i586.gz解压并copy到/usr/java下

sudo tar -zxvf jdk-8u45-linux-i586.gz

cp -r jdk-8u45-linux-i586.gz /usr/java

配置环境变量:

sudo vim /etc/profile

写入:

export JAVA_HOME=/usr/java/jdk1.8.0 _45

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${PATH}:${JAVA_HOME}/bin:${JRE_HOME}/bin

保存退出执行

source /etc/profile

修改系统jdk:

命令行执行

官网下载hadoop,我下载的是hadoop-1.2.1.tar.gz

解压到之前新建的hadoop文件夹里

配置hadoop环境变量:

export HADOOP_HOME_WARN_SUPPRESS=1

export HADOOP_HOME=/hadoop/hadoop-1.2.1

export PATH=${PATH}:${HADOOP_HOME}/bin:${JAVA_HOME}/bin:${JRE_HOME}/bin

进入conf文件夹更改4个配置文件:

1.hadopp-env.sh

2.mapred-site.xml

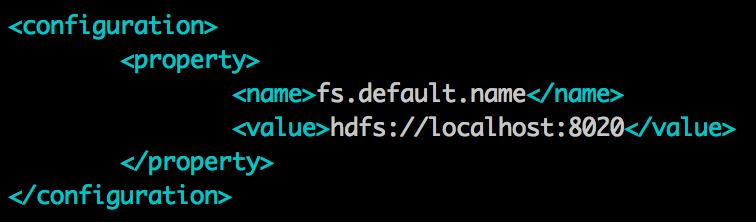

3.core-site.xml

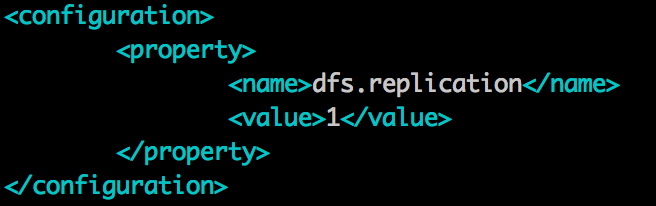

4.hdfs-site.xml

这几个文件都只是一些简单的默认配置

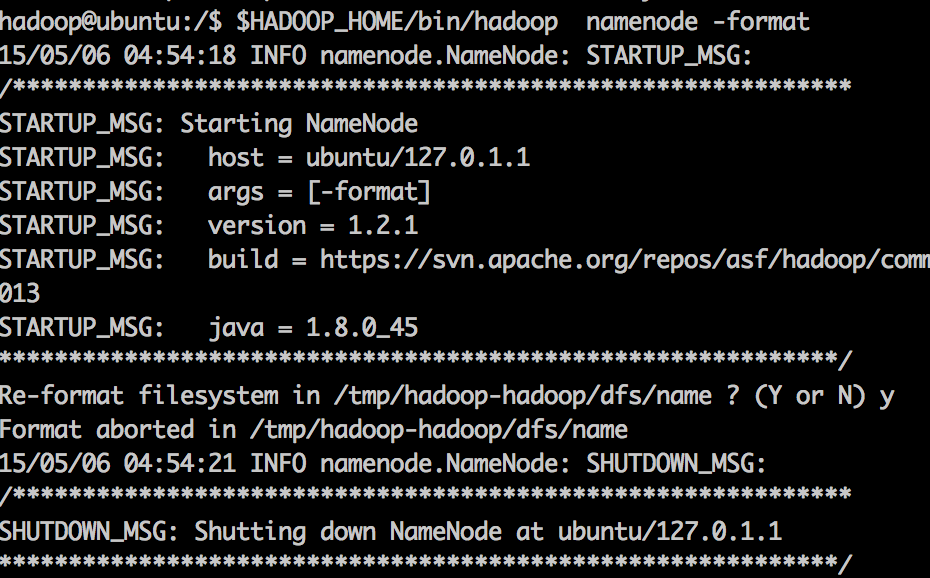

格式化hdfs:

命令行执行

$HADOOP_HOME/bin/hadoop namenode -format

出现下图即成功

启动hadoop:

命令行执行

$HADOOP_HOME/bin/start-all.sh

出现下图则成功

停止hadoop的命令为:

$HADOOP_HOME/bin/stop-all.sh

至此,hadoop的简单搭建就完成了,接下来就是深入了解~~

本文详细介绍Hadoop的安装步骤,包括创建管理员用户、SSH无密码登录配置、JDK安装及环境变量配置、Hadoop安装与环境配置等关键环节,并提供启动与停止Hadoop的方法。

本文详细介绍Hadoop的安装步骤,包括创建管理员用户、SSH无密码登录配置、JDK安装及环境变量配置、Hadoop安装与环境配置等关键环节,并提供启动与停止Hadoop的方法。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?