一、原有模型的架构

biLSTM + CRF

二、对原有模型加入注意力机制

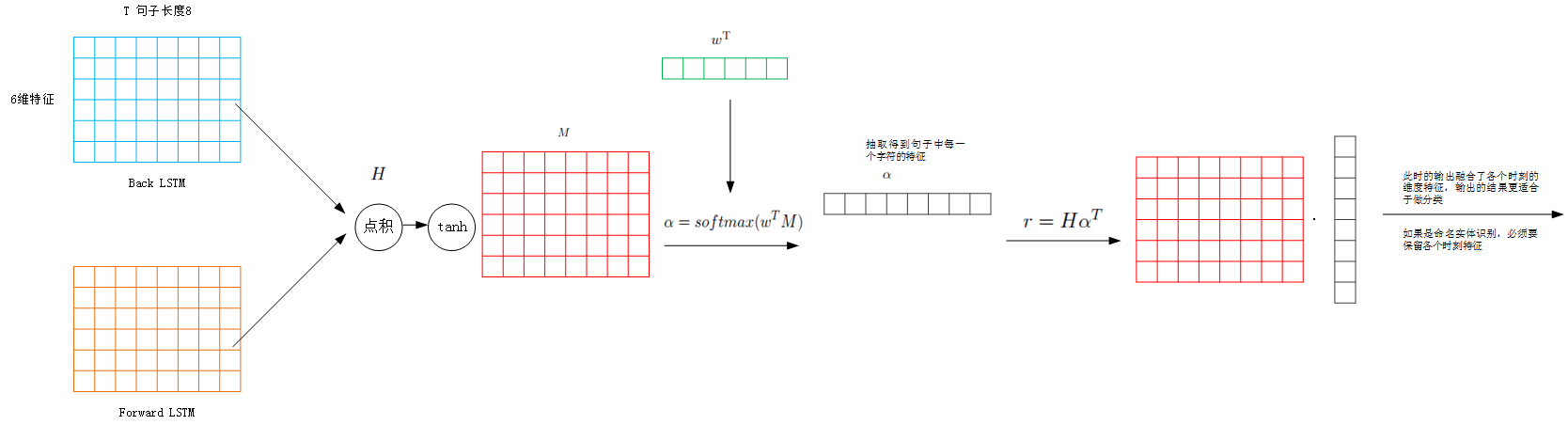

LSTM输出层加入注意力,参考文章:《Attention-Based Bidirectional Long Short-Term Memory Networks for Relation Classification》,该文章是用于文本实体关系分类的,其思想借用到本文

细节:

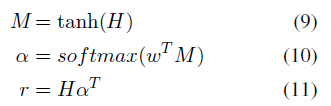

1)作者将前向和后向LSTM得到的特征,不是做拼接操作,而是元素点积

2)对该层结果加入注意力

3)获得句子的整体表示

4)最后放入分类器中,用于分类

三、流程图

四、移植到命名实体识别中

未完待续

本文探讨了在原有的biLSTM-CRF模型基础上引入注意力机制的方法,通过借鉴《Attention-Based Bidirectional Long Short-Term Memory Networks for Relation Classification》的思想,详细介绍了如何在LSTM输出层加入注意力,并最终应用于命名实体识别任务。

本文探讨了在原有的biLSTM-CRF模型基础上引入注意力机制的方法,通过借鉴《Attention-Based Bidirectional Long Short-Term Memory Networks for Relation Classification》的思想,详细介绍了如何在LSTM输出层加入注意力,并最终应用于命名实体识别任务。

1073

1073

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?