origin url

| The First Column | The Second Column |

|---|---|

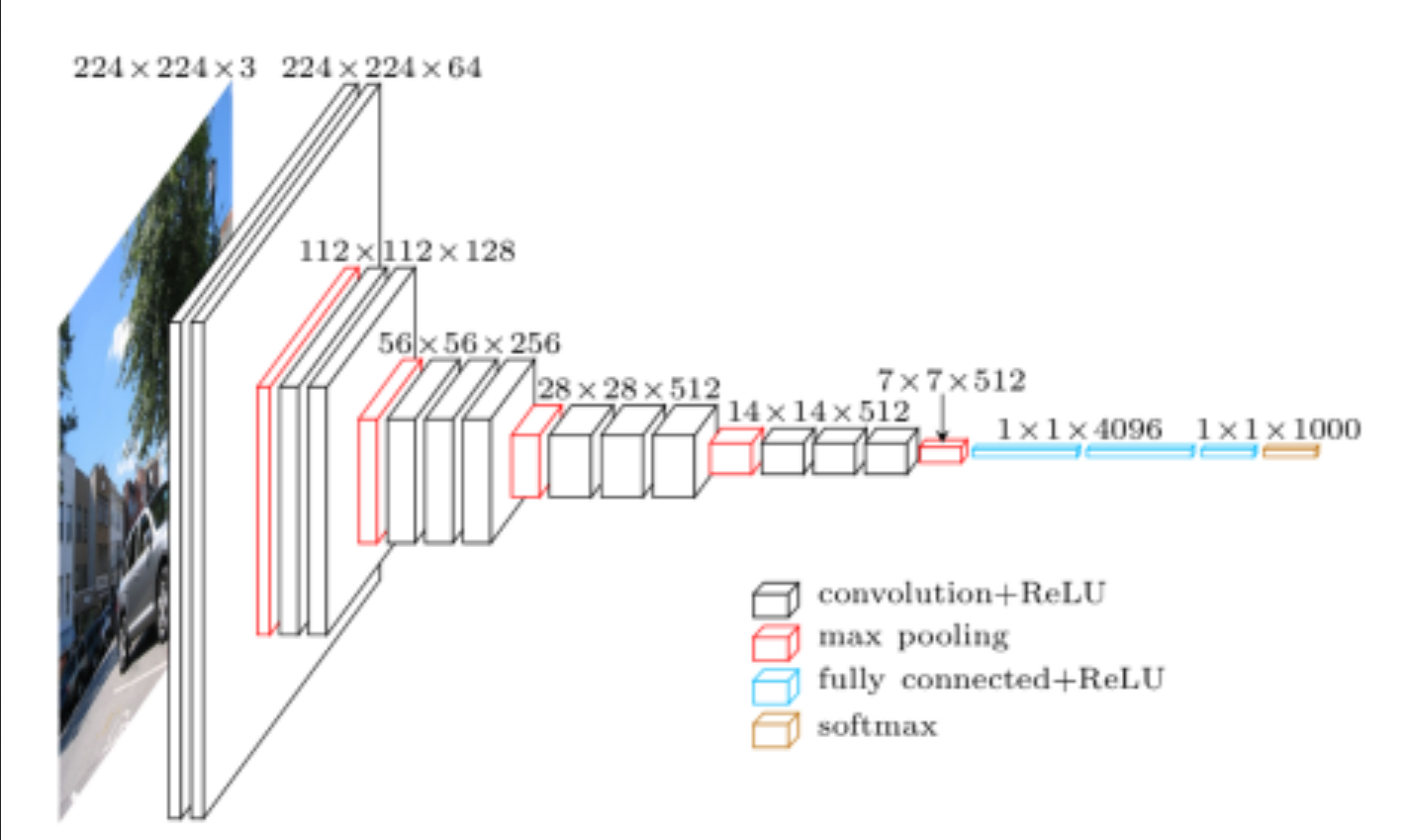

| VGG 网络结构 |  |

| Keras 中的 keep_prob | Dropout 的自由率 |

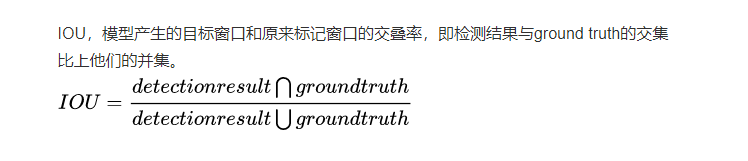

| IOU |  |

| 全连接层 |  |

| 全局平局池化 (Global Average Pooling) 与Fully Connected Lays |  |

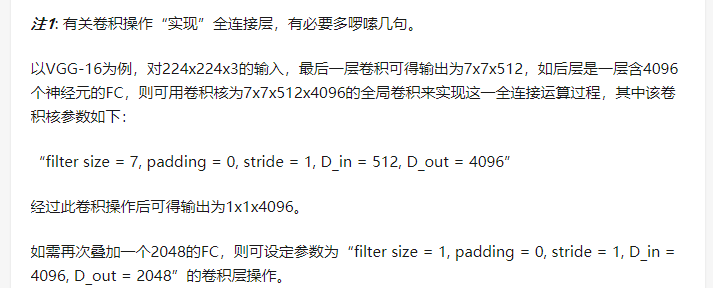

| VGG-16的全连接层 |  |

| fine_tuning classes 1000 -> classes 101效果 更差的原因 |  |

| 多继承 |  |

| 接口 |  |

| 分类器 |  |

| 如何评价一个分类器 |  |

| AUC |  |

| AUC | ROC曲线下面的面积 |

| AUC | Area under curve |

| AUC | 模型对分类问题的预测结果都是概率, 如果要计算 |

| 全连接层到 损失层之间的计算 |  |

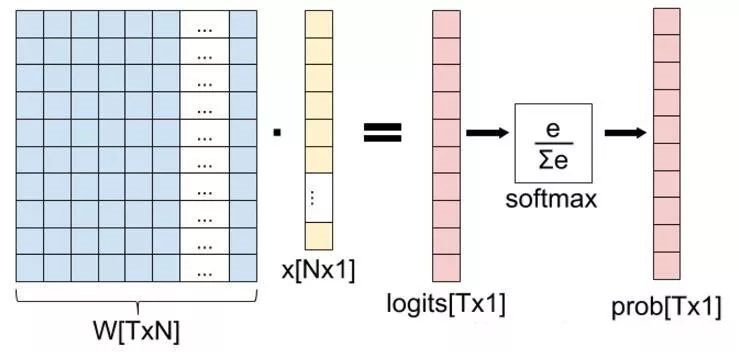

| W | 全连接层的参数,也称为权值 |

| X | 全连接层的输入,也就是特征 |

| 全连接层 |  |

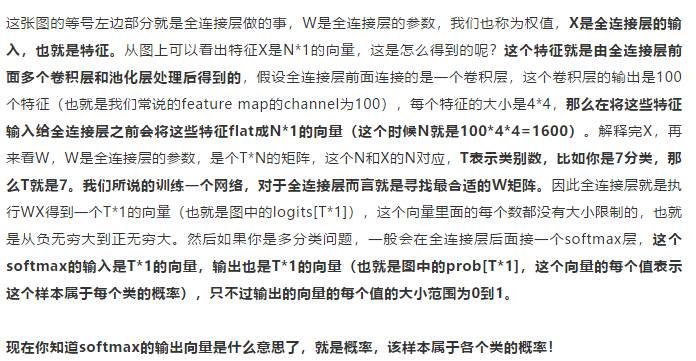

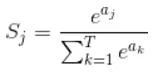

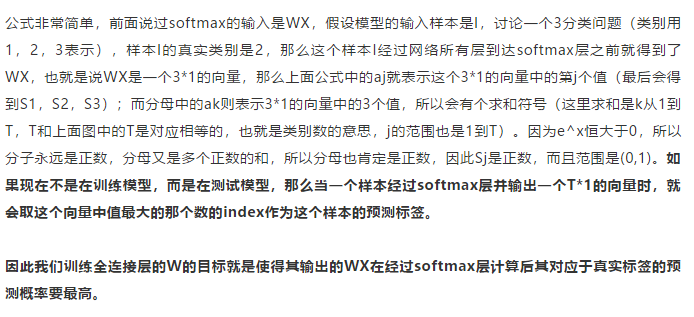

| softmax 公式 |  |

| softmax公式解释 |  |

| softmax 的3分类例子 |  |

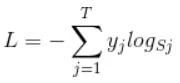

| softmax loss |  |

| softmax loss 公式解释 |  |

| softmax Loss 的5分类例子 |  |

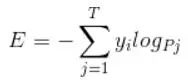

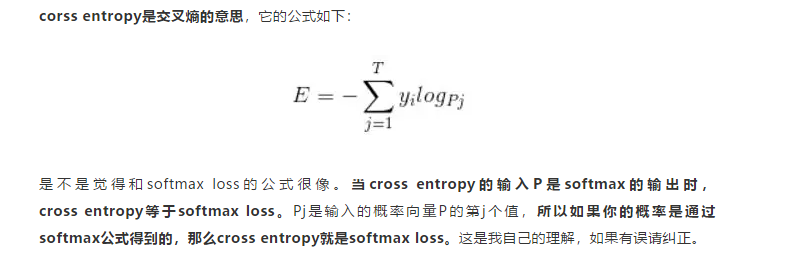

| cross Entropy 公式 |  |

| cross Entropy 公式解释 |  |

本文深入探讨了深度学习领域的关键概念,包括VGG网络结构、Keras中Dropout的使用、全连接层的工作原理、全局平均池化的作用、softmax函数及交叉熵损失函数的数学解释,并分析了softmax函数在多分类任务中的应用实例。

本文深入探讨了深度学习领域的关键概念,包括VGG网络结构、Keras中Dropout的使用、全连接层的工作原理、全局平均池化的作用、softmax函数及交叉熵损失函数的数学解释,并分析了softmax函数在多分类任务中的应用实例。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?