集群配置:

jdk1.8.0_161

hadoop-2.6.1

linux系统环境:Centos6.5

创建普通用户 dummy

设置静态IP地址

Hadoop伪分布式集群搭建:

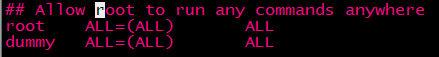

为普通用户添加sudo权限:

设置之前必须得安装sudo,先su 输入密码进入root用户,执行 yum install sudo

安装完后修改sudo配置文件 vi /etc/sudoers

进入配置文件,输入/root 查找root 按N下一个,直到找到

原本只有一行的,下面是自己复制上面的,改一下用户名,添加完成按Esc 再输入:wq保存退出

注意:修改只读文件时,可以先 chmod u+w 只读文件名 修改文件的权限(u代表用户,+w代表增加可写),修改完之后再 chmod u-w 只读文件名 还原权限

服务器网络设置:NAT模式

SecureCRT远程连接:

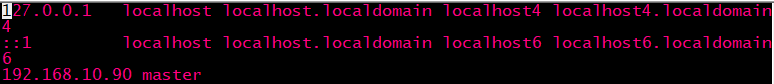

域名设置: vi /etc/hosts

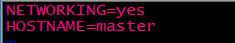

主机名设置:

root身份:vi /etc/sysconfig/network

普通用户身份:sudo vi /etc/sysconfig/network

重启服务器init 6

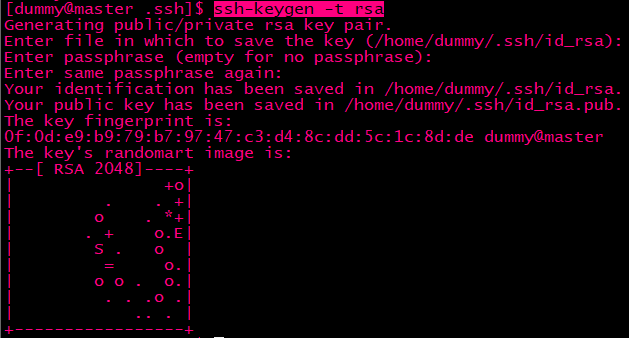

SSH免登录配置:

如果没有就创建.ssh:mkdir .ssh

cd .ssh进入.ssh

rm -rf *删除所有文件

输入ssh-keygen -t rsa,敲三次回车

然后ssh-copy-id master 输入yes 再输入密码

关闭防火墙:

进入root,chkconfig iptables --list 查看防火墙

chkconfig iptables off 关闭防火墙(每台主机都关掉)

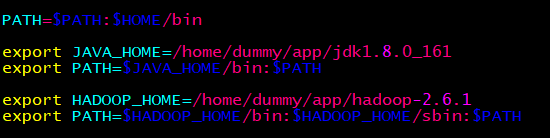

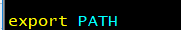

修改环境变量:

vi ~/.bash_profile

最后

保存退出后要 source ~/.bash_profile 让配置文件生效

修改配置文件:

进入hadoop的安装目录

1、编辑etc/hadoop/core-site.xml

<property>

<!-- 指定HDFS中NameNode的地址 -->

<name>fs.defaultFS</name>

<value>hdfs://master:9000</value>

</property>

<!-- 指定hadoop临时目录 -->

<property>

<name>hadoop.tmp.dir </name>

<value>/home/dummy/app/hadoop-2.6.1/hdpdata</value>

</property>

<configuration>

<!-- 指定HDFS副本的数量,默认为3 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

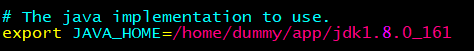

修改JAVA_HOME的路径

4、编辑etc/hadoop/slaves

#指定在哪几台机启动datanode, 伪分布写一个就可以了(namenode和datanode在同一主机)

master

第一次启动hdfs,首要进行格式化处理,在/bin目录下

hdfs namenode -format

启动hdfs,首先启动namenode,/sbin目录下

hadoop-daemon.sh start namenode

再启动datanode /sbin目录下

hadoop-daemon.sh start datanode

通过jps,查看进程,是否存在namenode和datanode的进程

本文详细介绍如何在Centos6.5环境下,使用Hadoop-2.6.1和JDK1.8.0_161搭建Hadoop伪分布式集群,包括配置静态IP、设置sudo权限、SSH免登录、修改环境变量及核心配置文件等步骤。

本文详细介绍如何在Centos6.5环境下,使用Hadoop-2.6.1和JDK1.8.0_161搭建Hadoop伪分布式集群,包括配置静态IP、设置sudo权限、SSH免登录、修改环境变量及核心配置文件等步骤。

1428

1428

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?