1.用Hive对爬虫大作业产生的文本文件(或者英文词频统计下载的英文长篇小说)词频统计。

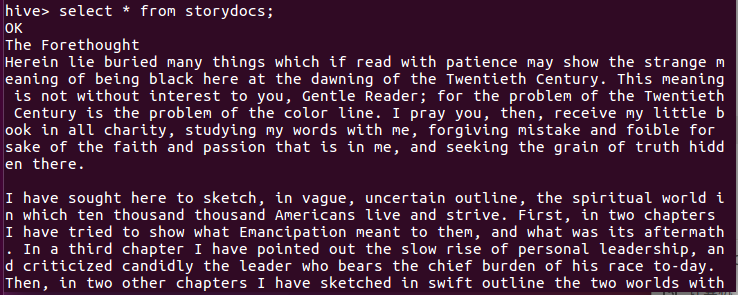

对英文长篇小说The Souls of Black Folk进行词频统计

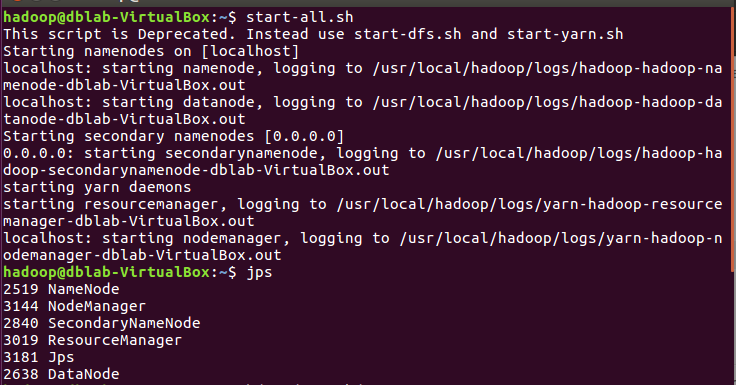

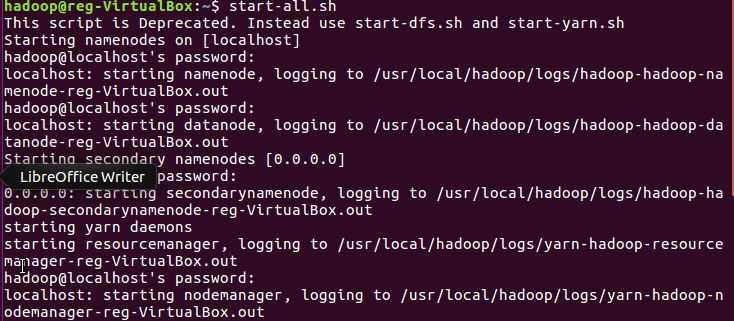

1.start-all.sh

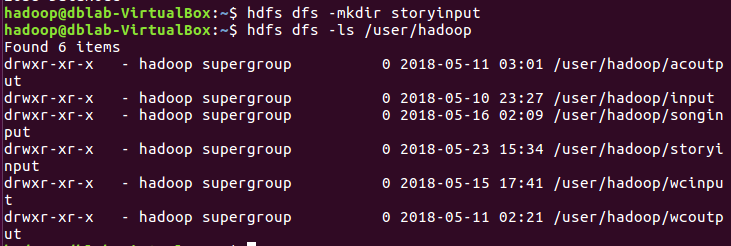

创建文件夹

1.hdfs dfs-mkdir storyinput

2.hdfs dfs-ls/usr/hadoop

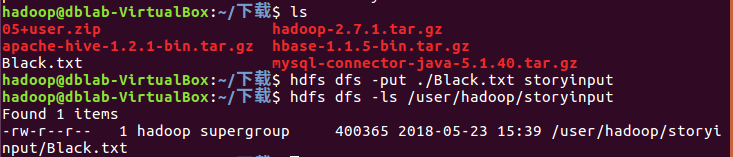

上传文件至hdfs:

下载story.txt保存在~/下载里,查询目录,上传至hdf

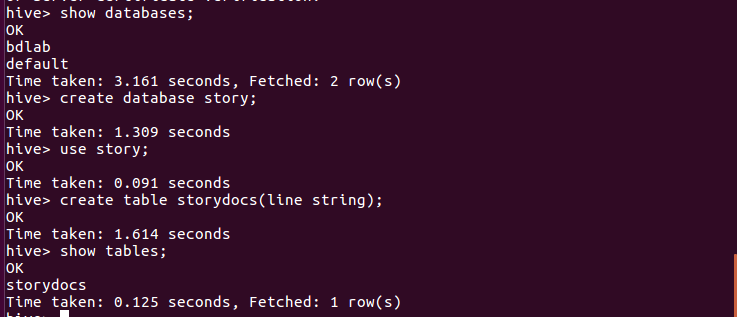

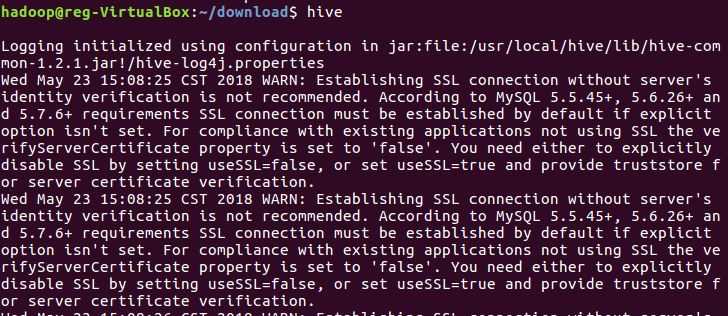

启动Hive

创建数据库story,在数据库里建原始文档表

导入文件内容到表storydocs

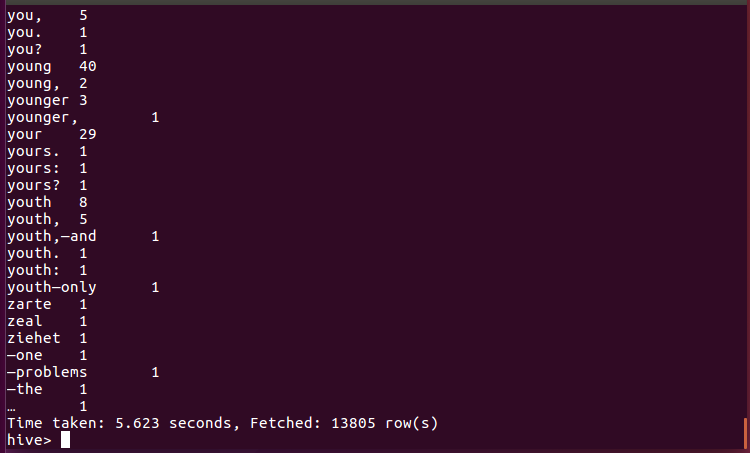

用HQL进行词频统计,结果放在表story_count里查看统计结果

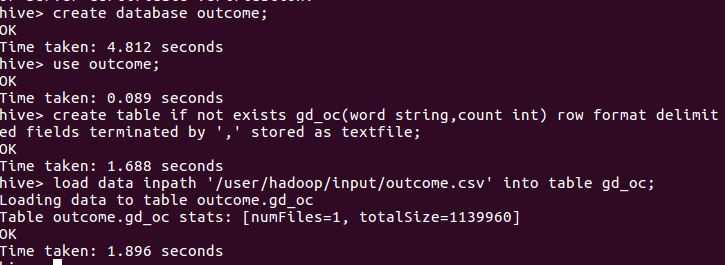

2.用Hive对爬虫大作业产生的csv文件进行数据分析,写一篇博客描述你的分析过程和分析结果。

将数据以csv格式上传到hdfs

进入文件路径并查看数据前5

将文件上传到HDFS上

查看上传成功的文件的前20个数据

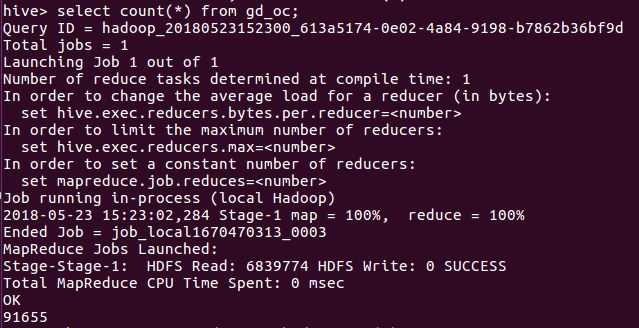

查看数据总条数

本文介绍如何使用Hive对英文长篇小说进行词频统计,并对爬虫产生的CSV文件进行数据分析。首先通过一系列HDFS命令上传和管理文件,然后在Hive中创建数据库及表,导入数据并运用HQL进行词频统计。此外还展示了CSV文件的数据分析流程。

本文介绍如何使用Hive对英文长篇小说进行词频统计,并对爬虫产生的CSV文件进行数据分析。首先通过一系列HDFS命令上传和管理文件,然后在Hive中创建数据库及表,导入数据并运用HQL进行词频统计。此外还展示了CSV文件的数据分析流程。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?