前言

其实cloudera已经做了这个事了,只是把kafka的包和cdh的parcel包分离了,只要我们把分离开的kafka的服务描述jar包和服务parcel包下载了,就可以实现完美集成了。

具体实现的简要步骤可参照cloudera官网提供的文档:http://www.cloudera.com/content/www/en-us/documentation/kafka/latest/topics/kafka_installing.html,

下面就是我根据这个文档的集成过程。

kafka相关包准备

csd包:http://archive.cloudera.com/csds/kafka/

parcel包: http://archive.cloudera.com/kafka/parcels/latest/ ( 根据自己的集群的系统版本下载 )

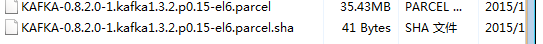

我用的是centos6.5 x64的系统,所以我下载的parcel包为KAFKA-0.8.2.0-1.kafka1.3.2.p0.56-el6.parcel与KAFKA-0.8.2.0-1.kafka1.3.2.p0.56-el6.parcel.sha1

集成实现

-

关闭集群,关闭cm服务( 假如不关闭cm服务,会出现在添加kafka服务时找不到相关的服务描述 )

-

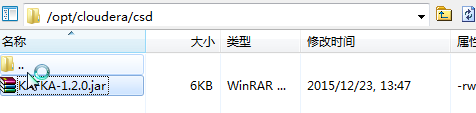

将csd包放到cm安装节点下的 /opt/cloudera/csd目录下,如图 :

- 将parcel包放到cm安装节点下的 /opt/cloudera/parcel-repo目录下,如图:

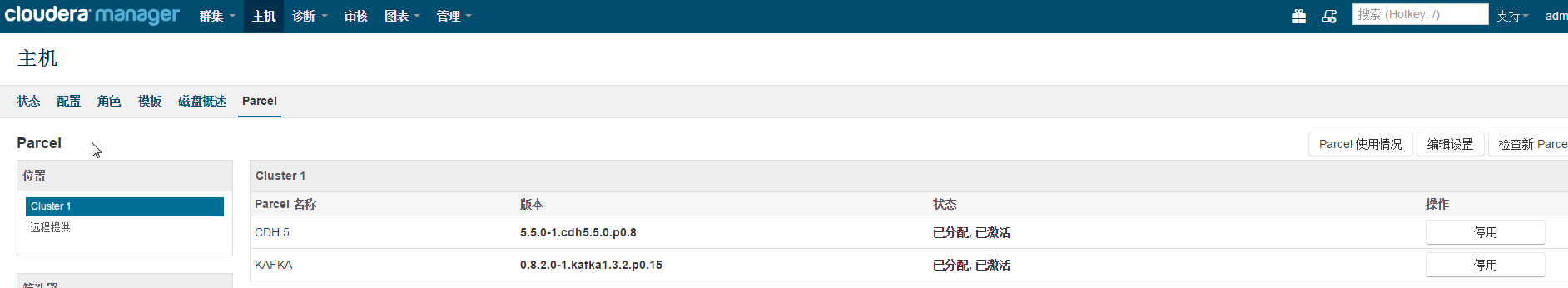

- 启动cm服务,分配并激活percel包

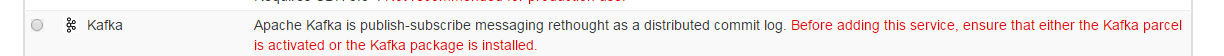

- 添加kafka服务:

- 启动服务

本文详细介绍了如何通过Cloudera平台集成Kafka服务的过程,包括准备工作、集成实现以及具体步骤,旨在帮助用户顺利实现Kafka与Cloudera环境的无缝对接。

本文详细介绍了如何通过Cloudera平台集成Kafka服务的过程,包括准备工作、集成实现以及具体步骤,旨在帮助用户顺利实现Kafka与Cloudera环境的无缝对接。

1952

1952

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?