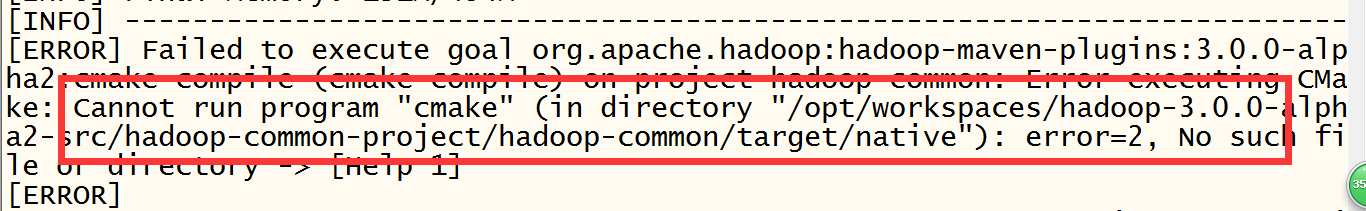

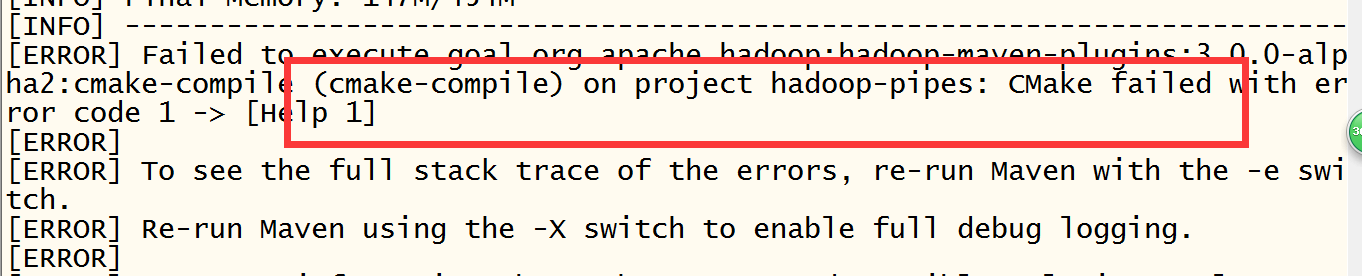

在编译hadoop的过程中,遇到缺少cmake命令的异常,异常信息为:Cannot run program "cmake" (in directory "/opt/workspaces/hadoop-3.0.0-alpha2-src/hadoop-common-project/hadoop-common/target/native"): error=2, No such file or directory;具体截图如下:

解决方案:安装cmake服务;当前系统环境:centos6.5 64位 1核2G

==================================================

方式一:直接通过yum命令进行安装(执行用户root)

yum install -y cmake

===================================================

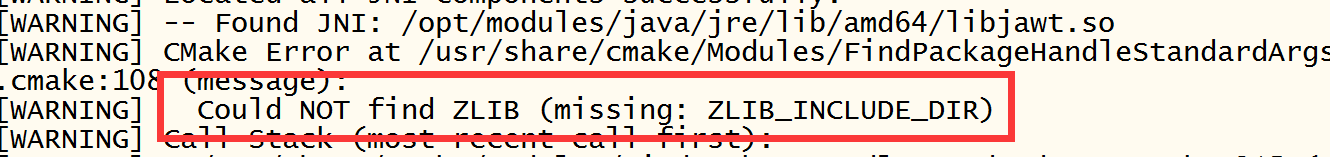

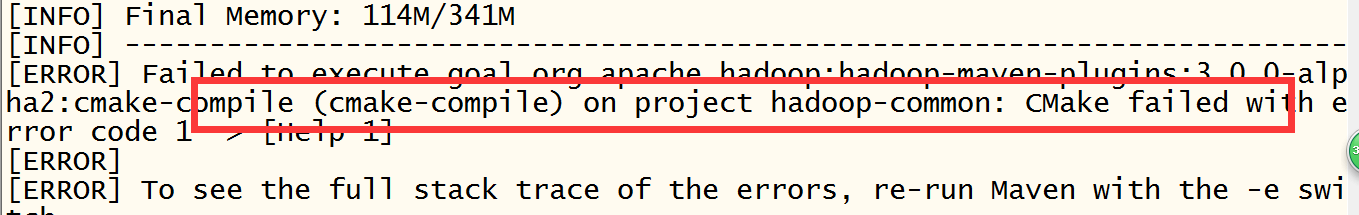

再执行编译hadoop可能会再次遇到异常,具体描述信息为:Could NOT find ZLIB (missing: ZLIB_INCLUDE_DIR);具体截图如下:

解决方案:安装zlib服务,命令如下:

yum install -y zlib

yum -y install zlib-devel

==============================================================

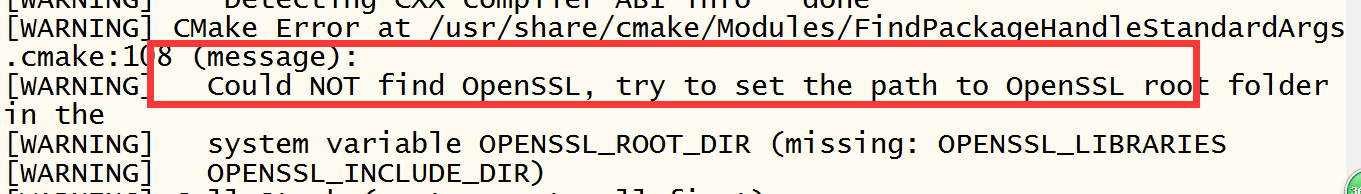

继续执行,可能出现(missing: OPENSSL_LIBRARIES OPENSSL_INCLUDE_DIR) ,具体异常如下:

解决方案为添加依赖服务:

yum install -y openssl openssl-devel

===============================================================

本文介绍了在编译Hadoop过程中遇到的缺少cmake命令、找不到ZLIB库及OPENSSL库等问题的解决方法,包括使用yum命令安装所需的服务。

本文介绍了在编译Hadoop过程中遇到的缺少cmake命令、找不到ZLIB库及OPENSSL库等问题的解决方法,包括使用yum命令安装所需的服务。

9409

9409

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?