简介:本文介绍的关键概念包括传递熵、符号熵和符号序列熵,这些都是信息论和数据处理中分析不确定性的关键工具。源码文件”PSTE_传递熵_符号熵_符号序列熵_x2yPSTE_frontn3j_源码.zip”包含了用于计算这些熵值的程序。传递熵考虑信道影响以评估通信系统效率,而符号熵和符号序列熵分别衡量离散变量和序列的不确定性。”x2yPSTE”和”frontn3j”可能是特定的算法标识和版本号。源码文件将提供深入理解这些理论概念在实际应用中的实施细节。

1. 传递熵的基本概念和计算方法

传递熵(Transfer Entropy)是信息论中的一个重要概念,它衡量了两个随机过程之间的信息传递量。要理解传递熵,我们首先需要掌握一些基本概念,如熵、条件熵和互信息等。在本章中,我们将深入探讨传递熵的定义、计算方法和它在信息理论中的应用。

1.1 传递熵的定义

传递熵由Schreiber在2000年提出,用于衡量一个随机过程对另一个随机过程的信息流向。它的核心思想是:如果一个过程X在给定过程Y的条件下,能够减少过程Y未来的不确定性,那么可以说X向Y传递了信息。

1.2 计算传递熵的方法

计算传递熵通常包括以下步骤:

1. 确定时间序列X和Y的时间延迟参数,这通常是通过最大化互信息来实现的。

2. 估算联合概率分布和边缘概率分布,可以使用直方图或核密度估计等方法。

3. 应用传递熵的数学公式进行计算:

T(X→Y) = ∑ p(x’, y’, y) log(p(y’, y) / p(y’))

这里,T(X→Y)表示从X到Y的传递熵,而p(x’, y’, y)代表在Y过去状态为y’、Y现在状态为y时,X未来状态为x’的联合概率。

接下来,我们将详细讨论符号熵的理论基础与计算公式,以及如何将这些理论知识应用于不同的实际场景中。

2. 符号熵的理论基础与计算公式

2.1 符号熵的定义

2.1.1 信息熵的概念起源

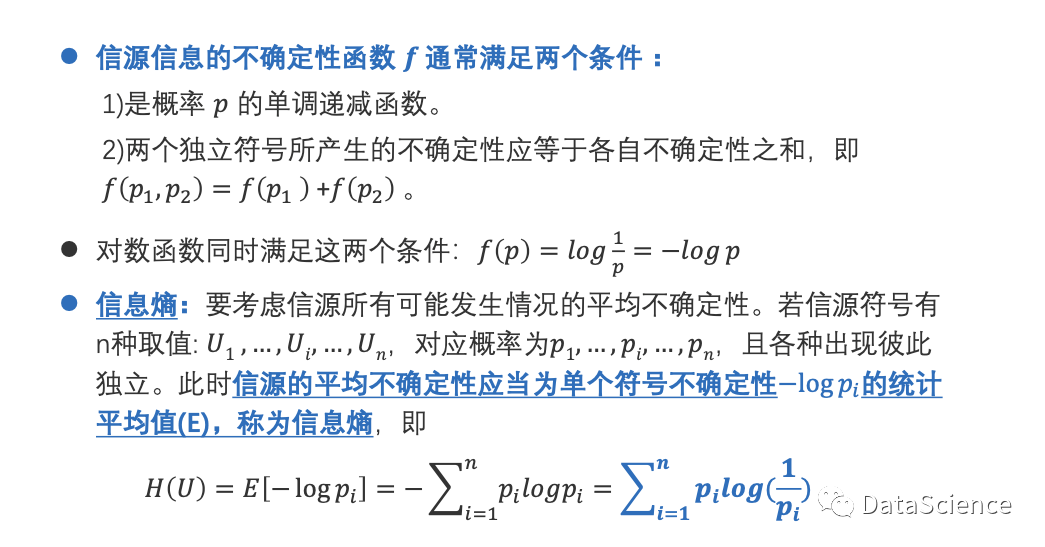

信息熵的概念最早是由克劳德·香农在其1948年的开创性论文《通信的数学理论》中提出的。香农受到物理学中热力学熵概念的启发,将熵的概念引入信息论领域,用以衡量信息的不确定性。在通信领域,信息熵指的是信源发出信息的平均不确定程度,它成为了信息论中一个核心概念。信源的熵越大,意味着其发出信息的不确定性越高,需要通过信道传输的信息量也就越大。

2.1.2 符号熵的数学定义和直观理解

符号熵,或称信息熵,可以定义为单个符号出现的概率与其对信息量贡献的乘积之和。其数学表达式通常写作:

[ H(X) = -\sum_{i=1}^{n} p(x_i) \log_2 p(x_i) ]

这里,( H(X) ) 是随机变量 ( X ) 的熵,( p(x_i) ) 表示第 ( i ) 个符号出现的概率,( n ) 是符号集中的符号总数。直观地说,符号熵描述了在不知道具体符号是什么的情况下,需要多少信息(以比特为单位)来确定符号的值。如果一个符号出现的概率很高,则其熵较低,因为它给接收者带来的信息量较少;相反,如果所有符号出现的概率都相同,那么每个符号带来的信息量最大,熵也就最高。

2.2 符号熵的计算方法

2.2.1 离散随机变量的符号熵计算

对于离散随机变量,每个可能的符号都有一个非负概率值,符号熵的计算就是基于这些概率值。举个例子,假设有一个简单的信源,它只发两个符号:A 和 B。符号 A 出现的概率为 0.7,符号 B 出现的概率为 0.3。则该信源的熵 ( H(X) ) 可以计算为:

[ H(X) = -[0.7 \times \log_2(0.7) + 0.3 \times \log_2(0.3)] \approx 0.881 \text{比特} ]

2.2.2 连续随机变量的符号熵计算

对于连续随机变量,其熵的计算稍微复杂一些。它依赖于变量的概率密度函数,而不是概率质量函数。连续变量的熵通常用微积分的方法计算:

[ H(X) = -\int_{-\infty}^{\infty} f(x) \log_2 f(x) \, dx ]

这里的 ( f(x) ) 是随机变量 X 的概率密度函数。由于连续变量可以取无限多个值,因此连续熵实际上代表的是概率密度函数曲线下的面积,可以视为这些无限多个可能取值的信息量之和。

2.2.3 符号熵的计算实例分析

举个具体的例子,考虑一个掷骰子的问题。标准的六面骰子有两个面是1点,其余面分别是2、3、4、5、6点。因此,掷出1的概率为 1/3,掷出其他点数的概率为 1/6。计算这个骰子的信息熵:

[ H(X) = -\left[ \frac{1}{3} \log_2 \left(\frac{1}{3}\right) + 4 \times \frac{1}{6} \log_2 \left(\frac{1}{6}\right) \right] ]

[ H(X) = -\left[ \frac{1}{3} \times (-\log_2 3) + \frac{2}{3} \times (-\log_2 6) \right] ]

[ H(X) = \log_2 3 + \frac{2}{3} \log_2 6 \approx 2.585 \text{比特} ]

该计算揭示了掷骰子的熵,直观上反映了掷骰子结果的不确定性。

接下来的章节将对符号序列熵的理论进行深入探讨,并展示其在应用中的具体实例。

3. 符号序列熵的理论与应用

3.1 符号序列熵的定义与特性

3.1.1 序列熵的引入与定义

在信息论中,序列熵是衡量符号序列不确定性的一个重要指标。序列熵的引入,允许我们从整体上分析一个序列的随机性或信息含量,而不仅仅是单个符号的不确定性。序列熵的定义需要考虑序列中所有可能的符号组合以及它们出现的概率。

序列熵的计算建立在概率论的基础之上,假设有一个符号序列 ( S = s_1, s_2, …, s_n ),其中每个符号 ( s_i ) 出现的概率为 ( P(s_i) )。那么,序列熵 ( H(S) ) 的计算公式可以表示为:

[ H(S) = -\sum_{i=1}^{n} P(s_i) \log P(s_i) ]

此处,对数的底数决定了熵的单位。通常情况下,我们使用以2为底的对数,得到的单位是比特(bits)。如果使用自然对数(以e为底),则单位为纳特(nats)。

3.1.2 序列熵的基本性质和应用场景

序列熵具有以下基本性质:

- 非负性 :序列熵值不会小于零,这表示所有符号序列都至少拥有一定的信息量。

- 最大值 :当序列中所有符号出现的概率相等时,序列熵达到最大值,表示序列具有最大的不确定性。

- 可加性 :对于两个独立的符号序列,它们的序列熵等于各自序列熵的和。

序列熵在多种场景中有着广泛的应用。例如,在自然语言处理中,序列熵可以帮助量化语句的复杂性或不可预测性,这在机器翻译、语音识别和文本生成等任务中非常有用。此外,序列熵也是信号处理和数据压缩等领域的关键概念。

3.2 符号序列熵的计算步骤和方法

3.2.1 序列熵的计算框架

为了计算给定符号序列的熵,需要遵循以下步骤:

1. 统计符号出现频率 :遍历序列,统计每个符号出现的次数,并计算其在序列中出现的概率。

2. 应用熵公式 :将每个符号的概率值代入序列熵的公式中进行计算。

3. 结果分析 :得到序列熵值后,对结果进行分析,以理解序列的随机性和信息含量。

3.2.2 多变量序列熵的计算方法

多变量序列熵涉及到序列中符号间的依赖关系。在多变量情形下,考虑的不仅仅是单个符号的概率分布,还有符号间的联合概率分布。计算多变量序列熵的过程与单变量类似,但需要额外计算符号间的联合概率,这通常涉及到条件概率的计算。

假设符号序列 ( S = (s_1, s_2, …, s_n) ),则多变量序列熵 ( H(S) ) 的计算公式可以扩展为:

[ H(S) = -\sum_{i=1}^{n} P(s_i) \log P(s_i) - \sum_{i=1}^{n} \sum_{j=1, j \neq i}^{n} P(s_i, s_j) \log P(s_i, s_j) ]

此处, ( P(s_i, s_j) ) 表示符号 ( s_i ) 和 ( s_j ) 同时出现的概率。

3.2.3 序列熵计算的实例演示

为了更直观地说明序列熵的计算方法,让我们通过一个简单的例子来演示。考虑以下符号序列:

A, A, B, A, B, B, A, A, B

我们首先统计每个符号的出现频率:

- A 出现了 5 次,概率为 ( P(A) = \frac{5}{9} )

- B 出现了 4 次,概率为 ( P(B) = \frac{4}{9} )

应用序列熵的公式,计算得到:

[ H(S) = -\left[ P(A) \log P(A) + P(B) \log P(B) \right] ]

[ H(S) = -\left[ \frac{5}{9} \log \frac{5}{9} + \frac{4}{9} \log \frac{4}{9} \right] ]

[ H(S) \approx -\left[ 0.556 \cdot (-0.653) + 0.444 \cdot (-0.817) \right] ]

[ H(S) \approx 0.988 \text{ bits} ]

从计算结果中可以看出,序列的熵值大约为 0.988 bits,表示该序列具有一定程度的不确定性。在实际应用中,这样的分析可以帮助我们了解数据集的随机性,或者设计有效的编码和压缩策略。

4. 源码文件解析及其功能

4.1 源码文件的结构分析

4.1.1 源码文件的组成和模块划分

在IT行业中,源码文件构成了软件开发的基石。理解一个源码文件的组成和模块划分是进行深入分析和优化的前提。典型的源码文件由以下部分组成:

- 声明部分 :包含必要的头文件引用、宏定义、全局变量声明等。

- 模块接口 :定义了模块提供的功能,例如函数声明、类定义等。

- 实现细节 :实现了接口中声明的各个功能的具体代码。

- 测试代码 :通常位于源码文件中,用于验证代码的正确性。

源码文件的模块划分遵循高内聚低耦合的原则,使得每个模块完成一项具体的功能,便于代码的维护和重用。以一个简单的C++源码文件为例:

#include <iostream>

#include <vector>

#include <string>

// 模块声明

class MathUtility {

public:

static int add(int a, int b);

static int subtract(int a, int b);

};

// 实现细节

int MathUtility::add(int a, int b) {

return a + b;

}

int MathUtility::subtract(int a, int b) {

return a - b;

}

// 主函数,用于测试模块功能

int main() {

std::cout << "Addition: " << MathUtility::add(1, 2) << std::endl;

std::cout << "Subtraction: " << MathUtility::subtract(2, 1) << std::endl;

return 0;

}

4.1.2 关键算法的源码剖析

关键算法是源码文件的核心部分,它的性能直接影响整个软件的效率。为了更好地理解这些算法,我们可以使用反向工程的方法对源码进行逐步剖析。例如,查看上一节中提到的 MathUtility 类中的加法函数:

int MathUtility::add(int a, int b) {

return a + b;

}

这个函数接受两个整数参数 a 和 b ,然后返回它们的和。虽然这个函数的逻辑很简单,但它展示了基本的算法实现。在剖析更复杂的算法时,我们会关注算法的复杂度、优化点、边界条件处理等方面。

4.2 源码文件中实现的特定算法功能

4.2.1 算法功能的理论基础

每个特定的算法功能都有其理论基础。例如,如果我们要在源码中实现一个排序算法,那么我们会使用到诸如冒泡排序、快速排序、归并排序等排序算法的理论。理解这些理论对于编写高效且可靠的算法至关重要。

以快速排序为例,它的理论基础是分治法(Divide and Conquer)。快速排序的基本步骤如下:

- 选择一个基准值(pivot)。

- 重新排列数组,使得所有比基准值小的元素都在基准值的前面,所有比基准值大的元素都在基准值的后面。这一步称为分区(partitioning)。

- 递归地将小于基准值元素的子数组和大于基准值元素的子数组排序。

4.2.2 算法在源码中的具体实现

理解了理论基础之后,下一步是在源码中具体实现算法。我们可以使用伪代码或者具体编程语言来实现算法。以快速排序的C++实现为例:

void quickSort(int arr[], int low, int high) {

if (low < high) {

int pi = partition(arr, low, high);

quickSort(arr, low, pi - 1); // Before pi

quickSort(arr, pi + 1, high); // After pi

}

}

int partition(int arr[], int low, int high) {

int pivot = arr[high];

int i = (low - 1);

for (int j = low; j <= high - 1; j++) {

if (arr[j] < pivot) {

i++;

std::swap(arr[i], arr[j]);

}

}

std::swap(arr[i + 1], arr[high]);

return (i + 1);

}

4.2.3 算法性能评估和优化

算法的性能评估是通过分析其时间和空间复杂度来进行的。快速排序的平均时间复杂度为O(n log n),但最坏情况下为O(n^2)。为了优化性能,可以采取以下措施:

- 选择合适的基准值策略,如随机选择或者三数取中。

- 使用尾递归优化,减少递归调用的开销。

- 对小数组采用插入排序等更高效的排序方法,减少快速排序的开销。

通过实际性能测试,我们可以评估这些优化措施的有效性,并根据测试结果继续调整算法实现。

通过本章节的介绍,我们从源码文件的结构分析到特定算法功能的实现和优化,已经逐步深入了解了源码文件解析及其功能。希望这能为IT行业的专业人士提供有用的视角和工具,以更好地理解和应用源码文件。

5. 文件命名标识的含义与信息理论应用

在计算机科学与IT领域,文件命名不仅是一个简单的标识,它背后往往蕴含着丰富的信息理论应用。为了深入理解文件命名标识的含义及其在信息理论中的应用,我们将从文件命名规则的解析和使用源码来理解信息理论两个方面进行探讨。

5.1 文件命名规则的解析

文件命名是信息组织的重要组成部分,它需要遵循一定的规则来保证文件的可读性、可搜索性及管理的高效性。

5.1.1 文件命名中的缩略词含义

在文件命名过程中,经常使用缩略词来代表特定的意义或功能模块,这不仅缩短了文件名,还能够在一定程度上提供额外信息。例如,在项目管理文件命名中,”PRD” 通常代表 Product Requirements Document(产品需求文档)。理解这些缩略词是快速识别文件内容的关键。

5.1.2 文件命名的结构和规则

文件命名的结构通常包括前缀、主体和后缀三部分。前缀可能表示项目名称、版本号或创建日期;主体部分表明文件内容或功能;后缀则标识文件类型。不同的组织或项目可能有其特定的命名规则,但一般都遵循便于管理和检索的原则。

5.2 使用源码理解和应用信息理论

源码文件不仅是程序的直接体现,也是信息理论在实际软件开发中应用的一个重要窗口。信息理论不仅能够用于文件命名,还能在源码层面帮助我们理解数据结构和算法的优化。

5.2.1 信息理论在源码中的应用实例

信息理论在源码中的应用可以从数据编码、压缩以及算法优化等方面体现。例如,在数据压缩算法中,信息熵的概念被用来衡量数据的不确定性,以此来确定压缩效率。代码示例如下:

import zlib

data = b"Hello world!"

compressed_data = zlib.compress(data)

print(f"Compressed data size: {len(compressed_data)} bytes")

在这个简单的例子中, zlib 库应用了信息熵原理对字符串进行压缩。

5.2.2 源码对于信息理论教学的意义

通过源码的阅读和分析,开发者可以直观地了解信息理论在实际编码中的应用。例如,了解哈夫曼编码的原理后,开发者可以通过阅读实现了哈夫曼编码的库的源码来加深理解。

import HuffmanCoding

# 示例代码展示如何使用哈夫曼编码

huffman = HuffmanCoding.HuffmanCoding()

huffman.buildEncodingTable('sample.txt')

print(huffmanuffman.getEncodedText())

5.2.3 源码的进一步开发与创新方向

信息理论为源码开发提供了理论基础和创新途径。开发者可以从信息熵的角度优化代码结构,提高代码的可读性和可维护性。例如,通过优化算法减少不必要的信息冗余,或者通过引入新的数据结构来改善数据组织方式。

信息理论的应用远不止于此,随着技术的不断发展,信息理论与IT的结合会更加紧密。比如,利用信息熵优化数据库查询性能、改进缓存机制等都是值得探索的领域。

通过深入分析和应用文件命名和信息理论,开发者不仅可以提升工作效率,还可以在技术上不断突破和创新。这是IT行业不断进步的动力之一。

简介:本文介绍的关键概念包括传递熵、符号熵和符号序列熵,这些都是信息论和数据处理中分析不确定性的关键工具。源码文件”PSTE_传递熵_符号熵_符号序列熵_x2yPSTE_frontn3j_源码.zip”包含了用于计算这些熵值的程序。传递熵考虑信道影响以评估通信系统效率,而符号熵和符号序列熵分别衡量离散变量和序列的不确定性。”x2yPSTE”和”frontn3j”可能是特定的算法标识和版本号。源码文件将提供深入理解这些理论概念在实际应用中的实施细节。

11

11

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?