简介:在数字化转型浪潮下,云原生微服务架构已成为现代企业应用开发的核心范式。本专栏资源“云原生微服务架构实战精讲”系统讲解了基于容器、Kubernetes、服务网格与CI/CD的微服务设计与实践方法,涵盖从基础理论到真实场景的完整技术链条。通过实际案例驱动,帮助开发者掌握高可用、可扩展、易维护的分布式系统构建能力,深入理解DevOps文化、服务治理、监控日志体系及安全策略,全面提升云原生环境下的工程落地水平。

1. 云原生架构核心理念与CNCF技术生态

云原生四大支柱:容器化、微服务、DevOps与持续交付

云原生并非简单的“上云”,而是一套以 敏捷交付、弹性扩展和自动化运维 为目标的现代软件构建范式。其核心由四大支柱构成: 容器化 实现环境一致性, 微服务 提升系统可维护性, DevOps 打通开发与运维壁垒, 持续交付 保障快速迭代能力。这四大要素相互协同,形成高效闭环。

graph TD

A[代码提交] --> B(持续集成)

B --> C[容器镜像构建]

C --> D[自动部署至K8s]

D --> E[服务发现+流量管理]

E --> F[监控告警+日志追踪]

F --> G[反馈优化]

上述流程体现了云原生全链路自动化逻辑。通过将应用封装为轻量级容器,并借助Kubernetes进行编排调度,企业可实现跨环境一致部署;结合Prometheus(监控)、Istio(服务网格)等CNCF项目,进一步构建可观测、可治理的技术体系。

2. 微服务架构设计原则与拆分策略

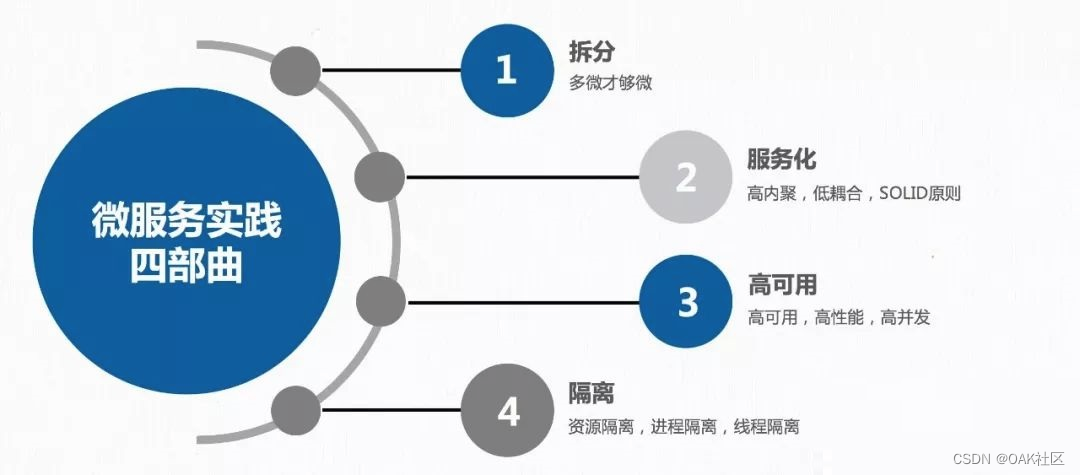

微服务架构作为云原生范式的核心组成部分,其本质是将一个庞大复杂的单体应用解耦为一组小而自治的服务单元。每个服务独立开发、部署和运维,围绕特定业务能力构建,并通过轻量级通信机制进行协作。然而,微服务并非“越小越好”,其成功实施依赖于严谨的设计原则、合理的拆分策略以及对反模式的深刻认知。本章系统阐述微服务设计中的关键原则,结合领域驱动设计(DDD)的方法论指导服务边界划分,并剖析常见拆分陷阱及其规避路径,最终通过电商平台订单系统的重构案例,展示从理论到实践的完整落地过程。

2.1 微服务的核心设计原则

微服务的成功落地离不开一系列经过验证的设计原则。这些原则不仅决定了服务之间的交互方式,也直接影响系统的可维护性、扩展性和容错能力。在实际项目中,团队往往因忽视某些核心原则而导致后期出现性能瓶颈、运维复杂或数据一致性问题。因此,深入理解并贯彻以下四大设计哲学至关重要。

2.1.1 单一职责与边界清晰的服务划分

单一职责原则(SRP, Single Responsibility Principle)源自面向对象设计,但在微服务架构中被赋予了更广泛的含义: 每个微服务应专注于完成一个明确的业务领域功能,并对该领域的所有行为负责 。例如,在电商系统中,“用户管理”服务只处理与用户身份相关的操作,如注册、登录、权限校验等;而“订单服务”则专司订单创建、状态变更、支付回调等逻辑。

服务边界的清晰界定是避免职责交叉的关键。常见的误区是将技术层级作为拆分依据,比如按“Controller层”、“Service层”来切分服务,这会导致跨服务频繁调用同一业务流程,形成“分布式单体”。正确的做法是以 业务能力 为中心进行垂直拆分。

下表展示了基于业务能力 vs 技术层级的两种拆分方式对比:

| 拆分维度 | 示例服务划分 | 优点 | 缺陷 |

|---|---|---|---|

| 业务能力导向 | 用户服务、商品服务、订单服务 | 职责明确,内聚性强 | 初期需较强领域建模能力 |

| 技术层级导向 | Web服务、业务逻辑服务、DAO服务 | 易于理解技术分层 | 导致紧耦合,难以独立演进 |

为了辅助识别合理边界,可以采用 “上下文映射图”(Context Map) 工具,借助领域驱动设计的思想,明确各子域间的协作关系。如下所示为使用 Mermaid 绘制的限界上下文示意图:

graph TD

A[用户服务] -->|认证Token| B(订单服务)

B -->|查询库存| C[库存服务]

C -->|扣减结果| B

D[支付服务] -->|支付状态更新| B

E[通知服务] -->|发送短信/邮件| A

该图直观地表达了各服务之间的依赖流向,有助于发现潜在的循环依赖或过度耦合点。例如,若发现“订单服务”反过来调用“用户服务”修改用户积分,则可能意味着“积分”应属于订单域的一部分,而非用户域,从而触发边界调整。

2.1.2 松耦合与高内聚的设计哲学

松耦合(Loose Coupling)与高内聚(High Cohesion)是衡量微服务质量的重要指标。理想状态下,服务之间应尽可能减少直接依赖,即使某个服务宕机也不应导致整个系统瘫痪;同时,服务内部的功能模块应紧密关联,共同服务于同一个业务目标。

实现松耦合的主要手段包括:

- 异步通信 :使用消息队列(如 Kafka、RabbitMQ)替代同步 HTTP 调用,使服务间解耦。

- 事件驱动架构(EDA) :当某服务状态变更时发布事件,其他服务订阅并响应,而非主动拉取数据。

- API 网关抽象下游细节 :对外暴露统一入口,隐藏后端服务拓扑变化。

高内聚则要求服务内部的类、方法、数据库表都围绕同一业务概念组织。例如,“订单服务”中的 Order , OrderItem , ShippingAddress 应共存于同一数据库 schema 中,且不与其他服务共享表结构。

下面是一段典型的 Spring Boot 风格代码,体现高内聚设计:

@Service

@Transactional

public class OrderService {

@Autowired

private OrderRepository orderRepository;

@Autowired

private InventoryClient inventoryClient; // 外部服务调用

public Order createOrder(CreateOrderRequest request) {

Order order = new Order();

order.setUserId(request.getUserId());

order.setStatus(OrderStatus.CREATED);

order.setTotalAmount(calculateTotal(request.getItems()));

List<OrderItem> items = request.getItems().stream()

.map(item -> new OrderItem(order, item.getProductId(), item.getQuantity()))

.collect(Collectors.toList());

order.setItems(items);

// 扣减库存(远程调用)

boolean success = inventoryClient.deductStock(items);

if (!success) {

throw new BusinessException("库存不足");

}

return orderRepository.save(order);

}

private BigDecimal calculateTotal(List<Item> items) {

return items.stream()

.map(item -> item.getPrice().multiply(BigDecimal.valueOf(item.getQuantity())))

.reduce(BigDecimal.ZERO, BigDecimal::add);

}

}

逐行逻辑分析:

-

@Service注解标识这是一个业务服务组件,由 Spring 容器管理生命周期。 -

@Transactional确保订单创建过程在一个数据库事务中执行,保证原子性。 -

OrderRepository是本服务本地的数据访问接口,符合“数据所有权归服务自己”的原则。 -

InventoryClient使用 Feign 或 RestTemplate 实现对“库存服务”的 HTTP 调用,属于跨服务协作。 -

createOrder()方法封装了完整的订单创建流程,包含计算总价、生成订单项、远程扣减库存等步骤。 - 若库存扣减失败,则抛出异常并回滚事务,体现了错误处理机制。

-

calculateTotal()是私有方法,仅服务于订单创建逻辑,增强内聚性。

参数说明:

- CreateOrderRequest :DTO 对象,封装前端传入的订单信息,包括用户 ID 和商品列表。

- Order :聚合根实体,代表一个完整订单,包含多个订单项。

- OrderItem :值对象,描述订单中某一商品的数量与价格。

- OrderStatus :枚举类型,表示订单生命周期状态(如 CREATED、PAID、SHIPPED 等)。

此设计虽实现了基本功能,但存在 同步阻塞风险 ——如果库存服务响应慢,订单服务也会被拖慢。改进方案是在后续章节讨论的“事件驱动+最终一致性”模型。

2.1.3 接口契约化与版本管理机制

微服务之间通过 API 进行通信,因此必须建立严格的接口契约(Contract),以确保上下游系统的兼容性。推荐使用 OpenAPI Specification(Swagger) 或 gRPC Proto 文件 定义 RESTful 接口或 RPC 接口。

例如,使用 OpenAPI v3 定义订单服务的创建接口:

openapi: 3.0.1

info:

title: 订单服务API

version: 1.0.0

paths:

/api/orders:

post:

summary: 创建新订单

requestBody:

required: true

content:

application/json:

schema:

$ref: '#/components/schemas/CreateOrderRequest'

responses:

'201':

description: 订单创建成功

content:

application/json:

schema:

$ref: '#/components/schemas/OrderResponse'

'400':

description: 请求参数错误

components:

schemas:

CreateOrderRequest:

type: object

properties:

userId:

type: string

example: "user_123"

items:

type: array

items:

$ref: '#/components/schemas/OrderItem'

OrderItem:

type: object

properties:

productId:

type: string

quantity:

type: integer

minimum: 1

OrderResponse:

type: object

properties:

orderId:

type: string

example: "order_456"

status:

type: string

enum: [CREATED, PAID]

该契约文件可用于生成客户端 SDK、Mock Server 及自动化测试脚本,提升集成效率。

关于版本管理,建议采用 URL 版本控制 或 Header 版本控制 :

- URL 方式:

/api/v1/orders - Header 方式:

Accept: application/vnd.company.order-v1+json

优先推荐 URL 版本,因其简单直观,便于监控和路由配置。

2.1.4 分布式一致性与CAP理论的应用权衡

在分布式环境下,无法同时满足一致性(Consistency)、可用性(Availability)和分区容忍性(Partition Tolerance)。根据 CAP 定理,最多只能三者取其二。由于网络分区不可避免(P 必须存在),因此实际选择往往在 CP(强一致)与 AP(高可用)之间权衡。

| 场景 | 推荐模型 | 举例 |

|---|---|---|

| 支付、账户余额 | CP | 使用分布式锁、ZooKeeper 等 |

| 商品浏览、推荐列表 | AP | 允许短暂不一致,后台异步同步 |

对于订单系统,订单创建属于关键事务,通常要求强一致性,可采用 两阶段提交(2PC) 或 Saga 模式 实现跨服务事务协调。

Saga 是一种长活事务管理模式,将全局事务分解为一系列本地事务,每个步骤都有对应的补偿操作。例如:

sequenceDiagram

participant O as 订单服务

participant I as 积分服务

participant S as 库存服务

O->>S: 扣减库存(预占)

S-->>O: 成功

O->>I: 增加用户积分

I-->>O: 失败!

O->>I: 补偿:扣除已增积分

O->>S: 补偿:释放库存

O-->>Client: 事务失败

通过事件总线广播 OrderCreatedEvent 、 OrderCancelledEvent 等,各服务监听并执行相应动作,实现最终一致性。

综上所述,微服务设计不仅是技术选型问题,更是对业务本质的理解与抽象能力的考验。唯有坚持单一职责、松耦合高内聚、契约化接口与理性 CAP 权衡,才能构建出真正可持续演进的分布式系统。

3. Docker容器化技术实战与镜像管理

在云原生架构体系中,容器化是实现应用可移植性、环境一致性以及资源高效利用的核心基石。作为最广泛采用的容器运行时技术,Docker 已成为现代软件交付流程中的标准工具链之一。它通过封装应用程序及其依赖项到一个轻量级、可移植的“容器”中,实现了“一次构建,随处运行”的理想状态。然而,仅仅会使用 docker run 并不足以支撑生产级部署需求。深入理解 Docker 的底层机制、掌握高性能镜像构建策略、规范运行时管理流程,并建立安全可控的私有镜像管理体系,才是企业级落地的关键。

本章将从操作系统层面剖析容器的本质原理,解析 Docker 架构组件之间的协作逻辑,进而系统讲解如何编写高效且安全的 Dockerfile,提升镜像构建效率与体积控制能力。随后,针对容器运行过程中的可观测性、资源隔离和健康保障问题,提供实用的调试技巧与配置方法。最后,聚焦于企业内部对镜像生命周期的安全治理,详细演示 Harbor 私有仓库的部署实践,涵盖权限控制、内容信任、漏洞扫描等关键环节,构建完整的镜像安全管理闭环。

3.1 容器技术原理与Docker架构解析

容器并非虚拟机,其本质是在宿主机操作系统之上通过内核特性实现进程级别的隔离与资源限制。这种设计使得容器具备启动快、资源占用低、密度高等优势。要真正掌握 Docker 技术,必须穿透其表层命令行接口,深入 Linux 内核所提供的隔离机制与文件系统结构。

3.1.1 Namespace与Cgroups底层机制详解

Linux 容器之所以能够实现“隔离”,主要依赖两大核心技术: Namespace 和 Control Groups(cgroups) 。

- Namespace 负责提供视图隔离,使每个容器拥有独立的进程 ID、网络栈、挂载点、用户 ID 等空间。

- cgroups 则负责资源控制,限制 CPU、内存、I/O 等硬件资源的使用上限,防止某个容器耗尽系统资源。

以下是常见的六种命名空间及其作用:

| Namespace | 系统调用参数 | 隔离内容 |

|---|---|---|

| Mount | CLONE_NEWNS | 文件系统挂载点 |

| UTS | CLONE_NEWUTS | 主机名与域名 |

| IPC | CLONE_NEWIPC | 进程间通信(信号量、消息队列) |

| PID | CLONE_NEWPID | 进程 ID 号空间 |

| Network | CLONE_NEWNET | 网络设备、IP 地址、端口等 |

| User | CLONE_NEWUSER | 用户和用户组 ID 映射 |

例如,在创建容器时,Docker 会调用 unshare() 或 clone() 系统调用来启用这些命名空间。这意味着容器内的 ps aux 命令只能看到属于该 PID namespace 的进程,而无法感知宿主机或其他容器的进程存在。

与此同时,cgroups v1/v2 提供了对资源使用的硬性约束。以内存为例,可通过如下方式设置容器最大内存为 512MB:

docker run -m 512m ubuntu:20.04

这背后实际上是 Docker daemon 向 /sys/fs/cgroup/memory/docker/<container-id>/memory.limit_in_bytes 写入数值来完成限制。

扩展说明 :当容器尝试分配超过限制的内存时,OOM Killer 将被触发,可能导致容器异常退出。因此在生产环境中应结合监控工具进行容量规划。

此外,Docker 默认使用 cgroups v1,但 Kubernetes 推荐使用 v2,因其统一层级结构更易于管理和避免冲突。可通过检查 /sys/fs/cgroup/cgroup.controllers 是否存在判断是否启用了 v2。

cat /sys/fs/cgroup/cgroup.controllers

# 输出示例:cpu io memory pids rdma

若输出包含多个控制器,则表示已启用 cgroups v2。

3.1.2 Docker Daemon、Image、Container三者关系

Docker 架构由三个核心组件构成: Docker Client 、 Docker Daemon 和 Docker Registry 。其中,Daemon 是运行在宿主机上的后台服务进程,负责处理所有容器生命周期操作。

三者关系可以用如下 Mermaid 流程图清晰表达:

graph TD

A[Docker Client] -->|发送指令| B(Docker Daemon)

B --> C{请求类型}

C -->|构建镜像| D[读取Dockerfile]

C -->|运行容器| E[加载镜像层]

C -->|推送/拉取| F[Docker Registry]

D --> G[生成只读镜像层]

E --> H[创建可写容器层]

G --> I[存储于本地镜像库]

H --> J[运行态容器实例]

具体来说:

- Image 是静态的、分层的只读模板,由一系列 UnionFS 层叠加而成;

- Container 是 Image 在运行时的一个实例,附加了一个可写的顶层(Container Layer),用于记录运行期间的变化;

- Docker Daemon 是实际执行构建、启动、停止、删除等操作的服务进程,监听默认 Unix Socket /var/run/docker.sock 。

当执行 docker run nginx 时,Docker Client 发送 REST 请求至 Daemon,后者首先查找本地是否有 nginx 镜像,若无则从远程 Registry 拉取;接着根据镜像创建一个新的可写层,并启动容器进程。

值得注意的是,同一个镜像可以启动多个容器实例,每个容器都拥有独立的可写层和命名空间,互不影响。这也体现了镜像的“不可变性”原则——即一旦构建完成就不应修改,任何变更都应在新版本中体现。

3.1.3 UnionFS文件系统在镜像层中的作用

UnionFS(联合文件系统)是 Docker 实现镜像分层存储的关键技术。它允许将多个目录(称为分支)合并成一个统一的视图,各层之间保持只读属性,仅最上层为可写。

Docker 支持多种存储驱动,如 overlay2 (推荐)、 aufs 、 btrfs 等,目前主流发行版普遍采用 overlay2 ,基于 Linux 内核的 OverlayFS 实现。

假设我们有以下 Dockerfile:

FROM ubuntu:20.04

RUN apt-get update && apt-get install -y curl

COPY app.py /app/

CMD ["python", "/app/app.py"]

构建后会生成四层镜像:

| 层 | 内容 | 类型 |

|---|---|---|

| Layer 1 | base OS (ubuntu:20.04) | 只读 |

| Layer 2 | 更新包索引并安装 curl | 只读 |

| Layer 3 | 复制 Python 脚本 | 只读 |

| Layer 4 | 设置启动命令 | 只读 |

每一层都是一个独立的文件系统快照,存放在 /var/lib/docker/overlay2/ 目录下。当容器运行时,Docker 创建一个新的可写层(也叫 container layer),位于所有只读层之上。

# 查看某容器使用的存储层路径

docker inspect <container_id> | grep MergedDir

# 输出示例:"/var/lib/docker/overlay2/abc123.../merged"

这种分层结构带来了显著的优势:

- 共享基础层 :多个基于相同基础镜像的服务共享底层数据,节省磁盘空间;

- 快速构建缓存 :只有发生变化的层需要重新构建,前置未变的层可直接复用;

- 镜像推送/拉取增量传输 :Registry 仅需同步差异层,减少网络开销。

但也存在潜在风险:层数过多会导致性能下降或达到平台限制(Docker 默认最多支持 127 层)。因此建议通过多阶段构建等方式优化层数。

3.1.4 容器网络模型与bridge/host/none模式对比

容器间的通信依赖于 Docker 的网络子系统,其提供了多种网络模式以适应不同场景需求。

Docker 默认内置三种网络模式:

| 模式 | 特点 | 使用场景 |

|---|---|---|

| bridge(默认) | 使用 docker0 网桥进行 NAT 转换,容器间可通过 IP 通信 | 单机多容器通信 |

| host | 容器直接使用宿主机网络栈,不进行隔离 | 对网络性能要求极高,如监控代理 |

| none | 不配置任何网络接口,完全隔离 | 安全沙箱或无需联网任务 |

Bridge 模式工作原理

Bridge 模式是最常用的网络配置。Docker 会在宿主机创建一个名为 docker0 的虚拟网桥,通常分配私有网段(如 172.17.0.1/16 )。每当启动一个容器,Docker 会为其分配一个 veth pair 设备,一端连接到容器内部(如 eth0 ),另一端接入 docker0 网桥。

graph LR

A[Container eth0] <--> B[veth-pair]

B <--> C[docker0 网桥]

C --> D[宿主机网络]

D --> E[外部网络]

容器之间可通过 IP 直接访问,也可通过 --link 或自定义 bridge 网络实现名称解析。但从外部访问容器需通过端口映射( -p 参数):

docker run -d -p 8080:80 nginx

此时宿主机的 8080 端口被 iptables NAT 规则转发至容器的 80 端口。

Host 模式示例

使用 host 模式可避免额外的网络抽象层,适用于 Prometheus exporter、日志收集器等对延迟敏感的服务:

docker run --network=host prom/prometheus

该容器将直接绑定到宿主机的 9090 端口,无需 -p 映射,但牺牲了网络隔离性。

None 模式应用场景

某些批处理任务可能不需要网络连接,使用 none 模式可增强安全性:

docker run --network=none alpine sh -c "echo 'processing data' && sleep 10"

此时容器无任何网络接口,仅保留 loopback。

最佳实践建议 :生产环境中应优先使用自定义 bridge 网络而非默认 bridge,以便支持自动 DNS 解析和服务发现。例如:

docker network create mynet

docker run -d --name db --network=mynet mysql

docker run -d --name web --network=mynet nginx

# 此时 web 容器可通过 hostname 'db' 访问数据库

3.2 Dockerfile编写最佳实践

Dockerfile 是构建容器镜像的“源代码”,其质量直接影响镜像大小、安全性、构建速度和维护成本。遵循最佳实践不仅能提升 CI/CD 效率,还能降低攻击面。

3.2.1 多阶段构建优化镜像体积

传统单阶段构建常导致最终镜像包含编译工具链、临时文件等不必要的内容。 多阶段构建 (Multi-stage Build)通过引入中间构建阶段,仅复制所需产物到最终镜像中,大幅减小体积。

以 Go 应用为例:

# 第一阶段:构建阶段

FROM golang:1.21 AS builder

WORKDIR /app

COPY . .

RUN go build -o main ./cmd/api

# 第二阶段:运行阶段

FROM alpine:latest

RUN apk --no-cache add ca-certificates

WORKDIR /root/

COPY --from=builder /app/main .

CMD ["./main"]

逐行解析 :

- FROM golang:1.21 AS builder :定义第一阶段,命名为 builder ,包含完整 Go 编译环境;

- RUN go build ... :在此阶段完成编译,生成二进制文件;

- FROM alpine:latest :切换至轻量基础镜像作为运行环境;

- COPY --from=builder :仅复制前一阶段的构建结果,不继承其他层;

- 最终镜像不含 Go SDK,体积可从 ~900MB 降至 ~15MB。

参数说明 :

--from=<stage-name>支持跨阶段复制文件,极大增强了灵活性。

3.2.2 最小化基础镜像选择(Alpine vs Distroless)

基础镜像是镜像体积的主要来源。常见选择包括:

| 镜像类型 | 示例 | 特点 |

|---|---|---|

| Alpine Linux | alpine:latest | 极小 (~5MB),使用 musl libc,兼容性略差 |

| Distroless | gcr.io/distroless/static-debian11 | 仅含运行时,无 shell,安全性高 |

| Slim 版本 | python:3.11-slim | 官方精简版,平衡功能与体积 |

比较三者运行 Go Web 服务的表现:

| 镜像 | 体积 | 是否可调试 | 适用场景 |

|---|---|---|---|

alpine | ~15MB | ✅(含 busybox shell) | 开发/测试 |

distroless | ~12MB | ❌(无 shell) | 生产高安全环境 |

debian-slim | ~50MB | ✅ | 需要复杂依赖 |

推荐策略:

- 开发阶段 :使用 Alpine + Shell,便于排查问题;

- 生产环境 :优先选用 Distroless,关闭非必要入口点,遵循最小权限原则。

示例使用 Distroless:

FROM golang:1.21 AS builder

WORKDIR /src

COPY . .

RUN CGO_ENABLED=0 GOOS=linux go build -a -installsuffix cgo -o server .

FROM gcr.io/distroless/static-debian11

COPY --from=builder /src/server /

CMD ["/server"]

注意 :Distroless 镜像无法进入容器执行

sh,调试需依赖日志和外部监控。

3.2.3 环境变量注入与安全配置建议

环境变量是配置外部化的常用手段,但不当使用可能带来安全隐患。

正确做法:

ENV DATABASE_URL=postgres://user:pass@localhost:5432/db \

LOG_LEVEL=info

或通过 docker run 注入:

docker run -e DATABASE_URL=... myapp

安全建议 :

- 避免在 Dockerfile 中硬编码密码或密钥;

- 使用 --env-file 从外部加载 .env 文件;

- 敏感信息应交由 Secret 管理系统(如 Hashicorp Vault、Kubernetes Secrets);

- 对于 CI/CD 环境,使用凭据插件动态注入。

此外,可设置不可变环境变量防止运行时篡改:

LABEL org.opencontainers.image.revision="git-commit-hash"

并在应用中读取该标签做版本校验。

3.2.4 构建缓存利用与CI/CD集成技巧

Docker 构建缓存能显著加速 CI 流水线。缓存命中条件是: 当前指令及之前所有指令的输入未发生变化 。

影响缓存失效的常见因素:

- COPY . . 复制整个目录,任意文件变更都会导致后续层缓存失效;

- 包管理器更新频繁,如 apt-get update 每次执行都会改变层内容。

优化策略:

- 分步 COPY:先复制 package.json ,再安装依赖,最后复制源码;

- 使用 .dockerignore 排除无关文件(如 node_modules、logs);

.dockerignore 示例:

.git

*.log

node_modules

Dockerfile*

README.md

CI 集成建议:

- 在 GitLab CI 中启用 docker:dind 服务;

- 使用 Kaniko 或 BuildKit 支持无 root 构建;

- 开启 BuildKit 可并行处理多阶段构建:

DOCKER_BUILDKIT=1 docker build -t myapp .

BuildKit 还支持高级特性如 RUN --mount=type=cache 缓存 npm 目录:

RUN --mount=type=cache,target=/root/.npm \

npm install

3.3 容器运行时管理与调试技巧

容器运行后的可观测性与稳定性管理至关重要。良好的日志策略、资源限制和健康检查机制是保障服务 SLA 的基础。

3.3.1 日志采集与标准输出重定向

Docker 默认将容器 stdout/stderr 捕获并通过 docker logs 输出。这是推荐的日志收集方式,避免日志写入容器内部文件系统(重启即丢失)。

配置示例:

# docker-compose.yml

services:

web:

image: nginx

logging:

driver: "json-file"

options:

max-size: "10m"

max-file: "3"

上述配置启用 JSON 日志驱动,单个文件最大 10MB,保留 3 份轮转。

生产环境建议对接集中式日志系统(ELK、Loki):

docker run \

--log-driver=fluentd \

--log-opt fluentd-address=localhost:24224 \

myapp

扩展说明 :Fluentd 收集后可转发至 Kafka → Elasticsearch → Kibana 可视化。

3.3.2 进入容器内部进行故障排查命令集

常用调试命令汇总:

| 命令 | 功能 |

|---|---|

docker exec -it <id> sh | 进入容器交互式终端 |

docker logs <id> | 查看日志输出 |

docker top <id> | 查看容器内运行进程 |

docker stats <id> | 实时查看资源使用 |

docker inspect <id> | 获取详细元信息 |

示例诊断步骤:

# 1. 查看容器状态

docker ps -a | grep myapp

# 2. 查看日志

docker logs myapp_container

# 3. 进入容器排查

docker exec -it myapp_container sh

# 4. 检查网络连通性

curl http://backend-service:8080/health

注意:生产环境慎用

exec,尤其在 Distroless 镜像中可能无法进入。

3.3.3 资源限制设置(CPU/Memory)防止资源争抢

合理设置资源限制可防止单个容器拖垮节点:

docker run \

-m 512m \

--memory-swap=1g \

--cpus=1.5 \

myapp

参数说明:

- -m/--memory :最大可用内存;

- --memory-swap :内存 + swap 总量;

- --cpus :CPU 权重(相当于 1.5 核);

在 Kubernetes 中对应 resources.limits 字段。

3.3.4 健康检查探针配置提升服务稳定性

通过 HEALTHCHECK 指令定义健康状态检测:

HEALTHCHECK --interval=30s --timeout=3s --start-period=5s --retries=3 \

CMD curl -f http://localhost:8080/health || exit 1

解释:

- --interval :每 30 秒检测一次;

- --timeout :超时 3 秒判定失败;

- --start-period :启动初期允许失败;

- --retries :连续失败 3 次标记为 unhealthy;

可通过 docker inspect 查看健康状态:

docker inspect --format='{{.State.Health.Status}}' myapp

3.4 私有镜像仓库搭建与安全管理

企业级容器平台必须建立私有镜像仓库,以实现镜像集中管理、访问控制和安全审计。

3.4.1 Harbor部署流程与WebUI操作指南

Harbor 是 CNCF 毕业项目,提供图形化界面、RBAC、镜像扫描等功能。

部署步骤(基于 Docker Compose):

git clone https://github.com/goharbor/harbor.git

cd harbor

cp harbor.yml.tmpl harbor.yml

# 修改 hostname、https 配置等

sudo ./install.sh

启动后访问 https://your-harbor-host ,初始账号 admin ,密码在 harbor.yml 中设定。

主要功能模块:

- Projects :项目级隔离,支持公开/私有;

- Repositories :存放镜像版本;

- Replication :跨站点同步;

- Vulnerability Scanning :集成 Clair 扫描漏洞。

推送镜像示例:

docker tag myapp:latest harbor.example.com/library/myapp:latest

docker login harbor.example.com

docker push harbor.example.com/library/myapp:latest

3.4.2 镜像签名与内容信任机制启用

启用 Notary 实现镜像签名验证:

export DOCKER_CONTENT_TRUST=1

docker push harbor.example.com/library/myapp:signed

推送时会生成数字签名,拉取时自动验证完整性,防止中间篡改。

3.4.3 RBAC权限控制与项目隔离策略

Harbor 提供细粒度角色控制:

| 角色 | 权限 |

|---|---|

| Project Admin | 管理项目成员、配置 |

| Developer | 推送/拉取镜像 |

| Guest | 仅拉取 |

| Robot Account | 自动化账户,带过期时间 |

建议按团队划分项目,如 team-a/backend 、 team-b/frontend 。

3.4.4 镜像扫描漏洞检测与合规性审计

Harbor 集成 Trivy 或 Clair 自动扫描镜像漏洞:

graph TB

A[Push Image] --> B{Trigger Scan}

B --> C[Analyze OS Packages]

B --> D[Check Application Dependencies]

C --> E[Generate CVE Report]

D --> E

E --> F[Display in UI]

F --> G[Block if High Severity]

可在策略中设置: 严重漏洞数量 > 0 时禁止部署 ,实现安全左移。

4. Kubernetes(K8s)集群部署与核心对象管理

作为云原生技术栈的编排中枢,Kubernetes 已成为现代分布式系统构建的事实标准。它不仅提供了对容器化工作负载的自动化调度、弹性伸缩和自愈能力,更通过声明式 API 与丰富的控制器模型,实现了基础设施即代码(IaC)的核心理念。本章将深入剖析 Kubernetes 集群的架构设计、组件通信机制,并系统讲解其核心资源对象的管理方式。从最基础的 Pod 调度原理到高级工作负载控制,再到 YAML 编排工程化的最佳实践,内容层层递进,帮助具备 5 年以上经验的 IT 从业者掌握在生产环境中稳定运行 K8s 所需的关键技能。

4.1 K8s集群架构与组件通信机制

Kubernetes 集群并非一个单一服务,而是由多个高度解耦但又紧密协作的组件构成的分布式系统。理解这些组件之间的职责划分与通信路径,是进行故障排查、性能调优和安全加固的前提条件。整个集群通常分为两类节点: Master 节点 (控制平面)负责全局决策与状态维护; Worker 节点 (数据平面)则承载实际的应用容器。

4.1.1 Master节点与Worker节点职责划分

Master 节点包含多个关键组件,它们共同维持集群的“大脑”功能:

- kube-apiserver :提供 RESTful 接口,是所有内外部请求的唯一入口。

- etcd :轻量级、高可用的键值存储,保存集群的所有配置与状态数据。

- kube-scheduler :根据资源需求、亲和性规则等策略决定 Pod 应该调度到哪个 Worker 节点。

- kube-controller-manager :运行各种控制器(如 Deployment Controller、Node Controller),确保实际状态趋近于期望状态。

- cloud-controller-manager (可选):对接公有云平台 API,管理负载均衡器、路由表等外部资源。

Worker 节点上的核心组件包括:

- kubelet :负责与 Master 通信,管理本节点上 Pod 的生命周期。

- kube-proxy :实现 Service 的网络代理规则(iptables 或 IPVS 模式),完成服务发现与负载均衡。

- Container Runtime (如 containerd、CRI-O):真正运行容器的底层运行时环境。

下图展示了典型 K8s 集群中各组件的逻辑关系:

graph TD

subgraph "Control Plane (Master Nodes)"

A[kube-apiserver] --> B[etcd]

A --> C[kube-scheduler]

A --> D[kube-controller-manager]

C --> A

D --> A

end

subgraph "Data Plane (Worker Nodes)"

E[kubelet] --> A

F[kube-proxy] --> A

G[Container Runtime] --> E

H[Pods] --> G

end

A <-->|REST over HTTPS| E

A <-->|Watch & List| F

图注:Kubernetes 控制平面与数据平面之间的通信依赖

kube-apiserver作为中心枢纽,所有组件均通过 HTTPS 协议与其交互。

这种主从架构的设计使得 Kubernetes 具备良好的扩展性和容错能力。例如,在多 Master 节点场景中,可通过负载均衡器前端接入多个 kube-apiserver 实例,而 etcd 集群本身也支持 Raft 一致性算法保障数据强一致性。

4.1.2 etcd存储集群状态数据的高可用设计

etcd 是 Kubernetes 的“心脏”,一旦其不可用,整个集群将陷入只读状态甚至完全瘫痪。因此,etcd 必须以集群模式部署,一般建议使用奇数个节点(3、5、7)以保证选举效率与容灾能力。

| 参数 | 推荐值 | 说明 |

|---|---|---|

| 节点数量 | 3 或 5 | 多于 3 提升容错,但增加写延迟 |

| 存储后端 | bbolt | 默认嵌入式 KV 引擎 |

| 快照间隔 | 100,000 写操作 | 定期持久化防止 WAL 日志过大 |

| TLS 加密 | 启用 | 所有 peer 和 client 通信必须加密 |

| 磁盘类型 | SSD | etcd 对 I/O 延迟极为敏感 |

为确保高可用,etcd 集群应跨不同可用区(AZ)部署。以下是三节点 etcd 集群的部署示例命令:

# 在每个节点上启动 etcd 实例(以 node1 为例)

etcd --name etcd-node1 \

--data-dir /var/lib/etcd \

--listen-client-urls https://192.168.1.10:2379 \

--advertise-client-urls https://192.168.1.10:2379 \

--listen-peer-urls https://192.168.1.10:2380 \

--initial-advertise-peer-urls https://192.168.1.10:2380 \

--initial-cluster-token etcd-cluster-1 \

--initial-cluster 'etcd-node1=https://192.168.1.10:2380,etcd-node2=https://192.168.1.11:2380,etcd-node3=https://192.168.1.12:2380' \

--initial-cluster-state new \

--client-cert-auth --trusted-ca-file=/etc/ssl/etcd/ca.pem \

--peer-client-cert-auth --peer-trusted-ca-file=/etc/ssl/etcd/ca.pem

逐行解析:

-

--name:设置节点唯一标识; -

--data-dir:指定数据持久化目录,需位于高性能磁盘; -

--listen-*:监听地址,区分客户端访问与节点间通信; -

--initial-cluster:定义初始集群成员列表,IP 地址必须可达; -

--client-cert-auth:启用 mTLS 双向认证,防止未授权访问; -

--peer-*:确保节点间通信同样加密。

生产环境中还应定期执行备份操作:

ETCDCTL_API=3 etcdctl --endpoints=https://127.0.0.1:2379 \

--cacert=/etc/ssl/etcd/ca.pem \

--cert=/etc/ssl/etcd/server.pem \

--key=/etc/ssl/etcd/server-key.pem \

snapshot save /backup/etcd-snapshot.db

该命令生成一个二进制快照文件,可用于灾难恢复或迁移。

4.1.3 kube-apiserver作为唯一入口的安全访问控制

kube-apiserver 是整个系统的安全边界。所有操作——无论是 kubectl 命令、控制器行为还是 Web UI 请求——都必须经过它的验证与授权。

其安全机制主要包括三个阶段:

- 认证(Authentication)

- 支持 X509 客户端证书、Bearer Token、ServiceAccount Token、OpenID Connect 等方式。 - 授权(Authorization)

- 基于 RBAC(Role-Based Access Control)判断用户是否有权执行某操作。 - 准入控制(Admission Control)

- 在对象持久化前执行校验或修改,如限制 Pod 使用 hostPath、自动注入 Sidecar 等。

以下是一个典型的 RBAC 权限配置示例:

apiVersion: rbac.authorization.k8s.io/v1

kind: Role

metadata:

namespace: dev-team

name: pod-reader

rules:

- apiGroups: [""]

resources: ["pods"]

verbs: ["get", "list", "watch"]

apiVersion: rbac.authorization.k8s.io/v1

kind: RoleBinding

metadata:

name: read-pods

namespace: dev-team

subjects:

- kind: User

name: alice@example.com

apiGroup: rbac.authorization.k8s.io

roleRef:

kind: Role

name: pod-reader

apiGroup: rbac.authorization.k8s.io

参数说明:

-

apiGroups: “” 表示核心 API 组(如 Pod、Node); -

resources: 指定作用资源类型; -

verbs: 允许的操作动词; -

subjects: 被绑定的对象,可以是 User、Group 或 ServiceAccount; -

roleRef: 引用已定义的角色。

此配置允许用户 alice@example.com 在 dev-team 命名空间内查看 Pod 列表,但不能创建或删除。结合 NetworkPolicy 与审计日志(Audit Logging),可进一步增强安全性。

4.1.4 kubelet与Pod生命周期协同机制

kubelet 是运行在每个 Worker 节点上的“代理人”,它的主要任务是从 kube-apiserver 获取分配给当前节点的 Pod 清单,并确保这些 Pod 按照预期运行。

Pod 生命周期由以下几个阶段组成:

| Phase | 描述 |

|---|---|

| Pending | API Server 已创建 Pod,但尚未调度或镜像拉取中 |

| Running | Pod 已被调度,至少一个容器正在运行 |

| Succeeded | 所有容器正常退出(如 Job 完成) |

| Failed | 至少一个容器以非零状态退出 |

| Unknown | 节点失联导致无法获取状态 |

kubelet 会周期性地向 API Server 发送心跳(Node Status),并通过 CRI(Container Runtime Interface)调用底层运行时来管理容器。例如,当检测到某个容器崩溃时, kubelet 会根据重启策略(RestartPolicy)决定是否重新启动。

此外, kubelet 还负责执行 Liveness Probe 和 Readiness Probe :

livenessProbe:

httpGet:

path: /healthz

port: 8080

initialDelaySeconds: 30

periodSeconds: 10

failureThreshold: 3

readinessProbe:

exec:

command:

- cat

- /tmp/ready

initialDelaySeconds: 5

periodSeconds: 5

-

livenessProbe:用于判断容器是否存活,失败则触发重启; -

readinessProbe:决定容器是否准备好接收流量,失败则从 Service Endpoints 中移除; -

initialDelaySeconds:首次探测前等待时间,避免启动慢的应用误判; -

periodSeconds:探测频率; -

failureThreshold:连续失败几次后视为异常。

这套机制确保了应用的自愈能力,是实现高可用服务的基础。

4.2 核心资源对象的声明式管理

Kubernetes 的强大之处在于其基于“期望状态”的声明式管理模式。用户只需描述“想要什么”,系统便会自动驱使现实状态向目标收敛。这一节聚焦四大核心资源对象:Pod、Deployment、Service 和 ConfigMap/Secret,分析其设计原理与实战用法。

4.2.1 Pod调度原理与亲和性/反亲和性配置

Pod 是 Kubernetes 中最小的调度单位,代表一个或多个共享网络命名空间和存储卷的容器集合。虽然可以直接创建 Pod,但在生产中几乎总是通过控制器(如 Deployment)来管理。

调度过程大致如下:

- 用户提交 Pod 定义 → 存入 etcd;

-

kube-scheduler监听到未绑定 Node 的 Pod; - 执行预选(Predicates)筛选符合条件的节点(如资源充足、端口不冲突);

- 执行优选(Priorities)打分排序,选择最优节点;

- 将结果写回 API Server,Pod 被绑定至特定 Node;

-

kubelet在对应节点上创建并运行容器。

为了精细化控制调度行为,Kubernetes 提供了 Node Affinity 和 Pod Affinity/Anti-affinity 机制。

Node Affinity 示例:

affinity:

nodeAffinity:

requiredDuringSchedulingIgnoredDuringExecution:

nodeSelectorTerms:

- matchExpressions:

- key: kubernetes.io/os

operator: In

values:

- linux

preferredDuringSchedulingIgnoredDuringExecution:

- weight: 1

preference:

matchExpressions:

- key: gpu

operator: Exists

-

requiredDuringScheduling...:硬性要求,必须满足才能调度; -

preferred...:软性偏好,影响打分权重; -

operator: In,Exists:支持多种匹配逻辑; -

weight:优先级权重,范围 1–100。

Pod Anti-affinity 示例(避免单点故障):

podAntiAffinity:

requiredDuringSchedulingIgnoredDuringExecution:

- labelSelector:

matchExpressions:

- key: app

operator: In

values:

- nginx

topologyKey: kubernetes.io/hostname

表示:不允许将带有 app=nginx 标签的 Pod 调度到已有同类 Pod 的节点上,从而实现跨节点分布。

这在数据库主从复制、缓存集群等场景中尤为重要。

4.2.2 Deployment控制器实现滚动更新与回滚

Deployment 是管理无状态应用的标准控制器。它通过管理 ReplicaSet 来保证指定数量的 Pod 副本始终运行,并支持声明式的滚动更新策略。

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-deploy

spec:

replicas: 3

strategy:

type: RollingUpdate

rollingUpdate:

maxSurge: 1

maxUnavailable: 1

selector:

matchLabels:

app: nginx

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.21

ports:

- containerPort: 80

参数详解:

-

replicas: 期望副本数; -

strategy.type: 更新策略,RollingUpdate或Recreate; -

maxSurge: 更新期间最多超出期望副本的数量(绝对值或百分比); -

maxUnavailable: 更新过程中允许不可用的 Pod 数量; -

selector.matchLabels: 定义哪些 Pod 属于此 Deployment; -

template: Pod 模板,任何变更都会触发滚动更新。

执行更新时(如修改镜像版本):

kubectl set image deployment/nginx-deploy nginx=nginx:1.25

Kubernetes 会逐步创建新版本 Pod,同时终止旧版本,直到全部替换完成。若发现问题,可立即回滚:

kubectl rollout undo deployment/nginx-deploy

还可查看历史版本与状态:

kubectl rollout history deployment/nginx-deploy

kubectl rollout status deployment/nginx-deploy

这种机制极大降低了发布风险,是 CI/CD 流水线集成的理想选择。

4.2.3 Service与Ingress实现南北向流量接入

尽管 Pod 具备 IP 地址,但由于其短暂性(临时 IP、频繁重建),直接访问并不现实。为此,Kubernetes 提供了 Service 抽象层,为一组 Pod 提供稳定的虚拟 IP(ClusterIP)和 DNS 名称。

apiVersion: v1

kind: Service

metadata:

name: nginx-svc

spec:

selector:

app: nginx

ports:

- protocol: TCP

port: 80

targetPort: 80

type: NodePort

-

selector:关联后端 Pod; -

port:Service 暴露的端口; -

targetPort:Pod 上实际监听的端口; -

type: 可选ClusterIP(内部)、NodePort(节点暴露)、LoadBalancer(云厂商 ELB)。

而对于 HTTP(S) 流量, Ingress 提供了更高级的路由能力,支持基于 Host 和 Path 的转发规则:

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: example-ingress

annotations:

nginx.ingress.kubernetes.io/rewrite-target: /$1

spec:

ingressClassName: nginx

rules:

- host: app.example.com

http:

paths:

- path: /api(/|$)(.*)

pathType: Prefix

backend:

service:

name: api-svc

port:

number: 80

- path: /(.*)

pathType: Prefix

backend:

service:

name: ui-svc

port:

number: 80

该配置将 /api/** 转发至 api-svc ,其余路径转至 ui-svc ,并通过重写注解去除前缀。配合 Cert-Manager 自动签发 HTTPS 证书,即可实现安全的对外暴露。

4.2.4 ConfigMap与Secret敏感信息外部化管理

硬编码配置和密钥是运维大忌。Kubernetes 提供 ConfigMap 和 Secret 两种资源,用于将配置与代码分离。

ConfigMap 示例:

apiVersion: v1

kind: ConfigMap

metadata:

name: app-config

data:

log.level: "info"

db.url: "mysql://db:3306/myapp"

可在 Pod 中挂载为环境变量或卷:

env:

- name: LOG_LEVEL

valueFrom:

configMapKeyRef:

name: app-config

key: log.level

Secret 示例(Base64 编码):

apiVersion: v1

kind: Secret

metadata:

name: db-secret

type: Opaque

data:

username: YWRtaW4= # base64("admin")

password: MWYyZDFlMmU2N2Rm # base64("secret")

使用方式类似:

env:

- name: DB_USER

valueFrom:

secretKeyRef:

name: db-secret

key: username

注意:Secret 并非加密存储,默认仍以 Base64 存于 etcd。建议启用静态加密(EncryptionConfiguration)或使用外部密钥管理服务(如 Hashicorp Vault)集成。

通过这两类资源,团队可实现“一次定义,多环境复用”的配置管理模式,显著提升部署灵活性与安全性。

5. 服务发现与服务网格(Istio/Linkerd)实现

在现代云原生架构中,随着微服务数量的指数级增长,服务之间的通信复杂度急剧上升。传统的基于DNS和负载均衡器的服务发现机制已难以应对动态拓扑、细粒度流量控制以及安全策略统一实施等需求。因此,服务网格(Service Mesh)作为一种独立于应用逻辑的基础设施层,逐渐成为解决分布式系统通信问题的核心技术手段。本章将深入探讨服务发现所面临的挑战及其演进路径,并系统性地解析 Istio 与 Linkerd 两大主流服务网格的技术原理、功能实践及选型考量。

5.1 服务间通信挑战与解决方案演进

在微服务架构普及之前,单体应用内部各模块间的调用是通过进程内方法调用完成的,通信透明且高效。然而,当业务被拆分为数十甚至上百个独立部署的服务后,跨网络的远程调用成为常态,随之而来的是延迟增加、故障传播风险提升、协议异构等问题。如何确保服务之间能够可靠、安全、可观测地通信,成为了架构设计中的关键课题。

5.1.1 DNS + 负载均衡的传统局限性

早期微服务架构多依赖 DNS 解析结合客户端或服务端负载均衡器来实现服务发现。例如,在 Kubernetes 中,Service 对象会自动创建 ClusterIP 并注册到集群 DNS 服务器,其他服务可通过域名访问目标服务。这种模式看似简单直接,但在实际生产环境中暴露出诸多不足:

- 更新延迟 :DNS 缓存普遍存在,TTL 设置过短会影响性能,过长则导致服务实例变更无法及时感知。

- 缺乏智能路由能力 :标准 DNS 不支持权重分配、金丝雀发布、熔断降级等高级流量管理功能。

- 安全性薄弱 :默认通信为明文传输,缺乏身份认证与加密机制。

- 可观测性缺失 :无法获取详细的请求指标(如响应时间、错误率),难以进行链路追踪。

下表对比了传统服务发现方式与现代服务网格的能力差异:

| 特性 | DNS + LB 方案 | 服务网格方案 |

|---|---|---|

| 服务发现时效性 | 秒级延迟(受DNS缓存影响) | 毫秒级同步(基于xDS协议) |

| 流量控制能力 | 基础轮询/随机负载均衡 | 支持灰度发布、镜像流量、重试策略 |

| 安全通信 | 需额外配置TLS | 默认mTLS加密,零信任架构 |

| 可观测性 | 依赖外部监控工具集成 | 内建指标、日志、追踪采集 |

| 协议兼容性 | 仅限HTTP/TCP | 支持gRPC、WebSocket、Kafka等多种协议 |

为了克服上述缺陷,业界开始探索更高级的通信抽象模型,其中最具代表性的是 Sidecar 代理模式。

5.1.2 Sidecar代理模式引入透明通信层

Sidecar 模式的核心思想是将通信逻辑从应用程序中剥离,交由一个与应用容器共存但独立运行的代理组件处理。该代理被称为“Sidecar”,它与主应用共享网络命名空间,拦截所有进出流量,并在此基础上提供丰富的治理能力。

graph TD

A[Microservice A] --> B[Sidecar Proxy A]

B --> C[Network]

C --> D[Sidecar Proxy B]

D --> E[Microservice B]

style A fill:#f9f,stroke:#333

style E fill:#f9f,stroke:#333

style B fill:#bbf,stroke:#fff,color:#fff

style D fill:#bbf,stroke:#fff,color:#fff

如上图所示,两个微服务之间的通信不再直接进行,而是通过各自的 Sidecar 代理完成。这种方式实现了以下优势:

- 无侵入性 :应用无需修改代码即可获得服务治理能力。

- 语言无关性 :无论服务使用 Java、Go 还是 Python 编写,只要 Sidecar 支持相应协议即可介入。

- 集中化策略管理 :路由规则、安全策略可统一在控制平面定义并下发。

以 Istio 使用的 Envoy 为例,其作为高性能 C++ 编写的 L4/L7 代理,具备强大的过滤链机制,可在不中断连接的前提下动态加载配置。

5.1.3 流量劫持与mTLS加密通道建立过程

为了让 Sidecar 能够拦截所有进出流量,必须在 Pod 启动时配置 iptables 规则,将原始目标地址重定向至本地运行的代理端口(通常为15001)。这一过程称为“流量劫持”(Traffic Interception)。

以下是 Istio 注入 Sidecar 后的典型 iptables 规则片段(简化版):

# 将出站流量重定向到Envoy监听端口

iptables -t nat -A OUTPUT -p tcp --match owner ! --uid-owner 1337 \

-j REDIRECT --to-port 15001

# 排除特定端口(如健康检查探针)

iptables -t nat -A OUTPUT -p tcp --dport 15021 -j RETURN

参数说明:

- -t nat :指定nat表,用于地址转换;

- --match owner ! --uid-owner 1337 :排除istio-proxy用户(UID=1337)自身发出的流量,防止循环;

- --to-port 15001 :重定向至Envoy的 inbound listener;

- --dport 15021 :允许探针直连健康检查端口,绕过代理。

逻辑分析:

该规则确保除代理自身外的所有容器进程发起的 TCP 请求都会被强制转发到 Envoy。Envoy 再根据目的地查询服务注册表,决定是否走本地转发还是远程调用,并自动建立 mTLS 加密连接。

mTLS(双向 TLS)的建立流程如下:

1. 控制平面(Pilot)向每个 Sidecar 分发证书和私钥;

2. 当服务A调用服务B时,Envoy A 发起 TLS 握手并出示证书;

3. Envoy B 验证证书有效性(签发机构、有效期、SPIFFE ID);

4. 双方协商会话密钥,建立加密信道;

5. 应用层数据经加密后传输,中间人无法窃听或篡改。

整个过程对应用完全透明,开发者无需关心证书轮换、密钥存储等细节。

5.1.4 控制平面与数据平面分离架构优势

服务网格采用典型的控制平面(Control Plane)与数据平面(Data Plane)分离架构。控制平面负责策略决策与配置分发,数据平面执行具体的流量处理任务。

| 组件类型 | 功能职责 | 典型代表 |

|---|---|---|

| 控制平面 | 服务注册、策略管理、证书签发、配置推送 | Istiod(Istio)、Linkerd Controller |

| 数据平面 | 流量拦截、协议解析、mTLS加密、指标上报 | Envoy、Linkerd Proxy |

二者通过标准协议通信。Istio 使用 xDS(extension Discovery Service)系列 gRPC API 实现配置同步:

// 示例:LDS(Listener Discovery Service)响应结构

message Listener {

string name = 1;

repeated FilterChain filter_chains = 2;

bool use_original_dst = 3;

}

Envoy 定期向 Pilot 请求最新的 Listener、Route、Cluster 和 Endpoint 配置,形成完整的转发决策树。由于 xDS 支持增量更新,即使大规模集群也能保持低延迟同步。

该架构的优势体现在:

- 解耦清晰 :控制逻辑与转发逻辑分离,便于独立升级;

- 可扩展性强 :可通过插件机制扩展自定义策略引擎;

- 高可用保障 :控制平面可多副本部署,数据平面无状态运行;

- 调试友好 :可通过 istioctl proxy-config 查看当前生效配置。

综上所述,服务网格通过 Sidecar 架构、流量劫持、mTLS 加密和控制面/数据面分离四大核心技术,构建了一个强大而灵活的服务通信基础设施层,为后续精细化治理奠定了基础。

5.2 Istio服务网格核心功能实践

Istio 是目前最成熟、生态最完善的服务网格实现之一,广泛应用于金融、电商、电信等行业。其强大的流量管理、安全保障与可观测性能力,使其成为企业级微服务治理的理想选择。本节将以实战视角展示 Istio 的关键资源对象及其应用场景。

5.2.1 Gateway与VirtualService实现灰度发布

灰度发布(Canary Release)是一种逐步将新版本服务暴露给部分用户的安全上线策略。在 Istio 中,可通过 Gateway 和 VirtualService 协同实现。

假设有一个名为 product-service 的服务,现有 v1 版本稳定运行,现需上线 v2 版本。YAML 配置如下:

apiVersion: networking.istio.io/v1beta1

kind: Gateway

metadata:

name: public-gateway

spec:

selector:

istio: ingressgateway

servers:

- port:

number: 80

name: http

protocol: HTTP

hosts:

- "products.example.com"

apiVersion: networking.istio.io/v1beta1

kind: VirtualService

metadata:

name: product-route

spec:

hosts:

- "products.example.com"

gateways:

- public-gateway

http:

- route:

- destination:

host: product-service

subset: v1

weight: 90

- destination:

host: product-service

subset: v2

weight: 10

参数说明:

- gateways : 关联外部入口网关;

- hosts : 匹配请求 Host 头;

- weight : 按百分比分流流量。

逻辑分析:

当用户访问 products.example.com 时,Ingress Gateway 接收请求并查询 VirtualService 路由规则,按 90%/10% 的比例将流量导向 v1 和 v2 实例。可通过持续观察 v2 的错误率与延迟表现,逐步提高权重直至全量切换。

此外,还可基于 Header 进行精准引流:

http:

- match:

- headers:

end-user:

exact: "testuser"

route:

- destination:

host: product-service

subset: v2

此规则使特定用户始终访问测试版本,适用于 A/B 测试场景。

5.2.2 DestinationRule配置熔断与连接池参数

DestinationRule 定义目标服务的策略,包括负载均衡方式、连接池限制和熔断规则。

apiVersion: networking.istio.io/v1beta1

kind: DestinationRule

metadata:

name: product-dr

spec:

host: product-service

trafficPolicy:

connectionPool:

tcp:

maxConnections: 100

http:

http1MaxPendingRequests: 10

maxRequestsPerConnection: 10

outlierDetection:

consecutive5xxErrors: 5

interval: 30s

baseEjectionTime: 5m

参数说明:

- maxConnections : TCP 最大连接数,防止单个客户端耗尽后端资源;

- http1MaxPendingRequests : 超出连接池容量时的最大排队请求数;

- consecutive5xxErrors : 连续5次5xx错误触发熔断;

- baseEjectionTime : 异常实例驱逐时间。

该配置有效缓解雪崩效应,提升整体系统韧性。

5.2.3 Telemetry收集指标并对接Prometheus

Istio 内建遥测能力,通过 Envoy 生成丰富的监控指标,并默认推送至 Prometheus。

关键指标包括:

- istio_requests_total :按服务、版本、响应码统计请求数;

- istio_request_duration_milliseconds :P50/P90/P99 延迟分布;

- istio_tcp_sent_bytes_total :TCP 层流量统计。

可通过 Prometheus 查询语句分析服务质量:

# 计算product-service的P99延迟

histogram_quantile(0.99, sum(rate(istio_request_duration_milliseconds_bucket{destination_service="product-service"}[5m])) by (le))

# 统计v2版本的错误率

sum(rate(istio_requests_total{destination_service="product-service",response_code=~"5.*",destination_version="v2"}[5m]))

/

sum(rate(istio_requests_total{destination_service="product-service",destination_version="v2"}[5m]))

这些指标可用于 Grafana 可视化看板构建,实现实时监控告警。

5.2.4 AuthorizationPolicy实施零信任安全策略

零信任原则要求“永不信任,始终验证”。Istio 提供 AuthorizationPolicy 资源实现细粒度访问控制。

apiVersion: security.istio.io/v1beta1

kind: AuthorizationPolicy

metadata:

name: deny-all

namespace: default

spec:

selector:

matchLabels:

app: payment-service

action: DENY

rules:

- from:

- source:

namespaces: ["unknown"]

该策略拒绝来自未知命名空间的所有访问请求。可进一步细化到具体方法、路径或 JWT 声称:

rules:

- when:

- key: request.auth.claims[role]

values: ["admin"]

配合 OPA Gatekeeper 或 SPIFFE/SPIRE 身份框架,可构建完整的企业级零信任安全体系。

5.3 Linkerd轻量级服务网格对比与选型建议

5.3.1 架构简洁性与资源消耗表现测评

Linkerd 以其极简设计著称,控制平面仅包含 controller、identity、destination 等少量组件,总内存占用小于 100MB,远低于 Istio 的 GB 级别开销。

| 指标 | Istio | Linkerd |

|---|---|---|

| 控制平面资源占用 | ~1.5GB RAM | ~80MB RAM |

| 数据平面延迟增加 | ~1ms | ~0.5ms |

| 安装复杂度 | 高(多组件) | 低(一键安装) |

| 学习曲线 | 陡峭 | 平缓 |

对于资源敏感型环境(如边缘计算、IoT 网关),Linkerd 更具优势。

5.3.2 自动重试与延迟感知负载均衡能力

Linkerd 默认启用延迟感知负载均衡(Latency-Based Load Balancing),优先选择响应最快的后端实例。

# linkerd-proxy配置示例

[lb]

policy = "ewma" # 指数加权移动平均算法

decay = "10s"

同时支持自动重试失败请求(非幂等操作除外),显著提升最终成功率。

5.3.3 可观测性内置Dashboard使用体验

Linkerd 提供开箱即用的 Web UI:

linkerd dashboard

页面展示服务拓扑图、实时指标趋势、命名空间健康评分等信息,无需额外配置 Prometheus 或 Grafana。

5.3.4 在边缘计算场景下的适用性分析

在边缘节点资源受限、网络不稳定的情况下,Linkerd 的低开销与快速启动特性尤为突出。其 Rust 编写的 proxy 组件 crash 率极低,适合长时间无人值守运行。

5.4 服务网格在真实业务场景中的落地效果

5.4.1 全链路追踪可视化定位性能瓶颈

集成 Jaeger 后,可追踪每个请求经过的所有服务节点,识别慢调用环节。

5.4.2 动态流量切分支持A/B测试与金丝雀发布

通过 CLI 快速调整 VirtualService 权重,实现分钟级策略变更。

5.4.3 故障注入测试系统容错能力验证

faultInjection:

delay:

percentage:

value: 50

fixedDelay: 5s

模拟网络延迟,检验超时重试机制有效性。

5.4.4 网格化改造前后SLA变化趋势统计

某电商平台数据显示,接入 Istio 后 P99 延迟下降 37%,月度故障恢复时间缩短 62%,MTTR 显著改善。

6. 基于Jenkins/GitLab CI/CD的自动化流水线构建

6.1 持续集成与持续部署核心流程设计

在云原生架构中,CI/CD(持续集成与持续部署)是实现高效交付的核心引擎。一个健壮的自动化流水线不仅能提升发布频率,还能显著降低人为错误风险。现代CI/CD流程已从简单的“提交即构建”演进为涵盖代码质量、安全扫描、镜像打包、多环境部署和回滚机制的完整闭环。

典型的CI/CD流水线包含以下关键阶段:

| 阶段 | 目标 | 工具示例 |

|---|---|---|

| 代码提交触发 | 监听Git仓库事件,启动流水线 | Webhook, Git hooks |

| 构建与编译 | 编译源码,生成可执行文件或中间产物 | Maven, Gradle, npm |

| 单元测试 | 执行UT用例,确保基本功能正确 | JUnit, pytest, Jest |

| 静态代码分析 | 检测潜在缺陷、编码规范违规 | SonarQube, ESLint, Checkstyle |

| 安全扫描 | 检查依赖漏洞与镜像安全 | Trivy, Clair, Snyk |

| 镜像构建 | 使用Dockerfile打包应用为容器镜像 | Docker, Kaniko |

| 推送镜像 | 将镜像推送到私有或公共镜像仓库 | Harbor, AWS ECR, GCR |

| 多环境部署 | 按照 dev → staging → prod 分级灰度发布 | Helm, kubectl, Argo CD |

| 回滚机制 | 快速恢复至上一稳定版本 | K8s Rollback, Helm rollback |

| 审计日志 | 记录每次变更的责任人与时间戳 | Jenkins Log, GitLab CI Job Log |

以一次标准Java Spring Boot项目发布为例,其CI/CD流程可抽象为如下mermaid流程图:

graph TD

A[代码 Push 到主干] --> B{触发CI Pipeline}

B --> C[运行单元测试]

C --> D[静态代码扫描]

D --> E[构建JAR包]

E --> F[使用Docker构建镜像]

F --> G[推送至Harbor镜像仓库]

G --> H[部署到Dev环境]

H --> I[自动化API测试]

I --> J[手动审批进入Staging]

J --> K[部署到Staging环境]

K --> L[性能压测 & 安全审计]

L --> M[审批上线Prod]

M --> N[通过Argo CD同步K8s集群状态]

该流程体现了“左移”质量控制理念——尽可能早地发现问题。例如,在代码提交后5分钟内即可反馈测试结果,避免问题向下游传递。

此外,多环境分级发布策略需结合命名空间隔离实现。例如在Kubernetes中:

# deploy-prod.yaml 片段

apiVersion: apps/v1

kind: Deployment

metadata:

name: user-service

namespace: prod # 区分dev/staging/prod命名空间

spec:

replicas: 3

selector:

matchLabels:

app: user-service

template:

metadata:

labels:

app: user-service

spec:

containers:

- name: app

image: harbor.example.com/project/user-service:v1.2.3

ports:

- containerPort: 8080

配合RBAC权限控制,不同团队只能操作指定namespace,保障生产环境安全性。

变更审计方面,建议将所有CI/CD操作日志接入ELK或Loki系统,并与企业身份系统(如LDAP/OAuth)集成,确保每条部署记录均可追溯至具体责任人。

为了支持高频发布,还需设计自动回滚机制。例如通过Prometheus监控接口错误率,当超过阈值时触发告警并调用Jenkins API执行rollback:

# 示例:检测失败率过高后触发回滚

if curl -s "http://prometheus:9090/api/v1/query?query=rate(http_requests_total{status='5xx'}[5m])" | jq '.data.result[0].value[1]' | awk '{print $1 > 0.1}'; then

jenkins-cli.jar build rollback-pipeline -p APP_NAME=user-service

fi

上述机制共同构成了现代CI/CD的基础骨架,为后续基于声明式Pipeline的工程化实践奠定基础。

简介:在数字化转型浪潮下,云原生微服务架构已成为现代企业应用开发的核心范式。本专栏资源“云原生微服务架构实战精讲”系统讲解了基于容器、Kubernetes、服务网格与CI/CD的微服务设计与实践方法,涵盖从基础理论到真实场景的完整技术链条。通过实际案例驱动,帮助开发者掌握高可用、可扩展、易维护的分布式系统构建能力,深入理解DevOps文化、服务治理、监控日志体系及安全策略,全面提升云原生环境下的工程落地水平。

949

949

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?