训练好一个神经网络模型后,我们希望能够将其应用在预测数据上,所以需要保存和恢复模型。

保存和恢复

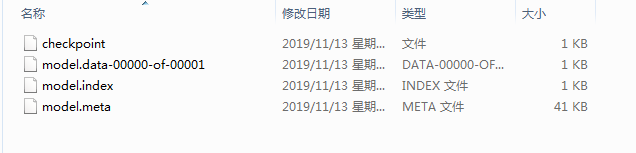

TensorFlow提供了一个非常简单的API来存储和加载一个神经网络模型。虽然以上程序只指定了一个文件路径,但是在这个文件目录下会出现四个文件。这是因为TensorFlow会将计算图的结构和图上参数取值分开保存。

***.meta保存了Tensorflow计算图的结构。

ckpt文件保存了Tensorflow程序中每一个变量的取值

|--***.data-00000-of-00001

|--***.index

checkpoint保存最新的checkpoint文件以及其它checkpoint文件列表

示例演示

将前面构建的神经网络训练后保存模型,并重新加载模型进行检测。

import os

import tensorflow as tf

from numpy.random import RandomState

#定义训练数据batch的大小

batch_size = 8

#定义神经网络的参数,随机初始化

w1 = tf.Variable(tf.random_normal([2, 3], stddev=1, seed=1))

w2 = tf.Variable(tf.random_normal([3, 1], stddev=1, seed=1))

#在shape上的一个维度上使用None可以方便使用不同的batch大小

x = tf.placeholder(tf.float32, shape=(None, 2), name='x-input')

y_ = tf.placeholder(tf.float32, shape=(None, 1), name='y-input')

#定义神经网络前向传播的过程

a = tf.matmul(x, w1)

y = tf.matmul(a, w2)

y = tf.sigmoid(y, name="predict")

#定义损失函数:交叉熵

cross_entropy = -tf.reduce_mean(y_ * tf.log(tf.clip_by_value(y, 1e-10, 1.0))

+(1-y_) * tf.log(tf.clip_by_value(1 - y, 1e-10, 1.0)))

#反向传播算法应用

train_step = tf.train.AdamOptimizer(0.001).minimize(cross_entropy)

#通过随机数生成一个数据集

rdm = RandomState(1)

dataset_size = 128

X = rdm.rand(dataset_size, 2)

#认为x1+x2<1的样本都认为是正样本,用0表示负样本,1来表示正样本

Y = [[int(x1+x2 < 1)] for (x1, x2) in X]

saver = tf.train.Saver()

with tf.Session() as sess:

#初始化变量

init = tf.global_variables_initializer()

sess.run(init)

print("Before training:")

print(sess.run(w1))

print(sess.run(w2))

#设定训练的次数

STEPS = 5000

for i in range(STEPS):

#每次选取batch_size个样本进行训练

start = (i * batch_size) % dataset_size

end = min(start + batch_size, dataset_size)

#通过选取的样本训练神经网络并更新参数

sess.run(train_step, feed_dict={x: X[start:end], y_: Y[start:end]})

print(sess.run(w1))

print(sess.run(w2))

result = sess.run(y, feed_dict={x: [[0.5, 0.6]]})

print("Train: ")

print(result)

#保存模型

saver.save(sess, './ckpt_dir/model')

if __name__ == "__main__":

with tf.Session() as sess:

if os.path.exists('./ckpt_dir/model.meta'):

#恢复模型的图结构

saver = tf.train.import_meta_graph('./ckpt_dir/model.meta')

#恢复模型的参数

saver.restore(sess, tf.train.latest_checkpoint('./'))

graph = tf.get_default_graph()

#通过name获得操作

operation_to_restore = graph.get_tensor_by_name("predict:0")

result = sess.run(operation_to_restore, feed_dict={x: [[0.5, 0.6]]})

print("SaveAndRestore: ")

print(result)

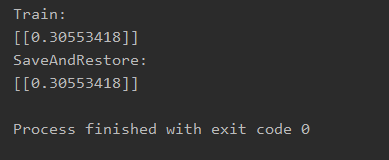

运行结果

加载后运行神经网络进行预测

本文介绍了如何在TensorFlow中保存和恢复神经网络模型。详细解释了保存模型时产生的四个文件的作用,包括*.meta文件保存计算图结构,ckpt文件保存变量取值,以及checkpoint文件保存checkpoint列表。并通过一个神经网络训练的例子,演示了模型的保存和恢复过程。

本文介绍了如何在TensorFlow中保存和恢复神经网络模型。详细解释了保存模型时产生的四个文件的作用,包括*.meta文件保存计算图结构,ckpt文件保存变量取值,以及checkpoint文件保存checkpoint列表。并通过一个神经网络训练的例子,演示了模型的保存和恢复过程。

1323

1323

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?