同步案例

同步方法与案例就不在阐述,可以看这篇文档同步案例

同步计划

开始时间:2021年12月28日14:56:39

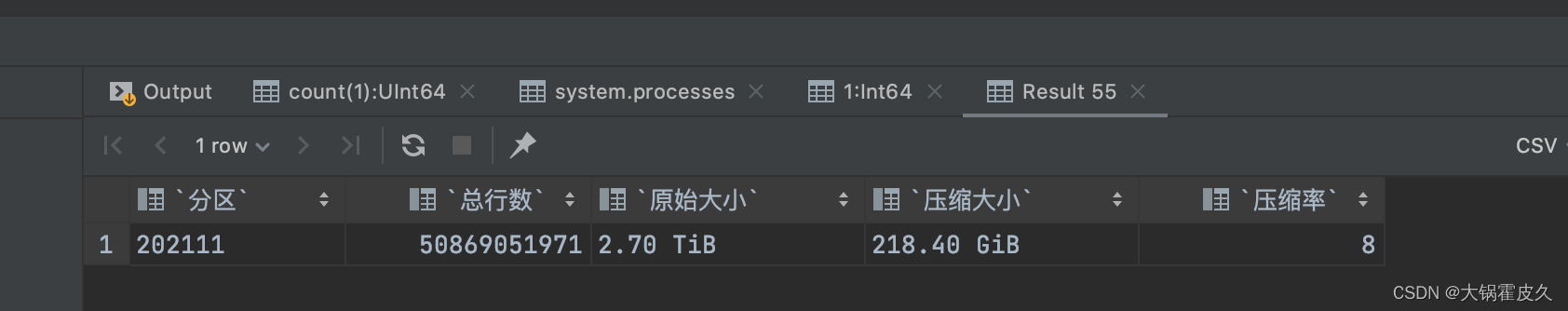

计划同步数据量:50869051971

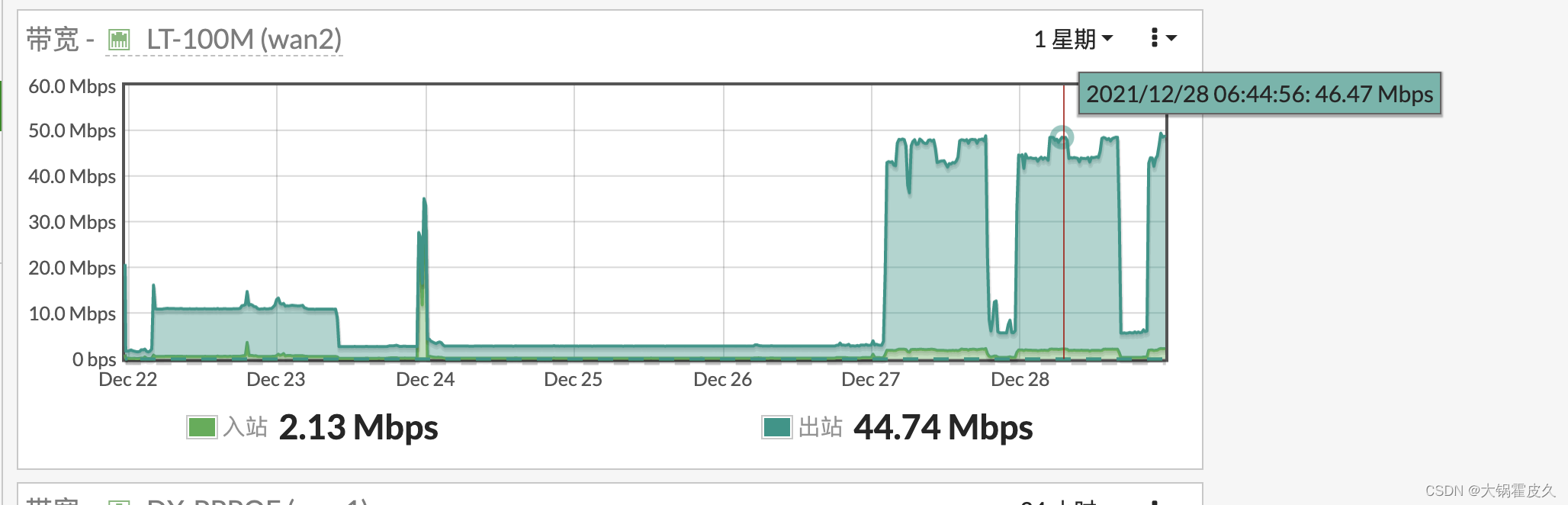

带宽占用:40~50Mb/S

结束时间:2021年12月29日 07:44:06

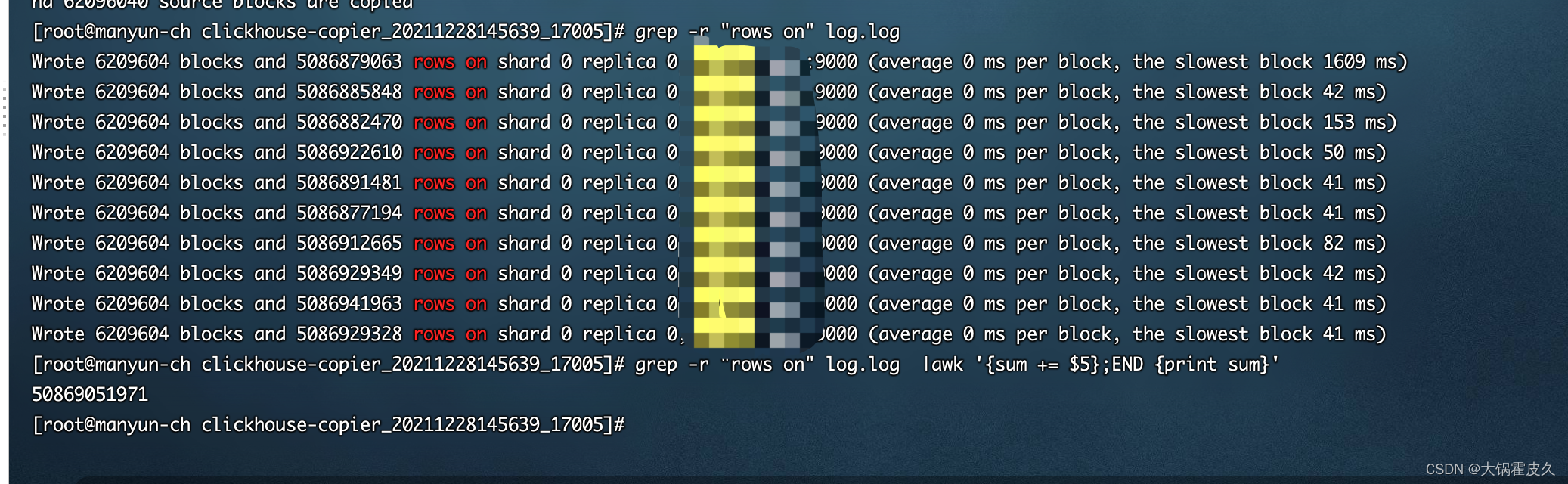

实际同步数据量:15260647381

计划同步数据量截图

带宽占用截图

实际同步数据量截图

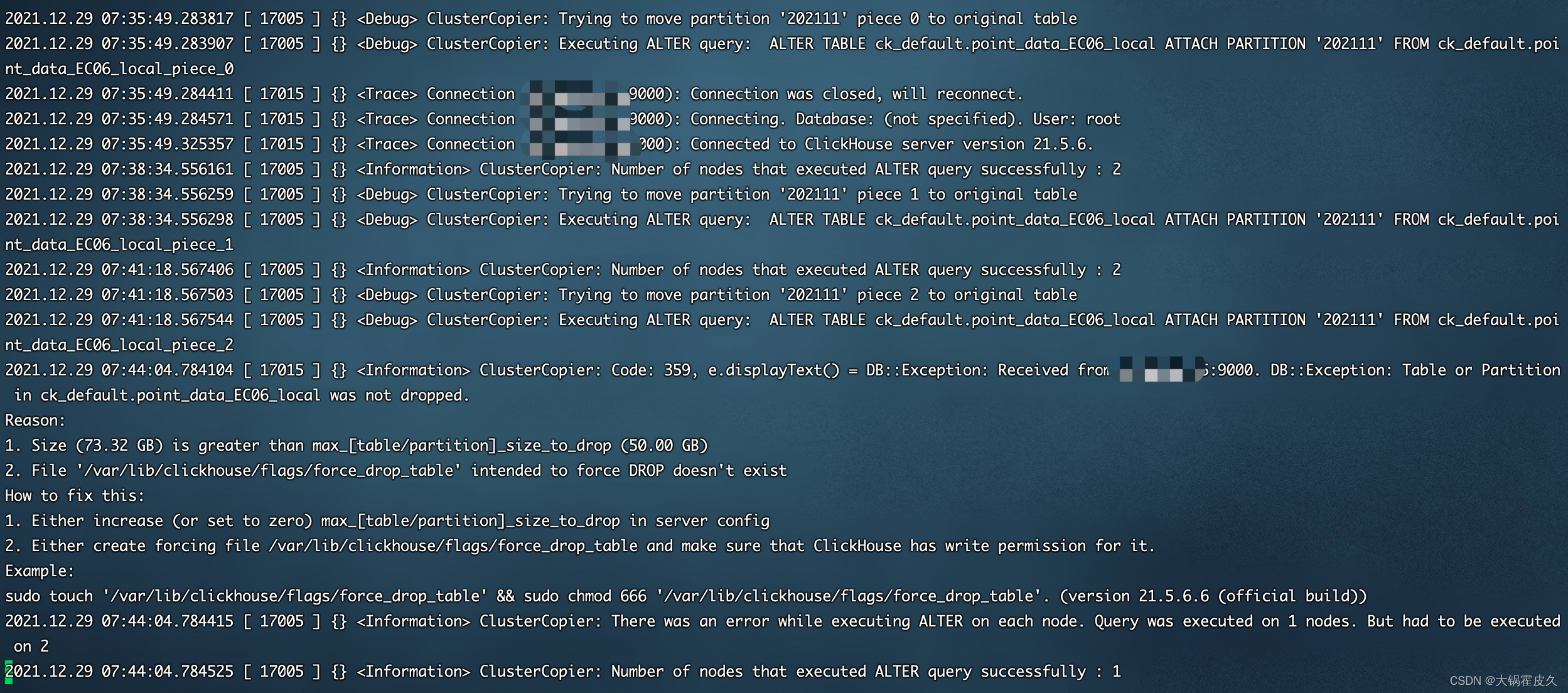

根据下图日志中反馈发现在写入piece 2的时候出现这种错误的原因在报错中已经体现出来,就是ClickHouse默认对一次ALTER TABLE命令的影响数据量大小有限制,不能超过50G,超过50G就会报错无法删除。

解决方案①

手动创建force_drop_table后再执行alter table。

- 每次alter table 50G的表后后都会删除该文件。

- 本次迁移一共会执行10次alter table 从第三次开始(因前两次导入到目标表后,目标表的数据量暂时未超过50G,第三次的开始的时候,发现目标的数据超过50G了)此时出现50G限制的报错,所以该方案并不适用。

解决方案②(采纳)

通过修改配置文件config.xml永久生效。

<max_table_size_to_drop>0</max_table_size_to_drop>

<max_partition_size_to_drop>0</max_partition_size_to_drop>

本文档记录了使用clickhouse-copier过程中遇到的数据同步问题,由于ClickHouse对ALTER TABLE命令的数据量有限制,超过50G会报错。解决方案包括尝试手动删除表以及修改配置文件config.xml永久提升限制。最终采纳的解决方案是通过修改配置文件,增加<max_table_size_to_drop>和<max_partition_size_to_drop>为0来允许大表的删除。

本文档记录了使用clickhouse-copier过程中遇到的数据同步问题,由于ClickHouse对ALTER TABLE命令的数据量有限制,超过50G会报错。解决方案包括尝试手动删除表以及修改配置文件config.xml永久提升限制。最终采纳的解决方案是通过修改配置文件,增加<max_table_size_to_drop>和<max_partition_size_to_drop>为0来允许大表的删除。

2010

2010

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?