CLICKHOUSE几个常见问题处理以及常用命令(持续更新)

- 常见问题

- 常用命令

常见问题

数据库报错分区键错误Too Many Parts (100000)

现象: 因原表采用了微秒作为分区键,导致该表分区超过100000个。导致新数据无法写入。

查看诸多资料后,分区键无法修改,只能新建表。也就是需要进行重新创建分区。

解决方案:

微秒字段转换成YYYYMM作为分区键

FROM_UNIXTIME(toInt32(alarm_time/1000),'%Y%m')

- 在集群中创建新的本地表alarm_new_local

- 在集群中创建分布式表alarm_new

- 将源分布式表alarm写入alarm_new

- 删除源分布式表alarm

- 新建新的分布式表alarm连接新本地表

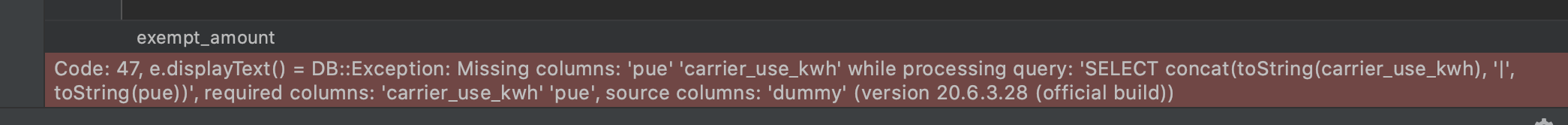

执行concat (别名1,‘|’ ,别名2) 组成一个字段报错source colums:‘dummy’

现象:

测试环境中执行类似sqlselect concat(toString(field1), '|', toString(field2)) as memo from 库名.表名;发生报错 ,截图如下。而在线上版本中可以正常执行

解决方案:

测试环境升级版本至于线上相同或者更新后解决该问题

yum install -y yum-utils

rpm --import https://repo.clickhouse.tech/CLICKHOUSE-KEY.GPG

yum-config-manager --add-repo https://repo.clickhouse.tech/rpm/clickhouse.repo

yum install -y clickhouse-server clickhouse-client

yum list clickhouse-server --showduplicates | sort -r

sleep 10

systemctl restart clickkouse

删除旧集群表后重建,5分钟左右出现zk中该表的配置文件消失的情况

网上的解决方案测试后无效

网上案例

现象:

- 确认metadata和data下无该表数据。

- 确认zk中无该表数据。

- 重建表后5分钟左右配置文件消失,但metadata和data下有该表(日志中会出现 No node, path)。此时该表形同虚设,无法正常使用。

- 标记该问题为bug,可能部分数据存在于缓存中导致无法重建

解决方案:

我通过更换表名后,zk中该表的配置文件不会消失。通过此方式解决该问题。需谨慎使用。

如何处理socket_timeout超时问题

HTTP协议在监听socket返回结果时的等待时间,DMS平台上默认设置是7200s,jdbc driver、DataGrip上默认是30s。该参数不是Clickhouse系统内的参数,它属于jdbc在HTTP协议上的参数,但它是会影响到前面的max_execution_time参数设置效果,因为它决定了客户端在等待结果返回上的时间限制。所以一般用户在调整max_execution_time参数的时候也需要配套调整socket_timeout参数,略微高于max_execution_time即可。用户设置参数时需要在jdbc链接串上添加socket_timeout这个property,单位是毫秒,例如:‘jdbc:clickhouse://127.0.0.1:8123/default?socket_timeout=3600000’。

重建分片01后,利用脚本创建分区表与本地表后报错如下

2021.10.13 17:43:30.543624 [ 56 ] {} ck_cdtp.point_data_local (fd45ddc2-c829-41a6-8dd5-b943838aa715): void DB::StorageReplicatedMergeTree::queueUpdatingTask(): Code: 999, e.displayText() = Coordination::Exception: Can’t get data for node /ck_cdtp/tables/01/point_data_local/replicas/manyun-ch.1/log_pointer: node doesn’t exist (No node), Stack trace (when copying this message, always include the lines below):

解决方案:

登录zk查看/ck_cdtp/tables/01/point_data_local/replicas/查看01分片节点是否存在,如果不存在,则删除本地表单独重新创建

分布式DDL某数据节点的副本不执行

问题:使用分布式ddl执行命令create table on cluster xxxx 某个节点上没有创建表,但是client返回正常,查看日志有如下报错。

nebula_dc.dc_test1: Retrying createReplica(), because some other replicas were created at the same time

解决方案:

重启该不执行的节点。

数据副本表和数据不一致

问题:

由于某个数据节点副本异常,导致两数据副本表不一致,某个数据副本缺少表,需要将两个数据副本调整一致。

解决方案:

- 在缺少表的数据副本节点上创建缺少的表,创建为本地表,表结构可以在其他数据副本通过show crete table xxxx获取。

- 表结构创建会clickhouse会自动从其他副本同步该表数据,验证数据量是否一致即可。

问题:

某个数据副本异常无法启动,需要重新搭建副本。

解决方案:

3. 清空异常副本节点的metadata和data目录。

4. 从另一个正常副本将metadata目录拷贝过来(这一步之后可以启动数据库,但是只有表结构没有数据)。

5. 执行sudo -u clickhouse touch /data/clickhouse/flags/force_restore_data

6. 启动数据库。

数据副本启动缺少zk表

问题:某个数据副本表在zk上丢失数据,或者不存在,但是metadata元数据里存在,导致启动异常

报错:>Can’t get data for node /clickhouse/tables/01-02/xxxxx/xxxxxxx/replicas/cluster01-02-2/metadata: node doesn’t exist (No node): Cannot attach table xxxxxxx

解决方案:

- metadata中移除该表的结构文件,如果多个表报错都移除

mv metadata/xxxxxx/xxxxxxxx.sql /tmp/ - 启动数据库

- 手工创建缺少的表,表结构从其他节点show create table获取。

- 创建后会自动同步数据,验证数据是否一致。

ZK table replicas数据未删除,导致重建表报错

问题:重建表过程中,先使用drop table xxx on cluster xxx ,各节点在clickhouse上table已物理删除,但是zk里面针对某个clickhouse节点的table meta信息未被删除(低概率事件),因zk里仍存在该表的meta信息,导致再次创建该表create table xxx on cluster, 该节点无法创建表(其他节点创建表成功)

报错:Replica /clickhouse/tables/01-03/xxxxxx/xxx/replicas/cluster01-03-2 already exists…

解决方案:

- 从其他数据副本cp该table的metadata sql过来.

- 重启节点。

Clickhouse节点意外关闭

问题:模拟其中一个节点意外宕机,在大量insert数据的情况下,关闭某个节点。

现象:数据写入不受影响、数据查询不受影响、建表DDL执行到异常节点会卡住

报错:Code: 159. >DB::Exception: Received from localhost:9000. DB::Exception: Watching task /clickhouse/task_queue/ddl/query-0000565925 is executing longer than distributed_ddl_task_timeout (=180) seconds. There are 1 unfinished hosts (0 of them are currently active), they are going to execute the query in background.

解决方案:

启动异常节点,期间其他副本写入数据会自动同步过来,其他副本的建表DDL也会同步。

clickhouse-copier 对T级别数据过程中出现计划与实际同步数据量不同报错

常用命令

# 创建数据库 默认引擎是Ordinary

create database if not exist db_name [engine = engine]

# 不同的数据库之间复制表结构

create table if not exists new_db.table_name as default.table_name engine = tinylog

# 查看集群状态

select * from system.clusters;

# 查看分区信息

select partition_id,name,table,database,disk_name from system.parts;

# 查看指定表的分区信息

select partition_id,name,table,database,disk_name from system.parts where table='point_data_EC06'

# 删除某表的指定分区

alter table ck_default.point_data_test_local drop partition '202109';

# 为表增加TTL

ALTER TABLE ck.point_data MODIFY TTL time + INTERVAL 7 DAY;

# 为表中已存在的列字段添加 TTL 或 修改TTL

ALTER TABLE ck.point_data MODIFY COLUMN device_guid String TTL time + INTERVAL 2 MONTH;

# 查看远端zookeeper

select name,value,czxid,mzxid from system.zookeeper where path='/clickhouse'

# 查看自身节点的宏变量

select * from system.macros

# 查看节点版本

SELECT version();

SELECT * FROM system.build_options

# 通过http查看节点版本 ,即使无密码也可以查到版本号

http://cknode_ip:8123/?

# 删除数据库

drop database if not exist db_name

# 删除数据

alter table ck.point_data_replica DELETE WHERE point_code='EC01'

# 查看建表语句

show create table

# 查集群中的进程

select

query_id,read_rows,total_rows_approx,memory_usage,

initial_user,initial_address,elapsed,query

from system.processes;

# kill 指定进程

kill query on cluster manyun_ch_cluster where query_id='b2576756-7d28-43cb-bcc1-c2cb3cd9729d';

# 查看数据库容量 压缩比等

select

sum(rows) as row,--总行数

formatReadableSize(sum(data_uncompressed_bytes)) as ysq,--原始大小

formatReadableSize(sum(data_compressed_bytes)) as ysh,--压缩大小

round(sum(data_compressed_bytes) / sum(data_uncompressed_bytes) * 100, 0) ys_rate--压缩率

from system.parts

# 查看具体表的指标

select

database,

table,

formatReadableSize(size) as size,

formatReadableSize(bytes_on_disk) as bytes_on_disk,

formatReadableSize(data_uncompressed_bytes) as data_uncompressed_bytes,

formatReadableSize(data_compressed_bytes) as data_compressed_bytes,

compress_rate,

rows,

days,

formatReadableSize(avgDaySize) as avgDaySize

from

(

select

database,

table,

sum(bytes) as size,

sum(rows) as rows,

min(min_date) as min_date,

max(max_date) as max_date,

sum(bytes_on_disk) as bytes_on_disk,

sum(data_uncompressed_bytes) as data_uncompressed_bytes,

sum(data_compressed_bytes) as data_compressed_bytes,

(data_compressed_bytes / data_uncompressed_bytes) * 100 as compress_rate,

max_date - min_date as days,

size / (max_date - min_date) as avgDaySize

from system.parts

where active

and database = 'database'

and table = 'tablename'

group by

database,

table

)

# 查看表中的列数据大小

SELECT column,

any(type),

formatReadableSize(sum(data_uncompressed_bytes)) as ysq,--原始大小

formatReadableSize(sum(data_compressed_bytes)) as ysh,--压缩大小

sum(rows)

FROM system.parts_columns

WHERE database = 'database'

and table = 'tablename'

AND active

GROUP BY column

ORDER BY column ASC

# 跟踪分区

SELECT database,

table,

count() AS parts,

uniq(partition) AS partitions,

sum(marks) AS marks,

sum(rows) AS rows,

formatReadableSize(sum(data_compressed_bytes)) AS compressed,

formatReadableSize(sum(data_uncompressed_bytes)) AS uncompressed,

round((sum(data_compressed_bytes) / sum(data_uncompressed_bytes)) * 100.,2) AS percentage

FROM system.parts

WHERE active

and database = 'ck_default'

and table = 'point_data_EC06_local'

GROUP BY database, table

# 查看分区表信息

SELECT

partition AS `分区`,

sum(rows) AS `总行数`,

formatReadableSize(sum(data_uncompressed_bytes)) AS `原始大小`,

formatReadableSize(sum(data_compressed_bytes)) AS `压缩大小`,

round((sum(data_compressed_bytes) / sum(data_uncompressed_bytes)) * 100, 0) AS `压缩率`

FROM system.parts

WHERE (database IN ('ck_default')) AND (table IN ('point_data_local')) AND (partition LIKE '202111')

GROUP BY partition

ORDER BY partition ASC

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?