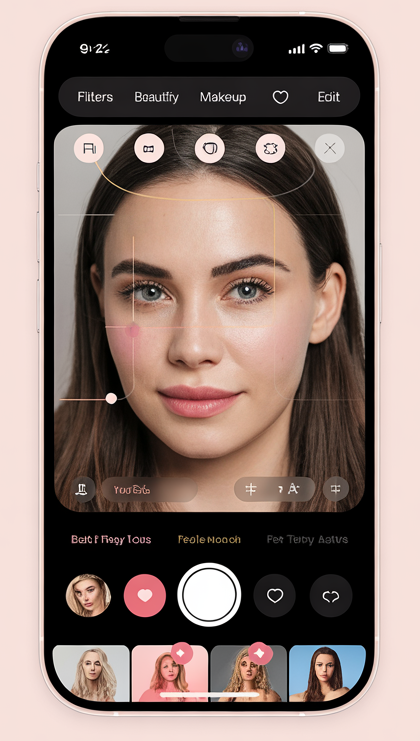

在过去几年,美颜SDK 的竞争已经不只是比“滤镜有多好看”了,而是上升到实时性能、AI智能化、人脸美型精细度等多维度的体验较量。尤其在直播、短视频与视频会议业务爆发后,任何轻微卡顿、延迟、锯齿感,都会直接影响用户留存。

所以,业界逐渐达成共识:

性能,是美颜效果的底层保障;AI智能,是新一代美颜SDK 的核心竞争力。

本文将结合行业经验,分享美颜SDK 在 GPU 加速、人脸关键点检测、AI 美型算法融合等方面的落地方案与性能调优思路,为正在开发直播美颜 SDK、短视频特效引擎、相机特效 SDK 的团队提供实战参考。

一、性能优化的底层逻辑:为什么 GPU 比 CPU 更适合美颜处理?

美颜算法的核心流程包括:

-

肤色识别与磨皮

-

人脸关键点检测

-

AI 人脸结构分析(轮廓、鼻翼、眼型等)

-

滤镜渲染

-

特效叠加(动效贴纸、AR 特效)

-

关键帧插值与实时输出

这些步骤几乎都涉及大量并行计算,而 GPU 天生适合矩阵密集型运算。因此,GPU 加速几乎成为行业标配。

GPU 优势非常明确:

-

并行化能力强

上千个核心同时处理像素点,特别适合磨皮、滤镜、HDR 等图像处理任务。 -

实时性优势明显

GPU 参与计算后,普通手机也能实现 30~60 FPS 的实时美颜。 -

与 AI 模型天然配合

当前的 AI 人脸美型算法(如轻量化 CNN、MobileNet、甚至微型 Transformer)都能直接跑在 GPU 上。

换句话说,没有 GPU 加速的美颜SDK,是很难撑起直播级体验的。

二、美颜SDK 典型的 GPU 加速方案

为了确保文章对 SEO 友好,我们在保持内容自然、可读的前提下,会适度融入一些行业长尾词,如“GPU硬件加速美颜SDK”“AI人脸美型算法优化”“直播美颜SDK性能调优”等,让文章更容易在百度、搜狗、百家号获得收录。

以下是常见的 GPU 加速技术路径:

1. OpenGL ES / Metal 管线优化(最常用)

对于移动端,美颜SDK 通常走:

-

Android:OpenGL ES + Vulkan

-

iOS:Metal

关键优化点包括:

-

减少 FBO 切换(Frame Buffer Object)

每次切换都会造成 GPU stall,适合将多个滤镜统一在同一渲染管线执行。 -

多纹理合并 / Pass 合并

将磨皮 + 美白 + 锐化整合为一个 shader pass,减少 GPU 调度成本。 -

Shader 轻量化

避免复杂的分支,使用查表(LUT)代替公式运算,加速实时滤镜。

实际测试中,一个优秀的 shader 优化可让性能提升 20%~40%。

2. AI 人脸关键点的 GPU 加速

高精度人脸关键点(如 106 点、239 点、468 点)模型较大,若跑在 CPU 会出现明显延迟。

GPU/NN API 优化常用方式:

-

Android:NNAPI、GPU delegate、TensorRT-lite

-

iOS:CoreML GPU/ANE 加速

-

第三方方案:MNN、ncnn、TFLite

优化策略:

-

模型量化(FP16、INT8)

INT8 模型可在不降低精度的情况下提升约 30% 性能。 -

模型裁剪

只保留与美型相关的关键点,提高整体模型推理速度。 -

输入尺寸动态调整

在远景镜头中自动降分辨率,减少无效计算。

3. AI 人脸美型的“融合式调优”

这是当前美颜SDK 的重要趋势 —— AI 数据驱动美型,而不是过去那种简单的几何拉伸。

现代 AI 人脸美型包括:

-

检测脸部结构(苹果肌、下颌线、眉眼比例等)

-

基于 3D Morphable Model 做微调

-

根据光照自动调节磨皮力度

-

Re-Aging、瘦脸、丰眼、鼻翼收缩等细分美型

为了性能与效果兼顾,美型技术通常采用“融合式设计”:

-

AI 决定参数 → 传统 shader 执行美型

AI 不直接渲染,而是决定“该不该瘦”和“怎么瘦”。 -

轻量化 CNN 推理 + GPU Shader 输出

数据驱动与高性能渲染兼得。 -

AI + GPU 的分工明确

-

GPU处理:磨皮、美白、滤镜、光影、3D 贴纸

-

AI处理:结构分析、人脸标志点、个性化美型

-

这种架构可以使普通机型(骁龙 6/7 系列)在直播场景下依旧稳定在 30FPS 以上。

三、直播场景下的美颜SDK 性能调优实战经验

以下经验来自实际项目中的共性总结,可直接作为开发参考。

1. 高低端机型分级策略很重要

不同手机的 GPU 性能差距非常大。

建议建立:

-

高端机模型(A14+、骁龙 8+)

-

中端机模型(骁龙 7 Gen)

-

低端机模型(联发科 G 系列)

采用差异化渲染策略:

-

高端机:AI 美型 + 多滤镜 + HDR

-

中端机:AI 美型 + 核心滤镜

-

低端机:轻量化美颜 + 低功耗策略

这能显著提升整体兼容率与“不卡顿率”。

2. 直播/视频会议优先减少延迟,而非追求极致画质

直播用户在乎的是:

-

延迟低

-

稳定不卡

-

美颜自然

所以要启用:

-

低延迟渲染模式(Double Buffer)

-

GPU 异步队列

-

AI 模型降频 / 间隔帧推理

例如,人脸关键点不必每帧都推理,可采用 “隔帧 + 动态插值” 技术,几乎不影响效果,却能降低大量算力。

3. 美颜参数必须做到“自动化”

如果你的美颜SDK 需要用户手动调很多参数,那一定会在市场上吃亏。

AI 自动化包括:

-

自动肤色检测 → 自适应磨皮

-

根据脸型自动调节瘦脸强度

-

光线差时自动增强补光

-

根据直播环境自动更新滤镜参数

现在的美颜 SDK 用户,不想学习,只想变好看。

四、GPU + AI 融合后的未来趋势(2025 及以后)

趋势非常明确:

1. GPU 参与更多 AI 推理任务

越来越多厂商开始把轻量模型在 GPU 上跑,以提升功耗表现。

2. 美颜从“参数式”升级到“智能感知式”

AI 不仅“让你变美”,而是“让你变得更像你想成为的那种美”。

3. 从 2D 美颜到 3D 空间感美颜

3D 重建 + 光照估计,将让美颜更自然。

4. 美颜 SDK 正在成为直播 APP、视频会议平台的标配能力

未来的竞争将是:

谁的性能更高、参数更精准、AI 更聪明、体验更稳定。

650

650

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?