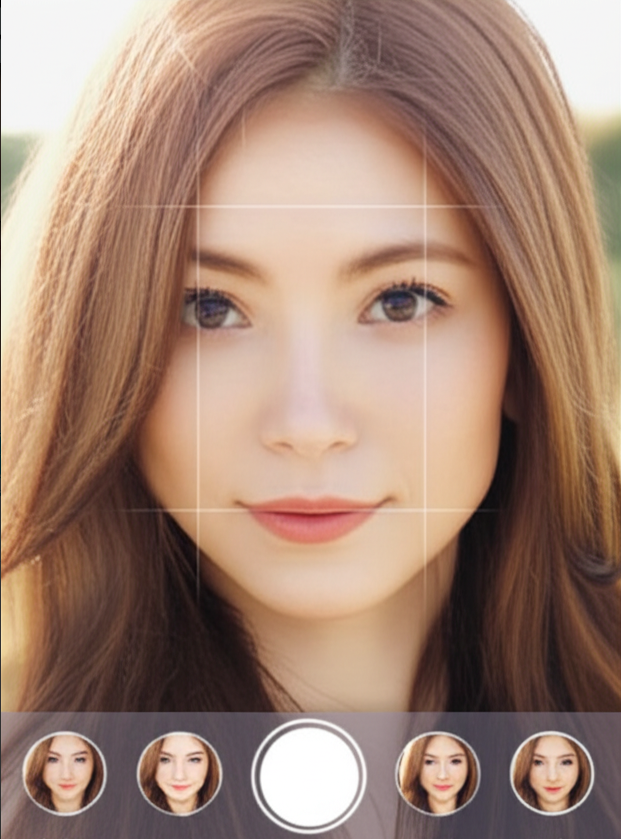

在当下的直播时代,“颜值经济”早已成为推动用户粘性的重要引擎。从秀场直播到短视频,再到电商带货,美颜功能几乎成了每个平台的“标配”。用户打开直播APP时,第一眼看到的画面是否自然、流畅、美观,很大程度上决定了他们是否愿意留下来。而支撑这一切的幕后技术,正是实时美颜sdk。

那么,一个直播平台的实时美颜功能究竟是如何实现的?从技术选型到架构设计,再到性能优化,美颜SDK的开发路径其实是一条融合了AI算法、GPU加速、图像渲染与跨平台适配的完整技术链。

一、从“滤镜”到“智能美颜”:实时美颜技术的演进

早期的直播美颜功能更多依赖固定滤镜,通过简单的磨皮和调色来提升画面质感。这种方式虽然轻量,但存在两个明显问题:

算法粗糙,人脸特征容易被“抹平”,失真感强;

适配性差,不同光线、肤色下的效果不稳定。

随着AI与计算摄影技术的普及,现代美颜SDK逐步引入人脸检测、人脸关键点识别、深度估计等算法,使美颜功能不再是“统一美”,而是更个性化、动态化、智能化。例如,AI可以根据用户脸型自动调整磨皮强度、光影分布,甚至根据表情实时更新美颜参数,实现更自然的实时美颜效果。

二、美颜sdk的核心架构:实时、精准与轻量并存

要让美颜功能在直播场景下实时运行,系统必须具备三大核心能力:

- 高性能图像处理引擎

实时美颜最关键的是低延迟图像处理。这通常通过GPU加速或NNAPI(神经网络接口)实现。

在移动端,开发者可借助OpenGL ES或Metal实现图像滤镜与渲染;

在PC端,DirectX或Vulkan则能进一步提升帧率表现;

对AI美颜模型,则可通过TensorRT、Core ML或ONNX Runtime等框架进行加速推理。

-

AI人脸识别与特征提取

这是美颜SDK的“大脑”。现代SDK往往采用深度卷积神经网络(CNN)来检测人脸特征点(如眉眼鼻唇轮廓、肤色分布等),从而精准控制磨皮、美白、瘦脸等效果。

优质SDK通常支持多脸识别与动态跟踪,即使用户快速移动、转头、眨眼,系统也能稳定识别。 -

模块化架构设计

美狐美颜SDK采用模块化设计,将不同的功能模块(如滤镜管理、人脸识别、特效渲染、性能调度等)进行解耦,方便平台二次开发与灵活配置。例如:

FaceDetectModule:人脸检测与跟踪;

BeautyRenderModule:图像处理与渲染;

EffectModule:动态贴纸、滤镜叠加;

PerformanceMonitor:帧率与内存优化监控。

三、跨平台适配与sdk集成的关键要点

直播平台通常需要兼容iOS、Android、Web、Windows等多端环境,因此SDK的跨平台设计尤为关键。

开发过程中可通过以下技术路径实现兼容性与可维护性:

统一渲染层设计:基于OpenGL ES或Vulkan构建统一渲染管线;

JNI与FFI桥接层:在Android与iOS间打通底层接口;

可配置参数接口(API):支持开发者灵活设置美颜等级、滤镜样式;

轻量化模型部署:使用模型剪枝与量化技术,将AI模型体积控制在10MB以内,确保加载速度与流畅度。

此外,美颜SDK往往与直播推流引擎进行融合开发,实现视频帧在推流前的预处理,从而保持画质与实时性的平衡。

四、性能优化与体验提升:让“美”更自然

真正好的美颜体验,不是把用户“P成模板”,而是做到自然、真实、有个性。

为此,开发者在性能与算法层面通常会采用以下优化策略:

GPU多线程渲染:分离主线程与渲染线程,降低卡顿;

区域化处理:仅对人脸区域进行高精度美颜,节省算力;

AI光影优化:根据光线变化自动调整肤色与亮度;

自适应参数曲线:根据用户肤质与环境光自动调整磨皮强度。

这些细节虽小,却决定了用户体验的“丝滑度”。当直播画面在不同光线、网络条件下都能保持自然感时,平台的留存率和主播满意度都会显著提升。

五、从技术到体验,打造“会思考的美颜系统”

实时美颜SDK不再是简单的滤镜叠加,而是AI智能与实时渲染技术的深度结合。

对于直播平台而言,一个优秀的美颜SDK意味着:

更高的用户留存(画面更自然、主播更自信);

更强的差异化竞争力(支持个性滤镜、动态特效);

更稳定的系统表现(低延迟、低功耗、高兼容性)。

未来,美颜技术将进一步融入AI视觉增强、AR特效、虚拟主播等领域,成为直播生态中不可或缺的“底层能力”。

662

662

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?