原文链接:https://openaccess.thecvf.com/content_cvpr_2016/papers/He_Deep_Residual_Learning_CVPR_2016_paper.pdf

文章概述

本文为了解决较深网络难以训练的问题,提出了残差学习框架(residual learning framework),在该框架中每一层不直接学习上一层的输出,而是学习上一层已经学到的部分与label之间的残差。该框架在ImageNet数据集上使用了152层的残差网络,比VGG深8倍,但其具有较低的复杂度和更高的准确性。该模型在ILSVRC 2015分类任务中获得了第一名,在其他数据集上的表现也很好。

介绍

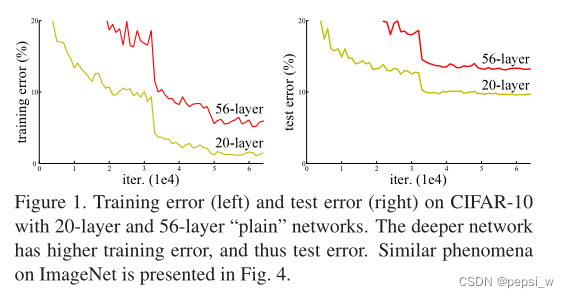

如下图所示,在没有使用残差函数的普通网络中,可以看出随着层数的增加,无论是测试精度还是训练精度都不如浅一点的网络表现好。

假设在一个浅的网络中叠加层数得到一个深的网络,按道理这个深的网络前面层数可以跟浅网络学到一样的东西,多叠加的层数只是做一个identity ma

本文介绍了残差学习框架,为解决深度神经网络训练中的梯度消失问题,提出每一层学习残差而非直接学习上一层输出。通过快捷连接实现恒等映射,确保网络优化更容易,提高深层网络性能。实验结果显示,残差网络在ImageNet、CIFAR-10等数据集上表现出色,证明了该方法的有效性。

本文介绍了残差学习框架,为解决深度神经网络训练中的梯度消失问题,提出每一层学习残差而非直接学习上一层输出。通过快捷连接实现恒等映射,确保网络优化更容易,提高深层网络性能。实验结果显示,残差网络在ImageNet、CIFAR-10等数据集上表现出色,证明了该方法的有效性。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

676

676

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?