交替最小二乘法(ALS)介绍

交替最小二乘法(Alternating Least Squares, ALS)是一种用于矩阵分解的优化算法,广泛应用于推荐系统。ALS通过交替优化用户特征和物品特征,旨在最小化用户-物品评分矩阵的重构误差。该方法特别适用于大规模稀疏数据的推荐任务。

基本原理

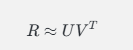

ALS的基本思想是将评分矩阵 RR 分解为用户特征矩阵 UU 和物品特征矩阵 VV,即:

在每次迭代中,ALS交替固定一个矩阵,优化另一个矩阵。具体步骤如下:

-

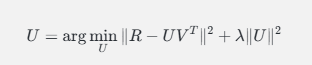

固定物品特征矩阵 VV,优化用户特征矩阵 UU:

-

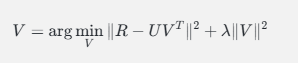

固定用户特征矩阵 UU,优化物品特征矩阵 VV:

其中,λλ 是正则化参数,用于防止过拟合。

Python 代码示例

以下是一个使用 numpy 实现简单的 ALS 的示例。

安装依赖

确保安装了 numpy:

pip install numpy

示例代码

import numpy as np

# 示例评分矩阵(用户 x 物品)

R = np.array([[5, 3, 0, 1],

[4, 0, 0, 1],

[1, 1, 0, 5],

[1, 0, 0, 4],

[0, 1, 5, 4]])

# 参数设置

num_users, num_items = R.shape

num_features = 2 # 特征数

lambda_reg = 0.1 # 正则化参数

num_iterations = 100 # 迭代次数

# 随机初始化用户和物品特征矩阵

U = np.random.rand(num_users, num_features)

V = np.random.rand(num_items, num_features)

# ALS算法

for _ in range(num_iterations):

# 固定 V,更新 U

for i in range(num_users):

V_i = V[R[i, :] > 0] # 仅选择用户 i 评分的物品

R_i = R[i, R[i, :] > 0] # 仅选择用户 i 的评分

if len(R_i) > 0:

U[i, :] = np.linalg.solve(np.dot(V_i.T, V_i) + lambda_reg * np.eye(num_features),

np.dot(V_i.T, R_i))

# 固定 U,更新 V

for j in range(num_items):

U_j = U[R[:, j] > 0] # 仅选择评分该物品的用户

R_j = R[R[:, j] > 0, j] # 仅选择该物品的评分

if len(R_j) > 0:

V[j, :] = np.linalg.solve(np.dot(U_j.T, U_j) + lambda_reg * np.eye(num_features),

np.dot(U_j.T, R_j))

# 预测评分矩阵

predicted_R = np.dot(U, V.T)

print("预测评分矩阵:\n", predicted_R)

# 为用户 0 推荐物品

user_id = 0

recommended_items = np.argsort(predicted_R[user_id])[::-1] # 按照预测评分降序排列

print("\n为用户 0 推荐的物品:\n", recommended_items)

Find More

代码解释

-

数据准备:创建一个用户-物品评分矩阵 RR。

-

参数设置:

num_features:特征数。lambda_reg:正则化参数。num_iterations:迭代次数。

-

初始化:随机初始化用户特征矩阵 UU 和物品特征矩阵 VV。

-

ALS算法:

- 在每次迭代中,首先固定物品特征矩阵 VV,更新用户特征矩阵 UU。

- 然后固定用户特征矩阵 UU,更新物品特征矩阵 VV。

- 使用最小二乘法来求解更新后的特征矩阵。

-

预测评分:计算预测评分矩阵,并打印结果。

-

推荐物品:为指定用户(例如用户 0)推荐物品,根据预测评分降序排列,输出推荐物品的索引。

总结

交替最小二乘法(ALS)是一种有效的矩阵分解技术,能够处理大规模稀疏数据,广泛应用于推荐系统。以上示例展示了如何使用 ALS 实现推荐功能,实际应用中可以根据需求进行扩展和优化。

604

604

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?