12-1 Motivation

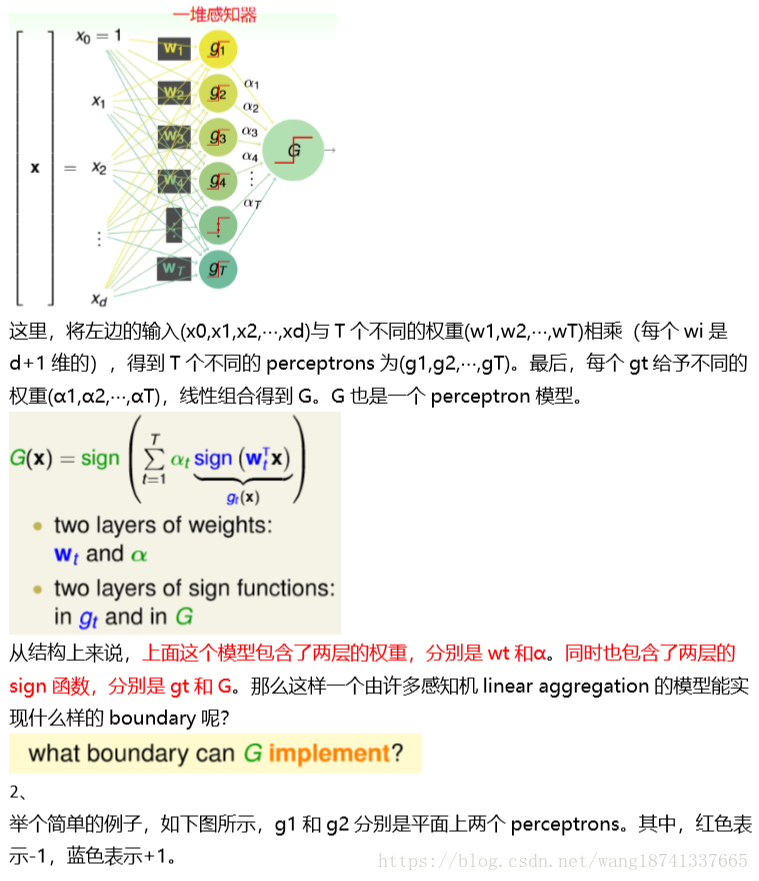

上节课我们主要介绍了Gradient Boosted Decision Tree。GBDT通过使用functional gradient的方法得到一棵一棵不同的树,然后再使用steepest descent的方式给予每棵 树不同的权重,最后可以用来处理任何而定error measure。上节课介绍的GBDT是以 regression为例进行介绍的,使用的是squared error measure。本节课讲介绍一种出现 时间较早,但当下又非常火的一种机器算法模型,就是神经网络(Neural Network)。 1、 在之前的机器学习基石课程中,我们就接触过Perceptron模型了,例如PLA算法。 Perceptron就是在gt(x外面加上一个sign函数,取值为{-1,+1}。现在,如果把许多 perceptrons线性组合起来,得到的模型G就如下图所示

总结

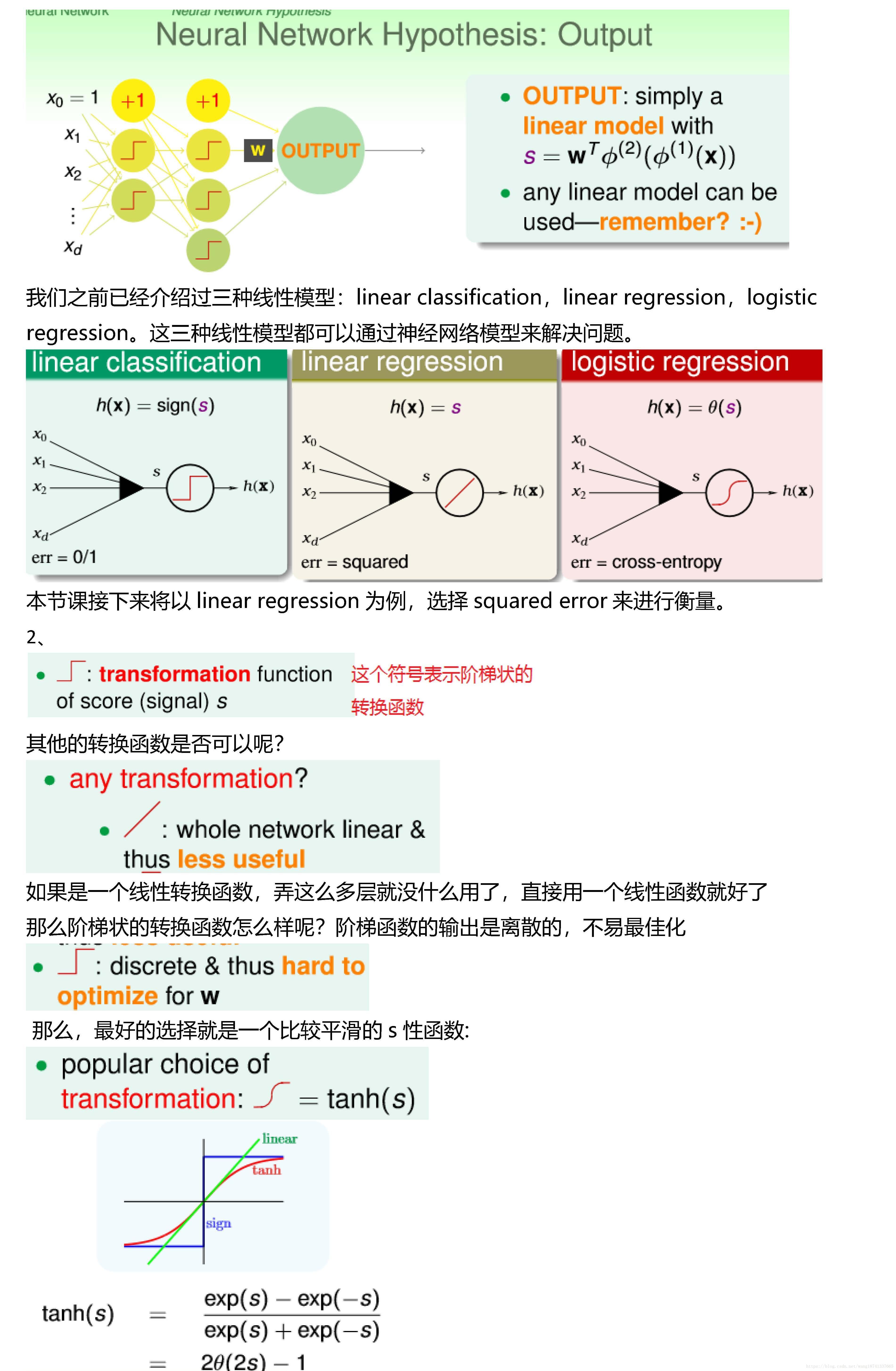

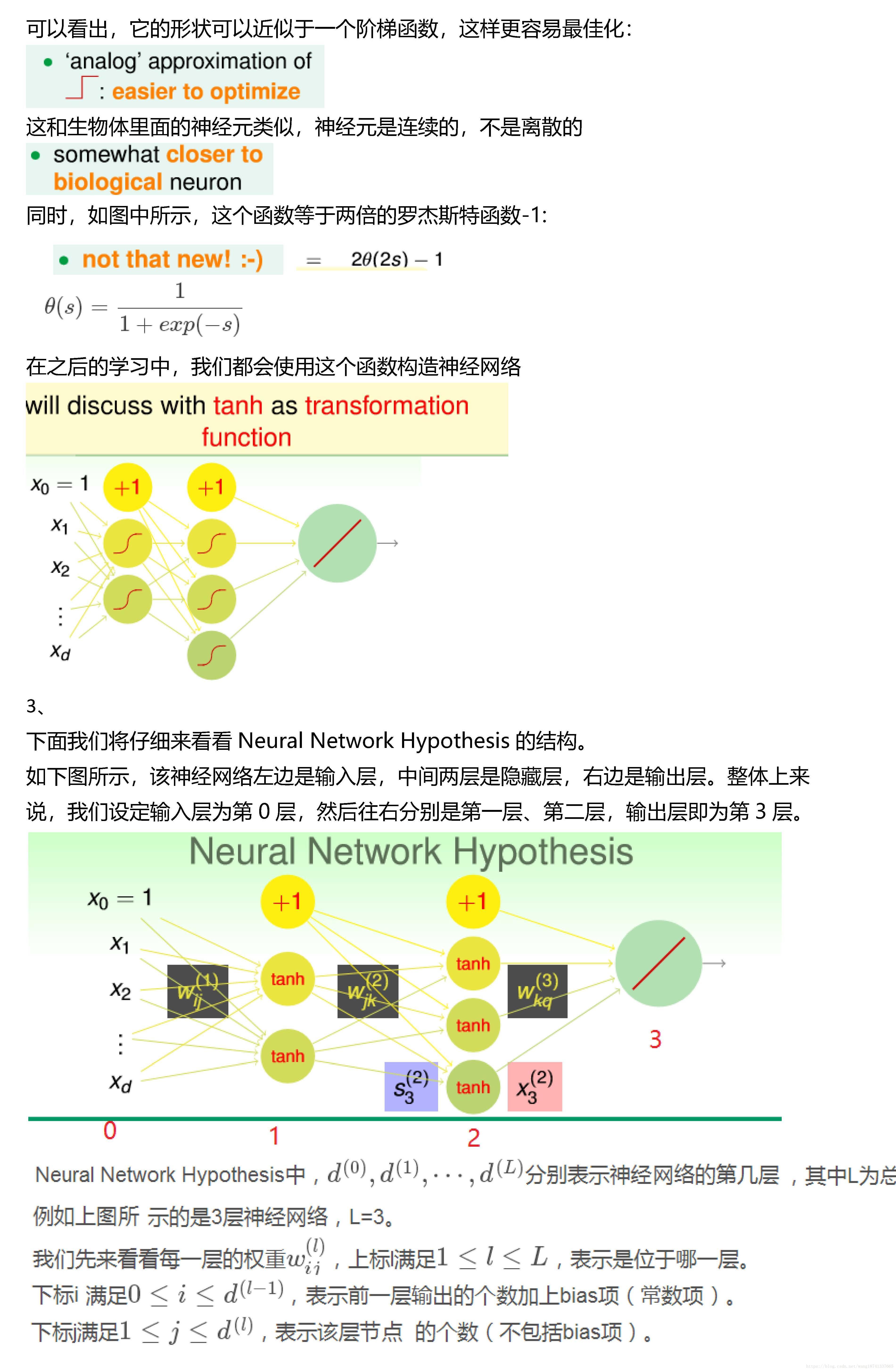

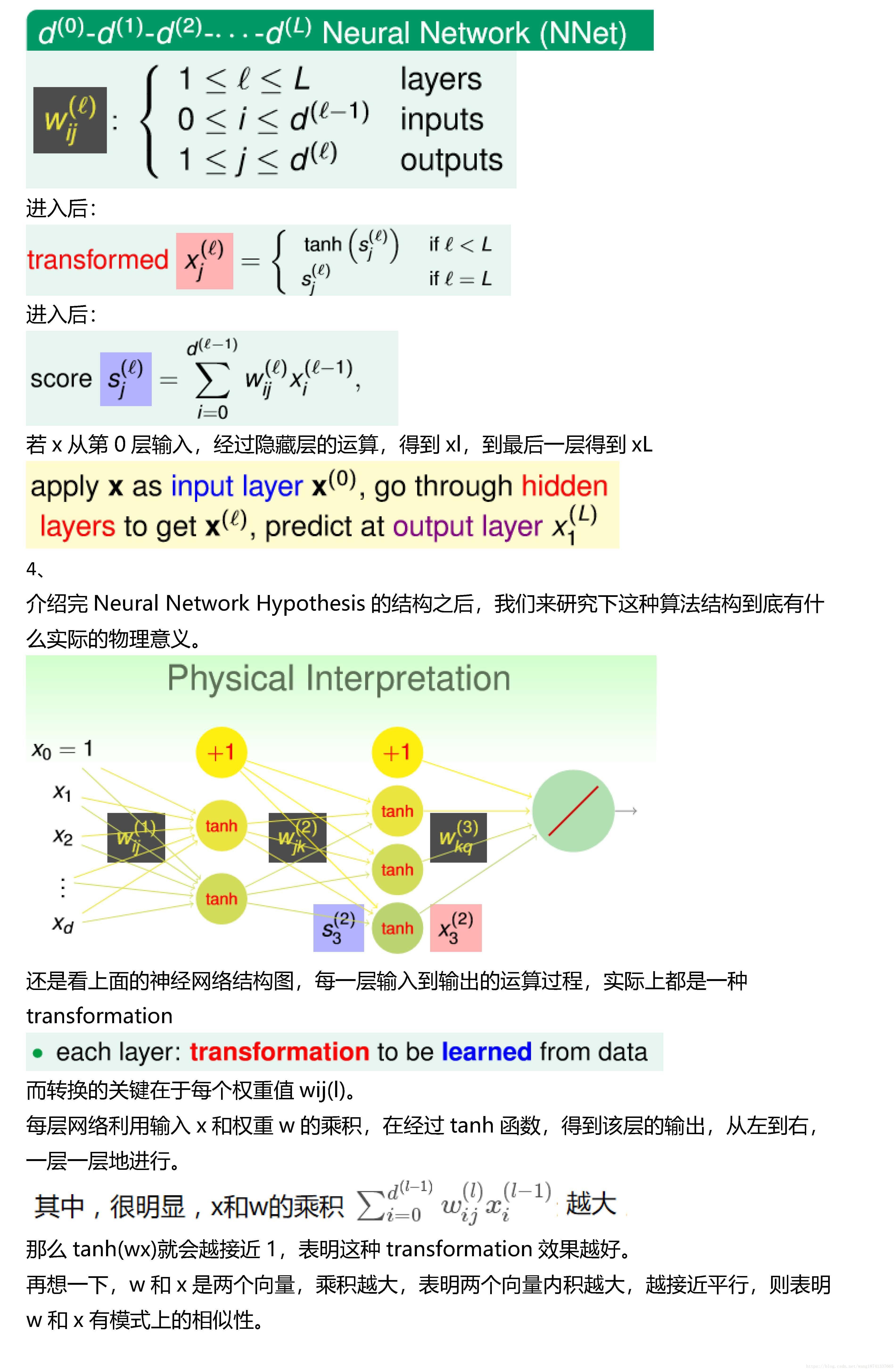

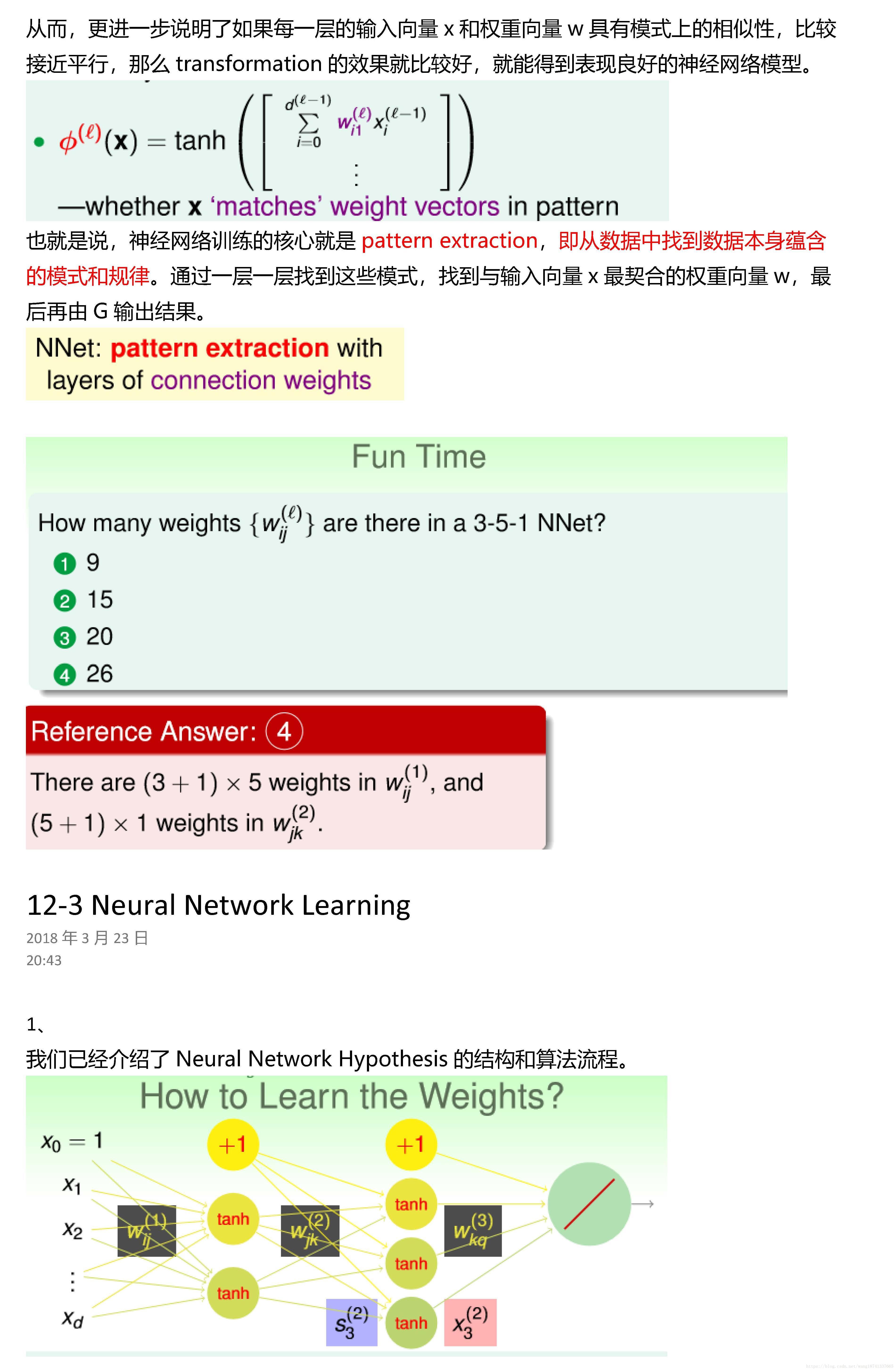

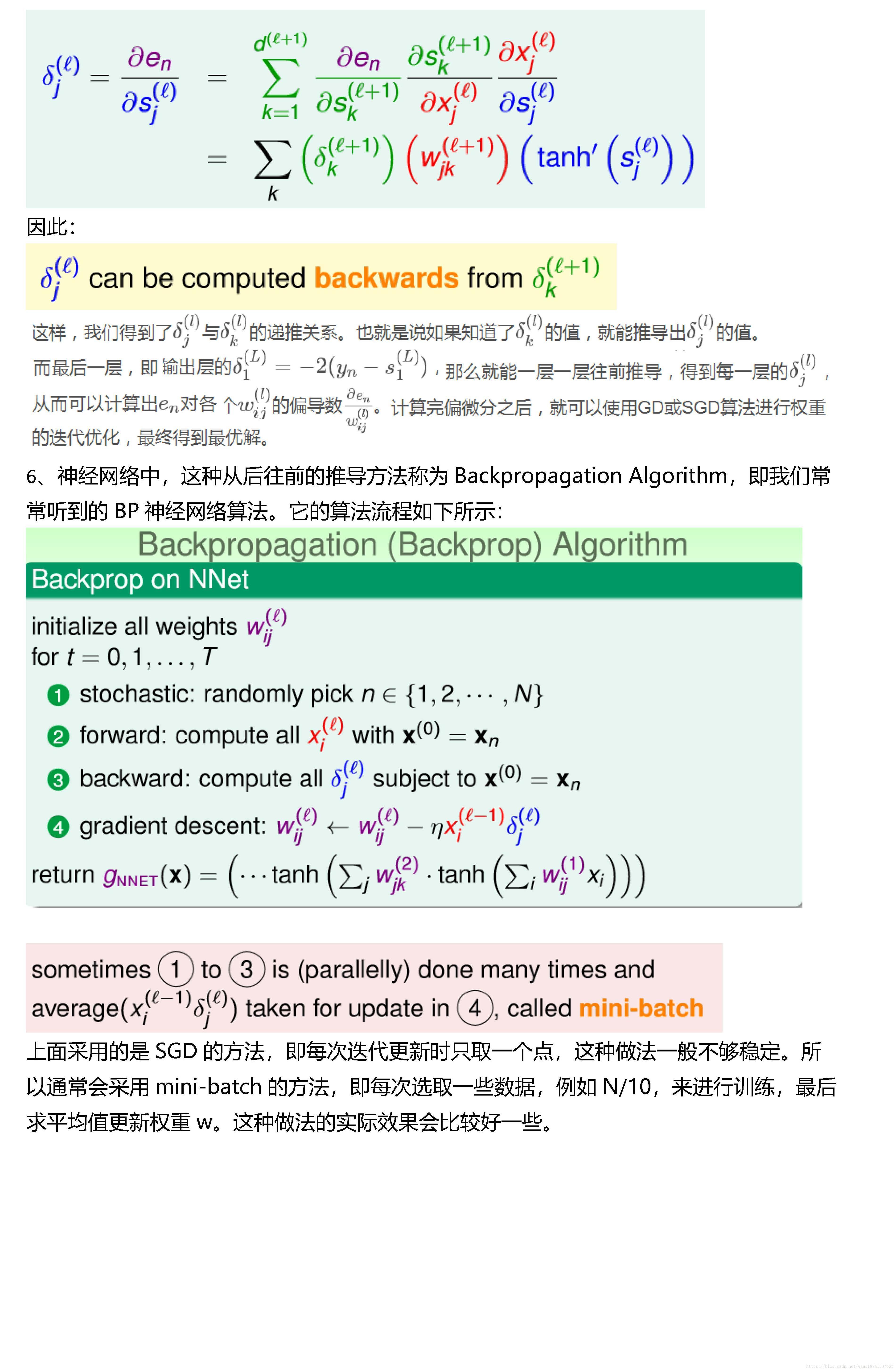

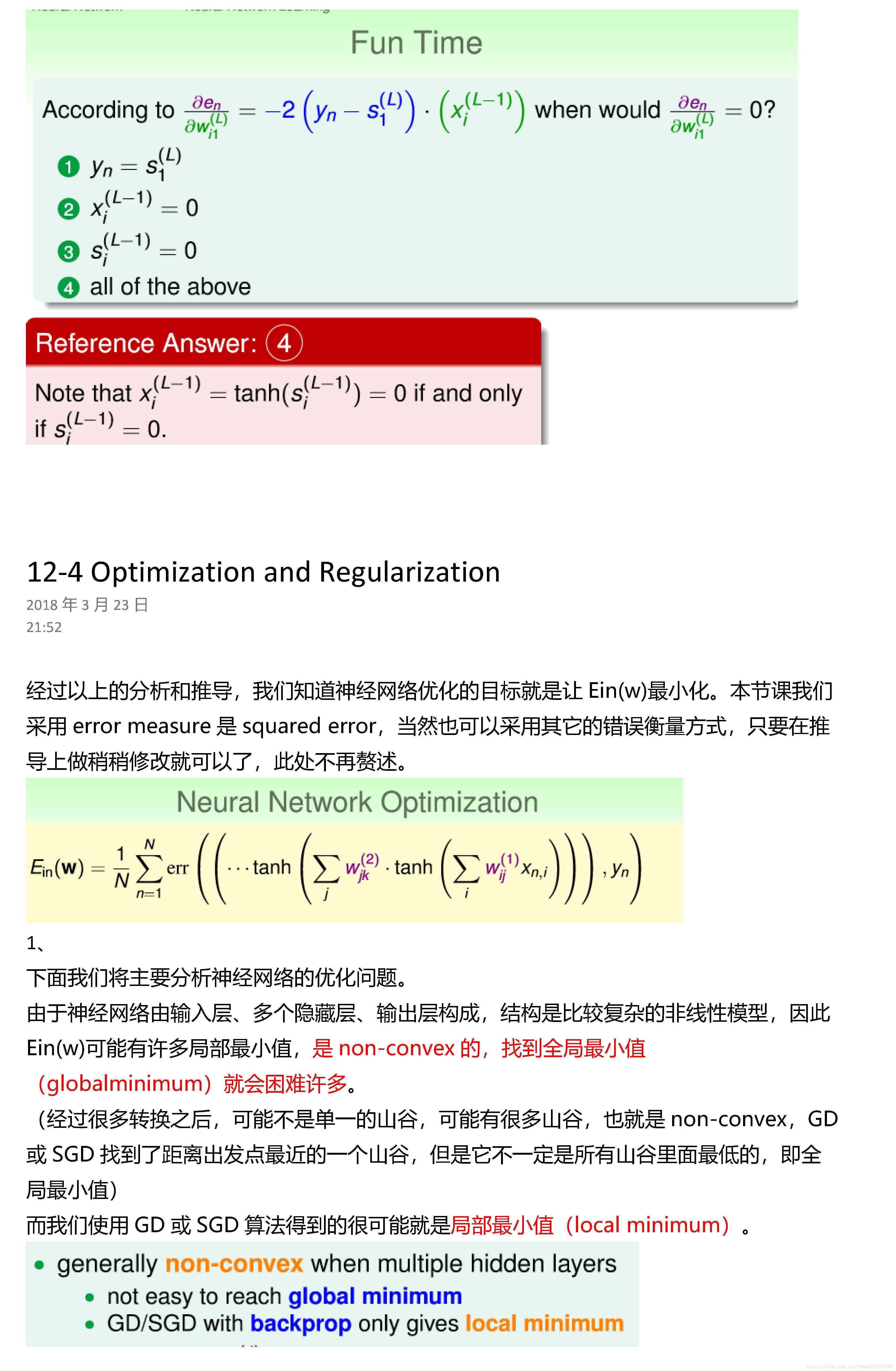

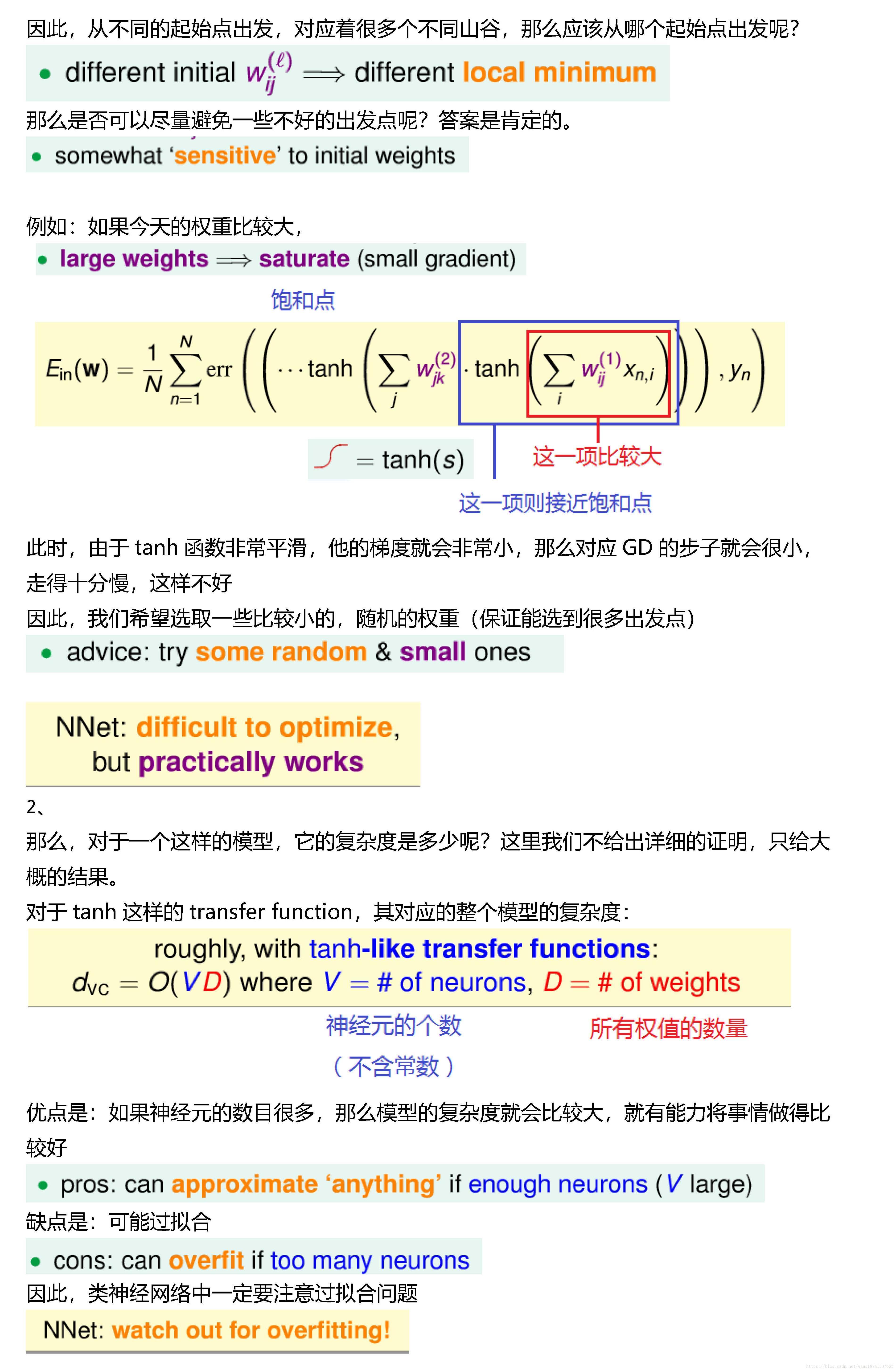

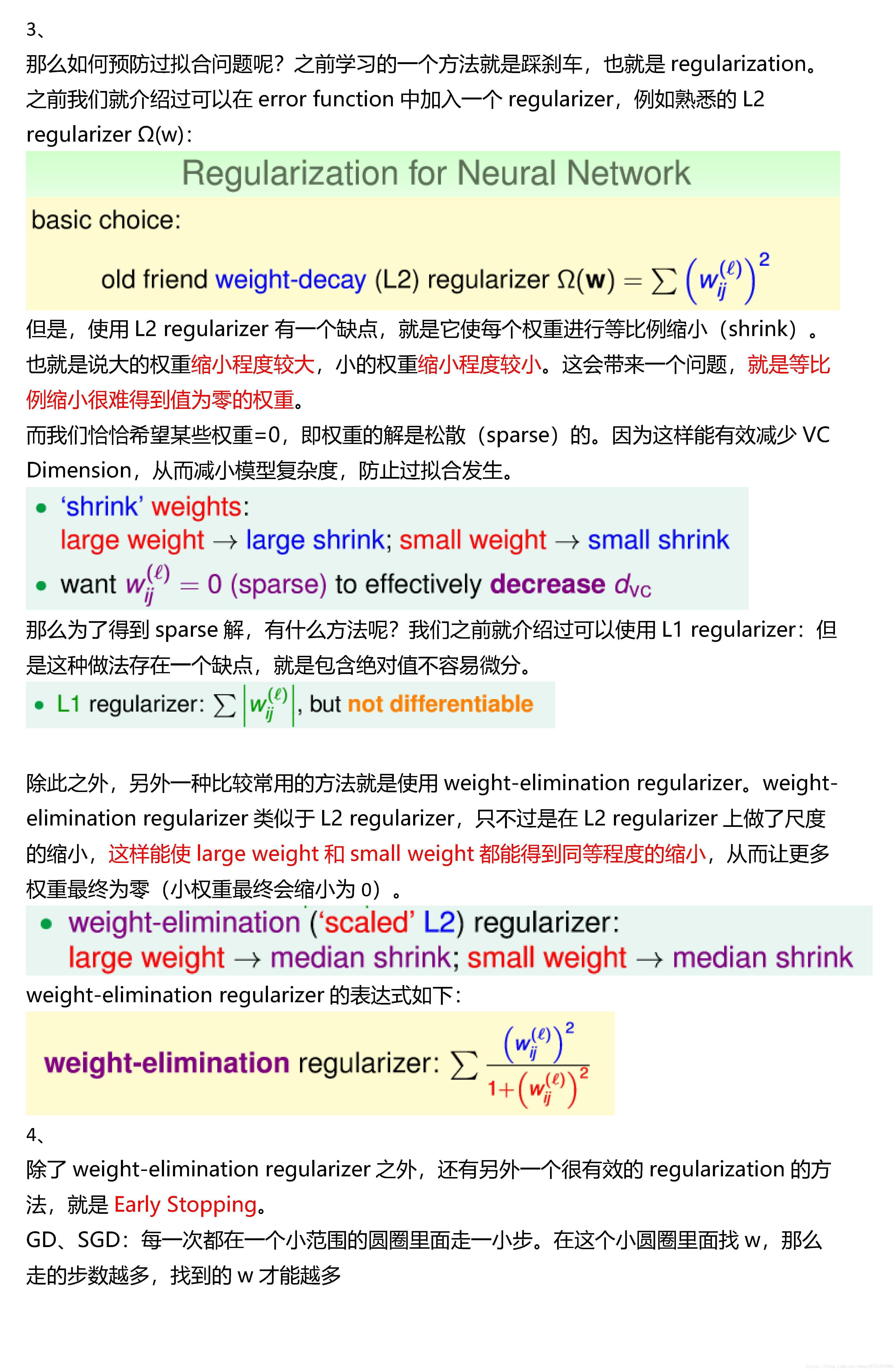

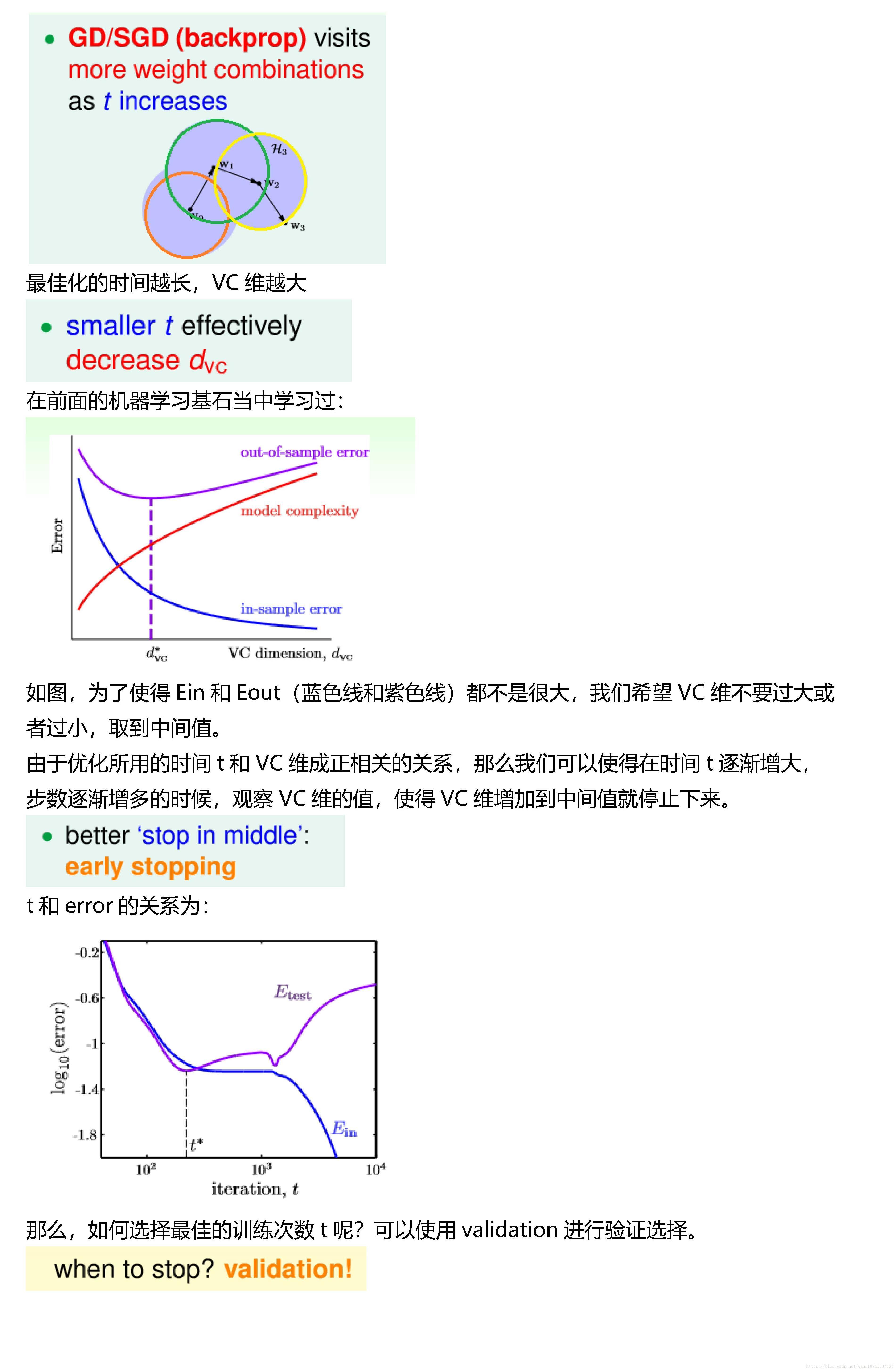

本节课主要介绍了Neural Network模型。 首先,我们通过使用一层甚至多层的perceptrons来获得更复杂的非线性模型。 神经网络的每个神经元都相当于一个Neural Network Hypothesis,训练的本质就是在每 一层网络上进行pattern extraction,找到最合适的权重wij(l),最终得到最佳的G。 本课程以regression模型为例,最终的G是线性模型,而中间各层均采用tanh函数作为 transform function。计算权重wij(l)的方法就是采用GD或者SGD,通过 Backpropagation算法,不断更新优化权重值,最终使得Ein(w)最小化,即完成了整个神 经网络的训练过程。最后,我们提到了神经网络的可以使用一些regularization来防止模 型过拟合。这些方法包括随机选择较小的权重初始值,使用weight-elimination regularizer或者early stopping等。

6348

6348

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?