本人项目地址大全:Victor94-king/NLP__ManVictor: 优快云 of ManVictor

git地址:https://github.com/opendatalab/MinerU

写在前面: 笔者更新不易,希望走过路过点个关注和赞,笔芯!!!

写在前面: 笔者更新不易,希望走过路过点个关注和赞,笔芯!!!

写在前面: 笔者更新不易,希望走过路过点个关注和赞,笔芯!!!

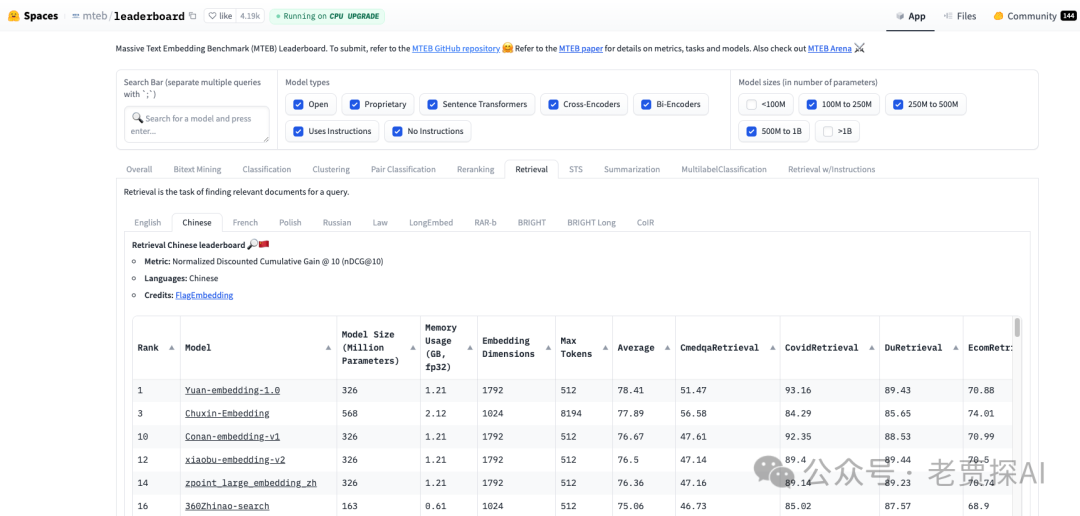

近期RAG 应用不断涌现,它们的性能表现各具特色。尽管我们可以通过多个方面(例如查询改写、图像数据处理、分块策略、元数据管理、密集检索、稀疏检索、结果重排、排序融合、提示词优化以及上下文压缩等)逐步优化这些应用,但在选择 SOTA(State-of-the-Art)模型时,参考开源排行榜依然是必不可少的步骤。mteb/leaderboard 是一个极为有用的资源,它能帮助您了解并选择符合您需求的多语言文本生成模型。例如,在RAG系统中,无论是中文还是英文的向量化模型、重排模型或摘要模型的选择,都可以通过该榜单获得直观且量化的参考依据。

MTEB Leaderboard

MTEB(Multilingual Text-to-Text Evaluation Benchmark)是一个多语言文本嵌入的评估基准,旨在评估和比较不同多语言文本生成模型的性能。排行榜页面展示了各种模型在多个任务上的表现,这些任务可能包括但不限于翻译、摘要、问答等。

-

https://huggingface.co/spaces/mteb/leaderboard

-

C-MTEB(Chinese Massive Text Embedding Benchmark)中文语义向量评测基准

-

评测任务:包括涵盖112种语言的58个数据集

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

440

440

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?