“在AI的世界里,数据不再只是结构化的表格,而是流动的向量海洋。”

当大模型遇见海量数据,我们面临一个关键问题:如何让AI快速找到最相关的知识? 向量数据库正是解决这个难题的智能钥匙。它通过将非结构化数据转化为高维向量,并构建高效的相似性搜索体系,成为现代AI系统的核心组件。

一、向量数据库的核心价值:解决 RAG 的 “最后一公里” 难题

在 RAG 系统中,嵌入模型将文本、图像等非结构化数据转换为高维向量,但当向量规模达到百万级时,如何快速找到最相关的向量成为瓶颈。向量数据库正是为此而生:

- 毫秒级相似性搜索:通过 HNSW、IVF 等索引技术,在十亿级向量中实现毫秒级查询。

- 多模态数据融合:支持文本、图像、音频等多类型向量存储,满足 ChatGPT-4o 等跨模态模型的需求。

- 弹性扩展能力:分布式架构支持线性扩展,轻松应对数据量的指数级增长。

1.1 与传统数据库的本质区别

| 维度 | 向量数据库 | 传统数据库 (RDBMS) |

|---|---|---|

| 核心能力 | 语义相似性搜索(ANN) | 结构化数据精确匹配 |

| 数据类型 | 高维向量(如 768 维文本嵌入) | 结构化表格数据 |

| 索引机制 | HNSW、LSH、IVF 等 | B-Tree、Hash 索引 |

| 典型场景 | 推荐系统、图像识别、RAG 问答 | 金融交易、ERP 系统 |

向量数据库与传统数据库并非替代关系,而是互补。例如在电商场景中,MySQL 存储商品基本信息,向量数据库存储商品图片和描述的嵌入向量,共同支撑 “拍照搜商品” 功能。

1.2 核心技术指标对比

| 指标 | FAISS | Milvus | Pinecone | Weaviate |

|---|---|---|---|---|

| 最大数据量 | 百亿级 | 千亿级 | 无限制 | 十亿级 |

| 查询延迟 | <1ms | <10ms | <100ms | <50ms |

| 索引类型 | Flat/HNSW | IVF-PQ/HNSW | HNSW | HNSW |

| 分布式支持 | ❌ | ✅ | ✅ | ✅ |

| GPU加速 | ✅ | ✅ | ✅ | ❌ |

二、技术原理:四层架构如何实现高效检索

向量数据库通常采用分层架构设计,核心包含四大模块:

- 存储层:优化高维向量存储格式,支持冷热数据分离。例如 Milvus 的混合存储方案,将热数据驻留在内存,冷数据存于云端对象存储,在查询时自动加载。

- 索引层:核心算法的竞技场:

- HNSW(分层可导航小世界图):通过多层图结构实现高效搜索,类似城市道路网的层级规划。

- IVF(倒排索引):将向量聚类后建立索引,检索时只需在最近邻聚类中搜索,显著减少计算量。

- 查询层:支持混合查询(向量搜索 + SQL 过滤),例如 “查找 2023 年后发布的、与‘人工智能’相关的论文”。

- 服务层:提供 RESTful API、事务管理、监控报警等企业级功能,保障生产环境稳定运行。

索引算法深度对比

| 算法 | 优势 | 局限 | 典型应用场景 |

|---|---|---|---|

| HNSW | 高召回率 | 内存消耗大 | 科研/金融领域 |

| IVF-PQ | 高压缩比 | 精度损失 | 推荐系统 |

| LSH | 高效哈希 | 敏感度低 | 实时搜索 |

| Annoy | 简单易用 | 不支持更新 | 快速原型 |

选型建议:小规模数据选HNSW,超大规模数据组合使用IVF+PQ,实时场景推荐LSH。

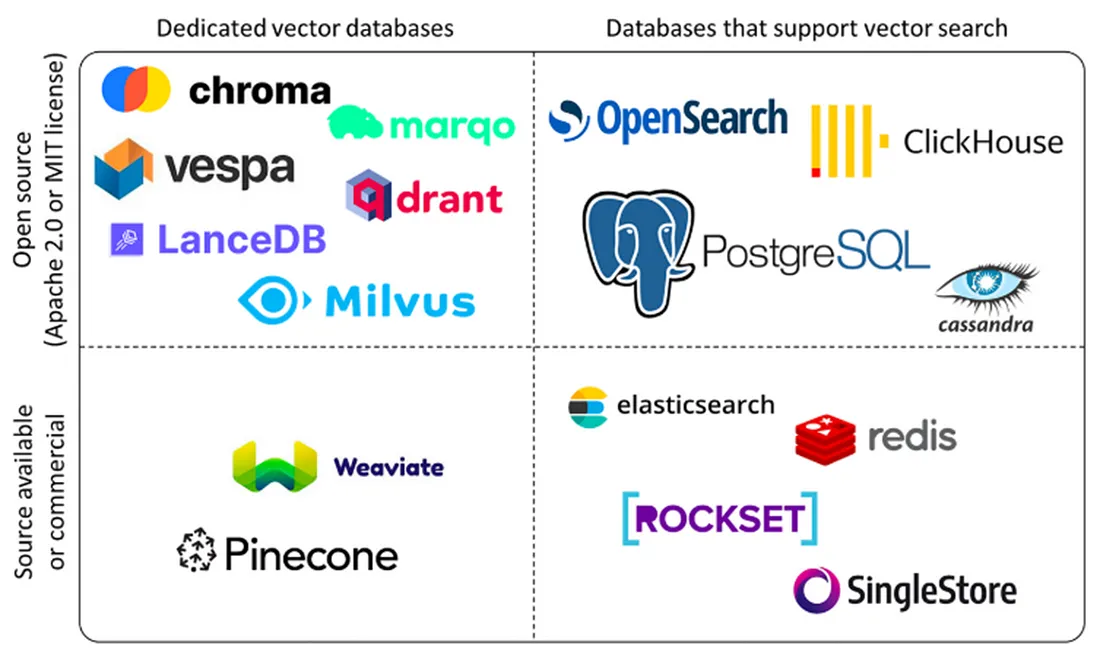

三、主流工具选型指南:从开源到云服务

面对市场上数十种向量数据库,如何选择最适合的工具?以下是主流工具的对比与适用场景:

3.1 新手入门首选

- ChromaDB

轻量级本地数据库,零配置启动,支持与 LangChain/LlamaIndex 无缝集成。适合原型开发和教育场景。 - FAISS

Facebook 开源的算法库,以 Python 接口为主,适合需要自定义索引策略的研究场景。例如,通过量化技术(PQ)将向量存储成本降低 90%。

3.2 生产环境主力

- Milvus

开源分布式向量数据库,支持 GPU 加速和 PB 级数据。在金融风控场景中,可实现每秒处理万级向量查询。 - Pinecone

完全托管的云服务,提供 99.95% 的 SLA 保障。适合对稳定性要求极高的企业级应用,如智能客服系统。 - Qdrant

Rust 开发的高性能数据库,支持二进制量化和混合搜索。在推荐系统中,可通过稀疏向量(Sparse)捕捉用户行为的长尾特征。

3.3 多模态与 AI 原生

- Weaviate

支持 GraphQL 和多模态数据,内置 20+AI 模块(如情感分析、OCR)。适合快速搭建 AI 应用原型,如法律文书智能分析系统。

四、实战案例:用 FAISS 构建本地知识库

以下是一个基于 LangChain 和 FAISS 的 RAG 系统实现示例,代码量不足 50 行:

索引类型选择:

IndexFlatL2:精确搜索(适合小数据集)IndexIVFFlat:分簇搜索(平衡精度与速度)IndexIVFPQ:量化压缩(适合大数据集)

4.1 环境准备

# 创建虚拟环境

conda create -n rag-env python=3.12

conda activate rag-env

# 安装依赖

pip install langchain faiss-cpu sentence-transformers

4.2 核心代码实现

from langchain_community.vectorstores import FAISS

from langchain_community.embeddings import HuggingFaceEmbeddings

from langchain_core.documents import Document

# 1. 示例文本和嵌入模型

texts = [

"张三是法外狂徒",

"FAISS是一个用于高效相似性搜索和密集向量聚类的库。",

"LangChain是一个用于开发由语言模型驱动的应用程序的框架。"

]

docs = [Document(page_content=t) for t in texts]

embeddings = HuggingFaceEmbeddings(model_name="BAAI/bge-small-zh-v1.5")

# 2. 创建向量存储并保存到本地, 默认使用IndexFlatL2

vectorstore = FAISS.from_documents(docs, embeddings)

local_faiss_path = "./faiss_index_store"

vectorstore.save_local(local_faiss_path)

print(f"FAISS index has been saved to {local_faiss_path}")

# 3. 加载索引并执行查询

# 加载时需指定相同的嵌入模型,并允许反序列化

loaded_vectorstore = FAISS.load_local(

local_faiss_path,

embeddings,

allow_dangerous_deserialization=True

)

# 相似性搜索

query = "FAISS是做什么的?"

results = loaded_vectorstore.similarity_search(query, k=1)

print(f"\n查询: '{query}'")

print("相似度最高的文档:")

for doc in results:

print(f"- {doc.page_content}")

FAISS index has been saved to ./faiss_index_store

查询: ‘FAISS是做什么的?’

相似度最高的文档:

- FAISS是一个用于高效相似性搜索和密集向量聚类的库。

五、行业前沿:成本优化与混合搜索技术

5.1 冷热数据分层存储

Milvus 的 Zilliz Cloud 通过冷热分离技术,将 90% 的冷数据存储在云端对象存储(如 S3),仅在查询时加载到内存,使存储成本降低 70% 以上。

5.2 混合搜索(Hybrid Search)

结合稀疏向量(Sparse)和密集向量(Dense)的优势:

- 稀疏向量:捕捉显式关键词(如 “Python”“机器学习”)。

- 密集向量:理解语义相似性(如 “深度学习” 与 “神经网络”)。

例如,Weaviate 的混合搜索功能可同时处理两种向量,在搜索学术论文时,既保证关键词匹配,又能发现领域相关的边缘研究。

六、总结与展望

向量数据库已从 AI 研究的 “小众工具” 发展为 RAG 系统的 “刚需组件”。随着硬件技术的进步(如 ARM 架构 CPU 的普及)和算法优化(如量化技术),其性能和成本将持续改善。未来,向量数据库将在以下方向深化发展:

- 多模态融合:支持视频、3D 模型等复杂数据类型。

- 联邦学习:在隐私计算框架下实现跨组织数据共享。

- 自治数据库:自动优化索引、自动扩展资源,降低运维门槛。

334

334

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?