Llama-1|Alpaca-LoRA 微调模型下载以及安装推理教程

经常玩AI的人应该对LoRA这一词并不陌生,尤其是在SD绘画领域,各种角色的LoRA模型层出不穷。那么语言领域是否存在LoRA呢?存在,且繁荣!

LoRA你可以理解为语言模型的一个角色,同绘画领域是一致的,是一个基于大模型所单独调教好的指定角色。比如Llama-1在泄漏之初的对话能力是极差的,仅能够通过排比式语句或其它方式引导其回复指定内容。这个时候LoRA技术的好处就体现了出来,我们如果直接对LLaMA大模型进行训练调整,这将是地狱级别的硬件消耗,然后我们可以冻结基础模型,通过嵌入式LoRA来对LLaMA进行微调,让其拥有指定的特殊功能强化。有点类似于你在SD中加载了刘亦菲,那么生成后的角色样貌总是和刘亦菲相似;又比如你基于官方模型SD-1.5大模型训练了一个李白,那么后生成的角色也都是围绕着李白的样貌。

项目描述

Alpaca模型是由坦福大学研发的LLM(Large Language Model大语言)开源模型,是一个在52K指令上从LLaMA 7B(Meta公司开源的7B)模型微调而来,具有70亿的模型参数(模型参数越大,模型的推理能力越强,当然随之训练模型的成本也就越高),而Alpaca-LoRA正是依托于此。

该代码库包含用于复现Stanford Alpaca使用低秩适应(LoRA)的结果的代码。我们提供了一个类似质量的Instruct模型,可以在树莓派上运行(用于研究),代码可以轻松扩展到 [其他模型] [此处可能缺少部分文本] text-davinci-003 13b 30b 65b。

除了训练代码,在单个RTX 4090上运行数小时之外,我们还发布了一个用于下载基础模型和LoRA上进行推理的脚本,以及得到的LoRA权重本身。为了进行便宜高效的微调,我们使用了Hugging Face的PEFT以及Tim Dettmers的bitsandbytes。

在没有超参数调整的情况下,LoRA模型产生的输出与Stanford Alpaca模型相当,进一步的调整可能能够获得更好的性能。

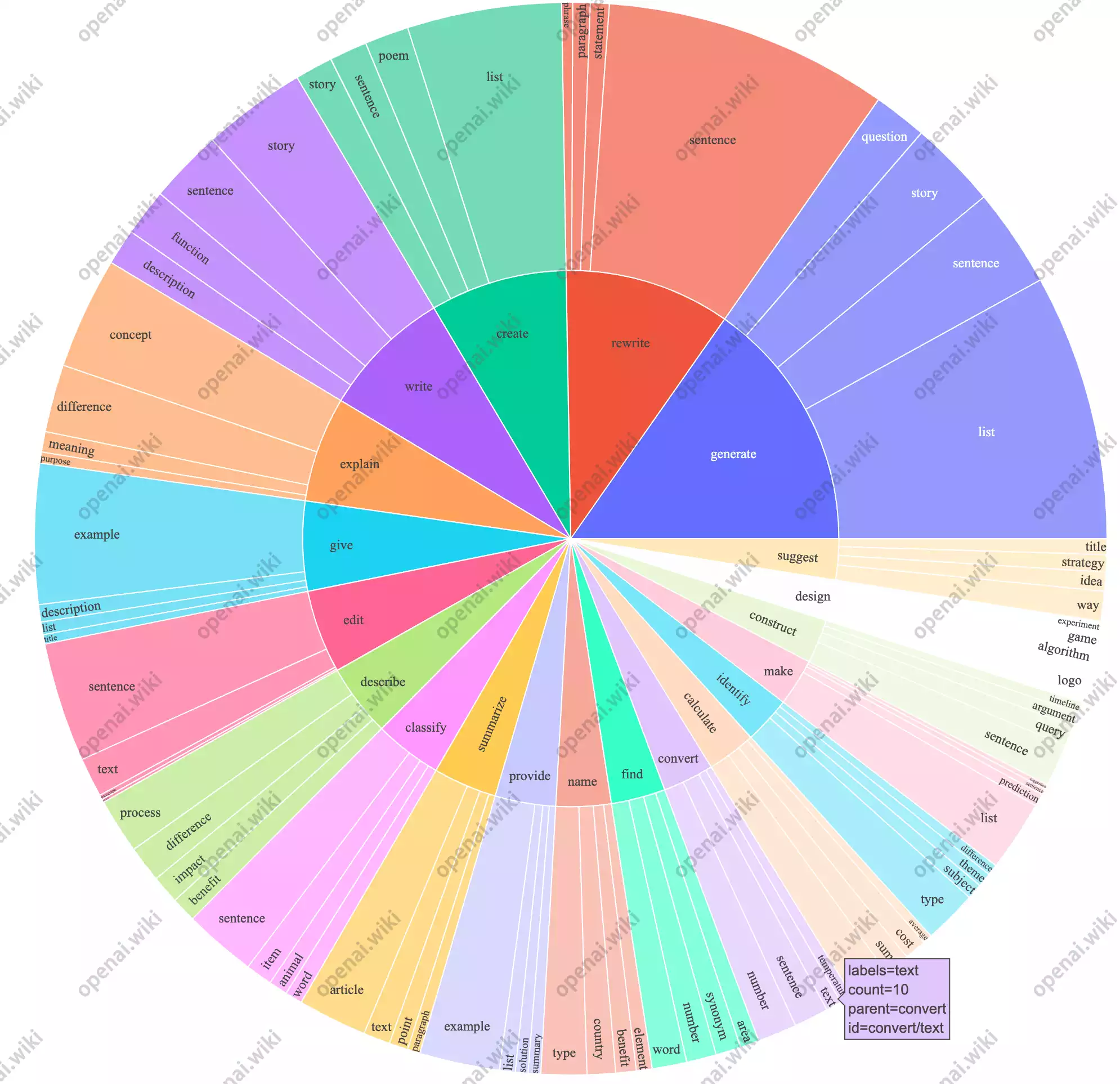

#image_title

项目声明

该项目的所有模型都是基于LLaMA-1泄漏版本,现Meta官方已开源发布LLaMA-2版本,版本2拥有更好的推理与性能,为大家讲解LLaMA-1仅为给特殊需要的人使用。

关于LLaMA-2版本的教程,可以查阅以下教程,官方模型支持Chat聊天对话形式。

项目相关

斯坦福Alpaca:tatsu-lab/stanford_alpaca

Alpaca-LoRA:tloen/alpaca-lora: Instruct-tune LLaMA on consumer hardware (github.com)

论文地址:https://arxiv.org/pdf/2106.09685.pdf

安装教程

为了避免各个语言模型需要单独安装配置各种语言环境等复杂问题,站长推荐大家使用Text-Generation-WebUI来加载模型。

你可以将Text-Generation-WebUI理解为是一个通用的语言模型加载工具,在你部署成功之后,各主流的开源语言模型无需单独安装部署,仅需要将模型放置到Text-Generation-WebUI的模型路径下即可使用,非常方便。

关于Text-Generation-WebUI的安装部署以及使用教程,请查看如下文章。

模型相关

官方下载

注意:如果你想运行7B的LoRA,那么就需要7B的LLama模型;如果你想推理65B的LoRA,那么就需要下载对应65B的LLaMA基础模型。

本文档提供了Alpaca-LoRA微调模型的下载、安装及推理教程。Alpaca模型是基于LLaMA大模型微调的70亿参数模型,利用LoRA技术进行高效微调。文章详细介绍了如何获取模型、加载模型以及使用Text-Generation-WebUI进行推理。同时,提供了多个推理示例展示模型的使用方法。

本文档提供了Alpaca-LoRA微调模型的下载、安装及推理教程。Alpaca模型是基于LLaMA大模型微调的70亿参数模型,利用LoRA技术进行高效微调。文章详细介绍了如何获取模型、加载模型以及使用Text-Generation-WebUI进行推理。同时,提供了多个推理示例展示模型的使用方法。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1233

1233

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?