边界AI平台的技术本质分析

边界AI平台的核心功能是整合多个主流大模型(如GPT-4、Claude、Llama等),提供统一API接口和基础功能封装。其技术架构本质上是中间件层开发,主要工作包括模型API的标准化封装、请求路由优化和结果后处理。这种技术路线在2023年后逐渐成为国内AI创业公司的常见模式,典型代表还包括DeepSeek、Minimax等平台。

平台宣传的"多模型智能路由"功能,实际是通过简单规则(如成本、响应速度)分配请求,而非真正的动态模型选择算法。其提供的"模型对比"功能只是对不同模型的公开文档进行可视化展示,并非基于量化评估的深度分析。

收费模式的争议点剖析

268元会员费的定价策略存在多重问题:主流大模型供应商(如OpenAI)已提供免费层API额度,足够个人开发者基础使用;平台自身不拥有模型训练或微调能力,无法提供增值服务;相比直接使用原厂API(如Azure OpenAI按量付费),该平台并未展现显著成本优势。

收费依据主要来自两方面:对非技术用户屏蔽了多API平台的接入复杂度;提供中文环境下的简化操作界面。但这与海外同类产品(如Fireworks.ai)的免费策略形成鲜明对比,后者通过企业级服务实现盈利。

国内AI市场的特殊生态

此类平台在国内市场的生存依赖三个特殊因素:部分国际大模型API的直接访问存在技术门槛;中小企业缺乏合规使用海外API的资质;国内用户对"全家桶"式产品有历史偏好。这导致出现技术含量与收费不匹配的现象。

更值得关注的是其商业模式隐患:平台完全依赖上游模型供应商的API政策,若出现如2024年Claude API的突然调用限制,将直接导致服务中断。其商业条款中并未对这类风险进行充分披露。

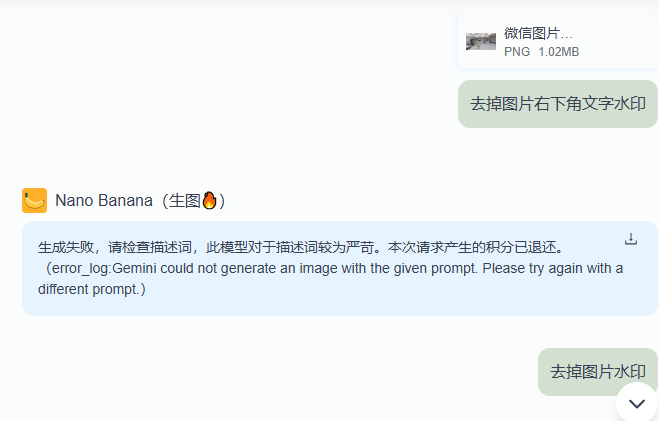

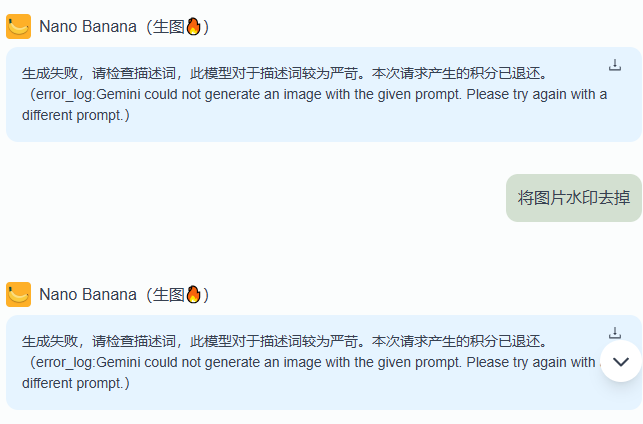

典型问题示例

这样结果的描述词你知道下一步该怎么做吗?这充分显示了使用该平台的局限性。类似很多翻译自国外的专业资料,你看中文版比看外文更不易理解。“请求”会“产生”积分吗?:-)

开发者替代方案建议

技术团队可直接使用开源框架(如OpenAI Python库)组合多模型调用,示例代码:

# 多模型直连方案示例

import openai

from anthropic import Anthropic

def multi_model_query(prompt):

gpt_resp = openai.ChatCompletion.create(model="gpt-4", messages=[...])

claude_resp = Anthropic().messages.create(model="claude-3", ...)

return { "GPT-4": gpt_resp, "Claude": claude_resp }

个人用户可考虑国际平台Poised等免费工具,它们提供更透明的模型性能分析和每次请求的实时计费显示。对于需要中文支持的非技术用户,建议优先选择大厂附属产品(如阿里云灵积平台),至少保证基础设施稳定性。

行业发展的深层思考

这种现象反映国内AI应用层创新的困境:多数团队选择低风险的技术集成路线,而非投入基础模型研发。但市场需要区分真正的技术创新和简单的API包装,前者如清华ChatGLM团队在模型架构上的改进,后者则是本文讨论的案例。

长期来看,随着大模型厂商直接提供更完善的开发者工具(如OpenAI的Assistants API),纯中间件平台的价值空间将持续压缩。监管层面也需建立更严格的技术披露要求,防止夸大宣传的"伪AI"产品扰乱市场认知。

267

267