ollama 升级到 0.12.9后,用dify(版本号:1.8.1)访问,报错如下:

[ollama] Error: req_id: 69de246fe9 PluginInvokeError: {"args":{"description":"[models] Error: API request failed with status code 500: {\"error\":\"Failed to create new sequence: failed to process inputs: unexpected EOF\"}"},"error_type":"InvokeError","message":"[models] Error: API request failed with status code 500: {\"error\":\"Failed to create new sequence: failed to process inputs: unexpected EOF\"}"}

起初怀疑是ollama配置文件 的问题,于是

vi /etc/systemd/system/ollama.service

[Unit]

Description=Ollama Service

After=network-online.target

[Service]

ExecStart=/usr/local/bin/ollama serve

User=ollama

Group=ollama

Restart=always

RestartSec=3

Environment="PATH=/root/miniforge3/condabin:/usr/local/cuda-11.8/bin:/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin:/snap/bin"

Environment="OLLAMA_HOST=0.0.0.0:11434"

Environment="OLLAMA_NUM_PARALLEL=8"

Environment="CUDA_VISIBLE_DEVICES=0,1"

[Install]

WantedBy=default.target

~

检查并未有问题。

根据报错Failed to create new sequence,队列不足,又增加参数,扩大队列

Environment="OLLAMA_MAX_QUEUE=10"

并无效果,仍然报错。

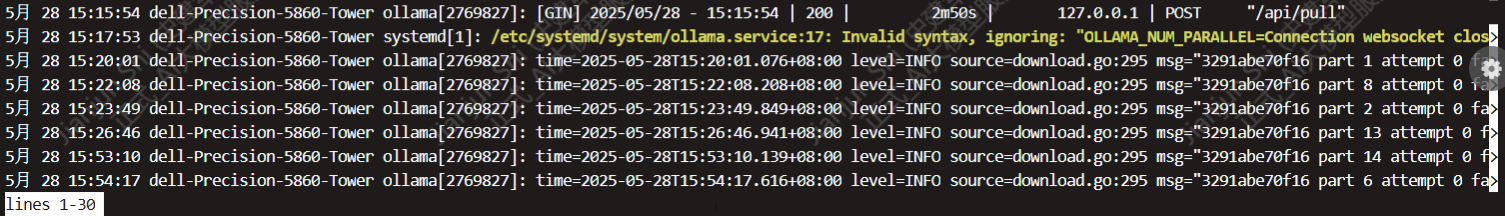

使用 journalctl -u ollama 查看ollama运行日志,发现

于是将 Environment="OLLAMA_NUM_PARALLEL=8" 删除,

发现问题依旧

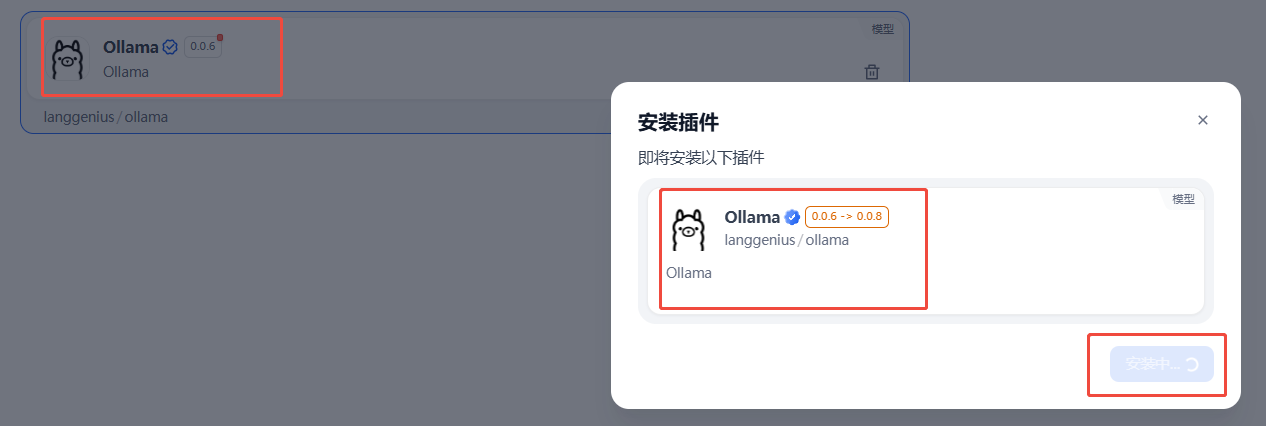

后来发现,dify升级到1.8.1后,ollama插件一直没有更新,于是更新一下ollama插件。

更新完成后再试。

输入命令试试查看ollama运行日志

# 查看最新日志(持续滚动)

journalctl -u ollama -f

仍然报错:llm predict error: Failed to create new sequence: failed to process inputs: unexpected EOF

11月 07 13:16:38 dell-Precision-5860-Tower ollama[1298429]: time=2025-11-07T13:16:38.847+08:00 level=INFO source=server.go:1485 msg="llm predict error: Failed to create new sequence: failed to process inputs: unexpected EOF"

11月 07 13:16:38 dell-Precision-5860-Tower ollama[1298429]: [GIN] 2025/11/07 - 13:16:38 | 500 | 159.651316ms | 172.176.0.7 | POST "/api/chat"

问题到底在哪,该怎么办呢。

搜遍全网,也没有此类错误的情况。于是怀疑是ollama版本( 0.12.9)过高,dify软件不支持的问题,dify目前版本是 1.8.1,于是考虑降低ollama版本号:

连接到另外一台部署ollama 0.11.10的服务器,测试果然是成功的。

最好没办法,还是先等等dify平台升级吧。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?