基于多摄像头融合车辆部件的夜间车辆检测与跟踪

摘要

利用传统的可见光相机进行夜间车辆检测与跟踪是一项具有挑战性的任务,因为能见度有限。目前最先进的系统将夜间车辆视为配对的车辆前大灯或尾灯,无法确定车辆的轮廓或其空间占用情况。因此,本文提出了首个结合车辆前大灯和尾灯以定位车辆轮廓的夜间框架。该新框架包含一种新颖的多摄像头车辆表示方法,通过不同车辆部件之间的相互几何距离,对车辆前大灯和尾灯进行分组和重建。这种新颖的车辆轮廓表示方法成功消除了重复的车辆灯光,并在检测过程中补偿了缺失的车辆灯光。最终,采用车辆大灯对齐和轮廓调整进一步优化车辆轮廓。所提多摄像头系统主要考虑监控中的典型四轮车辆,例如轿车和运动型多功能车(SUV),可能无法处理大型卡车,如十八轮卡车。实验在多种场景下的夜间交通视频上进行,所提系统在多目标跟踪精度(MOTA)上平均达到0.896,在杰卡德系数(JC)上平均达到0.904,相比基线系统分别提高了19.2%和15.9%。本文使用的夜间交通数据集可在https://github.com/JustMeZXX/Intelligent-Night-Time-Traffic-Surveillance获取。

索引词

多摄像头,夜间,车辆检测与跟踪,车辆轮廓,车辆表示,四轮。

一、引言

近十年来,基于计算机视觉的应用(如自动化交通监控)作为智能交通系统(ITS)[1]–[3]和结构健康监测(SHM)[4]–[7]的组件受到了广泛关注。这些智能交通系统旨在提供创新服务,使道路上的动态车辆能够安全地获取信息并与基础设施网络协调。因此,作为采集和分析道路车辆行为的基础,设计一种自动化的基于视觉的车辆检测与跟踪系统是智能交通系统的重要组成部分。通常情况下,交通监控(包括车辆分类、检测和跟踪)主要在白天条件下进行研究[8]–[10]。然而,由于光照不足,使用可见光相机在夜间情况下进行车辆检测与跟踪更具挑战性[10]–[12]。

典型的车辆外观特征,如颜色、形状或车牌,在夜间可能无法清晰可见。尽管一些成像传感器(如红外和激光雷达相机)在多个夜间交通监控应用中取得了令人满意的性能,但这些传感器的高成本和部署受限限制了其广泛应用[13]–[17]。相反,由于视觉相机基础设施的普遍性,设计仅依靠视觉相机的自动化车辆检测与跟踪系统备受期待,这也是本文的研究重点。

先前研究中,基于视觉相机的夜间车辆检测与跟踪系统主要依赖于标准的检测后跟踪策略[11],其中对单个车辆灯光特征进行检测和跟踪。前大灯和尾灯是夜间车辆定位的唯一显著且可靠的特征。如何利用这些检测到的显著车辆灯光特征来推断夜间车辆位置,仍然是一个关键问题[10]。文献[18]提出了一种轻量级系统,能够在不同照明条件下实现对车辆尾灯的跟踪以及警示信号的检测。文献[19]通过检测三种尾灯活动(如刹车、左转和右转)来分析夜间车辆动态。采用车辆灯光配对方法,将属于同一车辆身份的车辆前大灯或尾灯进行成对定位。最终通过跟踪这些配对的车辆前大灯或尾灯获得车辆轨迹[20]–[24]。

文献[20]设计了一种基于图的马尔可夫随机场(MRF),用于建模车辆尾灯与车牌之间的空间关系。然而,在夜间车牌不可见的情况下,将车牌作为建模MRF的显著特征并不可行。文献[21]研究了基于周围车辆传感器信息所捕获的车辆尾灯之间的空间车辆关系。但由于难以获取周围车辆的数据,此类传感器信息在当前可能不具备实际可用性。文献[22]提出了一种自适应车辆掩模训练方法,利用车辆对称性来检测和跟踪车辆前灯。然而,这种基于对称性的方法在高交通密度下,当存在多辆车辆时通常较为敏感并排行驶时可能会失效,尤其是在车辆部分被遮挡的情况下。文献[23]提出了用于车辆前大灯配对的最大加权独立集(MWIS)方法,文献[24]则将该MWIS前大灯配对方法与前大灯跟踪整合到一个统一的框架中。然而,MWIS的一个局限性在于其假设每帧中配对的候选前大灯数量远大于实际的前大灯对数量,当部分车辆前大灯未被检测到时,这一假设不再成立。尽管先前的研究在夜间配对的车辆前大灯或尾灯跟踪方面表现出良好的性能,但这些研究普遍存在的局限性是无法将同一车辆的前大灯和尾灯进行关联,也无法估计完整的车辆轮廓。此类车辆轮廓估计在多个工业应用中具有重要意义,例如判断车辆类型或估计其载荷。

因此,本文提出了一种新颖的多摄像头夜间车辆检测与跟踪系统,通过融合多个监控摄像头的视觉输入来定位车辆轮廓。本文的主要贡献包括:我们提出了首个融合框架,该框架通过整合车辆的前大灯和尾灯来实现夜间车辆轮廓的定位。该融合框架还包括一个集成的时序跟踪方案,有助于获取车辆聚类的数量。所提出的车辆轮廓定位算法能够在一次系统初始化后完全在线地在实际场景中运行,系统初始化期间需提供车道标线和典型车辆几何结构(例如一小部分车辆宽度和高度的验证集)作为先验信息。

提出了一种新颖的多摄像头车辆表示方法,该方法不仅能够对夜间可用的车辆前大灯和尾灯进行分组,还能根据车辆不同部件之间的相互几何兼容性,重建缺失的车辆前大灯和尾灯。几何兼容性被建模为一种基于类内和类间势函数的双向能量函数。然后通过最大化这个新设计的能量函数来确定车辆轮廓。

此外,提出了一种包含车辆变道检测和前灯对齐的车辆轮廓优化方法,用于微调定位的车辆轮廓。当估计的车辆运动方向(从先前帧获得)与车道标线相交时,即检测到车辆变道。随后,在后视图中根据透视一致性和变道检测得到的附加角度,对定位的车辆前灯进行对齐和补偿。

在所提系统中,首先从前部和后部的监控摄像头中检测车辆前灯和尾灯。然后将这些检测结果融合到后置摄像头视图中,并分别对融合的车辆前灯和检测到的尾灯进行跟踪。接着提出车辆轮廓定位方法,用于对这些被跟踪的车辆前灯和尾灯进行聚类分组。尽管车辆前灯和尾灯是从两个摄像头中检测得到的,但车辆几何它们所捕获的信息是相关的。因此,在本文中,我们利用这些相关性,创建了一个集成车辆前大灯和尾灯的基准,用于夜间车辆轮廓的定位。同时提出了一种车辆轮廓优化方法,以对齐这些定位的车辆轮廓。这种多摄像头车辆轮廓定位无需任何离线训练,完全基于车辆前大灯和尾灯的动态跟踪历史进行自我更新。

所提系统的其他子系统基于先前的车辆前灯和尾灯检测算法[20],并使用卡尔曼滤波器(KF)[25]进行跟踪。与通过将分组的检测结果分配给相应车辆来消除误检(假阳性)的最先进算法不同,该系统还能够在定位车辆轮廓的同时重建缺失的(漏检的假阴性)车辆前灯或尾灯。所提多摄像头系统主要考虑监控中的典型四轮车辆,例如轿车和运动型多功能车(SUV),可能无法处理大型卡车,例如十八轮卡车。

本文其余部分分为四个部分。在第二节中,我们对所提出的多摄像头夜间车辆检测与跟踪系统进行了概述,第三节详细描述了系统的各个组件。实验结果在第四节中给出,第五节为结论。

II. 系统模型概述

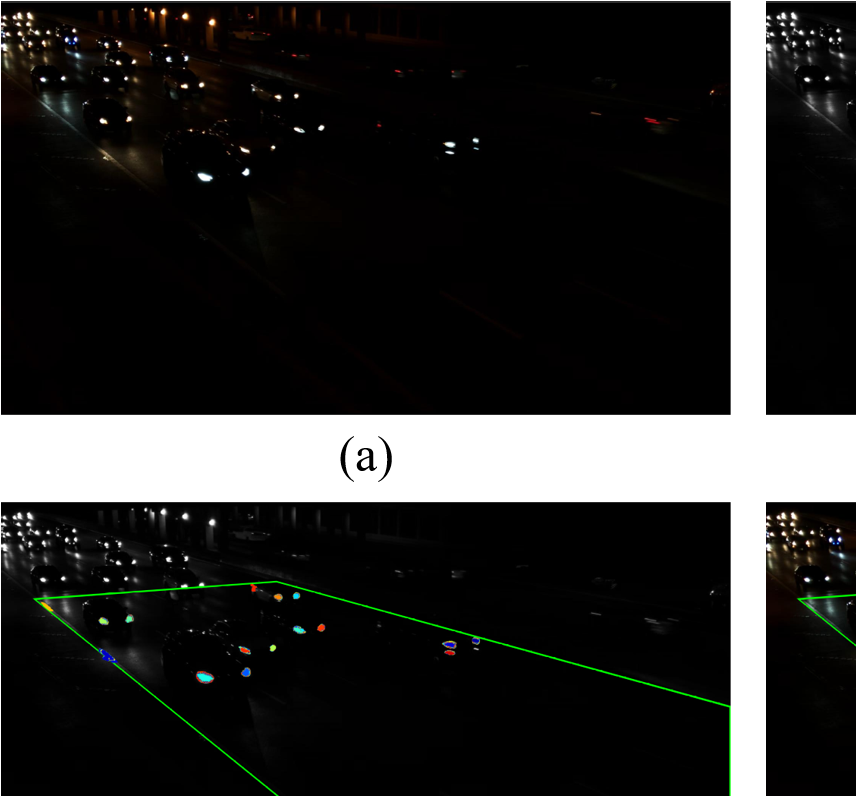

在本节中,我们对所提出的多摄像头夜间车辆检测与跟踪系统进行概述。该系统利用两个固定摄像头,分别安装在前视和后视位置以捕捉交通动态。前后摄像头的位置选择使得这些摄像头能够捕获大部分车辆的前大灯和尾灯。现场摄像头系统设置的详细信息见第四节-A部分。该系统的核心目标是从固定的后置摄像头中检测并跟踪多个车辆轮廓。该系统的输入为夜间前后视图的RGB视频序列,输出为多边形格式的后视车辆轮廓轨迹。

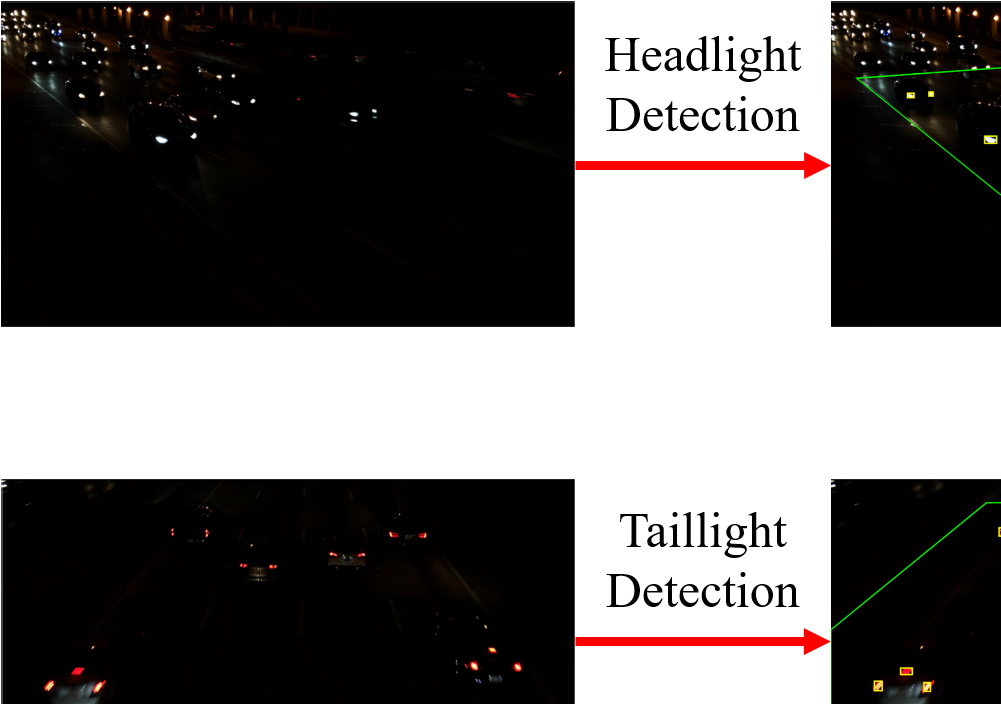

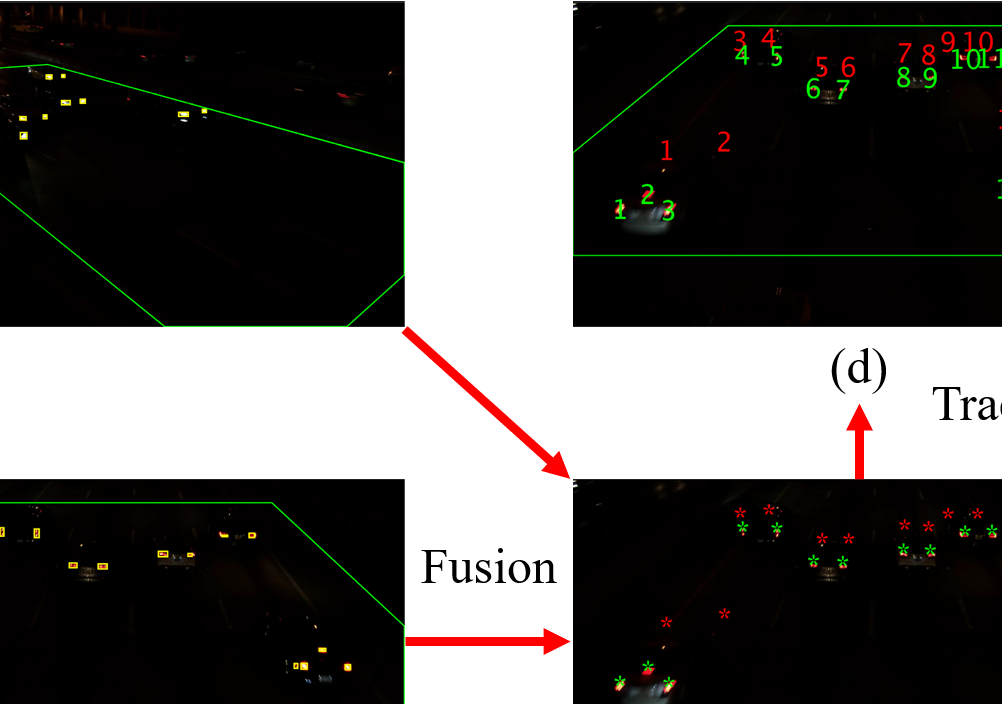

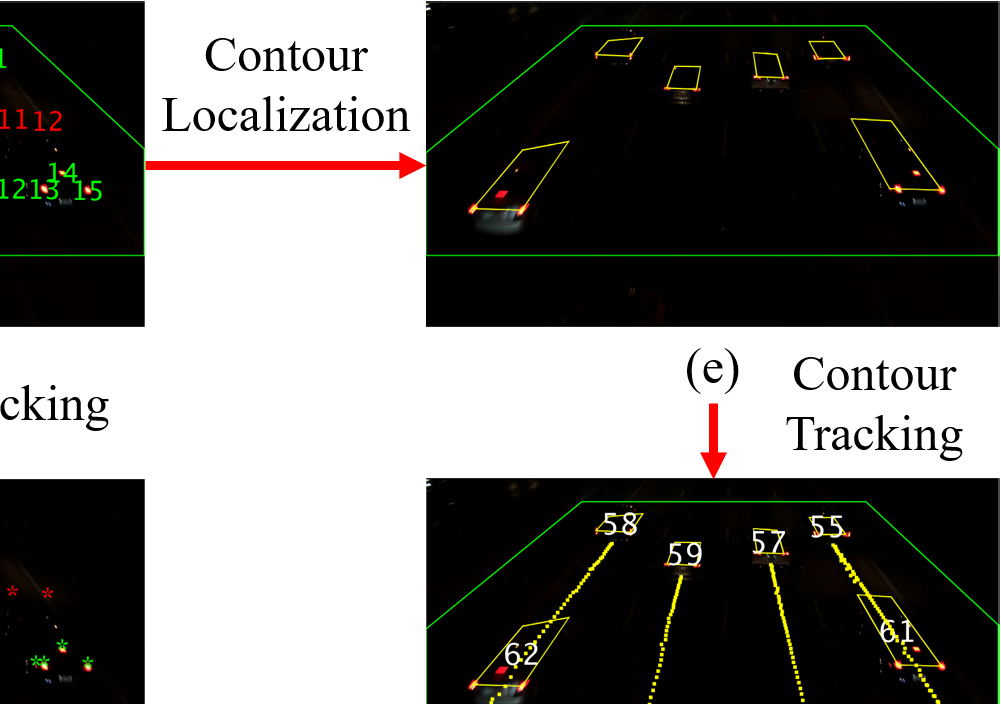

所提系统的关键要素如图1所示。该系统由以下三个主要部分组成:1)分别检测和跟踪车辆的前大灯与尾灯,2)融合车辆前大灯与尾灯信息,在后视图中实现车辆轮廓定位,3)对定位的车辆轮廓进行跟踪。在该系统中,通过在后视图中跟踪车辆前大灯和尾灯,将预测结果引入连续帧[20],[21],从而提升了检测与融合效果,并利用了时序跟踪线索。这些时序线索包括各个车辆部件的跟踪历史以及先前的车辆前灯与尾灯关联关系。记录的这些时序线索随后被用作车辆轮廓定位的第一步,以确定每一帧中的粗略车辆位置。

本研究的一个关键贡献是车辆轮廓定位,包括粗略的车辆位置识别、车辆前灯与尾灯分组及重建,以及车辆轮廓优化。

III. 多摄像头夜间车辆检测与跟踪系统设计

在本节中,我们详细描述了多摄像头夜间车辆检测与跟踪系统。基本的检测与跟踪过程基于我们的先前研究[21],其中利用附加传感器线索开发了车辆尾灯检测算法。在本文中,采用类似的过程来检测车辆前大灯。然后,提出基于多摄像头车辆表示的车辆轮廓定位方法,以对车辆前大灯和尾灯进行分组与重建,并估计车辆轮廓。此外,还开发了车辆轮廓优化方法,以提高所获得的车辆轮廓轨迹的精度。

A. 车辆前灯和尾灯检测与融合

在视频采集过程中,其中一个标记为前视摄像头C1的摄像头捕获包含车辆前灯的RGB视频序列,另一个标记为后视摄像头C2的摄像头捕获包含车辆尾灯的RGB视频序列。在所提系统中,对前视和后视中的车辆前大灯和尾灯进行检测是第一步。在检测到车辆前灯和尾灯后,采用基于单应性的方法将检测到的车辆前灯融合到后视图中。以下段落将讨论检测与融合过程。

1) 前灯

前视视频的第kth个RGB帧表示为Hk={Rk,Gk,Bk},其中Rk、Gk和Bk分别表示红色、绿色和蓝色通道矩阵。由于观察到车辆前灯像素的亮度大于其他非前灯像素,因此将RGB输入帧转换为灰度图像,同时保留亮度[26],其公式如下:

$$ L_k = 0.299R_k + 0.587G_k + 0.114B_k $$

其中Lk是一个矩阵,表示输入帧Hk的亮度,如图2(b)所示。本研究中,尺寸Lk被设置为1920×1088。随后从该亮度中提取最大稳定极值区域(MSERs)[28],如图2(c)所示。每个MSER的最小外接矩形被用作其检测到的边界框,其中MSER掩码中的像素数与检测到的边界框中像素数的比值记录为边界框范围。接着使用交并比(IoU)为0.01的非极大值抑制(NMS)方法,利用这些记录的范围去除重叠的检测边界框。我们还确定了剩余边界框中哪些框的像素级平均亮度高于预设阈值(此处设为130)。经过NMS后检测到的车辆前灯如图2(d)所示。距离摄像头较远的车辆空间分辨率非常低,且超出了我们夜间交通监控的关注范围;因此,我们将感兴趣区域(ROI)指定为监控摄像头视场(FOV)的中间部分,如图2(c)-(d)所示。

我们假设每辆车仅具有两个前灯。因此,在非极大值抑制后应用一种后处理方法[23],以去除在相邻区域检测到的同一车辆的四个车辆前灯或由反射光束产生的额外前大灯。

2) 尾灯

类似于前大灯,后视视频的kth RGB帧表示为Tk={Rk,Gk,Bk}。我们假设两个固定摄像头的帧是时间同步的。我们还假设摄像头的视场(FOV)有显著重叠,并且该重叠区域是关注的重点。根据车辆尾灯检测算法,在[20]输入帧被转换到CRGB空间,表示为:

$$ C_k = R_k - \max{G_k, B_k} - 3|G_k - B_k| $$

其中Ck是表示输入帧Tk的CRGB的矩阵。同样,此处矩阵尺寸设置为1920×1088,最大值和绝对值操作均为逐元素操作。从CRGB中提取相同的MSERs,然后应用NMS以去除重复的检测。CRGB、MSERs以及经过NMS后检测到的车辆尾灯示例如图3(b)-(d)所示。

3) 基于单应性的前灯融合

如图2(d)和图3(d)所示,车辆前大灯和尾灯分别在时间同步的前视图和后视图中被检测为边界框。由于车辆轮廓定位在后视图中,我们将从前视图检测到的车辆前灯融合到该后视图中。为简化处理,在此融合过程中仅考虑这些检测到的车辆前灯的中心坐标。这些检测到的中心坐标通过图2(a)和图3(a)之间的预估的单应性矩阵融合到后视图中。由于这两个摄像头是固定的,单应性矩阵是基于白天监控拍摄的同步图像进行估计的,其中两个摄像头之间的车道标线上的对应特征点可见且易于检测。

在检测到地面上的这些特征点后,根据参考文献[30]估计用于关联前视和后视摄像头的3×3单应性矩阵。由于在应用单应性矩阵之前目标车辆前灯点的投影位置存在不准确性,以及预估的单应性矩阵本身的有限精度,导致后视图中融合点的位置存在一定误差。我们后续的自适应处理能够补偿这些误差,并微调目标点的位置。在第IV-B节中包含了在前后方地面检测对应特征点的详细信息,同时也报告了基于单应性的前灯融合的精度。

如图1(c)所示,融合的车辆前灯被标记为红色星标,检测到的车辆尾灯被标记为绿色星标。然后利用连续帧[20]中的信息进行跟踪,以提高融合的车辆前灯和检测到的车辆尾灯的精度。

B. 车辆前大灯与尾灯跟踪

在将每一帧中检测到的车辆前大灯和尾灯融合到后视图之后,对车辆前大灯和尾灯进行跟踪。跟踪车辆前大灯和尾灯的主要目的是在后视图中匹配并预测连续帧中缺失的车辆前大灯和尾灯。在此跟踪过程中,使用卡尔曼滤波器(KF)来跟踪车辆前大灯和尾灯,其中每个KF被称为一个跟踪器。在每一帧中,将卡尔曼滤波跟踪器与车辆前灯或尾灯检测之间的关联进行分配。

由于对融合的车辆前大灯中心和检测到的车辆尾灯采用了相同的跟踪过程,我们仅描述针对检测到的车辆尾灯边界框的跟踪过程。车辆前灯的跟踪以类似方式完成。这些已跟踪的车辆尾灯的中心坐标将保留用于后续处理。由于交通监控采用透视视角,在KF预测步骤中使用了恒定加速度模型。KF及关联的详细信息将在下文段落中讨论。

1) KF

给定一个检测到的车辆尾灯,状态向量ski,定义为:

$$ s_{ki} = [c_{ki}, v_{ki}, a_{ki}]^T $$

其中cki是第ith个车辆尾灯在帧Tk时的中心坐标,vki是速度,aki是中心坐标的加速度。注意,cki、vki和aki均为长度为二的向量,表示笛卡尔坐标系中的x和y分量。卡尔曼滤波器是一种递归算法,包含预测与更新步骤。

a) 预测

在预测步骤中,当前状态向量$\hat{s}

{ki}$和状态协方差矩阵$\hat{P}

{ki}$被预测为:

$$ \hat{s}

{ki} = A s

{k-1i}, \quad \hat{P}

{ki} = A P

{k-1i} A^T + Q $$

其中A是状态转移矩阵,Q是噪声协方差矩阵。$s_{k-1i}$和$P_{k-1}$向量和状态协方差矩阵。(3)-(4)中该KF预测过程的初始化和经验参数设置遵循参考文献[27]。

b) 更新

在更新步骤中,当前状态向量$ski$和状态协方差矩阵$P_{ki}$将被更新为:

$$ s_{ki} = \hat{s}

{ki} + K

{ki}(y_{ki} - M\hat{s}

{ki}), \quad P

{ki} = (I - K_{ki}M)\hat{P}

{ki} $$

其中$y

{ki}$是当前观测值,M是测量矩阵。(5)中的KF增益$K_{ki}$计算为:

$$ K_{ki} = \hat{P}

{ki} M^T(M \hat{P}

{ki} M^T + R)^{-1} $$

其中R是测量噪声协方差矩阵。(5)-(6)中该KF更新过程的参数也遵循参考文献[27]。

2) 关联

在进行卡尔曼滤波器更新的同时,执行当前检测结果与预测的卡尔曼滤波器跟踪器之间的关联。设第T帧中第i个检测到的车辆尾灯为$ki=[x_{ik}, y_{ik}, w_{ki}, h_{ki}]$,第j个预测的车辆尾灯为$\hat{T}

{kj}=[\hat{x}

{kj}, \hat{y}

{kj}, \hat{w}

{kj}, \hat{h}

{kj}]$,其中$i \in {1, 2, …, P}$且$j \in {1, 2, …, Q}$。在帧Tk,除了P个检测结果与Q个预测结果之间的关联外,我们还引入虚拟关联,以处理检测或预测无对应匹配的情况。因此,不失一般性,这些分配的虚拟关联使得关联矩阵成为方阵[23],其中包含虚拟元素集合的检测集和预测集均表示为$N_k={1, 2, …, N_k}$。该关联被建模为一个约束优化问题,旨在寻找使:最小化的分配A={aki,j}

$$ A^* = \arg\min_A \sum_i \sum_j \epsilon

{ij} a_{ij} $$

s.t.

$$

\begin{cases}

\sum_{j=1}^{N_k} a_{ij} = 1, & i \in N_k \

\sum_{i=1}^{N_k} a_{ij} = 1, & j \in N_k \

a_{ij} \in {0, 1}, & i \land j \in N_k \

\epsilon_{ij} \leq \sigma, & i \land j \in N_k \setminus D_k

\end{cases}

$$

其中$a_{ij}$是第ith次检测与第jth次预测之间的关联(如果某次检测未被分配给任何预测,则将其分配给虚拟元素$D_k$,反之亦然)。σ为关联阈值,在本研究中设置为60像素,而$\epsilon_{ij}$为相似性距离,定义为:

$$

\epsilon_{ij} =

\begin{cases}

\frac{|(x_{ik}, y_{ik}) - (\hat{x}

{kj}, \hat{y}

{kj})|}{\text{IoU}(w_{ki}, h_{ki}, \hat{w}

{kj}, \hat{h}

{kj})}, & i \land j \in N_k \setminus D_k \

0, & i \lor j \in D_k

\end{cases}

$$

术语$|(x_{ik}, y_{ik}) - (\hat{x}

{kj}, \hat{y}

{kj})|$表示具有相互对应关系的第ith个检测结果与第jth个预测结果之间的中心坐标欧几里得距离。量$\text{IoU}(w_{ki}, h_{ki}, \hat{w}

{kj}, \hat{h}

{kj})$是$(1, 1, w_{ki}, h_{ki})$与$(1, 1, \hat{w}

{kj}, \hat{h}

{kj})$之间的对齐的IoU,其中$[\hat{w}

{kj}, \hat{h}

{kj}] = [w_{k-1j}, h_{k-1j}]$。注意,在跟踪这些融合的车辆前灯的中心坐标时,$\text{IoU}(w_{ki}, h_{ki}, \hat{w}

{kj}, \hat{h}

{kj})$等于1。(7)中的约束优化通过匈牙利算法(HA)[29]求解,从而获得来自后视视角的车辆前灯和尾灯的跟踪轨迹。在跟踪过程中,未被分配到任何检测结果的卡尔曼滤波器(KF)跟踪器将使用恒定加速度预测模型在若干连续帧(本研究中为两帧)内保留。此外,若某个检测结果未被分配给任何KF跟踪器,则将启动一条新的轨迹。

C. 车辆轮廓定位

在第三节-B中描述的后视图中对融合的车辆前灯和检测到的车辆尾灯进行跟踪后,所提系统会执行车辆轮廓定位过程,这是该系统的一个关键贡献。

在本节中,利用从车辆前灯的融合中心坐标获得的显著车辆信息来确定每一帧中的粗略车辆位置。基于这些已识别的车辆位置,将车辆前大灯和尾灯进行分组以形成车辆轮廓。随后,提出了一种车辆轮廓优化方法,以对这些获得的车辆轮廓进行校准。以下段落将详细讨论这些步骤。

1) 车辆位置识别

在跟踪每一帧中车辆的前大灯和尾灯后,分别获得车辆前大灯和尾灯中心坐标的轨迹。受利用车辆牌照[20]和融合传感器信息[21]来定位车辆的启发,需要从可用跟踪器中提取显著车辆特征。在将多个车辆部件合并为一个有效车辆之前,选择显著车辆特征以确定车辆数量及其位置的粗略信息。观察发现,由于亮度分量及形状在前期检测与跟踪过程中的鲁棒性,车辆前大灯的跟踪比车辆尾灯更加稳定。因此,采用被跟踪的车辆前大灯作为显著车辆特征来识别初步车辆位置。我们假设每辆车仅包含两个前灯,且这两个前灯通常位于一定距离范围内(以像素数量为单位等效测量)。该距离可根据固定摄像头参数以及相对于所需视场内车辆的位置(方向)预先确定。所提出的车辆位置识别方法包括基于距离的聚类和车辆簇检索,具体如下所述。

a) 基于距离的聚类

在此聚类步骤中,如果两个被跟踪的车辆前灯之间的距离小于阈值ε,则将它们聚类为一辆车辆。该距离阈值ε设定为该聚类跟踪器与其两个相邻道路地标之间两个水平距离的平均值。然后,在帧Tk中的每一对被跟踪车辆前灯上执行此基于距离的聚类策略,从而获得车辆头灯簇。然而,当多辆车辆并排行驶时,这种简单的基于距离的聚类无法将多个车辆前灯划分为独立的簇。如图4(a)所示,由于空间邻近性,索引为4的车辆前灯被分配为一个簇。因此,提出了一种车辆簇检索方法来解决此问题。

b) 车辆簇检索

此检索步骤的主要目标是确定当多辆车辆并排行驶时的真实车辆聚类。在当前帧中,若一个聚类包含两个以上被跟踪的车辆前灯,则需要根据其跟踪线索来确定确切的车辆数量,这些车辆被称为子簇。

如图5所示,在第Tk帧通过基于距离的聚类得到的cth聚类车辆前灯表示为集合$f_k^c = {f_{k,1}^c, f_{k,2}^c, …, f_{k,L}^c}$,包含L (>2)个车辆前大灯跟踪器,其中每个跟踪器标识记为$f_{k,i}^c$,且同一集合内的跟踪器标识被分配至同一车辆簇。为了探究不同跟踪器之间的连接并检索真实的车辆簇,我们追溯这些L个跟踪器的起始帧Tk−N,其中N为最长跟踪历史。在Tk到Tk−N之间的每一帧Tk−n,找到$f_{k-n}^c$的mth个子集表示为$f_{k-n}^{c,m} = {f_{k-n}^{c,i}, f_{k-n}^{c,j}}$,其中i,j ∈ {1, 2, …, L}且m ∈ {1, 2, …, Mn}。当仅存在一个跟踪器时,跟踪器索引i等于j。此外,我们使用空标识对跟踪历史少于N帧的前灯跟踪器进行填充,以实现泛化。因此,在每一帧Tk−n,子集与Tk时刻集合$f_k^c$之间的关系表示为:

$$ f_k^c \equiv f_{k-n}^c = \sum_m f_{k-n}^{c,m} $$

其中,集合$f_k^c$在所有N个被跟踪帧中等于$f_{k-n}^c$。由于车辆簇检索是按序列顺序执行的在线算法,因此每个子集$f_{k-n}^{c,m}$中剩余的跟踪器数量不超过两个。

然后,在跟踪这N个目标时,我们统计由相同的跟踪器索引对组成的子集$f_{k-n}^{c,m}$出现的次数,并记录其尺寸,即元素数量。

连续帧。因此,从这N个被跟踪的帧中,帧Tk时具有标识$f_{k,i}^c$和$f_{k,j}^c$的跟踪器之间的关系表示为:

$$ \Delta_{i,j}^{k,c} = {p_{i,j}^{k,c}, w_{i,j}^{k,c}} $$

其中,$p_{i,j}^{k,c}$是从所有N个被跟踪的帧中获得的具有相同跟踪器索引对(i,j)的子集$f_{k-n}^{c,m}$的重复出现次数,$w_{i,j}^{k,c}$是连接权重。当前集合$f_k^c$的车辆簇检索随后被表述为一个约束优化问题,旨在寻找二值连接$C_c = {c_{i,j}^{k,c}}$,以最大化:

$$ C_c^

= \arg\max_{C_c} \sum_i \sum_j p_{i,j}^{k,c} w_{i,j}^{k,c} c_{i,j}^{k,c} $$

s.t.

$$

\begin{cases}

\sum_{i=1}^L c_{i,j}^{k,c} = 1, & j \in {1, 2, …, L} \

\sum_{j=1}^L c_{i,j}^{k,c} = 1, & i \in {1, 2, …, L} \

c_{i,j}^{k,c} \in {0, 1}

\end{cases}

$$

由于假设一辆车仅具有两个前灯,且多个前灯可能在轨迹中缺失,因此不同跟踪器之间的连接权重高于自连接的权重。因此,第T帧中具有标识$f_{k,i}^c$和$f_{k,j}^c$的两个跟踪器之间的连接权重$w_{i,j}^{k,c}$定义为:

$$

w_{i,j}^{k,c} =

\begin{cases}

\rho, & i \neq j \

1, & i = j

\end{cases}

$$

其中,设置ρ > 1可确保这些相互连接具有更高的优先级。然而,对于那些分配了两个以上跟踪器但没有跟踪历史的车辆前大灯簇(例如新轨迹),我们仅使用提供的道路地标将这些簇拆分为多个子簇。此外,我们对每个聚类后的车辆前大灯重复检索过程,并利用获得的连接${C_1^

, C_2^

, … C_C^

}$从多个可用的车辆头灯跟踪器中识别初步车辆位置。图4(b)展示了由所获连接得到的车辆前大灯簇。这些连接被添加到相应跟踪器的跟踪历史中,用于后续处理。算法1给出了所提出的车辆位置识别的关键步骤。

2) 分组

在从被跟踪的车辆前灯确定车辆位置后,通过多个车辆前大灯跟踪器检索属于同一车辆的车辆前灯簇。设C为在帧Tk时检索到的簇的数量,其中第cth个簇表示为$F_k^c$。在第cth个簇中,m个被跟踪的车辆前灯表示为$F_k^c = {F_{k,1}^c, F_{k,2}^c, …, F_{k,m}^c}$,其中第ith个跟踪器表示为$F_{k,i}^c = {f_{k,i}^c, F_{k,i}^c, x_{k,i}^c, y_{k,i}^c}$,其中$f_{k,i}^c$为跟踪器标识,$F_{k,i}^c$为该跟踪器在两个相邻道路地标之间的水平距离,$(x_{k,i}^c, y_{k,i}^c)$为该跟踪器的像素坐标。

由于聚类的车辆前灯跟踪器被视为识别车辆位置的显著特征,因此分组过程的主要目标是将先前已跟踪的车辆尾灯与这些聚类的前灯跟踪器组合成有效的车辆轮廓。在此分组过程中,我们采用两个车辆部件(例如车辆前大灯和尾灯)之间的相互几何距离作为分组准则。接下来将详细讨论该分组过程的具体细节。

a) 车辆尾灯分配

作为该分组过程的第一步,需要将车辆尾灯跟踪器分配给这些检索到的前灯聚类。考虑到在帧$F_k^c$中的已聚类的车辆前灯Tk,然后基于每个聚类的质心$F_k^c$的空间邻近性,找到n个候选车辆尾灯跟踪器$D_k^c$,此过程类似于[21]中的传感器上下文融合。这n个候选跟踪器表示为$D_k^c = {D_{k,1}^c, D_{k,2}^c, …, D_{k,n}^c}$,其中每个$D_{k,d}^c = {d_{k,d}^c, D_{k,d}^c, u_{k,d}^c, v_{k,d}^c}$,d为被跟踪的车辆尾灯标识,$D_{k,d}^c$表示该跟踪器的水平距离在两个相邻道路地标之间,$(u_{k,d}^c, v_{k,d}^c)$是车辆尾灯跟踪器的像素坐标。因此,每个车辆前大灯簇$F_k^c$的车辆尾灯分配输出为n个候选车辆尾灯跟踪器$D_k^c$,然后对每个$S_k^c = {F_k^c, D_k^c}$进行分组。

b) 几何分组准则

我们考虑三种车辆几何距离作为分组准则,用于将估计的车辆前大灯和尾灯组合成有效的车辆轮廓。可以看出,从后方交通监控视角观察,车辆轮廓通常是多边形。因此,定义不同车辆部件之间分组兼容性的三个必要车辆几何距离为:

- 两个给定的车辆前灯之间的水平距离,记为a。

- 两个给定车辆尾灯之间的水平距离,记为b。

- 两个前灯和两个尾灯的中心点之间的垂直距离,记为h。

类似于假设每辆车仅有两个前灯,我们也假设在我们的数据中每辆车仅有两个尾灯。利用这些车辆几何距离来确定兼容性,对车辆前灯和尾灯进行分组。

c) 在线动态回归与预测(ODRAP)

通过估计不同车辆部件之间的空间距离来确定其几何兼容性。考虑$S_{p+1}^c$中的第ith个跟踪器$S_{p+1,c,i}^c$,其空间距离表示为$\tilde{a} {p+1,c,i}^c$、$\tilde{b} {p+1,c,i}^c$和$\tilde{h} {p+1,c,i}^c$,分别对应前述的车辆几何距离a、b和h。由于这些车辆前灯和尾灯是构成车辆轮廓的互补部分,在当前帧Tp+1中,所提出的ODRAP方法基于每个跟踪器$S {p+1,c,i}^c$的跟踪历史来预测当前的空间距离。

如果$S_{p+1,c,i}^c$在过去p个连续帧中已被跟踪,则根据其过去p个连续的空间距离以及对应的两个相邻道路地标之间的水平距离来估计关于$S_{p+1,c,i}^c$的空间距离,表示为:

$$

\begin{aligned}

a_{c,i} &= [a_{1,c,i}^c, …, a_{p,c,i}^c] \

b_{c,i} &= [b_{1,c,i}^c, …, b_{p,c,i}^c] \

h_{c,i} &= [h_{1,c,i}^c, …, h_{p,c,i}^c] \

L_{c,i} &=

\begin{cases}

[F_{1,c,i}^c, …, F_{p,c,i}^c], & S_{p+1,c,i}^c \in F_{p+1}^c \

[D_{1,c,i}^c, …, D_{p,c,i}^c], & S_{p+1,c,i}^c \in D_{p+1}^c

\end{cases}

\end{aligned}

$$

ac,i、bc,i和hc,i分别表示两个前大灯之间的水平距离、两个尾灯之间的水平距离,以及车辆前灯与尾灯中心点之间的垂直距离,Lc,i表示该跟踪器在过去两个相邻道路地标之间的水平距离。用于预测在帧Tp+1时跟踪器$S_{p+1,c,i}^c$的空间距离的模型参数是从过去的p个连续帧中估计得到的。因此,给定三个向量对$(L_{c,i}, a_{c,i})$, $(L_{c,i}, b_{c,i})$和$(L_{c,i}, h_{c,i})$从过去的p个连续帧中获得,Lc,i与每个ac,i、bc,i、hc,i之间的参数分别被估计为:

$$

\begin{aligned}

\alpha_{c,i}^

&= \arg\min_{\alpha_{c,i}} |a_{c,i} - F_{\alpha_{c,i}}(L_{c,i})| \

\beta_{c,i}^

&= \arg\min_{\beta_{c,i}} |b_{c,i} - F_{\beta_{c,i}}(L_{c,i})| \

\gamma_{c,i}^

&= \arg\min_{\gamma_{c,i}} |h_{c,i} - F_{\gamma_{c,i}}(L_{c,i})|

\end{aligned}

$$

其中$\alpha_{c,i}^

$、$\beta_{c,i}^

$以及$\gamma_{c,i}^

$为估计的模型参数。我们使用二次形式,即$F(x) = ax^2 + bx + c$,来建模每个向量对中变量之间的关系。此外,我们基于标注的车辆轮廓[21]中的向量对$(L_0, a_0)$、$(L_0, b_0)$和$(L_0, h_0)$,从一个小的验证集初始化模型参数$P_0^

= {\alpha_0^

, \beta_0^

, \gamma_0^

}$。因此,基于这些估计的模型参数,ODRAP预测跟踪器$S_{p+1,c,i}^c$的空间距离为:

$$

\begin{aligned}

\tilde{a}

{p+1,c,i}^c &= F

{\alpha_{c,i}^

}(L_{p+1,c,i}^c) =

\begin{cases}

\overrightarrow{\tilde{a}

{p+1,c,i}^c}, & S

{p+1,c,i}^c \in F_{p+1}^c \

\overleftarrow{\tilde{a}

{p+1,c,i}^c}, & S

{p+1,c,i}^c \in D_{p+1}^c

\end{cases} \

\tilde{b}

{p+1,c,i}^c &= F

{\beta_{c,i}^

}(L_{p+1,c,i}^c) =

\begin{cases}

\overrightarrow{\tilde{b}

{p+1,c,i}^c}, & S

{p+1,c,i}^c \in F_{p+1}^c \

\overleftarrow{\tilde{b}

{p+1,c,i}^c}, & S

{p+1,c,i}^c \in D_{p+1}^c

\end{cases} \

\tilde{h}

{p+1,c,i}^c &= F

{\gamma_{c,i}^*}(L_{p+1,c,i}^c) =

\begin{cases}

\overrightarrow{\tilde{h}

{p+1,c,i}^c}, & S

{p+1,c,i}^c \in F_{p+1}^c \

\overleftarrow{\tilde{h}

{p+1,c,i}^c}, & S

{p+1,c,i}^c \in D_{p+1}^c

\end{cases}

\end{aligned}

$$

其中输入$L_{p+1,c,i}^c$定义为:

$$

L_{p+1,c,i}^c =

\begin{cases}

F_{p+1,c,i}^c, & S_{p+1}^c \in F_{p+1}^c \

D_{p+1,c,i}^c, & S_{p+1}^c \in D_{p+1}^c

\end{cases}

$$

由(15)式可得,跟踪器$S_{p+1,c,i}^c$在当前帧Tp+1获得的空间距离有两个值,分别表示为两个方向,例如→和←。这些方向代表来自车辆前灯或尾灯的空间距离估计,将用于势函数的建模。需要注意的是,帧索引(p+1)表明ODRAP是一种在线算法,其中利用了过去的p个连续帧。

d) 类内势函数

在预测每个跟踪器$S_{p+1,c,i}^c$的三个空间距离后,类内势函数表示同一类型(前灯或尾灯)的两个跟踪器之间的兼容性。由于车辆前大灯和尾灯在形成车辆轮廓时是互补部分,类内势函数进一步建模为两个方向,例如→和←。注意,索引(i,j)或(m,n)用于表示来自车辆前灯或尾灯的跟踪器及估计的空间距离。因此,当空间距离由车辆前灯估计时,两个跟踪器之间的类内势函数跟踪器被建模为:

$$

\begin{aligned}

\overrightarrow{\chi}(F_{p+1,c,i}^c, F_{p+1,c,j}^c, \overrightarrow{\tilde{a}

{p+1,c,i}^c}, \overrightarrow{\tilde{a}

{p+1,c,j}^c}) &\sim N\left(\frac{|x_{p+1,c,j}^c - x_{p+1,c,i}^c| - \frac{\overrightarrow{\tilde{a}

{p+1,c,i}^c} + \overrightarrow{\tilde{a}

{p+1,c,j}^c}}{2}}{\overrightarrow{\rho_a}}; \mu_{\overrightarrow{a}}, \sigma_{\overrightarrow{a}}^2\right) \

\overrightarrow{\phi}(D_{p+1,c,m}^c, D_{p+1,c,n}^c, \overrightarrow{\tilde{b}

{p+1,c,i}^c}, \overrightarrow{\tilde{b}

{p+1,c,j}^c}) &\sim N\left(\frac{|u_{p+1,c,m}^c - u_{p+1,c,n}^c| - \frac{\overrightarrow{\tilde{b}

{p+1,c,i}^c} + \overrightarrow{\tilde{b}

{p+1,c,j}^c}}{2}}{\overrightarrow{\rho_b}}; \mu_{\overrightarrow{b}}, \sigma_{\overrightarrow{b}}^2\right)

\end{aligned}

$$

其中$\overrightarrow{\chi}(\cdot)$和$\overrightarrow{\phi}(\cdot)$是均值为$\mu_a$、$\mu_b$,方差为$\sigma_a^2$、$\sigma_b^2$的高斯分布。为了符号简洁,高斯分布表示为$N(x;\mu,\sigma^2) = \frac{1}{\sigma\sqrt{2\pi}} e^{-\frac{1}{2}(x-\mu/\sigma)^2}$,其中x为输入变量,μ和σ²分别为均值和方差。具体而言,针对两个被跟踪的车辆前大灯,$\overrightarrow{\chi}(\cdot)$建模了它们检测到的水平距离与估计的空间(水平)距离之间的差异。此外,$\overrightarrow{\phi}(\cdot)$建模了它们检测到的水平距离与尾灯之间当前估计的水平距离之间的差异。参数$\overrightarrow{\rho_a}$和$\overrightarrow{\rho_b}$是归一化因子,用于使输入具有相应的均值$\mu_{\overrightarrow{a}}$、$\mu_{\overrightarrow{b}}$和方差$\sigma_{\overrightarrow{a}}^2$、$\sigma_{\overrightarrow{b}}^2$。“→”方向表示空间距离由车辆前大灯跟踪器估计得出。类似地,当当前空间(水平)距离由车辆尾灯跟踪器估计时,两个车辆跟踪器之间的类内势函数建模为:

$$

\begin{aligned}

\overleftarrow{\chi}(F_{p+1,c,i}^c, F_{p+1,c,j}^c, \overleftarrow{\tilde{a}

{p+1,c,m}^c}, \overleftarrow{\tilde{a}

{p+1,c,n}^c}) &\sim N\left(\frac{|x_{p+1,c,i}^c - x_{p+1,c,j}^c| - \frac{\overleftarrow{\tilde{a}

{p+1,c,m}^c} + \overleftarrow{\tilde{a}

{p+1,c,n}^c}}{2}}{\overleftarrow{\rho_a}}; \mu_{\overleftarrow{a}}, \sigma_{\overleftarrow{a}}^2\right) \

\overleftarrow{\phi}(D_{p+1,c,m}^c, D_{p+1,c,n}^c, \overleftarrow{\tilde{b}

{p+1,c,m}^c}, \overleftarrow{\tilde{b}

{p+1,c,n}^c}) &\sim N\left(\frac{|u_{p+1,c,m}^c - u_{p+1,c,n}^c| - \frac{\overleftarrow{\tilde{b}

{p+1,c,m}^c} + \overleftarrow{\tilde{b}

{p+1,c,n}^c}}{2}}{\overleftarrow{\rho_b}}; \mu_{\overleftarrow{b}}, \sigma_{\overleftarrow{b}}^2\right)

\end{aligned}

$$

其中符号与(17)类似,只是方向“←”表示空间距离是从尾灯估算的跟踪器。由于每个方向上的两个类内势函数具有相等的权重,为简化起见,均值设为$\mu_{\overrightarrow{a}} = \mu_{\overrightarrow{b}} = 0$和$\mu_{\overleftarrow{a}} = \mu_{\overleftarrow{b}} = 0$,方差设为$\sigma_{\overrightarrow{a}}^2 = \sigma_{\overrightarrow{b}}^2 = 1$和$\sigma_{\overleftarrow{a}}^2 = \sigma_{\overleftarrow{b}}^2 = 1$。

e) 类间势函数

在预测每个跟踪器的三个空间距离$S_{p+1,c,i}^c$后,建模前大灯跟踪器与尾灯跟踪器之间的类间势函数,以表示它们的兼容性。类似地,在建模类间势函数时也考虑了两个方向,例如→和←。因此,两个车辆跟踪器在两个方向上的类间势函数被建模为高斯分布,如下所示:

$$

\begin{aligned}

\overrightarrow{\psi}(F_{p+1,c,i}^c, D_{p+1,c,m}^c, \overrightarrow{\tilde{h}

{p+1,c,i}^c}) &\sim N\left(\frac{|y

{p+1,c,i}^c - v_{p+1,c,m}^c| - \frac{\overrightarrow{\tilde{h}

{p+1,c,i}^c}}{\overrightarrow{\rho_h}}}; \mu

{\overrightarrow{h}}, \sigma_{\overrightarrow{h}}^2\right) \

\overleftarrow{\psi}(F_{p+1,c,i}^c, D_{p+1,c,m}^c, \overleftarrow{\tilde{h}

{p+1,c,m}^c}) &\sim N\left(\frac{|y

{p+1,c,i}^c - v_{p+1,c,m}^c| - \frac{\overleftarrow{\tilde{h}

{p+1,c,m}^c}}{\overleftarrow{\rho_h}}}; \mu

{\overleftarrow{h}}, \sigma_{\overleftarrow{h}}^2\right)

\end{aligned}

$$

$\overrightarrow{\psi}(\cdot)$和$\overleftarrow{\psi}(\cdot)$均对检测到的垂直距离与估计的空间(垂直)距离之间的差异进行建模。$\overrightarrow{\rho_h}$和$\overleftarrow{\rho_h}$是归一化因子,用于使输入具有相应的均值$\mu_{\overrightarrow{h}}$、$\mu_{\overleftarrow{h}}$和方差$\sigma_{\overrightarrow{h}}^2$、$\sigma_{\overleftarrow{h}}^2$。类似地,方向“→”表示空间距离由车辆前大灯跟踪器估计,而“←”表示空间距离由车辆尾灯跟踪器估计。为简便起见,均值设为$\mu_{\overrightarrow{h}} = 0$和$\mu_{\overleftarrow{h}} = 0$,方差设为$\sigma_{\overrightarrow{h}}^2 = 1$和$\sigma_{\overleftarrow{h}}^2 = 1$。

f) 能量

在此步骤中,通过结合双向类内和类间势函数,能量函数$\overrightarrow{\varepsilon}$和$\overleftarrow{\varepsilon}$在(20)中给出,如页面底部所示。在类间项中,$F_{p+1}^c$是$F_{p+1,c,i}^c$和$F_{p+1,c,j}^c$的中心坐标,而$D_{p+1}^c$是$D_{p+1,c,m}^c$和$D_{p+1,c,n}^c$的中心坐标。因此,(20)中相应的预测空间距离$\overrightarrow{\tilde{h}

{p+1,c}^c}$和$\overleftarrow{\tilde{h}

{p+1,c}^c}$被表示为:

$$

\overrightarrow{\tilde{h}

{p+1,c}^c} = \frac{\overrightarrow{\tilde{h}

{p+1,c,i}^c} + \overrightarrow{\tilde{h}

{p+1,c,j}^c}}{2}, \quad \overleftarrow{\tilde{h}

{p+1,c}^c} = \frac{\overleftarrow{\tilde{h}

{p+1,c,m}^c} + \overleftarrow{\tilde{h}

{p+1,c,n}^c}}{2}

$$

由于势函数在两个不同的跟踪器之间建模(如果它们都存在),并且不失一般性,我们将(20)中类内项的值设为一个常数λ。在我们的数值评估中,λ被设置为10⁻⁴。此外,(20)中的类间项χ(·)和ϕ(·)在$F_{p+1}^c = \emptyset$或$D_{p+1}^c = \emptyset$时等于1。

g) 双向推理

由于车辆前大灯和尾灯是构成车辆轮廓的互补组件,我们将公式(20)中的建模双向能量进行组合。$S_{p+1}^c$中跟踪器的分组过程被表述为一个约束优化问题,旨在同时寻找前大灯对$(F_{p+1,c,i}^c, F_{p+1,c,j}^c) \in F_{p+1}^c$和尾灯对$(D_{p+1,c,m}^c, D_{p+1,c,n}^c) \in D_{p+1}^c$,使得组合双向能量函数最大化,即:

$$

(F_{p+1,c,i}^{c

}, F_{p+1,c,j}^{c

}, D_{p+1,c,m}^{c

}, D_{p+1,c,n}^{c

}) = \arg\max_{i,j,m,n} \left( \log\overrightarrow{\varepsilon} + \log\overleftarrow{\varepsilon} \right)

$$

s.t.

$$

\begin{cases}

\theta(F_{p+1,c,i}^c, F_{p+1,c,j}^c) \leq \varepsilon_F, & F_{p+1}^c \neq \emptyset \

\theta(D_{p+1,c,m}^c, D_{p+1,c,n}^c) \leq \varepsilon_D, & D_{p+1}^c \neq \emptyset

\end{cases}

$$

其中使用对数以避免数值溢出。(22)中角度εF和εD的阈值均设为0.2弧度,角度$\theta(F_{p+1,c,i}^c, F_{p+1,c,j}^c)$, $\theta(D_{p+1,c,m}^c, D_{p+1,c,n}^c)$为

$$

\begin{aligned}

\theta(F_{p+1,c,i}^c, F_{p+1,c,j}^c) &=

\begin{cases}

\left| \frac{y_{p+1,c,i}^c - y_{p+1,c,j}^c}{x_{p+1,c,i}^c - x_{p+1,c,j}^c} \right|, & i \neq j \

0, & i = j

\end{cases} \

\theta(D_{p+1,c,m}^c, D_{p+1,c,n}^c) &=

\begin{cases}

\left| \frac{v_{p+1,c,m}^c - v_{p+1,c,n}^c}{u_{p+1,c,m}^c - u_{p+1,c,n}^c} \right|, & m \neq n \

0, & m = n

\end{cases}

\end{aligned}

$$

因此,从获得的前大灯和尾灯跟踪器$(F_{p+1,c,i}^{c

}, F_{p+1,c,j}^{c

}, D_{p+1,c,m}^{c

}, D_{p+1,c,n}^{c

})$中,(22)式中的车辆轮廓表示为:

$$

R_{p+1}^c = [x_{p+1,c,i}^{c

}, y_{p+1,c,i}^{c

}; x_{p+1,c,j}^{c

}, y_{p+1,c,j}^{c

}; u_{p+1,c,m}^{c

}, v_{p+1,c,m}^{c

}; u_{p+1,c,n}^{c

}, v_{p+1,c,n}^{c

}]

$$

其中每一行代表该跟踪器的像素坐标。

h) 车辆空间距离更新

由于ODRAP是一种在线算法,因此需要根据当前帧(p+1)获得的车辆轮廓$R_{p+1}^c$来更新车辆空间距离。该更新过程在构成$R_{p+1}^c$的每个候选跟踪器上均以相同方式执行,因此为避免重复,我们仅说明$F_{p+1,c,i}^{c

}$的更新过程。$F_{p+1,c,i}^{c

}$的这三个车辆空间距离被更新为:

$$

\begin{aligned}

a_{p+1,c,i}^{c

} &=

\begin{cases}

|x_{p+1,c,i}^{c

} - x_{p+1,c,j}^{c

}|, & i \neq j \

\emptyset, & \text{otherwise}

\end{cases} \

b_{p+1,c,i}^{c

} &=

\begin{cases}

|u_{p+1,c,m}^{c

} - u_{p+1,c,n}^{c

}|, & m \neq n \

\emptyset, & \text{otherwise}

\end{cases} \

h_{p+1,c,i}^{c

} &=

\begin{cases}

\left| y_{p+1,c,i}^{c

} - \frac{v_{p+1,c,m}^{c

} + v_{p+1,c,n}^{c

}}{2} \right|, & F_{p+1}^c \neq \emptyset \land D_{p+1}^c \neq \emptyset \

\emptyset, & \text{otherwise}

\end{cases}

\end{aligned}

$$

其中,更新仅存在于两个分组的候选跟踪器之间,空集表示未执行更新。当前帧中这些更新后的车辆空间距离(p+1)随后被添加到过去p个连续帧的$ac,i

$、$bc,i

$和$hc,i*$中,用于后续的ODRAP处理。

i) 类内重建

在上述双向推理之后,$S_{p+1}^c$内的前大灯和尾灯的候选跟踪器被分组为一个车辆轮廓$R_{p+1}^c$,如(24)所示。然而,当某些车辆前灯或尾灯缺失时,例如i

=j

或m

=n

,双向推理无法重建这些缺失的车辆部件。在这种情况下,利用车辆几何互容性,并结合来自(15)的预测的车辆空间距离,来重建这些缺失的车辆组件。考虑到从(22)获得的跟踪器,这些缺失的车辆前灯或尾灯的类内重建可表示为:

$$

\begin{aligned}

\tilde{x}

{p+1,c,j}^{c

} &= x_{p+1,c,i}^{c

} + (\overrightarrow{\tilde{a}

{p+1,c,i}^{c

}} + \overleftarrow{\tilde{a}_{p+1,c,m}^{c

}} + \overleftarrow{\tilde{a}

{p+1,c,n}^{c

}}) \cos\alpha’/3 \

\tilde{y}_{p+1,c,j}^{c

} &= y

{p+1,c,i}^{c

} + (\overrightarrow{\tilde{a}_{p+1,c,i}^{c

}} + \overleftarrow{\tilde{a}

{p+1,c,m}^{c

}} + \overleftarrow{\tilde{a}_{p+1,c,n}^{c

}}) \sin\alpha’/3 \

\tilde{u}

{p+1,c,n}^{c

} &= u_{p+1,c,m}^{c

} + (\overleftarrow{\tilde{b}

{p+1,c,m}^{c

}} + \overrightarrow{\tilde{b}_{p+1,c,i}^{c

}} + \overrightarrow{\tilde{b}

{p+1,c,j}^{c

}}) \cos\alpha’/3 \

\tilde{v}_{p+1,c,n}^{c

} &= v_{p+1,c,m}

1218

1218

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?