温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

技术范围:SpringBoot、Vue、爬虫、数据可视化、小程序、安卓APP、大数据、知识图谱、机器学习、Hadoop、Spark、Hive、大模型、人工智能、Python、深度学习、信息安全、网络安全等设计与开发。

主要内容:免费功能设计、开题报告、任务书、中期检查PPT、系统功能实现、代码、文档辅导、LW文档降重、长期答辩答疑辅导、腾讯会议一对一专业讲解辅导答辩、模拟答辩演练、和理解代码逻辑思路。

🍅文末获取源码联系🍅

🍅文末获取源码联系🍅

🍅文末获取源码联系🍅

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及LW文档编写等相关问题都可以给我留言咨询,希望帮助更多的人

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

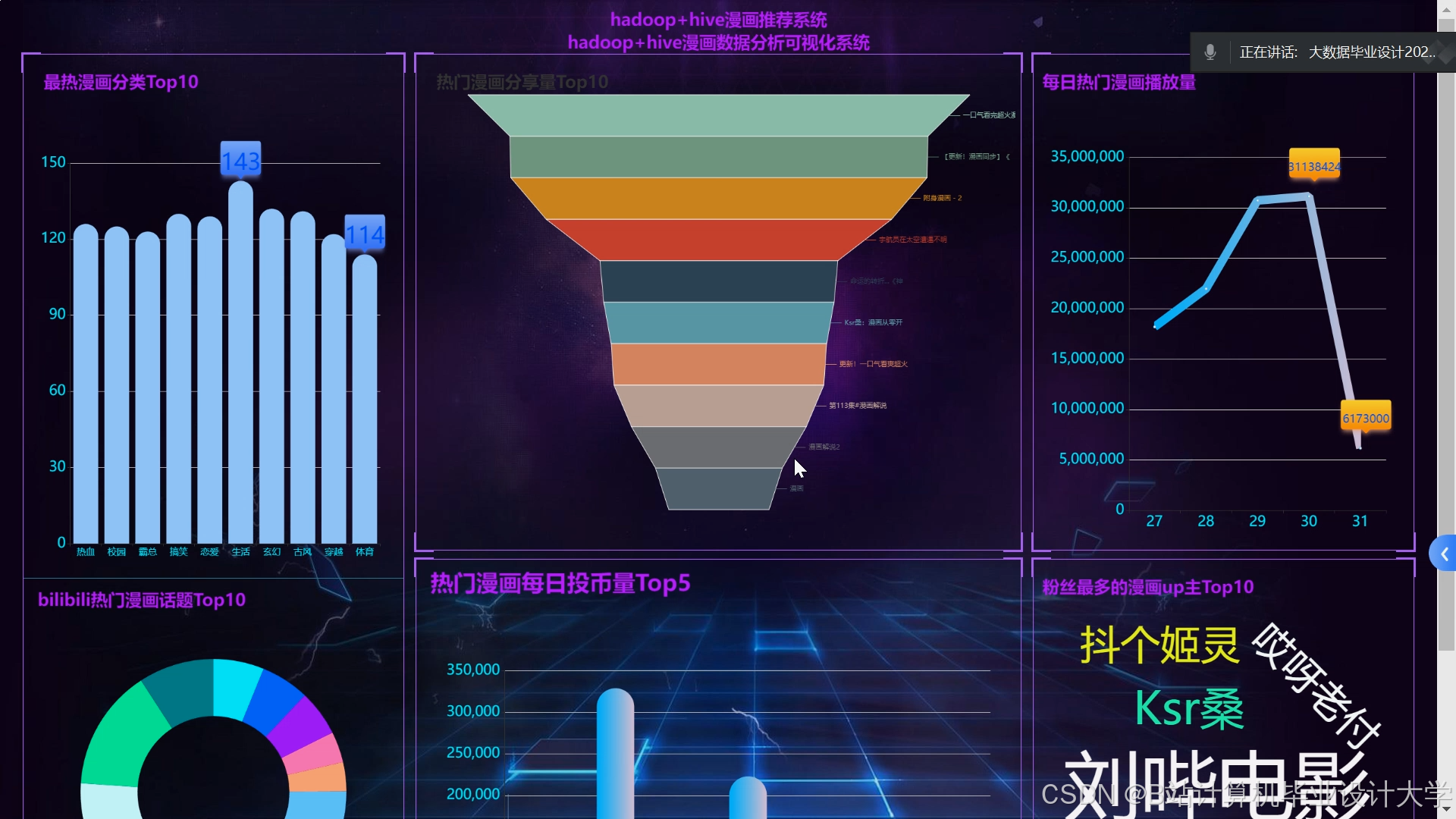

以下是一份关于《Hadoop+Spark+Hive动漫推荐系统(漫画推荐系统)》的任务书模板,结合大数据处理与推荐算法设计,供参考:

任务书:Hadoop+Spark+Hive动漫推荐系统(漫画推荐系统)

一、项目背景

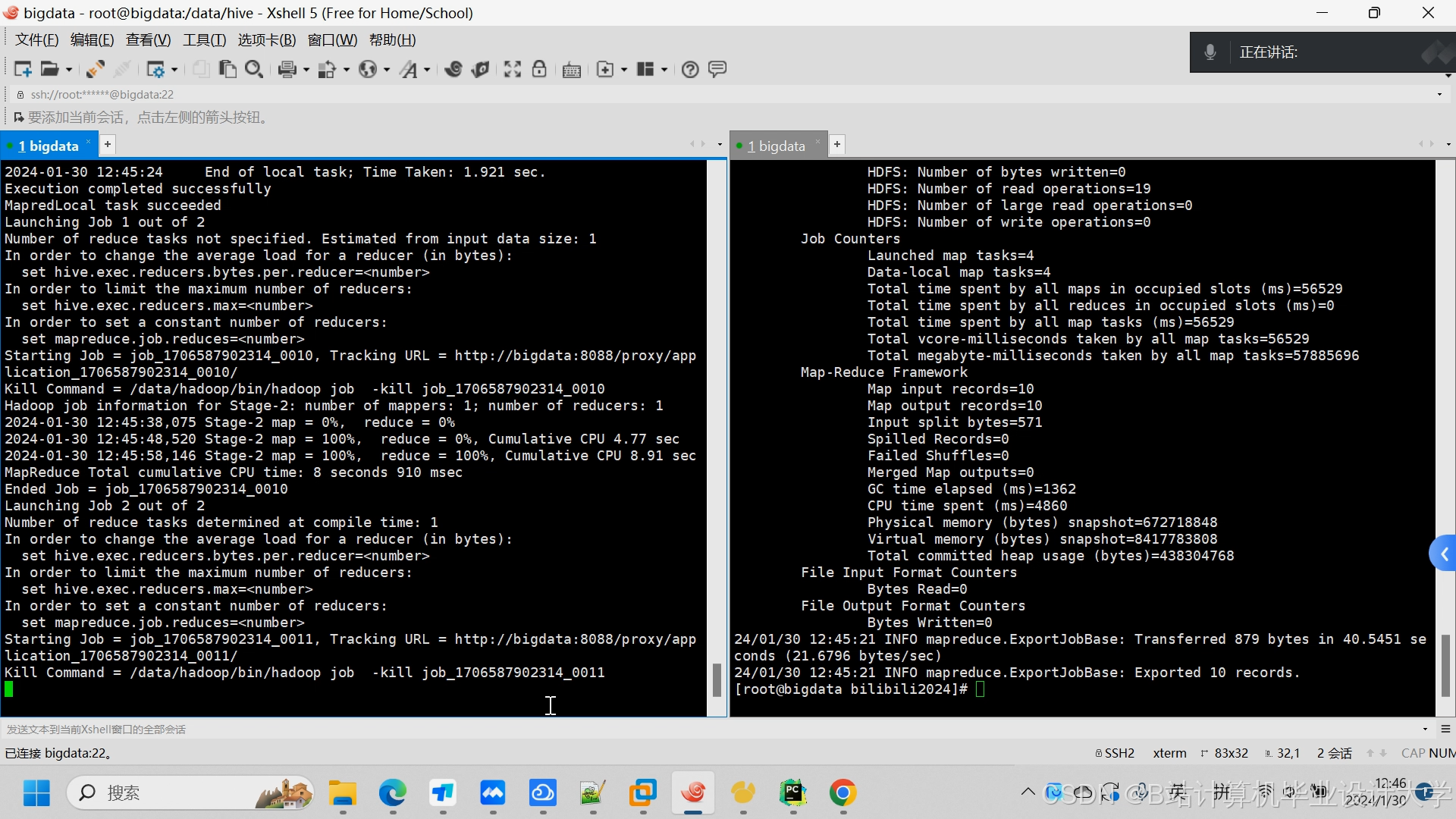

随着动漫(漫画)平台的用户规模和内容库快速增长,用户面临“信息过载”问题,传统推荐方式(如热门推荐、分类浏览)难以满足个性化需求。本项目基于Hadoop生态体系(Hadoop+Spark+Hive),结合协同过滤、内容分析等算法,构建一套高效、可扩展的动漫推荐系统,实现用户兴趣匹配与实时推荐,提升用户体验和平台活跃度。

二、项目目标

- 数据存储与处理:利用Hadoop HDFS存储海量用户行为数据(点击、收藏、评分)和漫画元数据(标题、标签、作者、画风)。

- 离线分析:通过Hive构建数据仓库,完成用户画像构建、漫画特征提取、历史行为分析。

- 实时推荐:基于Spark Streaming处理用户实时行为,动态调整推荐结果(如“猜你喜欢”“实时热门”)。

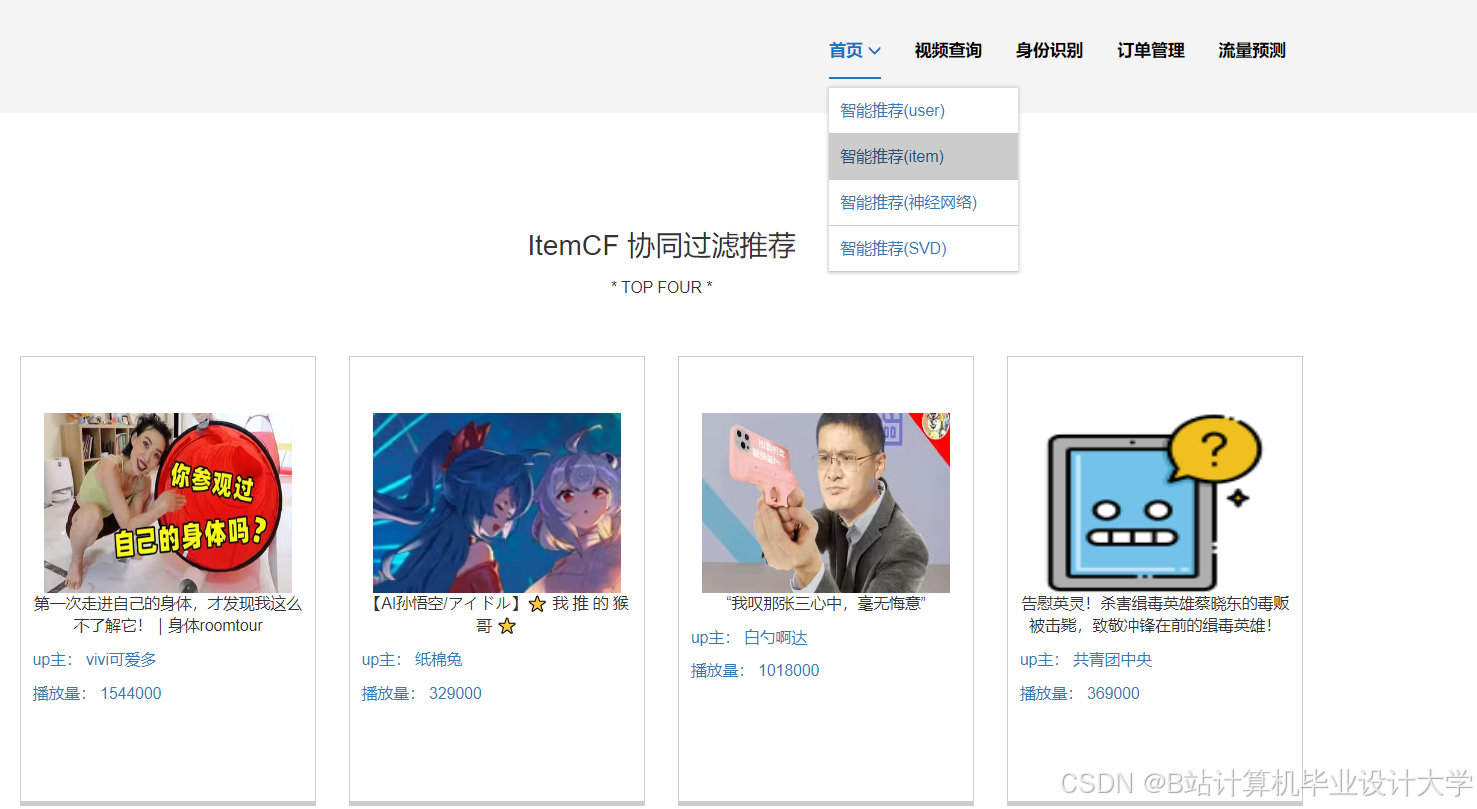

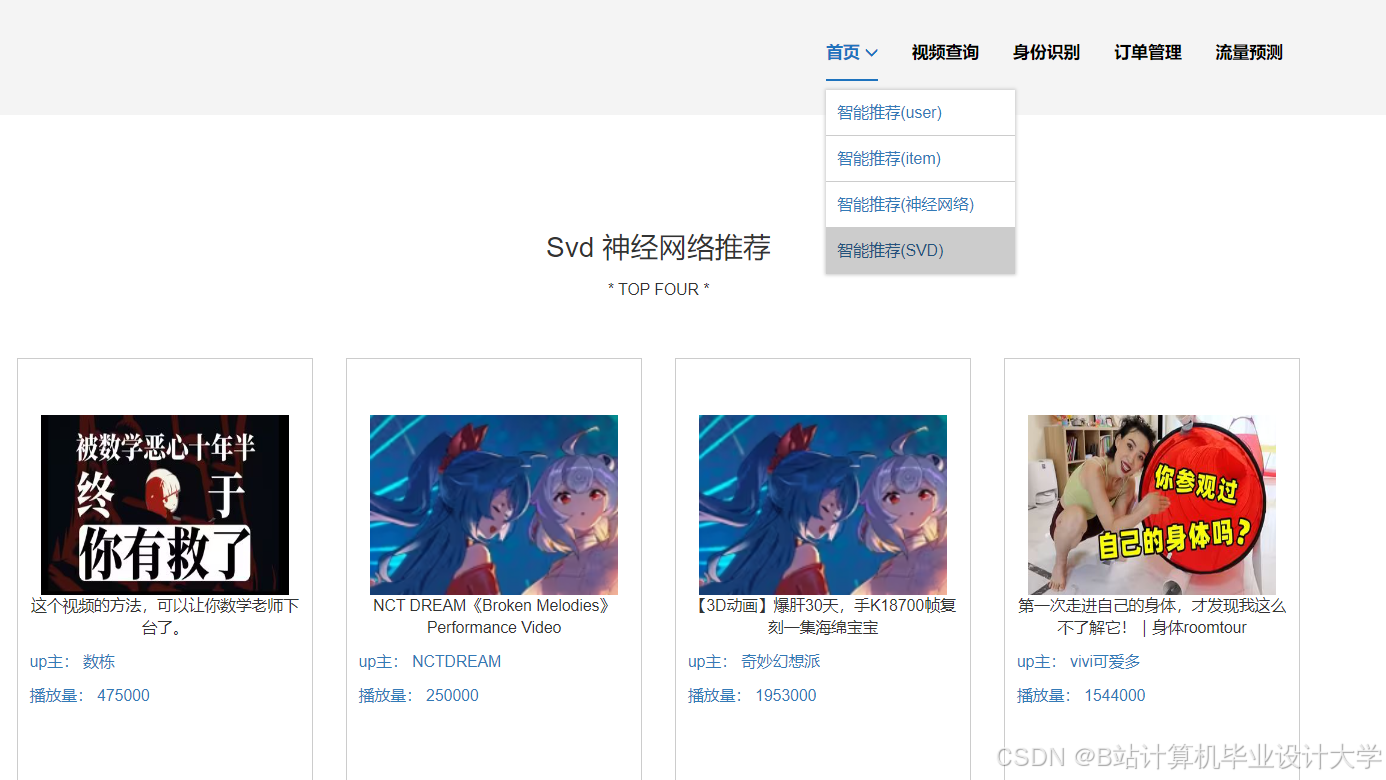

- 混合推荐引擎:结合协同过滤(User-based/Item-based)和内容相似度算法,生成个性化推荐列表。

- 可视化与评估:开发推荐效果监控仪表盘,支持A/B测试和模型调优。

三、任务分工与职责

1. 数据采集与预处理团队

- 任务:

- 设计数据采集方案(埋点日志、数据库同步、第三方API)。

- 清洗原始数据(处理异常值、标准化标签、去重)。

- 将数据导入HDFS,划分训练集与测试集。

- 交付物:数据采集脚本、清洗规则文档、初始数据集。

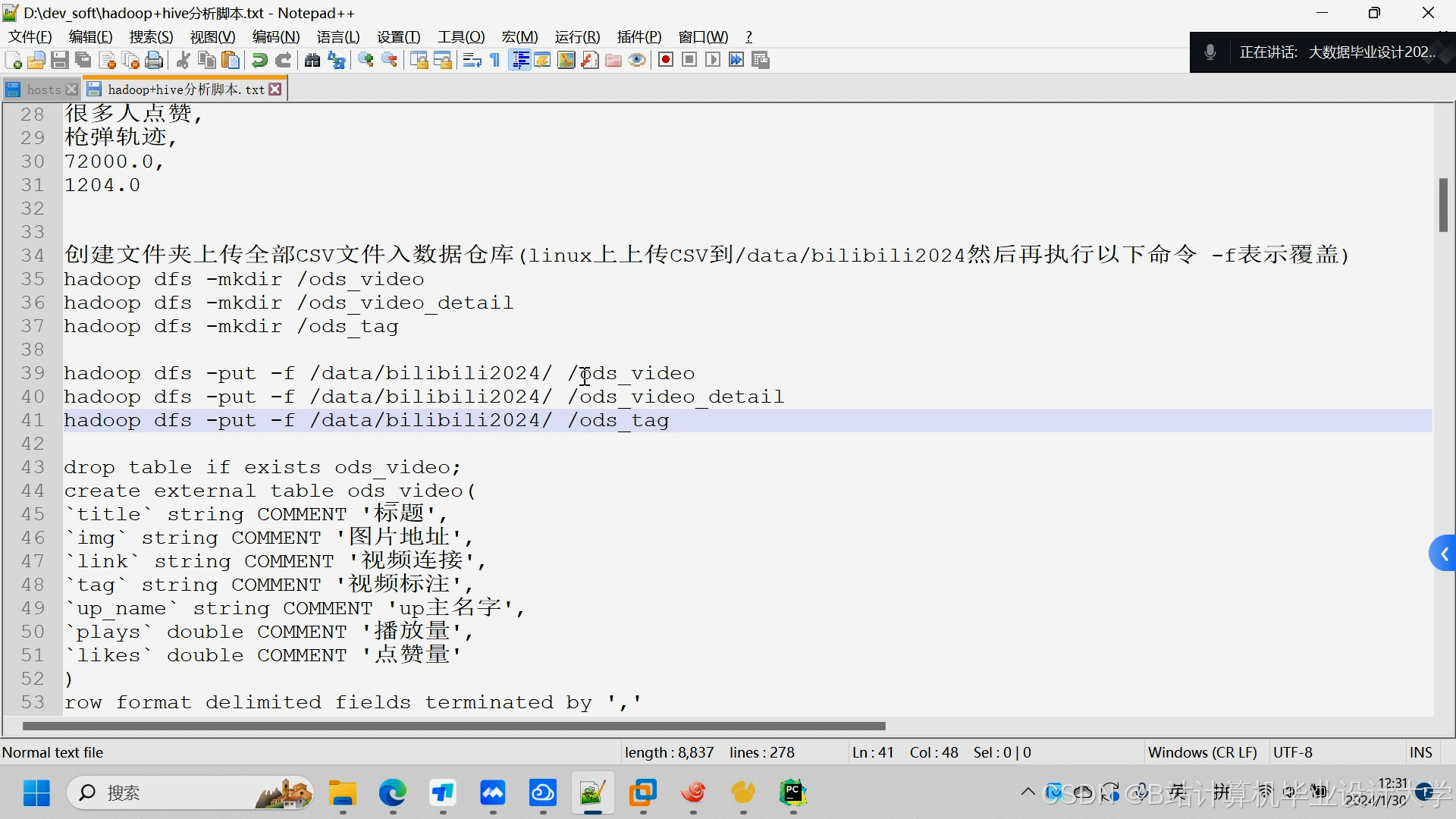

2. Hadoop集群与Hive数据仓库团队

- 任务:

- 部署Hadoop集群(HDFS+YARN),配置存储与计算资源。

- 基于Hive设计数据仓库分层模型(ODS→DWD→DWS→ADS)。

- 编写HiveQL脚本生成用户画像(如年龄、性别、偏好标签)和漫画特征(如风格、主题、热度)。

- 交付物:集群部署文档、数据仓库设计图、Hive脚本。

3. Spark推荐算法开发团队

- 任务:

- 离线推荐:

- 实现基于Spark MLlib的协同过滤算法(ALS)。

- 开发内容相似度模型(TF-IDF/Word2Vec提取漫画标签向量)。

- 实时推荐:

- 利用Spark Streaming处理用户实时行为(如新收藏漫画),触发推荐更新。

- 集成Redis缓存热门推荐结果,降低延迟。

- 离线推荐:

- 交付物:推荐算法代码、模型训练报告、实时处理逻辑文档。

4. 系统集成与接口开发团队

- 任务:

- 开发推荐服务API(RESTful接口),供前端调用。

- 实现推荐结果与漫画详情页的联动(如“看过该漫画的用户还喜欢”)。

- 集成A/B测试框架,对比不同推荐策略的效果。

- 交付物:API文档、接口测试报告、A/B测试方案。

5. 可视化与评估团队

- 任务:

- 使用Superset/Grafana开发推荐效果监控面板(点击率、转化率、用户留存)。

- 设计评估指标(如精准率、召回率、NDCG),定期生成分析报告。

- 根据反馈优化推荐策略(如调整权重、过滤低质量漫画)。

- 交付物:可视化原型图、评估报告、优化建议文档。

6. 测试与运维团队

- 任务:

- 制定测试计划(单元测试、集成测试、压力测试)。

- 监控集群资源使用情况,处理故障(如数据倾斜、内存溢出)。

- 编写运维手册,制定数据备份与恢复策略。

- 交付物:测试报告、运维日志、系统部署文档。

四、技术栈

- 存储层:Hadoop HDFS

- 计算层:Spark Core + Spark SQL + Spark Streaming + MLlib

- 数据仓库:Hive

- 缓存与消息队列:Redis + Kafka(可选)

- 可视化:Superset/ECharts

- 开发语言:Scala/Python + Java

- 版本控制:Git

五、时间计划

| 阶段 | 时间 | 里程碑 |

|---|---|---|

| 需求分析与设计 | 第1-2周 | 完成数据模型设计、推荐算法选型 |

| 环境搭建与开发 | 第3-5周 | 集群部署、核心模块开发(Hive/Spark) |

| 算法训练与测试 | 第6-7周 | 离线模型训练、实时推荐逻辑验证 |

| 系统集成与优化 | 第8周 | API对接、可视化开发、性能调优 |

| 交付与验收 | 第9周 | 上线试运行、用户反馈收集、项目验收 |

六、验收标准

- 功能完整性:

- 支持至少3种推荐场景(个性化推荐、热门推荐、相似漫画推荐)。

- 实时推荐延迟≤1秒,离线推荐任务完成时间≤10分钟(百万级数据)。

- 推荐效果:

- 精准率≥30%,召回率≥50%(基于测试集评估)。

- 用户点击率(CTR)提升≥15%(对比基准策略)。

- 系统性能:

- 集群吞吐量≥10万条/小时(用户行为日志处理)。

- 高可用性:支持节点故障自动恢复。

- 文档完备性:

- 包含设计文档、用户手册、运维指南、测试报告。

七、风险评估与应对

- 数据稀疏性:采用混合推荐(协同过滤+内容分析)缓解冷启动问题。

- 算法偏差:定期更新模型,引入多样性控制(如推荐结果去重、覆盖更多类别)。

- 集群性能瓶颈:优化Spark分区数、调整Executor内存配置。

项目负责人(签字):

日期:

此任务书可根据实际业务需求调整,例如增加用户反馈机制(如“不喜欢”按钮)或扩展推荐维度(如社交关系链分析)。

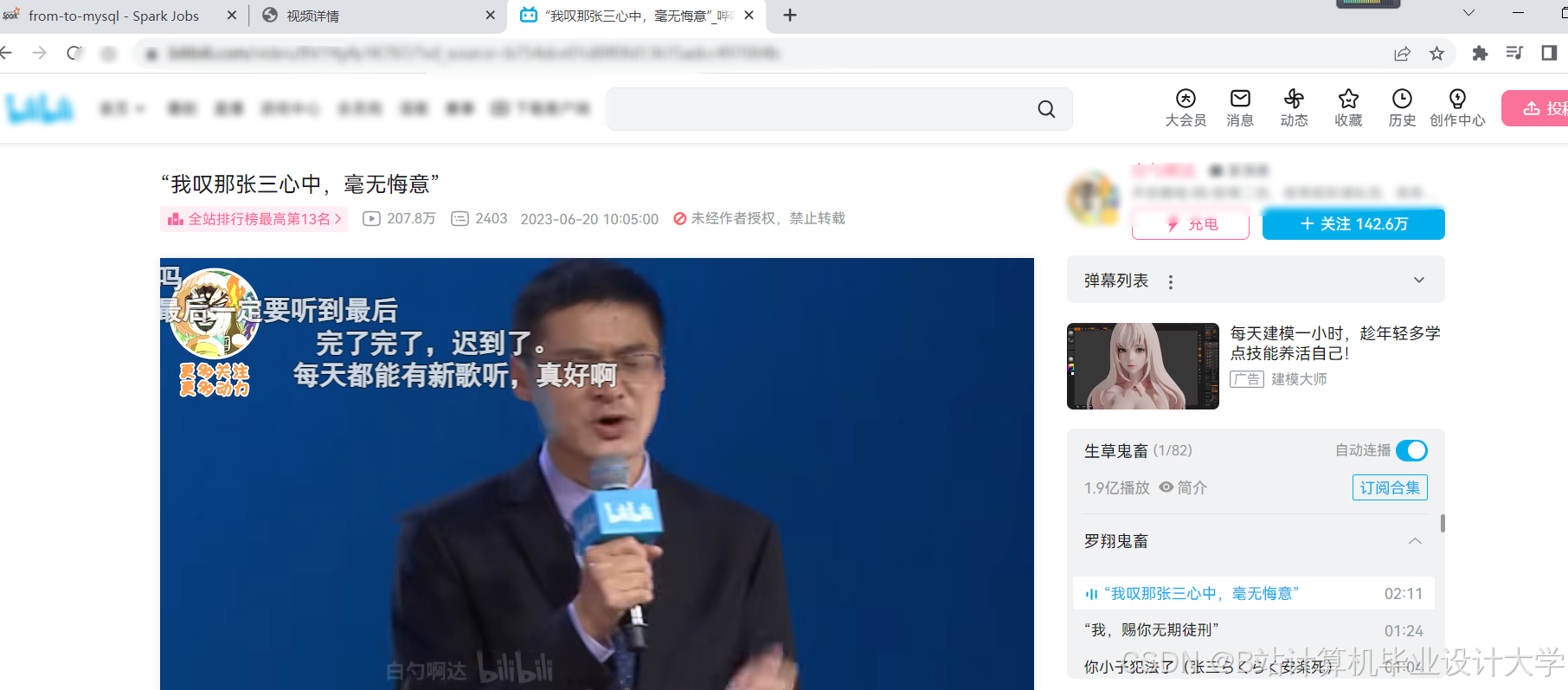

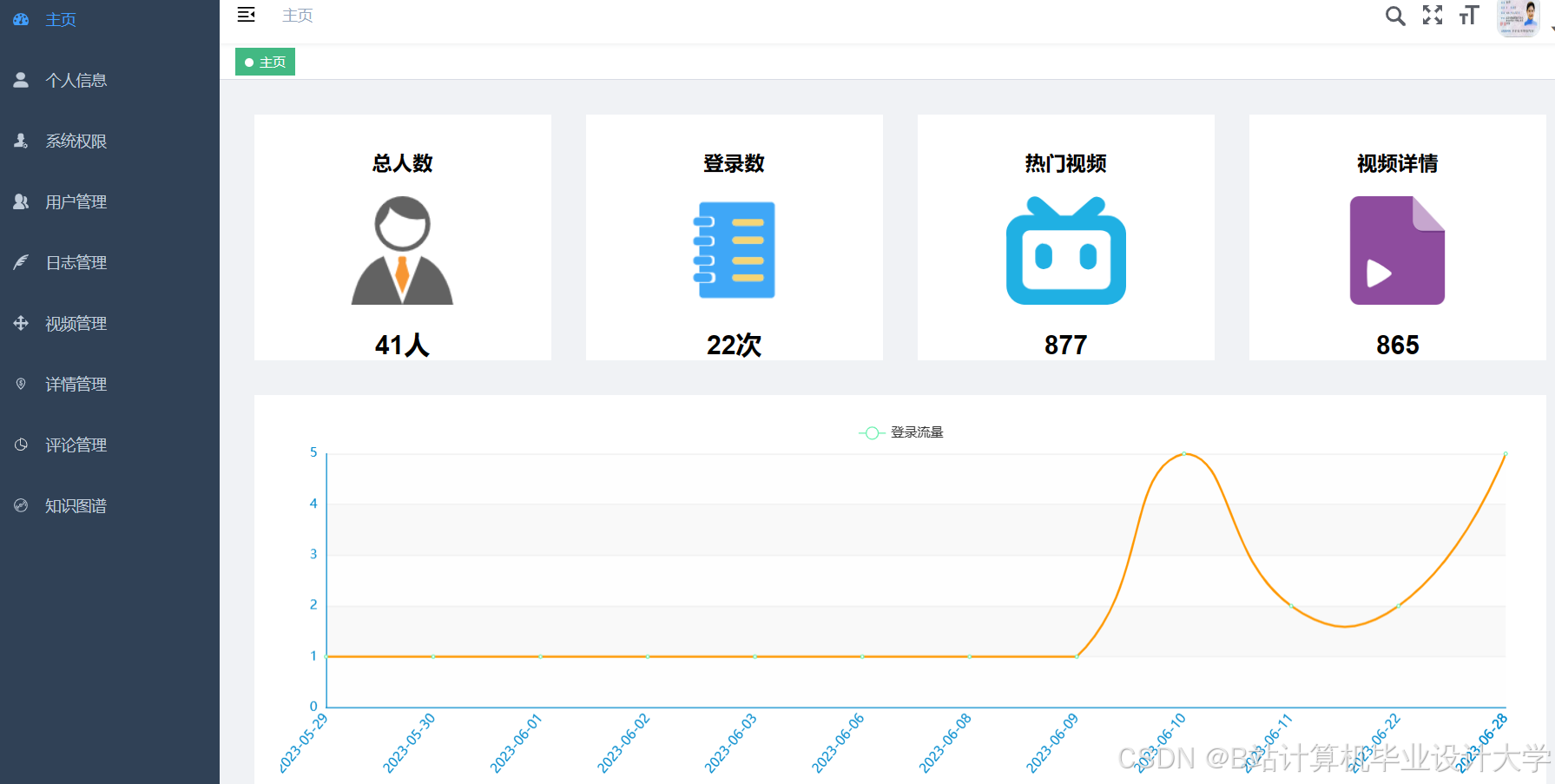

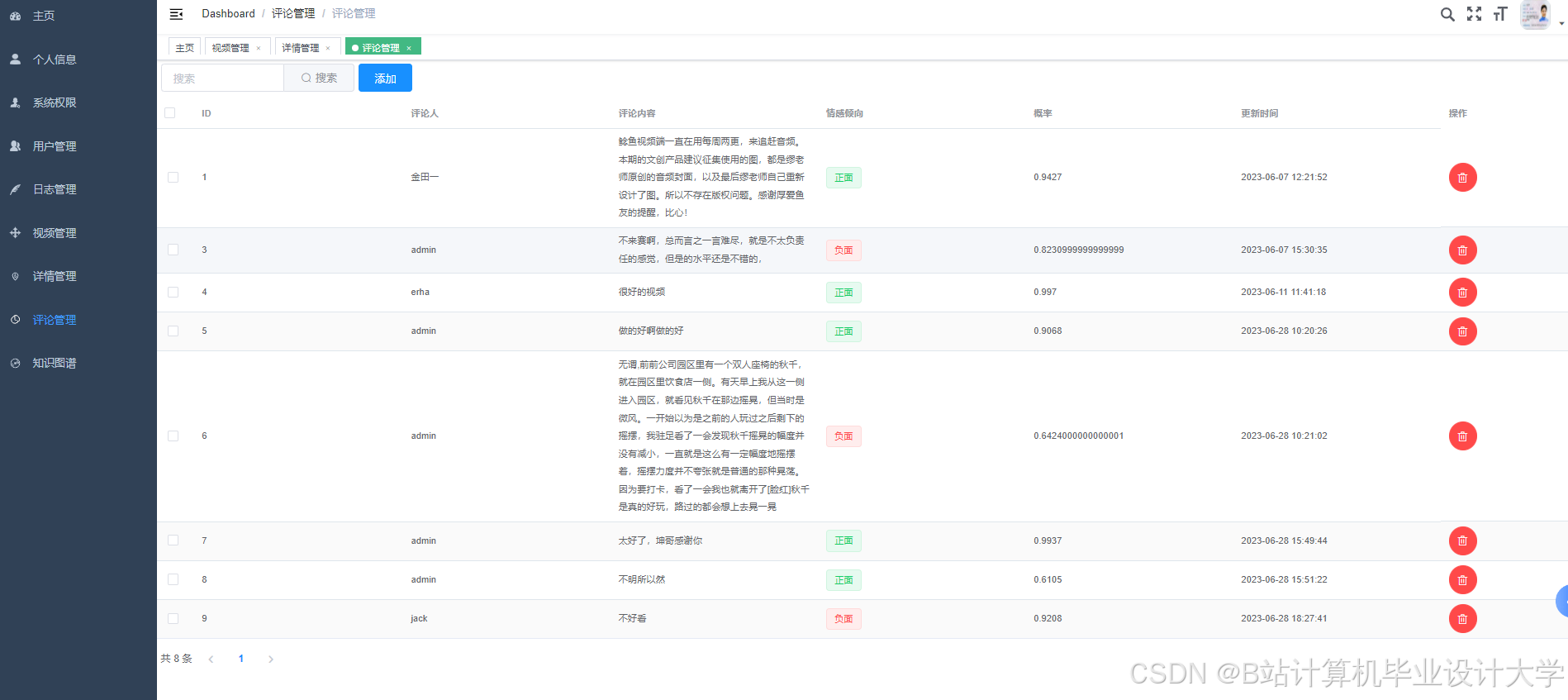

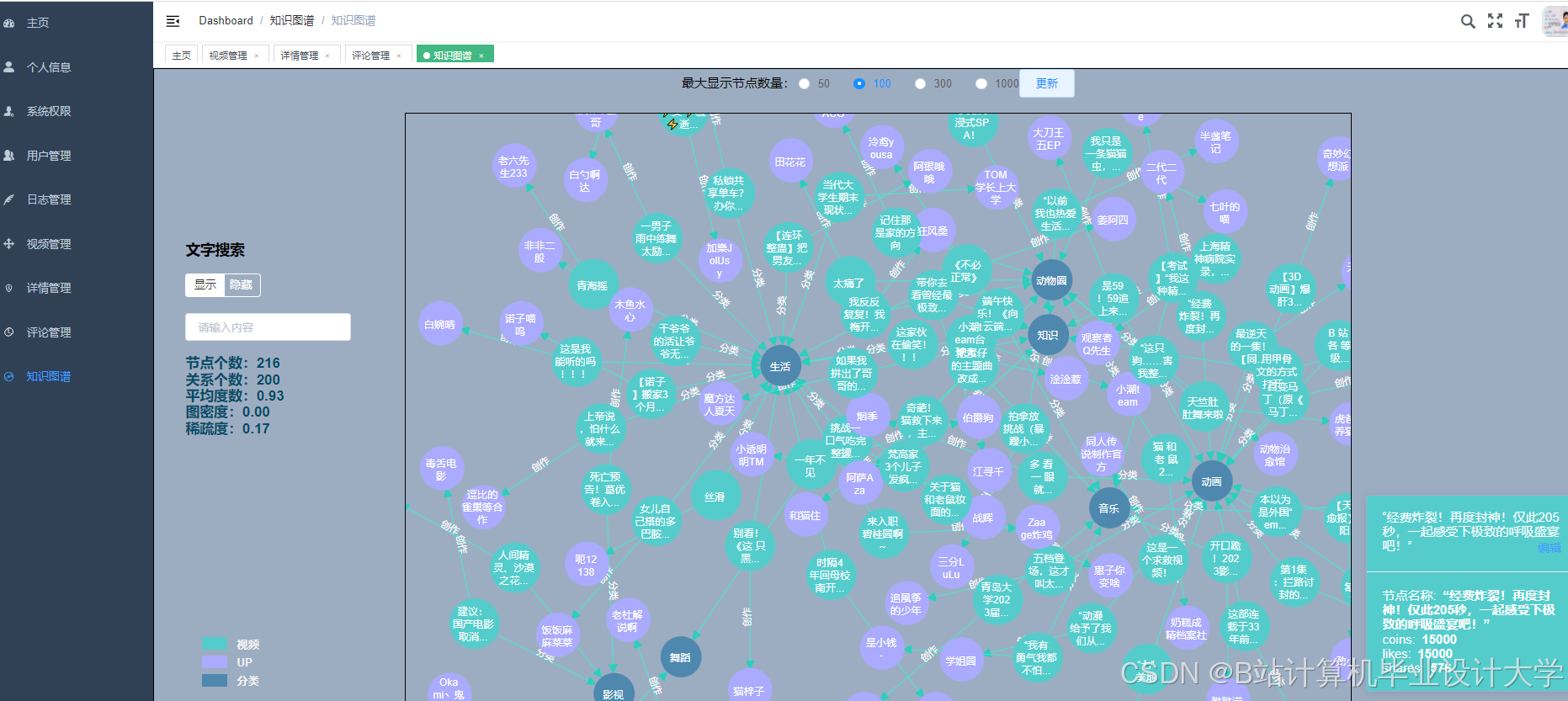

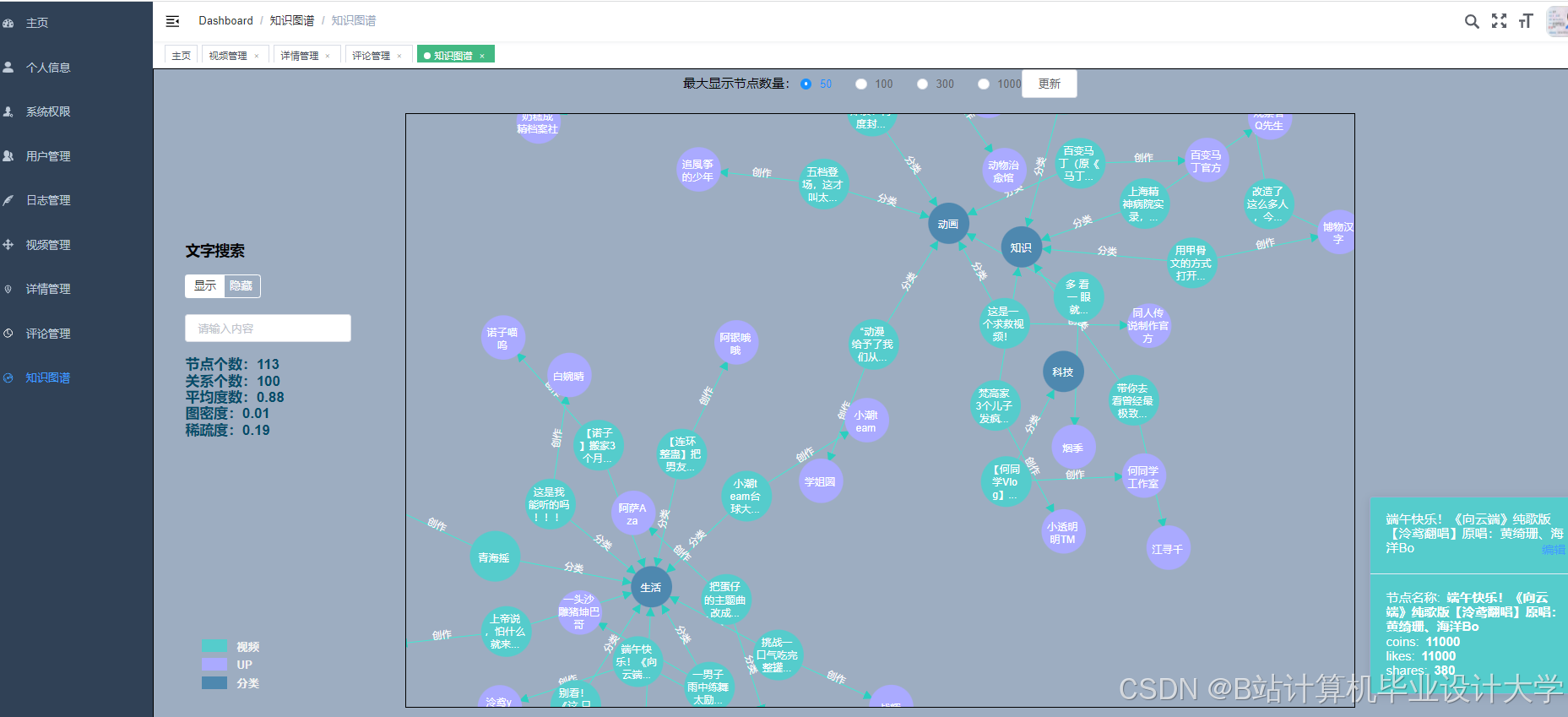

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

为什么选择我

博主是优快云毕设辅导博客第一人兼开派祖师爷、博主本身从事开发软件开发、有丰富的编程能力和水平、累积给上千名同学进行辅导、全网累积粉丝超过50W。是优快云特邀作者、博客专家、新星计划导师、Java领域优质创作者,博客之星、掘金/华为云/阿里云/InfoQ等平台优质作者、专注于Java技术领域和学生毕业项目实战,高校老师/讲师/同行前辈交流和合作。

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查↓↓↓↓↓↓获取联系方式↓↓↓↓↓↓↓↓

1250

1250

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?