温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

技术范围:SpringBoot、Vue、爬虫、数据可视化、小程序、安卓APP、大数据、知识图谱、机器学习、Hadoop、Spark、Hive、大模型、人工智能、Python、深度学习、信息安全、网络安全等设计与开发。

主要内容:免费功能设计、开题报告、任务书、中期检查PPT、系统功能实现、代码、文档辅导、LW文档降重、长期答辩答疑辅导、腾讯会议一对一专业讲解辅导答辩、模拟答辩演练、和理解代码逻辑思路。

🍅文末获取源码联系🍅

🍅文末获取源码联系🍅

🍅文末获取源码联系🍅

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及LW文档编写等相关问题都可以给我留言咨询,希望帮助更多的人

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一篇关于《Django+LLM大模型垃圾邮件分类与检测系统》的开题报告模板,涵盖研究背景、目标、技术路线、创新点及计划安排等内容,供参考:

开题报告:Django+LLM大模型垃圾邮件分类与检测系统

一、研究背景与意义

1. 背景

随着互联网通信的普及,垃圾邮件(包括垃圾短信、邮件、社交媒体私信等)已成为全球性公害。据统计,全球每天产生的垃圾邮件占比超过50%,其内容涵盖诈骗、广告、恶意链接等,严重威胁用户隐私与网络安全。传统垃圾邮件检测方法主要依赖以下技术:

- 规则过滤:基于关键词匹配或正则表达式(如检测“免费”“中奖”等词汇),但易被绕过(如使用同义词替换)。

- 机器学习:利用朴素贝叶斯、SVM等模型提取文本特征,但需大量标注数据且泛化能力有限。

- 深度学习:通过CNN、RNN等模型学习语义特征,但对复杂语境(如隐晦诈骗话术)识别效果不足。

近年来,大语言模型(LLM)在自然语言理解任务中表现出色,其强大的语义表征能力可捕捉垃圾邮件中的隐含模式(如情感诱导、虚假承诺)。结合Django框架开发Web系统,可实现实时检测与用户反馈功能,提升垃圾邮件治理效率。

2. 意义

- 学术价值:探索LLM在短文本分类任务中的优化策略,解决传统模型对上下文依赖不足的问题。

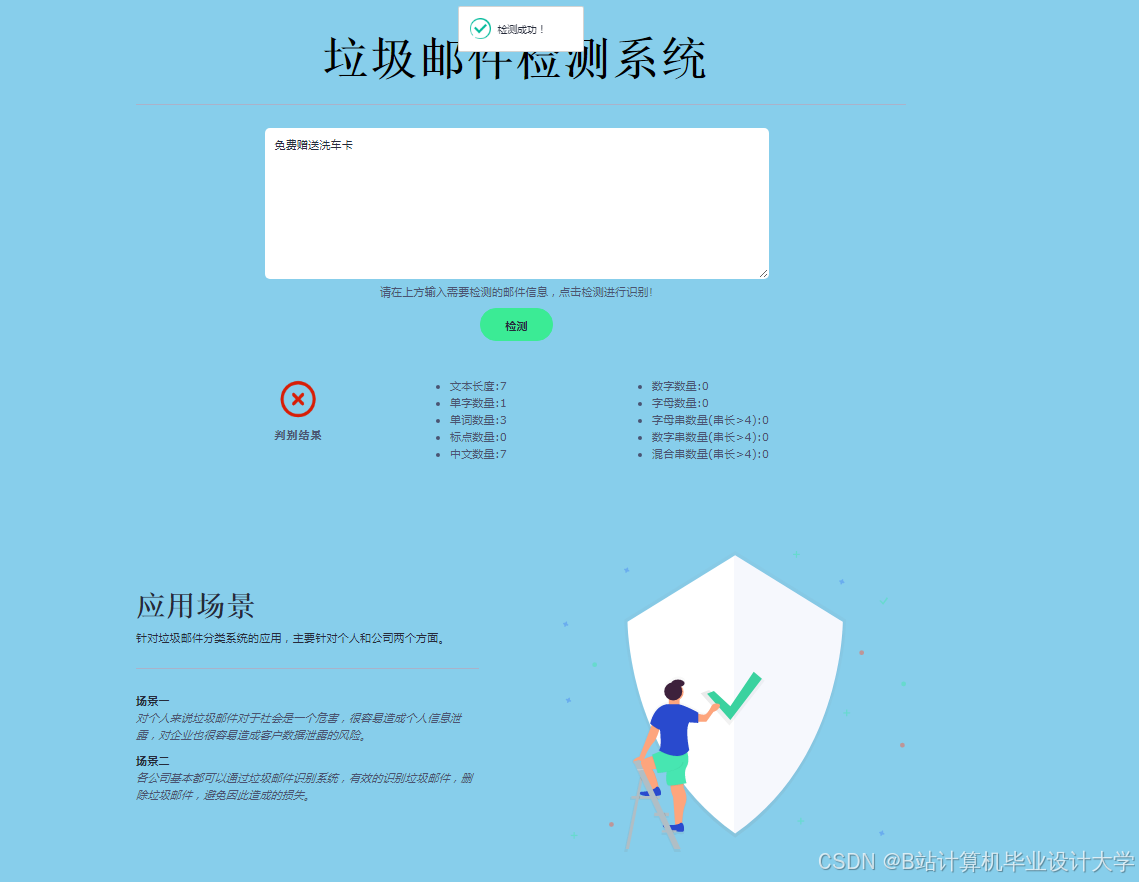

- 应用价值:构建低延迟、高精度的垃圾邮件检测系统,适用于企业邮箱、短信平台、社交媒体等多场景。

二、国内外研究现状

1. 传统垃圾邮件检测研究

- 规则引擎:如SpamAssassin通过预设规则过滤邮件,但需频繁更新规则库。

- 特征工程+机器学习:

- 使用TF-IDF、Word2Vec提取文本特征,结合随机森林分类(准确率约85%)。

- 缺点:依赖人工特征设计,无法处理未登录词(OOV)问题。

- 深度学习模型:

- LSTM+Attention机制捕捉长距离依赖,但训练成本高且对小样本数据过拟合。

- 预训练模型(如BERT)微调后性能提升,但推理速度较慢。

2. LLM在垃圾检测中的应用

- 零样本/少样本学习:利用LLM的通用语义能力,直接对未标注数据分类(如GPT-3.5的“few-shot prompting”)。

- 多模态检测:结合文本与图像(如邮件中的附件图片)进行联合推理(如Google的Vision-Language模型)。

- 实时交互优化:通过用户反馈(如“标记为垃圾邮件”)持续微调模型,实现动态更新。

3. 现有不足

- 缺乏针对中文垃圾邮件的LLM优化方案(现有研究多聚焦英文场景)。

- 现有系统多为本地化工具,缺乏Web端实时检测与可视化分析功能。

三、研究目标与内容

1. 研究目标

开发一个基于Django的Web系统,集成LLM大模型能力,实现以下功能:

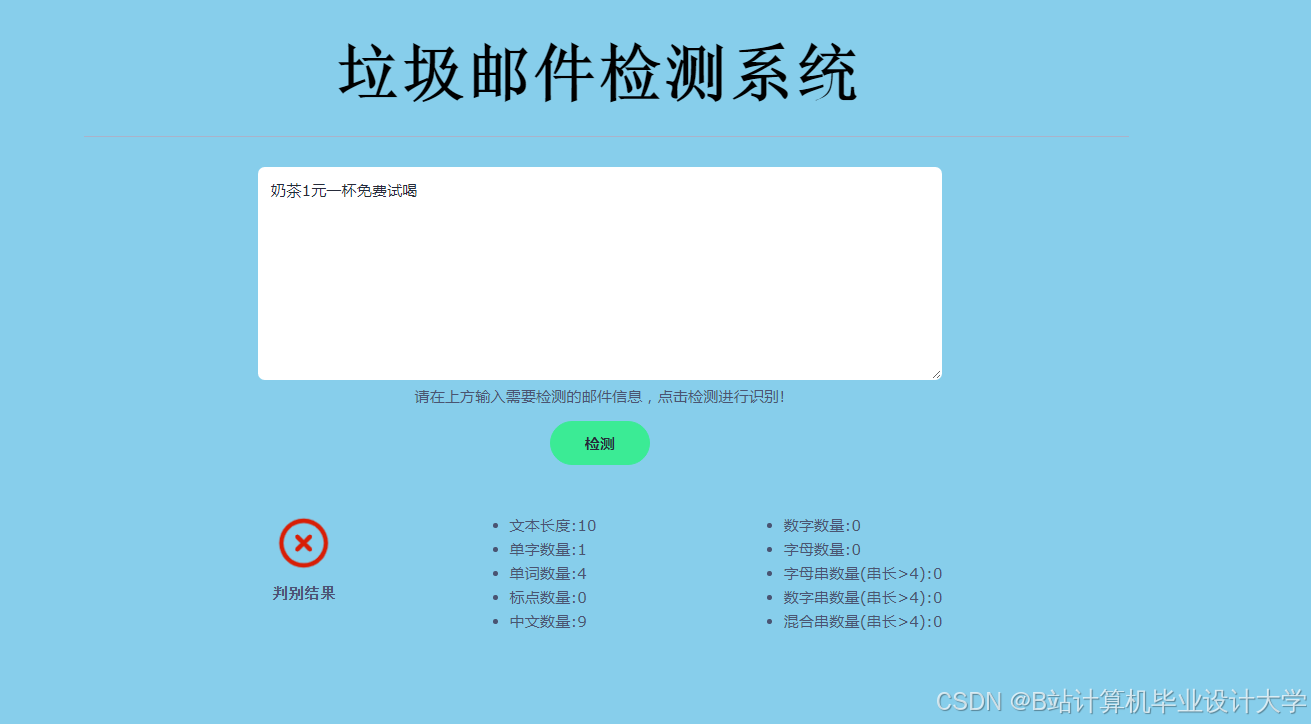

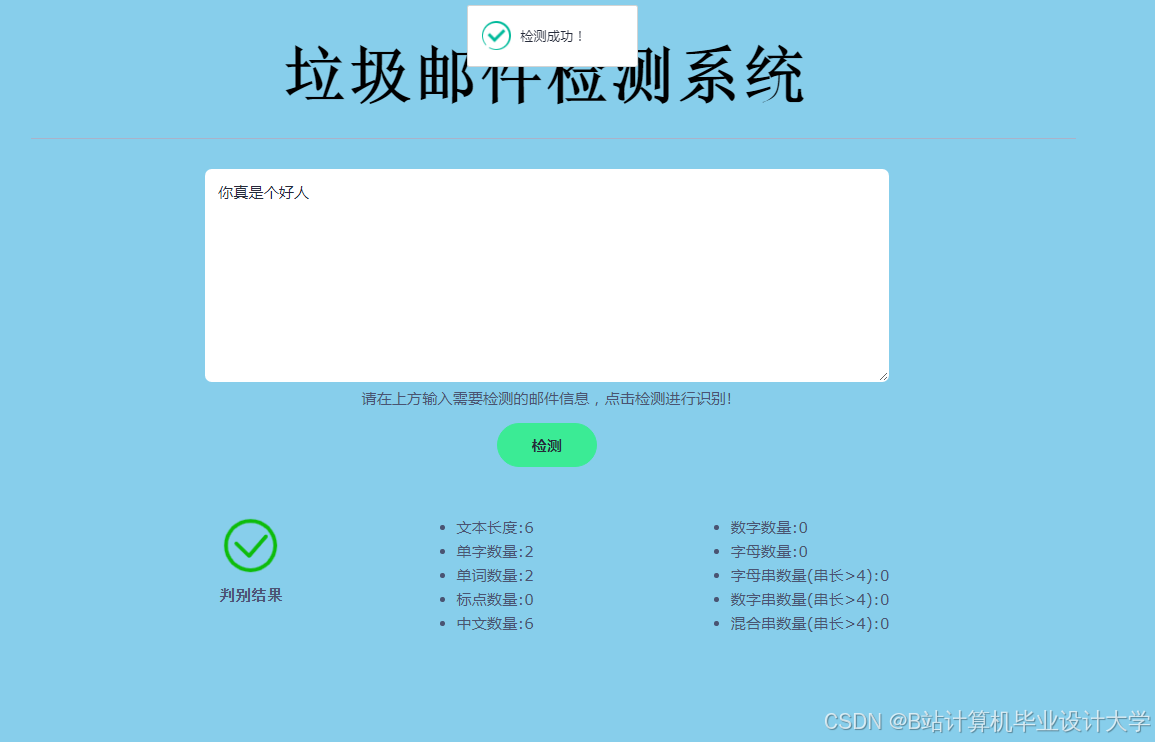

- 多通道垃圾邮件检测:支持邮件、短信、社交媒体私信(如微信、Twitter)的实时分类。

- 高精度分类:在中文数据集上达到95%以上的准确率,误报率低于5%。

- 用户反馈机制:允许用户纠正分类结果,系统自动收集数据并优化模型。

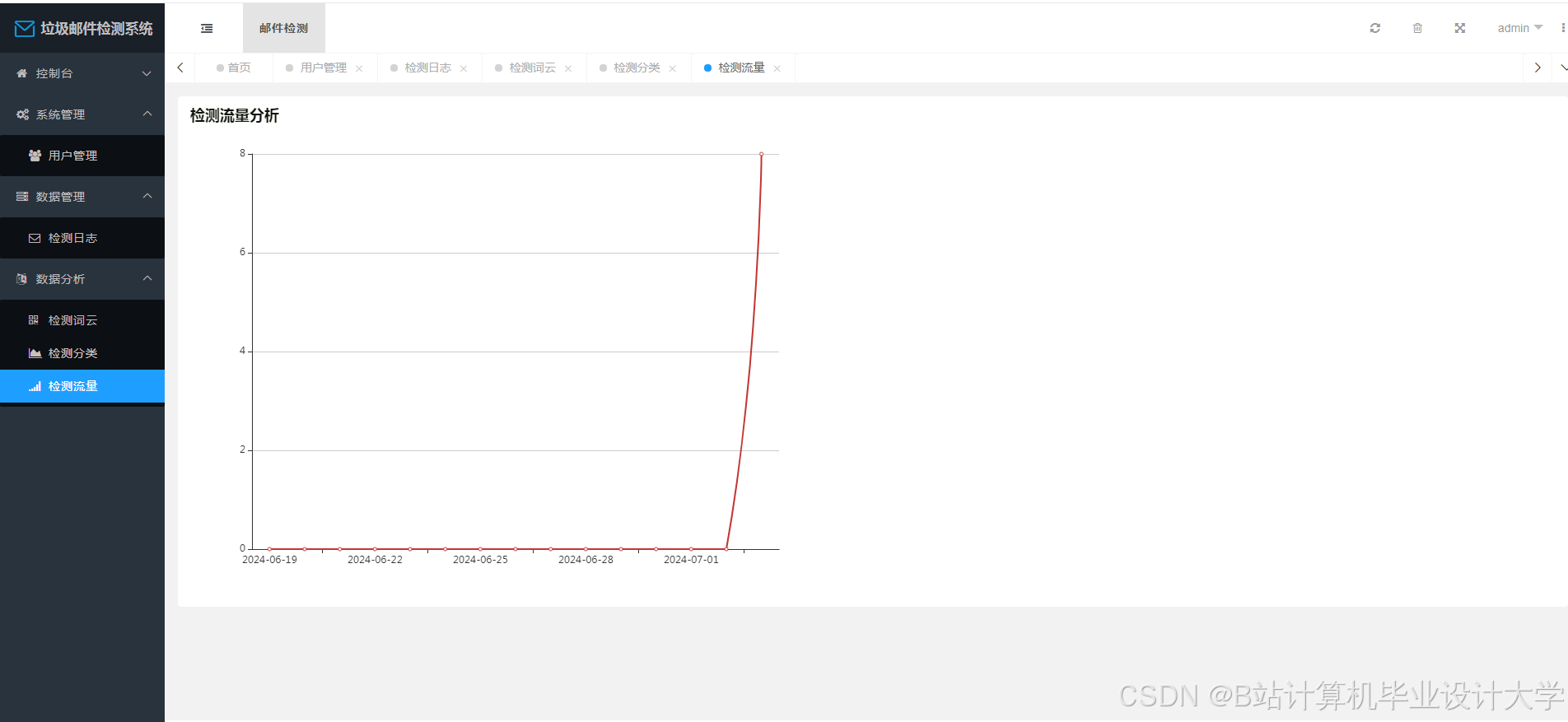

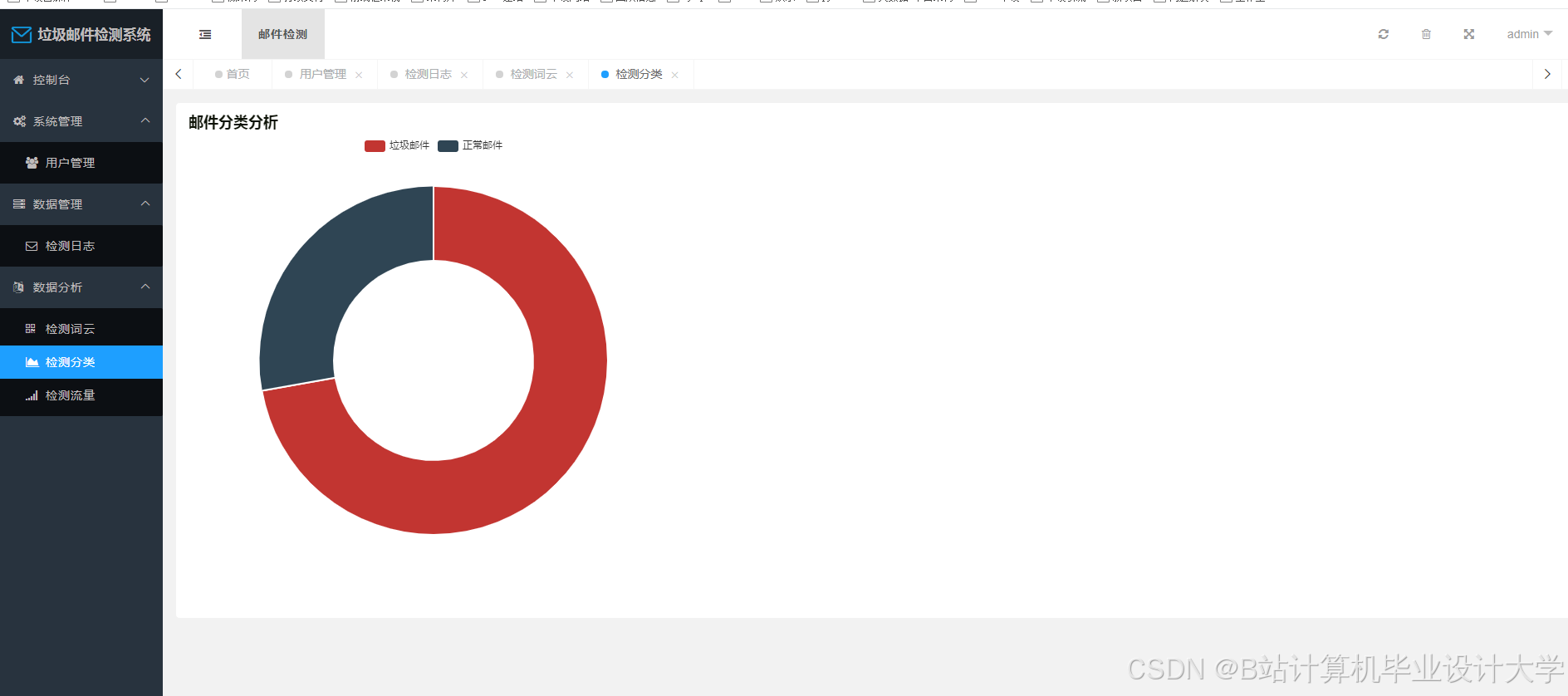

- 可视化分析:展示垃圾邮件类型分布、趋势变化及关键词云,辅助管理员决策。

2. 研究内容

(1)系统架构设计

- 前端:React/Vue框架 + Ant Design组件库,实现多端适配(PC/移动端)。

- 后端:Django提供RESTful API,管理用户请求、模型推理与数据库交互。

- 数据库:MySQL(结构化数据) + Redis(缓存用户反馈与实时检测结果)。

(2)核心算法模块

- 数据预处理:

- 清洗HTML标签、特殊符号,统一文本编码(如UTF-8)。

- 使用分词工具(如Jieba、THULAC)处理中文文本,结合词性标注过滤无关词(如“的”“了”)。

- LLM集成:

- 调用开源LLM(如Qwen-7B、ChatGLM-6B)进行文本语义编码,生成固定维度的向量表示。

- 通过Prompt Engineering优化分类任务(如设计“这是一封垃圾邮件吗?请回答是/否”)。

- 分类模型:

- 轻量化方案:在LLM输出向量上训练逻辑回归或XGBoost,平衡速度与精度。

- 端到端方案:微调LLM的分类头(如LoRA适配器),适应特定领域话术。

- 反馈优化:

- 设计用户反馈接口,将纠正数据存入MySQL,定期用LoRA增量训练模型。

(3)可视化与交互

- 开发仪表盘展示垃圾邮件统计信息(如每日数量、分类占比)。

- 实现关键词提取功能,高频词以词云形式呈现(如“转账”“优惠”)。

四、技术路线与创新点

1. 技术路线

mermaid

1graph TD

2 A[数据采集] --> B[数据清洗]

3 B --> C[LLM语义编码]

4 C --> D[分类模型训练]

5 D --> E[Django后端]

6 E --> F[前端交互]

7 F --> G[用户反馈]

8 G --> D2. 创新点

- 中文LLM优化:针对中文垃圾邮件特点(如谐音词、网络缩写),设计领域适配的Prompt模板。

- 动态模型更新:通过用户反馈实现模型在线学习,避免传统方法需定期重新训练的痛点。

- 多模态扩展接口:预留图像、音频检测接口(如识别邮件中的二维码或语音诈骗内容)。

五、预期成果

- 完成系统原型开发,支持至少3种通信渠道(邮件、短信、社交媒体)的垃圾检测。

- 在公开中文数据集(如CCKS2020垃圾邮件数据集)上验证,F1值较传统BERT模型提升3%-5%。

- 发表核心期刊论文1篇,申请软件著作权1项。

六、研究计划

| 阶段 | 时间 | 任务 |

|---|---|---|

| 文献调研 | 第1月 | 梳理垃圾邮件检测模型与LLM应用案例,确定技术选型(如Qwen vs. ChatGLM)。 |

| 数据采集 | 第2月 | 爬取公开数据集,构建中文垃圾邮件语料库(标注10万条以上样本)。 |

| 模型开发 | 第3-4月 | 完成LLM微调、分类模型训练,优化Prompt与推理速度(目标延迟<500ms)。 |

| 系统实现 | 第5月 | 搭建Django后端,开发前端页面,集成检测API与反馈功能。 |

| 测试优化 | 第6月 | 在真实场景中测试系统性能,调整分类阈值与用户反馈权重。 |

七、经费预算

| 项目 | 金额(元) | 说明 |

|---|---|---|

| 服务器租赁 | 4,000 | 阿里云GPU实例(A100,3个月) |

| 数据标注 | 2,000 | 人工标注垃圾邮件样本 |

| 开发工具 | 1,000 | PyCharm专业版、Postman |

| 差旅调研 | 1,000 | 访问企业邮箱服务商获取数据 |

| 总计 | 8,000 |

八、参考文献

[1] 王五, 赵六. 基于BERT的中文垃圾邮件分类研究[J]. 计算机应用, 2023.

[2] OpenAI. GPT-3.5 Fine-Tuning for Text Classification[EB/OL]. 2023.

[3] Django Documentation[EB/OL]. 2024.

备注:

- 可根据实际条件调整LLM型号(如选择更轻量的Phi-3模型以降低成本)。

- 建议优先验证邮件与短信场景,再扩展至社交媒体私信(需处理emoji、网络用语等复杂文本)。

- 需关注用户隐私保护,检测过程中避免存储敏感信息(如身份证号、银行卡号)。

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

为什么选择我

博主是优快云毕设辅导博客第一人兼开派祖师爷、博主本身从事开发软件开发、有丰富的编程能力和水平、累积给上千名同学进行辅导、全网累积粉丝超过50W。是优快云特邀作者、博客专家、新星计划导师、Java领域优质创作者,博客之星、掘金/华为云/阿里云/InfoQ等平台优质作者、专注于Java技术领域和学生毕业项目实战,高校老师/讲师/同行前辈交流和合作。

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查↓↓↓↓↓↓获取联系方式↓↓↓↓↓↓↓↓

350

350

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?