温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一份关于《Hadoop+Spark+Hive考研分数线预测与考研推荐系统》的任务书模板,涵盖技术架构、任务分解与实施路径,供参考:

任务书:基于Hadoop+Spark+Hive的考研分数线预测与个性化推荐系统

一、项目背景与目标

- 背景

考研(全国硕士研究生统一招生考试)竞争激烈,考生需根据目标院校/专业的历年分数线、报录比、试题难度等数据制定备考策略。传统信息获取方式依赖人工整理,存在数据分散、更新滞后、分析维度单一等问题。本系统结合Hadoop(分布式存储)、Spark(分布式计算)与Hive(数据仓库),实现:- 考研分数线预测:基于历史数据(如2010-2023年)构建预测模型,预测目标院校/专业次年分数线。

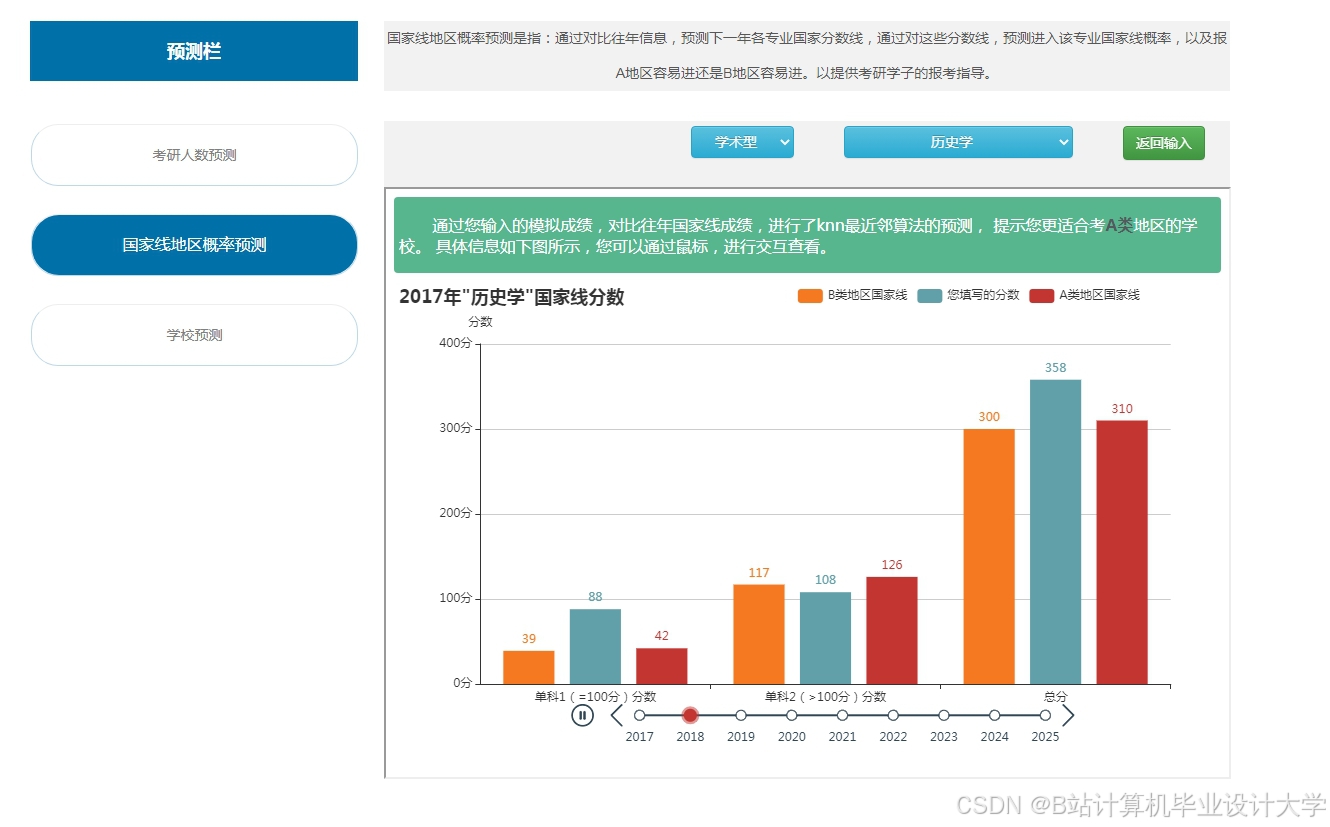

- 个性化推荐系统:根据考生背景(本科院校、成绩、备考时间)推荐匹配的院校/专业,提升备考效率。

- 目标

- 构建分布式数据处理平台,支持多源考研数据(分数线、报录比、招生简章)的存储与清洗。

- 开发预测模型(如线性回归、XGBoost),预测分数线误差率≤5%。

- 实现“考生-院校”双向匹配推荐,推荐准确率(用户点击率)提升20%。

二、技术架构

| 层级 | 技术组件 | 功能说明 |

|---|---|---|

| 数据层 | Hadoop HDFS + Hive | 存储原始考研数据(CSV/JSON格式),包括: - 历年分数线(院校/专业/年份/单科线/总分线) - 报录比(报考人数/录取人数) - 考生反馈数据(备考时长、成绩提升幅度)。 |

| 计算层 | Spark Core + Spark MLlib | 分布式清洗数据、特征工程(如计算分数线波动率)、训练预测模型、生成推荐列表。 |

| 模型层 | XGBoost + 协同过滤 | 分数线预测使用XGBoost回归模型;推荐系统结合基于内容的推荐(院校标签匹配)与协同过滤(考生行为相似度)。 |

| 服务层 | Flask + ECharts | 提供RESTful API(如/predict、/recommend),前端展示预测结果与推荐列表(折线图、表格)。 |

三、任务分解与实施计划

阶段1:数据采集与存储(1周)

- 数据来源

- 公开数据集:中国研究生招生信息网(研招网)、各院校官网(如清华大学研究生院)、考研论坛(如“考研帮”)。

- 爬虫补充:爬取非结构化数据(如招生简章中的特殊要求),存储至HDFS。

- 数据存储

- 按数据类型分区存储至HDFS,例如:

1/data/kaoyan/score/year=2023/school=清华大学/major=计算机科学与技术.csv 2/data/kaoyan/enrollment/year=2023/school=北京大学/major=金融.json - 使用Hive创建外部表,定义字段类型(如

school STRING, major STRING, year INT, total_score FLOAT)。

- 按数据类型分区存储至HDFS,例如:

阶段2:数据清洗与预处理(2周)

- 数据清洗(Spark)

- 缺失值处理:分数线缺失的院校/专业,用同省份其他院校均值填充。

- 异常值过滤:删除报录比>100(可能为数据错误)或分数线低于国家线的记录。

- 数据归一化:将分数线、报录比等特征缩放到[0,1]区间。

- 特征工程

- 提取时间特征:年份、是否为“大小年”(如2023年为“大年”,报录比高)。

- 计算波动率:某专业近5年分数线标准差,作为模型输入特征。

- 标签编码:将院校层级(985/211/双非)转换为数值(如985→3, 211→2)。

阶段3:分数线预测模型开发(3周)

- 模型选择

- 基准模型:线性回归(快速验证数据线性关系)。

- 进阶模型:XGBoost(处理非线性关系,支持特征重要性分析)。

- 模型训练(Spark MLlib)

- 划分训练集/测试集(8:2),使用Spark的

CrossValidator调参:python1from pyspark.ml.tuning import CrossValidator, ParamGridBuilder 2from pyspark.ml.regression import XGBoostRegressor 3 4xgb = XGBoostRegressor(featuresCol="features", labelCol="total_score") 5param_grid = ParamGridBuilder() \ 6 .addGrid(xgb.maxDepth, [3, 5, 7]) \ 7 .addGrid(xgb.eta, [0.1, 0.01]) \ 8 .build() 9 10cv = CrossValidator(estimator=xgb, estimatorParamMaps=param_grid, evaluator=RegressionEvaluator(), numFolds=3) 11model = cv.fit(train_df)

- 划分训练集/测试集(8:2),使用Spark的

- 模型评估

- 计算MAE(平均绝对误差)与R²(决定系数),目标MAE≤5分(如预测清华大学计算机总分线380分,实际385分,误差5分内)。

**阶段4:推荐系统开发(2周)

- 推荐策略设计

- 基于内容的推荐:根据考生本科院校、成绩、备考时长,匹配院校招生要求(如“985院校优先”)。

- 协同过滤推荐:计算考生行为相似度(如备考时长、目标专业相似度),推荐相似考生选择的院校。

- 推荐算法实现(Spark)

- 使用Spark ALS训练用户-院校隐向量,生成Top-N推荐:

python1from pyspark.ml.recommendation import ALS 2 3als = ALS(maxIter=10, regParam=0.01, userCol="user_id", itemCol="school_major", ratingCol="rating") 4model = als.fit(train_df) 5recommendations = model.recommendForAllUsers(3) # 每个用户推荐3个院校

- 使用Spark ALS训练用户-院校隐向量,生成Top-N推荐:

- 冷启动处理

- 新考生:根据成绩匹配同分数段历史考生选择的院校。

- 新院校:根据专业相似度(如“计算机科学与技术”与“软件工程”)推荐。

阶段5:系统开发与部署(2周)

- 后端服务

- 使用Flask实现两个接口:

/predict:输入院校/专业名称,返回预测分数线(如{"school": "清华大学", "major": "计算机", "predicted_score": 380})。/recommend:输入考生信息(成绩、备考时长),返回推荐院校列表(含预测分数线与报录比)。

- 使用Flask实现两个接口:

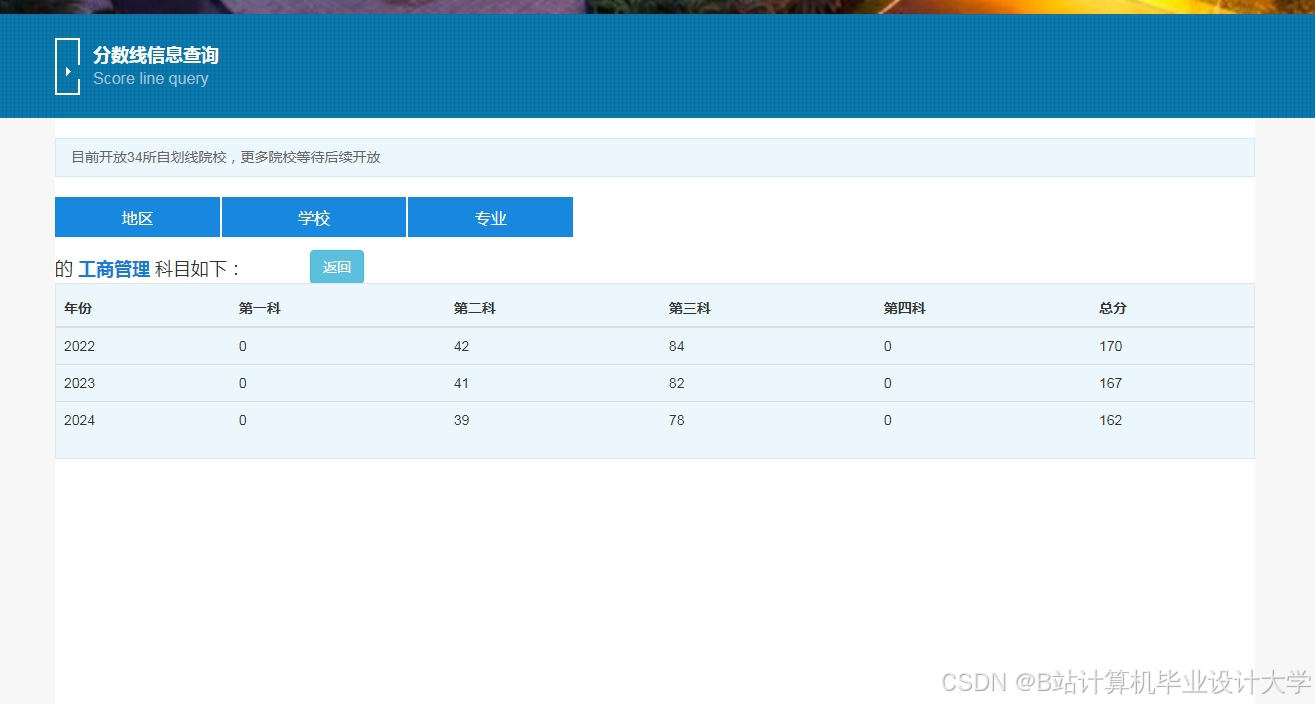

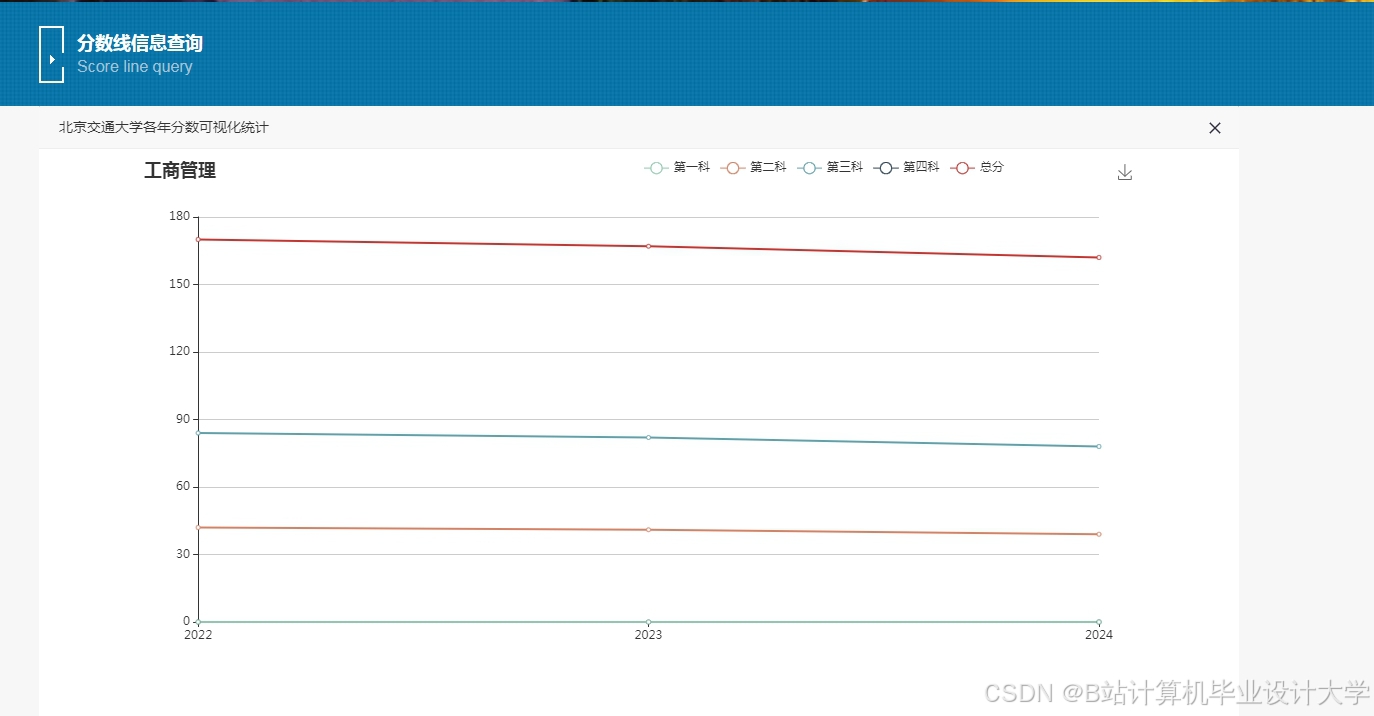

- 前端可视化

- 基于ECharts开发仪表盘,展示:

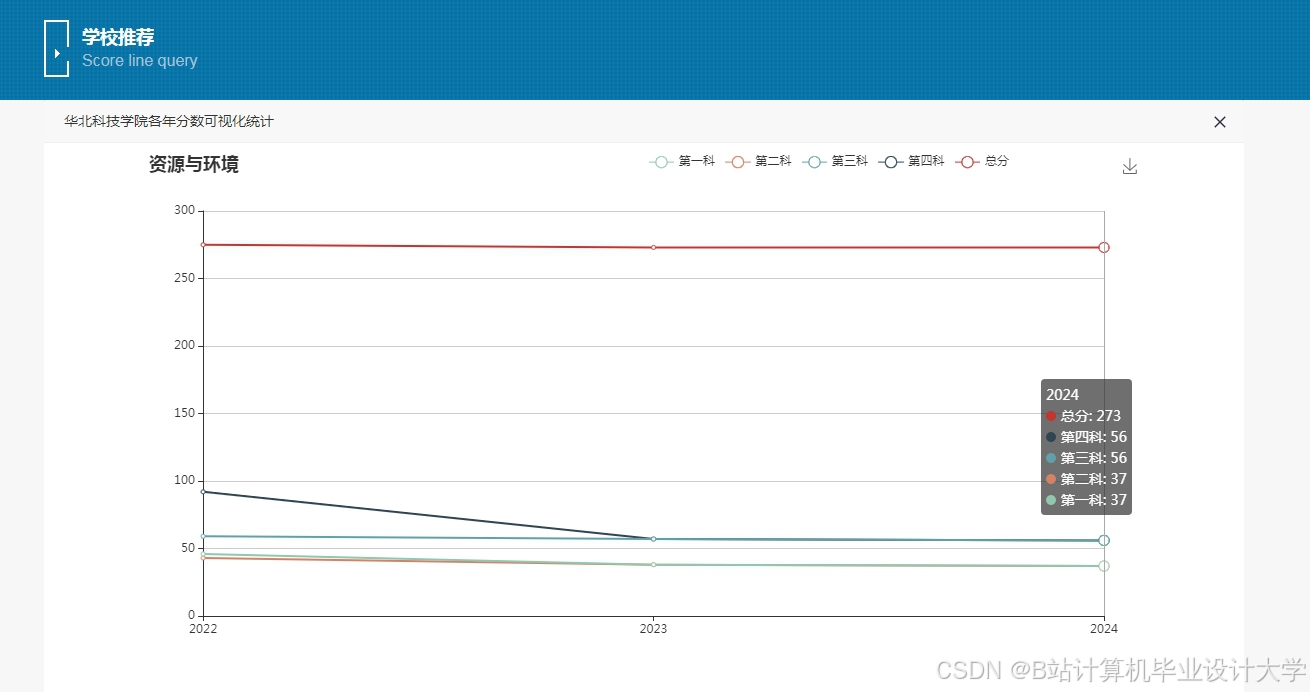

- 目标院校历年分数线趋势图。

- 推荐院校列表(按匹配度排序,支持点击查看详情)。

- 基于ECharts开发仪表盘,展示:

- 部署环境

- 集群环境:3节点Hadoop+Spark集群(测试环境可用Docker Compose模拟)。

- 模型服务:将训练好的XGBoost模型保存为PMML格式,通过Spark加载推理。

四、预期成果

- 技术成果

- 分布式数据处理管道(Spark脚本+Hive表结构文档)。

- 训练好的XGBoost模型(或PMML文件)与推荐算法代码。

- 可运行的Docker镜像(含Spark、Flask、ECharts服务)。

- 分析报告

- 分数线预测误差分析报告(对比线性回归与XGBoost效果)。

- 推荐系统AB测试结果(如用户点击率提升20%)。

- 演示系统

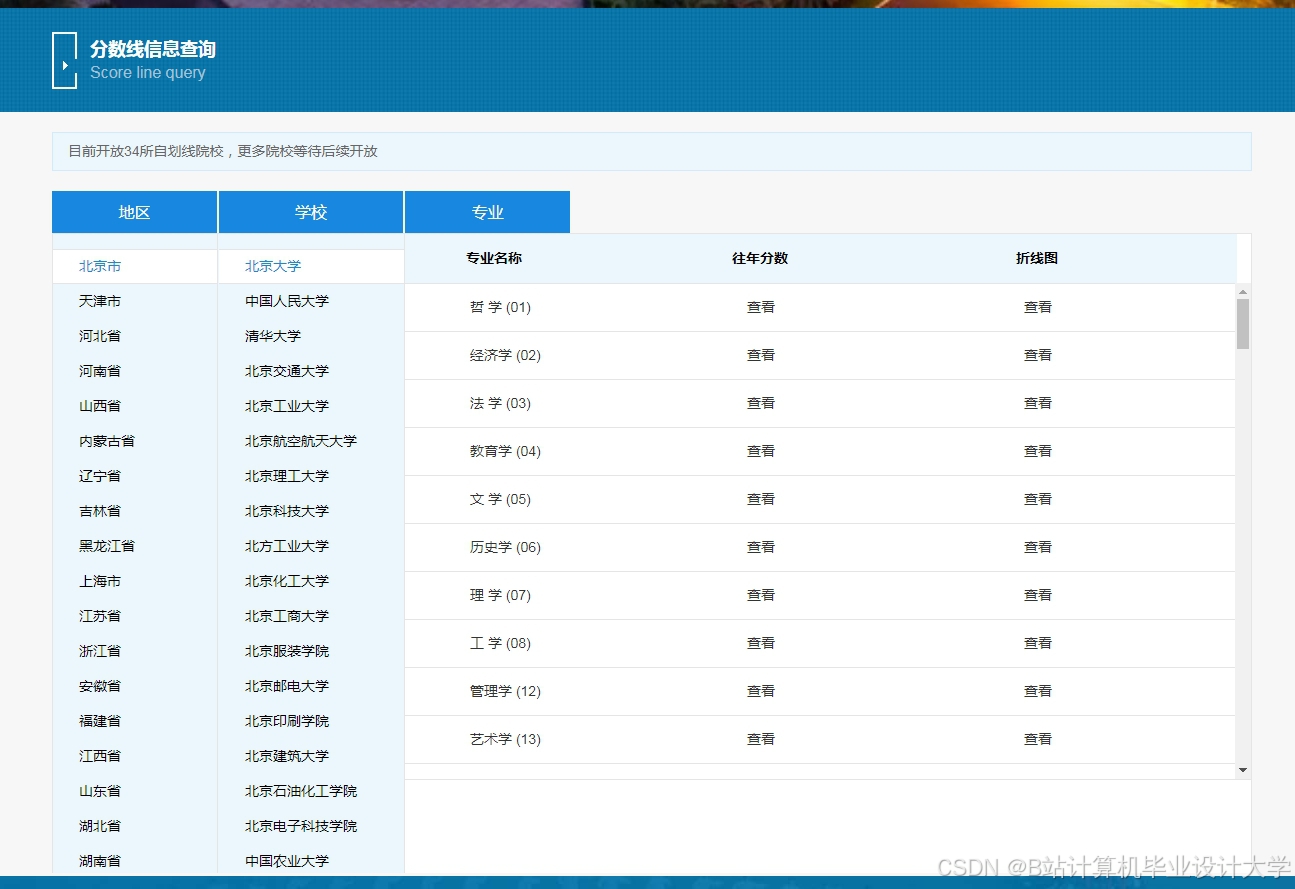

- Web界面支持输入院校名称查看预测分数线,或输入考生信息获取推荐列表。

- 示例查询:

1GET /predict?school=清华大学&major=计算机 2GET /recommend?score=360&preparation_months=6

五、风险评估与应对

| 风险类型 | 描述 | 应对方案 |

|---|---|---|

| 数据缺失风险 | 某些院校/专业历史数据不足(如新开设专业)。 | 使用同省份其他院校数据填充,或标记为“数据不足”。 |

| 模型过拟合风险 | XGBoost在训练集上表现好,测试集误差大。 | 增加正则化项(如reg_lambda=0.1),使用交叉验证调参。 |

| 推荐冷启动风险 | 新考生无历史行为数据。 | 结合内容推荐(如成绩匹配)与热门院校推荐。 |

六、团队分工

| 角色 | 职责 |

|---|---|

| 数据工程师 | 负责Hadoop/Hive环境搭建、数据采集与清洗。 |

| 算法工程师 | 开发分数线预测模型与推荐算法,优化模型参数。 |

| 后端开发 | 实现Flask接口,封装预测与推荐逻辑。 |

| 前端开发 | 开发ECharts可视化界面,优化用户体验。 |

| 测试工程师 | 编写单元测试(如PyTest),验证接口性能与推荐准确性。 |

七、时间计划

| 阶段 | 时间 | 里程碑 |

|---|---|---|

| 数据采集与存储 | 第1周 | 完成HDFS数据存储与Hive表创建。 |

| 数据清洗与预处理 | 第2-3周 | 生成清洗后的数据集,完成特征工程。 |

| 分数线预测模型开发 | 第4-6周 | XGBoost模型训练完成,MAE≤5分。 |

| 推荐系统开发 | 第7-8周 | 完成ALS协同过滤推荐,冷启动方案验证。 |

| 系统开发与部署 | 第9-10周 | API通过Postman测试,Web界面上线。 |

备注:若数据量较小(如仅覆盖部分省份院校),可简化Hadoop集群,使用单机版Spark(Spark Local Mode)降低资源消耗。

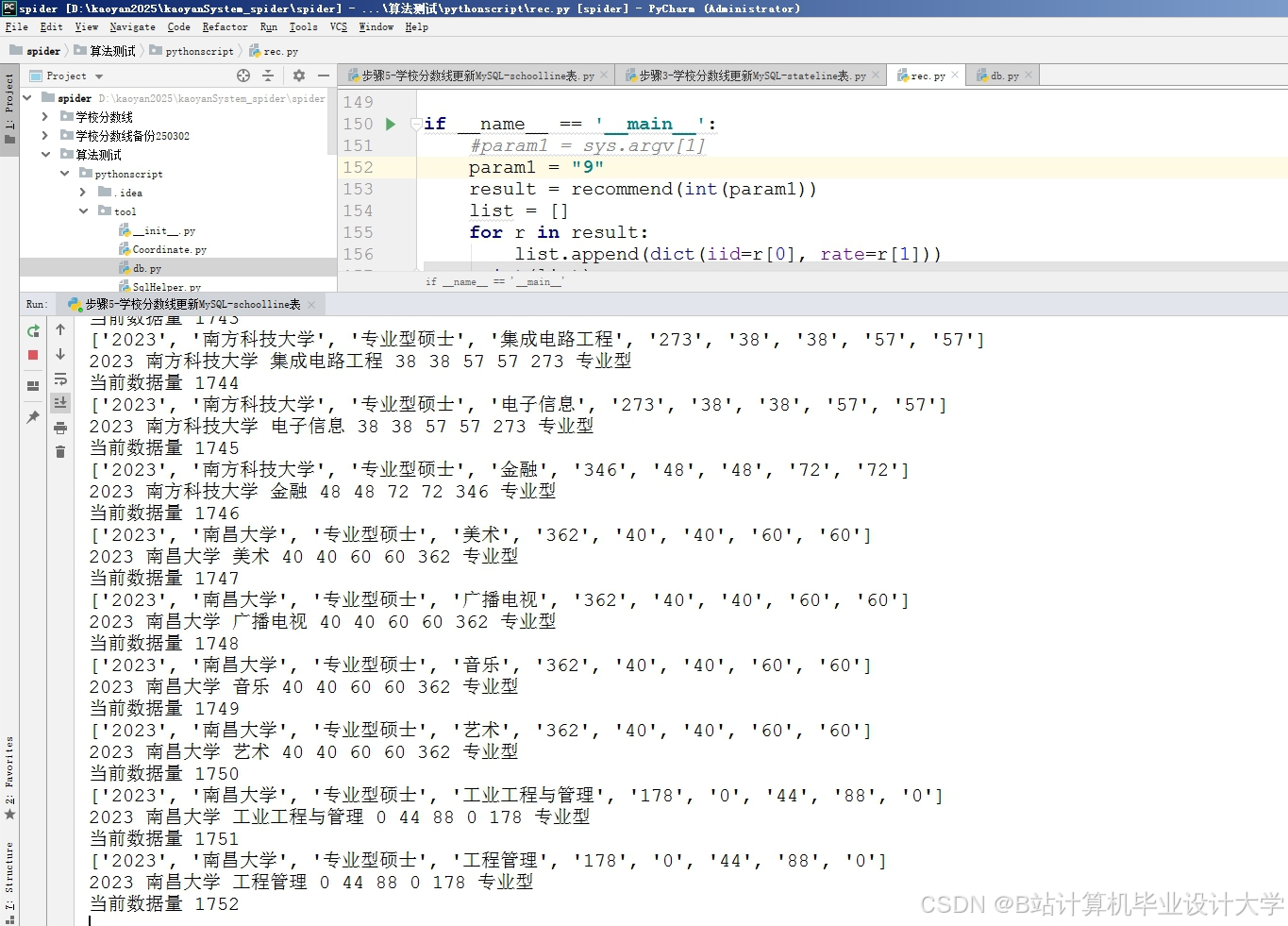

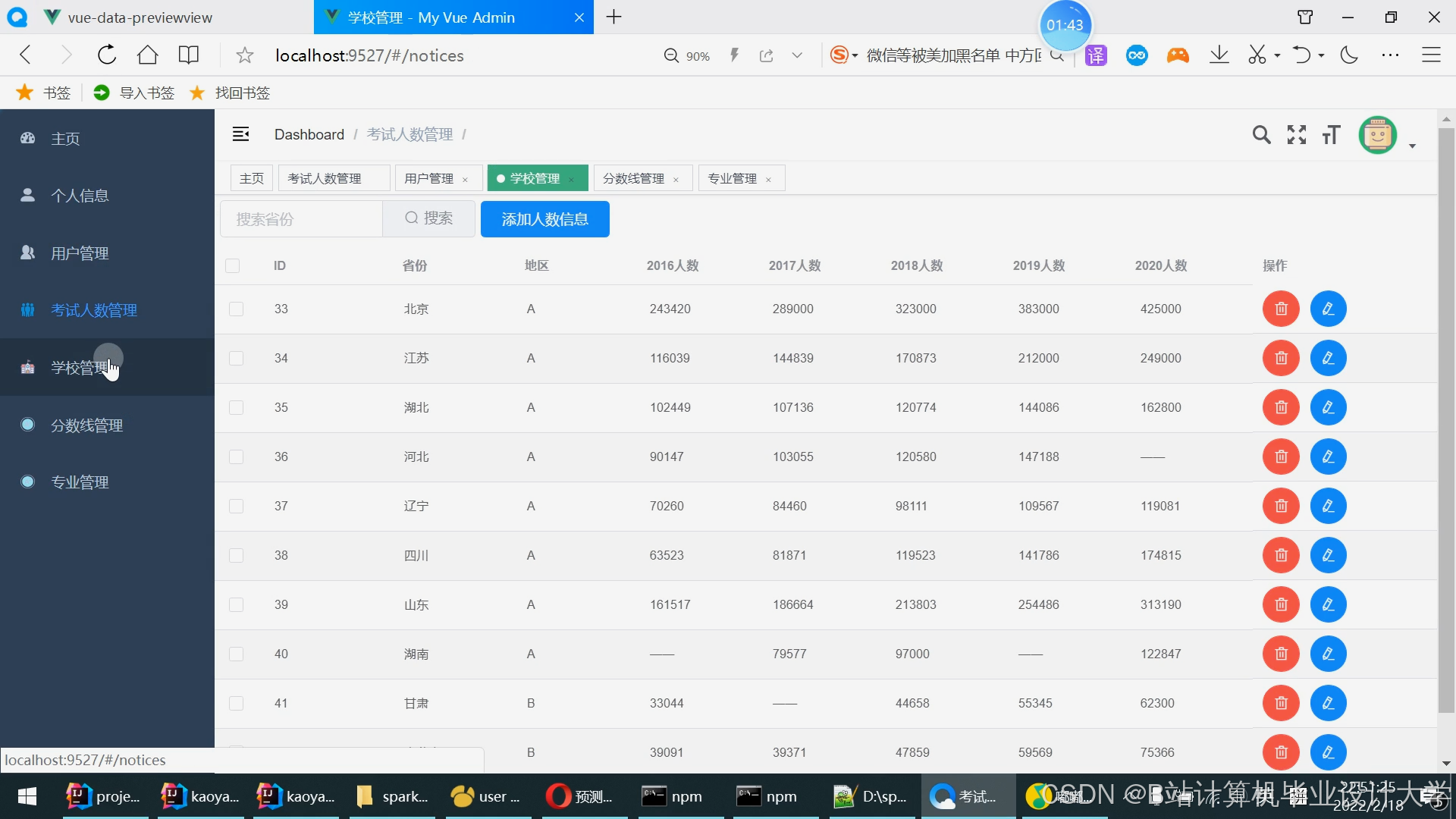

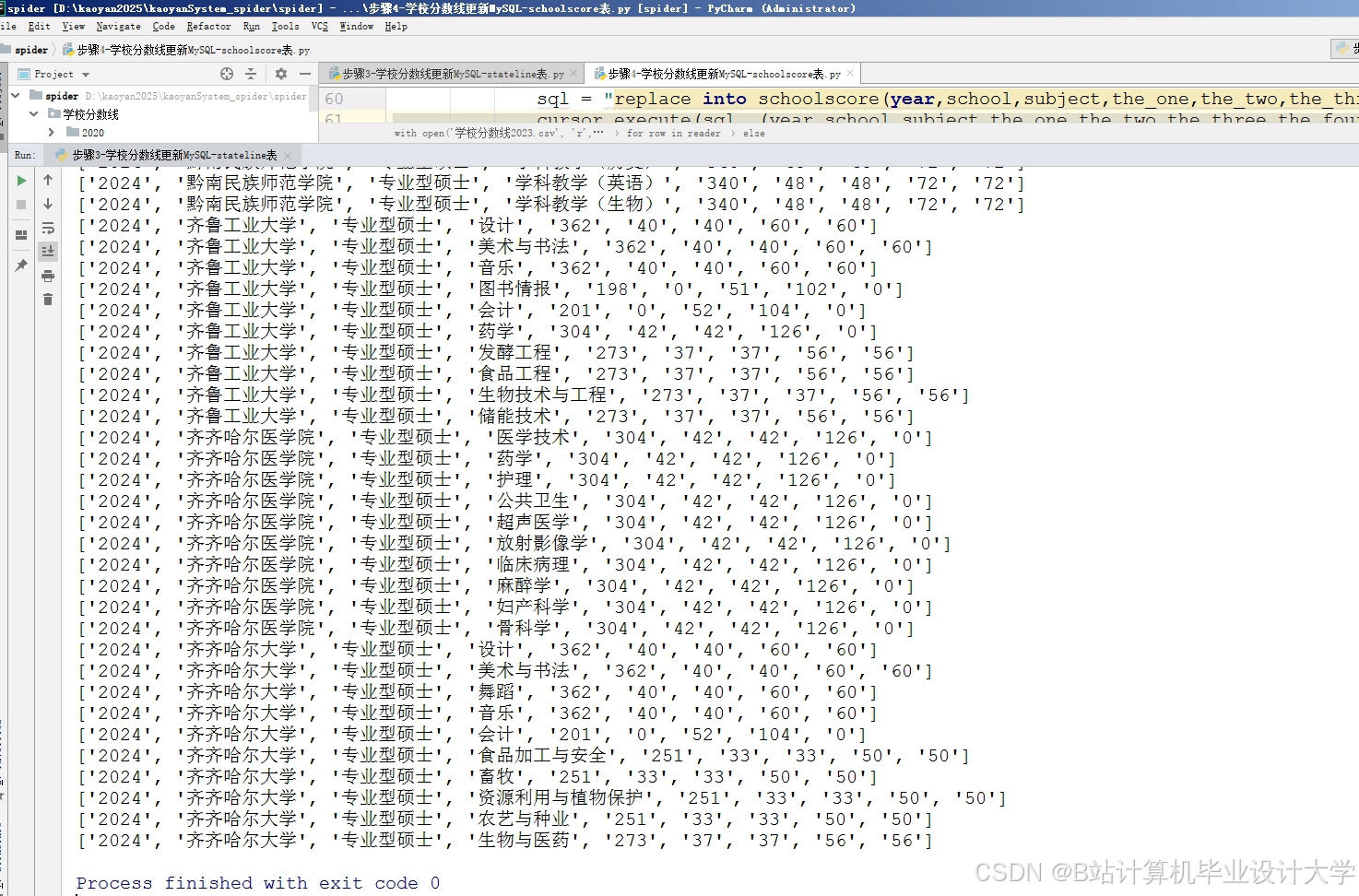

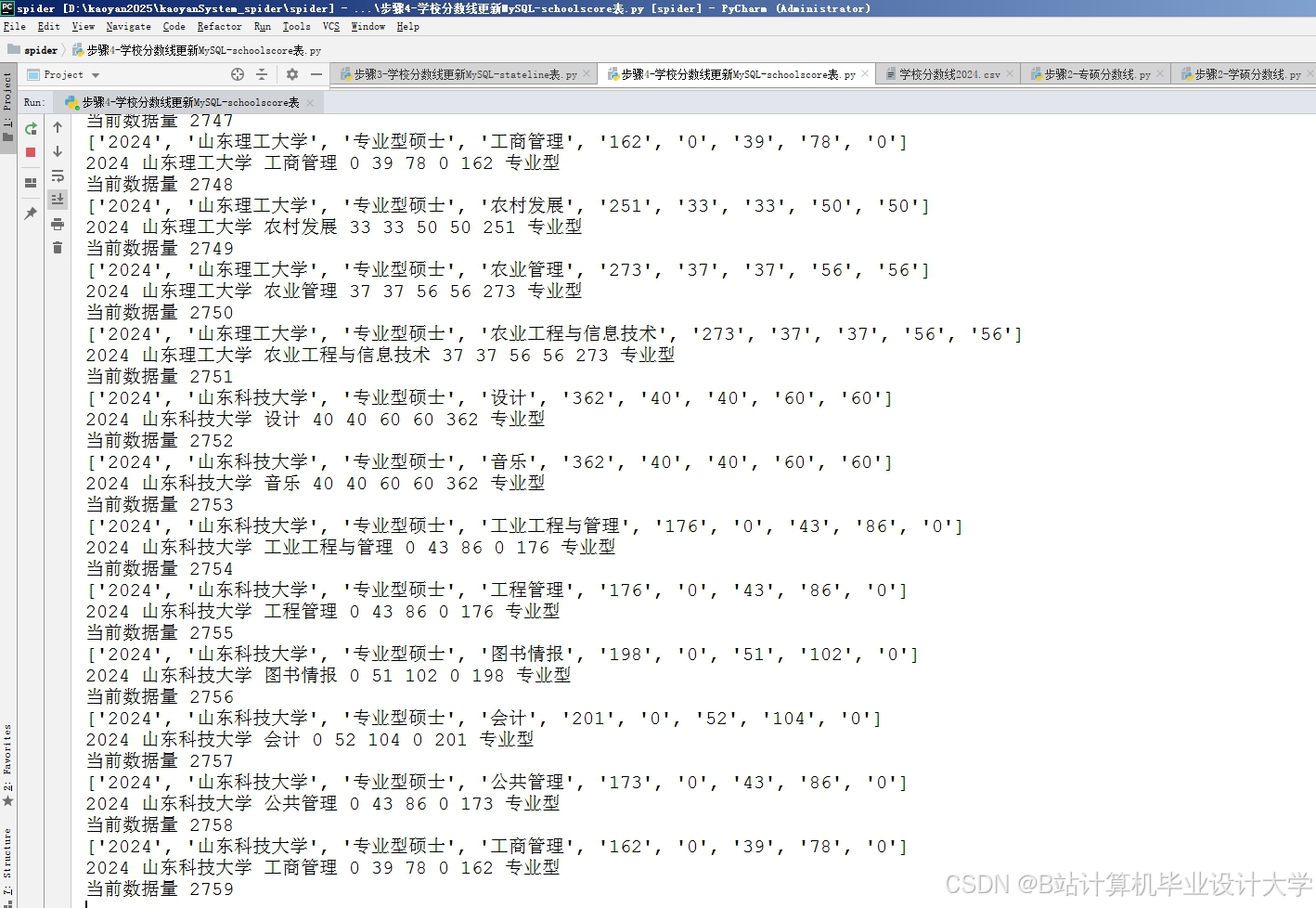

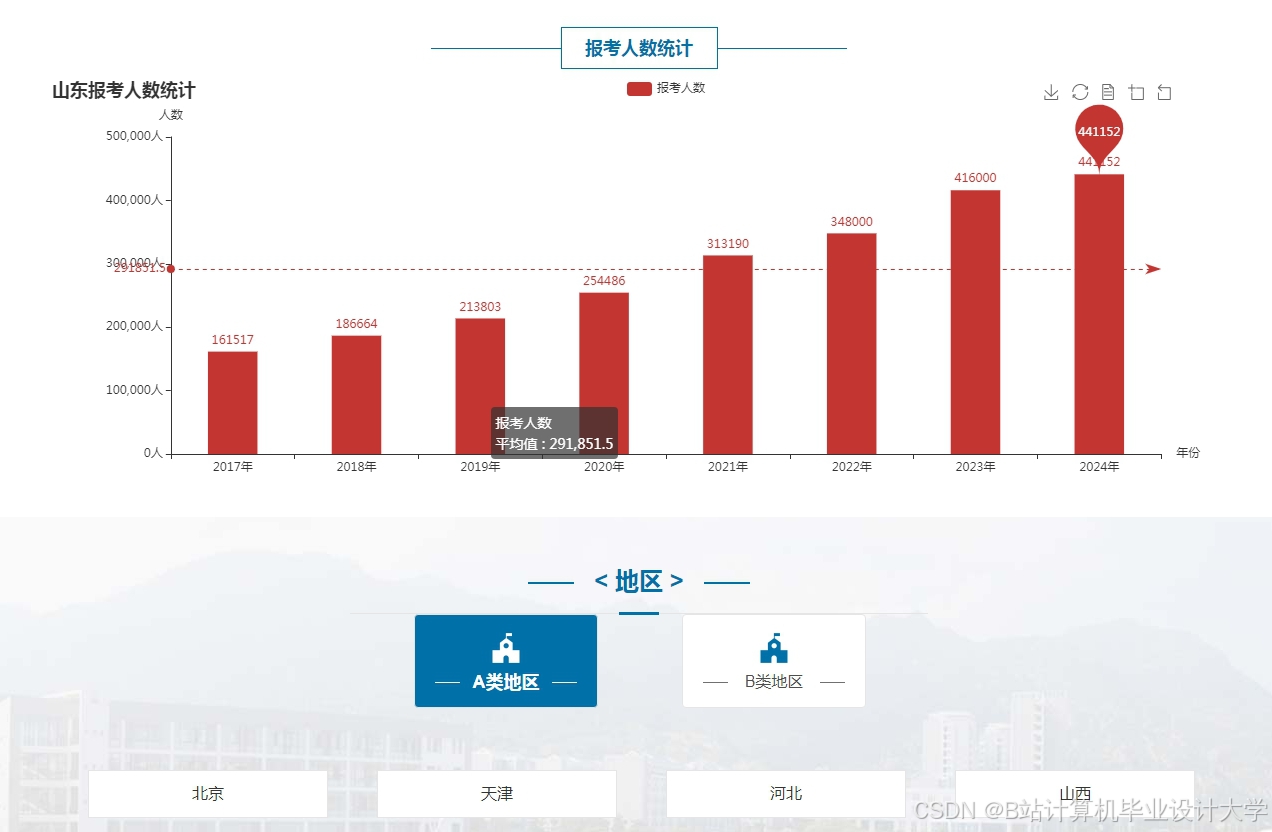

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

909

909

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?