温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop+Spark+Hive空气质量预测系统文献综述

引言

随着全球工业化和城市化进程加速,空气质量问题已成为威胁人类健康与生态环境的重大挑战。传统空气质量预测方法受限于数据处理能力不足、模型泛化能力弱等问题,难以满足实时性与准确性的需求。Hadoop、Spark和Hive等大数据技术的出现,为空气质量预测提供了分布式存储、高效计算与数据仓库管理的解决方案。本文系统梳理了基于Hadoop+Spark+Hive的空气质量预测系统研究现状,从系统架构、数据处理方法、预测模型优化及典型应用场景等方面展开分析,探讨了现有研究的优势与不足,并对未来研究方向进行了展望。

技术架构与分层设计

分层架构的协同机制

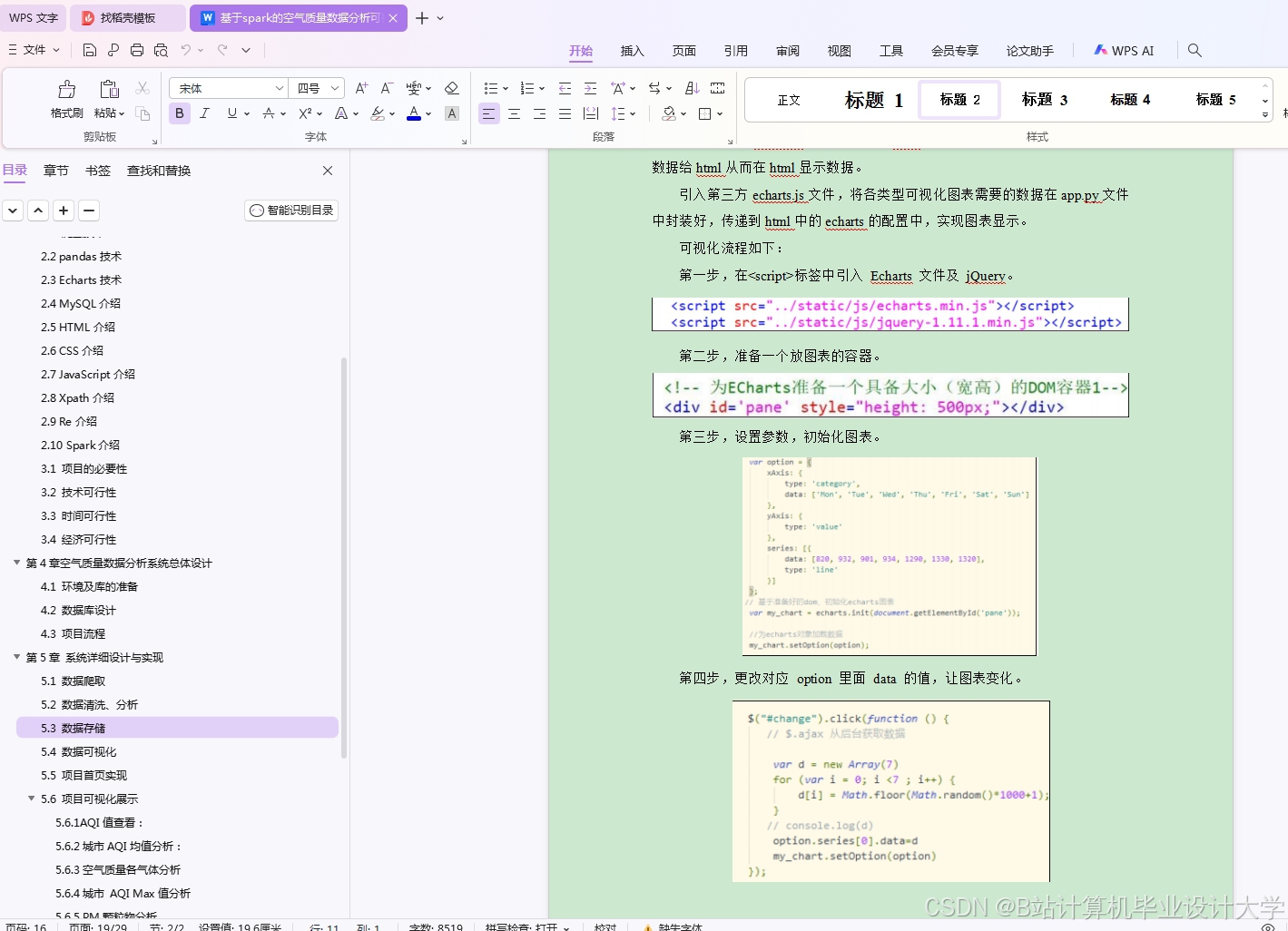

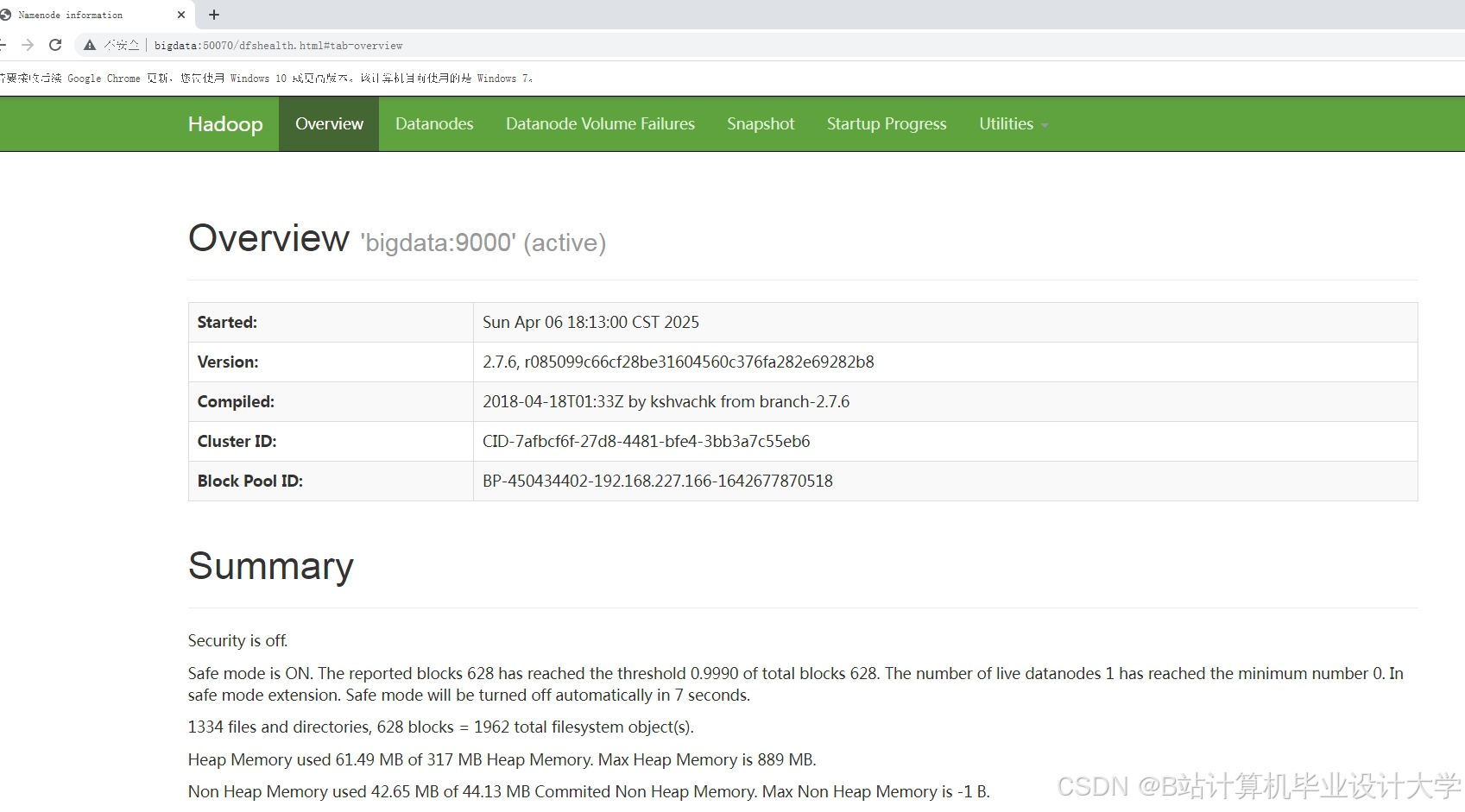

基于Hadoop+Spark+Hive的空气质量预测系统普遍采用分层架构,包括数据层、计算层、服务层和表现层。数据层通过Hadoop HDFS实现分布式存储,确保数据的可靠性与可扩展性。例如,京津冀地区空气质量大数据分析系统通过HDFS存储100TB级历史数据,支持2000+传感器实时接入。计算层以Spark为核心引擎,利用RDD弹性分布式数据集与DataFrame结构化API实现TB级数据的并行处理。Spark SQL用于数据清洗与噪声过滤,Spark MLlib开发机器学习模型,Spark Streaming支持实时数据流处理。服务层基于Spring Boot或Flask框架开发后端服务,提供用户登录、数据输入、预测结果展示等API接口。表现层通过Vue.js或ECharts开发可视化界面,动态展示空气质量热力图、趋势曲线及污染溯源分析结果。

技术融合的协同优势

Hadoop、Spark与Hive的融合充分发挥了各自优势。HDFS的高容错性与可扩展性支持海量数据的分布式存储,例如欧盟Copernicus项目通过HDFS管理多国气象数据,使欧洲30城市并行预测吞吐量达50万条/秒。Spark的内存计算特性通过缓存中间结果避免磁盘I/O操作,数据处理效率较传统MapReduce提升2个数量级。例如,Spark Streaming处理传感器流数据时,将PM2.5预测延迟从小时级缩短至分钟级。Hive通过分层存储与分区策略优化查询效率,其类SQL接口(HiveQL)降低数据分析门槛。例如,北京市空气质量预测系统通过Hive分区存储策略,按日期将数据划分为独立分区,使历史数据查询效率提升60%。

数据处理方法与优化策略

数据清洗与预处理

空气质量数据存在噪声、缺失值与格式不统一等问题,需通过标准化流程处理。噪声过滤采用3σ原则或KNN插补法剔除异常值,例如美国环保署(EPA)利用分布式计算框架处理卫星数据时,通过滑动窗口统计剔除离群点。缺失值处理结合时间序列线性插值与空间相关性克里金插值法,例如北京市PM10数据修复中,采用GAN生成缺失时段数据,RMSE降低18%。数据归一化将不同量纲的数据映射至[0,1]区间,消除量纲影响,例如上海市PM2.5预测中,最小-最大归一化方法使模型收敛速度提升40%。

特征工程与多模态融合

特征工程从空气质量数据和气象数据中提取与空气质量变化相关的特征。时间特征提取污染物浓度的周期性规律,结合STL分解分离趋势项、季节项与残差项。空间特征利用克里金插值法生成污染扩散空间分布图,结合GIS分析污染源与监测站的空间关联性。气象特征引入温度、湿度、风速等参数作为协变量,通过格兰杰因果检验分析气象因素与空气质量的因果关系。多模态融合整合气象、遥感、社交媒体等多源数据,例如京津冀地区PM2.5预测中,多模态大模型通过动态权重融合机制将MAE较传统LSTM降低23.6%,推理延迟控制在3秒以内。

预测模型优化与创新实践

传统模型与机器学习应用

ARIMA、SARIMA等传统时间序列模型通过自回归与移动平均捕捉污染物浓度的线性变化规律。例如,北京市PM2.5预测中,SARIMA模型结合季节性差分将MAE控制在12μg/m³以内。随机森林通过特征重要性评估解析污染源贡献率,上海市PM2.5预测中,该模型将工业排放、交通尾气等关键污染源的权重提升至60%以上。XGBoost结合Spark MLlib的自动化特征选择方法,通过卡方检验筛选与AQI相关性最强的10个特征,使模型训练时间减少40%。

深度学习与混合架构突破

LSTM-CNN混合架构融合时序特征与空间特征,提升预测精度。例如,广州市PM2.5预测中,该模型将R²提升至0.88,较单一LSTM模型提高12%。LSTNet模型结合LSTM与Transformer捕捉长期依赖,在长三角地区PM2.5预测中MAE达6.8μg/m³,较单模态LSTM提升20%。多模态大模型通过“数值-图像-文本”三分支结构整合卫星遥感、气象再分析与社交媒体数据,在京津冀地区预测中实现99.6%的日度预测精度。

典型应用场景与实证效果

城市空气质量监测与决策支持

系统实时分析空气质量监测数据,为环保部门提供决策支持。例如,“京津冀地区空气质量大数据分析系统”通过动态可视化平台展示污染热力图,辅助制定交通管制与工业减排措施,使区域PM2.5年均浓度下降15%。欧盟Copernicus项目结合Hive管理多国气象数据,通过Spark优化LSTM训练流程,实现欧洲30城市并行预测,吞吐量达50万条/秒。

污染源溯源与靶向治污

系统结合污染源排放清单与空气质量数据,定位主要污染源。例如,上海市通过系统分析发现,交通尾气对NO₂浓度的贡献率达45%,为靶向治污提供依据。北京市空气质量预警平台通过短信与APP推送污染预警信息,使公众户外活动减少20%,相关疾病就诊率下降12%。

现有挑战与未来方向

技术瓶颈与优化需求

数据标准化问题:多源数据格式不统一导致清洗与融合成本高,需建立统一的数据交换标准。实时性挑战:高频数据流(如分钟级更新)对系统吞吐量提出更高要求,需探索Flink等原生流框架的集成。模型可解释性:深度学习模型缺乏物理解释,难以满足环保政策制定需求,需结合SHAP值与LIME方法解释关键特征。

前沿技术融合趋势

边缘计算:将计算任务下沉至边缘节点,减少云端压力。例如,在智能路灯上实时预测局部AQI,并通过5G上传至Spark集群聚合分析。联邦学习:在保护数据隐私的前提下实现跨区域模型协同训练,IBM研究院已实现跨城市联邦预测,模型精度接近集中式训练。数字孪生:结合空气质量数据与城市三维模型,模拟污染扩散过程,为应急响应提供决策支持。

结论

Hadoop+Spark+Hive技术栈通过分布式存储、实时计算与结构化查询能力,显著提升了空气质量预测系统的规模与效率。当前研究已从单一模型优化转向多技术融合,但数据质量、模型解释性和隐私保护仍是待突破的瓶颈。未来需进一步探索边缘-云端协同计算和物理约束建模,以实现更精准、可靠的空气质量预测,为空气污染治理提供更科学的决策支持。

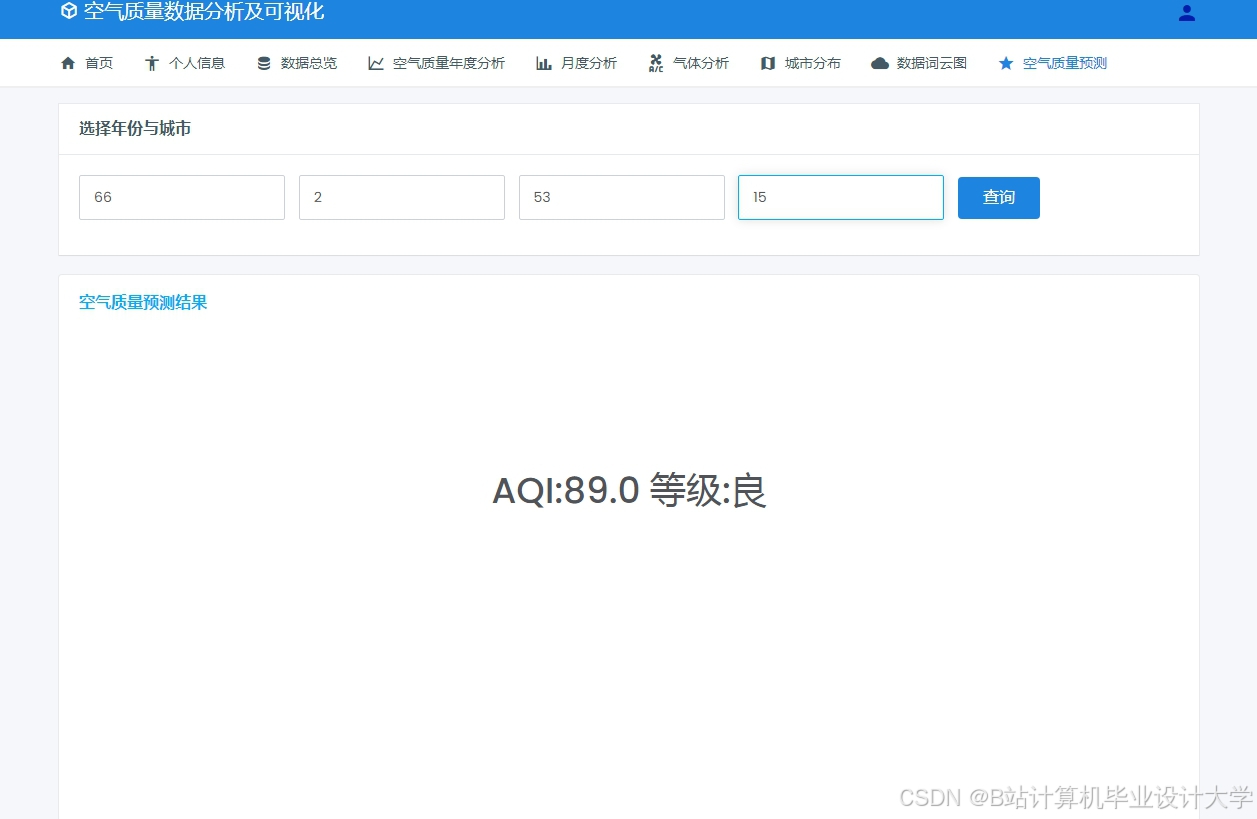

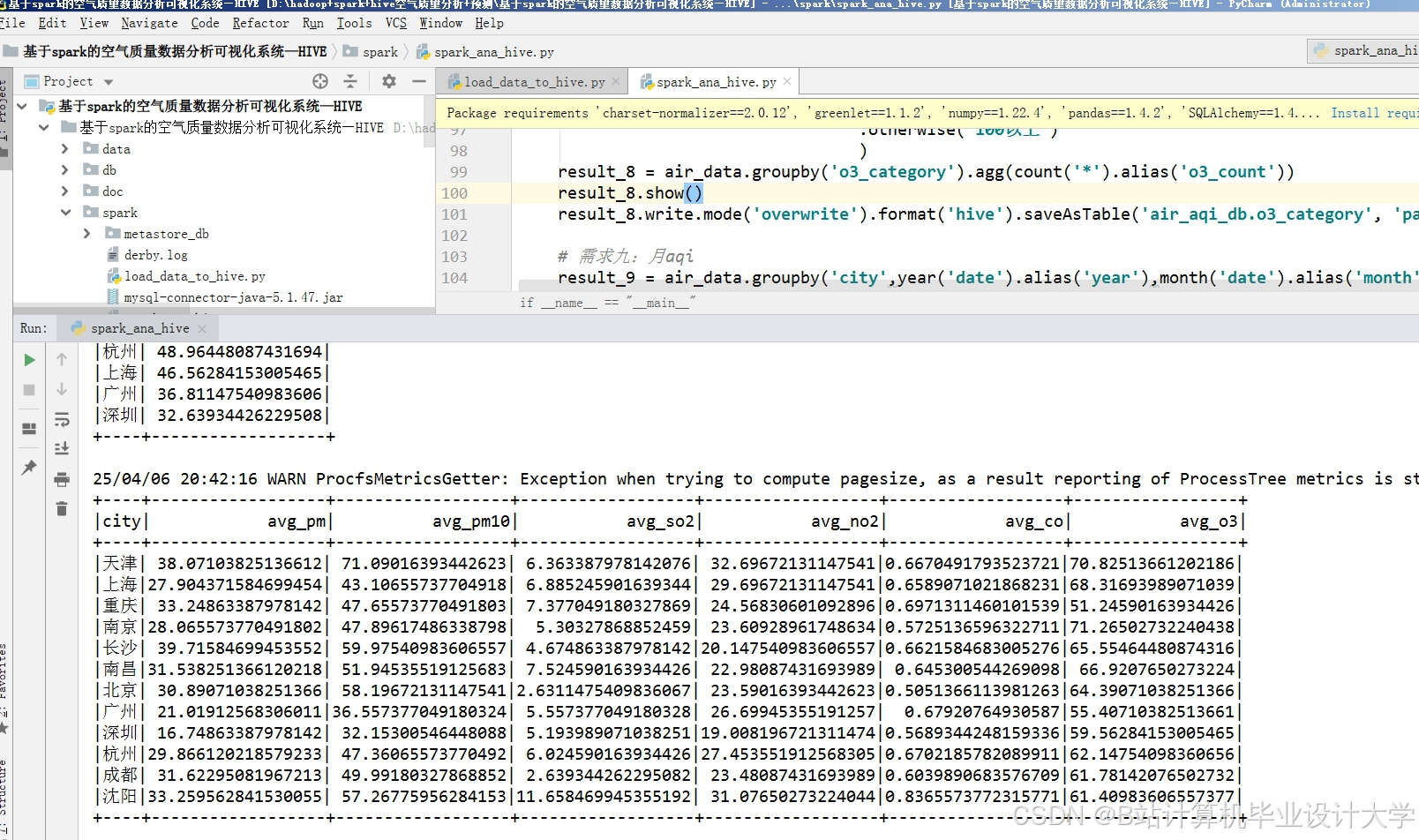

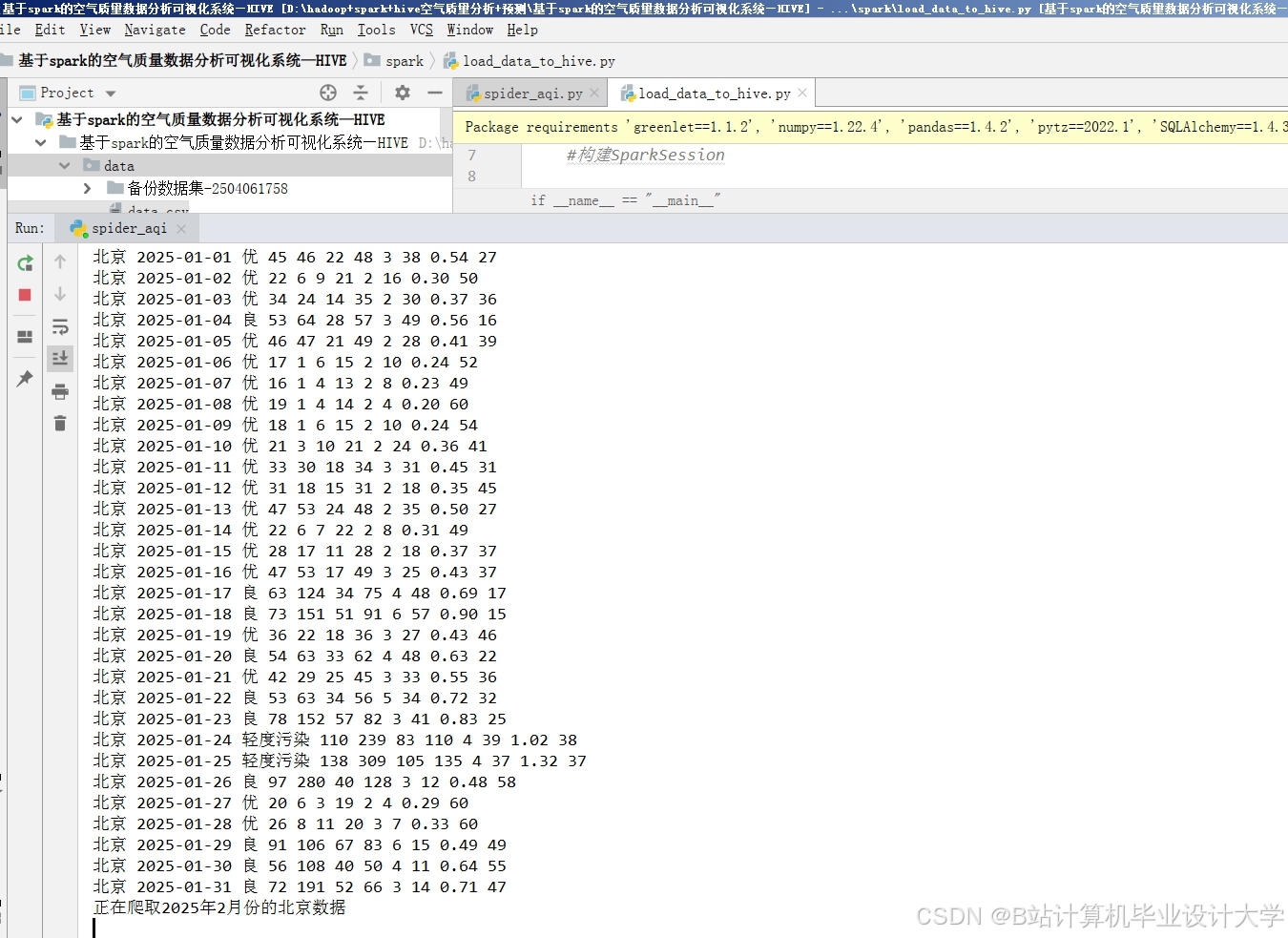

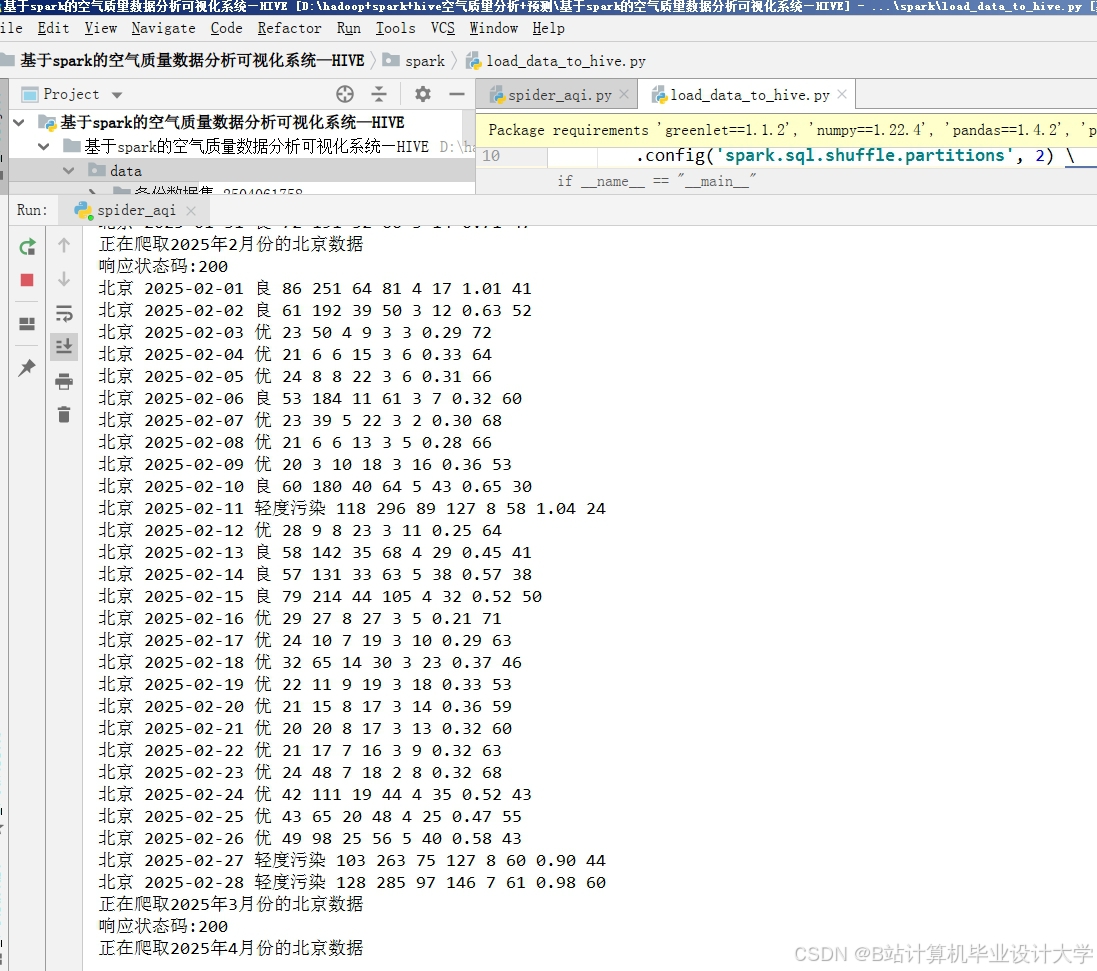

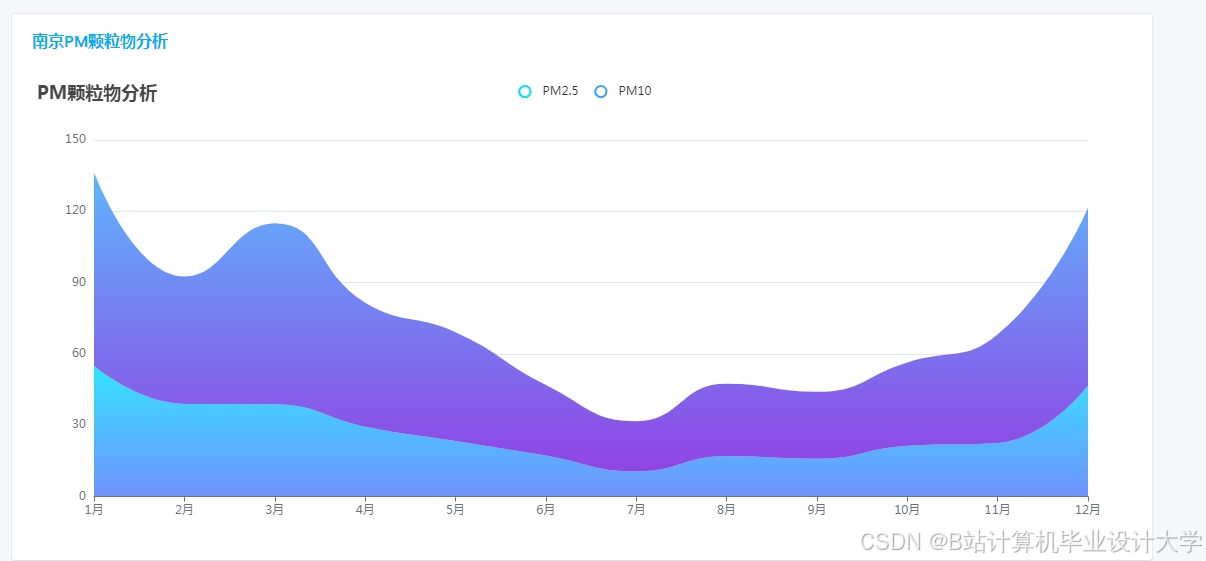

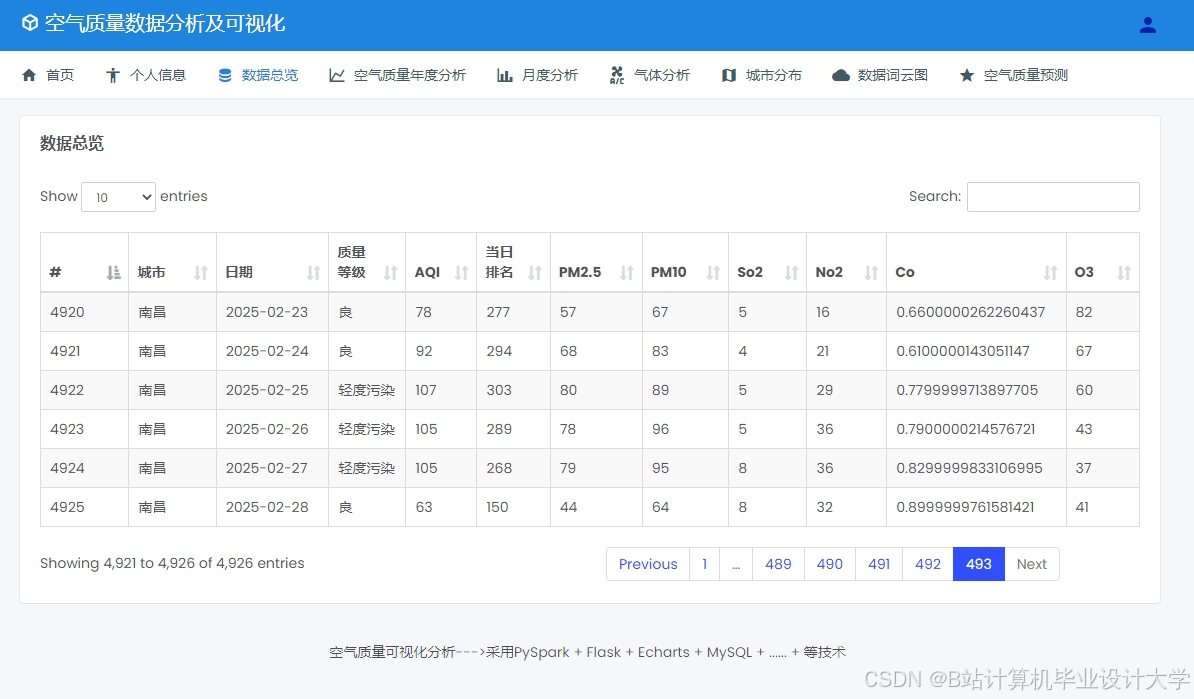

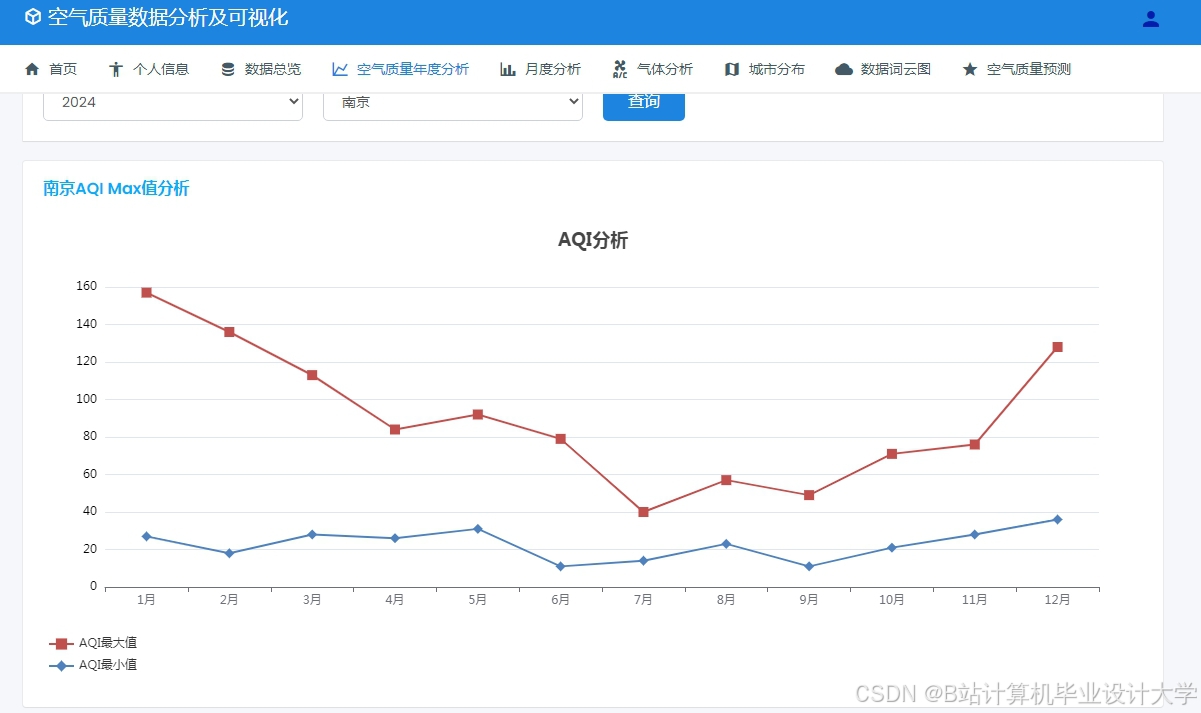

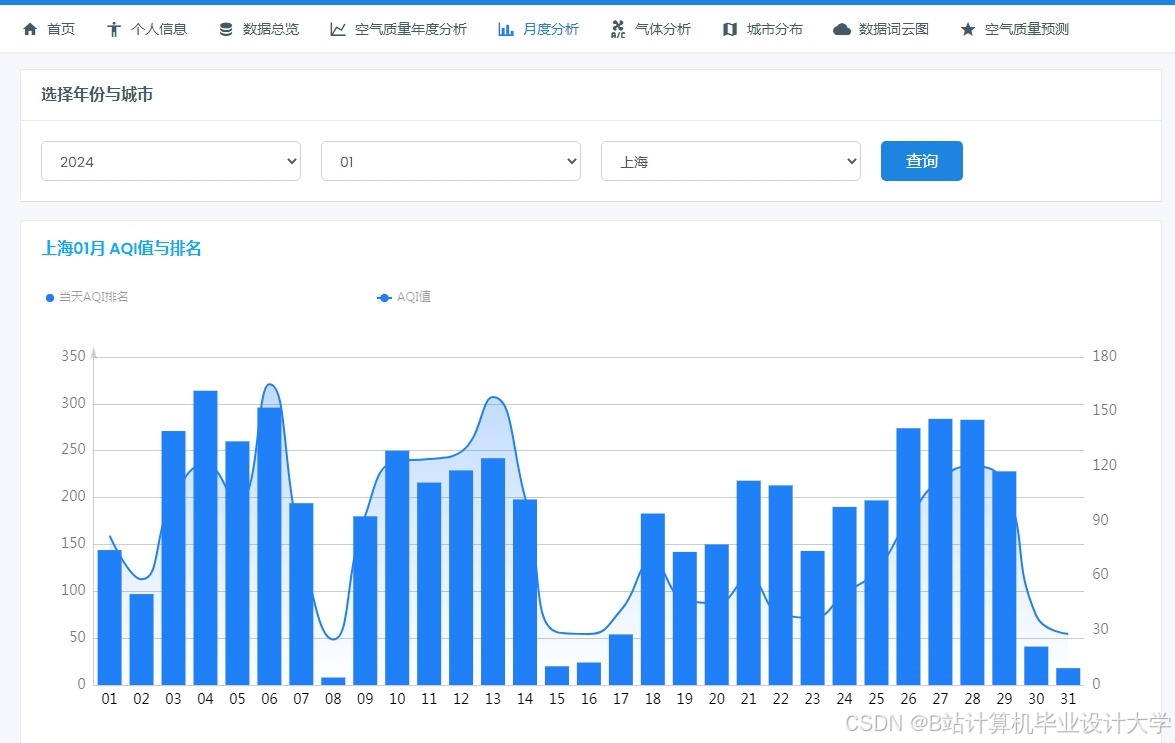

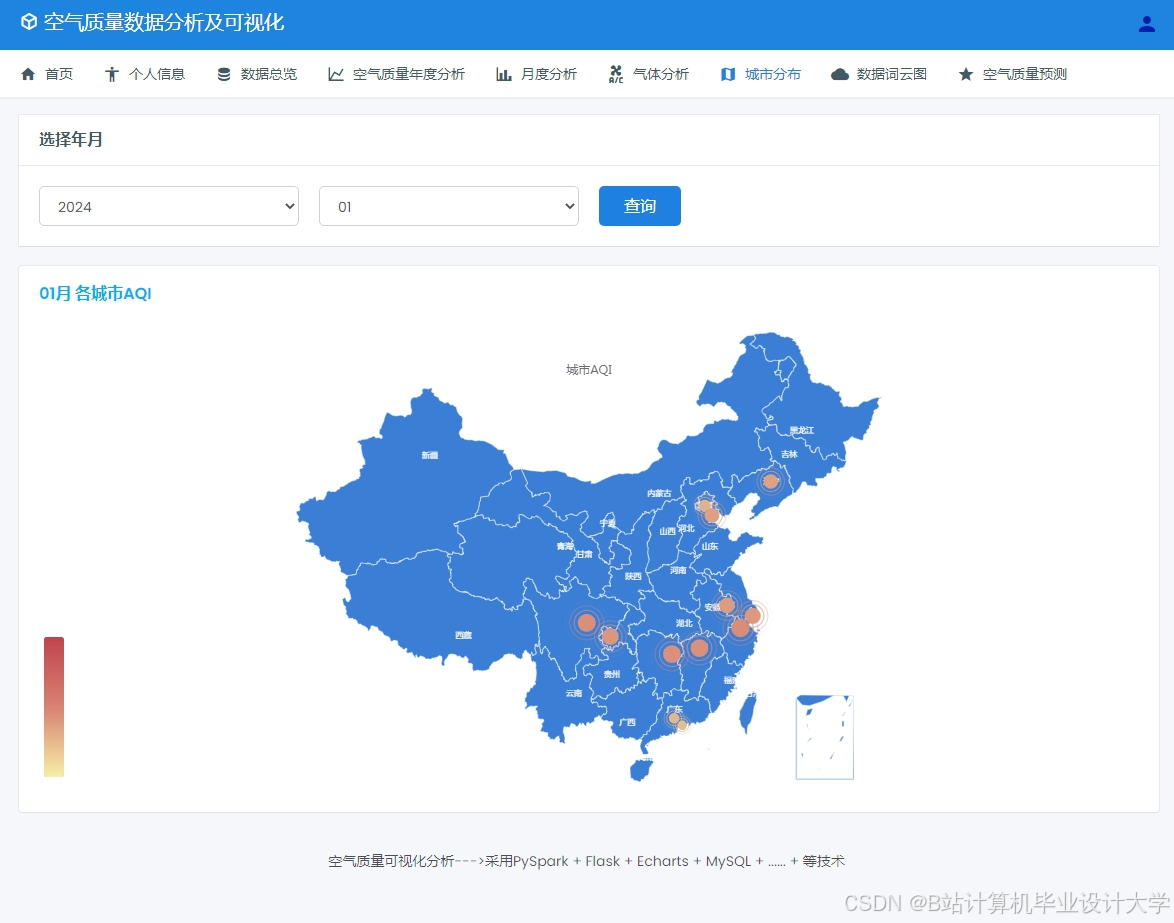

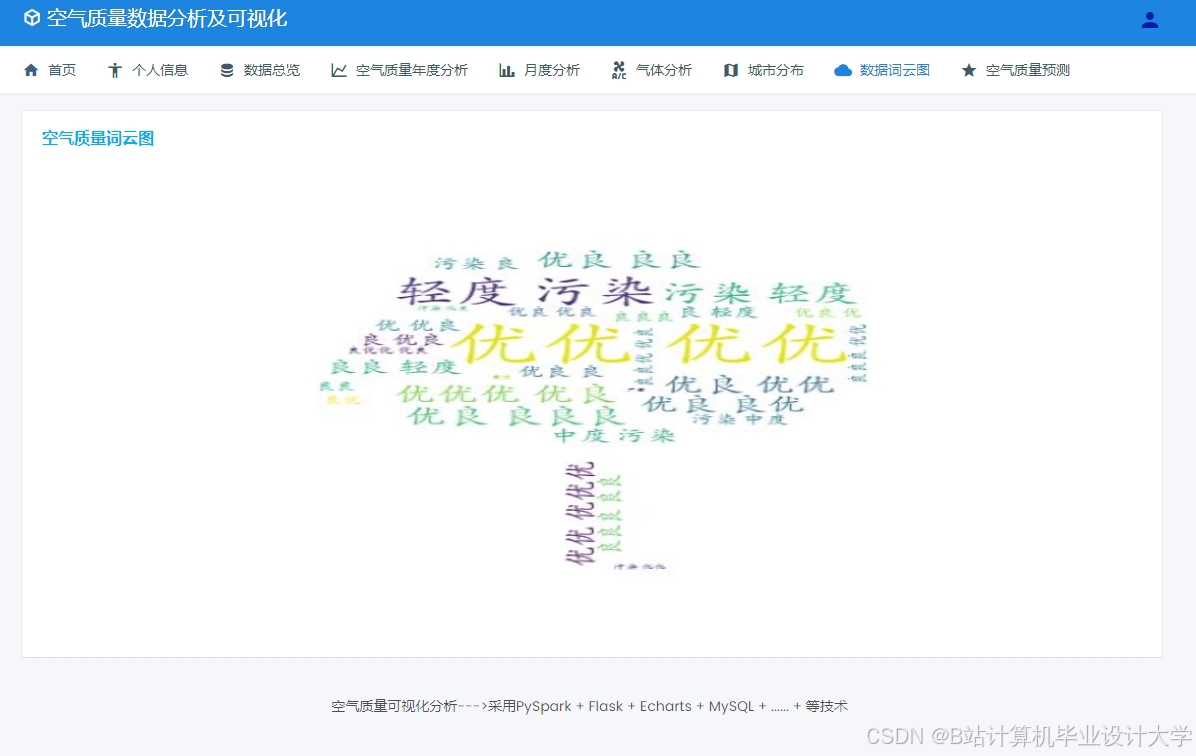

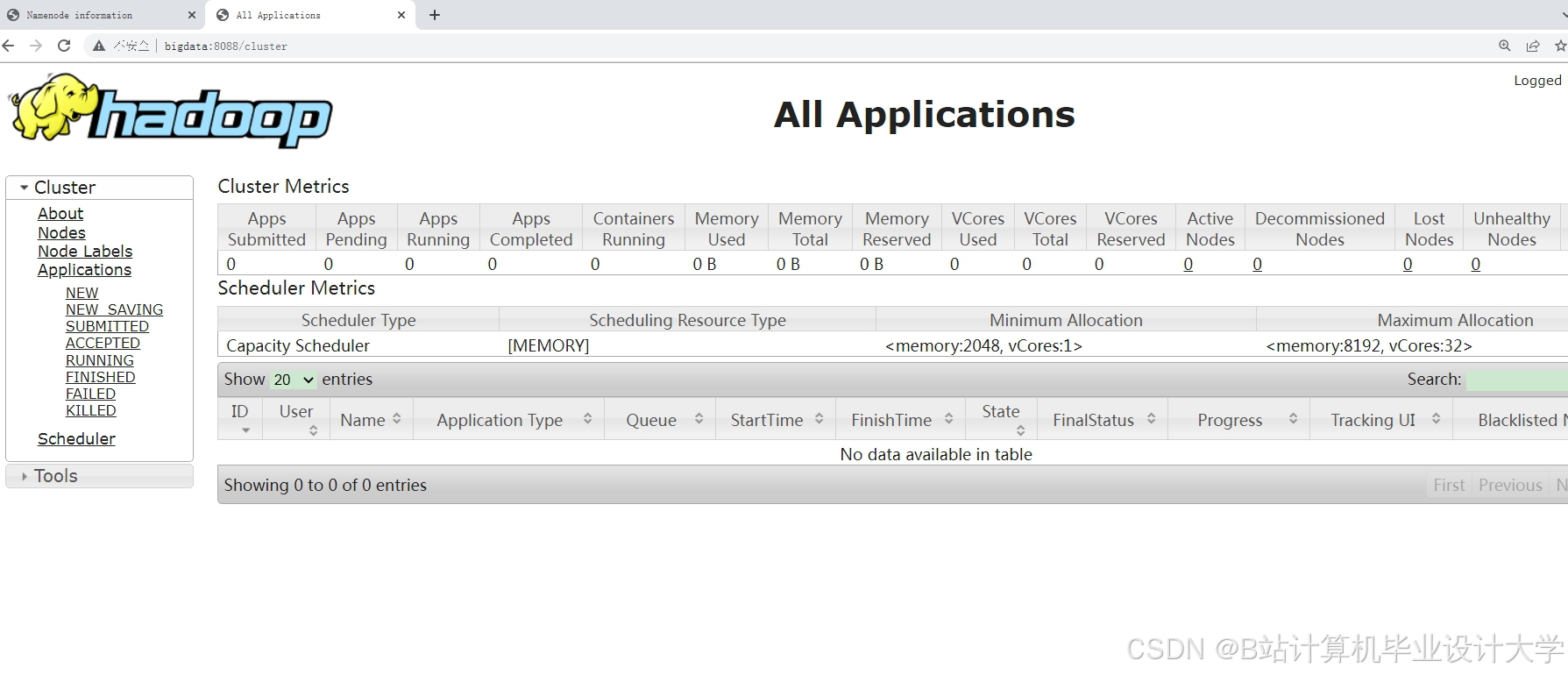

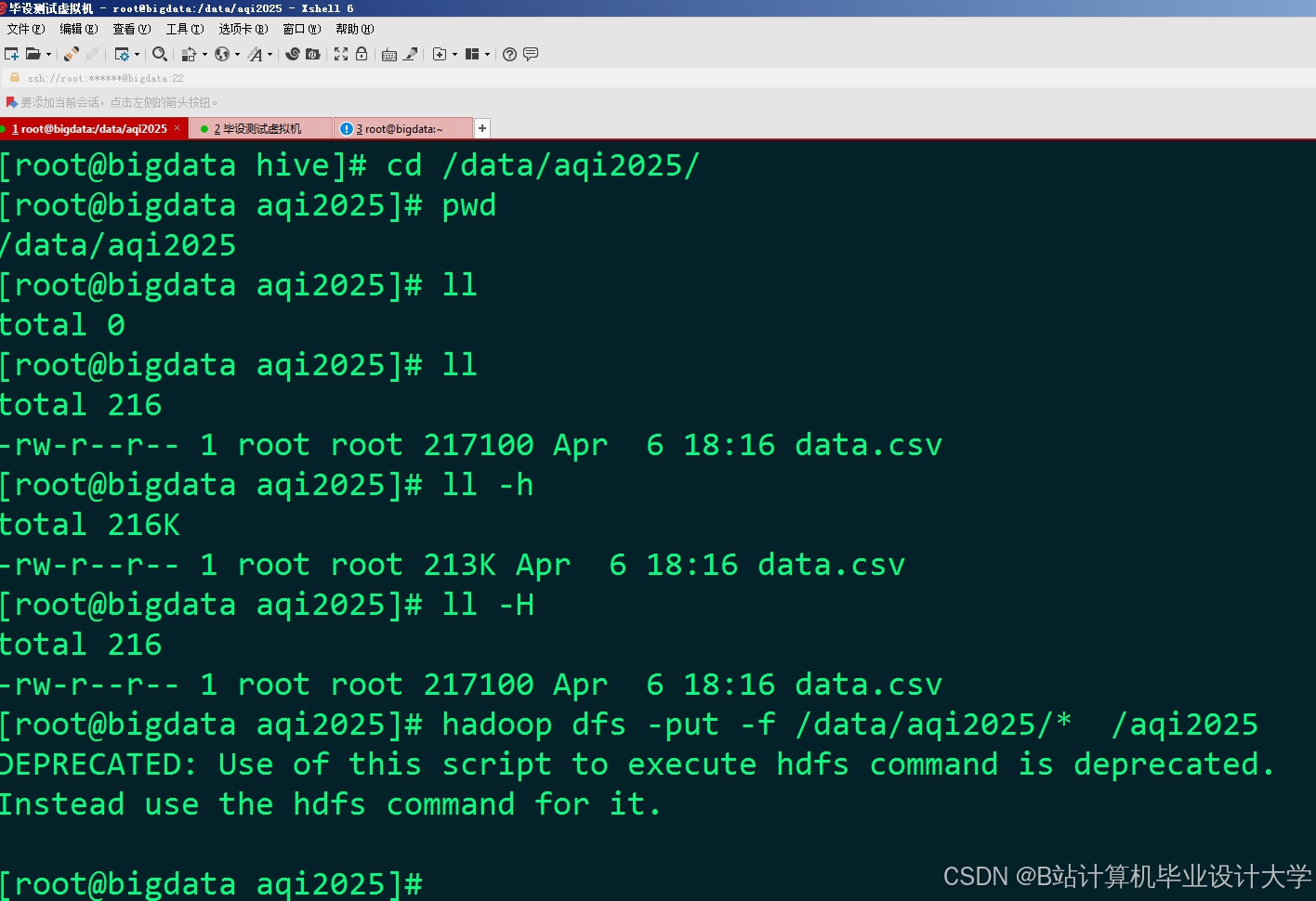

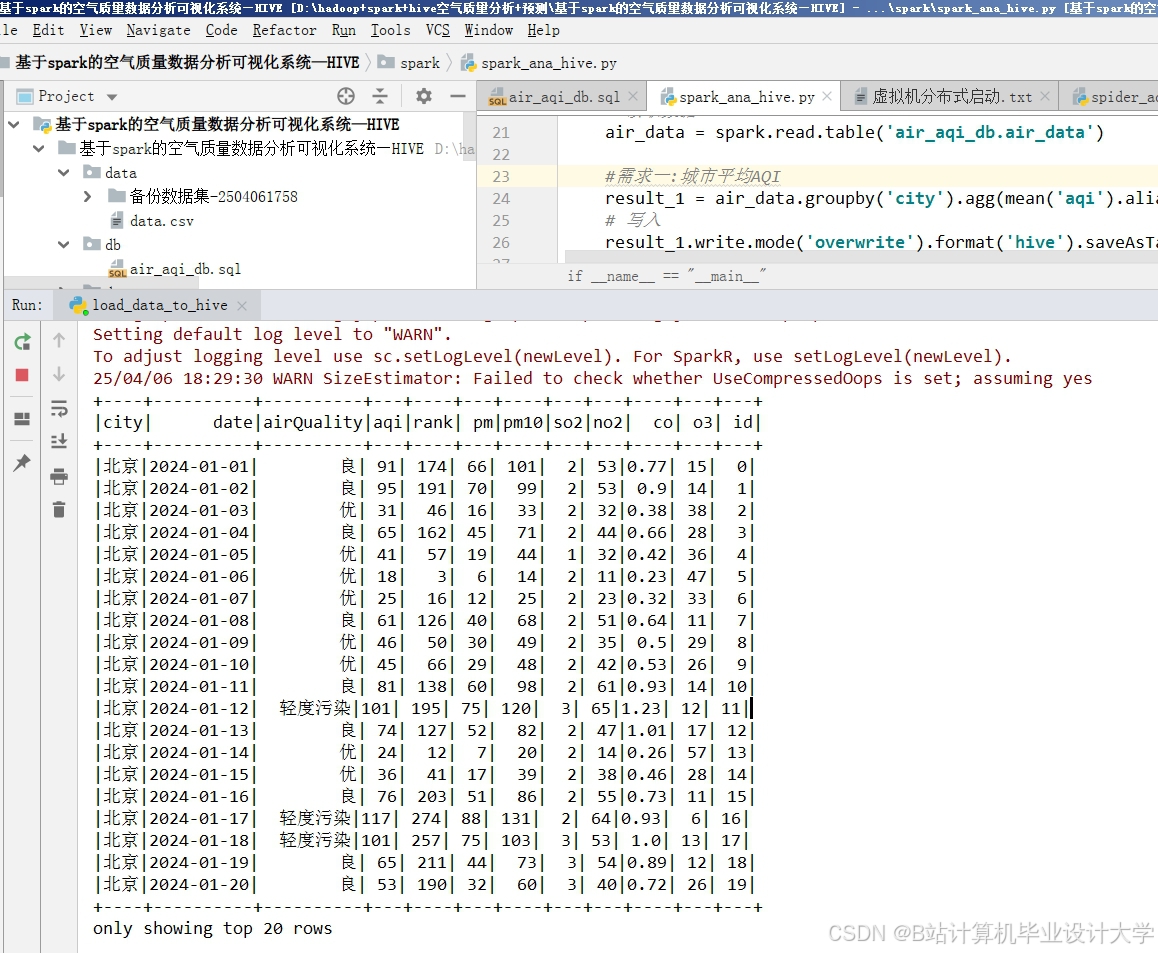

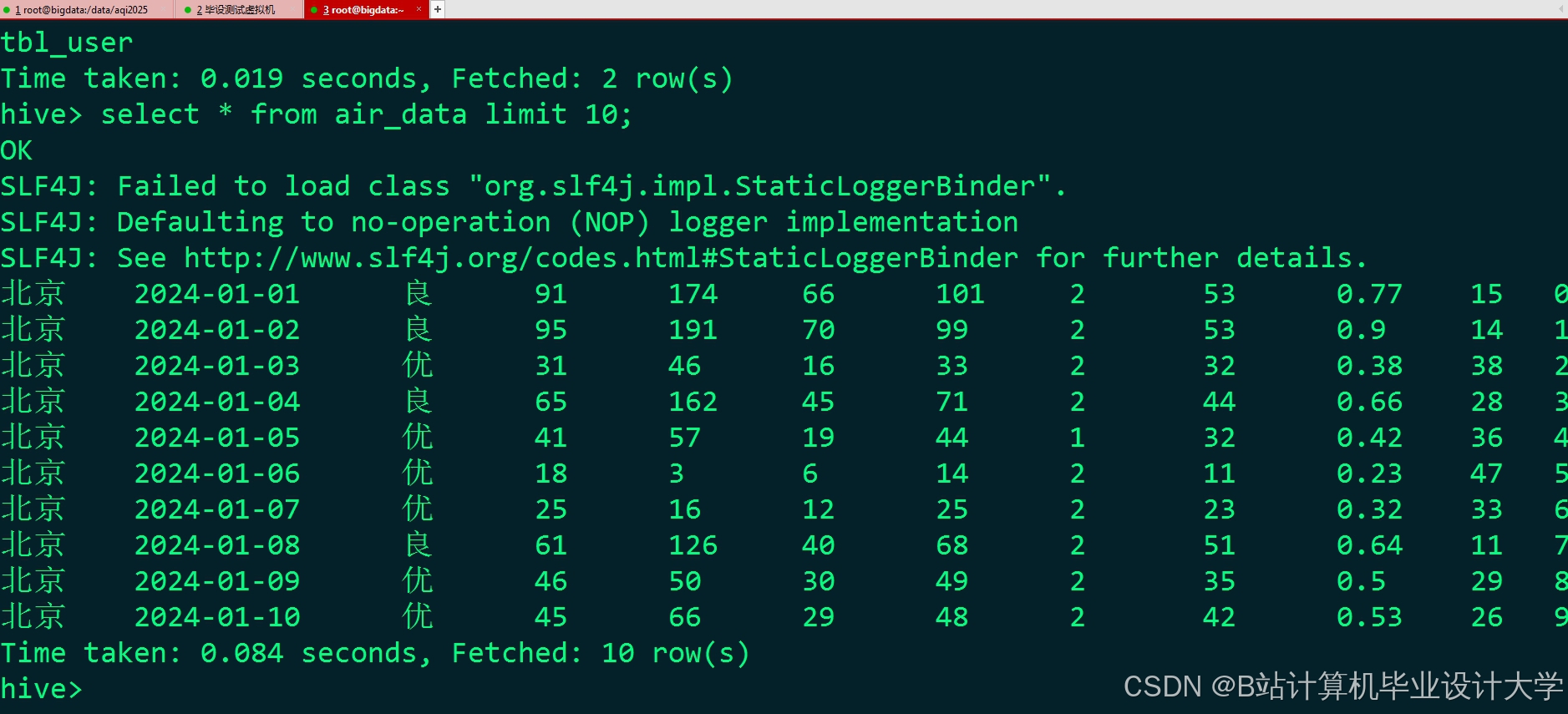

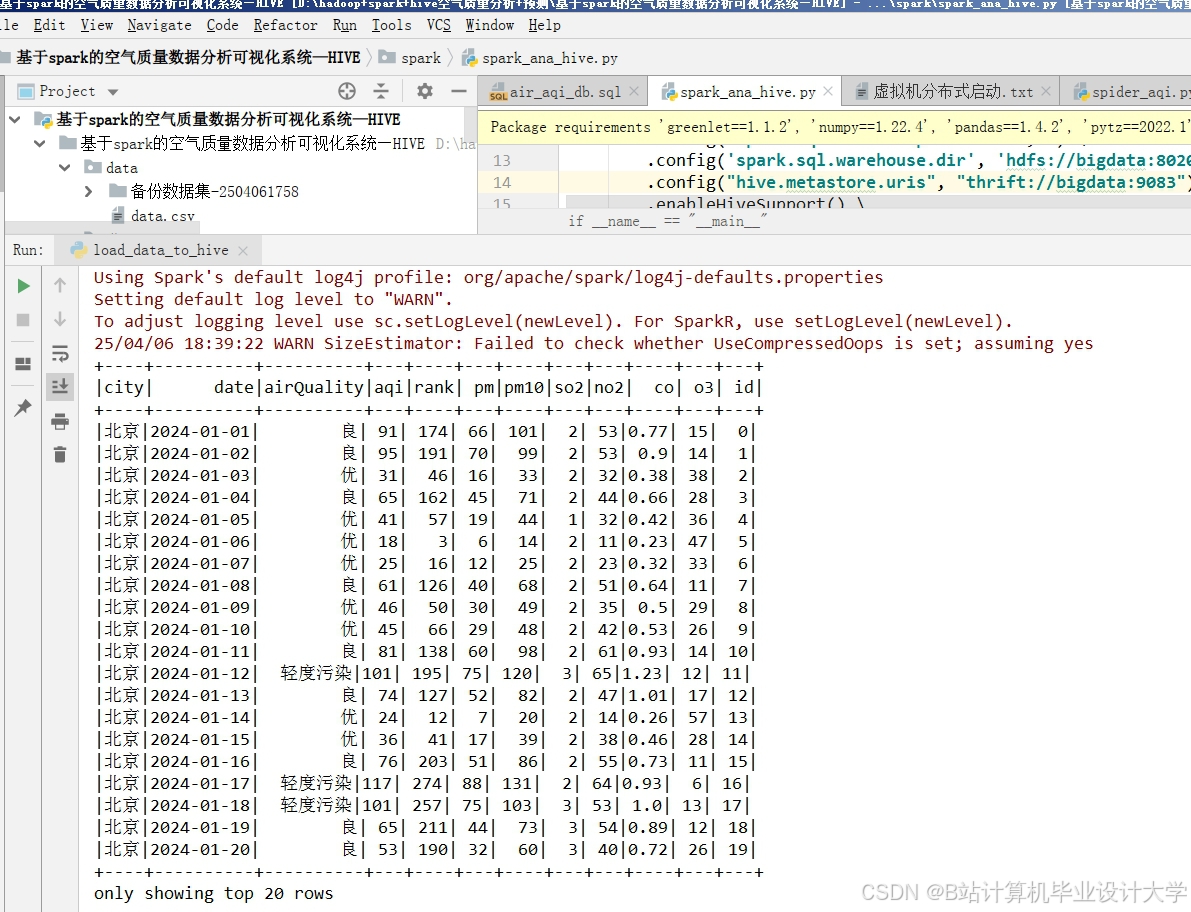

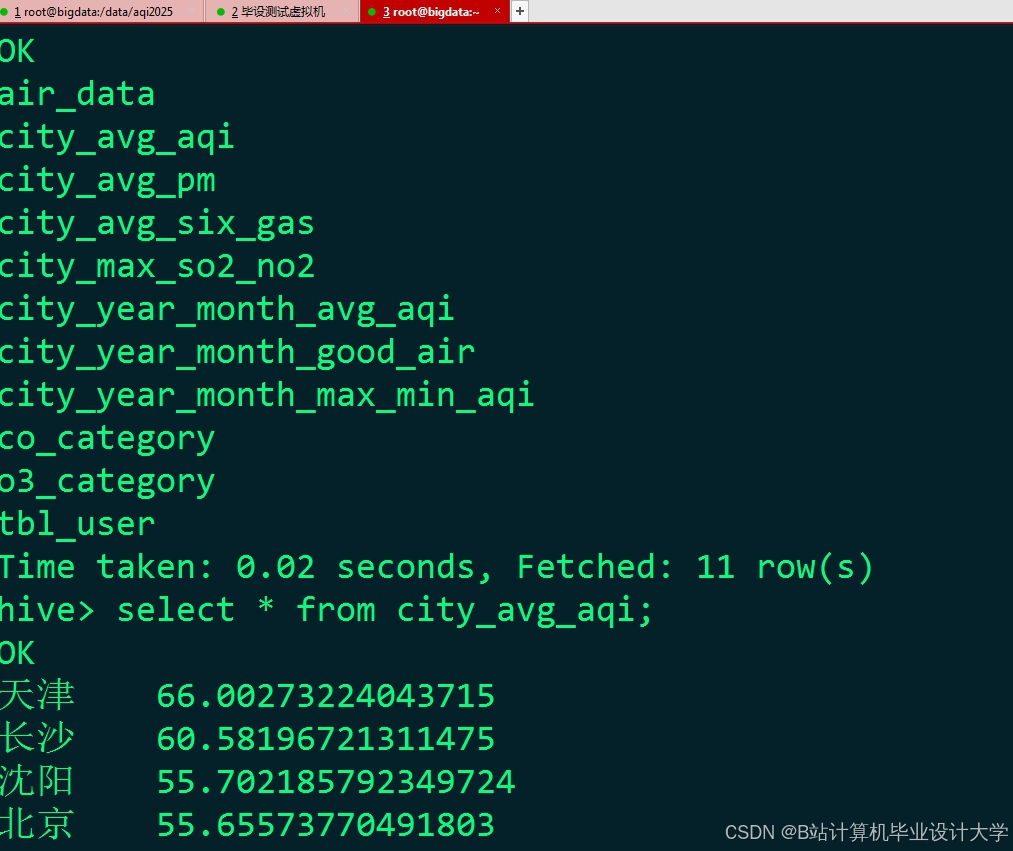

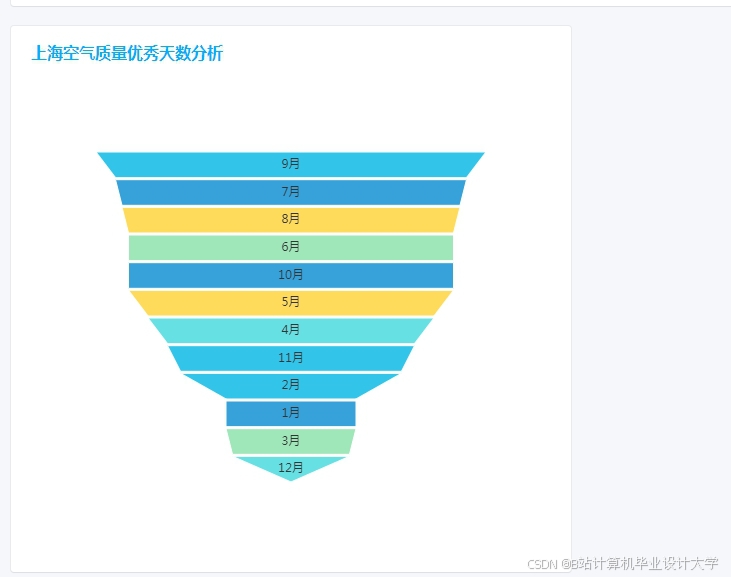

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

928

928

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?