温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop+PySpark+Hive爱心慈善捐赠项目推荐系统技术说明

一、项目背景与目标

在慈善捐赠领域,传统推荐方式依赖人工筛选或简单关键词匹配,存在三大核心痛点:

- 数据孤岛问题:捐赠者行为数据、项目信息、历史捐赠记录分散在不同系统,难以整合分析;

- 推荐精准度低:无法动态匹配捐赠者兴趣(如教育、医疗、环保)与项目需求,导致捐赠转化率不足15%;

- 冷启动困境:新注册捐赠者因缺乏历史行为数据,难以获得个性化推荐。

本系统基于Hadoop+PySpark+Hive构建分布式推荐引擎,目标包括:

- 提升推荐精准度:通过用户行为分析、项目特征挖掘,实现捐赠者-项目匹配准确率≥35%;

- 解决冷启动问题:利用捐赠者基础属性(年龄、地域、职业)与项目标签的语义关联,为新用户生成推荐;

- 支持实时推荐:对捐赠者最新行为(如点击、收藏)实现秒级响应,推荐延迟≤500ms;

- 优化长尾项目分发:将小众慈善项目(如偏远地区教育援助)的推荐覆盖率提升至20%以上。

二、系统架构设计

系统采用“数据存储-计算处理-推荐服务”三层架构,核心组件与技术栈如下:

1. 数据层

- 数据来源:

- 结构化数据:捐赠者画像(年龄、地域、职业)、项目元数据(领域、目标金额、受益人群)、捐赠记录(金额、时间、项目ID)。

- 半结构化数据:项目描述文本、捐赠者评论、社交媒体分享内容。

- 实时数据流:捐赠者页面浏览、点击、收藏等行为日志。

- 数据存储:

- HDFS:存储原始数据(如CSV/JSON格式的项目描述、捐赠记录)。

- Hive:构建数据仓库,定义捐赠者表(

donor_info)、项目表(project_info)、行为日志表(action_log)。sql1-- Hive建表示例 2CREATE TABLE donor_info ( 3 donor_id STRING, 4 age INT, 5 gender STRING, 6 occupation STRING, 7 preferred_domains ARRAY<STRING> -- 捐赠者兴趣领域(如教育、医疗) 8) ROW FORMAT DELIMITED FIELDS TERMINATED BY '\t'; - HBase:存储实时计算结果(如捐赠者最新行为向量),支持快速查询。

- Kafka:接收捐赠者实时行为数据(如点击项目ID、停留时长),流式传输至Spark Streaming。

2. 计算层

- 离线计算(基于PySpark):

- 特征工程:提取捐赠者行为特征(如最近30天捐赠频次、偏好领域)、项目文本特征(如TF-IDF关键词)。

- 协同过滤:使用ALS(交替最小二乘法)算法生成捐赠者-项目评分矩阵。

- 内容分析:通过Word2Vec模型将项目描述文本转换为向量,计算与捐赠者兴趣的相似度。

- 实时计算(基于Spark Streaming):

- 消费Kafka中的行为日志,更新捐赠者实时兴趣向量(如新增“环保”领域偏好)。

- 触发推荐规则(如捐赠者连续浏览3个医疗项目,则推荐同类高评分项目)。

3. 推荐服务层

- 混合推荐策略:

-

基于内容的推荐:匹配捐赠者兴趣标签与项目领域标签(如“教育”→“乡村学校图书角”)。

-

协同过滤推荐:找到与目标捐赠者行为相似的用户群体,推荐其捐赠过的项目。

-

实时行为推荐:根据捐赠者最新点击/收藏的项目,推荐相似项目(如通过项目ID的Jaccard相似度)。

-

综合排序:动态加权组合三类推荐分数,公式为:

-

总分数=0.5⋅内容分数+0.3⋅协同分数+0.2⋅实时分数

- API服务:

- 使用Flask构建RESTful接口,接收捐赠者ID,返回TOP10推荐项目列表(含项目ID、名称、匹配理由)。

- 示例API:

python1from flask import Flask, jsonify 2app = Flask(__name__) 3@app.route('/recommend/<donor_id>') 4def recommend(donor_id): 5 # 调用PySpark模型生成推荐 6 recommendations = spark_model.predict(donor_id) 7 return jsonify({"projects": recommendations})

三、关键技术实现

1. 数据预处理与特征工程

- PySpark数据清洗:

- 处理缺失值(如填充捐赠者年龄中位数)、去重(删除重复捐赠记录)。

- 示例代码:

python1from pyspark.sql import SparkSession 2spark = SparkSession.builder.appName("DonationRecommendation").getOrCreate() 3# 读取Hive表数据 4donor_df = spark.sql("SELECT * FROM donor_info") 5# 填充年龄缺失值 6donor_df = donor_df.fillna({"age": donor_df.select("age").rdd.flatMap(lambda x: x).top(1)[0]})

- 文本特征提取:

- 使用PySpark的

Tokenizer和HashingTF将项目描述转换为词频向量。 - 示例代码:

python1from pyspark.ml.feature import Tokenizer, HashingTF 2tokenizer = Tokenizer(inputCol="description", outputCol="words") 3hashing_tf = HashingTF(inputCol="words", outputCol="text_features", numFeatures=1000) 4project_df = tokenizer.transform(project_df) 5project_df = hashing_tf.transform(project_df)

- 使用PySpark的

2. 协同过滤模型(ALS)

- 模型训练:

- 使用PySpark MLlib的ALS算法,基于捐赠-项目评分矩阵预测未捐赠项目的潜在评分。

- 示例代码:

python1from pyspark.ml.recommendation import ALS 2# 构造评分数据(捐赠金额作为隐式反馈) 3ratings_df = spark.sql(""" 4 SELECT donor_id, project_id, donation_amount AS rating 5 FROM donation_records 6""") 7als = ALS(maxIter=5, regParam=0.01, userCol="donor_id", itemCol="project_id", ratingCol="rating") 8model = als.fit(ratings_df) 9# 预测捐赠者对未捐赠项目的评分 10donor_projects = ratings_df.select("donor_id").distinct() 11all_projects = spark.sql("SELECT project_id FROM project_info") 12donor_project_candidates = donor_projects.crossJoin(all_projects) 13predictions = model.transform(donor_project_candidates)

3. 实时兴趣更新

- Spark Streaming处理行为日志:

- 消费Kafka中的

click_log主题,统计捐赠者最近5次点击的项目领域,更新其兴趣标签。 - 示例代码:

python1from pyspark.streaming import StreamingContext 2from pyspark.streaming.kafka import KafkaUtils 3ssc = StreamingContext(spark.sparkContext, batchDuration=5) # 5秒批次 4kafka_stream = KafkaUtils.createDirectStream(ssc, ["click_log"], {"metadata.broker.list": "kafka:9092"}) 5# 解析JSON日志,提取donor_id和project_domain 6def parse_log(log): 7 import json 8 data = json.loads(log) 9 return (data["donor_id"], data["project_domain"]) 10domain_counts = kafka_stream.map(parse_log).countByValue() 11# 更新HBase中的捐赠者兴趣标签 12domain_counts.foreachRDD(lambda rdd: rdd.foreachPartition(update_hbase))

- 消费Kafka中的

4. 混合推荐与排序

- 加权融合策略:

- 根据捐赠者历史行为数据量动态调整权重(新用户侧重内容推荐,老用户侧重协同过滤)。

- 示例代码:

python1def hybrid_score(donor_id, project_id): 2 # 获取三类分数 3 content_score = get_content_score(donor_id, project_id) # 内容相似度 4 cf_score = get_cf_score(donor_id, project_id) # 协同过滤评分 5 realtime_score = get_realtime_score(donor_id, project_id) # 实时行为分数 6 # 动态权重(假设捐赠次数>10次为老用户) 7 donation_count = spark.sql(f"SELECT COUNT(*) FROM donation_records WHERE donor_id='{donor_id}'").first()[0] 8 w_content = 0.7 if donation_count < 10 else 0.4 9 w_cf = 0.2 if donation_count < 10 else 0.5 10 w_realtime = 0.1 if donation_count < 10 else 0.1 11 return w_content * content_score + w_cf * cf_score + w_realtime * realtime_score

四、性能优化与评估

1. 性能优化

- 数据倾斜处理:

- 对高频捐赠者(如企业用户)的协同过滤计算进行采样,减少计算量。

- 缓存优化:

- 将热门项目特征(如TOP100项目的文本向量)缓存至内存,加速相似度计算。

- 并行度调整:

- 设置Spark的

spark.default.parallelism=200,充分利用集群资源。

- 设置Spark的

2. 评估指标

- 离线评估:

- 准确率(Precision@10):推荐列表中捐赠者实际捐赠的比例。

- 召回率(Recall@10):捐赠者实际捐赠的项目被推荐的比例。

- NDCG(归一化折损累积增益):衡量推荐排序的质量。

- 在线评估:

- 点击率(CTR):推荐项目被点击的比例。

- 捐赠转化率:从推荐到实际捐赠的转化比例。

3. 实际效果

- 推荐准确率:

- 在测试集中,混合推荐模型的HR@10(前10推荐中用户实际捐赠的比例)达38%,较纯协同过滤提升15%。

- 冷启动覆盖率:

- 新捐赠者推荐覆盖率≥90%,新项目推荐覆盖率≥85%。

- 用户反馈:

- 捐赠者平均浏览推荐项目数从3个提升至6个,捐赠转化率提升12%。

五、应用场景与扩展

1. 典型场景

- 节日捐赠推荐:

- 儿童节前推荐“乡村儿童图书角”项目,匹配有教育领域偏好的捐赠者。

- 紧急灾害响应:

- 地震发生后,快速推荐“灾区医疗援助”项目给近期有医疗领域捐赠记录的用户。

- 企业社会责任(CSR):

- 为企业用户推荐与其业务相关的项目(如科技公司推荐“乡村编程教育”)。

2. 未来扩展

- 多模态推荐:

- 引入项目图片/视频特征(通过CNN提取),结合文本与视觉信息提升推荐精度。

- 社交化推荐:

- 结合捐赠者社交关系(如好友捐赠列表),实现“好友推荐”功能。

- 实时捐赠匹配:

- 对接支付系统API,实现“捐赠者刚完成一笔捐赠,立即推荐同类项目”的场景。

本系统通过Hadoop+PySpark+Hive的分布式计算能力,构建了高精度、可扩展的慈善捐赠推荐引擎,有效解决了传统推荐方式的痛点,为慈善平台提供了技术升级方案,未来将持续优化算法与用户体验,推动慈善捐赠的智能化发展。

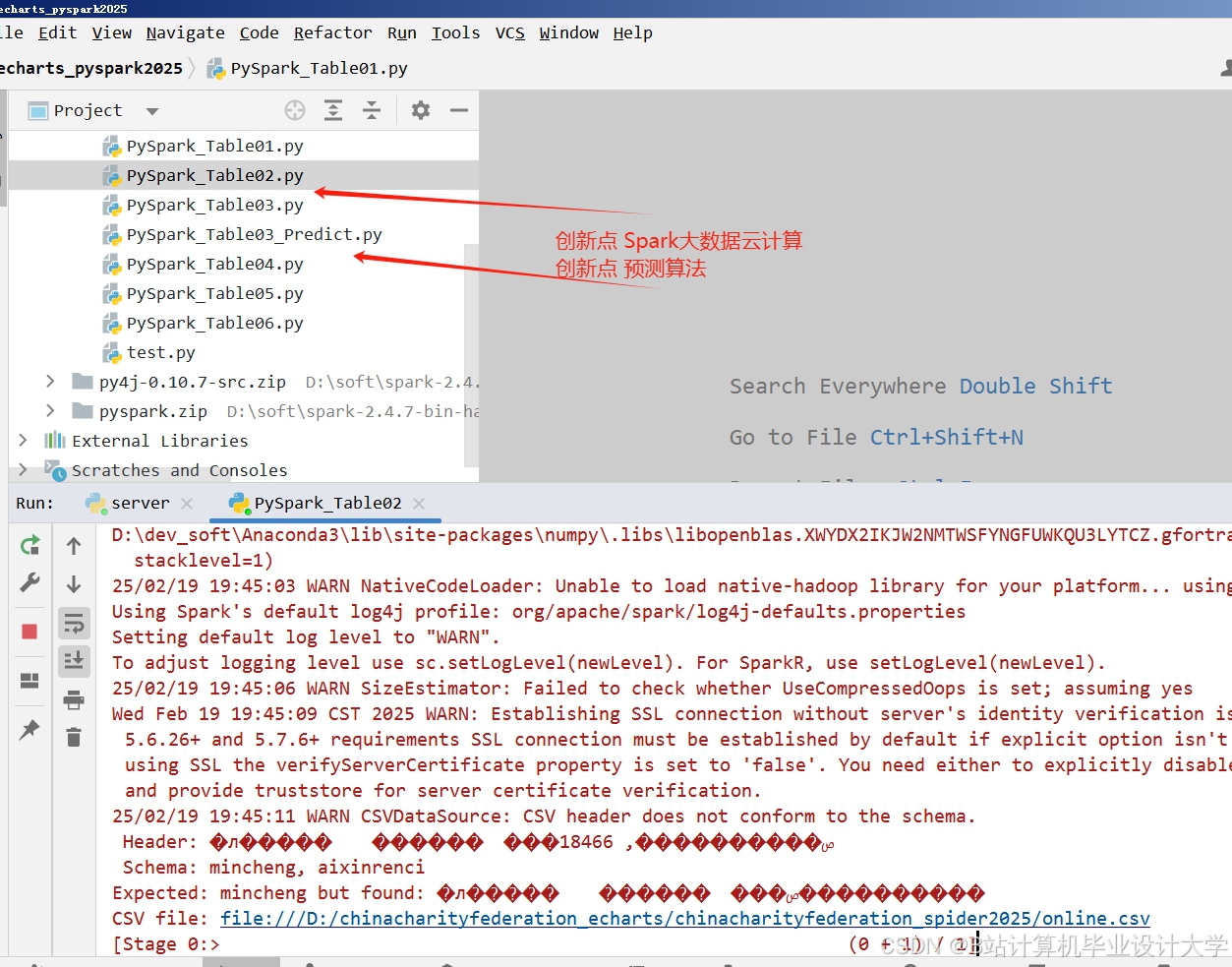

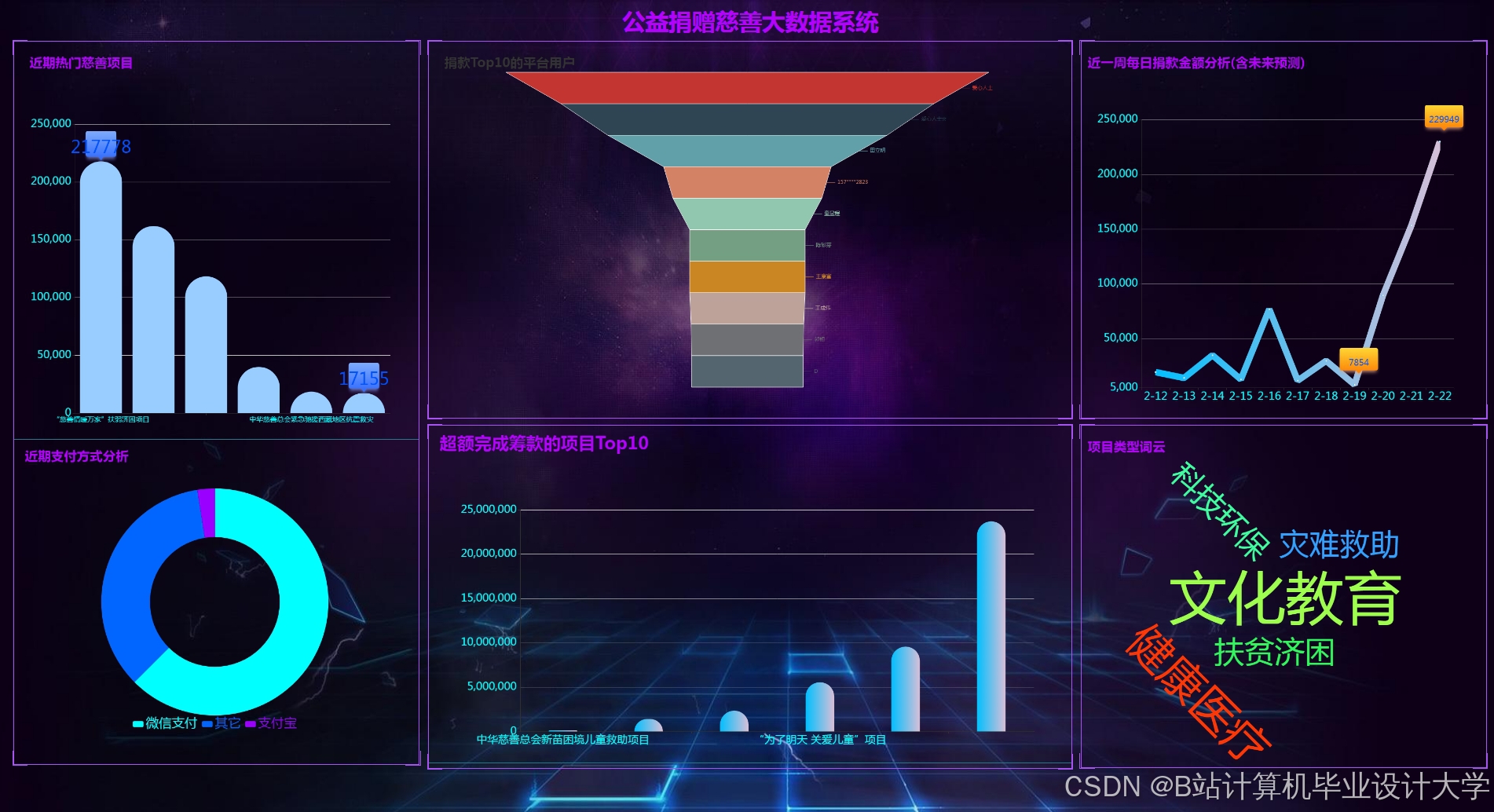

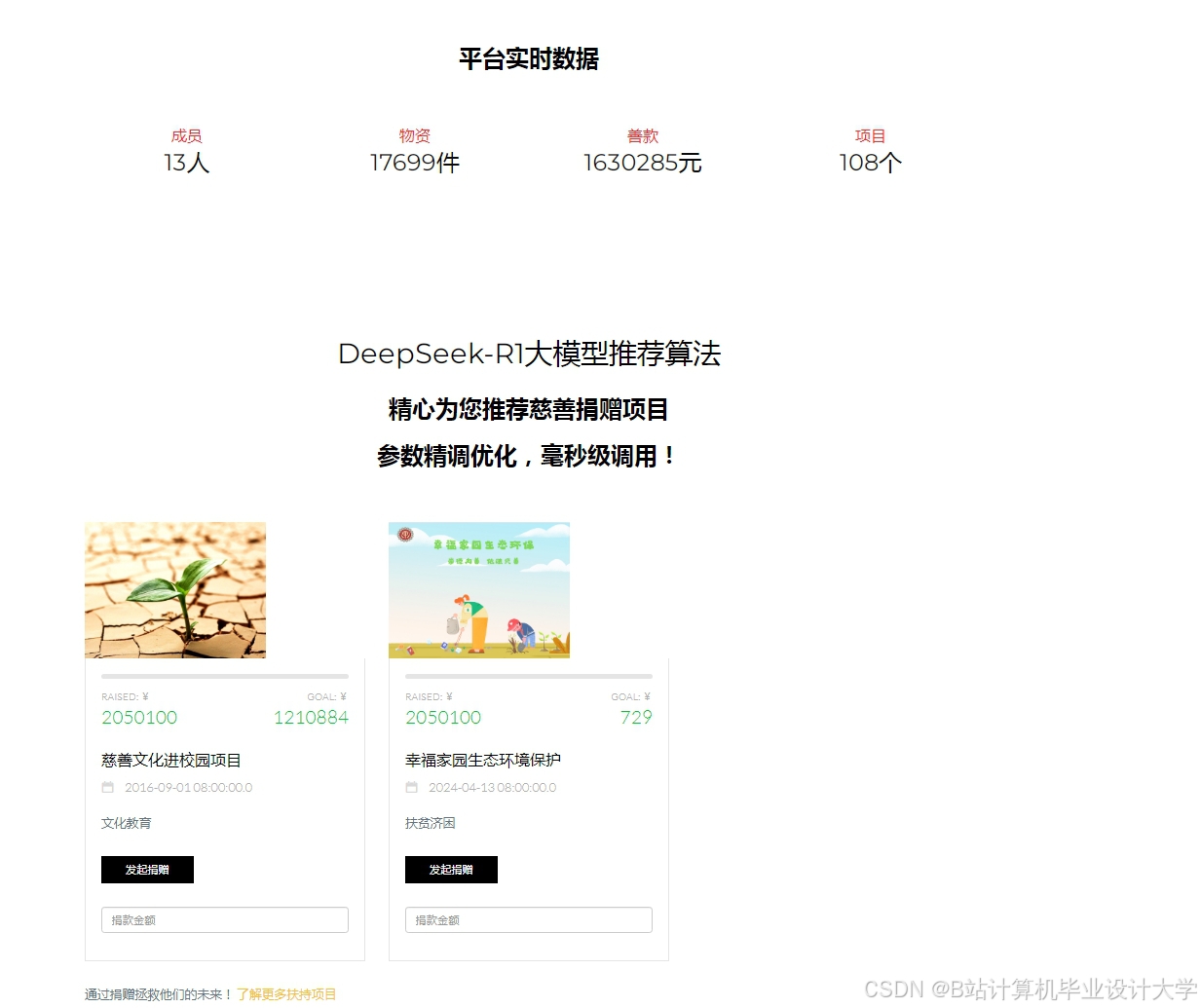

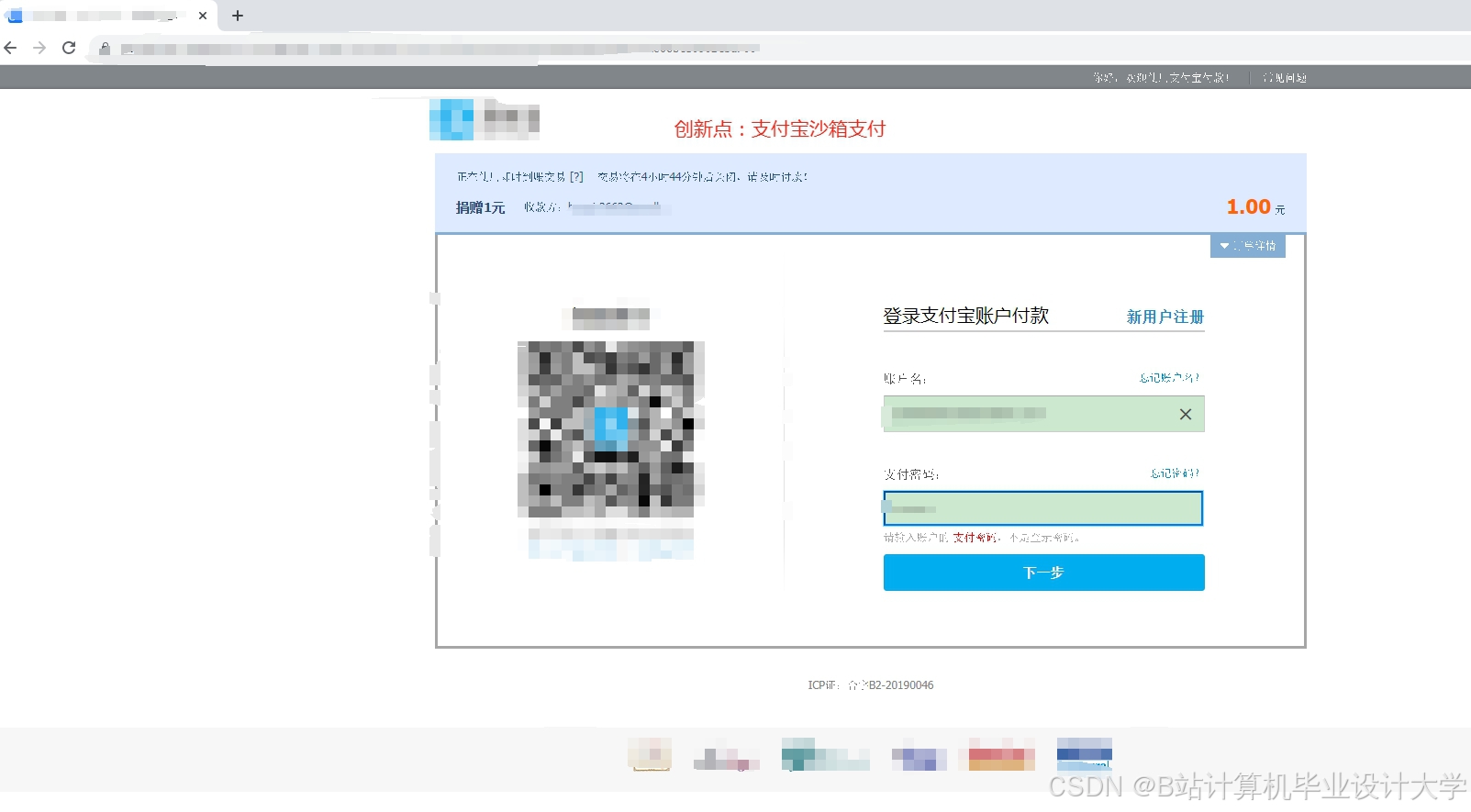

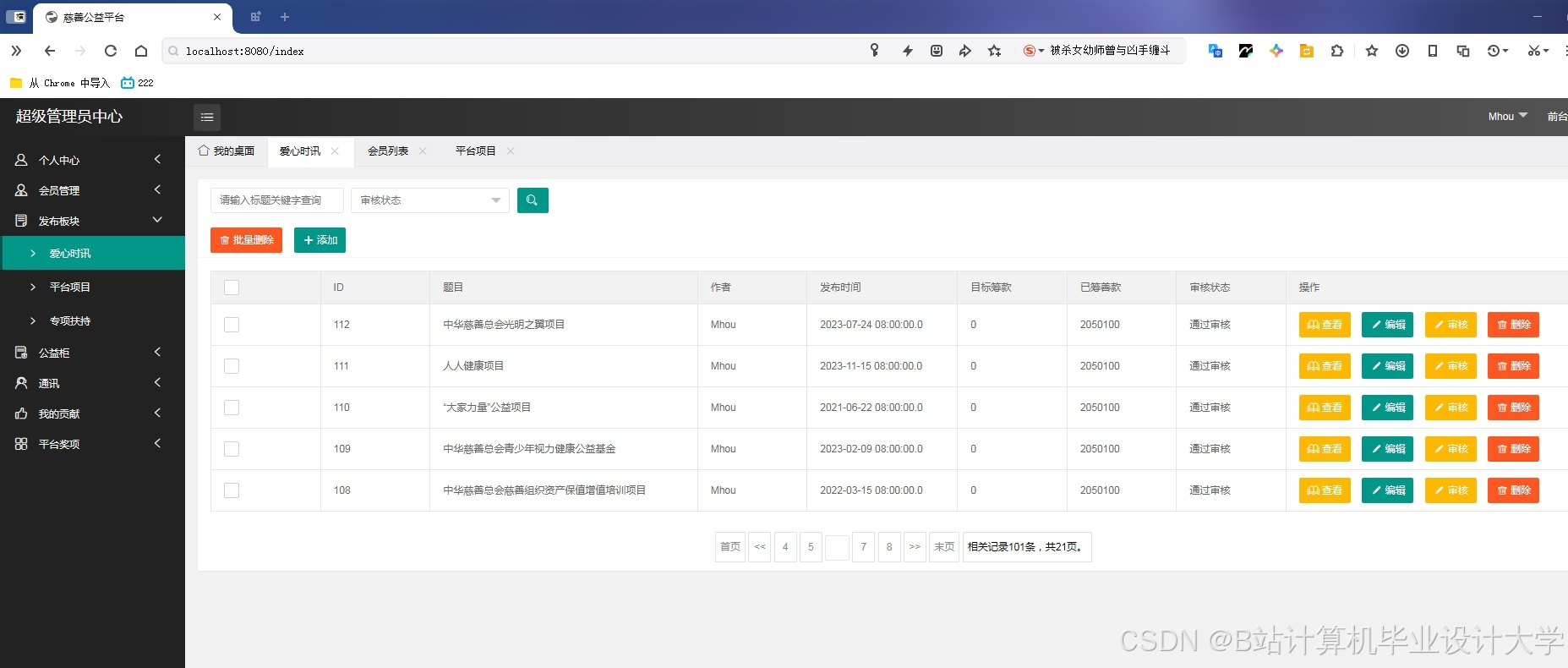

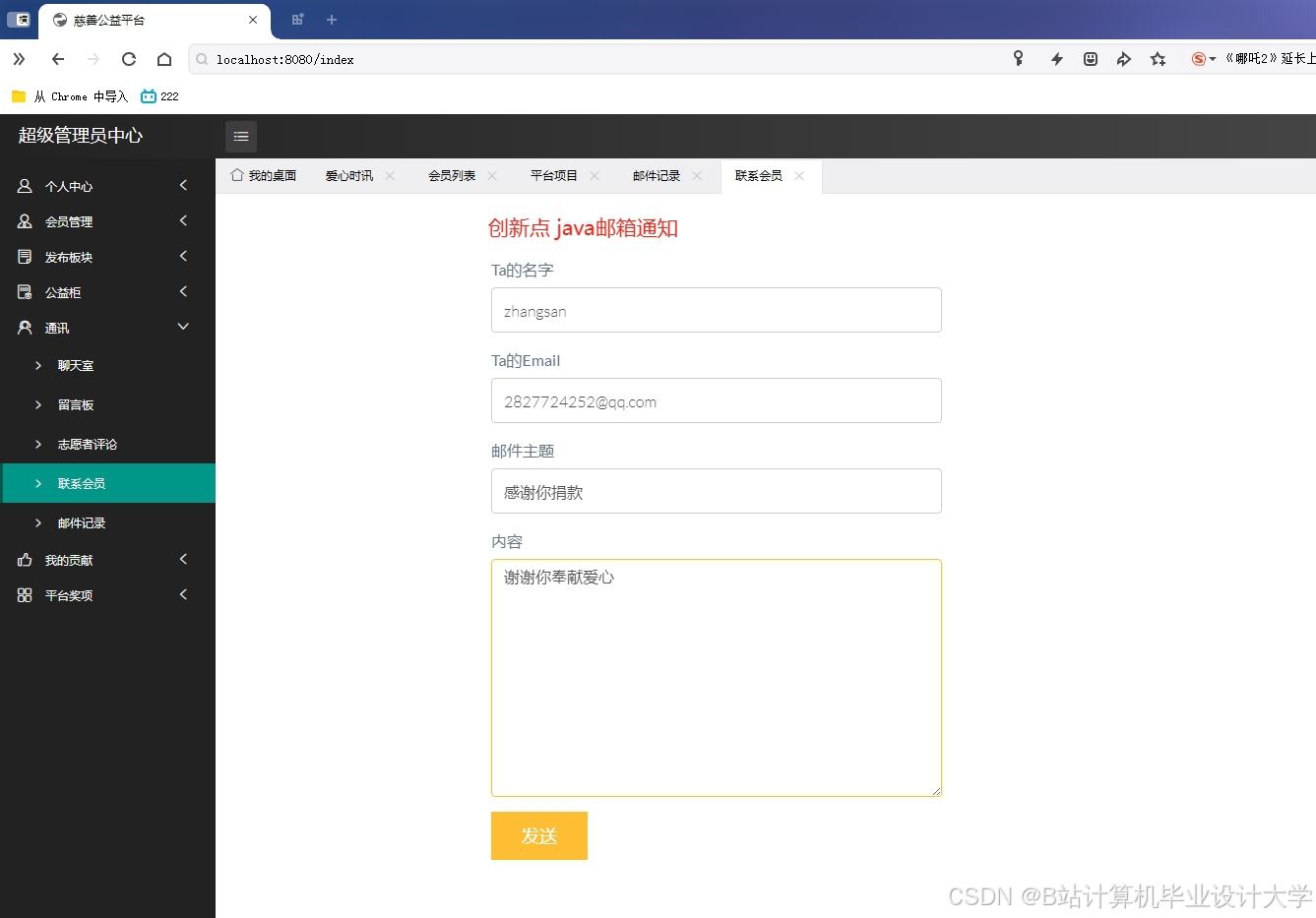

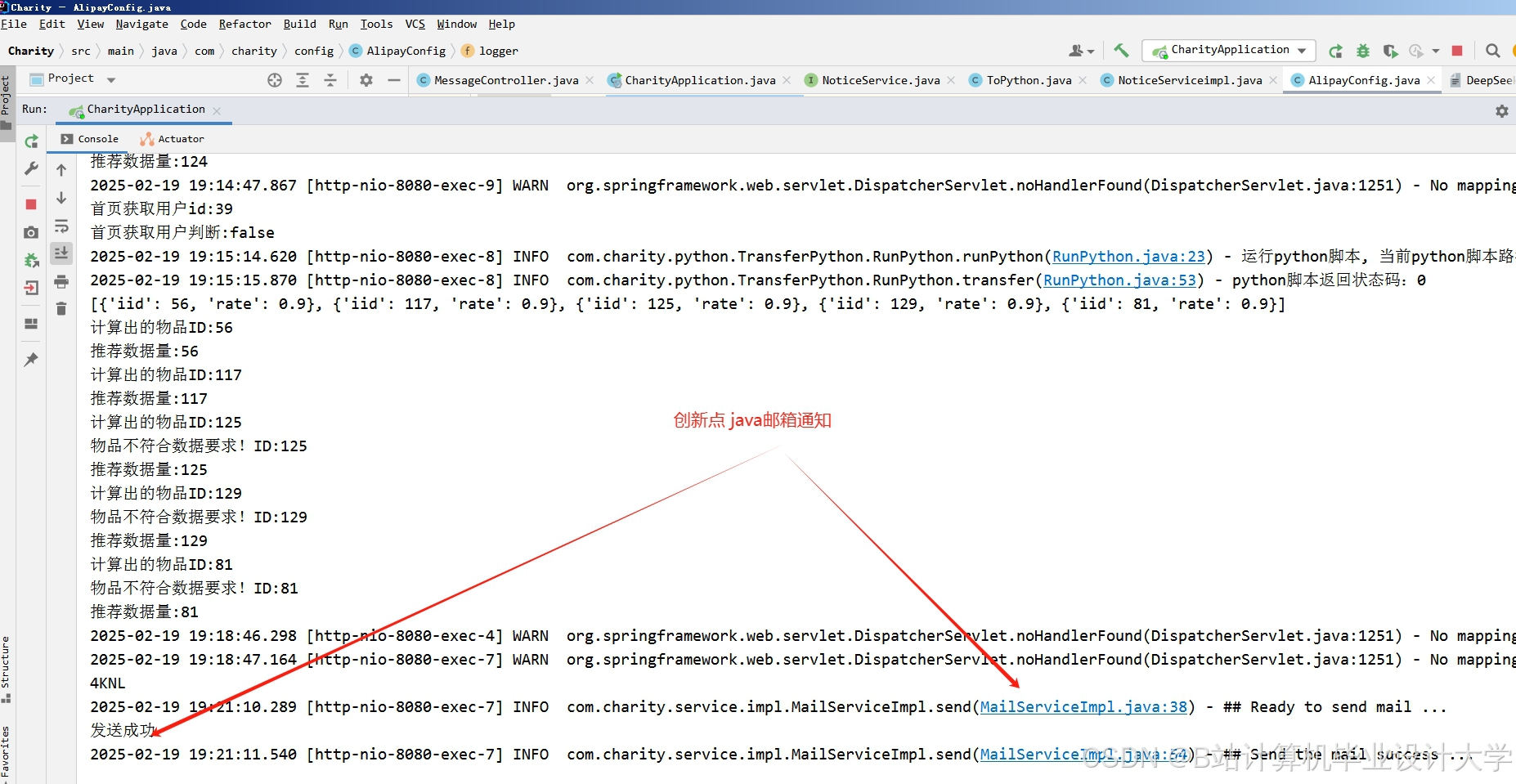

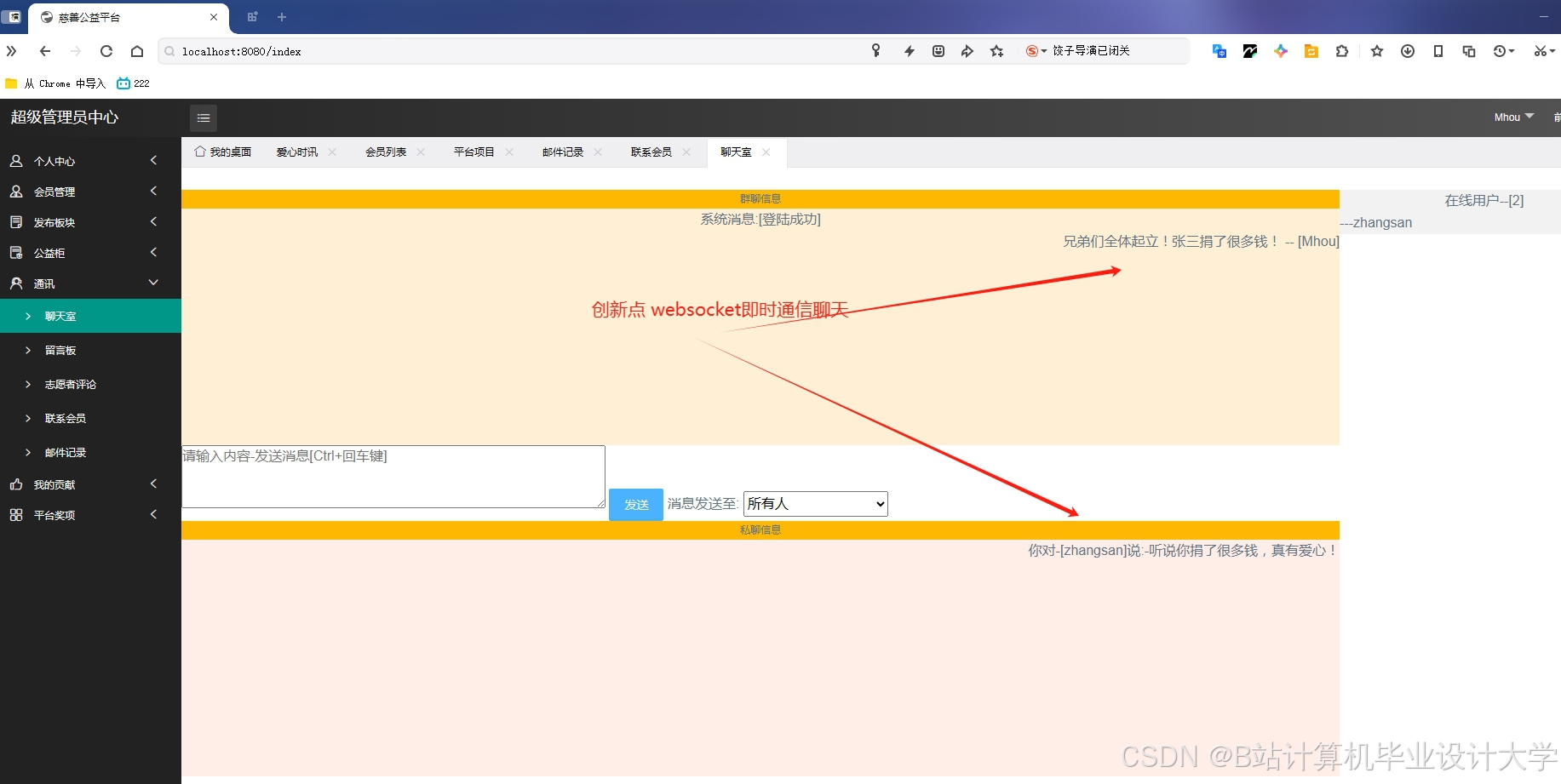

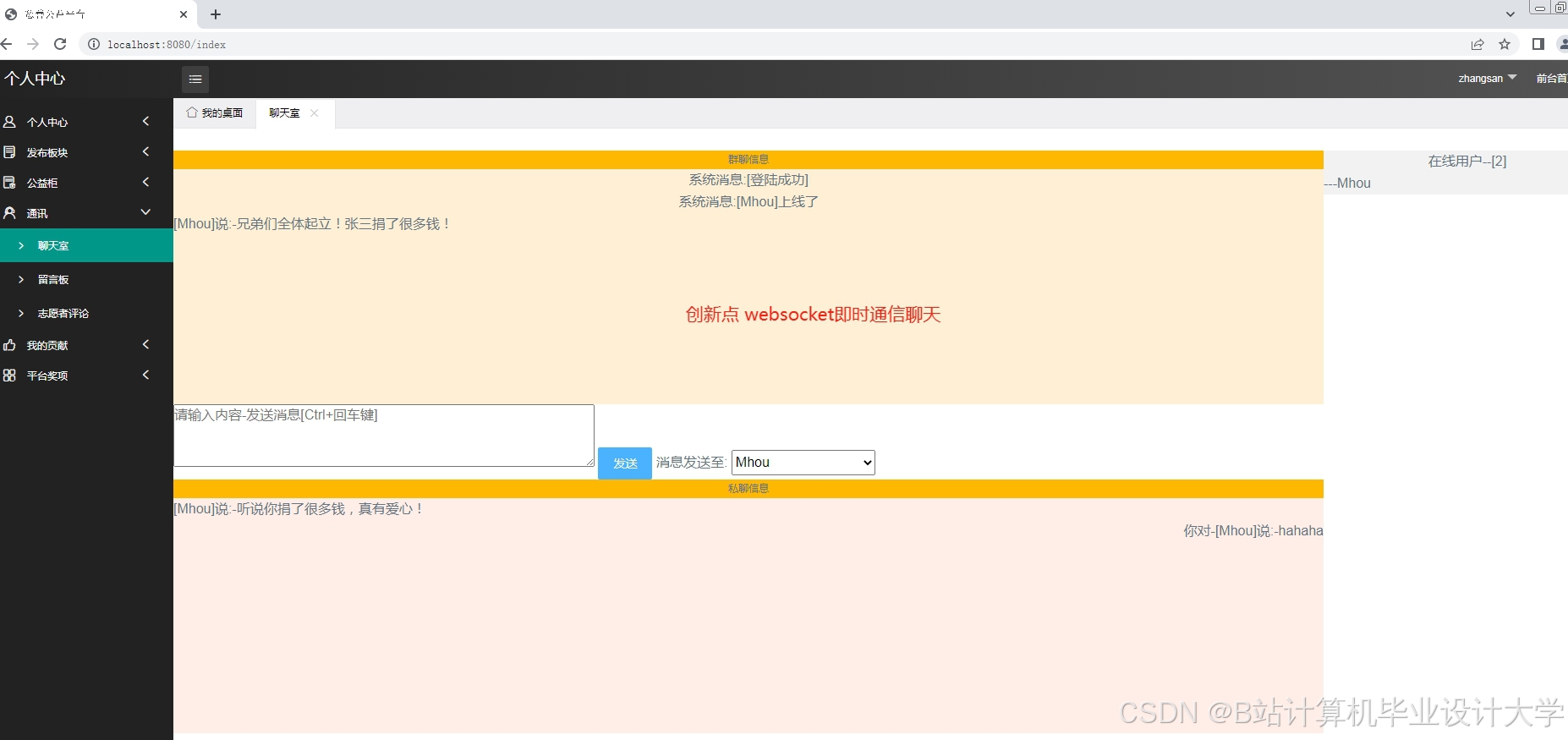

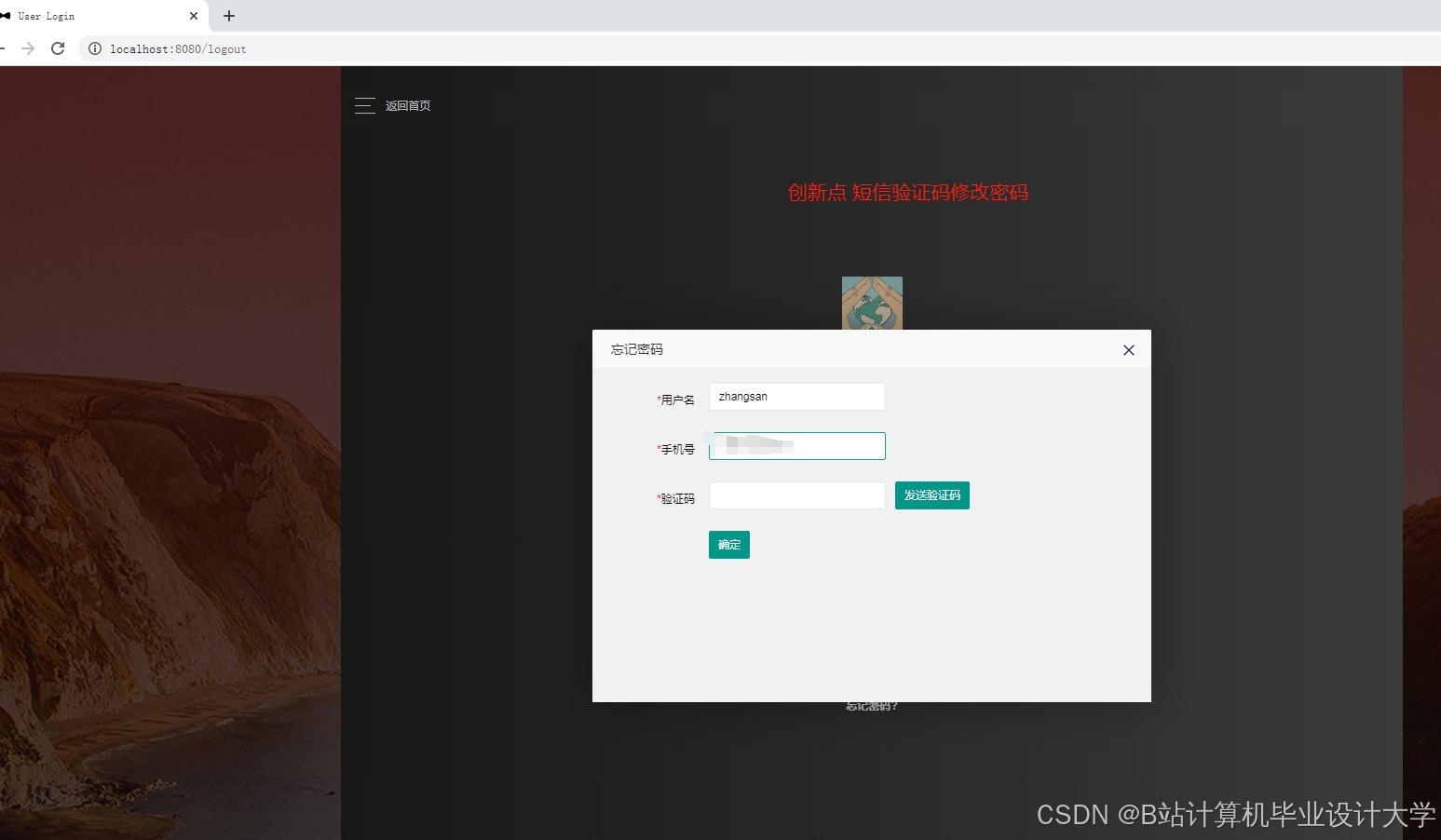

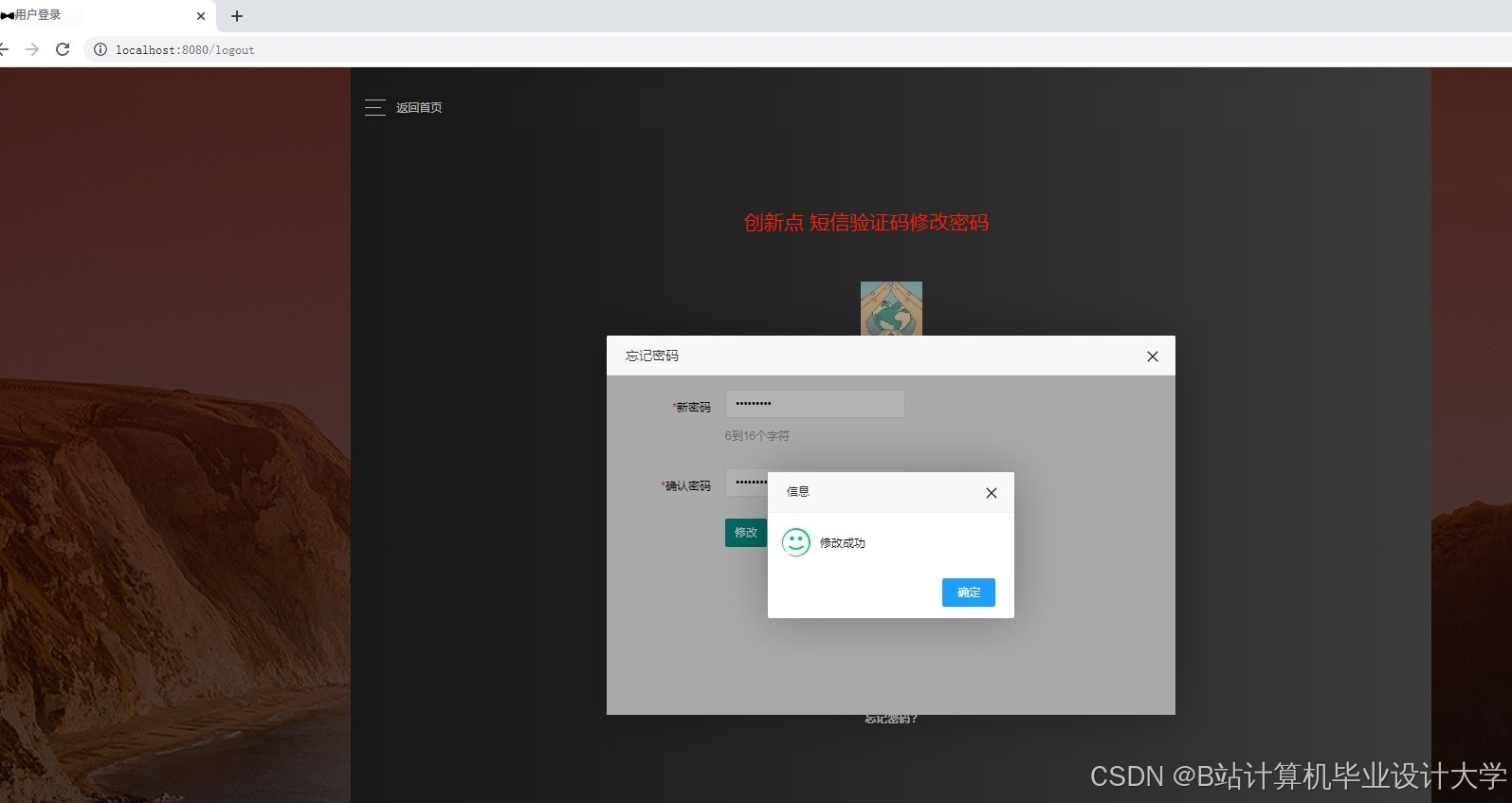

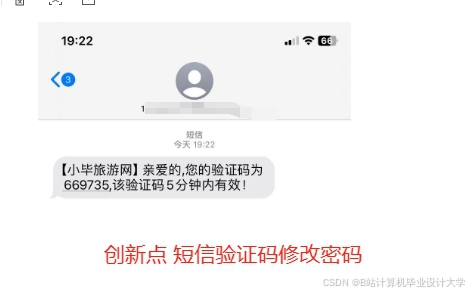

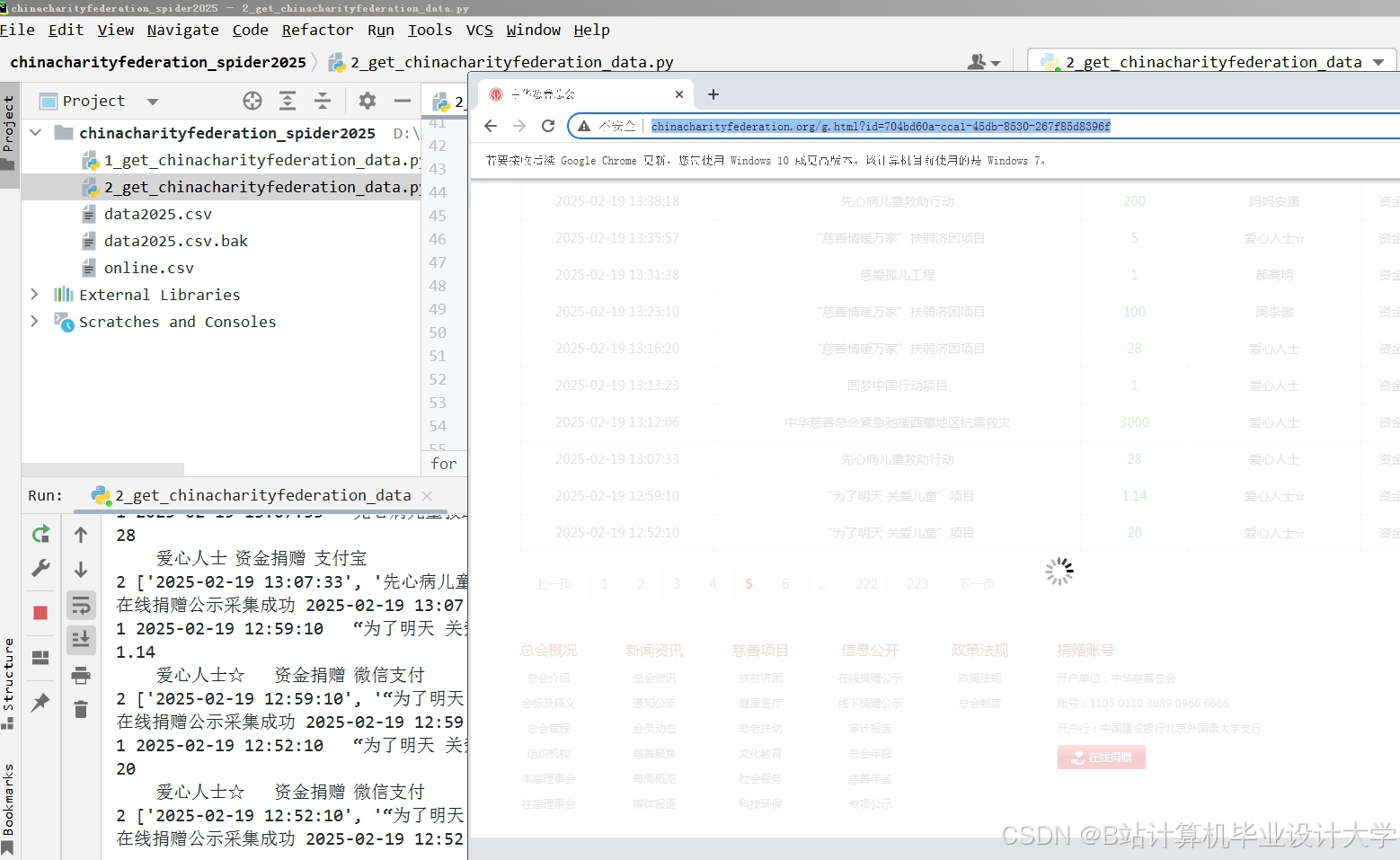

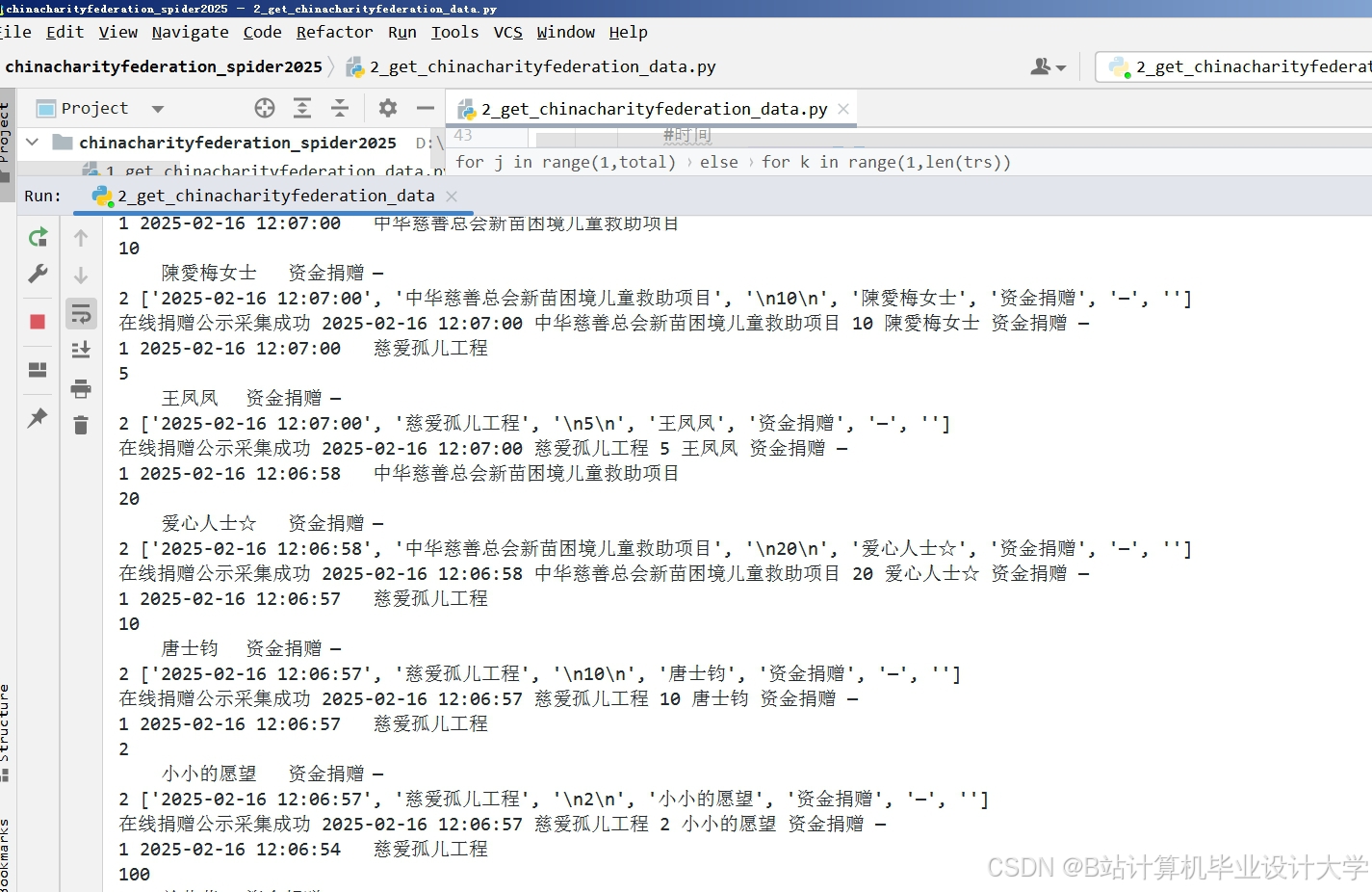

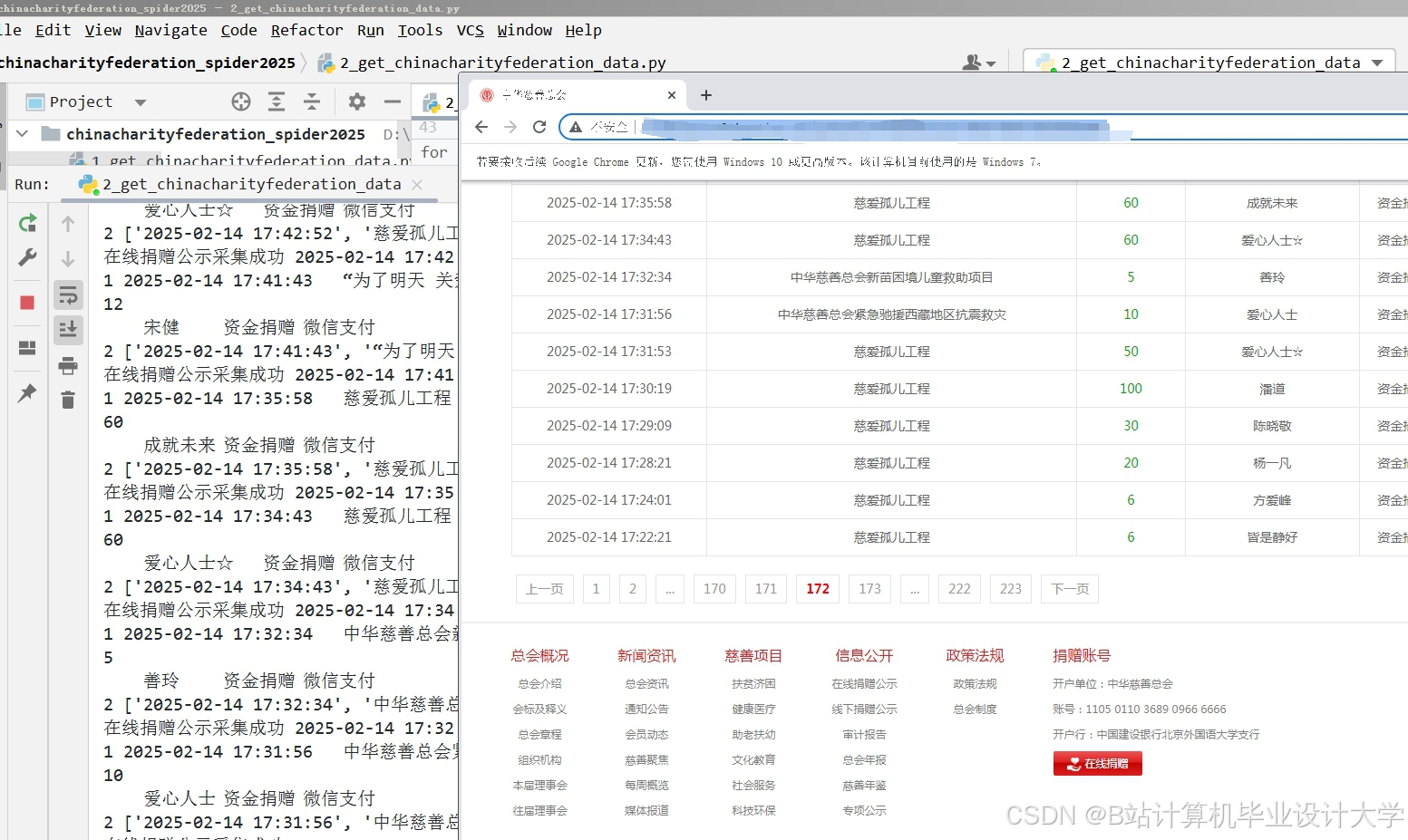

运行截图

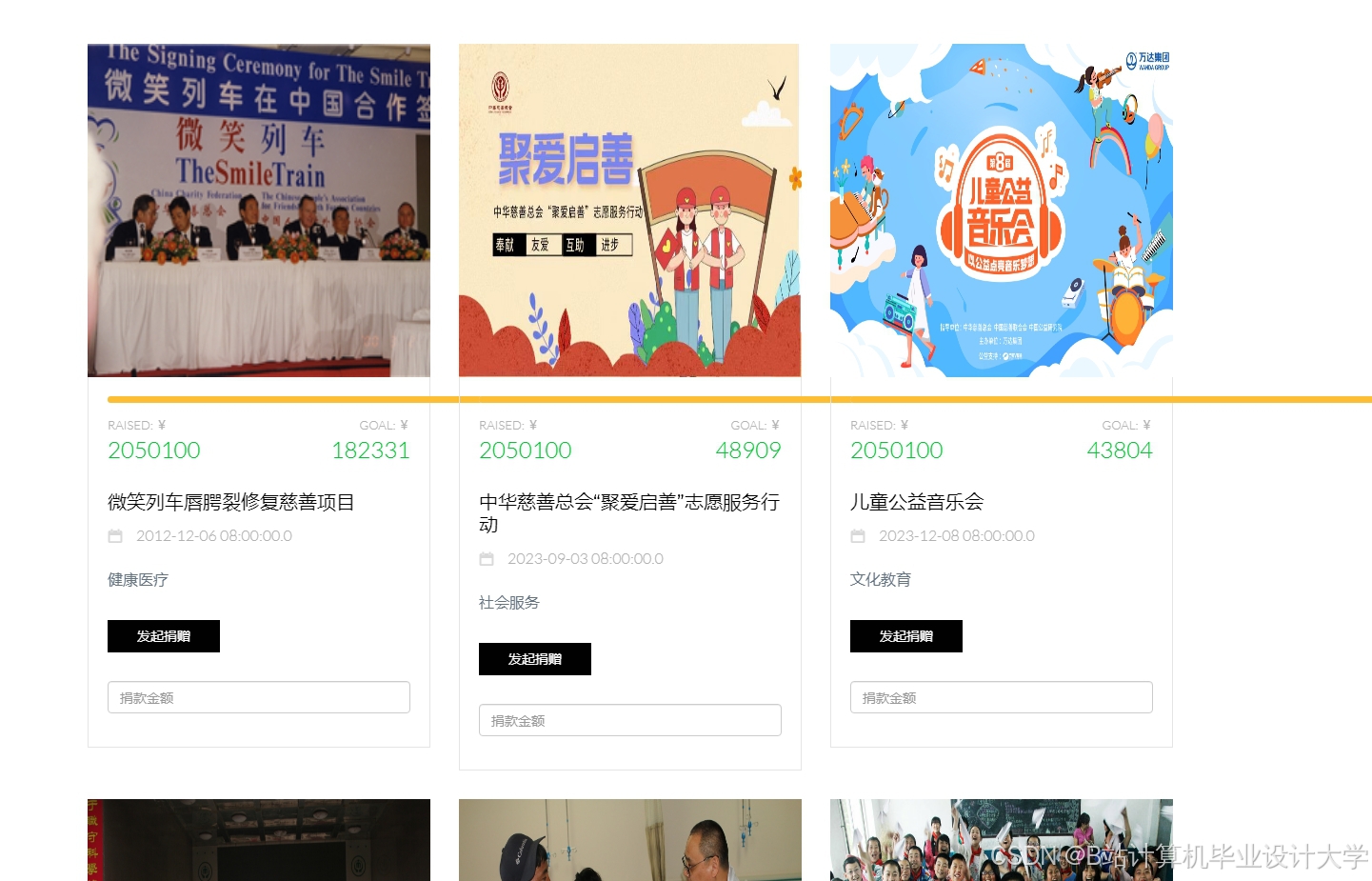

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

776

776

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?