温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一份关于《Hadoop+PySpark+Scrapy爬虫考研分数线预测》的任务书模板,供参考:

任务书:基于Hadoop+PySpark+Scrapy的考研分数线预测系统

一、项目背景与目标

-

背景

考研分数线受报考人数、试题难度、招生政策等多因素影响,传统预测方法依赖人工统计和简单模型,效率低且准确性不足。

大数据技术(Hadoop、PySpark)可处理海量历史数据,结合爬虫(Scrapy)实时获取动态信息,构建智能化预测模型。 -

目标

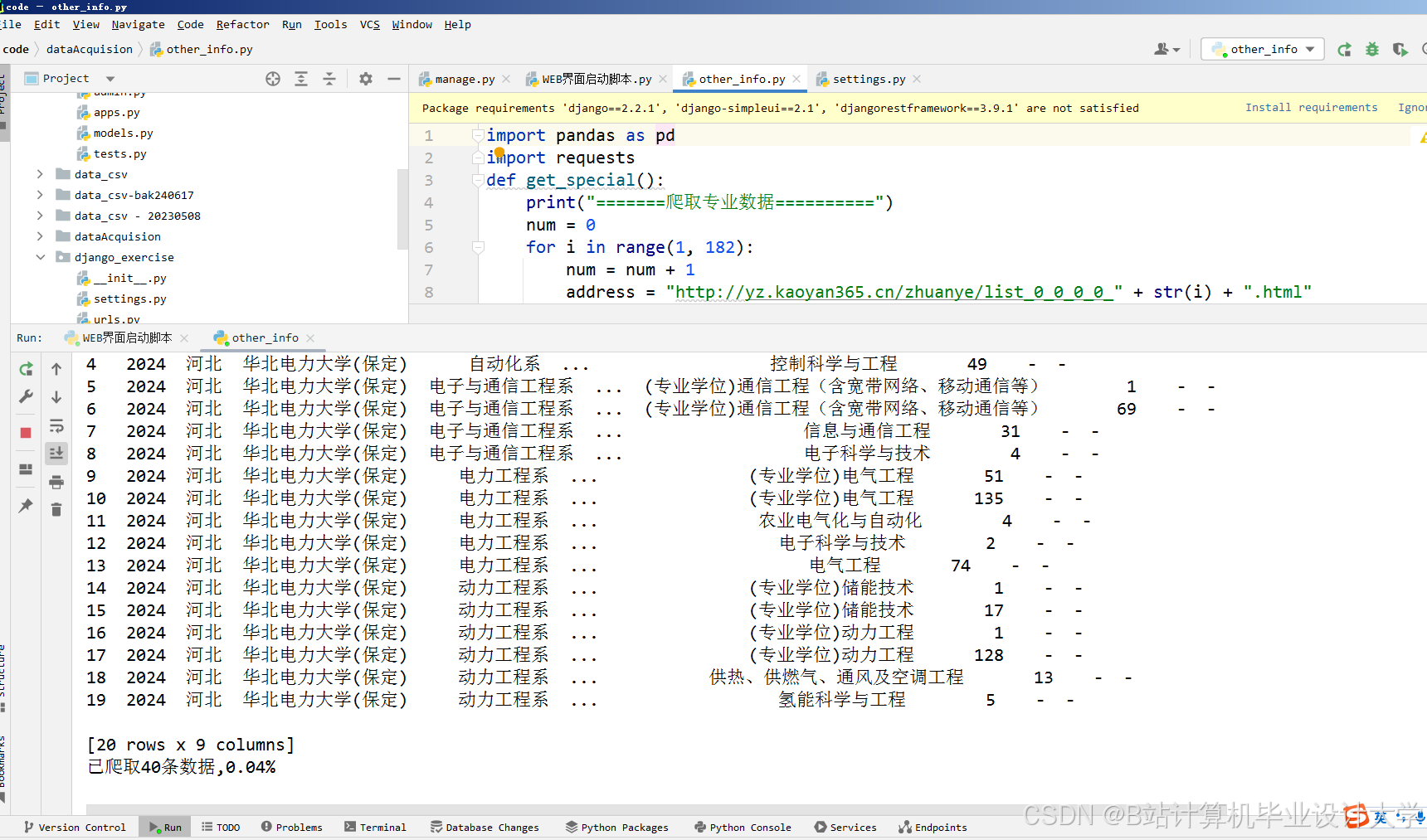

- 开发分布式爬虫系统,抓取考研相关数据(历史分数线、报考人数、院校招生计划等)。

- 构建基于Hadoop+PySpark的数据处理与分析平台,挖掘影响分数线的关键因素。

- 训练机器学习模型(如线性回归、随机森林),实现考研分数线的动态预测。

- 验证模型准确性,提供可视化预测结果。

二、任务分工与职责

- 数据采集组(Scrapy爬虫开发)

- 任务:

- 设计Scrapy爬虫框架,抓取目标网站(如研招网、各高校官网)的考研数据。

- 处理反爬机制(IP代理、User-Agent轮换、动态加载页面解析)。

- 存储原始数据至HDFS或本地数据库(MySQL/MongoDB)。

- 输出:原始数据集(CSV/JSON格式)。

- 任务:

- 数据处理组(Hadoop+PySpark)

- 任务:

- 搭建Hadoop集群,配置HDFS和YARN资源管理。

- 使用PySpark清洗、去重、转换数据(如处理缺失值、异常值)。

- 特征工程:提取影响分数线的特征(如报考人数增长率、试题难度系数)。

- 输出:清洗后的结构化数据集。

- 任务:

- 模型构建组(机器学习与预测)

- 任务:

- 基于PySpark MLlib或Scikit-learn训练预测模型。

- 优化模型参数(如网格搜索、交叉验证)。

- 评估模型性能(MAE、RMSE、R²等指标)。

- 输出:训练好的模型文件及评估报告。

- 任务:

- 可视化与部署组

- 任务:

- 使用Matplotlib/Seaborn或ECharts生成预测结果可视化图表。

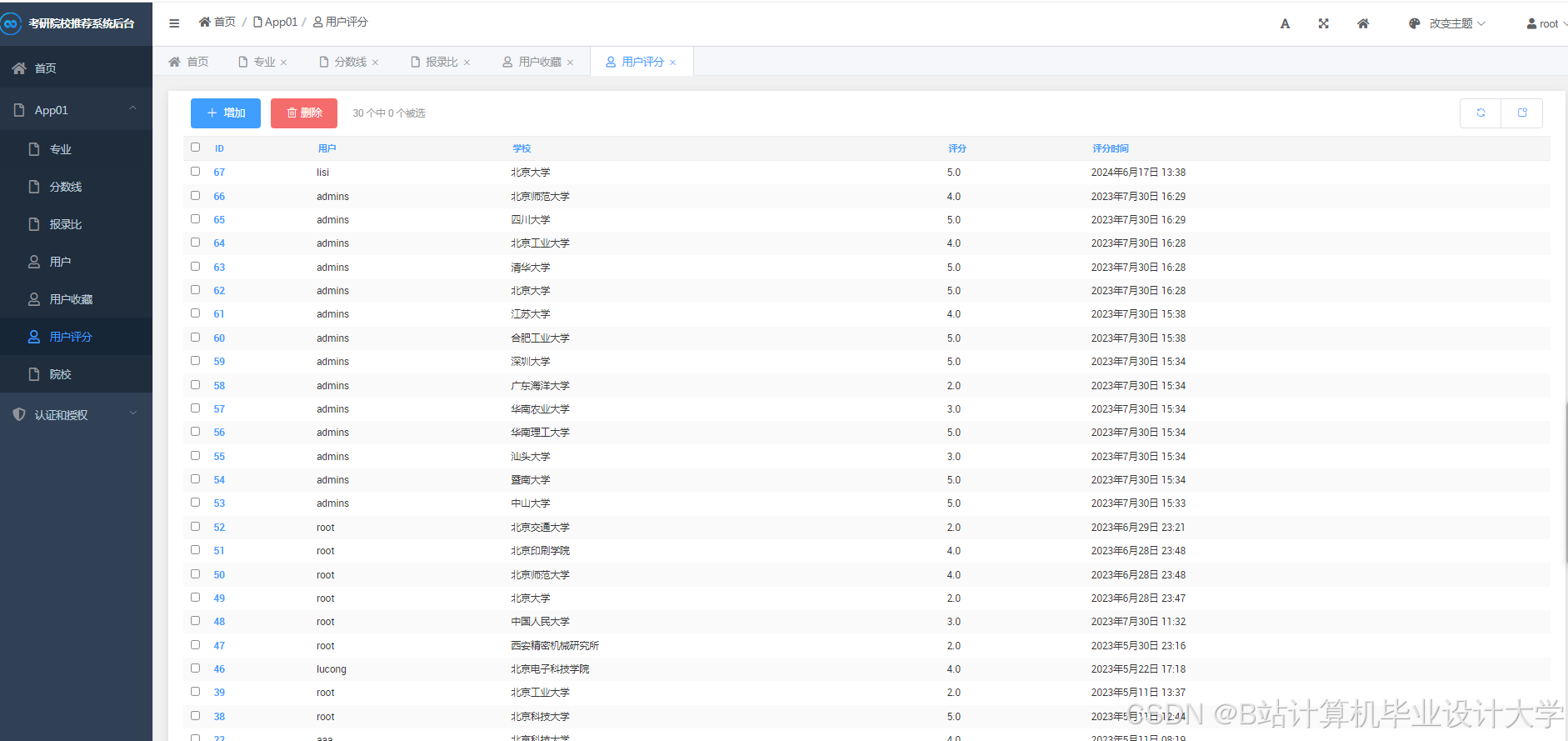

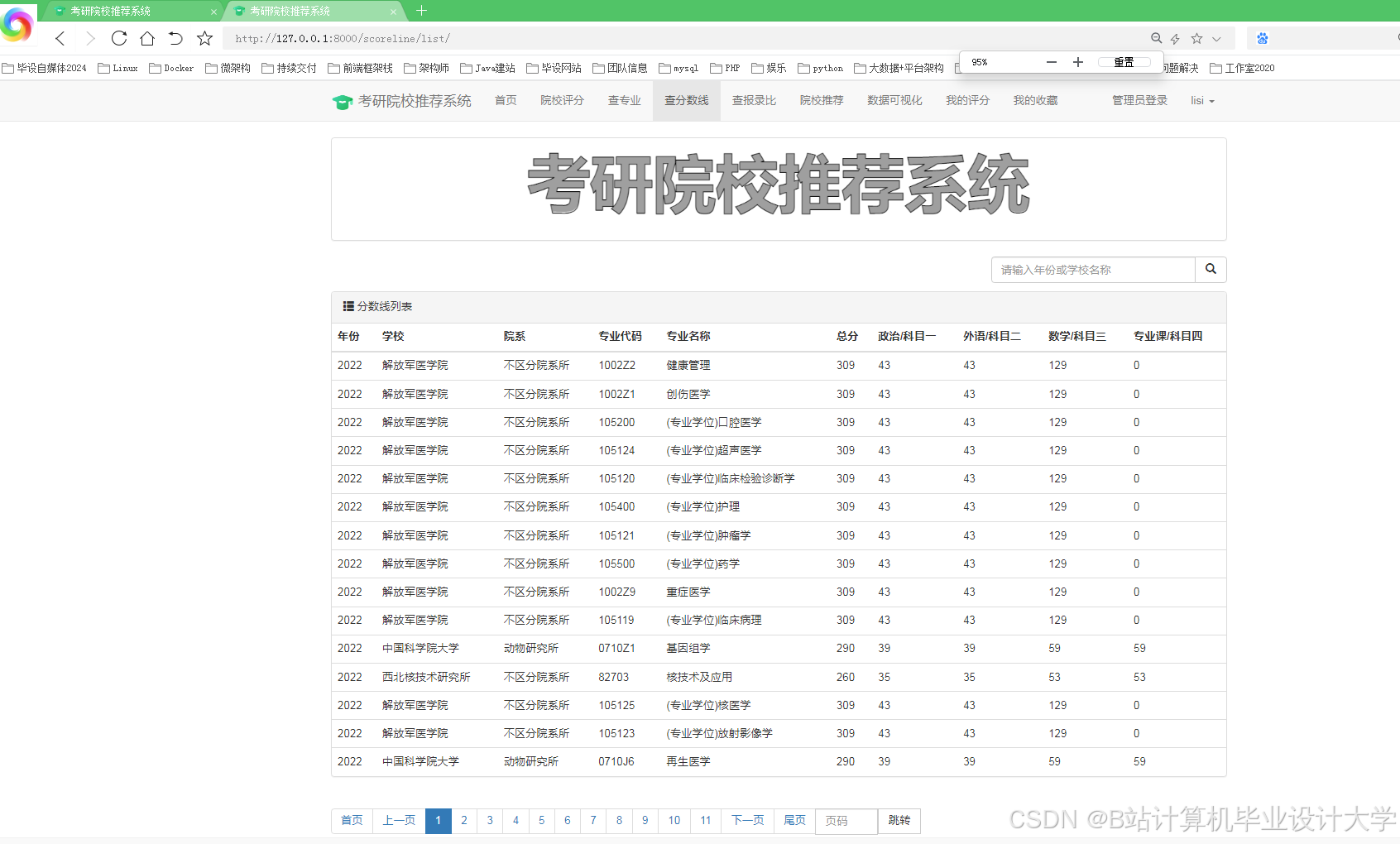

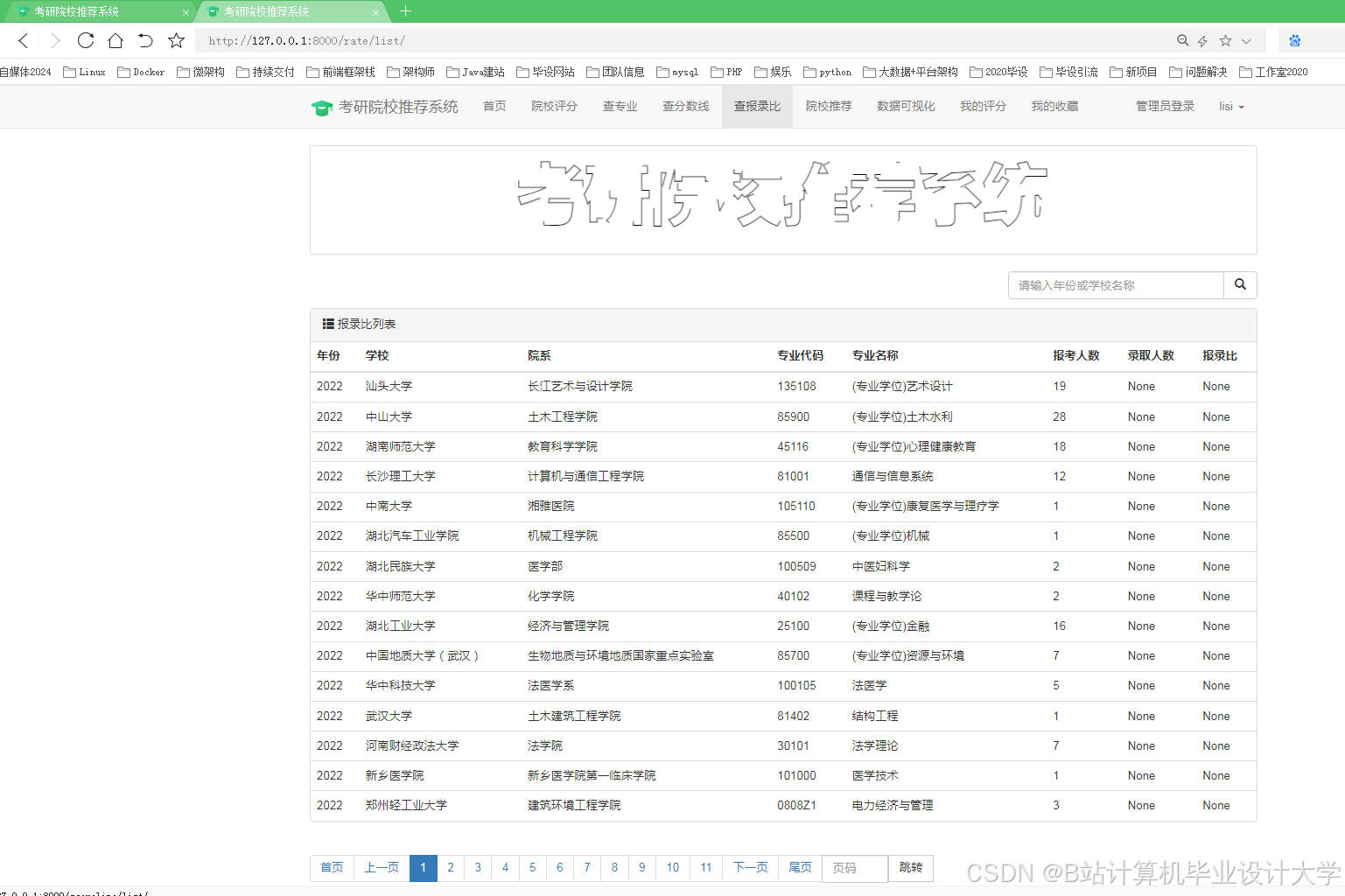

- 开发Web界面(Flask/Django)展示预测结果与历史趋势。

- 部署系统至云端(如AWS/阿里云)或本地服务器。

- 输出:可视化报告与系统部署文档。

- 任务:

三、技术栈与工具

- 数据采集:Scrapy、Requests、Selenium(处理动态页面)。

- 分布式存储与计算:Hadoop(HDFS、YARN)、PySpark。

- 数据处理:Pandas、NumPy、PySpark SQL。

- 机器学习:Scikit-learn、PySpark MLlib、XGBoost。

- 可视化:Matplotlib、Seaborn、ECharts。

- 部署:Flask/Django、Docker、Linux服务器。

四、时间计划

| 阶段 | 时间 | 任务内容 |

|---|---|---|

| 需求分析与设计 | 第1-2周 | 确定数据源、技术选型、系统架构设计。 |

| 爬虫开发与测试 | 第3-4周 | 完成Scrapy爬虫编写,抓取并存储原始数据。 |

| 数据处理与特征工程 | 第5-6周 | 使用Hadoop+PySpark清洗数据,提取特征。 |

| 模型训练与优化 | 第7-8周 | 训练预测模型,调整参数并评估性能。 |

| 可视化与部署 | 第9-10周 | 开发Web界面,部署系统并编写文档。 |

| 验收与总结 | 第11-12周 | 测试系统稳定性,提交最终报告与代码。 |

五、预期成果

- 分布式爬虫系统,可高效抓取考研相关数据。

- 基于Hadoop+PySpark的数据处理流水线。

- 考研分数线预测模型(准确率≥85%)。

- 可视化Web平台,支持历史数据查询与未来预测。

- 完整的技术文档与用户手册。

六、风险评估与应对

- 数据源变更:目标网站结构更新导致爬虫失效。

- 应对:定期维护爬虫,增加自动化适配逻辑。

- 集群性能瓶颈:Hadoop集群资源不足。

- 应对:优化资源分配,采用弹性云服务扩容。

- 模型过拟合:训练数据量不足或特征选择不当。

- 应对:增加数据多样性,使用正则化与交叉验证。

七、验收标准

- 爬虫系统可稳定运行,每日抓取数据量≥10万条。

- 数据处理流程在1小时内完成百万级数据清洗。

- 预测模型在测试集上的MAE误差≤5分。

- Web界面响应时间≤2秒,支持并发访问≥100人。

项目负责人:XXX

日期:XXXX年XX月XX日

此任务书可根据实际需求调整技术细节和时间安排。

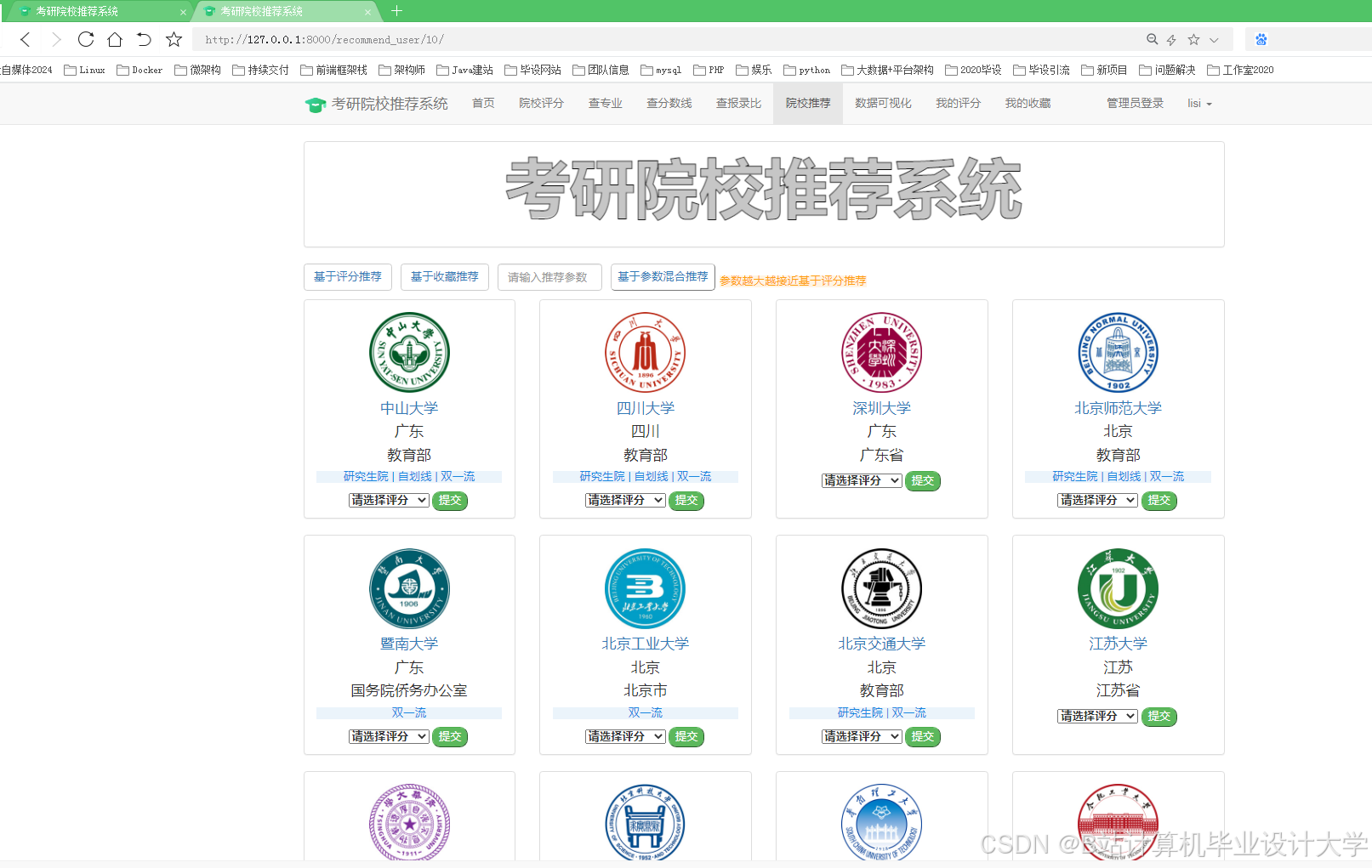

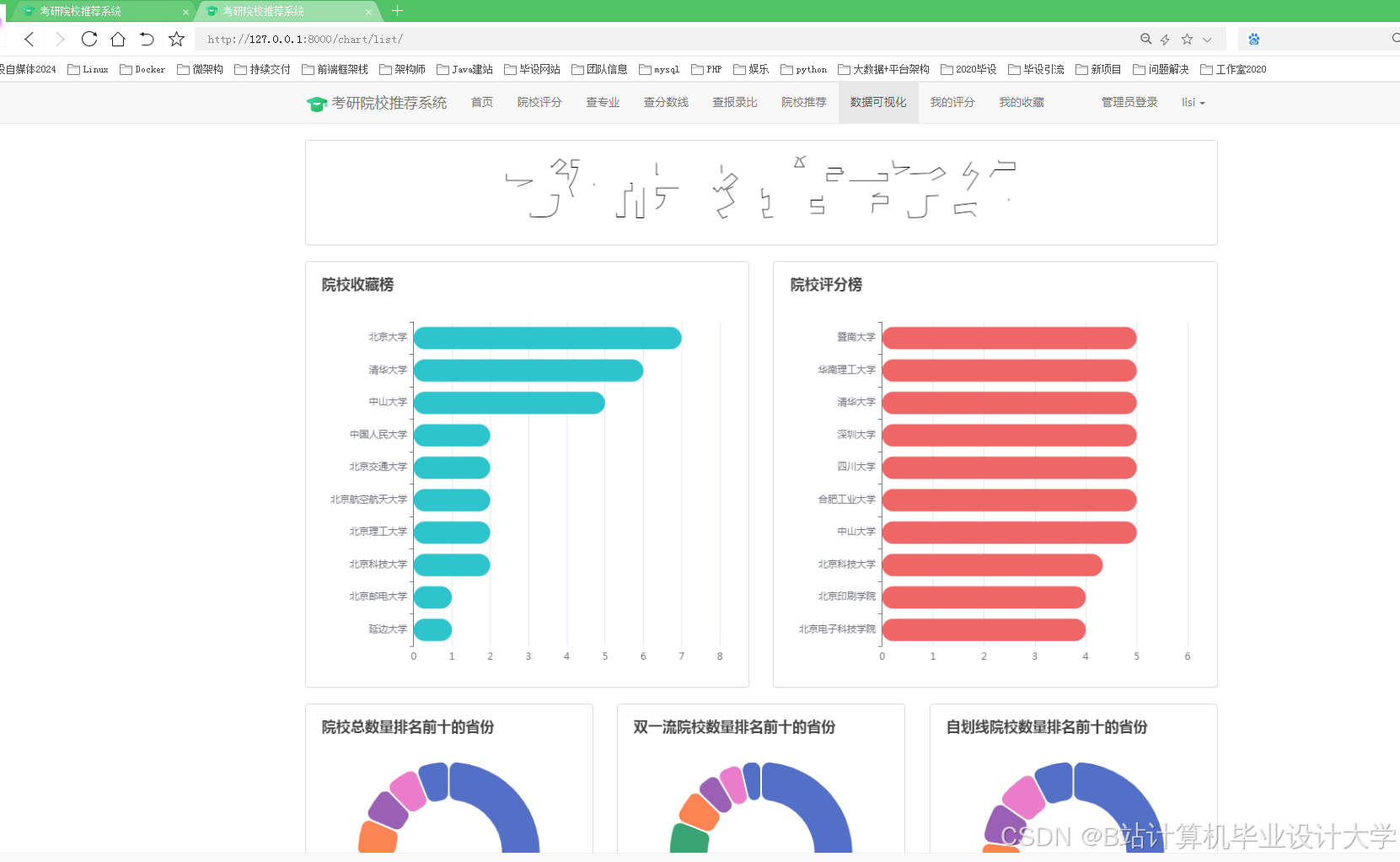

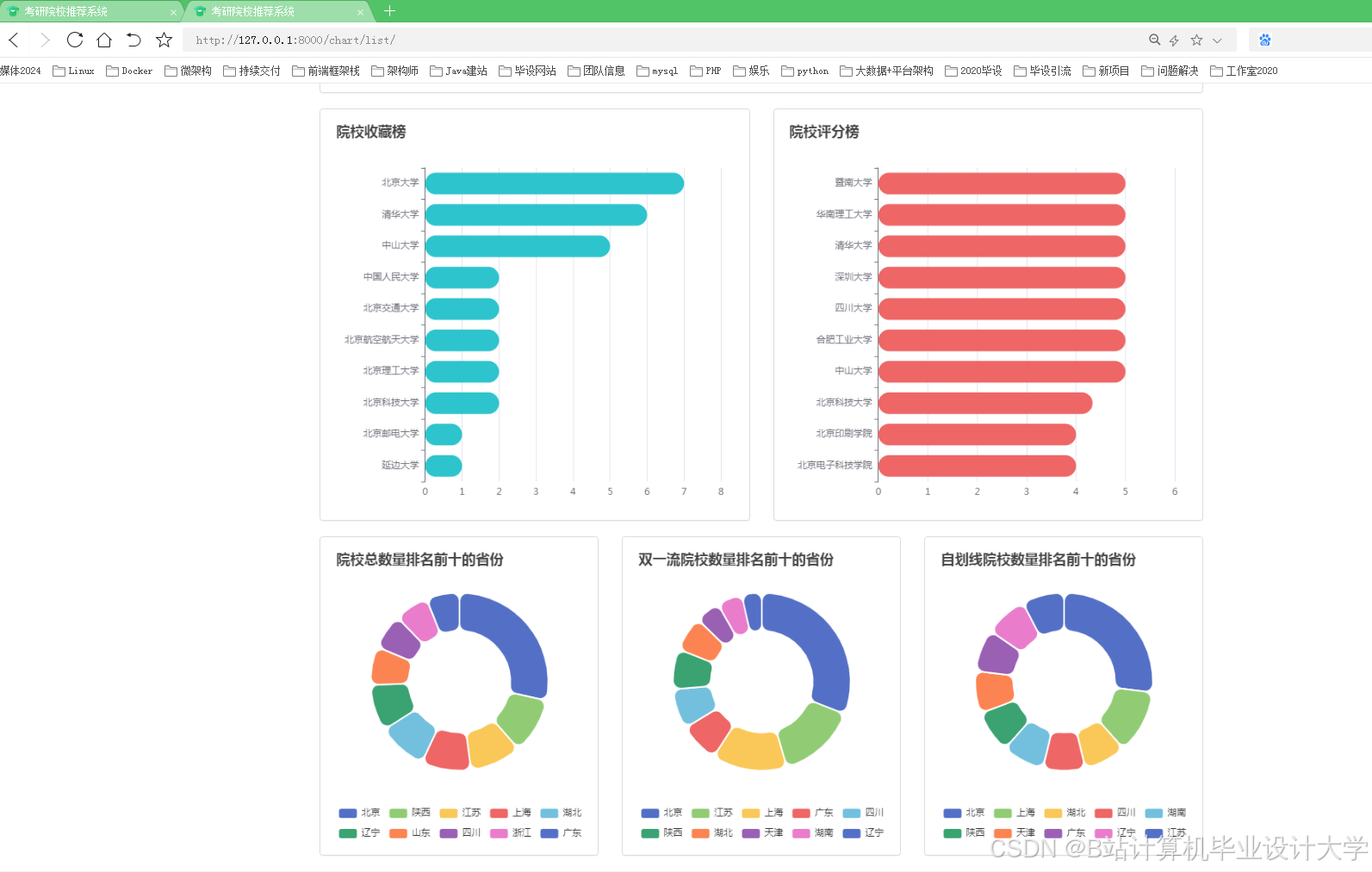

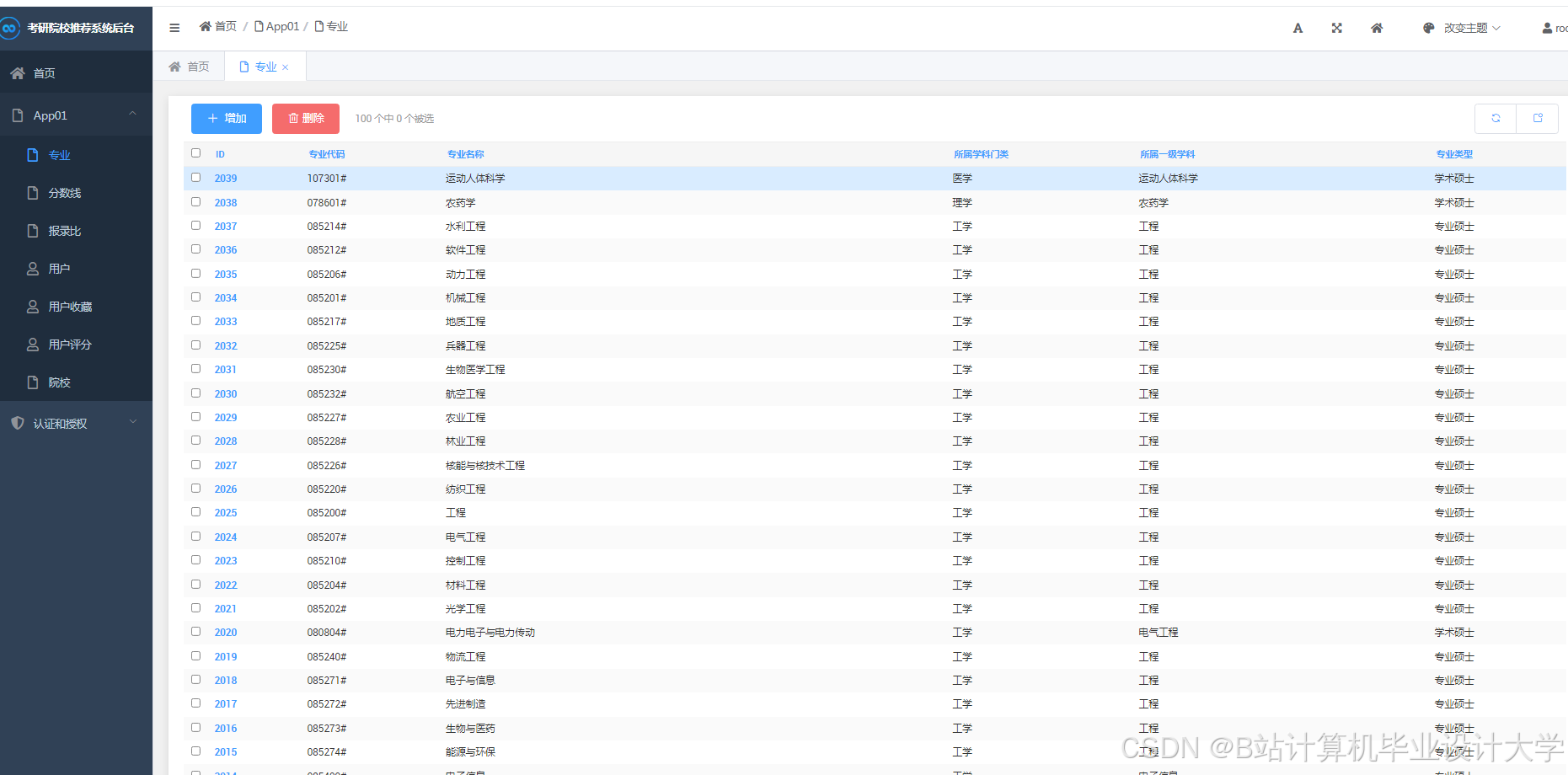

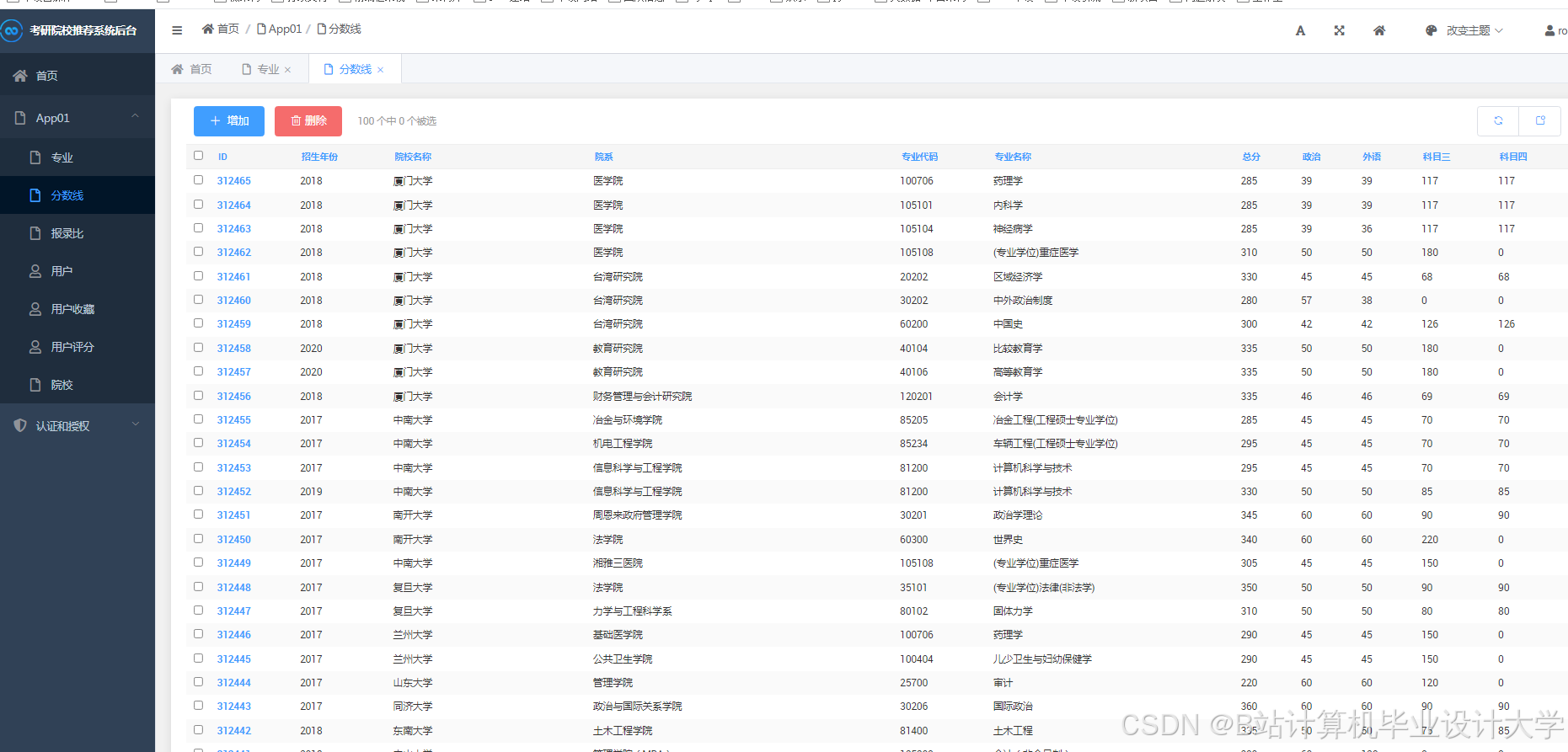

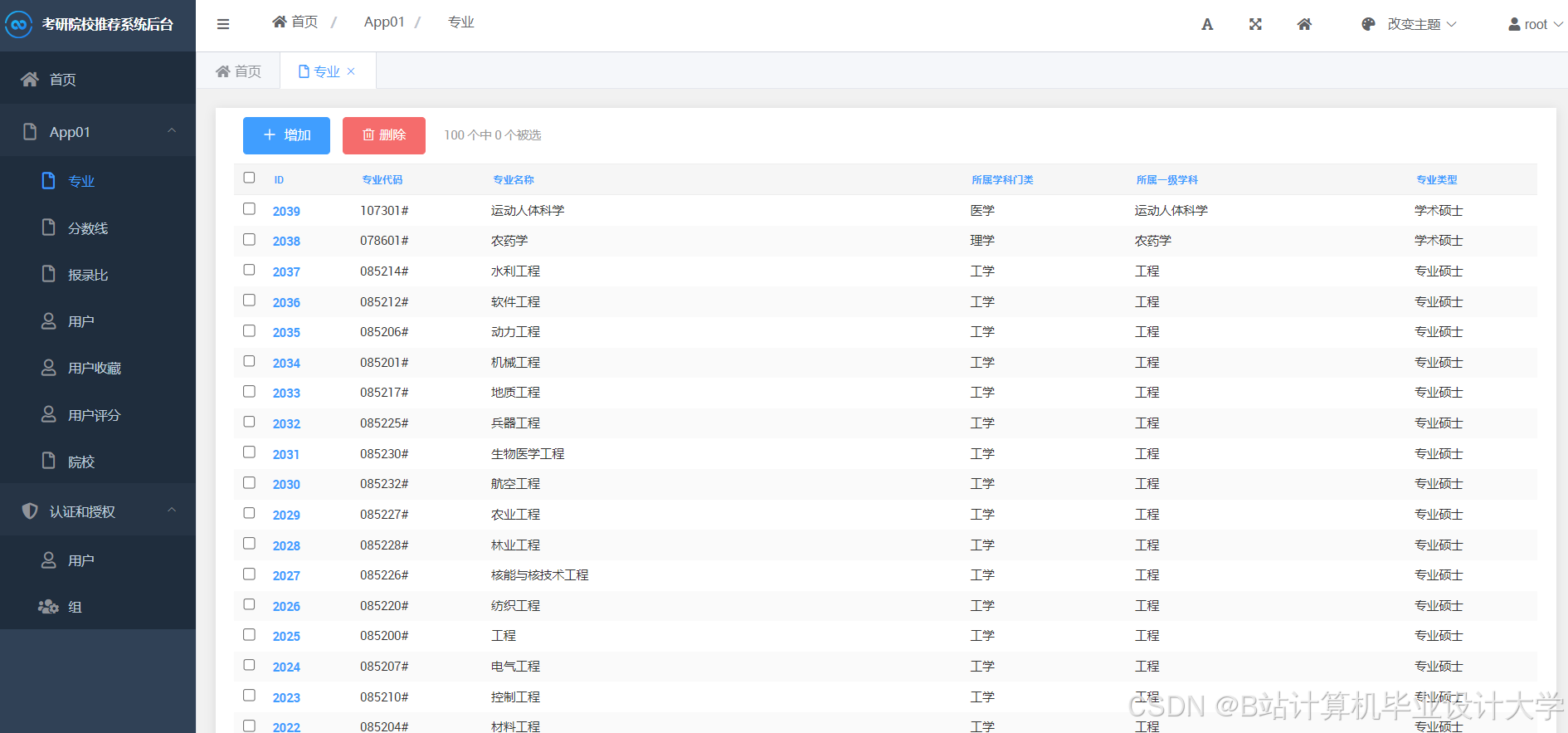

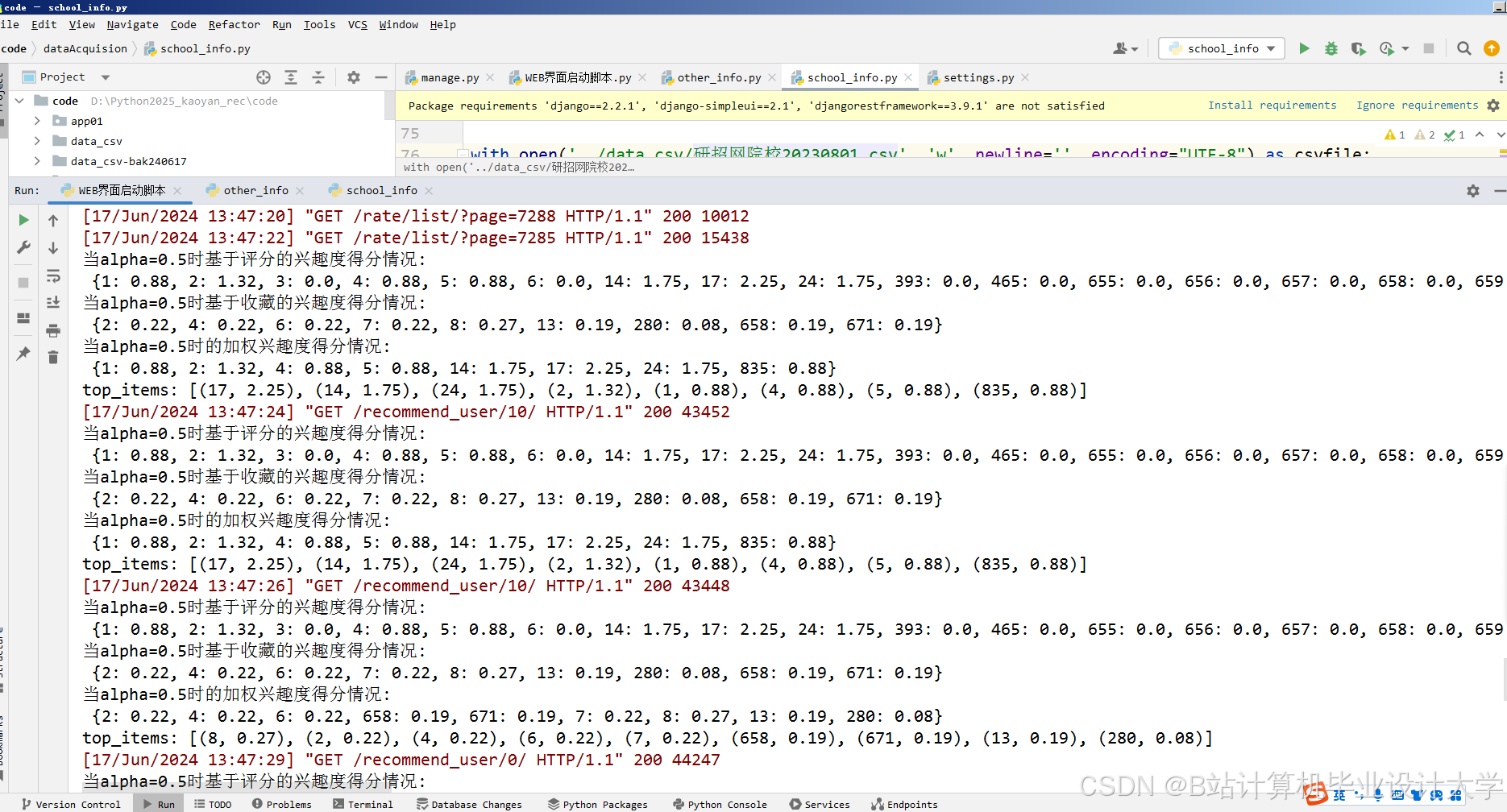

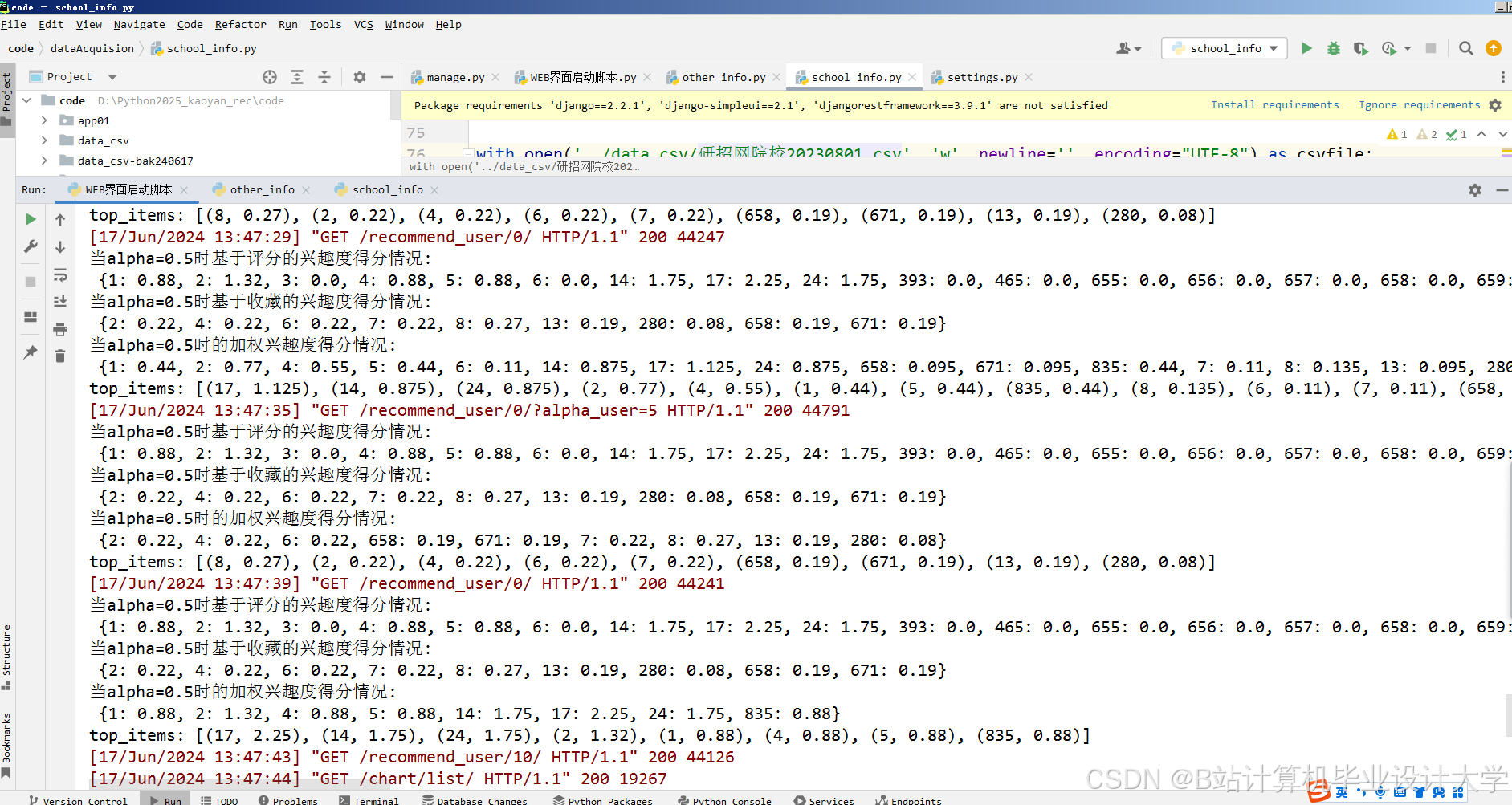

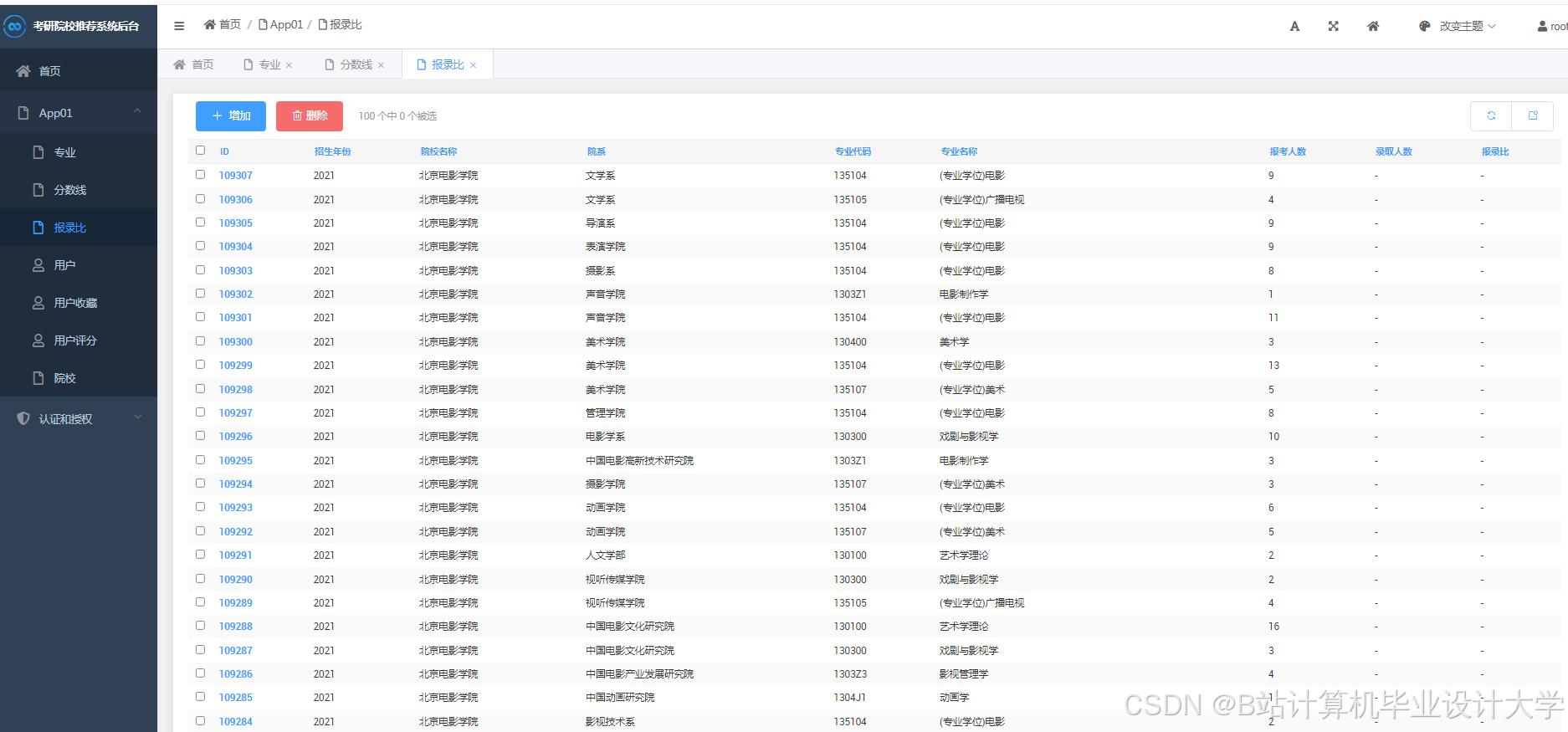

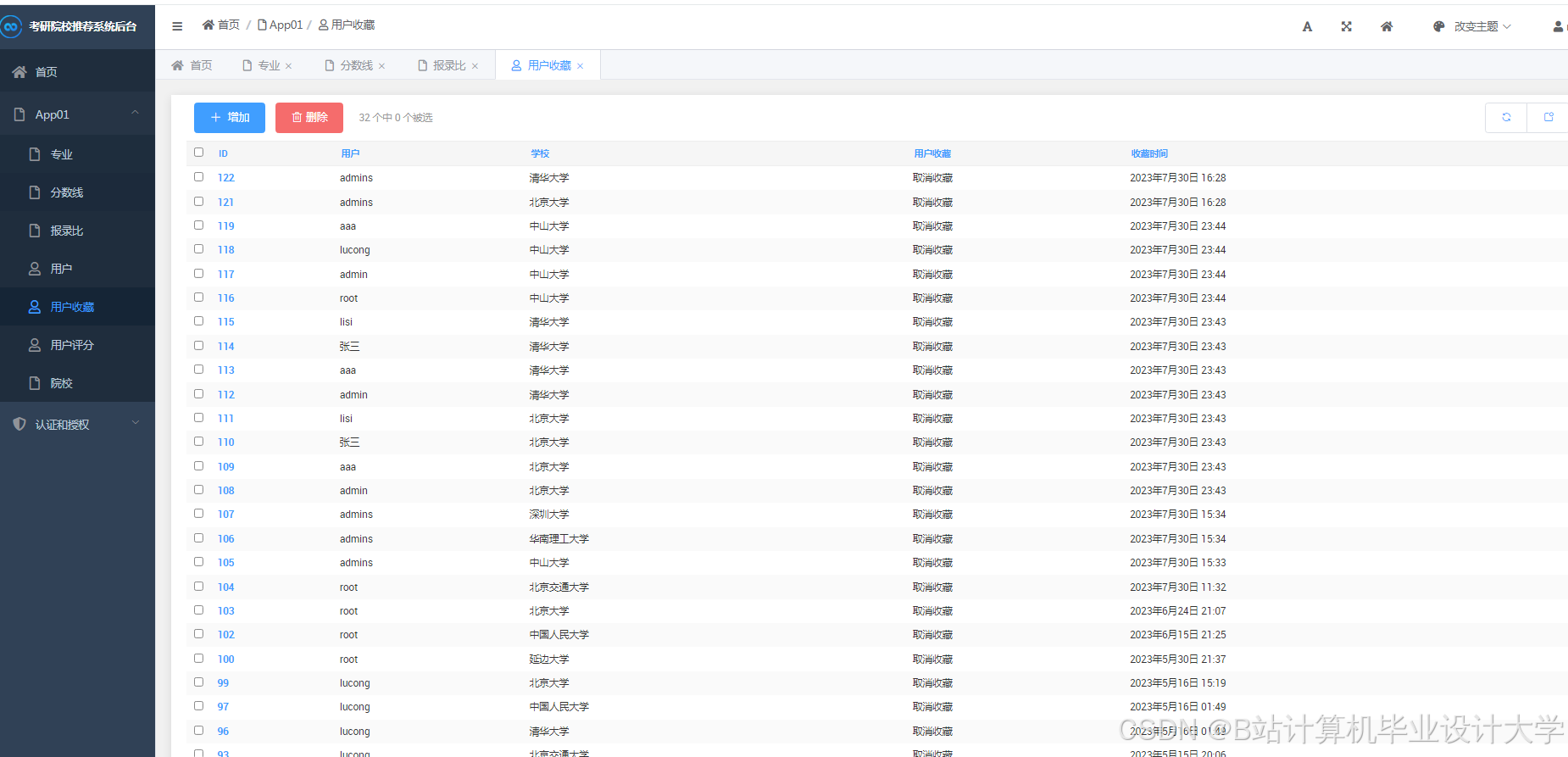

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

2501

2501

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?