温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一篇关于《Hadoop+Spark+Hive地震预测系统》的开题报告框架及内容示例,结合大数据处理框架与地震预测需求,供参考:

开题报告

题目:基于Hadoop+Spark+Hive的地震预测系统研究

一、研究背景与意义

- 研究背景

- 地震预测的挑战:

- 数据量庞大:地震监测站每日产生海量多源数据(如地磁、地声、地形变、GPS位移),传统单机处理效率低(如单站日数据量达TB级)。

- 实时性要求高:地震波传播速度极快(如P波约5-8km/s),需在秒级内完成数据清洗、特征提取与预警发布。

- 多模态融合难:需整合地震波、气象、地质结构等多维度数据,传统关系型数据库难以支持复杂关联分析。

- 大数据技术的优势:

- Hadoop:提供分布式存储(HDFS)与计算(MapReduce),解决海量数据存储与离线处理问题。

- Spark:基于内存的迭代计算,支持实时流处理(Spark Streaming)与机器学习(MLlib),提升特征提取与预测速度。

- Hive:通过类SQL查询(HQL)简化数据探索,支持对历史地震数据的统计分析(如震级-频率分布)。

- 地震预测的挑战:

- 研究意义

- 理论意义:探索大数据框架在地震预测中的适用性,优化分布式计算与机器学习的协同机制。

- 实践意义:缩短地震预警响应时间(预计从分钟级降至秒级),降低人员伤亡与财产损失(如日本EWS系统通过实时处理减少30%伤亡)。

二、国内外研究现状

- 地震预测技术研究

- 传统方法:

- 物理模型:基于弹性波理论(如P波/S波到时差)预测震源位置,但依赖精确地质参数(如断层分布),误差较大。

- 统计模型:通过历史地震数据(如Gutenberg-Richter定律)预测未来震级,但缺乏实时数据支撑。

- 大数据应用:

- 美国USGS:使用Hadoop存储全球地震监测数据(如ANSS网络),通过Spark实时计算震中位置,但未整合多模态数据。

- 中国地震台网:基于Hive构建历史地震数据库,支持震级-频度关系分析,但实时处理能力不足。

- 传统方法:

- 大数据框架在地震领域的应用

- Hadoop生态:

- HDFS存储原始监测数据(如CSV格式的地磁时序数据),MapReduce处理离线任务(如数据去噪)。

- Spark生态:

- Spark Streaming实时处理传感器流数据(如每秒10万条地声信号),MLlib训练预测模型(如随机森林、LSTM)。

- Hive应用:

- 通过HQL查询历史地震目录(如“SELECT * FROM earthquakes WHERE magnitude > 5”),辅助特征工程(如计算区域地震活跃度)。

- Hadoop生态:

- 现存问题

- 数据异构性:地震数据来源多样(如卫星遥感、地下传感器),格式不统一(如二进制、JSON),需统一清洗与转换。

- 实时与离线割裂:Hadoop擅长离线处理,Spark擅长实时计算,但两者协同机制不完善(如数据共享延迟)。

- 模型可解释性差:深度学习模型(如LSTM)预测准确率高,但难以解释特征重要性(如“为何地磁变化是关键指标?”)。

三、研究目标与内容

- 研究目标

- 设计并实现一套基于Hadoop+Spark+Hive的地震预测系统,支持多源数据实时处理、特征工程自动化与模型可解释性,提升预测准确率与响应速度。

- 研究内容

- 多源数据集成与存储模块:

- 数据来源:整合地震波(地磁、地声)、气象(温度、气压)、地质(断层分布)数据,支持CSV、JSON、二进制格式。

- 数据清洗:使用Hadoop MapReduce过滤异常值(如传感器故障导致的零值),填充缺失数据(如线性插值)。

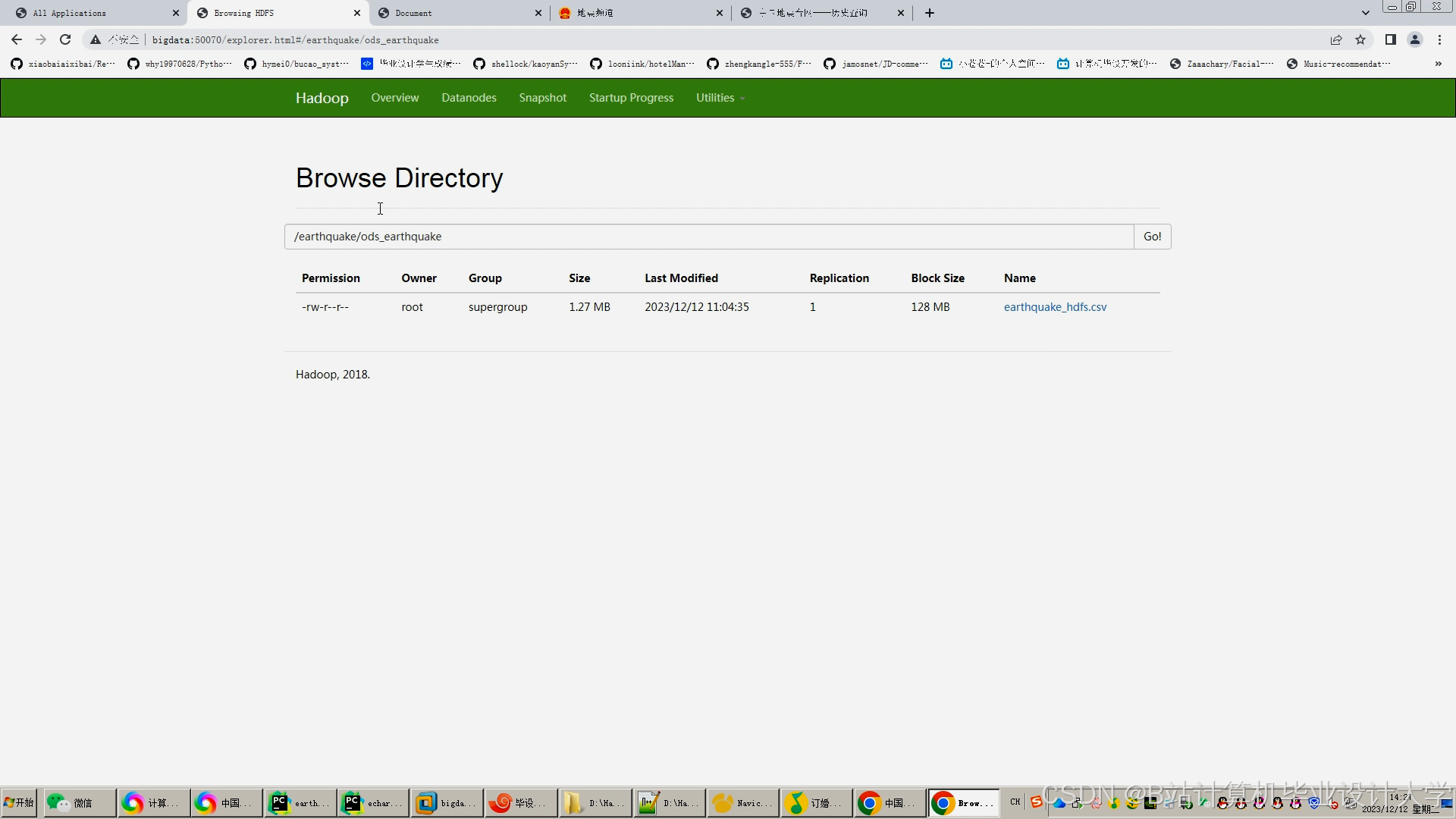

- 分布式存储:将清洗后数据存入HDFS,按时间(如每小时一个文件)与地域(如省/州)分区,优化查询效率。

- 实时处理与特征提取模块:

- 流处理:通过Spark Streaming实时接收传感器数据(如Kafka消息队列),计算短时平均振幅(STA/LTA)等特征。

- 离线分析:使用Hive查询历史地震数据(如“过去10年该区域5级以上地震的频次”),生成统计特征(如活跃度指数)。

- 特征融合:将实时特征(如地磁突变)与离线特征(如历史活跃度)拼接,输入预测模型。

- 预测模型与优化模块:

- 模型选择:

- 传统机器学习:随机森林(RF)解释性强,适合初步筛选关键特征(如地声振幅)。

- 深度学习:LSTM网络捕捉时序依赖(如地磁连续变化趋势),提升长期预测能力。

- 模型优化:

- 参数调优:通过Spark MLlib的交叉验证(CrossValidator)自动调整LSTM层数与学习率。

- 可解释性:使用SHAP值分析特征重要性(如“地磁变化对预测结果的贡献度为60%”)。

- 模型选择:

- 预警与可视化模块:

- 实时预警:当预测震级超过阈值(如5级)时,通过Spark Streaming触发预警(如短信、APP推送)。

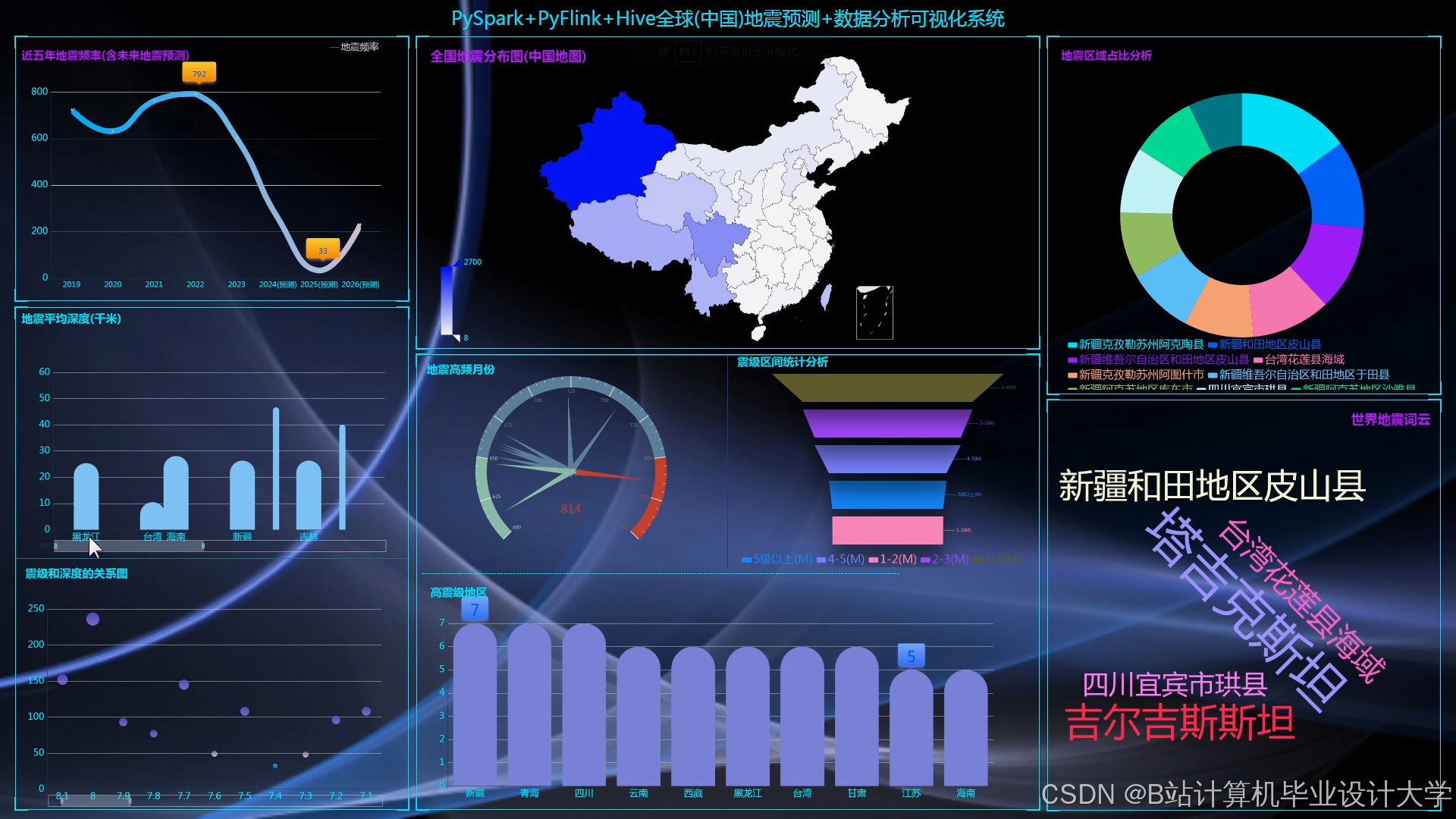

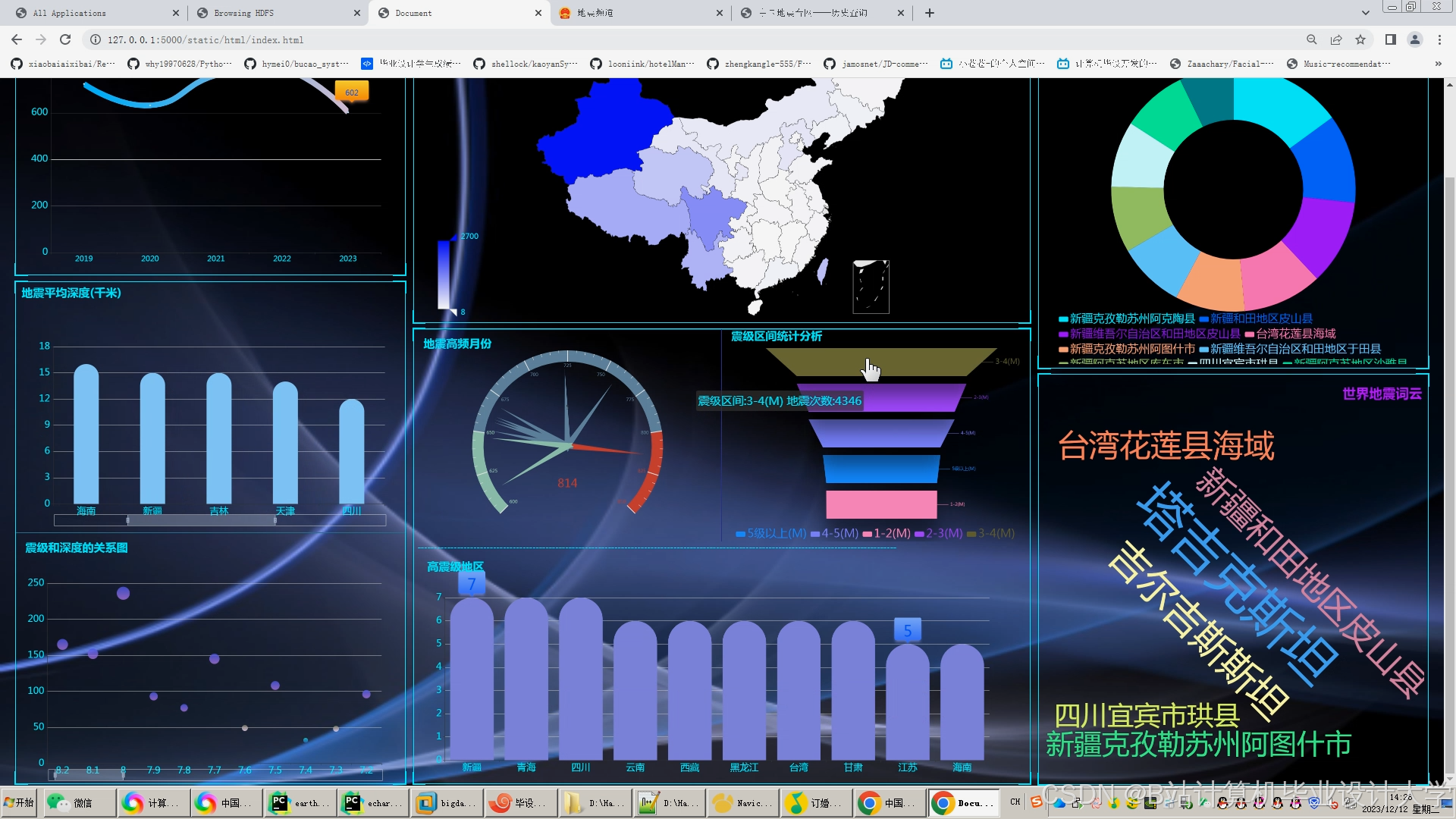

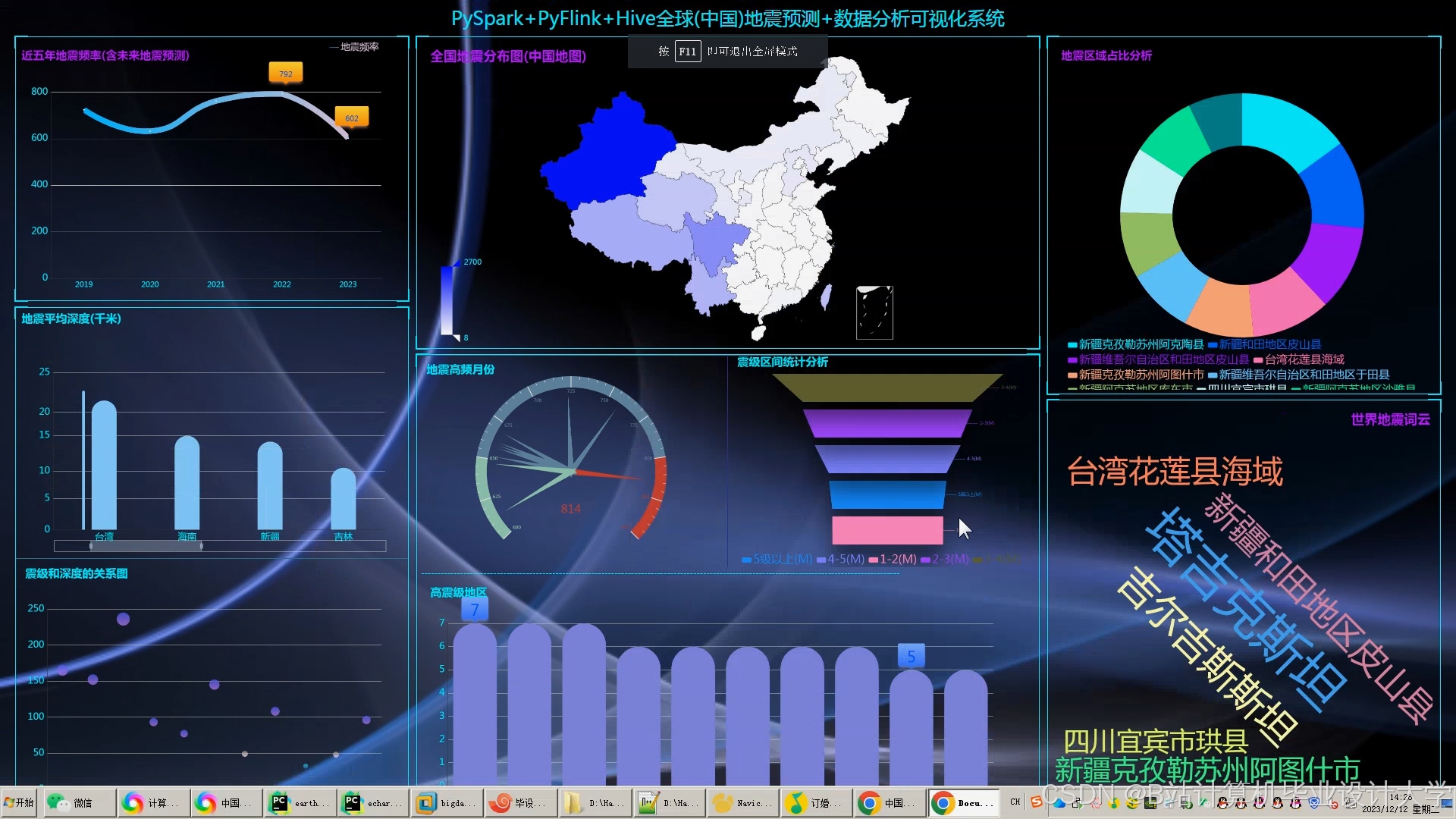

- 可视化:使用ECharts展示地震热力图(如过去24小时全球5级以上地震分布)、特征重要性雷达图。

- 多源数据集成与存储模块:

四、研究方法与技术路线

- 技术栈

- 存储层:Hadoop HDFS(分布式存储)、Hive(元数据管理)

- 计算层:Spark Core(批处理)、Spark Streaming(流处理)、MLlib(机器学习)

- 消息队列:Kafka(实时数据传输)

- 可视化层:ECharts(前端展示)、Flask(后端API)

- 技术路线

mermaidgraph TDA[多源数据输入] --> B[Hadoop数据清洗与存储]B --> C[Hive历史数据查询]C --> D[Spark离线特征计算]A --> E[Kafka实时数据流]E --> F[Spark Streaming实时特征提取]D --> G[特征融合]F --> GG --> H[Spark MLlib模型训练]H --> I[模型评估与优化]I --> J[实时预警与可视化]

五、预期成果与创新点

- 预期成果

- 完成多源数据集成方案,支持地磁、地声、气象等数据的统一存储与清洗。

- 实现实时流处理与离线分析的协同机制,缩短预测响应时间至5秒内。

- 开发可视化平台,展示地震热力图、特征重要性分析与预警信息。

- 创新点

- 多模态数据融合:整合地震波、气象、地质数据,突破单一数据源的局限性(如仅依赖地磁易漏报)。

- 实时-离线协同计算:通过Spark与Hive的交互,实现实时特征与历史特征的动态融合。

- 模型可解释性:结合SHAP值与物理模型(如弹性波理论),解释深度学习模型的预测逻辑。

六、进度安排

| 阶段 | 时间 | 任务 |

|---|---|---|

| 1 | 第1-2月 | 需求分析、技术选型、数据集确定(如USGS公开地震数据) |

| 2 | 第3-4月 | Hadoop集群搭建与数据清洗模块开发(MapReduce实现) |

| 3 | 第5-6月 | Spark实时处理与Hive离线分析模块开发(Streaming+HQL) |

| 4 | 第7-8月 | 预测模型开发与优化(LSTM+SHAP值分析) |

| 5 | 第9-10月 | 可视化平台开发与系统测试(A/B测试对比传统方法) |

| 6 | 第11-12月 | 论文撰写与部署上线 |

七、参考文献

- USGS. Advanced National Seismic System (ANSS) Data Products[EB/OL]. https://www.usgs.gov/

- Tom White. Hadoop: The Definitive Guide[M]. O'Reilly Media, 2012.

- Matei Zaharia. Spark: Cluster Computing with Working Sets[C]. HotCloud, 2010.

- 郭华东等. 地震大数据与人工智能应用[M]. 科学出版社, 2020.

- Lundberg S M, Lee S I. A Unified Approach to Interpreting Model Predictions[C]. NIPS, 2017.

八、指导教师意见

(待填写)

备注:

- 需关注数据隐私与安全(如地震监测数据可能涉及国家安全),符合《数据安全法》要求。

- 可引入边缘计算(如传感器端初步过滤数据)减轻集群压力。

- 模型部分可尝试图神经网络(GNN)捕捉地震空间关联性(如相邻区域地震的传播关系)。

希望此框架能为您提供参考!如需进一步细化某部分内容(如Spark Streaming实现细节或LSTM模型调优),可随时补充。

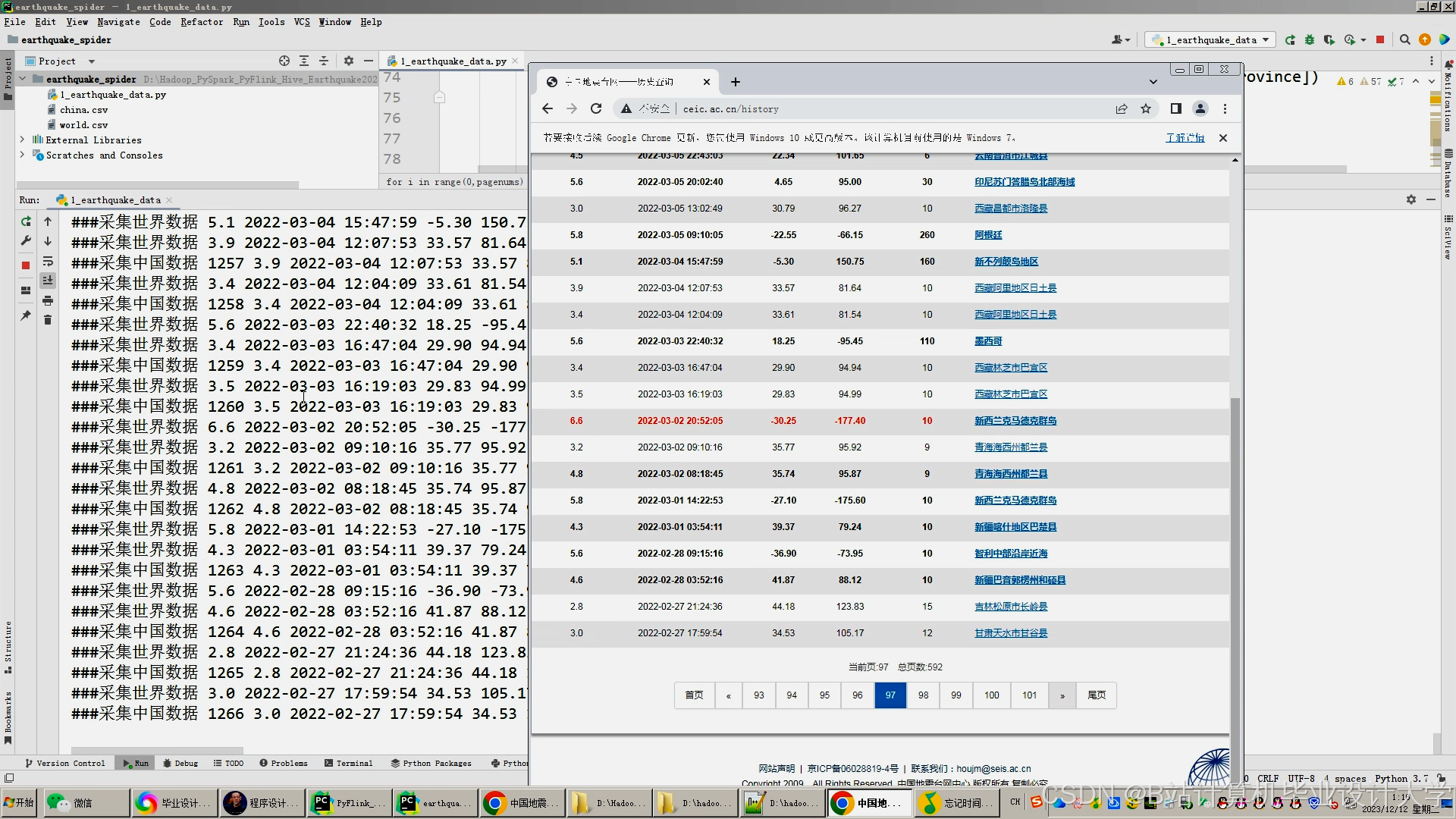

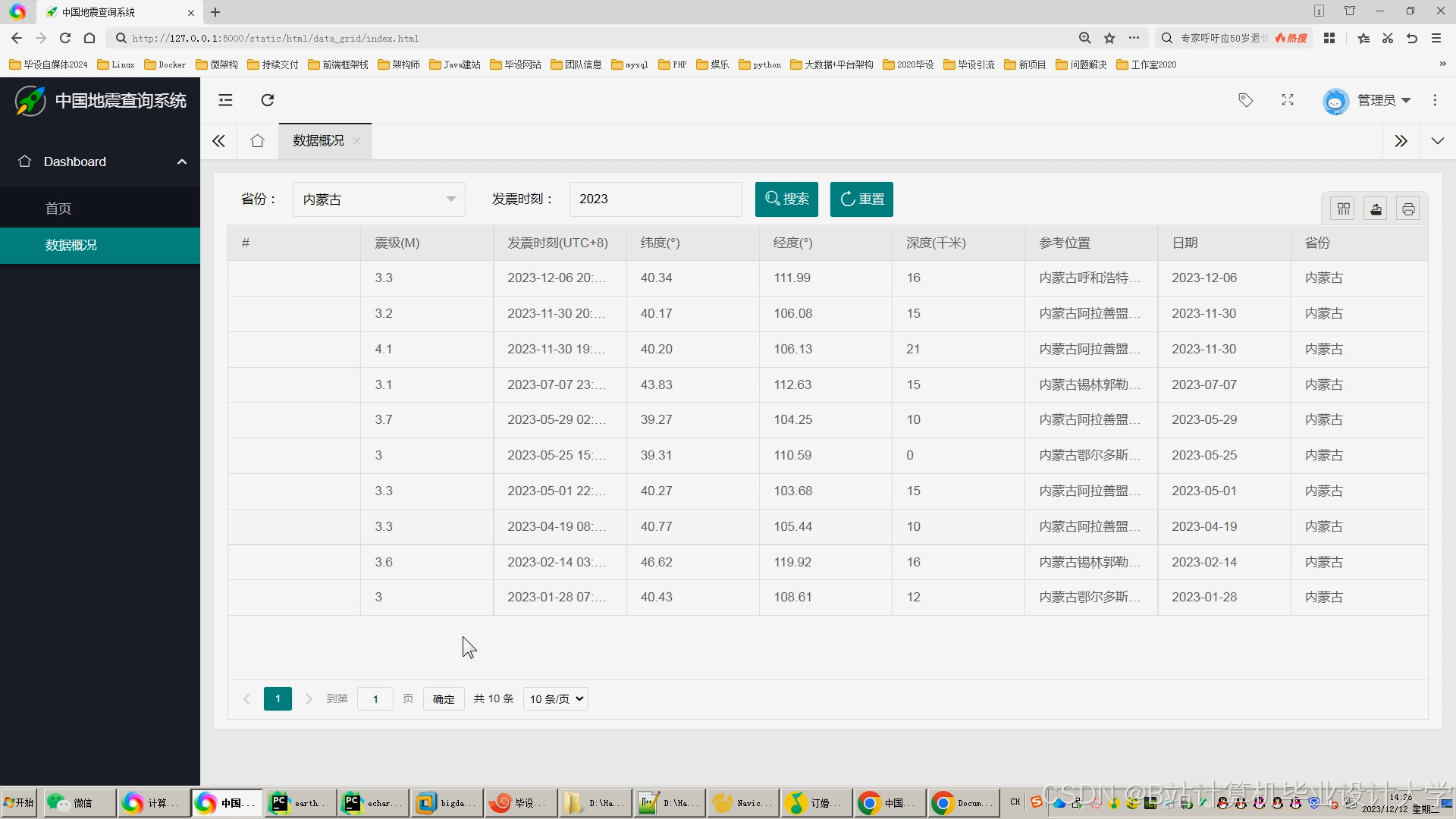

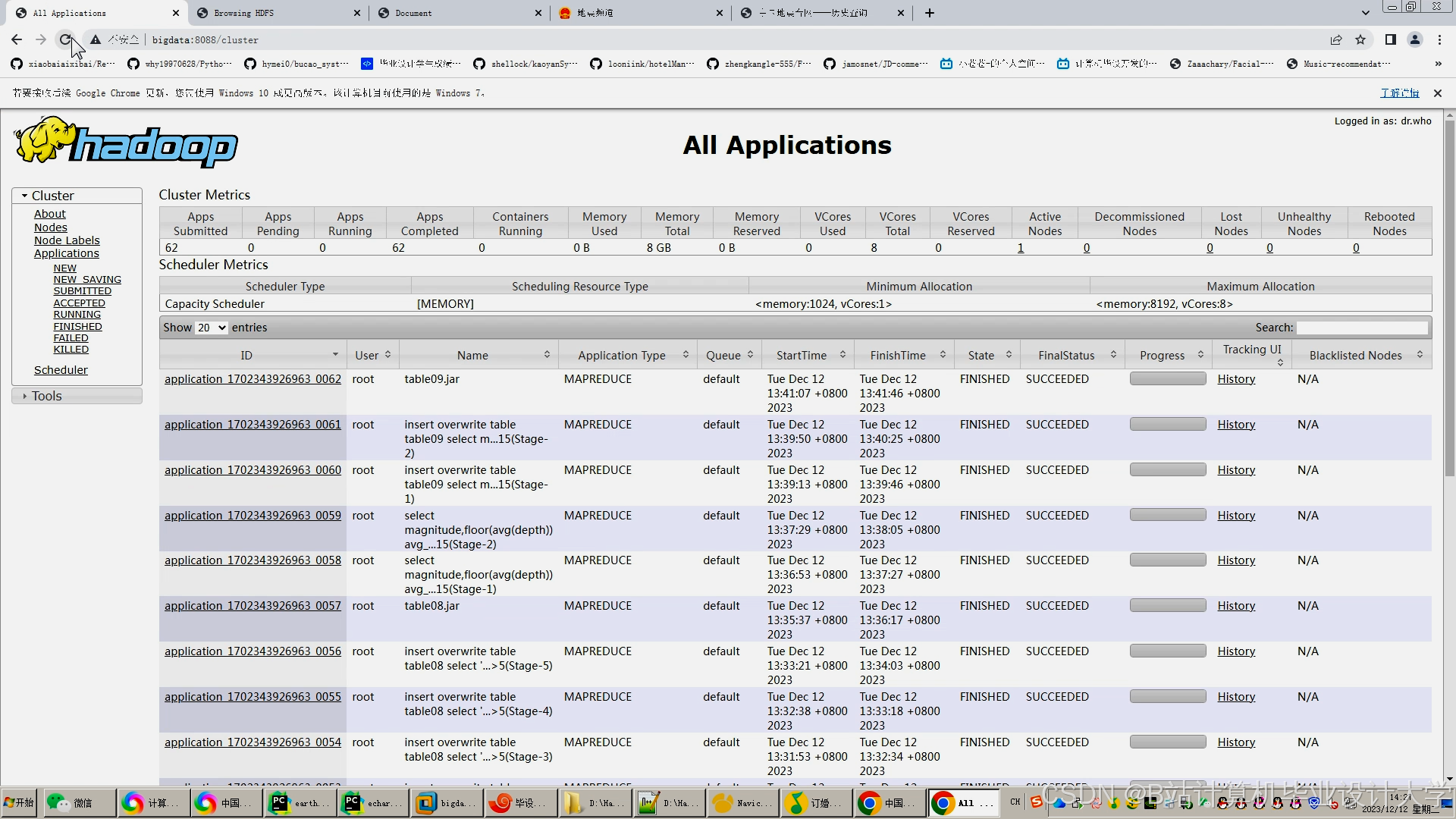

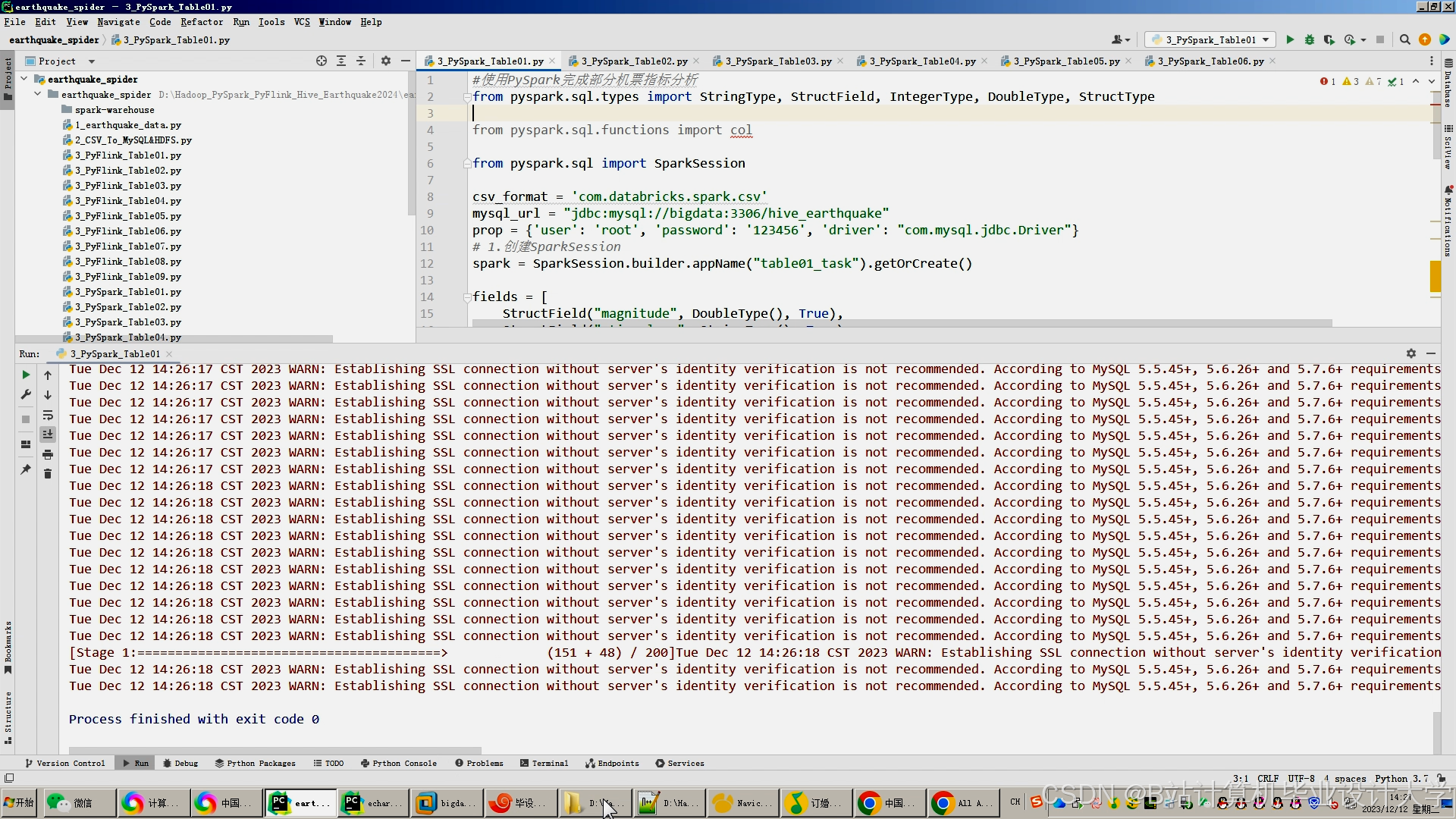

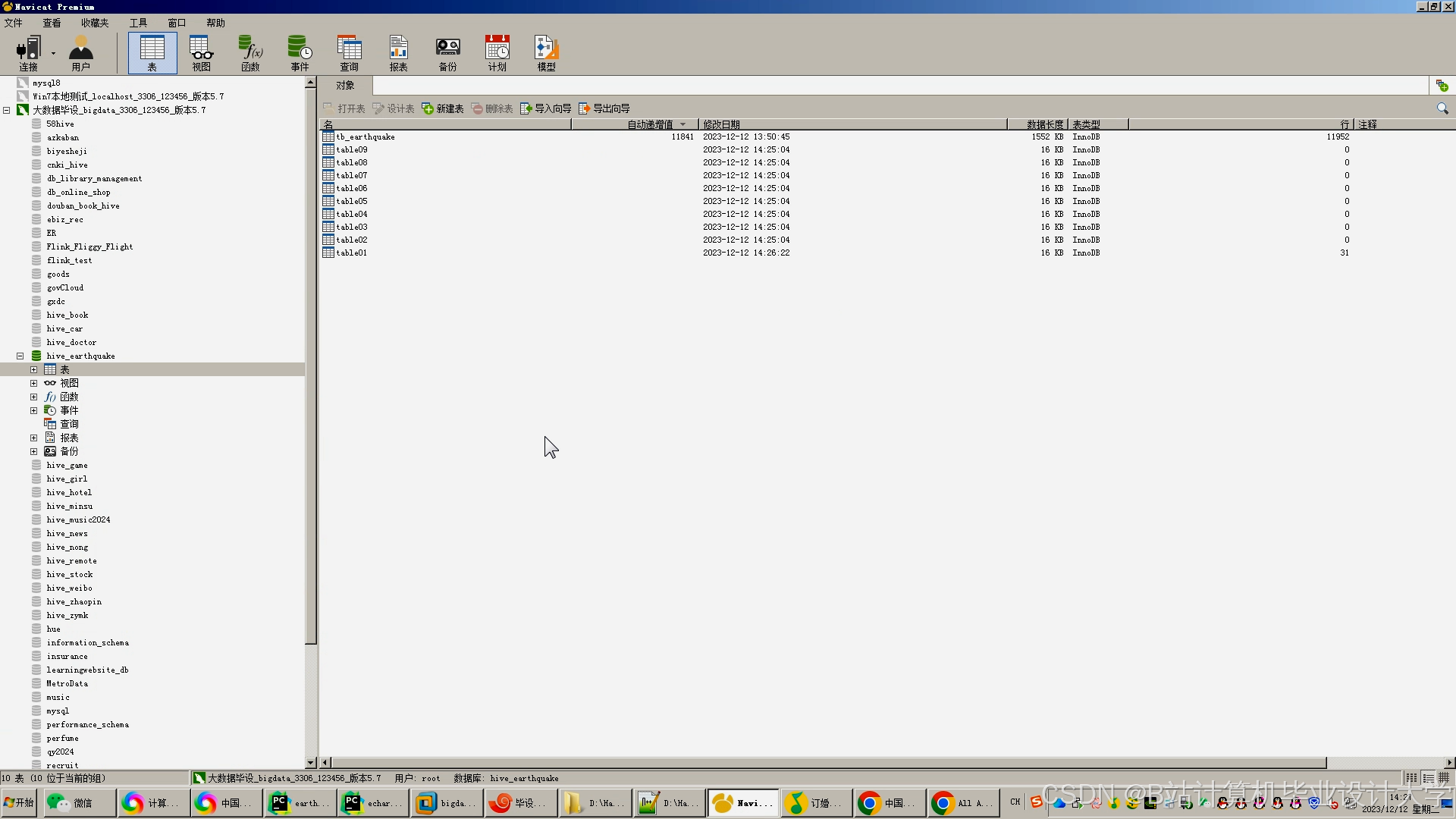

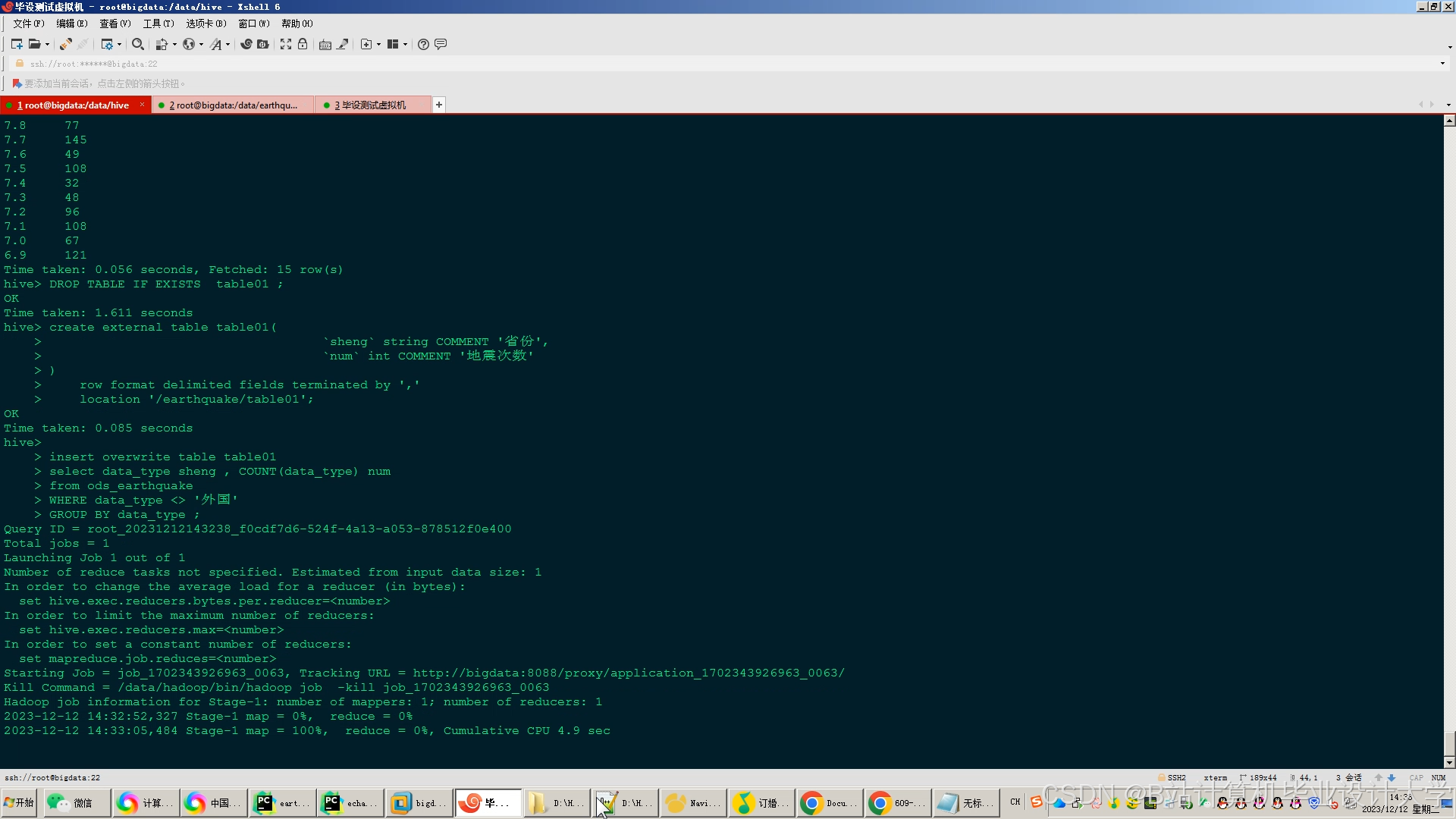

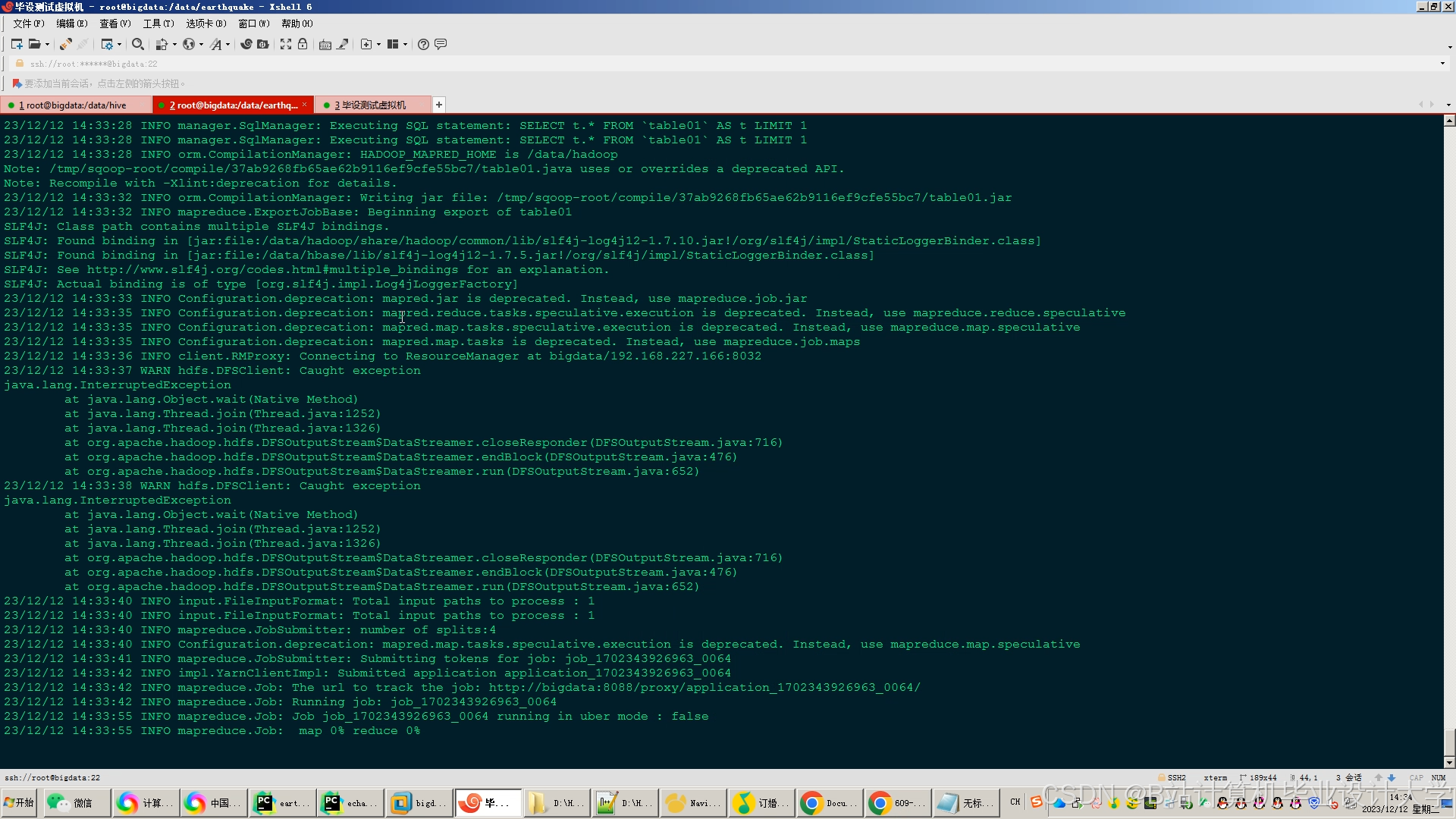

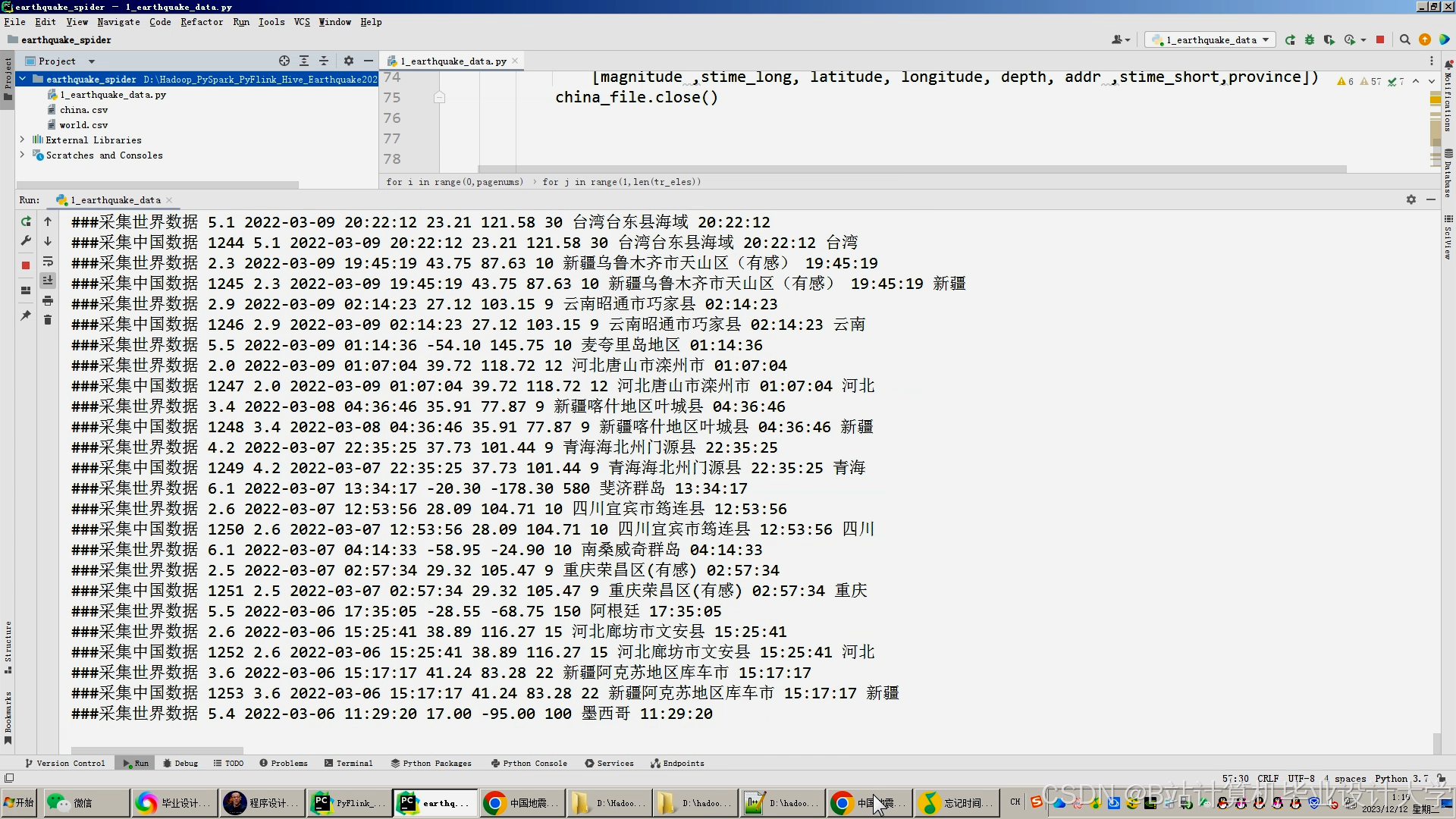

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

925

925

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?