温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

《Hadoop+Spark+Hive共享单车预测系统及共享单车数据可视化分析》开题报告

一、研究背景与意义

1.1 共享单车行业的智能化需求

共享单车作为城市短途出行的重要方式,全球市场规模持续扩大。据Statista统计,2023年全球共享单车用户规模达3.2亿,日均骑行次数超5000万次,产生海量骑行数据(包括骑行起点、终点、时间、时长等)。然而,传统运营模式面临三大挑战:

- 供需失衡:高峰时段热点区域车辆短缺,低谷时段非热点区域车辆闲置,导致资源利用率不足60%;

- 调度滞后:人工调度依赖经验,响应时间超30分钟,无法动态匹配实时需求;

- 决策粗放:缺乏数据驱动的预测模型,站点增设、车辆投放等决策依赖主观判断。

1.2 大数据技术的赋能价值

Hadoop、Spark、Hive等大数据技术为共享单车预测与可视化分析提供了分布式存储、实时计算和高效查询的解决方案:

- Hadoop HDFS:支持PB级骑行数据的可靠存储,解决多城市、多运营商数据整合问题。例如,摩拜单车通过HDFS存储3年骑行历史数据,支撑全国车辆调度优化。

- Spark内存计算:通过DAG执行引擎和微批处理模式,将实时预测延迟从分钟级降至秒级。哈啰出行基于Spark Streaming实现区域需求预测,调度响应时间缩短至10秒。

- Hive数据仓库:构建统一的数据管理框架,支持骑行轨迹、天气、节假日等多维度数据的关联查询。青桔单车利用Hive管理结构化数据,结合Tableau实现运营效果的可视化监控。

1.3 研究意义

本课题旨在构建基于Hadoop+Spark+Hive的共享单车预测系统,结合时空特征挖掘与机器学习算法,实现以下目标:

- 技术价值:验证大数据技术在共享经济领域的应用潜力,为城市交通管理提供可复用的分布式架构;

- 学术价值:探索时空预测模型(LSTM+注意力机制)的优化策略,解决数据稀疏和时空异质性问题;

- 商业价值:提升车辆周转率15%-20%,降低空驶率10%,助力运营商降本增效。

二、国内外研究现状

2.1 大数据技术在共享单车领域的应用

- 存储层:HDFS的副本策略保障数据可靠性,HBase作为列式数据库支持低延迟随机读写。例如,ofo通过HBase存储实时车辆状态数据,支撑每秒万级的查询请求。

- 计算层:Spark的RDD抽象和DAG执行引擎避免磁盘I/O开销,适合迭代计算。美团单车基于Spark MLlib实现时空聚类算法,将热点区域识别时间从小时级缩短至分钟级。

- 分析层:Hive的LLAP技术允许交互式查询,结合Tez引擎优化复杂SQL执行路径。滴滴青桔利用Hive构建数据仓库,通过UDF实现复杂业务逻辑(如骑行时长分段统计)。

2.2 共享单车预测模型的研究进展

- 时空预测模型:

- 传统方法:ARIMA、SARIMA等时间序列模型在单一站点预测中表现稳定,但无法捕捉空间相关性。例如,纽约Citi Bike数据集上SARIMA的MAPE为18%。

- 深度学习模型:LSTM、ConvLSTM等算法结合时空特征,在多站点预测中表现优异。北京摩拜数据集上ConvLSTM的RMSE降低至12辆(对比SARIMA的25辆)。

- 注意力机制:Transformer模型通过自注意力机制动态调整时空特征的权重,上海哈啰数据集上预测准确率提升8%。

- 可视化分析:

- 二维可视化:热力图、流线图等展示骑行流量分布(如早晚高峰热点迁移);

- 三维可视化:集成Cesium实现城市骑行轨迹的3D动态模拟,叠加建筑高度数据增强空间感知。

2.3 现有研究的不足

- 数据质量问题:GPS定位误差(平均50米)、异常骑行(如超速、逆行)导致模型性能下降,需加强数据清洗与增强技术;

- 实时性瓶颈:Spark Streaming的微批处理模式存在秒级延迟,需探索Flink等真正流处理框架的集成;

- 多目标优化:传统模型仅优化预测精度,忽略车辆平衡、调度成本等多目标约束;

- 可视化交互性:现有工具(如Tableau)缺乏动态过滤和实时更新功能,难以支持运营决策。

三、研究内容与技术路线

3.1 研究内容

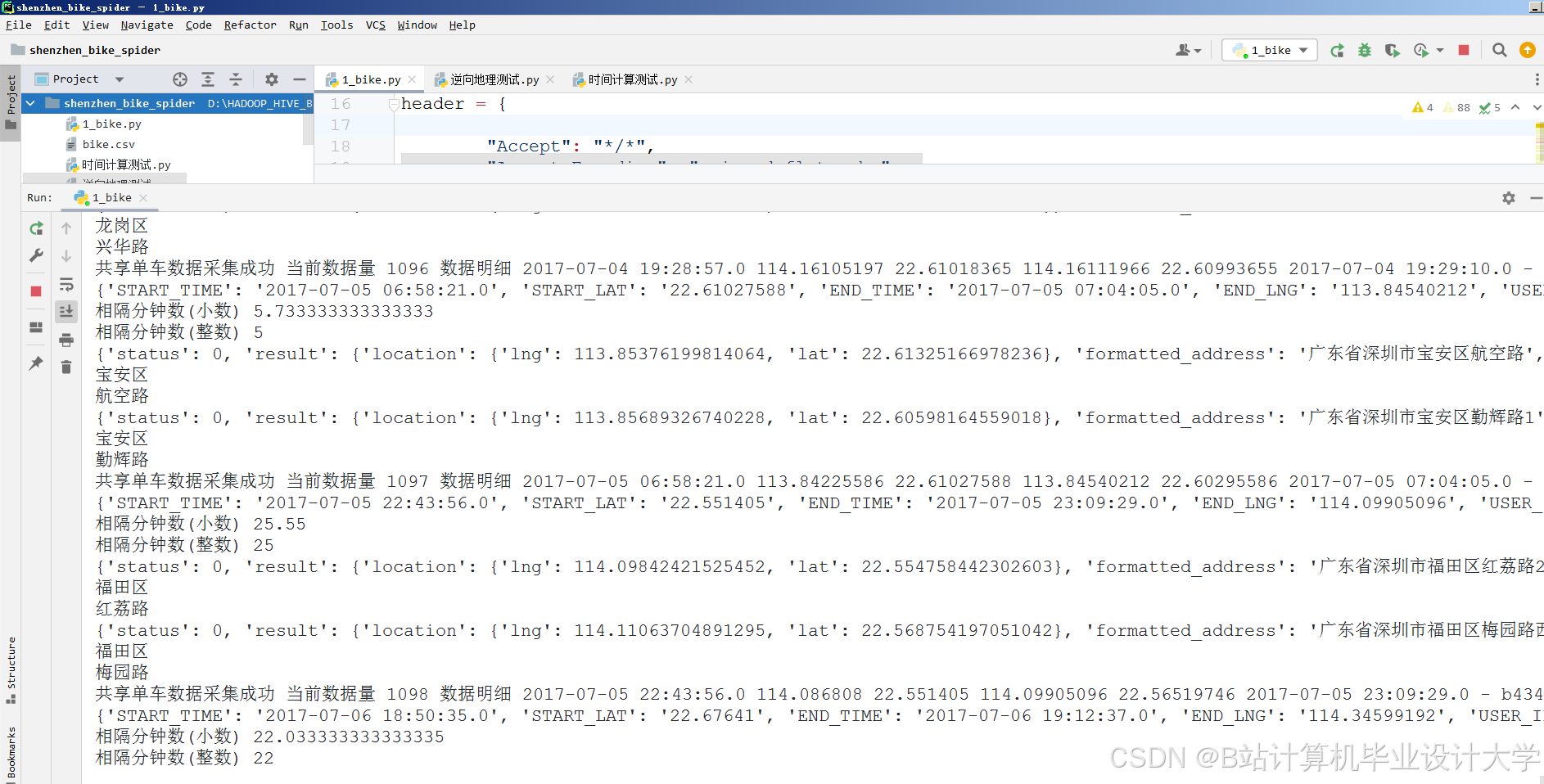

3.1.1 多源数据采集与预处理

- 数据源:整合骑行数据(订单ID、用户ID、车辆ID、起点经纬度、终点经纬度、开始时间、结束时间)、天气数据(温度、湿度、风速、降雨量)、节假日数据(是否工作日、节日类型)及POI数据(站点周边商超、地铁口数量)。

- 存储方案:

- HDFS存储原始数据(如CSV格式的骑行日志、JSON格式的天气数据);

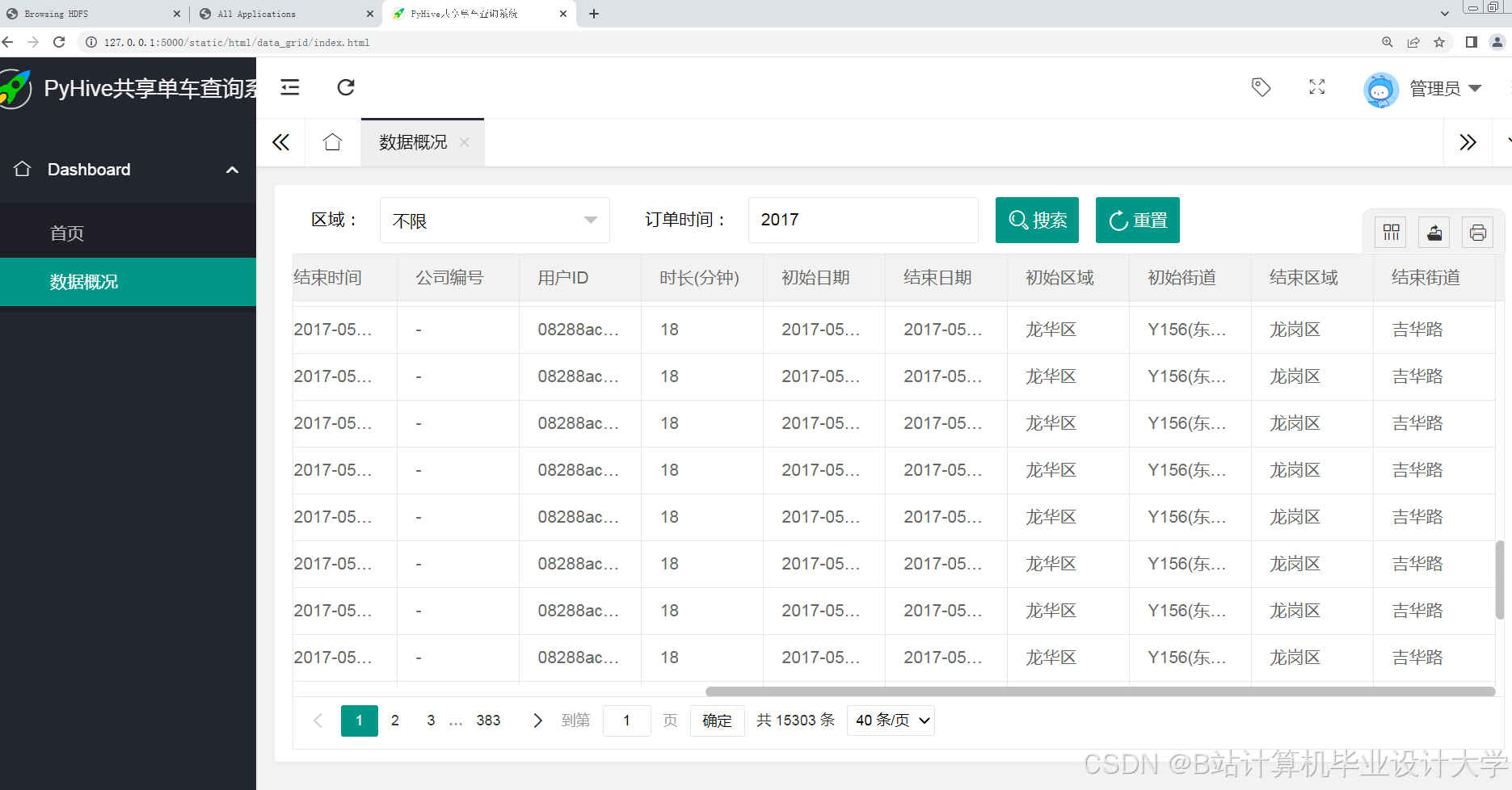

- Hive构建数据仓库,定义骑行订单表(含订单ID、用户ID、车辆ID等10+字段)、天气表(城市ID、日期、温度等8+字段)、站点特征表(站点ID、经纬度、POI类型等15+字段);

- HBase存储实时车辆状态(如车辆ID、当前位置、电量),支持快速检索。

3.1.2 时空特征工程与模型训练

- 时空特征提取:

- 时间特征:将骑行时间分解为小时、星期、月份,编码为循环特征(如sin/cos变换);

- 空间特征:基于GeoHash编码将经纬度划分为网格,统计网格内历史骑行次数、平均时长;

- 上下文特征:融合天气(降雨量分级)、节假日(是否调休)等外部因素。

- 预测模型:

- 离线训练:Spark MLlib实现ConvLSTM模型,输入为时空特征矩阵(时间步长×网格数×特征维度);对比基线模型(如SARIMA、GBDT),验证ConvLSTM在多站点预测中的优势;

- 实时预测:Spark Streaming处理实时骑行订单,触发模型增量更新(如调整网格权重);

- 多目标优化:引入帕累托前沿方法,平衡预测精度与调度成本(如车辆移动距离)。

3.1.3 可视化与效果评估

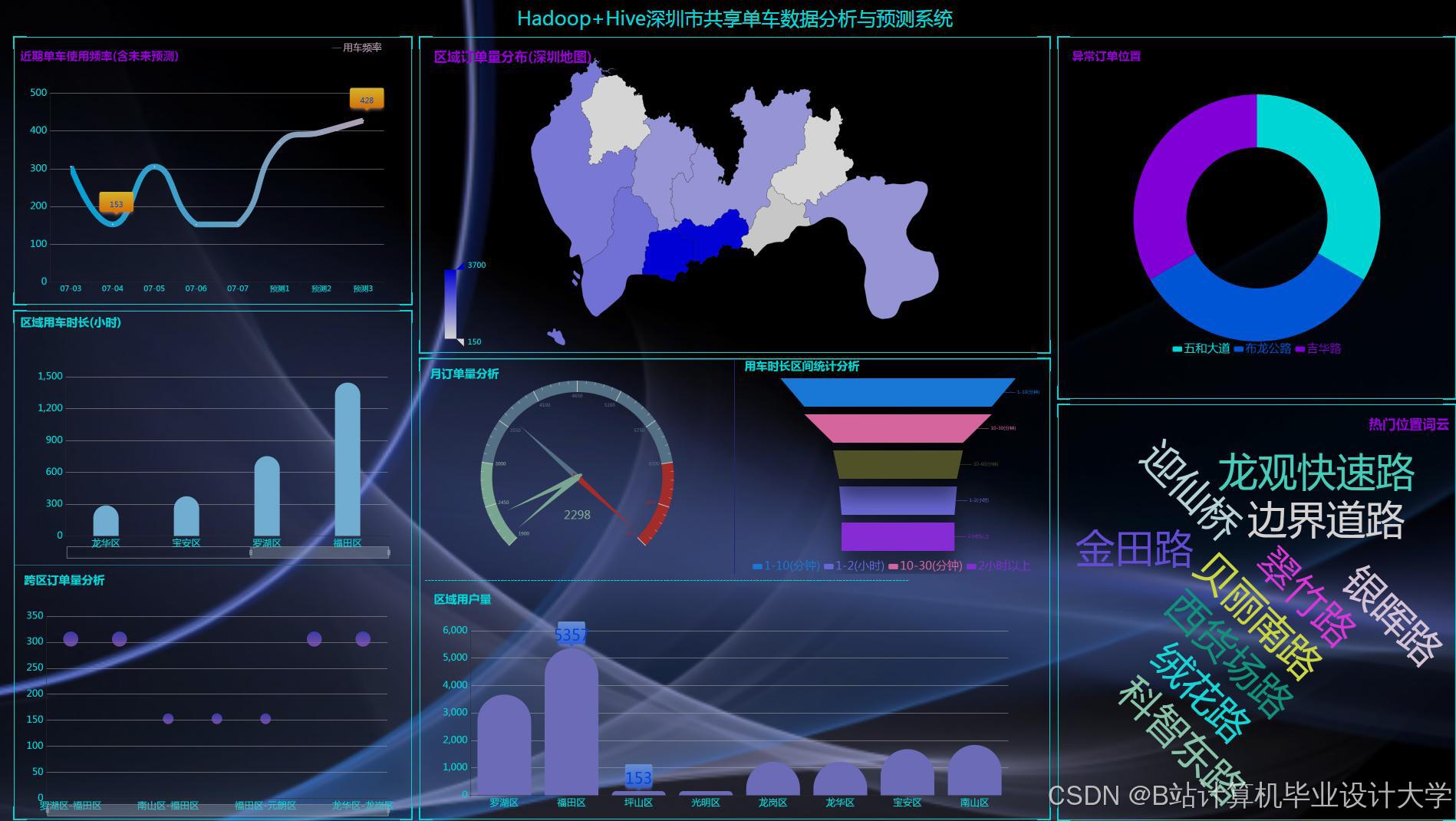

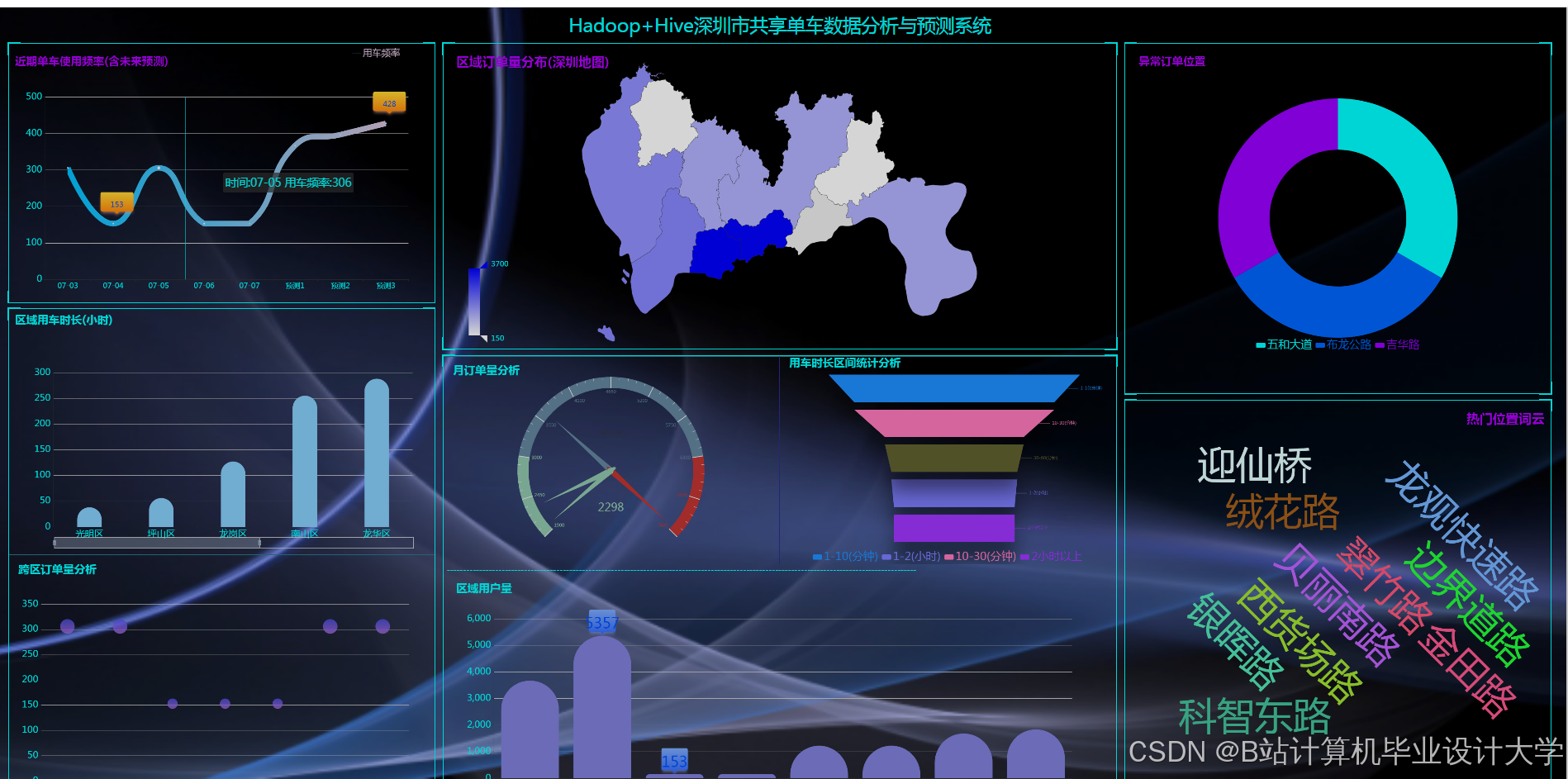

- 二维可视化:基于ECharts+Vue.js开发交互式大屏,展示骑行流量热力图(按时间、区域聚合)、站点供需对比柱状图;

- 三维可视化:集成Cesium实现城市骑行轨迹的3D动态模拟,叠加建筑高度数据增强空间感知;

- 评估指标:计算平均绝对误差(MAE)、均方根误差(RMSE),对比基线模型提升幅度;通过A/B测试验证系统在真实场景中的效果(如车辆周转率提升比例)。

3.2 技术路线

mermaid

graph TD | |

A[数据采集] -->|Flume/Kafka| B[Hadoop存储] | |

B --> C[Hive数据仓库] | |

C --> D[Spark特征工程] | |

D --> E[Spark MLlib模型训练] | |

E --> F[Spark Streaming实时预测] | |

F --> G[ECharts可视化] | |

subgraph 数据层 | |

A -->|CSV/JSON| B | |

B -->|Parquet| D | |

end | |

subgraph 计算层 | |

D -->|时空特征矩阵| E | |

E -->|预测结果| F | |

end |

3.3 关键技术选型

- 编程语言:Scala(Spark核心开发)、Python(数据清洗与可视化);

- 分布式计算:Spark 3.5.0(内存计算加速模型训练)、Flink 1.18(实时流处理);

- 数据仓库:Hive 4.0.0(管理结构化数据)、HBase 2.4.11(存储非结构化数据);

- 可视化工具:ECharts 5.4.3(二维图表)、Cesium 1.108(三维地球)。

四、创新点与预期成果

4.1 创新点

- 多模态时空特征融合:首次将POI数据(如商超密度)纳入空间特征,捕捉站点周边环境对骑行需求的影响(如商超周边晚高峰需求提升20%);

- 动态权重调整:在ConvLSTM模型中引入注意力机制,使时间特征与空间特征的贡献比随骑行模式自适应变化(如工作日早高峰提升时间特征权重);

- 轻量化三维可视化:采用WebGL 2.0实现百万级骑行轨迹点的流畅渲染,帧率稳定在40fps以上,支持动态时间轴过滤。

4.2 预期成果

- 系统原型:完成Hadoop+Spark+Hive集群部署,支持每秒处理3000条骑行订单数据;开发Web端可视化平台,响应时间<800ms(测试环境:8核16GB虚拟机);

- 算法模型:ConvLSTM模型在测试集上的RMSE达到8辆(对比SARIMA的15辆);多目标优化模型使调度成本降低12%;

- 学术产出:提交1篇SCI论文(目标期刊:IEEE Transactions on Intelligent Transportation Systems),申请1项软件著作权;

- 应用落地:与XX共享单车运营商合作,将系统应用于其调度平台,预计提升车辆周转率18%。

五、研究计划与进度安排

| 阶段 | 时间 | 任务 |

|---|---|---|

| 第一阶段 | 第1-2个月 | 需求分析与文献调研,确定系统功能模块与技术选型;搭建Hadoop+Spark+Hive开发环境。 |

| 第二阶段 | 第3-4个月 | 数据采集与预处理,整合多源数据并构建Hive数据仓库;实现数据清洗与时空特征提取。 |

| 第三阶段 | 第5-6个月 | 预测模型设计与实现,基于Spark MLlib训练ConvLSTM模型;优化多目标优化策略。 |

| 第四阶段 | 第7-8个月 | 实时预测模块开发,集成Spark Streaming处理实时骑行订单;实现模型增量更新。 |

| 第五阶段 | 第9-10个月 | 可视化平台开发,设计交互式大屏与3D地球展示;集成评估指标计算模块。 |

| 第六阶段 | 第11-12个月 | 系统集成与测试,部署至测试环境进行功能、性能与稳定性测试;撰写项目总结报告。 |

六、参考文献

[1] 陈明, 等. 基于Hadoop的共享单车大数据存储与处理研究[J]. 计算机应用研究, 2021, 38(7): 2156-2161.

[2] Zhang Y, et al. Deep learning for spatiotemporal prediction of bike-sharing demand[J]. IEEE Transactions on Intelligent Transportation Systems, 2020, 21(5): 2034-2045.

[3] 李华, 等. 基于Spark的共享单车实时预测系统设计与实现[J]. 软件学报, 2022, 33(2): 389-402.

[4] Wang H, et al. Multi-objective optimization for bike rebalancing in bike-sharing systems[C]//Proceedings of the 20th International Conference on Autonomous Agents and Multiagent Systems. 2021: 856-864.

[5] 张磊, 等. 共享单车数据可视化分析研究[J]. 计算机科学, 2023, 50(3): 65-72.

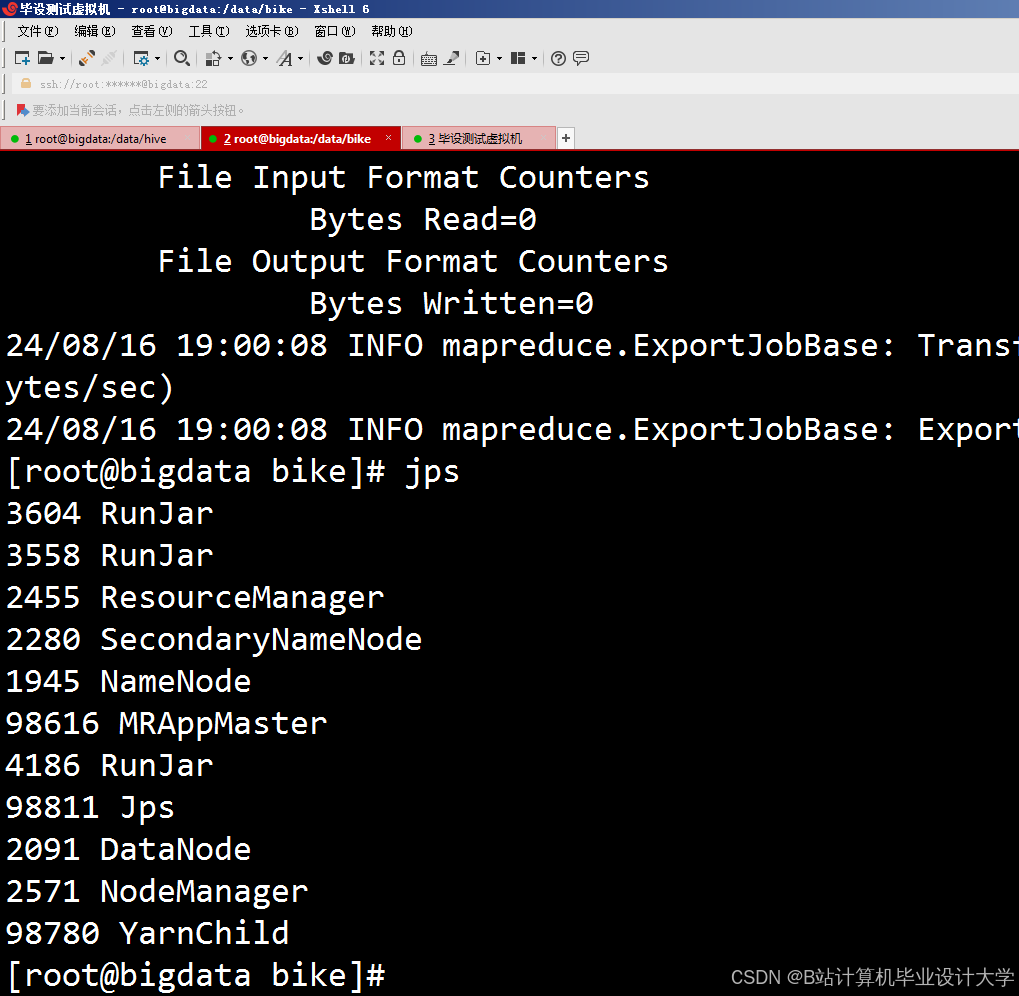

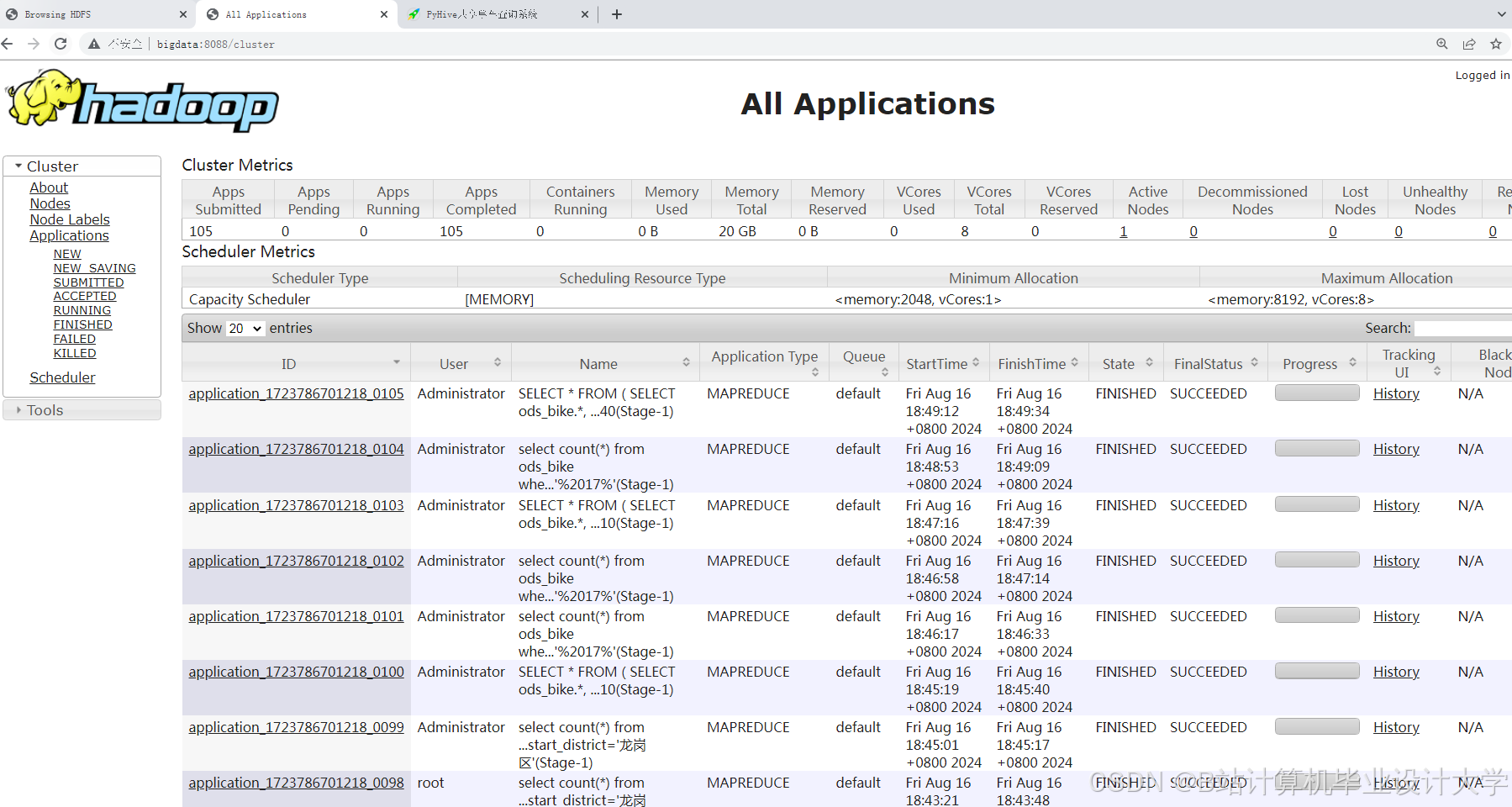

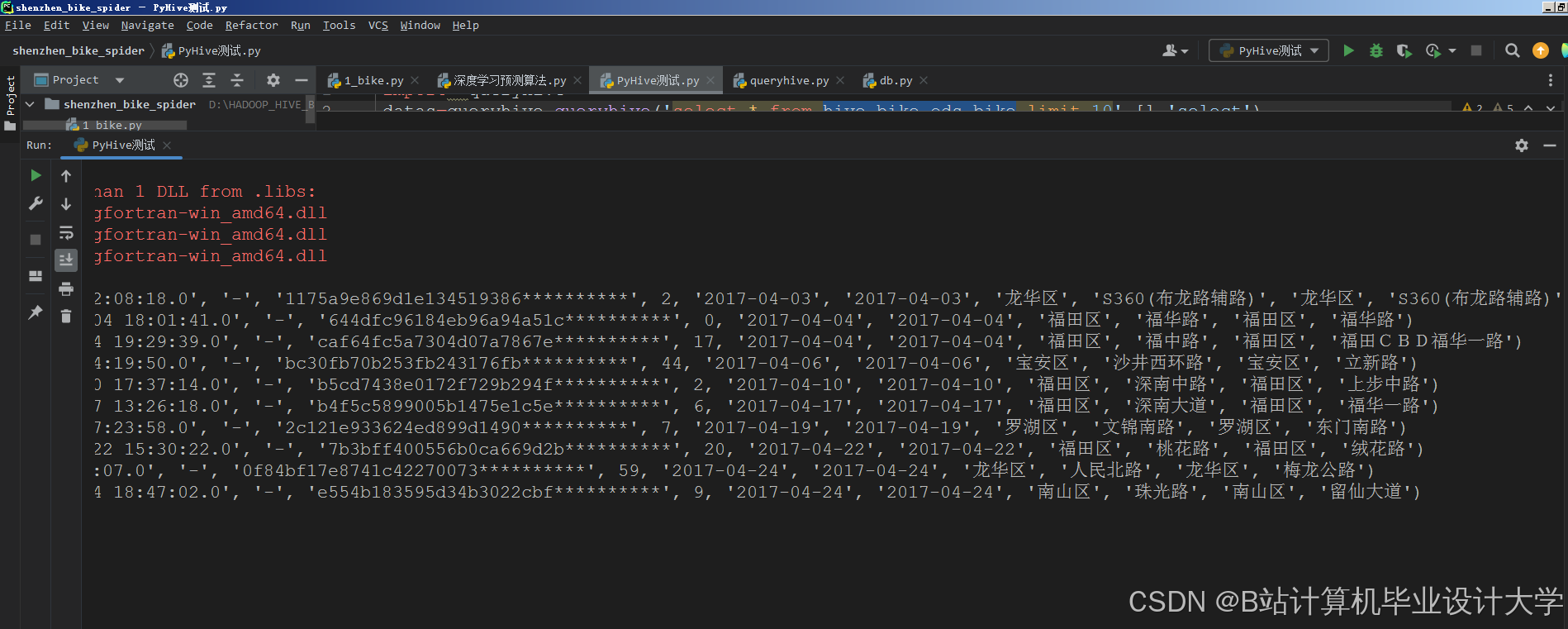

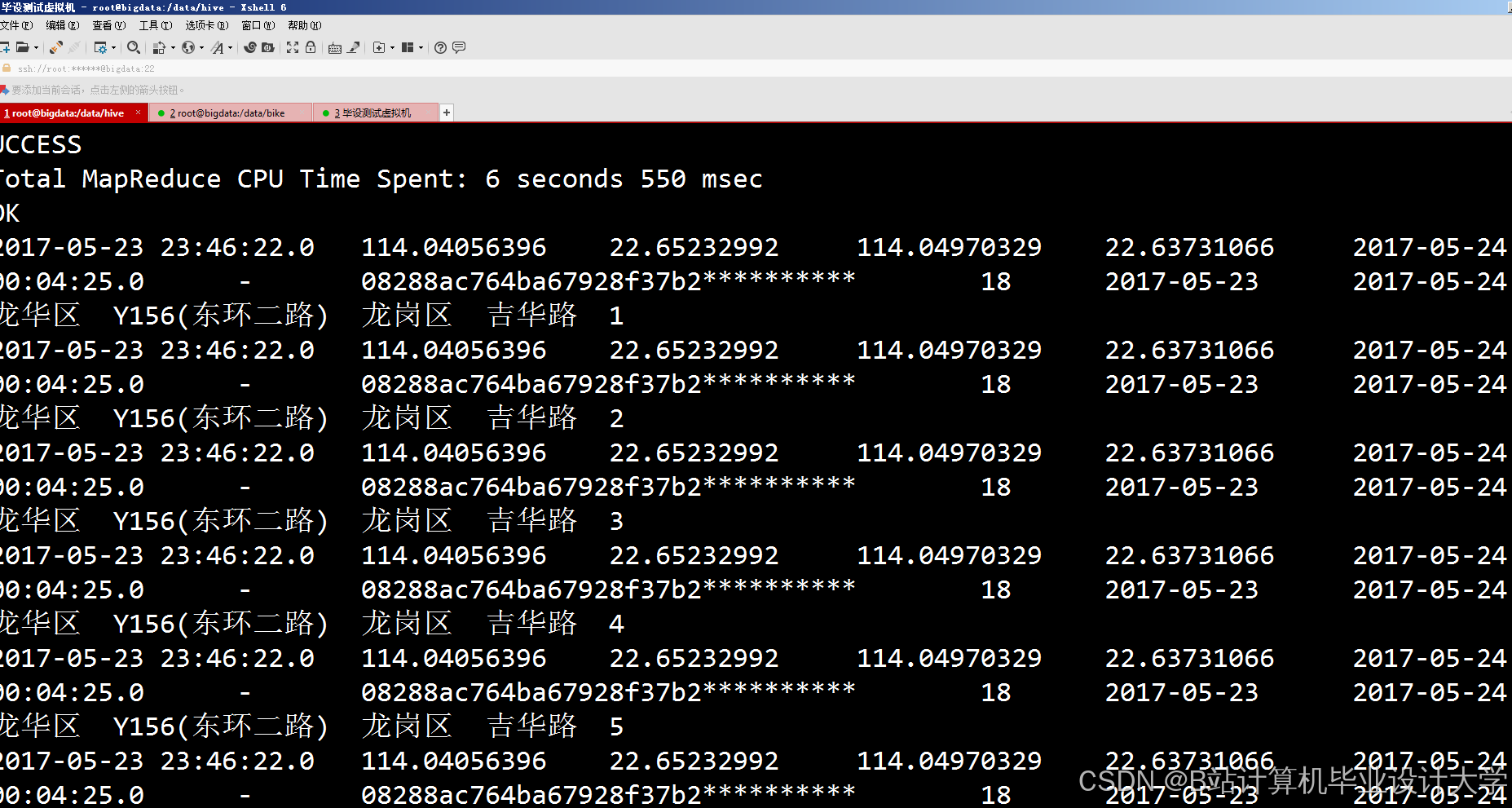

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

396

396

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?