温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一份关于《Hadoop+Spark+Hive视频推荐系统》的任务书模板,结合大数据处理、推荐算法开发与实时推荐需求设计:

任务书

项目名称:基于Hadoop+Spark+Hive的智能视频推荐系统

项目周期:18周

项目负责人:XXX

团队成员:XXX、XXX、XXX

一、项目背景与目标

- 背景

- 视频平台(如YouTube、抖音)用户规模爆发式增长,用户行为数据(点击、观看时长、点赞)和视频元数据(标题、标签、分类)呈现海量、高维、实时性强的特点。

- 传统推荐系统(如基于规则的推荐)难以处理复杂用户兴趣和冷启动问题,需结合大数据技术(Hadoop存储、Spark计算)与机器学习算法(协同过滤、深度学习)实现个性化推荐。

- Hive可管理历史行为数据,Spark支持实时特征计算与模型推理,Hadoop提供分布式存储基础,共同构建高并发、低延迟的推荐引擎。

- 目标

- 构建用户行为数据采集与存储系统,覆盖点击、观看、收藏、分享等行为。

- 基于Spark实现用户画像构建与视频特征提取,支持离线批处理与实时更新。

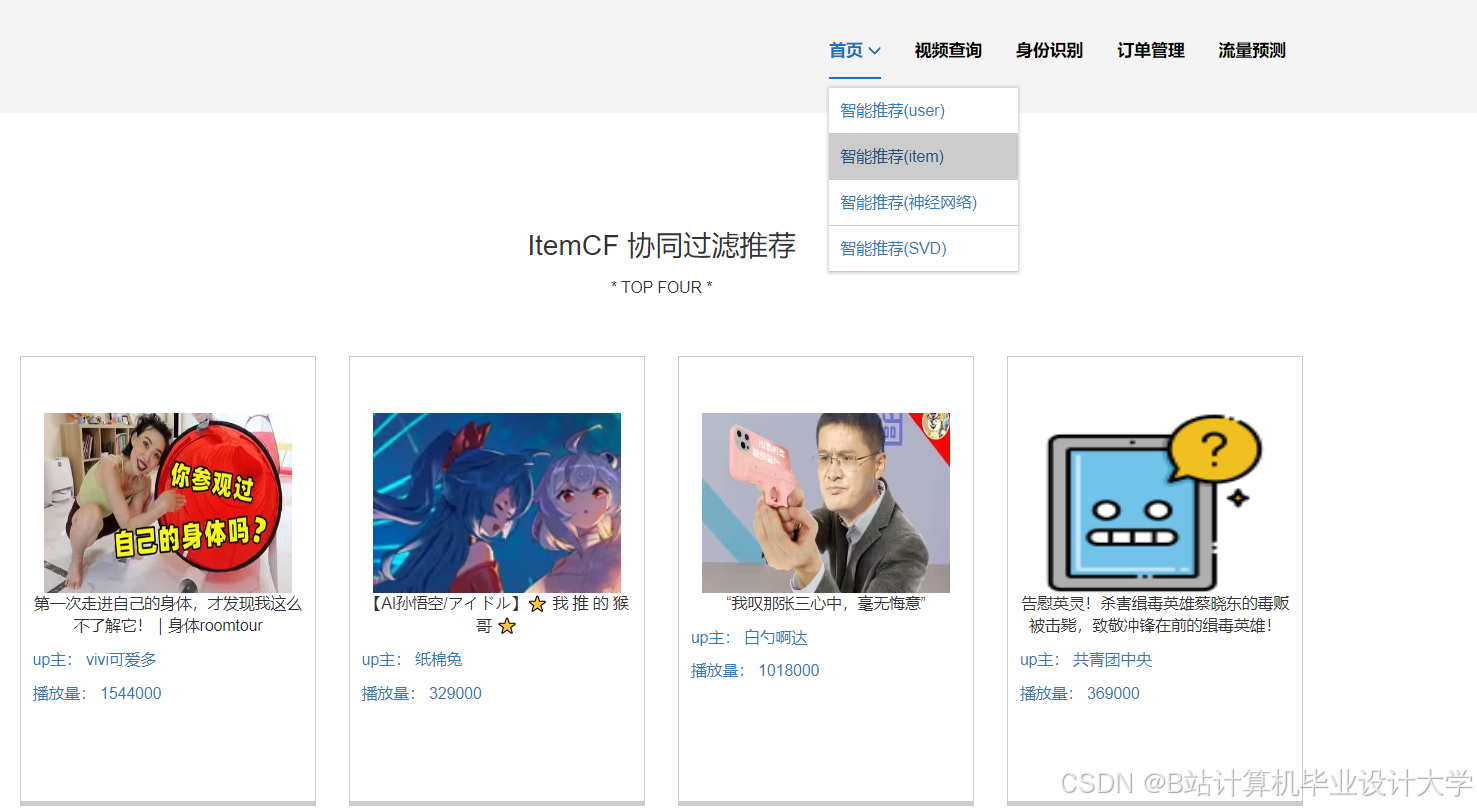

- 开发混合推荐模型(协同过滤+内容过滤+深度学习),提升推荐多样性(覆盖率)与精准度(点击率)。

- 通过Hive管理推荐结果,结合可视化工具(Grafana/Superset)展示推荐效果指标(如CTR、用户留存率)。

二、项目任务分解

模块1:多源数据采集与存储(Hadoop+Flume+Kafka)

- 任务内容

- 数据源整合:

- 用户行为数据:点击日志(用户ID、视频ID、时间戳)、观看时长记录、互动行为(点赞/评论/分享)。

- 视频元数据:标题、标签、分类、上传者、时长、分辨率(结构化数据,JSON/CSV格式)。

- 上下文数据:设备类型(手机/PC)、地理位置、时间(工作日/周末)。

- 数据采集:

- 实时数据:使用Flume采集用户点击日志,通过Kafka缓冲避免数据丢失,最终写入HDFS。

- 离线数据:编写Python脚本批量导入视频元数据至Hive表。

- 数据存储:

- 原始日志存储于HDFS,按日期分区(如

/logs/raw/20240101/)。 - 使用Hive创建外部表,定义字段类型(如

user_id STRING, video_id STRING, click_time TIMESTAMP)。

- 原始日志存储于HDFS,按日期分区(如

- 数据源整合:

- 技术工具

- Hadoop HDFS(分布式存储)

- Flume(日志采集)

- Kafka(消息队列,防数据堆积)

- Hive(数据仓库建模)

模块2:用户画像与视频特征工程(Spark)

- 任务内容

- 用户画像构建:

- 基础属性:年龄、性别、注册时间(从用户信息表关联获取)。

- 行为特征:

- 短期兴趣:统计过去7天点击次数最多的Top 10视频分类。

- 长期偏好:计算用户历史观看视频的标签TF-IDF权重(如“科技”标签出现频率)。

- 实时特征:使用Spark Structured Streaming更新用户当前会话的点击序列(用于序列推荐)。

- 视频特征提取:

- 内容特征:

- 文本特征:通过BERT模型提取视频标题的语义向量(降维至128维)。

- 标签特征:对多标签分类进行One-Hot编码(如“动作+喜剧”转为[1,0,1,0...])。

- 统计特征:计算视频过去24小时的点击量、平均观看时长、完播率。

- 内容特征:

- 数据存储:

- 用户画像与视频特征存储至Hive分区表(如

/feature/user/date=20240101/)。 - 特征矩阵保存为Parquet格式以优化查询性能。

- 用户画像与视频特征存储至Hive分区表(如

- 用户画像构建:

- 技术工具

- Spark SQL(特征统计)

- Spark MLlib(特征转换,如TF-IDF)

- HuggingFace Transformers(BERT文本嵌入)

- Hive(特征管理)

模块3:推荐模型开发(Spark ALS+TensorFlow)

- 任务内容

- 离线推荐模型:

- 协同过滤(ALS):

- 使用Spark MLlib的

ALS算法训练用户-视频评分矩阵(隐式反馈:观看时长标准化为0-1评分)。 - 生成用户潜在因子向量(User Factors)和视频潜在因子向量(Item Factors)。

- 使用Spark MLlib的

- 内容过滤:

- 计算用户历史偏好向量(标签TF-IDF加权平均)与视频特征向量的余弦相似度。

- 模型融合:

- 加权组合ALS评分与内容相似度(如权重比7:3),生成Top 200候选视频列表。

- 协同过滤(ALS):

- 实时推荐模型:

- 序列推荐(GRU4Rec):

- 使用TensorFlow/Keras构建GRU神经网络,输入用户点击序列(过去10个视频ID),预测下一个可能点击的视频。

- 通过PySpark的

Pandas UDF将模型部署至Spark集群,实现分布式推理。

- 序列推荐(GRU4Rec):

- 冷启动处理:

- 新用户:推荐热门视频(按点击量排序)+基于设备类型的个性化(如手机用户优先短视频)。

- 新视频:基于内容相似度推荐给相似兴趣用户(如“新上线的科幻电影”推荐给历史观看过《星际穿越》的用户)。

- 离线推荐模型:

- 技术工具

- Spark MLlib(ALS协同过滤)

- TensorFlow/Keras(深度学习模型)

- MLflow(模型版本管理)

模块4:推荐结果生成与排序(Spark+Hive)

- 任务内容

- 候选集生成:

- 合并离线推荐(ALS+内容过滤)与实时推荐(GRU4Rec)结果,去重后保留Top 500视频。

- 排序优化:

- 多目标排序:

- 使用XGBoost训练排序模型,输入特征包括:预测点击率(pCTR)、视频时长、用户历史互动率、广告标识(是否付费)。

- 输出综合得分,按得分降序排列生成最终推荐列表(Top 20)。

- 多样性控制:

- 限制同一分类的视频数量(如不超过3个),避免信息茧房。

- 多目标排序:

- 结果存储:

- 将推荐结果(用户ID、视频ID列表、排序分数)写入Hive表,供前端调用。

- 候选集生成:

- 技术工具

- Spark SQL(结果合并与去重)

- XGBoost(排序模型)

- Hive(推荐结果管理)

模块5:推荐效果评估与可视化(Grafana+Superset)

- 任务内容

- 离线评估:

- 划分训练集/测试集(时间窗口:前7天训练,第8天测试)。

- 计算指标:准确率(Precision@K)、召回率(Recall@K)、覆盖率(推荐视频种类占比)。

- 在线AB测试:

- 将用户随机分为两组,A组使用旧推荐策略,B组使用新模型,对比7日点击率(CTR)提升幅度。

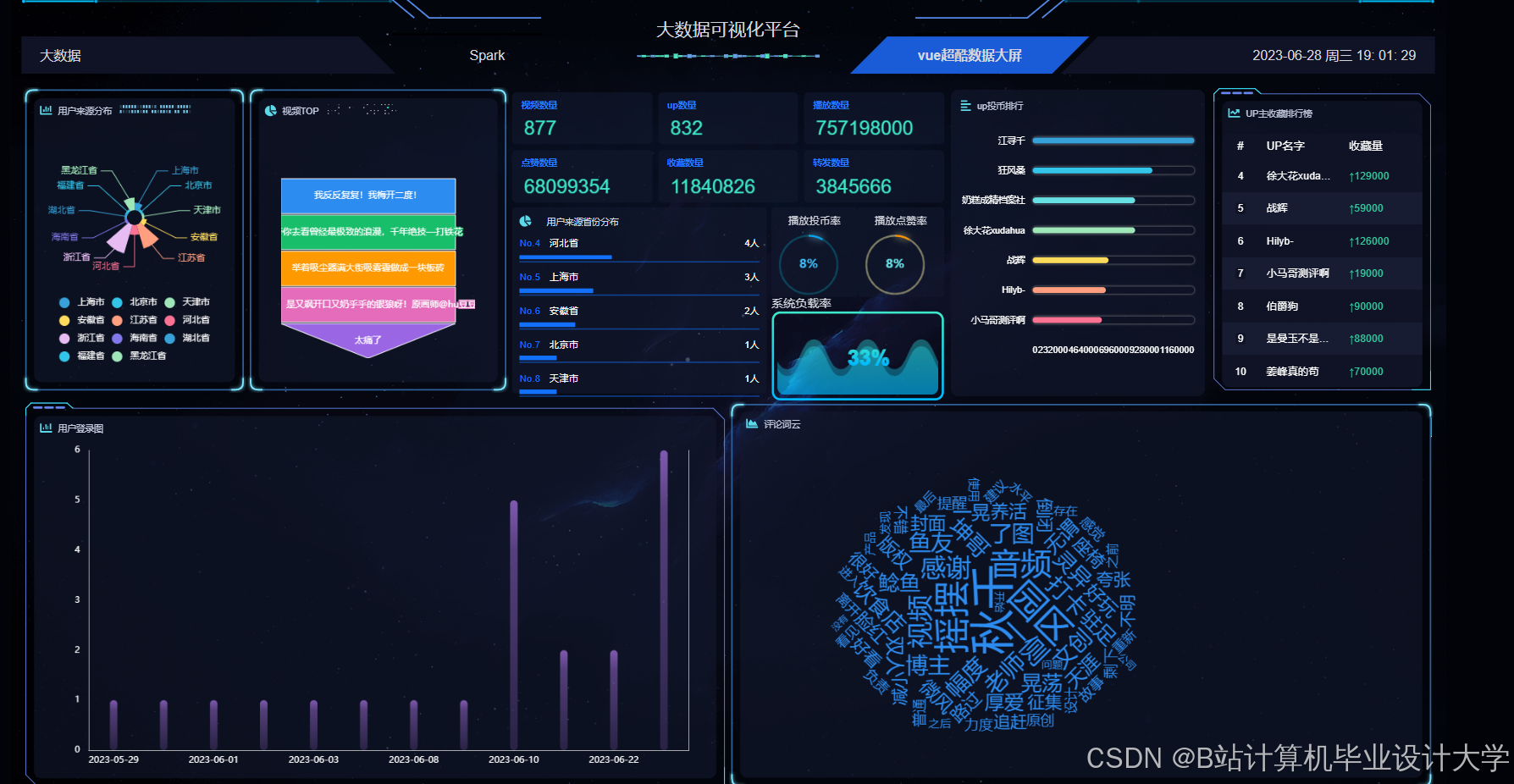

- 可视化看板:

- 核心指标:实时展示CTR、平均观看时长、用户留存率(折线图)。

- 推荐分布:饼图展示不同分类视频的推荐占比(如“科技”占25%)。

- 用户反馈:柱状图显示用户对推荐结果的满意度评分(1-5分)。

- 离线评估:

- 技术工具

- Grafana(实时指标监控)

- Apache Superset(多维分析看板)

- Jupyter Notebook(AB测试分析)

模块6:系统集成与性能优化

- 任务内容

- 批处理与流处理集成:

- 使用Airflow调度每日离线任务(如ALS模型训练、特征更新)。

- Spark Structured Streaming处理实时用户行为,触发GRU4Rec模型推理并更新推荐列表。

- 性能优化:

- 数据倾斜处理:对热门视频ID加盐(如

video_id_1、video_id_2)后进行JOIN操作。 - 缓存优化:在Spark中缓存频繁访问的Hive表(如用户画像表)。

- 模型轻量化:将GRU4Rec模型转换为TensorFlow Lite格式,减少推理延迟。

- 数据倾斜处理:对热门视频ID加盐(如

- 高可用设计:

- 部署HDFS NameNode HA与Spark Cluster Manager(YARN)。

- 使用Kafka多副本机制保障实时数据可靠性。

- 批处理与流处理集成:

- 技术工具

- Spark Structured Streaming(实时计算)

- Airflow(任务调度)

- Kafka(高可用消息队列)

三、时间计划

| 阶段 | 时间 | 任务 |

|---|---|---|

| 需求分析与设计 | 第1-2周 | 确定数据源、推荐算法选型(ALS vs. FM)、系统架构设计 |

| 数据采集与存储 | 第3-4周 | 完成Flume+Kafka实时采集配置,编写历史数据导入脚本,初始化Hive数据仓库 |

| 特征工程开发 | 第5-6周 | 实现Spark用户画像与视频特征计算,生成Parquet格式特征矩阵 |

| 模型开发与训练 | 第7-10周 | 完成Spark ALS模型训练,集成GRU4Rec深度学习模块,输出离线/实时推荐候选集 |

| 排序与评估 | 第11-12周 | 开发XGBoost排序模型,搭建AB测试框架,完成首轮在线评估 |

| 可视化开发 | 第13-14周 | 开发Grafana实时看板与Superset分析平台,实现与Hive/Spark的API对接 |

| 系统集成与优化 | 第15-16周 | 集成Airflow调度与Kafka消息队列,优化Spark作业性能,进行全链路压力测试 |

| 部署与验收 | 第17-18周 | 部署系统至生产环境(如AWS EMR),提交用户手册与维护文档,完成项目验收 |

四、预期成果

- 完成用户行为数据采集系统,覆盖至少10万日活用户与50万视频元数据。

- 离线推荐准确率(Precision@10)≥35%,实时推荐延迟≤200ms。

- 开发交互式可视化平台,支持推荐效果实时监控与多维分析。

- 提交项目文档(技术报告、用户手册、测试报告、代码仓库链接)。

五、风险评估与应对

- 数据稀疏性问题:

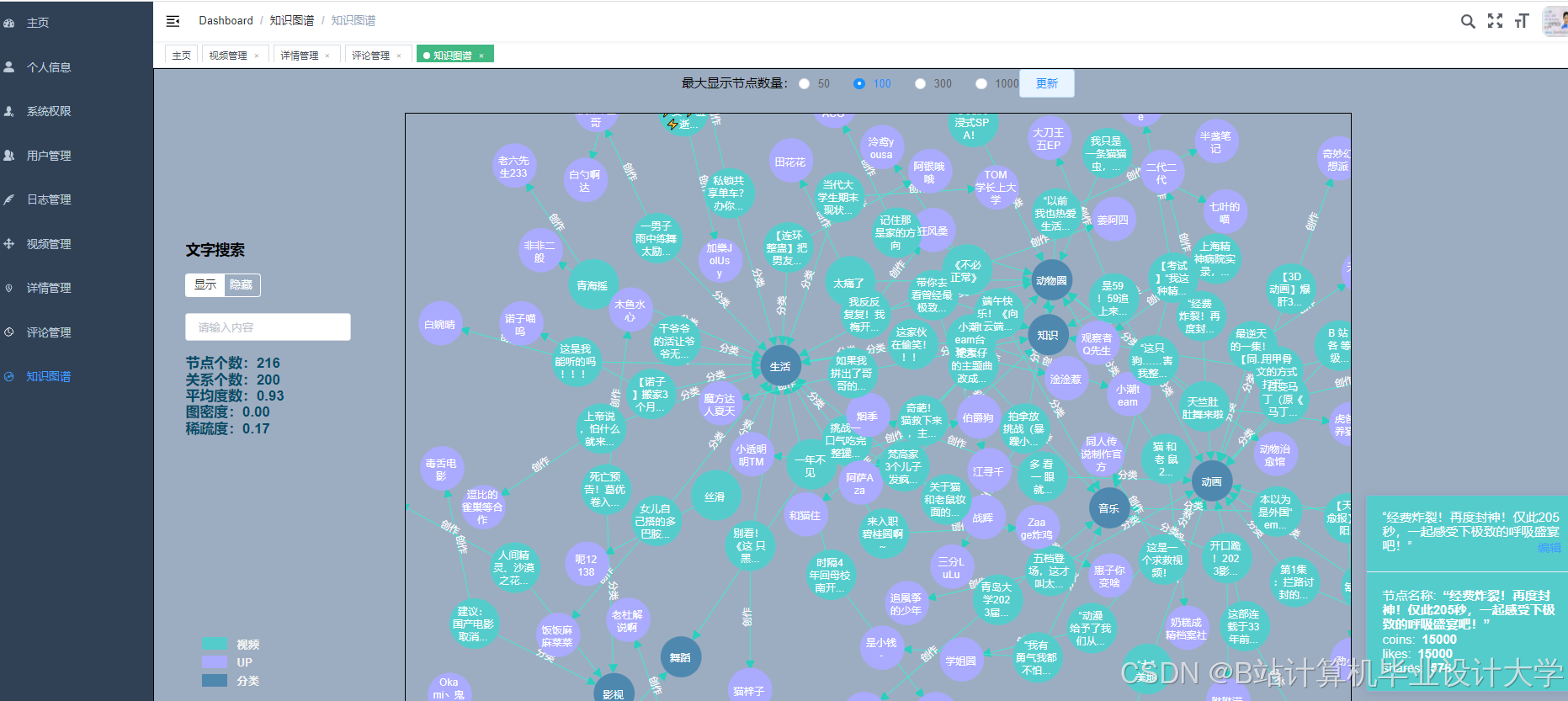

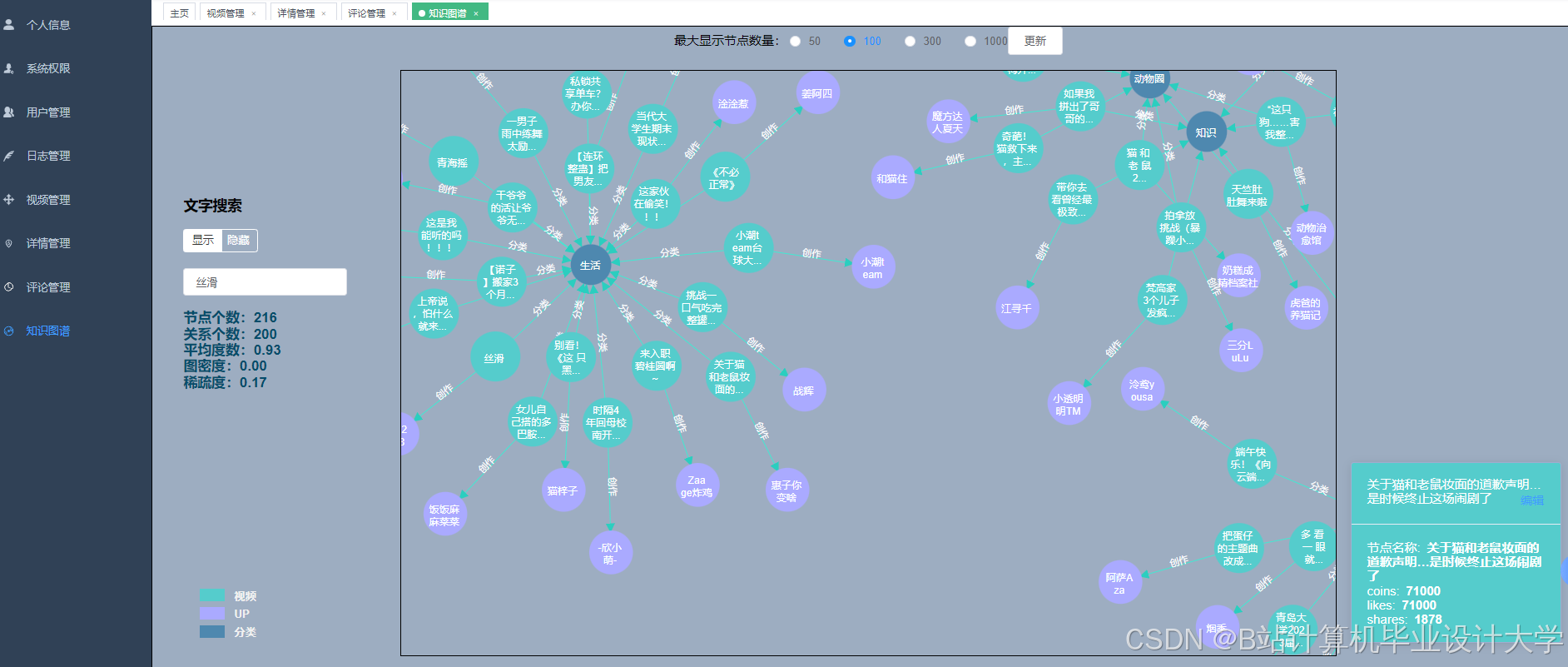

- 应对:对长尾用户/视频采用聚类降维(如K-Means聚类用户兴趣),或引入知识图谱补充关系。

- 模型更新延迟:

- 应对:使用Spark Streaming实时更新用户特征,缩短模型重训练周期(从每日改为每小时)。

- 冷启动效果差:

- 应对:结合热门推荐与基于内容的推荐,逐步积累新用户行为数据。

项目负责人签字:________________

日期:________________

此任务书可根据实际业务需求(如是否需支持广告推荐)调整模型复杂度与评估指标,建议优先实现离线推荐核心功能,再逐步扩展实时推荐与深度学习模块。

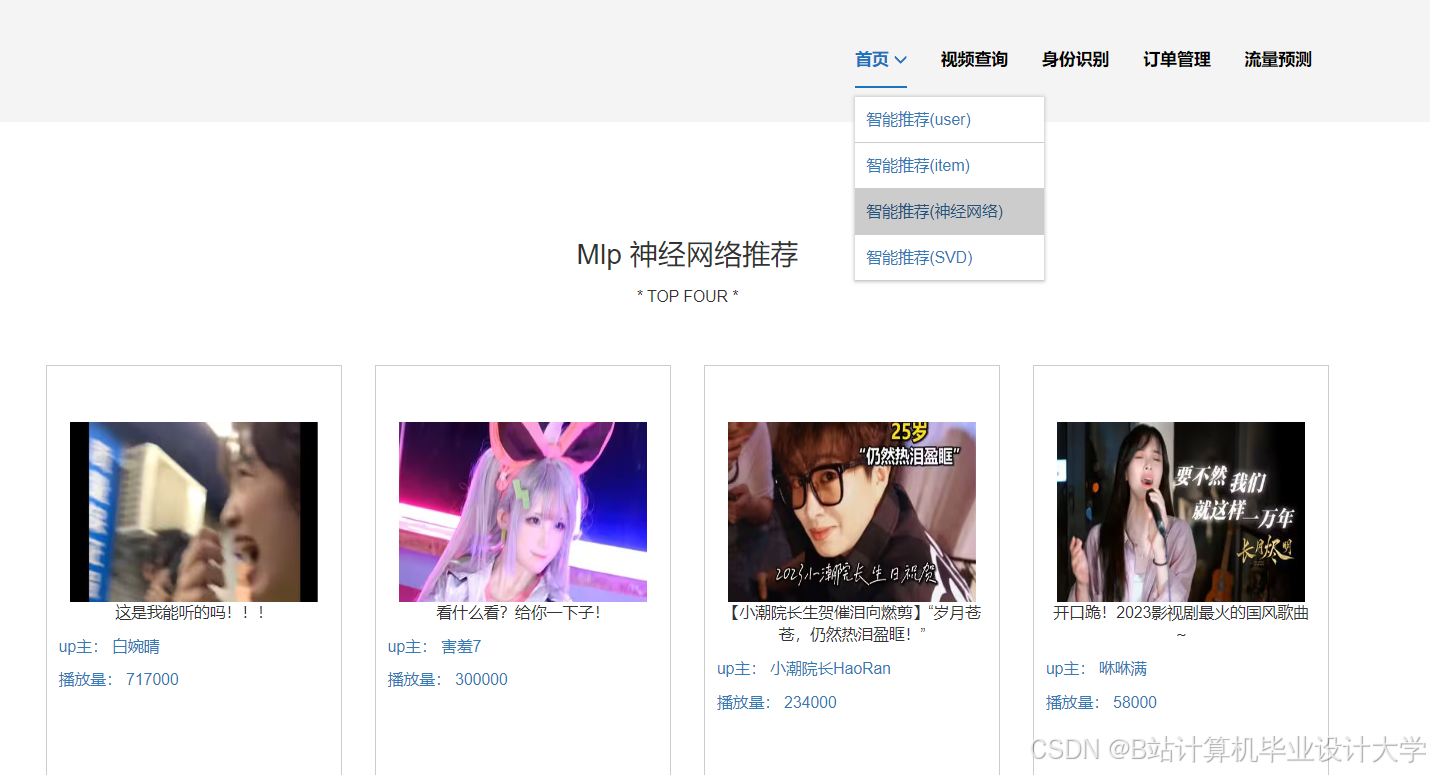

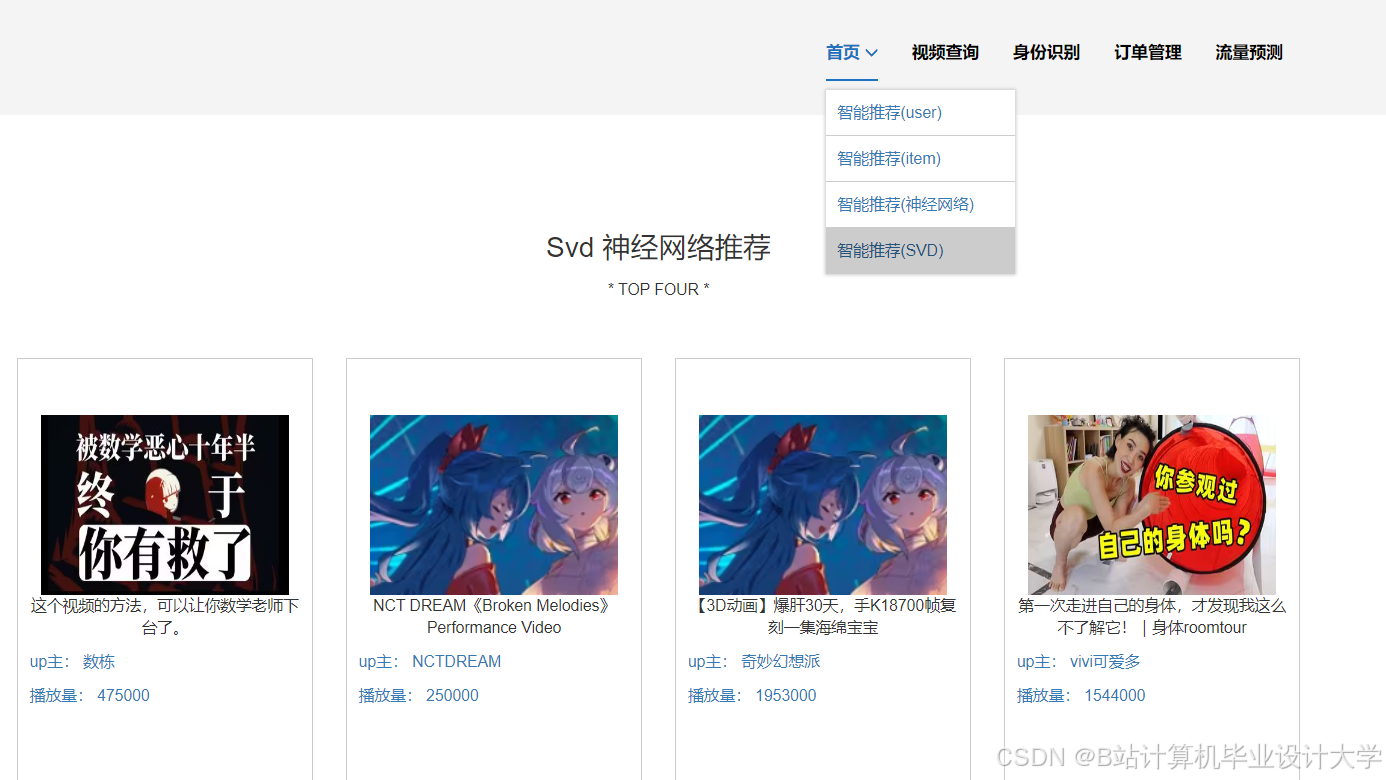

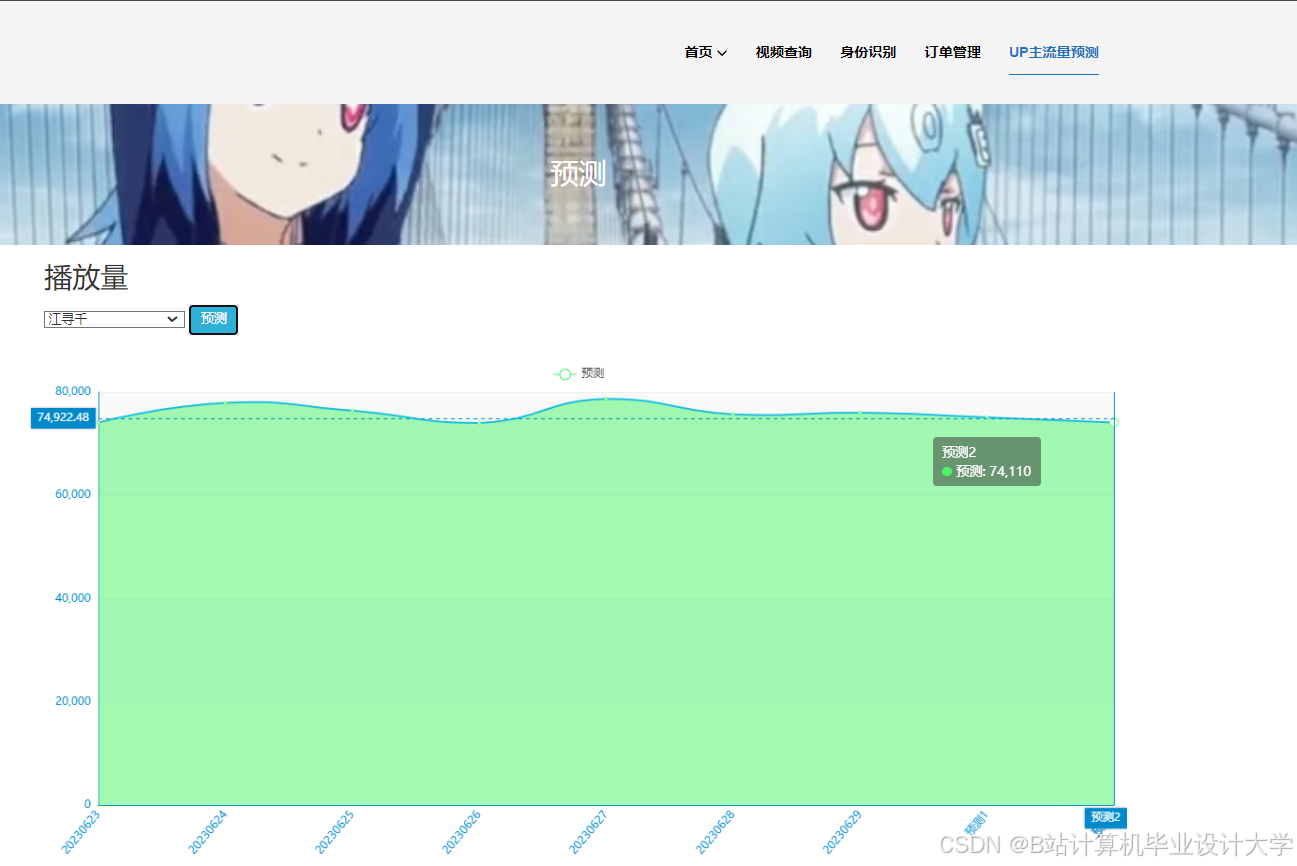

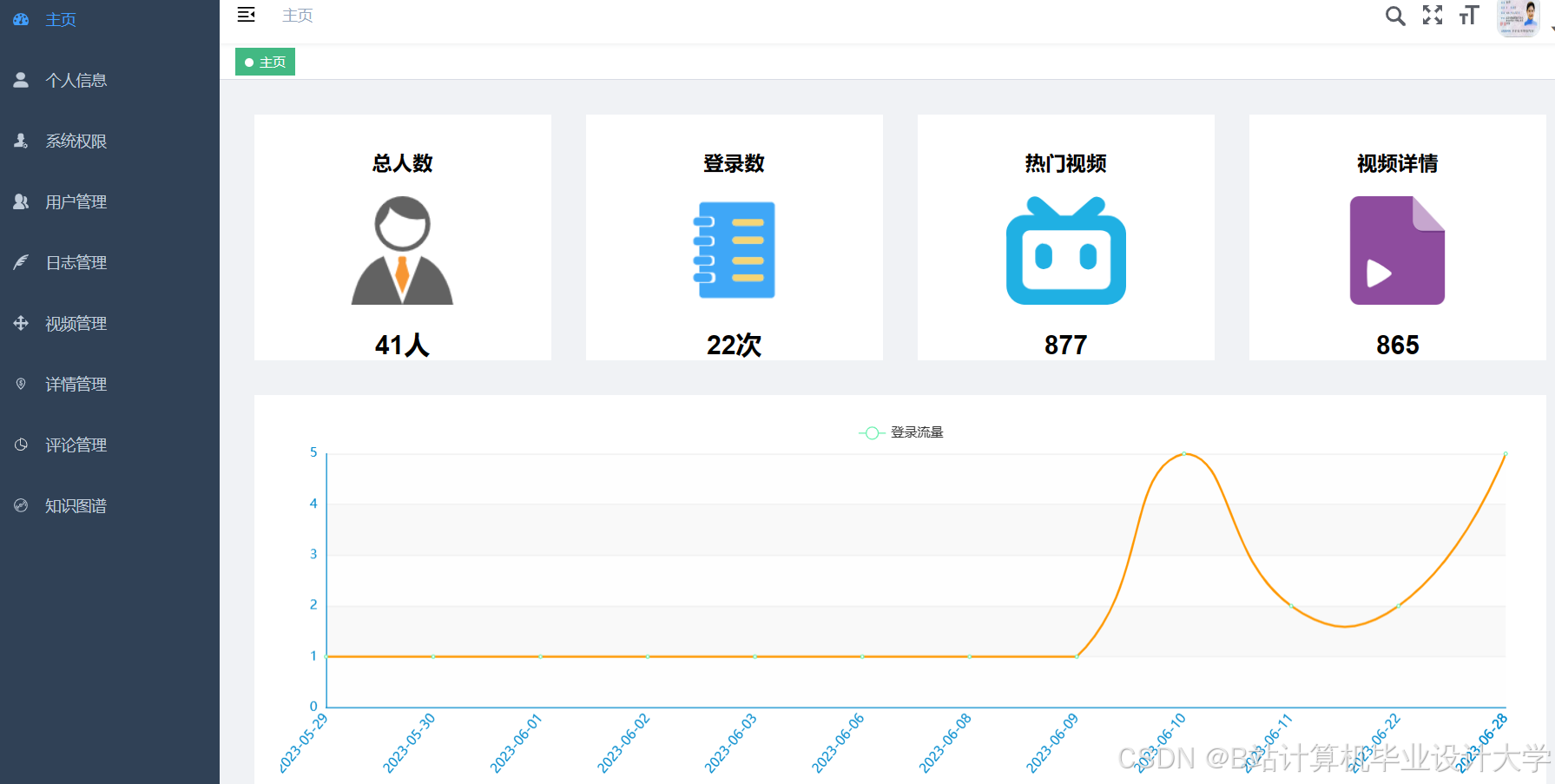

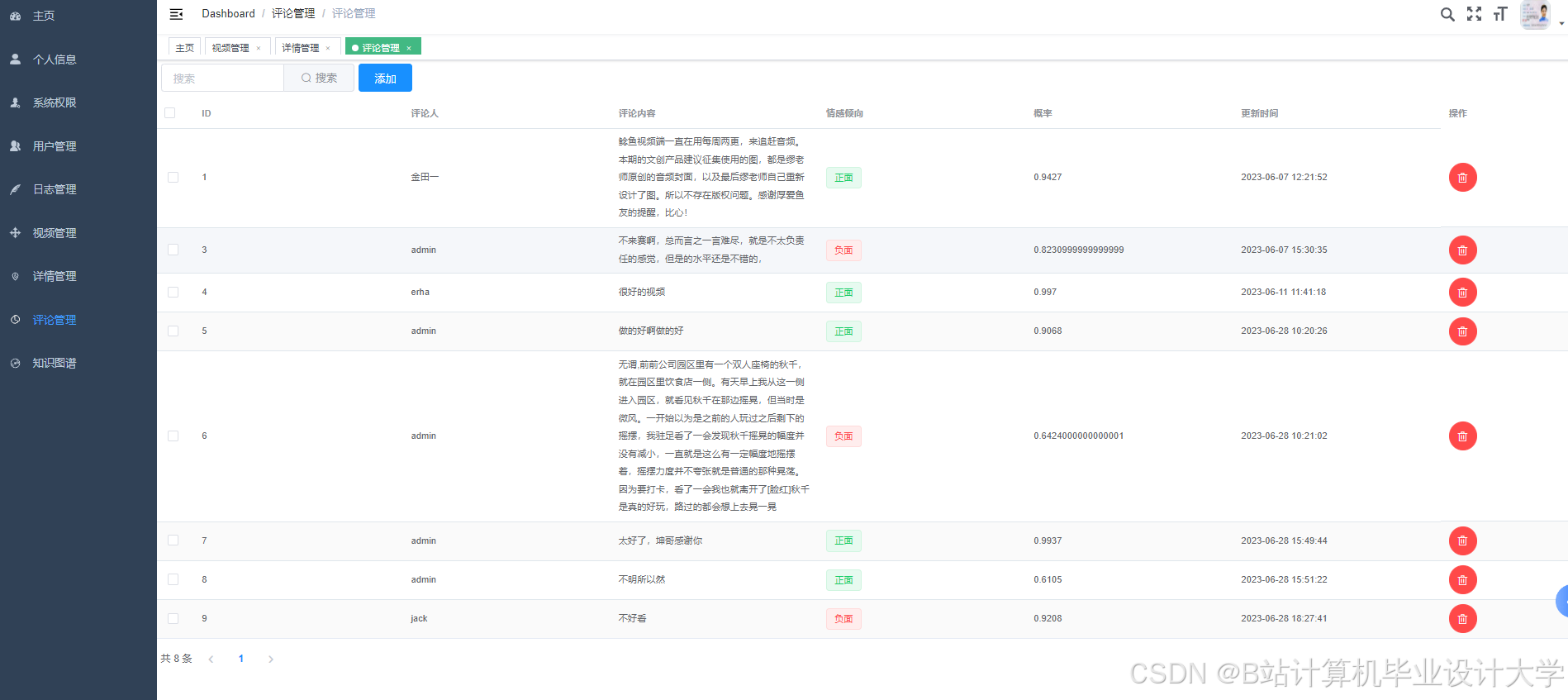

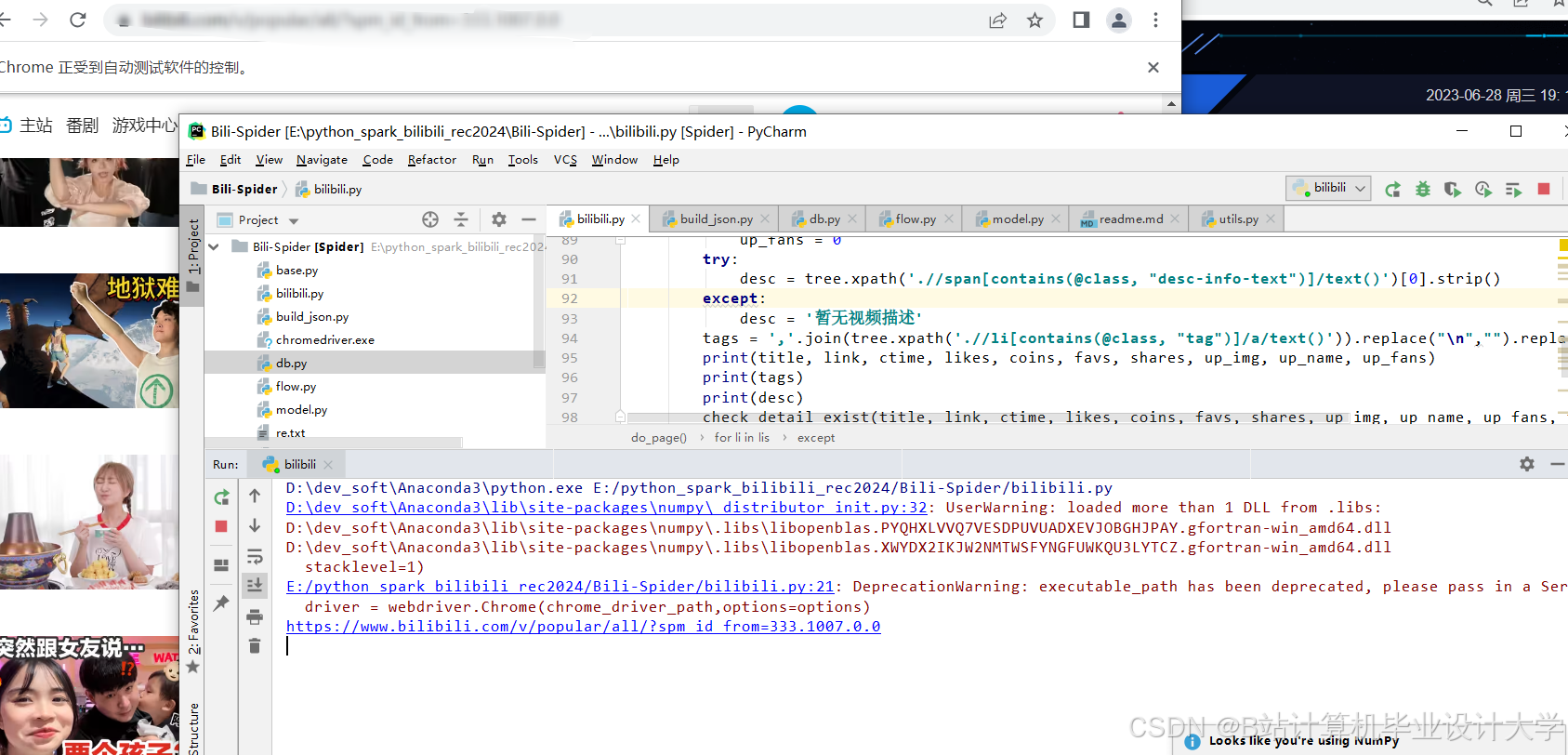

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?