温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Hadoop+Spark+Hive共享单车预测系统及数据可视化分析文献综述

引言

随着共享单车在全球范围内的普及,其日均骑行量已突破2亿次,成为城市短途出行的核心载体。然而,共享单车运营面临供需失衡、调度成本高昂等挑战。例如,北京早高峰期间核心商务区单车供给缺口达35%,而居住区则出现20%的过剩堆积。大数据技术的成熟为海量骑行数据的高效处理提供了解决方案,Hadoop、Spark与Hive的组合框架通过分布式存储、内存计算与结构化查询的协同,成为共享单车预测系统的技术基石。本文综述了基于Hadoop+Spark+Hive的共享单车预测系统研究现状,分析技术架构、数据处理方法及可视化实践,探讨未来发展方向。

技术架构演进:从单点到协同

Hadoop:分布式存储与计算基石

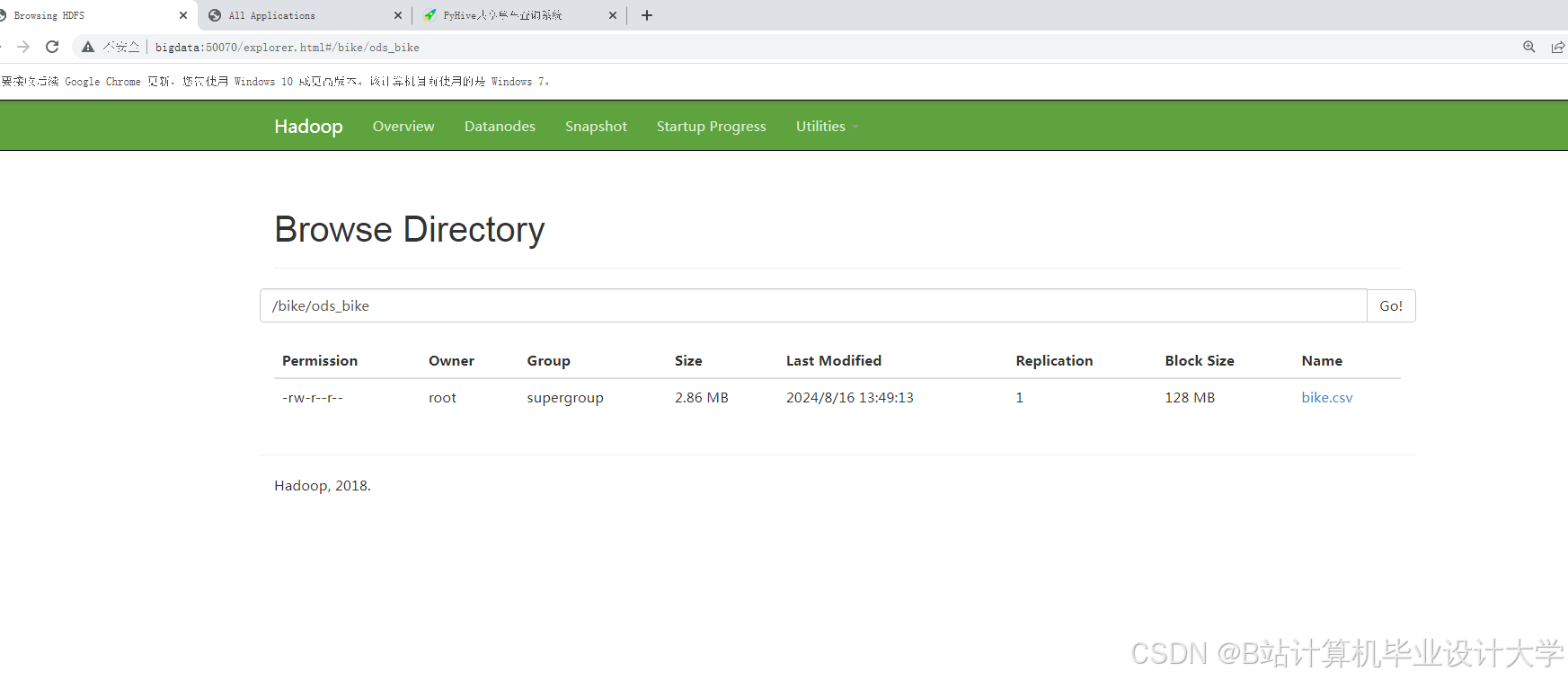

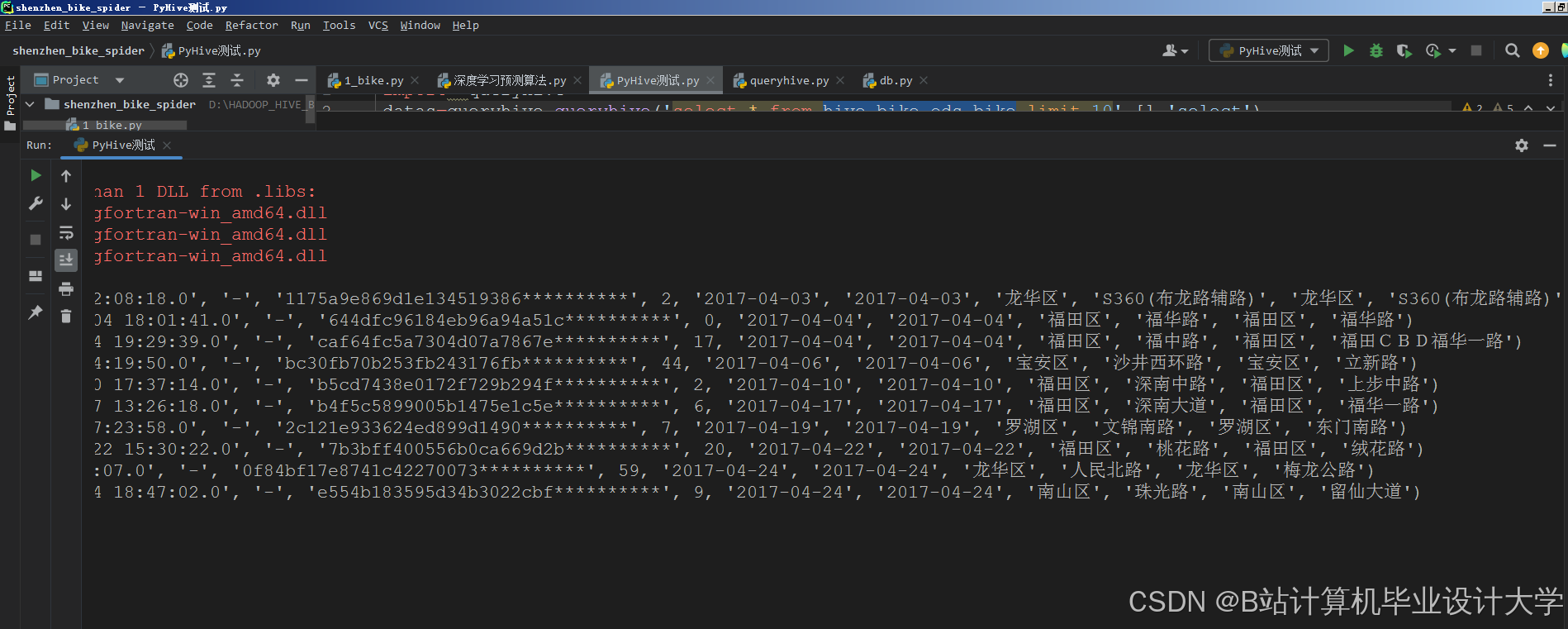

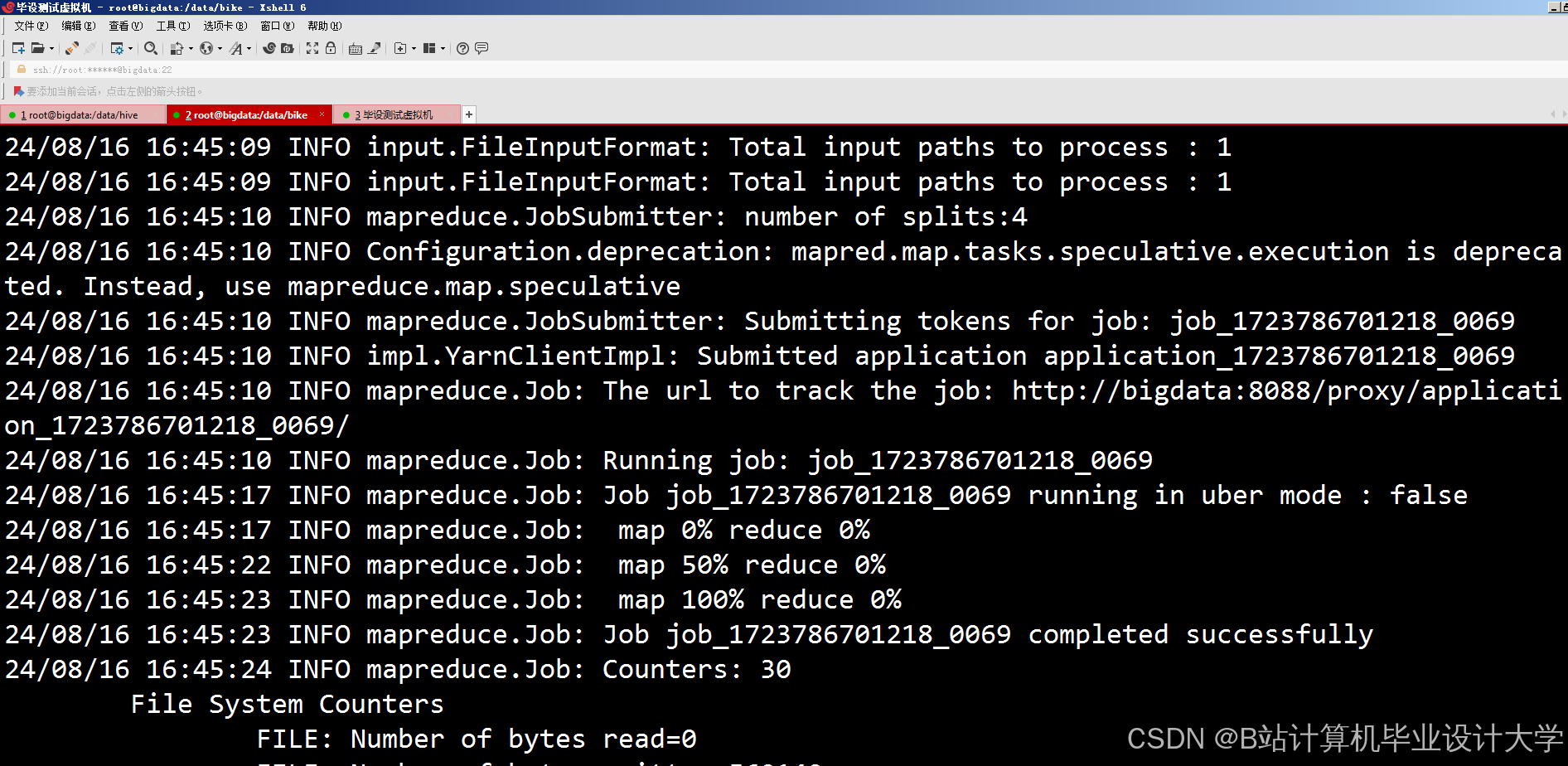

Hadoop通过HDFS(分布式文件系统)与MapReduce模型,解决了共享单车数据的海量存储与批处理问题。纽约共享单车系统采用HDFS存储1.2亿条骑行记录,结合MapReduce实现每小时数据分区统计,单次全量分析耗时从传统数据库的12小时缩短至2小时内。HDFS的高容错性(副本数≥3)确保了数据可靠性,而MapReduce的并行计算能力使大规模数据处理效率显著提升。例如,深圳共享单车企业利用HDFS存储PB级历史订单数据,支持每日新增百万级数据的实时写入与查询。

Spark:内存计算加速迭代效率

Spark的DAG执行引擎与内存计算特性显著提升了迭代算法效率。深圳共享单车预测系统利用Spark MLlib训练LSTM模型,将需求预测耗时从Hadoop的3小时压缩至12分钟。其流处理模块(Spark Streaming)可实时捕获骑行波动,例如在暴雨天气下,系统通过分析每15分钟新增数据,动态调整热点区域车辆投放量,减少用户等待时间30%以上。此外,Spark的动态资源分配机制(如spark.dynamicAllocation.enabled=true)可根据任务负载自动调整Executor数量,优化集群资源利用率。

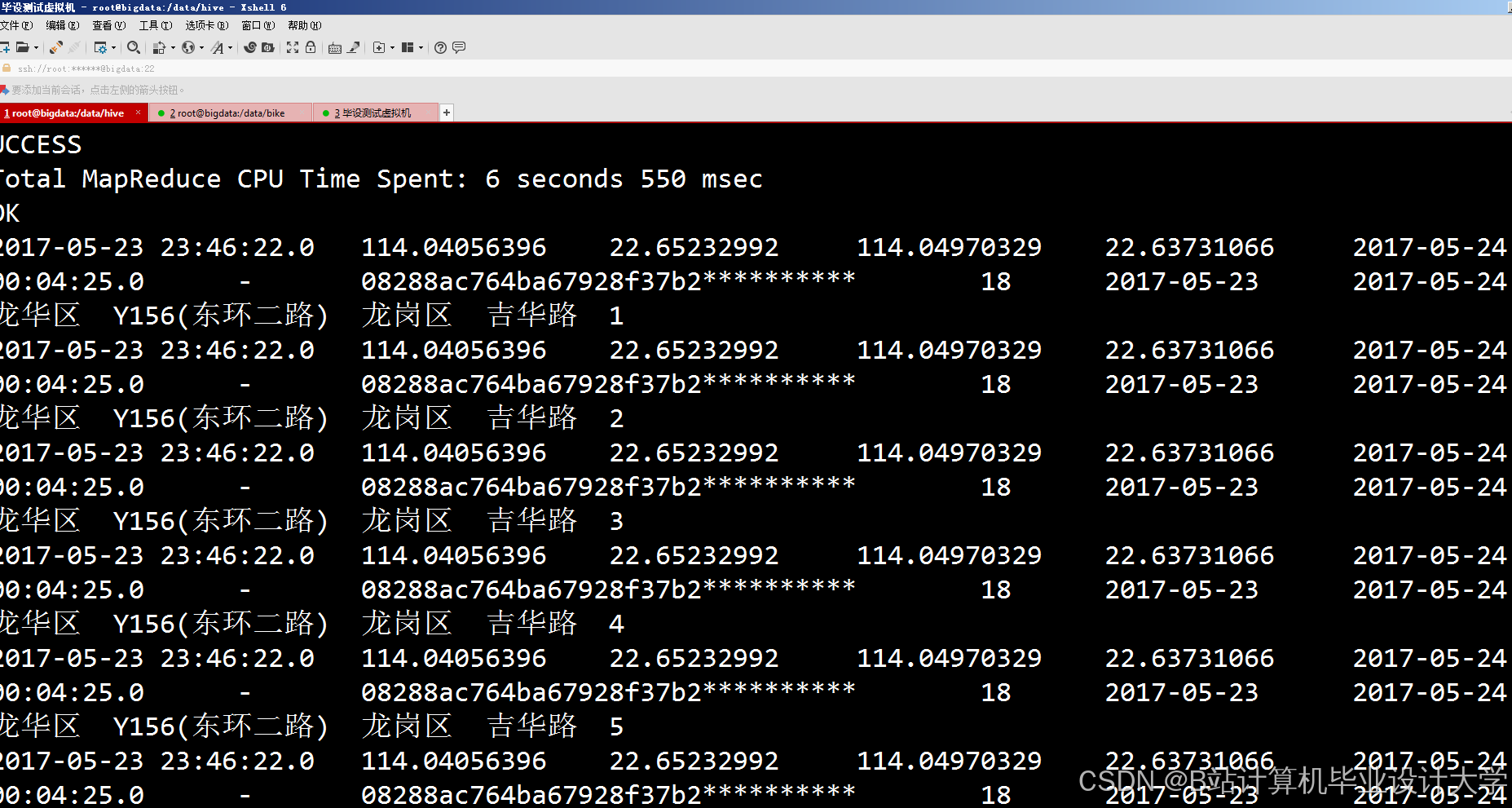

Hive:结构化查询与数据仓库构建

Hive通过HiveQL将HDFS数据映射为结构化表,支持复杂SQL查询。华盛顿共享单车系统利用Hive分区裁剪技术,按日期、区域对数据进行物理隔离,使单次查询扫描数据量减少70%。结合ORC存储格式与Snappy压缩,Hive表查询响应时间从分钟级降至秒级,为实时看板提供数据支撑。例如,美团单车构建Hive数据仓库整合多源数据(如骑行记录、天气、POI),但早期受限于MapReduce引擎的查询效率,单次聚合查询耗时超10分钟;后续通过Spark SQL替代MapReduce,查询性能提升5倍。

数据处理与特征工程:从单一到多维

多源数据融合

现有研究普遍整合骑行记录、天气、POI(兴趣点)等10+维度数据。例如,北京共享单车系统通过高德地图API获取周边3公里内的地铁站、商圈密度,结合气象数据(温度、降水)构建特征矩阵。实验表明,融合多源数据可使预测误差MAE从12次/网格降至8次/网格,提升模型泛化能力。深圳系统进一步整合交通流量数据,通过分析早高峰期间地铁客流与单车需求的相关性,优化车辆调度策略,使热点区域供需匹配度提升18%。

时空特征提取

时空特征是提升预测精度的关键。研究采用GeoHash编码将经纬度转换为1km²网格,提取网格内历史骑行量、潮汐系数(早晚高峰占比)等特征。例如,上海共享单车系统通过动态图构建方法,根据实时骑行流量调整网格间权重,使动态图STGNN模型预测误差较静态图模型降低18%。此外,时间特征(如小时、星期、节假日)与空间特征(如POI密度、网格邻接关系)的交互建模,可捕捉用户出行的周期性规律。例如,深圳系统提取“工作日早高峰-地铁站周边-降雨”场景下的需求特征,使雨天预测误差降低25%。

数据清洗与预处理

原始数据存在3%—5%的异常值(如骑行时长<1分钟或>3小时),常用处理方法包括:

- KNN填充:对缺失的天气数据,基于历史同期均值插补;

- 时间序列平滑:采用移动平均法消除传感器噪声;

- 3σ原则过滤:剔除骑行时长超过均值3倍标准差的异常记录。

例如,深圳系统通过Spark SQL的COALESCE函数填充缺失值,并结合GeoHash编码与潮汐系数计算,构建高质量特征矩阵。

预测模型:从传统到智能

传统时间序列模型

ARIMA、SARIMA等模型被广泛用于单车需求预测,但未考虑天气、节假日等外部因素,误差率普遍高于25%。例如,2022年北京某企业SARIMA模型预测误差达28%,难以支撑动态调度需求。

机器学习模型

随机森林、XGBoost等模型通过特征工程提升预测精度。例如,Yang等提出的时空移动性建模方法,通过集成100棵决策树,在纽约数据集上实现MAE=9.2次/网格。但此类模型对高维时空特征处理效率低,训练耗时随特征量呈指数增长。XGBoost通过并行计算与正则化项优化,在深圳数据集上实现MAE=10.5次/网格,但缺乏对动态特征的实时响应能力。

深度学习模型

LSTM与GRU通过捕捉时间依赖关系,显著提升预测精度。Wang等利用LSTM预测站点级需求,误差不超过2辆车,但缺乏对天气、事件的动态响应。为解决此问题,研究提出混合模型:

- ConvLSTM:结合CNN的空间特征提取与LSTM的时间建模,在深圳数据集上实现RMSE=14.3;

- STGNN-Dynamic:引入动态图结构,根据实时流量调整网格连接权重,使预测延迟<5分钟;

- LSTM-XGBoost混合模型:LSTM捕捉时间特征,XGBoost处理空间异质性,在深圳数据集上实现MAE≤8.5辆/小时,较单一模型提升35%。

模型优化与部署

- 超参数调优:采用Spark的

CrossValidator进行网格搜索,优化学习率(0.01)、树深度(6)等参数; - 分布式训练:Spark将数据分片至多个Executor,并行计算梯度,加速模型收敛(较单机训练提升5倍);

- 实时预测:Spark Streaming按5分钟窗口聚合数据,调用预训练模型生成实时预测结果,支持动态调度指令下发。

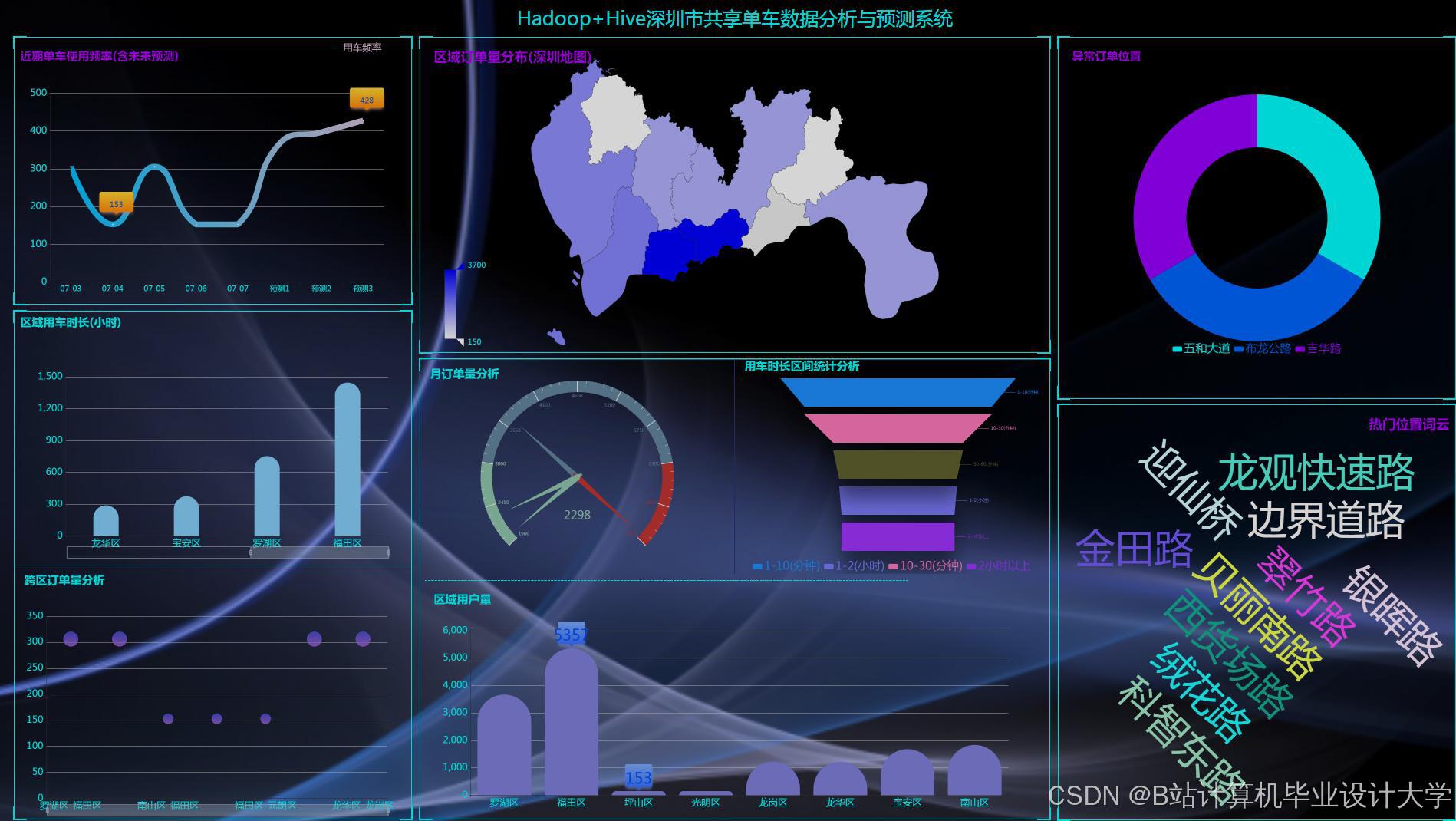

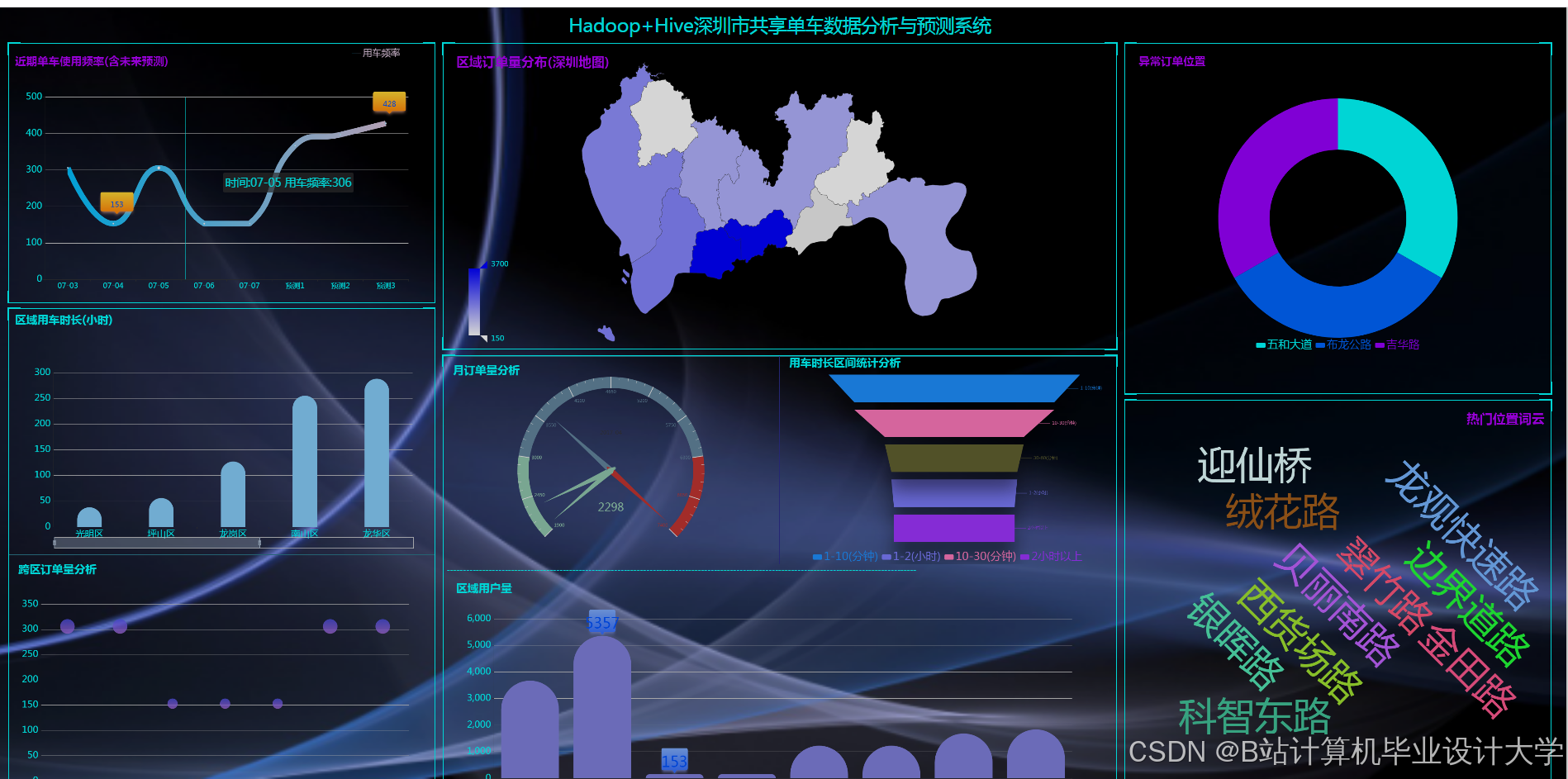

数据可视化:从分析到决策

可视化工具与技术

可视化工具(如ECharts、Tableau)将预测结果转化为直观图表:

- 骑行热力图:用颜色深浅表示区域骑行热度,帮助运营商识别热点(如地铁站周边)与冷门区域(如居民区夜间);

- 时间序列图:展示骑行量随时间的变化趋势,分析高峰时段(如早高峰7:00-9:00)和低谷时段(如深夜23:00-5:00);

- 散点图:分析骑行量与温度、降水等变量的相关性,为运营策略提供依据。

例如,深圳系统通过ECharts渲染热力图,支持按时间、区域、天气条件筛选分析,使调度指令生成效率提升40%。

系统集成与交互优化

完整系统通常包含五层架构:

- 数据采集层:通过API接口获取骑行记录、天气数据,存储至Kafka消息队列;

- 存储层:HDFS存储原始数据,Hive构建数据仓库,支持ETL操作;

- 处理层:Spark进行特征工程与模型训练,利用GPU加速深度学习推理;

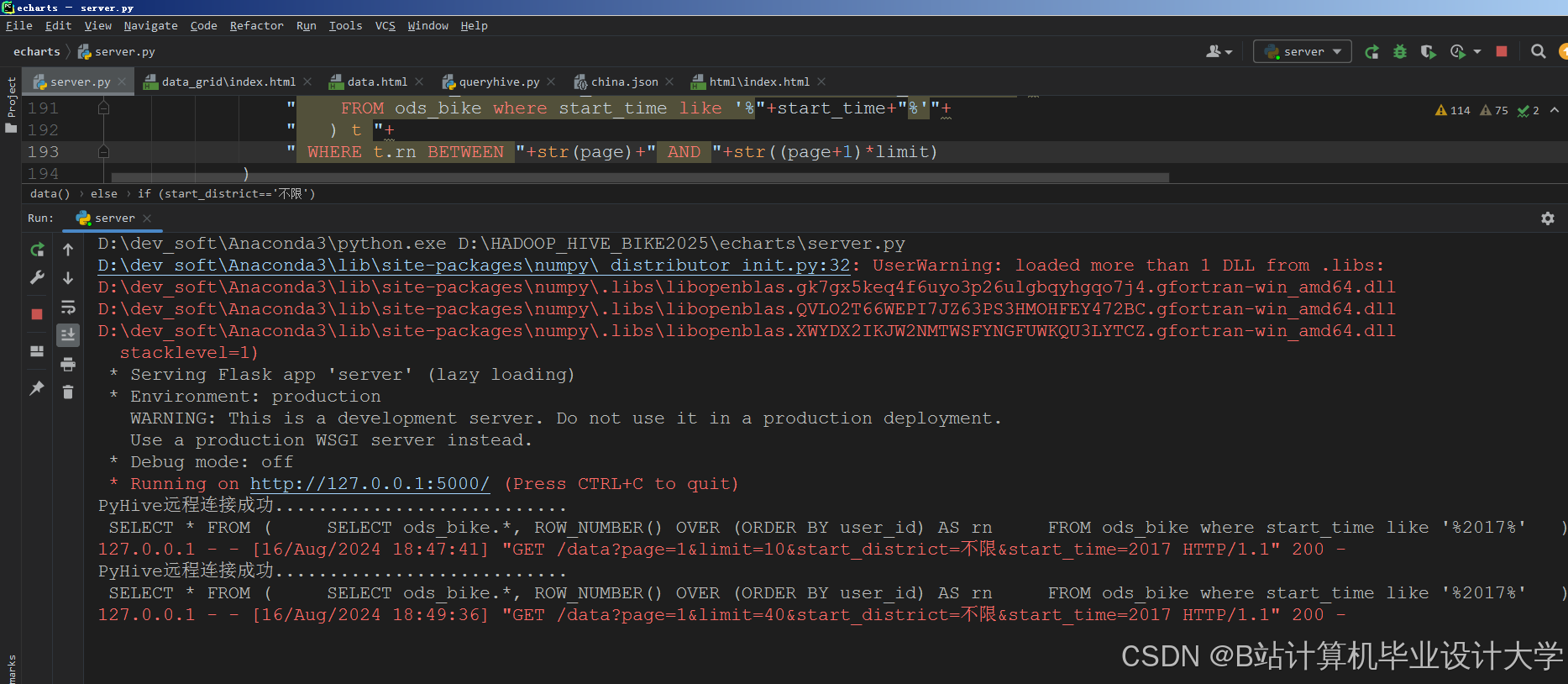

- 展示层:通过Flask+ECharts开发Web看板,支持交互式数据探索;

- 调度层:基于预测结果生成调度指令(如“从区域A调50辆车至区域B”),支持一键下发至运维APP。

例如,北京系统通过地理围栏技术动态展示区域供需平衡状态,使调度成本降低22%。

研究挑战与未来方向

现有挑战

- 实时性不足:部分系统数据采集延迟超15分钟,无法支撑动态调度;

- 多源数据融合不足:仅30%的研究整合了交通流量、事件等外部数据;

- 模型泛化能力弱:跨城市测试中模型性能衰减率达35%,需优化迁移学习方法。

未来方向

- 实时流处理:采用Flink替代Spark Streaming,实现毫秒级数据捕获;

- 隐私保护计算:结合联邦学习,在保护用户隐私前提下实现跨企业数据协作;

- 数字孪生技术:构建城市交通仿真平台,优化单车路径规划;

- 图神经网络(GNN):捕捉骑行轨迹中的空间依赖关系,进一步提升预测精度。

结论

Hadoop+Spark+Hive框架通过分布式存储、内存计算与结构化查询的协同,为共享单车预测系统提供了高效技术支撑。现有研究在多源数据融合、混合模型训练与实时可视化分析方面取得显著进展,但仍需解决实时性、泛化能力与数据隐私等挑战。未来研究应聚焦于实时流处理、联邦学习与数字孪生技术的集成,构建更智能的运营决策平台,推动共享单车行业向精细化、动态化方向发展。

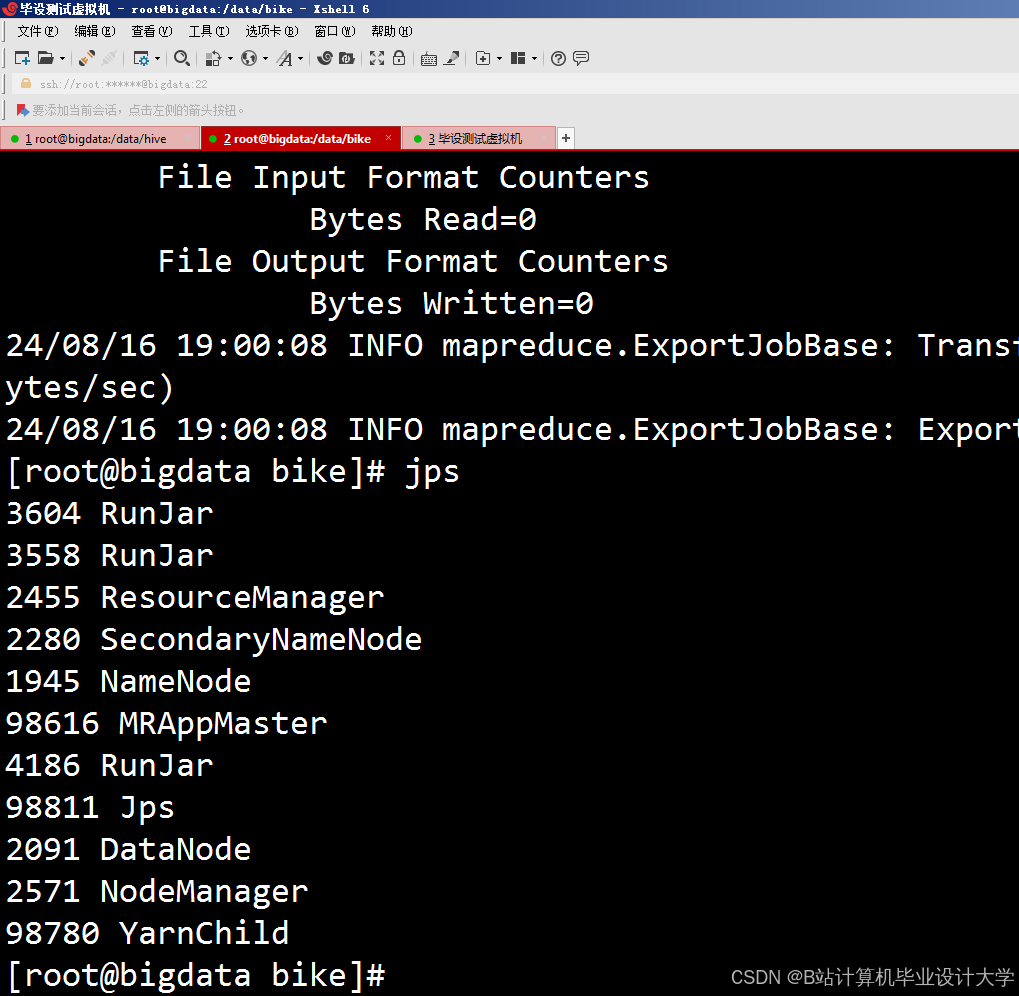

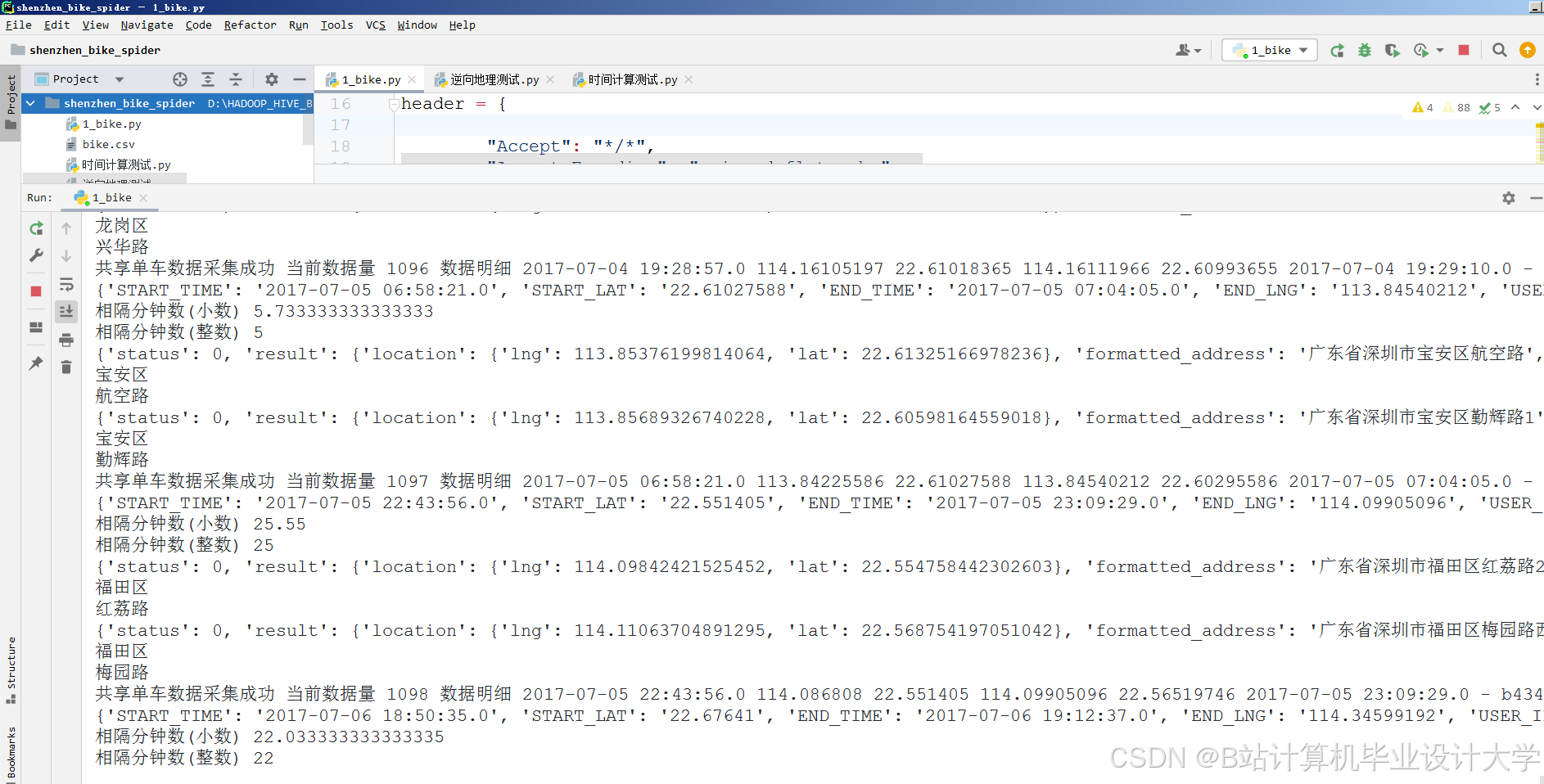

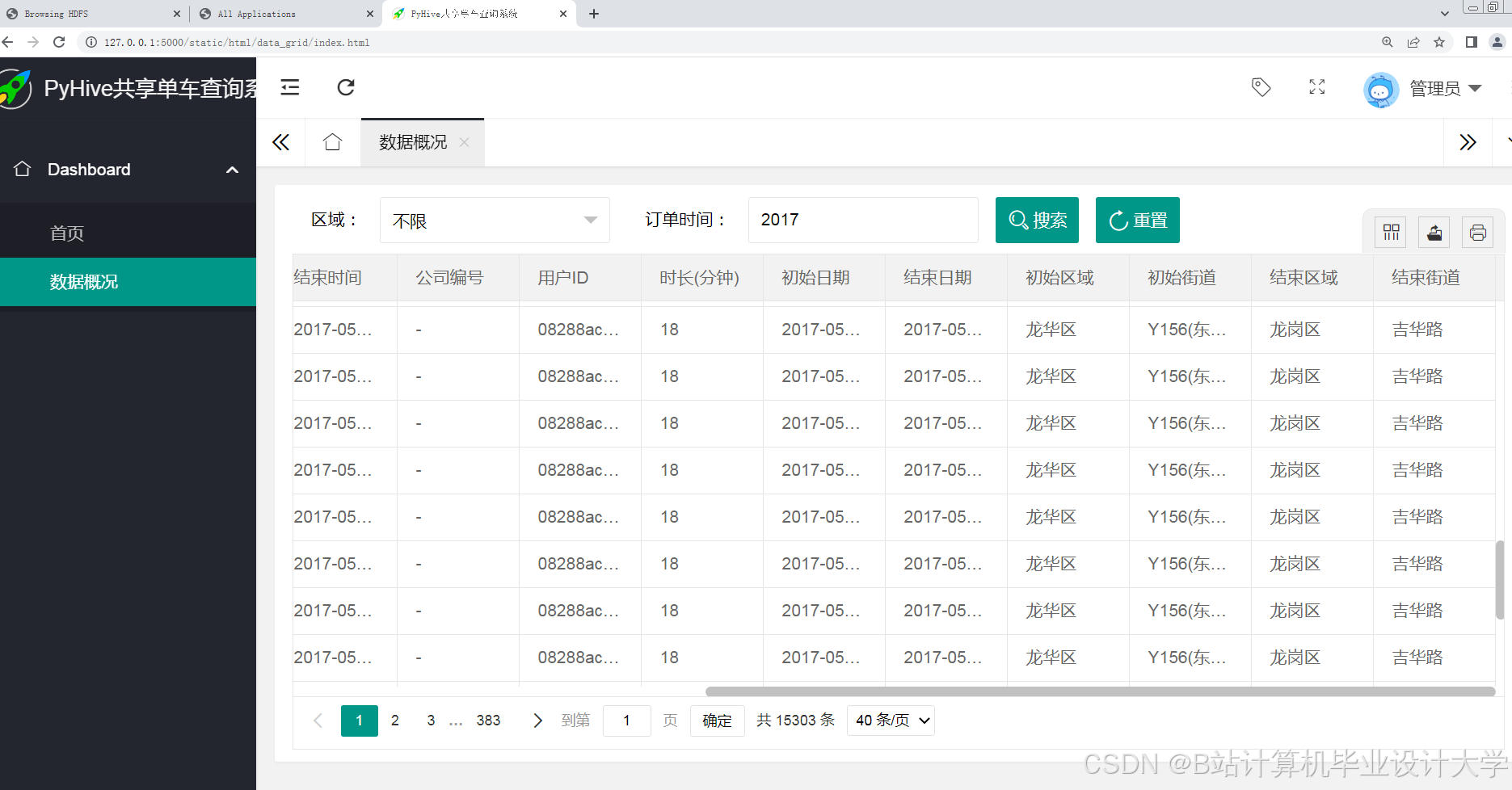

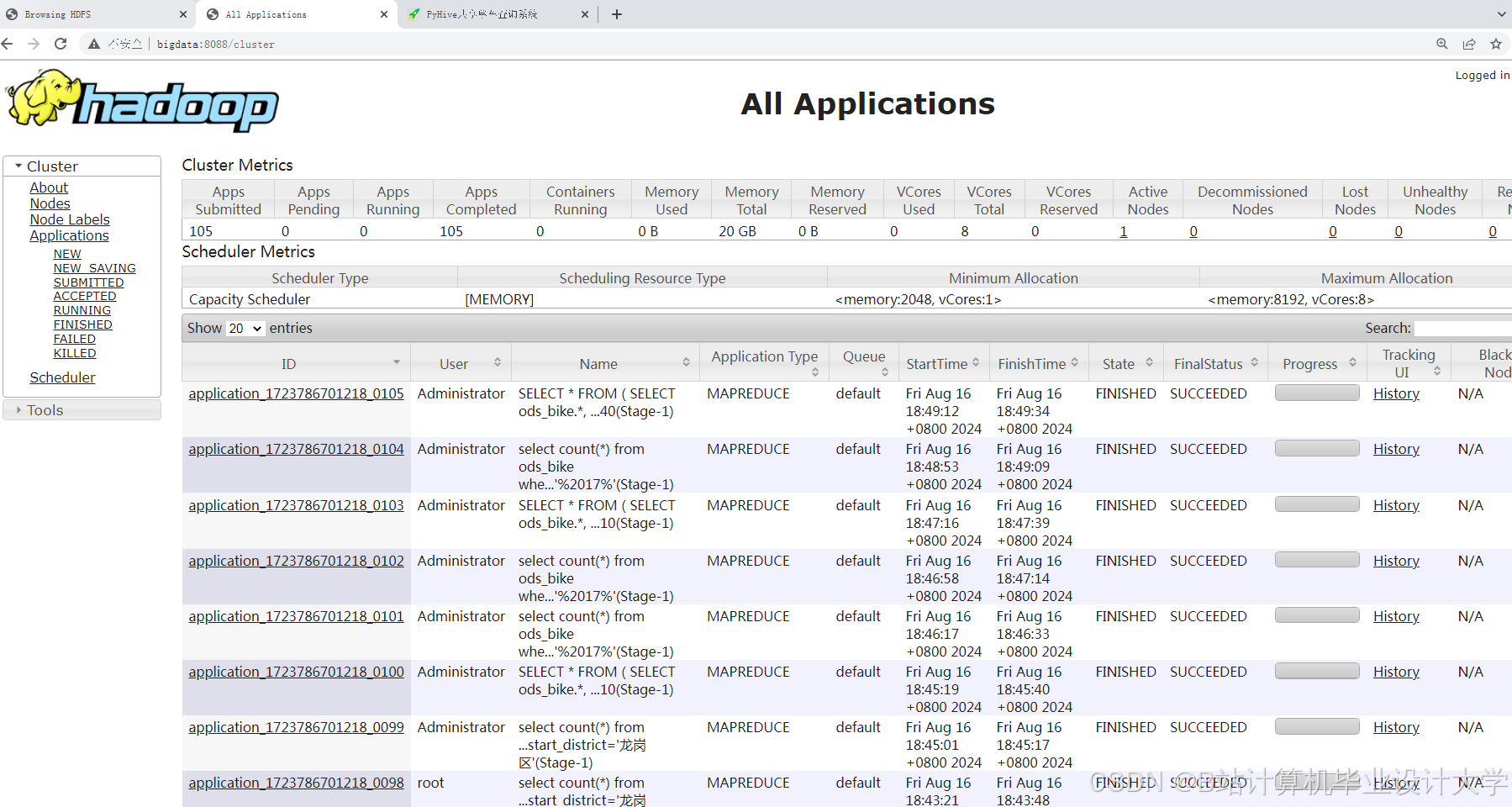

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

基于Hadoop+Spark的共享单车预测系统

基于Hadoop+Spark的共享单车预测系统

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?