温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

以下是一份针对《Hadoop+Spark+Hive物流预测系统》的任务书模板,涵盖数据采集、预测模型构建、系统集成与性能优化等核心模块,结合物流行业场景设计:

任务书:基于Hadoop+Spark+Hive的物流预测系统

一、项目背景与目标

1. 背景

- 物流行业面临海量订单数据、复杂运输网络、动态需求波动等挑战,传统预测方法(如时间序列平滑、线性回归)难以捕捉多维度非线性关系。

- 需结合大数据处理框架(Hadoop+Spark)与分布式计算能力,构建高精度物流预测系统,支撑资源调度、路径优化、库存管理等核心业务。

2. 目标

- 构建Hadoop+Hive数据仓库,整合订单、运输、天气、节假日等多源数据。

- 基于Spark MLlib开发多模型融合预测引擎(时间序列+机器学习+深度学习),实现以下预测任务:

- 区域订单量预测(未来24小时/7天分时段、分区域)。

- 运输时效预测(包裹从分拣中心到目的地的预计耗时)。

- 异常事件预警(如天气导致的延误、分拣中心拥堵)。

- 系统支持每15分钟更新一次预测结果,预测误差率(MAPE)≤10%,支撑动态资源调度决策。

二、项目任务与分工

1. 多源数据采集与存储(Hadoop+Hive)

- 任务内容

- 数据源接入:

- 订单数据:订单ID、用户ID、商品类型、重量、体积、收货地址(经纬度)、下单时间、支付状态。

- 运输数据:包裹状态(揽收、分拣、运输、派送)、车辆ID、司机ID、GPS轨迹、分拣中心ID、中转站ID。

- 外部数据:

- 天气API(降雨量、风速、温度,影响运输效率)。

- 节假日日历(如“双11”导致订单激增)。

- 交通路况数据(通过高德/百度地图API获取实时拥堵指数)。

- 数据清洗与存储:

- 处理异常数据(如订单重量为负、GPS坐标超出合理范围)。

- 分层存储至Hive:

- ODS层:原始数据(保留1年历史订单和运输记录)。

- DWD层:清洗后数据,按主题分区(订单、运输、外部数据)。

- DWS层:聚合指标(如“区域A_每小时订单量”“分拣中心B_日处理包裹数”)。

- ADS层:模型输入特征表(如“区域A_过去7天每小时订单量_天气类型_节假日标志”)。

- 数据源接入:

- 技术工具

- 数据采集:Flume(日志文件)、Kafka(实时运输状态流)、Sqoop(批量导入Hive)。

- 存储格式:Hive表(Parquet压缩)、HBase(实时订单状态缓存)。

2. 特征工程与预测模型开发(Spark MLlib)

- 任务内容

- 特征设计:

- 订单量预测特征:

- 时间特征:小时、星期几、是否为节假日、是否为促销日(如“618”)。

- 空间特征:区域ID、区域人口密度、周边分拣中心容量。

- 历史特征:过去7天/30天同小时订单量、同比变化率。

- 外部特征:天气类型(雨/雪导致派送延迟)、交通拥堵指数。

- 运输时效预测特征:

- 包裹特征:重量、体积、目的地距离。

- 运输特征:车辆类型(货车/电动车)、司机历史时效评分、分拣中心处理效率。

- 动态特征:当前路段拥堵情况、天气状况。

- 订单量预测特征:

- 模型构建:

- 区域订单量预测:

- 基线模型:Prophet(时间序列分解)。

- 增强模型:XGBoost(融合时间+空间+外部特征)。

- 深度学习模型:LSTM(捕捉长期依赖,如周/月周期性)。

- 融合策略:加权平均(XGBoost权重=0.6,LSTM权重=0.4)。

- 运输时效预测:

- 回归模型:Gradient Boosting Trees(GBRT),输出预计耗时(分钟)。

- 分类模型:随机森林(预测是否延误,阈值=标准时效×1.2)。

- Spark实现示例:

scalaimport org.apache.spark.ml.feature.{VectorAssembler, StringIndexer}import org.apache.spark.ml.regression.{LinearRegression, RandomForestRegressor}import org.apache.spark.ml.Pipeline// 1. 特征组装val assembler = new VectorAssembler().setInputCols(Array("hour", "region_id", "weather_type", "historical_orders")).setOutputCol("features")// 2. 定义随机森林模型val rf = new RandomForestRegressor().setLabelCol("delivery_time").setFeaturesCol("features").setNumTrees(100)// 3. 构建Pipelineval pipeline = new Pipeline().setStages(Array(assembler, rf))// 4. 训练模型val model = pipeline.fit(trainingData)val predictions = model.transform(testData)

- 区域订单量预测:

- 模型评估:

- 指标:MAPE(平均绝对百分比误差)、RMSE(均方根误差)、F1-Score(延误分类任务)。

- 对比基线:传统ARIMA模型、单一XGBoost模型。

- 特征设计:

- 输出成果

- 特征工程代码库(Spark SQL/Pandas UDF)。

- 预测模型权重文件(Spark MLlib格式)、模型评估报告。

3. 物流预测系统开发

- 任务内容

- 系统架构设计:

- 离线预测:每日凌晨运行Spark Batch作业,生成未来7天区域订单量预测结果,存储至Hive ADS层。

- 实时预测:通过Spark Structured Streaming监听Kafka订单流,每15分钟触发一次短时预测(未来24小时)。

- 异常预警:基于规则引擎(如“运输时效>标准时效×1.5”触发告警)结合模型输出。

- 关键流程示例(实时订单量预测):

scala// 1. 读取实时订单数据(Kafka)val ordersStream = spark.readStream.format("kafka").option("subscribe", "new_orders_topic").load()// 2. 关联历史特征(从Hive ADS层)val historicalFeatures = spark.table("region_hourly_features_ads")val joinedStream = ordersStream.join(broadcast(historicalFeatures), "region_id")// 3. 调用预训练模型预测val predictions = joinedStream.mapPartitions { partition =>val model = loadModel("/models/xgboost_order_prediction.bin")partition.map(row => {val features = extractFeatures(row) // 提取时间+空间+外部特征val predictedOrders = model.predict(features)(row.region_id, row.timestamp, predictedOrders)})}// 4. 写入MySQL供可视化展示predictions.writeStream.format("jdbc").option("url", "jdbc:mysql://db-host:3306/logistics_db").option("dbtable", "realtime_order_predictions").start() - 可视化看板:

- 使用Grafana展示区域订单热力图、运输时效分布、异常事件列表。

- 系统架构设计:

- 输出成果

- 系统代码库(Scala/Python)、部署文档。

- AB测试方案(对比人工调度与模型驱动调度的成本差异)。

4. 系统集成与性能优化

- 任务内容

- 部署Hadoop集群(5节点)、Spark Standalone集群(3主2从)、Hive Metastore。

- 优化Spark作业性能:

- 调整

spark.executor.memory(8-16GB)、spark.sql.shuffle.partitions(200-500)。 - 对高频查询特征(如区域ID)使用Bloom Filter加速JOIN。

- 调整

- 监控系统:

- Prometheus+Grafana监控Spark任务延迟、Hive查询响应时间。

- 设置预警阈值(如单次预测耗时>2秒触发告警)。

- 输出成果

- 集群部署文档、性能优化报告(含资源占用率对比)。

三、技术栈与开发环境

| 模块 | 技术选型 |

|---|---|

| 大数据框架 | Hadoop 3.3.4, Spark 3.3.2 (Scala 2.12), Hive 3.1.3 |

| 机器学习 | Spark MLlib 3.3.2, XGBoost4J-Spark |

| 数据流处理 | Kafka 3.4.0, Spark Structured Streaming |

| 可视化 | Grafana 9.0, MySQL 8.0 (存储预测结果) |

| 开发环境 | Linux (CentOS 7), IntelliJ IDEA, JupyterLab |

四、项目里程碑计划

| 阶段 | 时间 | 交付物 |

|---|---|---|

| 数据调研与ETL开发 | 第1-2周 | Hive表结构、数据清洗脚本 |

| 特征工程与模型训练 | 第3-4周 | 特征重要性分析报告、模型权重文件 |

| 系统开发与测试 | 第5-6周 | 实时预测Demo、AB测试方案 |

| 系统集成与调优 | 第7周 | 集群部署脚本、性能监控看板 |

| 项目验收 | 第8周 | 用户操作手册、模型迭代计划 |

五、预期成果

- 模型性能:

- 区域订单量预测MAPE≤8%,运输时效预测RMSE≤15分钟。

- 系统性能:

- 实时预测延迟<1秒,支持每秒5000次请求。

- 业务价值:

- 降低分拣中心闲置率20%,减少运输车辆空驶里程15%。

六、风险评估与应对

| 风险类型 | 应对措施 |

|---|---|

| 数据延迟 | 设置Kafka消息缓存(TTL=1小时),重试机制 |

| 模型过拟合 | 采用交叉验证(K=5)、正则化(L2 penalty) |

| 冷启动问题 | 对新区域采用基于相似区域的迁移学习 |

| 集群资源不足 | 动态扩容Spark Worker节点,使用YARN资源调度 |

项目负责人:__________

日期:__________

此任务书可根据实际物流数据规模调整集群规模(如增加Spark Worker节点),并建议优先在单个城市(如上海)验证模型效果,再扩展至全国范围。

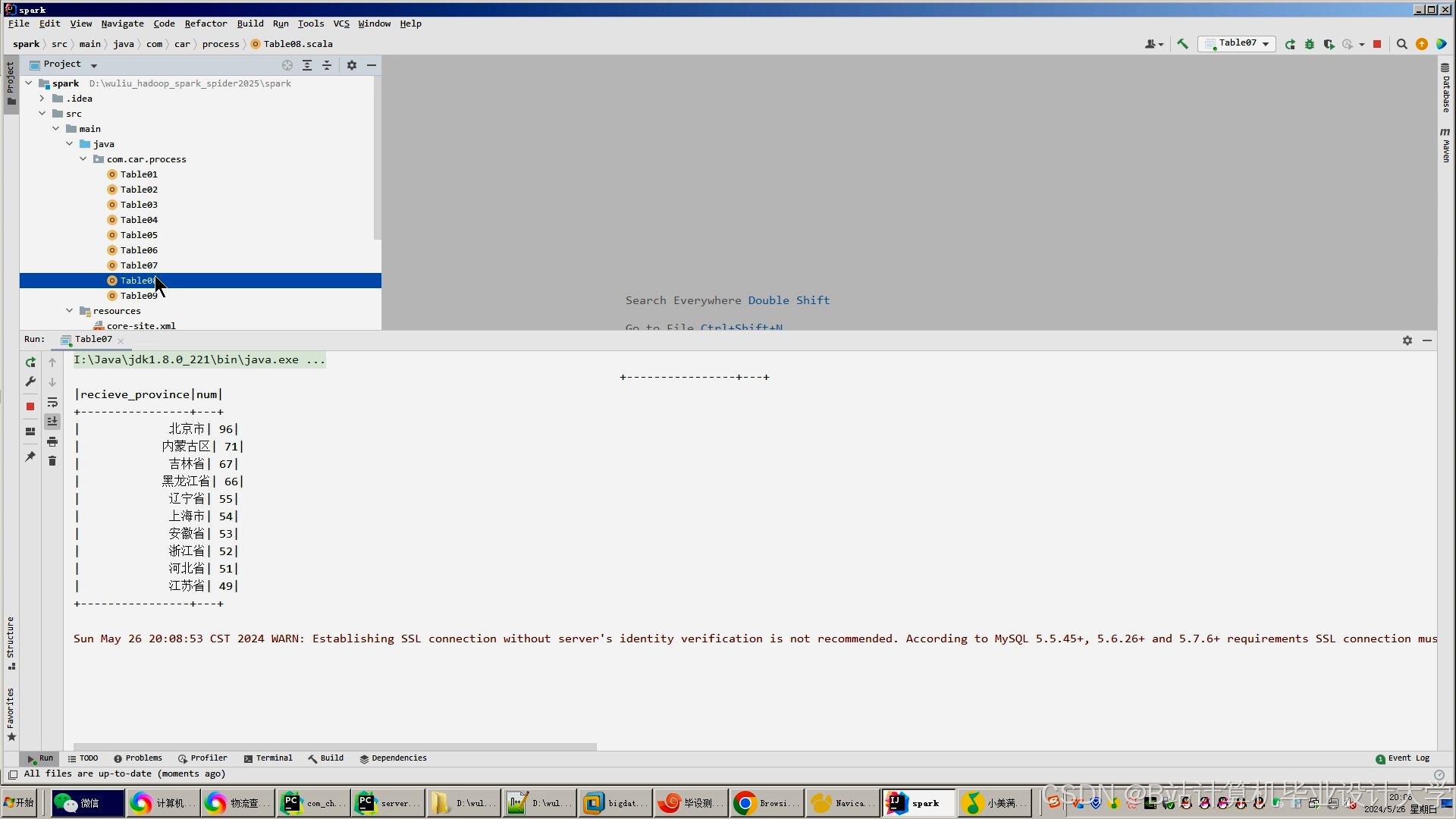

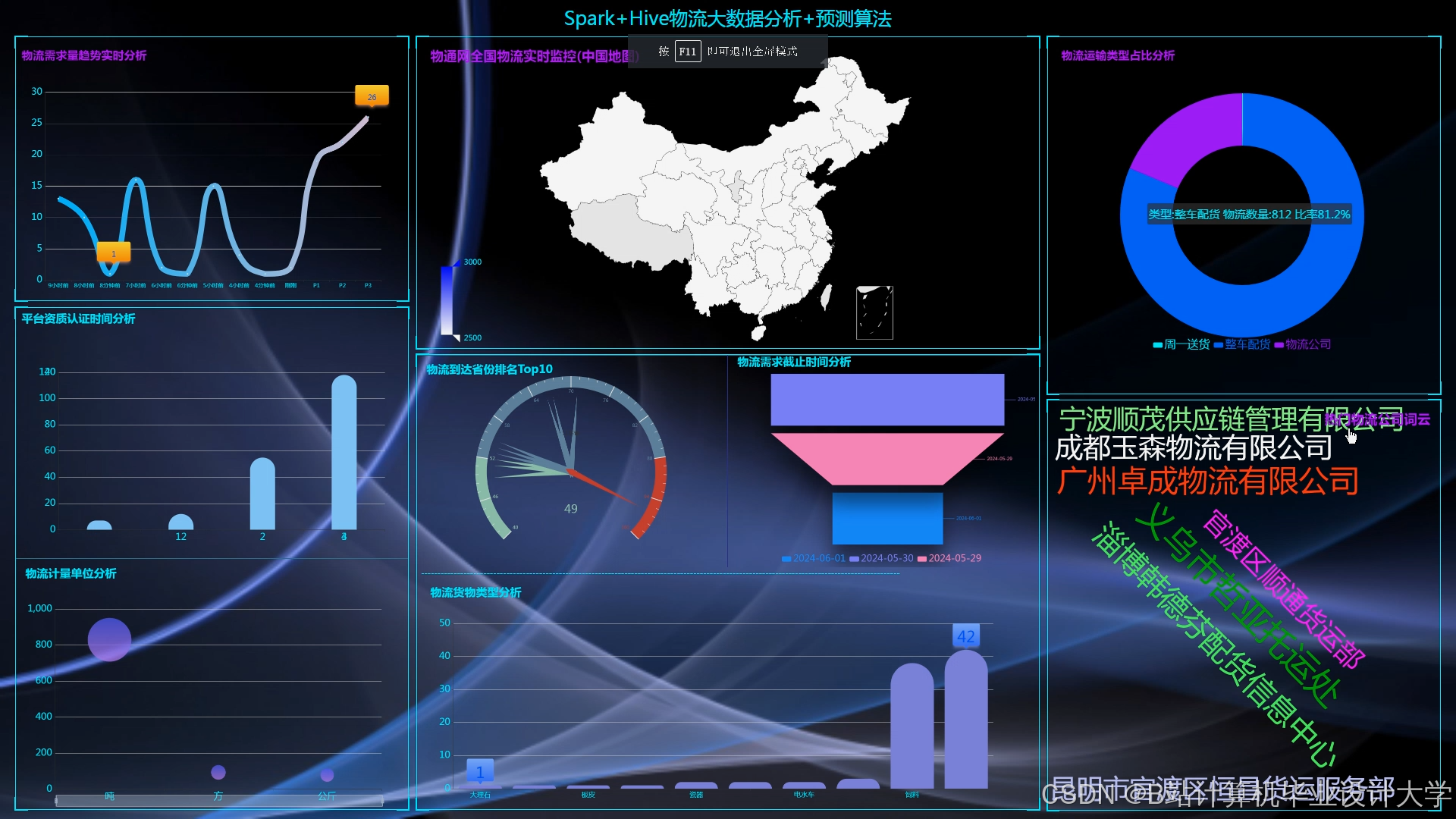

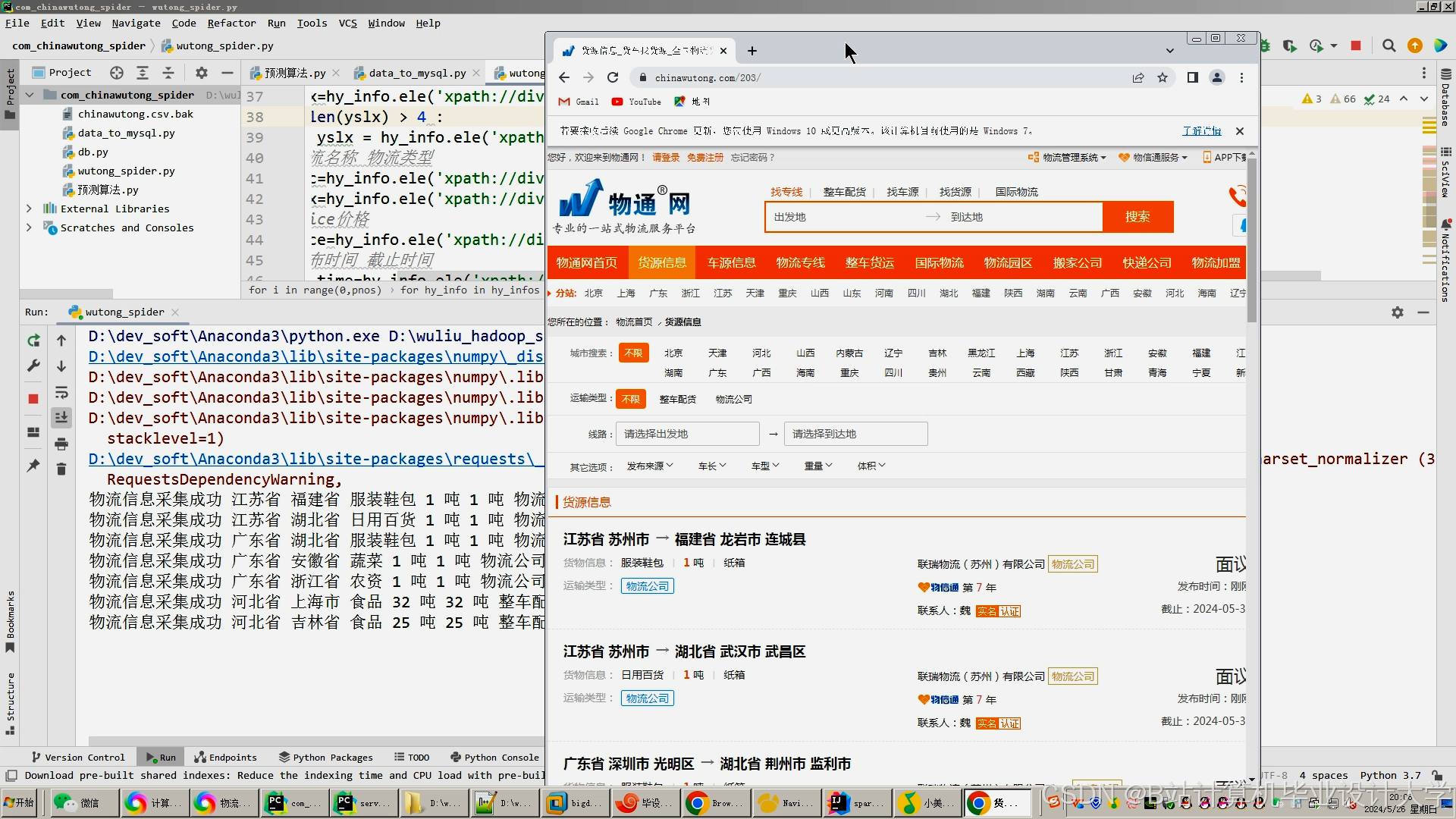

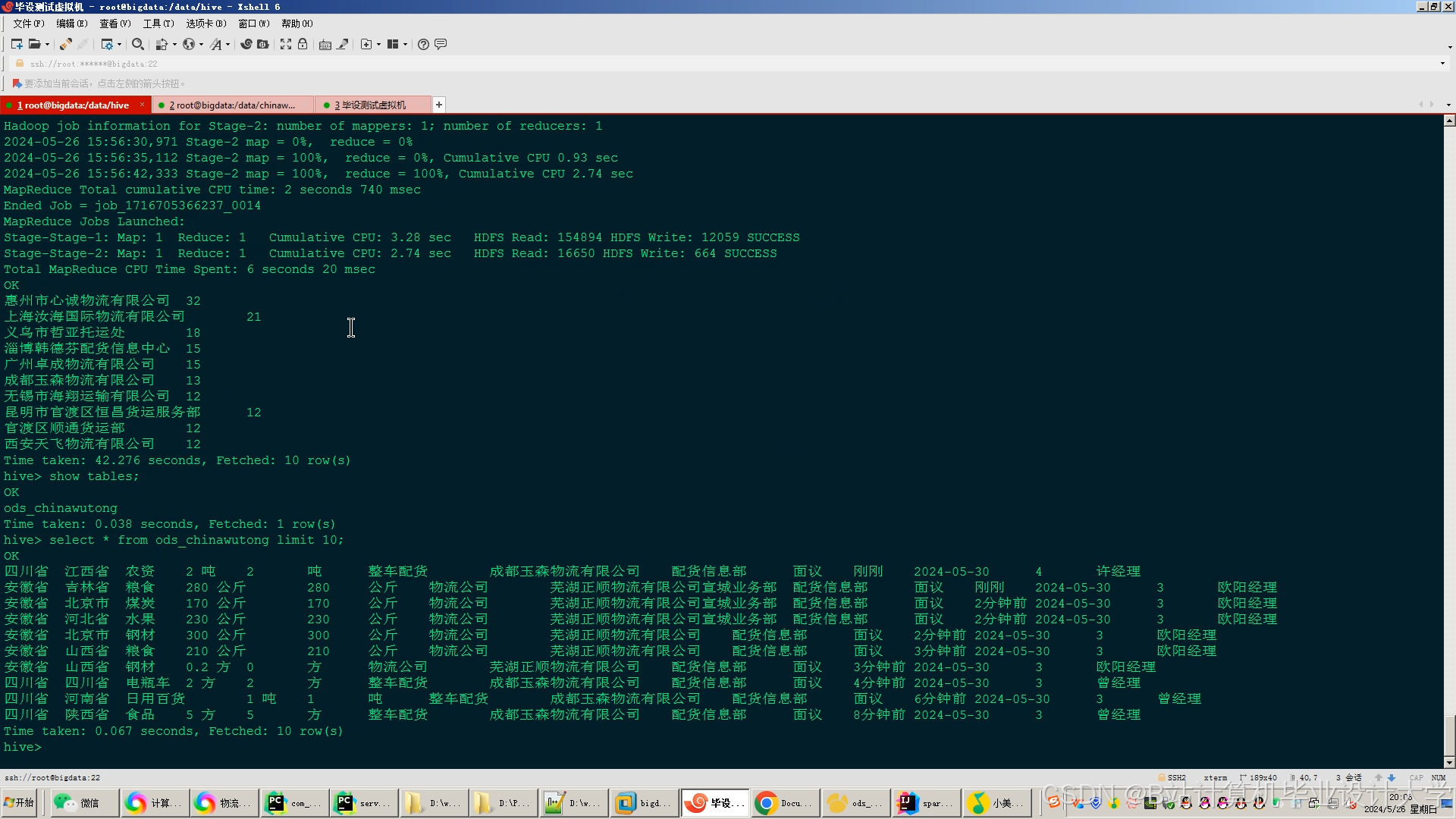

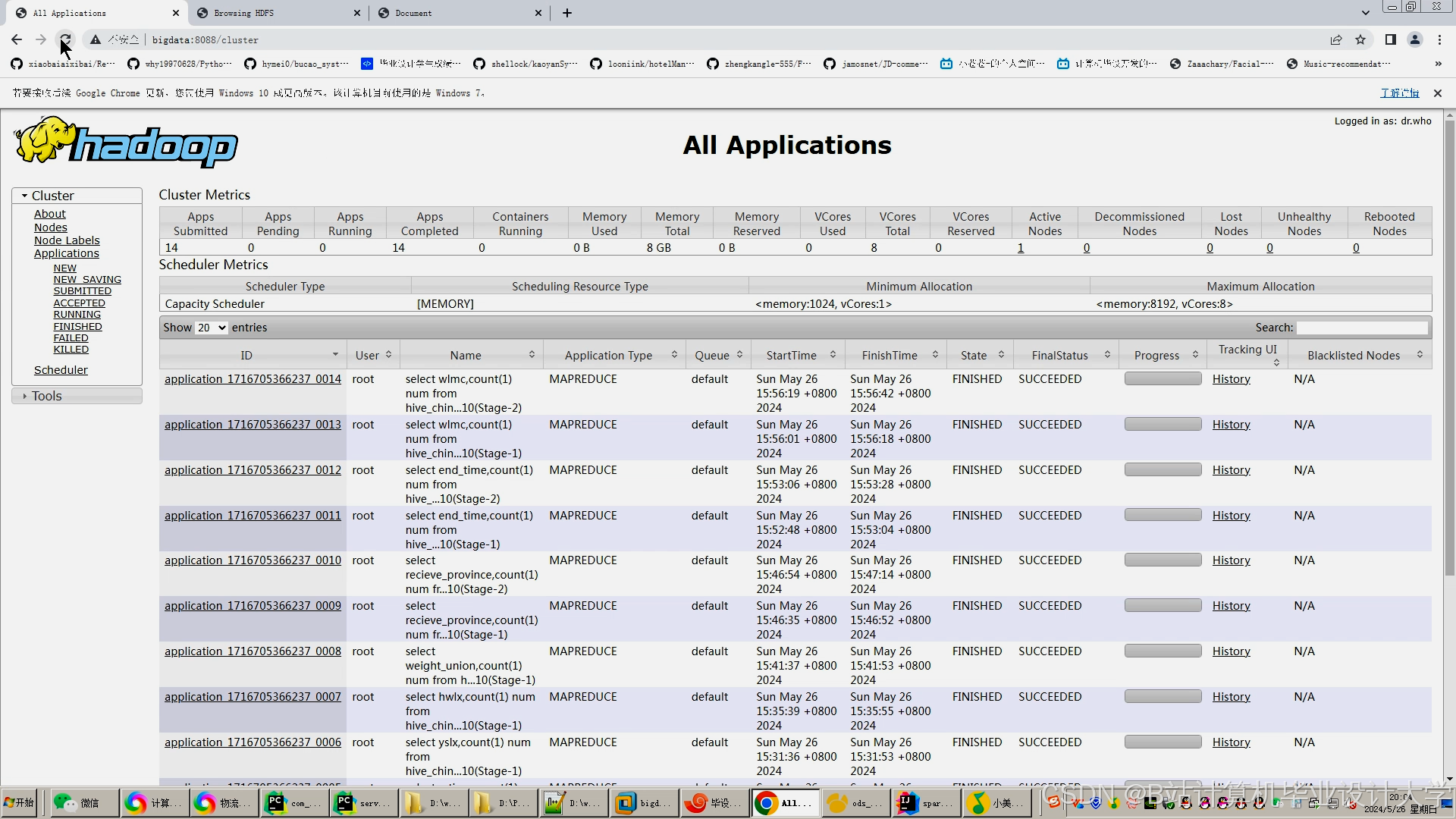

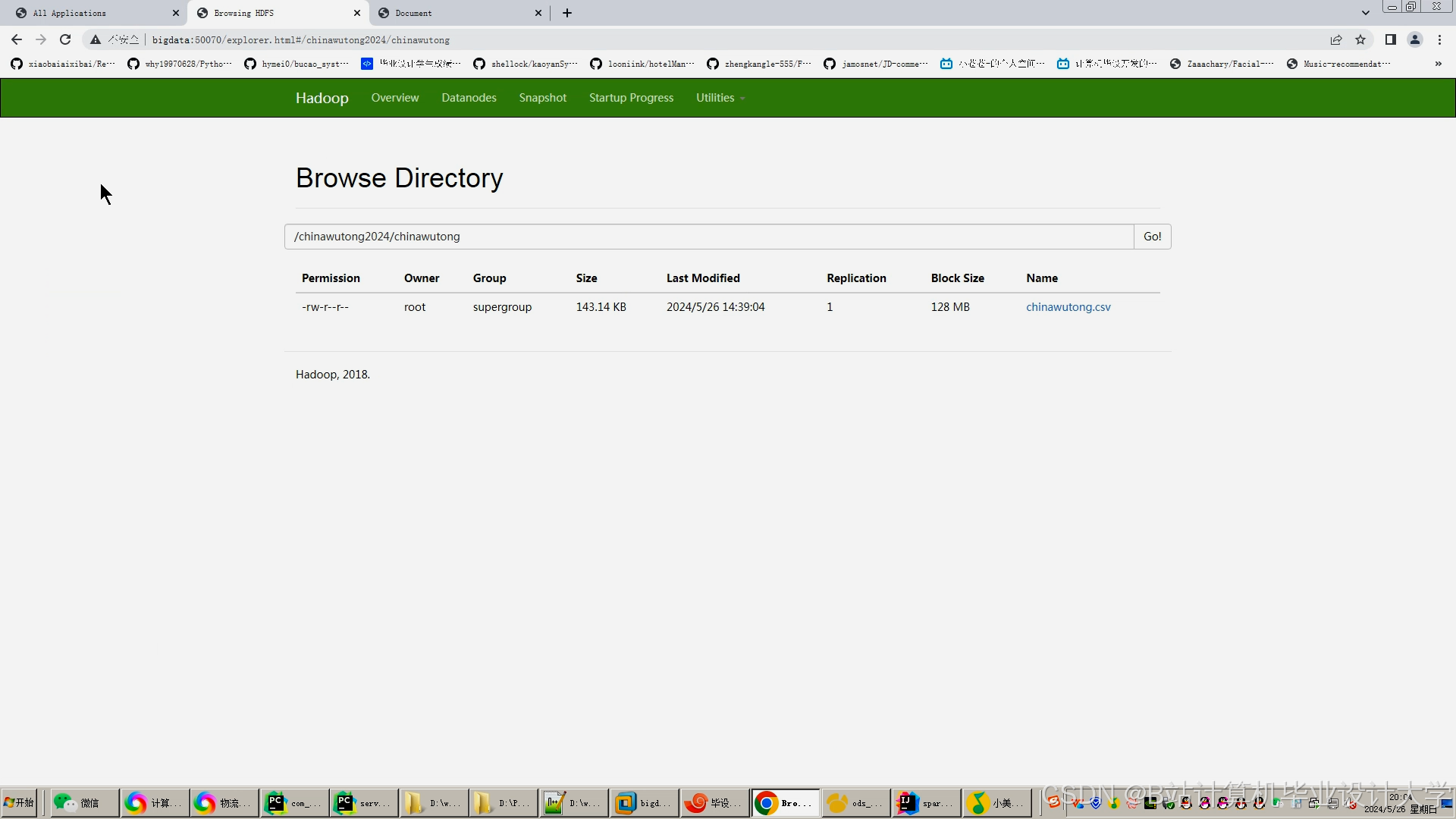

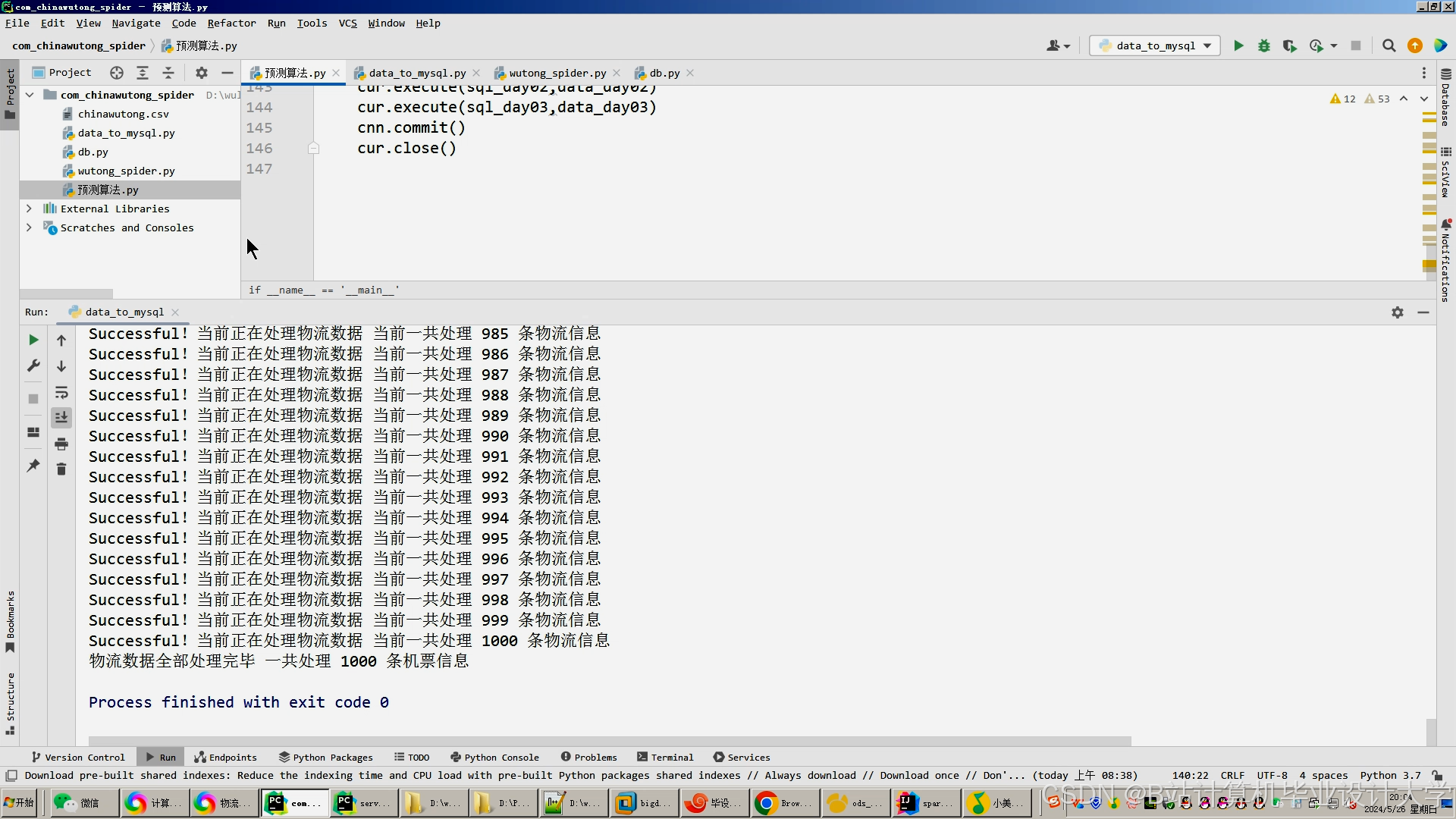

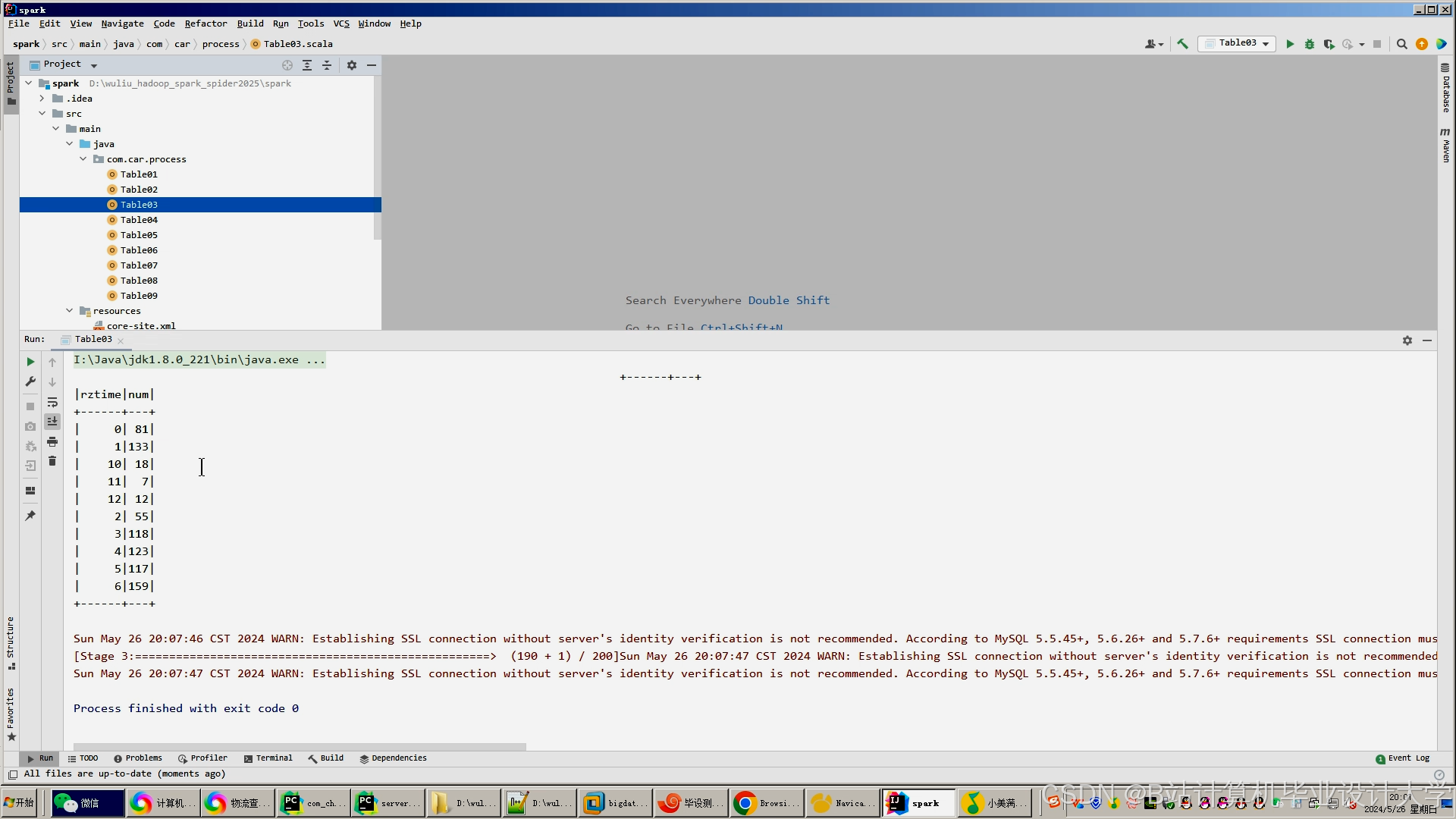

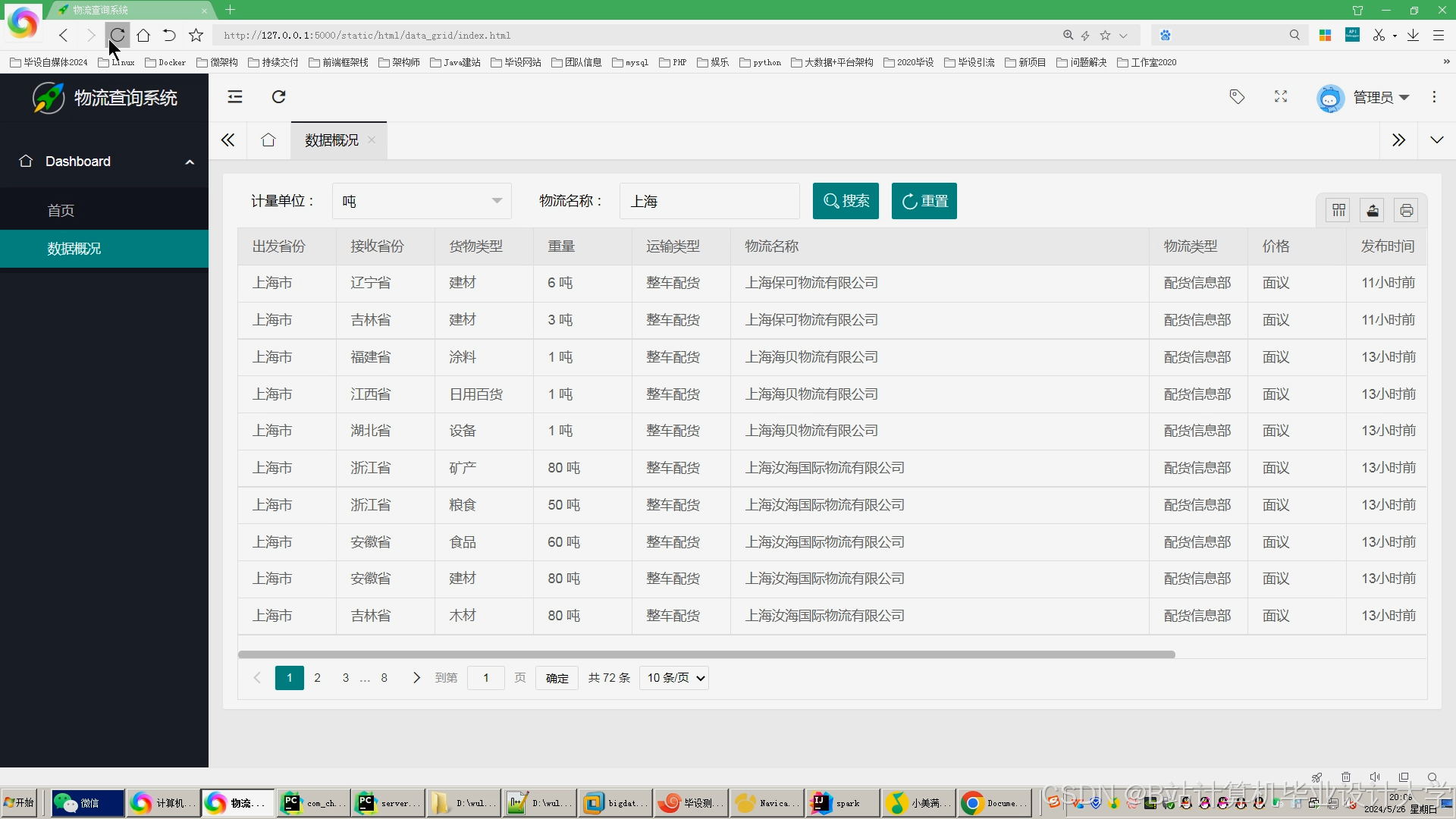

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

基于Hadoop+Spark的物流预测系统

基于Hadoop+Spark的物流预测系统

911

911

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?