温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

任务书:Python深度学习空气质量预测分析、可视化与数据爬虫开发

一、项目背景与目标

随着工业化和城市化进程加速,空气质量问题已成为全球关注的焦点。实时监测与预测空气质量(PM2.5、PM10、NO₂、SO₂等指标)对公众健康、政策制定及环境治理具有重要意义。本项目旨在通过Python技术栈实现以下目标:

- 数据获取:开发网络爬虫,从公开数据源(如环保部门网站、气象平台)抓取历史及实时空气质量数据;

- 深度学习预测:构建LSTM、Transformer等深度学习模型,预测未来空气质量变化趋势;

- 数据可视化:利用Matplotlib、Plotly、ECharts等工具生成交互式可视化图表,直观展示空气质量时空分布及预测结果;

- 系统集成:开发一个完整的Python应用程序,集成爬虫、预测与可视化功能,支持用户交互与结果导出。

二、任务分解与技术路线

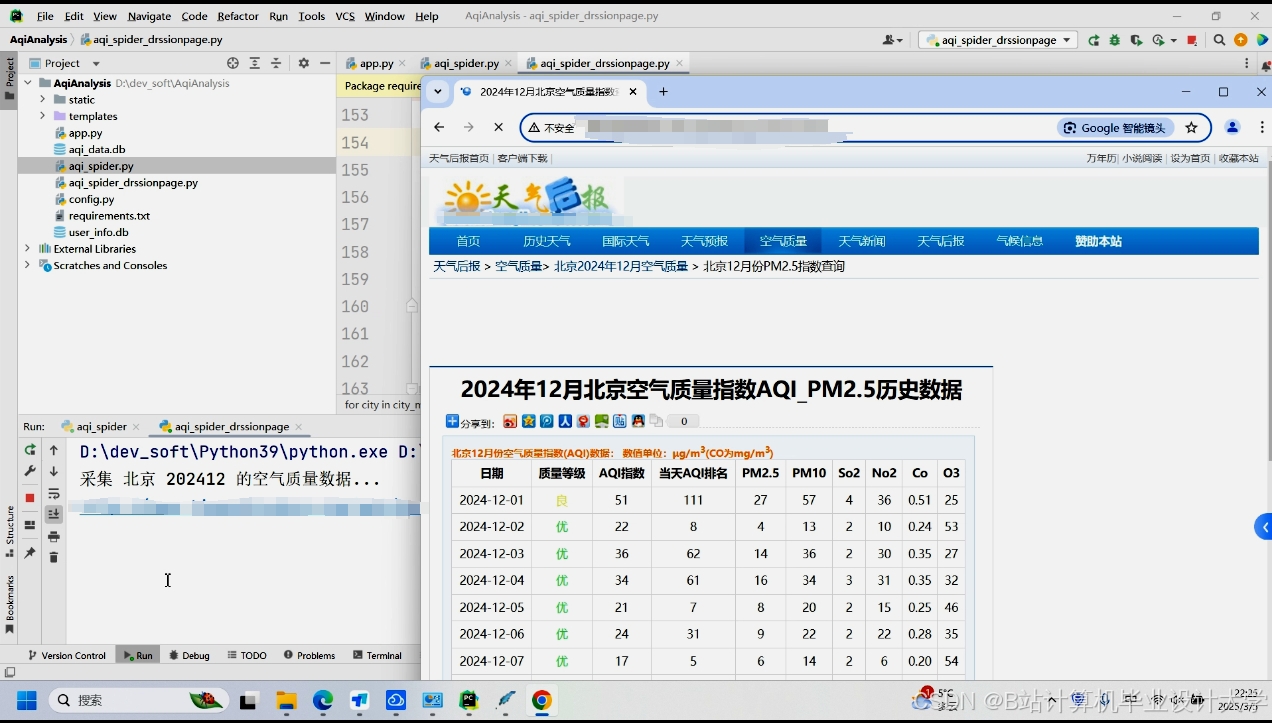

任务1:空气质量数据爬虫开发

目标:从指定数据源(如中国环境监测总站、AQICN、OpenWeatherMap等)爬取多城市、多指标的空气质量历史数据与实时数据。

技术实现:

- 数据源分析:

- 确定目标网站(如AQICN、中国空气质量在线监测平台)的API接口或网页结构;

- 分析数据字段(时间、城市、PM2.5、PM10、O₃、NO₂、SO₂、CO、温度、湿度、风速等)。

- 爬虫开发:

- 使用

Requests或Selenium库模拟HTTP请求,获取JSON/HTML格式数据; - 解析数据:

BeautifulSoup(HTML解析)或json模块(JSON解析); - 反爬策略:设置请求头(User-Agent)、代理IP池、延迟访问;

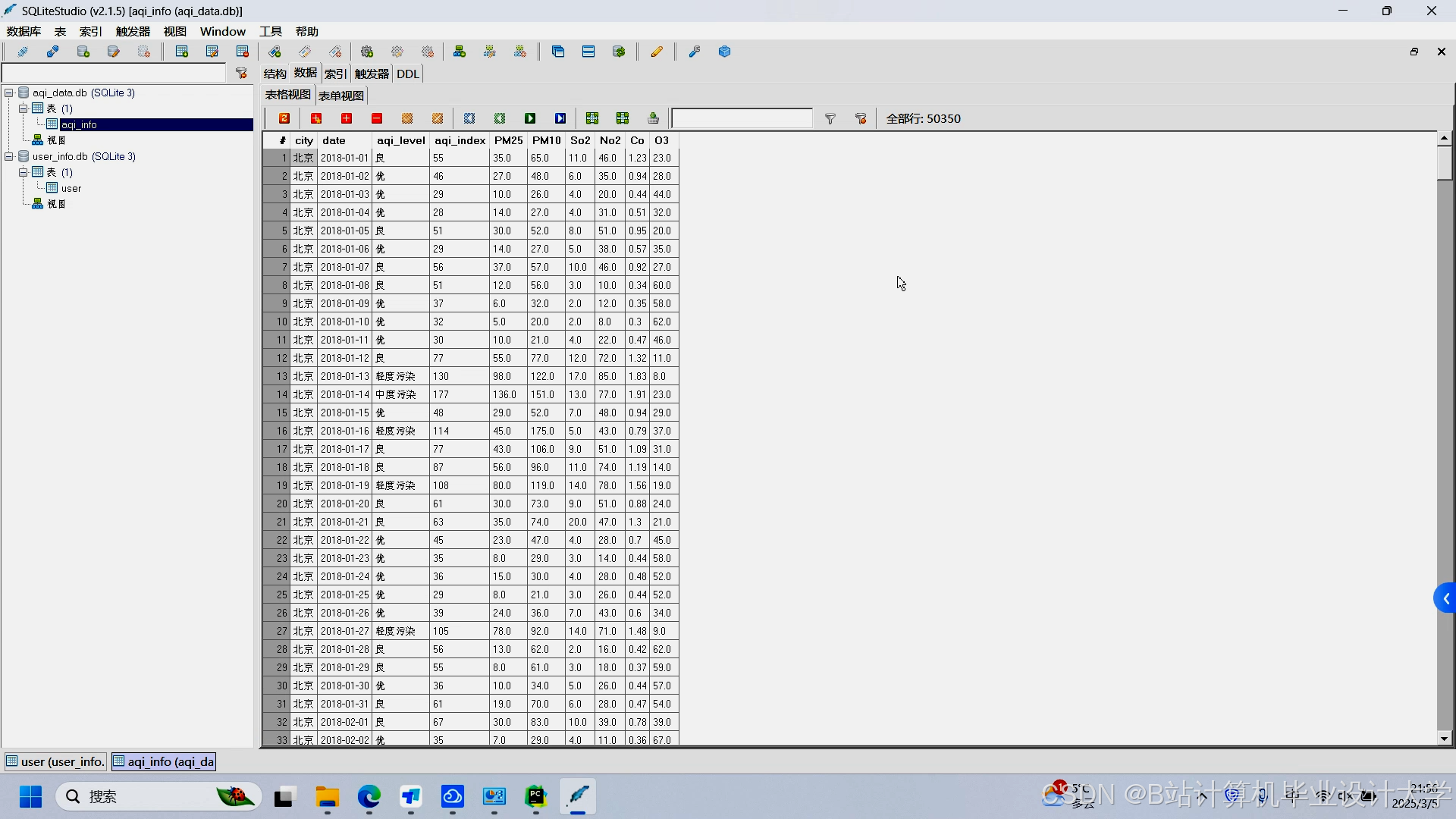

- 数据存储:将爬取数据保存至CSV文件或MySQL数据库(使用

pandas或SQLAlchemy)。

- 使用

- 定时任务:

- 使用

APScheduler或Celery实现每日定时爬取,更新本地数据库。

- 使用

交付物:

- 爬虫代码(Python脚本);

- 原始数据集(CSV/SQL格式);

- 数据字段说明文档。

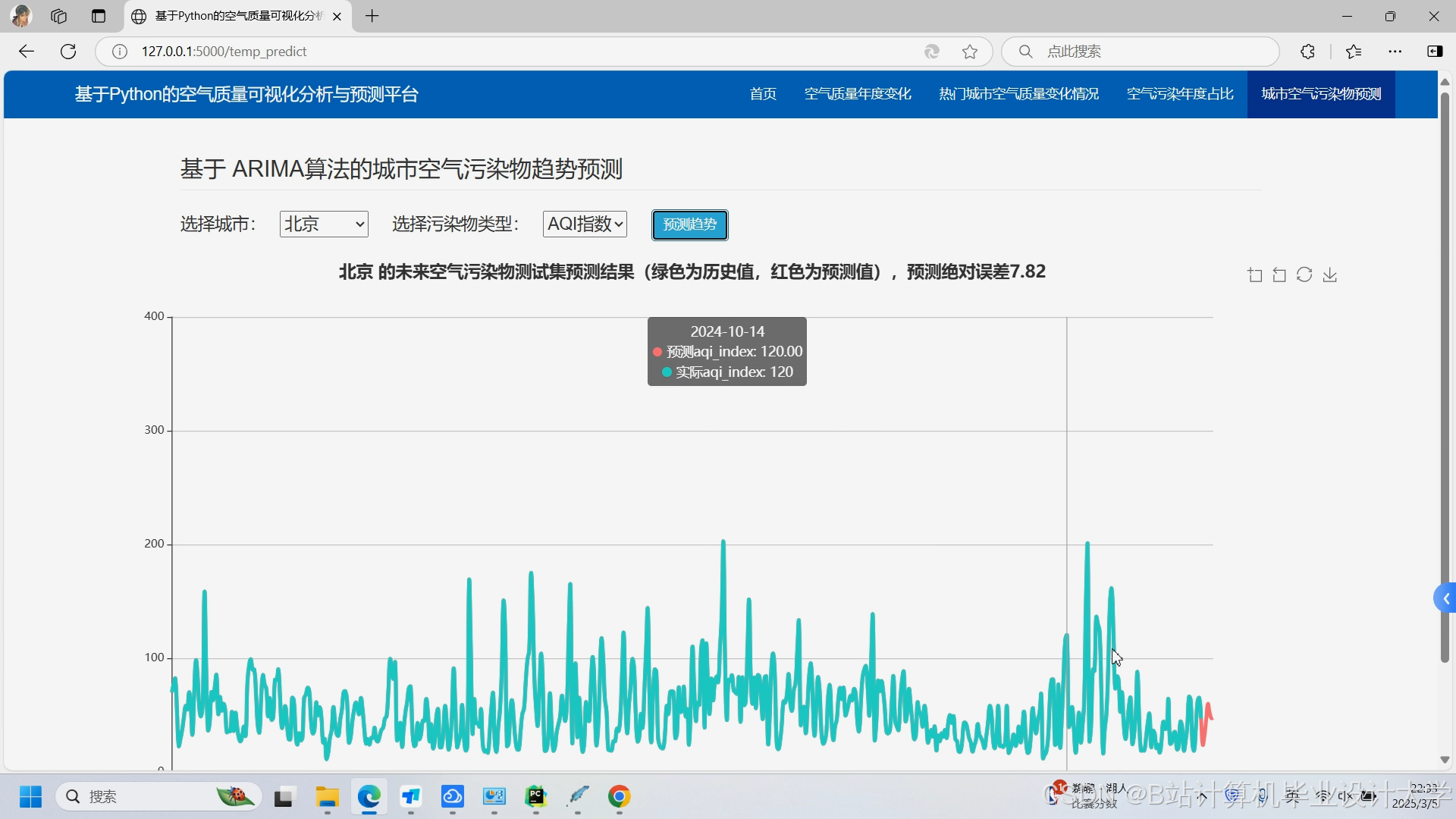

任务2:空气质量深度学习预测模型构建

目标:基于历史数据训练深度学习模型,预测未来24/48小时的空气质量指标(如PM2.5浓度)。

技术实现:

- 数据预处理:

- 缺失值处理:线性插值、KNN填充;

- 异常值检测:基于3σ原则或IQR方法;

- 特征工程:提取时间特征(小时、星期、月份)、气象特征(温度、湿度、风速)及滞后特征(前1-3小时的PM2.5值);

- 数据标准化:使用

MinMaxScaler或StandardScaler归一化数据。

- 模型选择与训练:

- 基线模型:线性回归、随机森林(用于对比基准性能);

- 深度学习模型:

- LSTM:处理时间序列依赖关系;

- Transformer:捕捉长距离时序模式;

- CNN-LSTM混合模型:结合空间与时间特征;

- 训练配置:使用

TensorFlow/Keras或PyTorch框架,划分训练集/测试集(8:2),采用Adam优化器,MAE/RMSE作为损失函数。

- 模型评估与优化:

- 评估指标:MAE、RMSE、R²;

- 超参数调优:网格搜索(GridSearchCV)或贝叶斯优化(Optuna);

- 可视化训练过程:绘制损失曲线与评估指标变化图。

交付物:

- 预处理代码与数据集;

- 训练好的模型文件(.h5或.pt格式);

- 模型评估报告(含对比实验结果)。

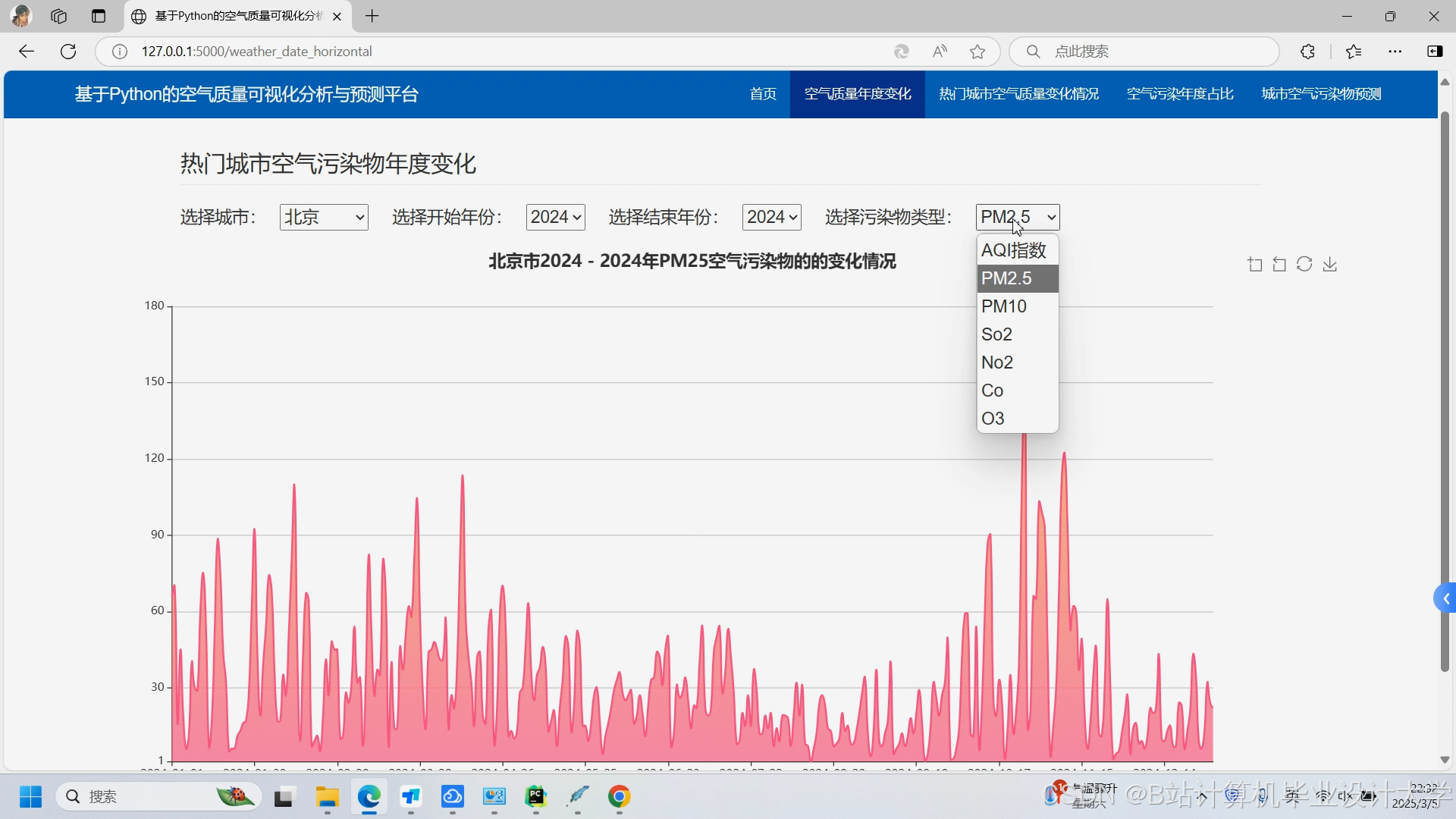

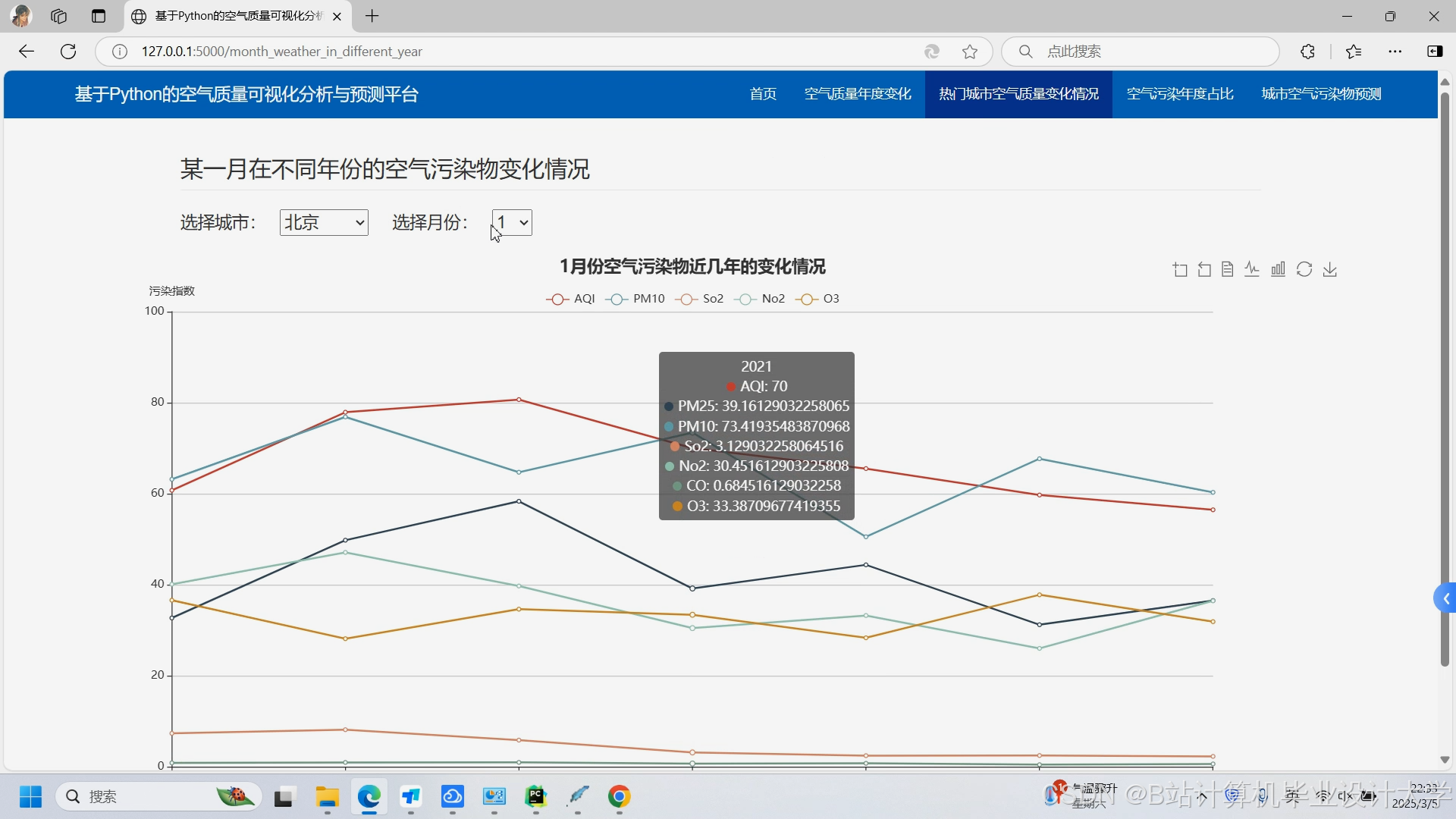

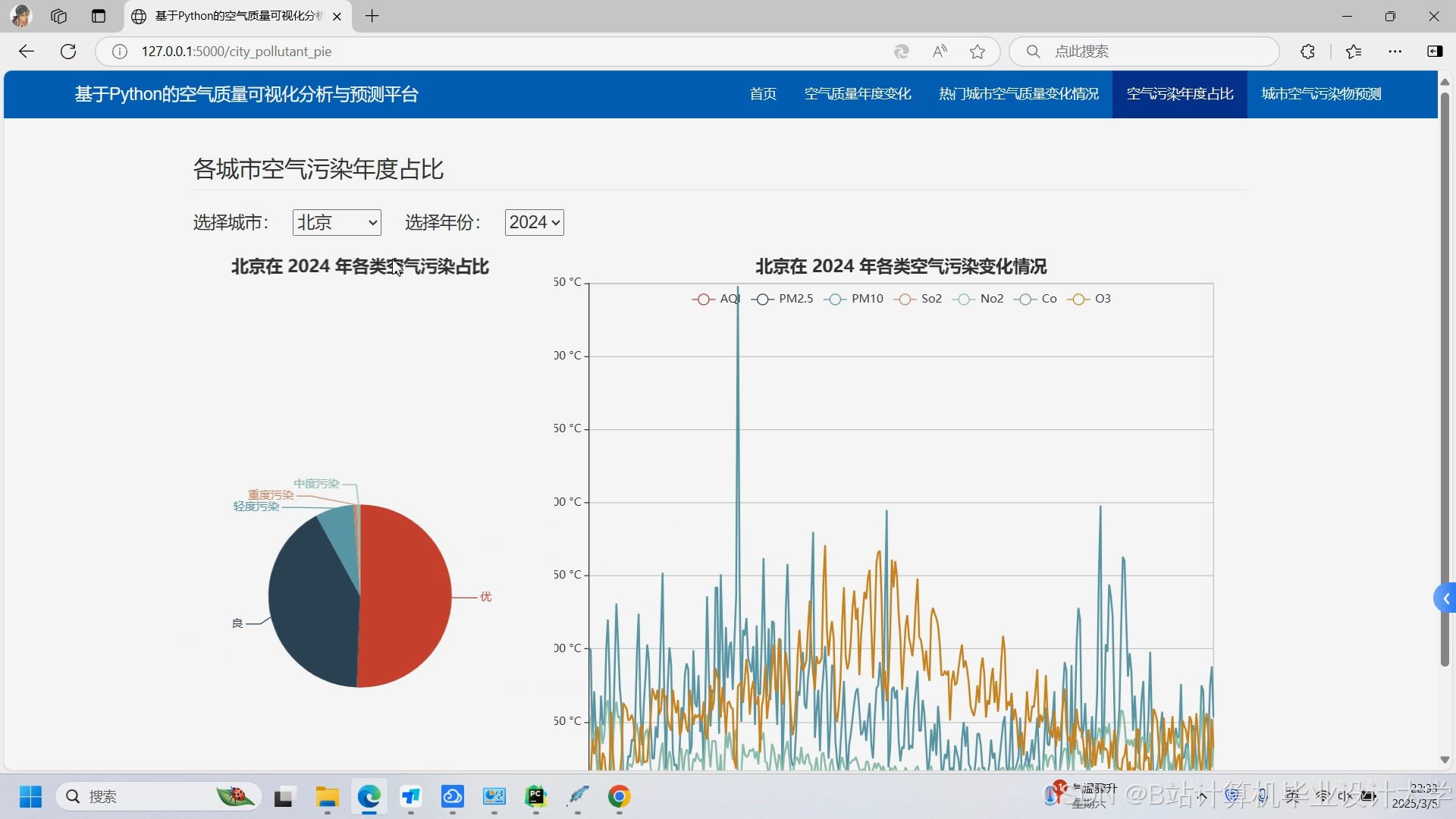

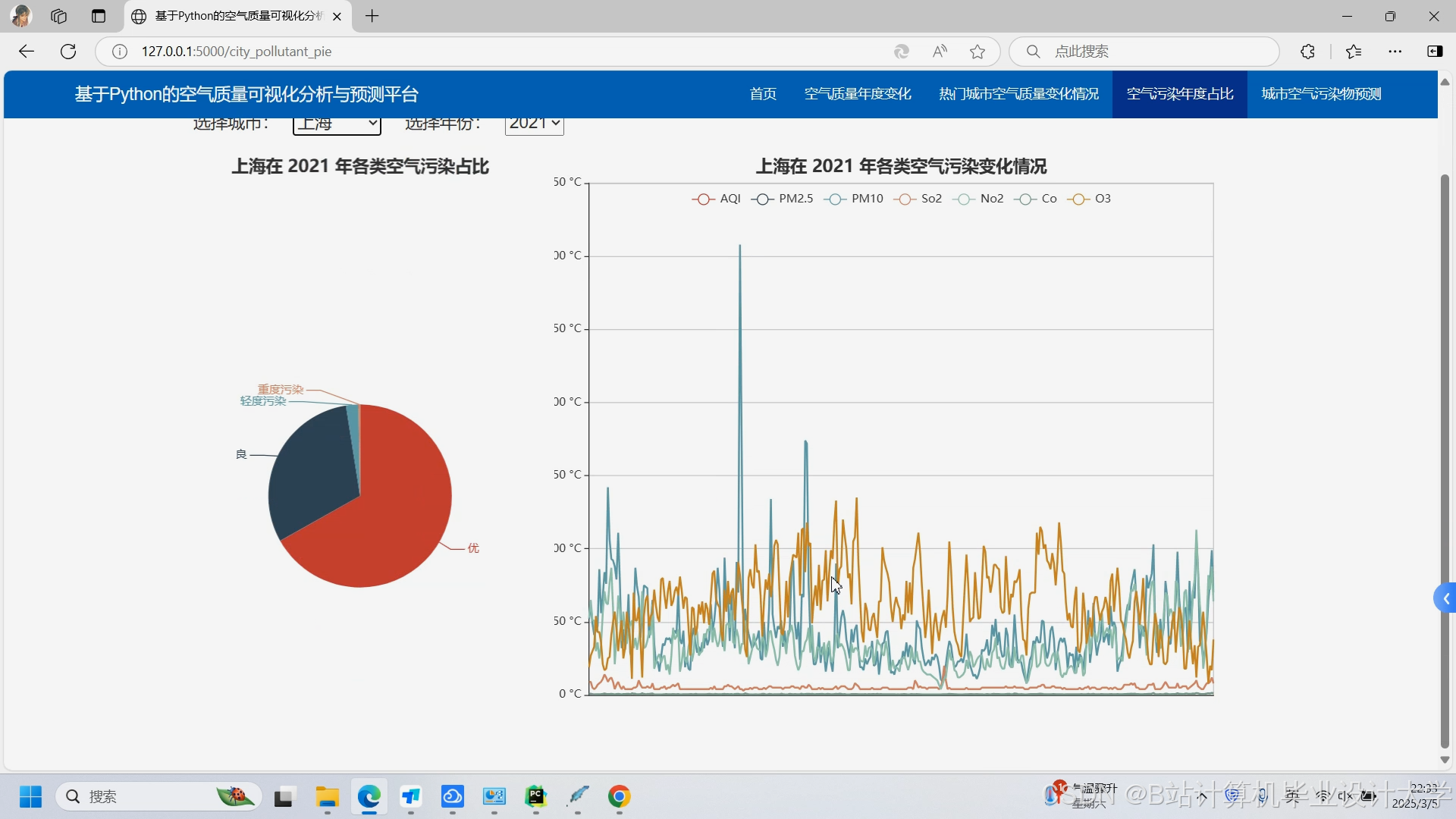

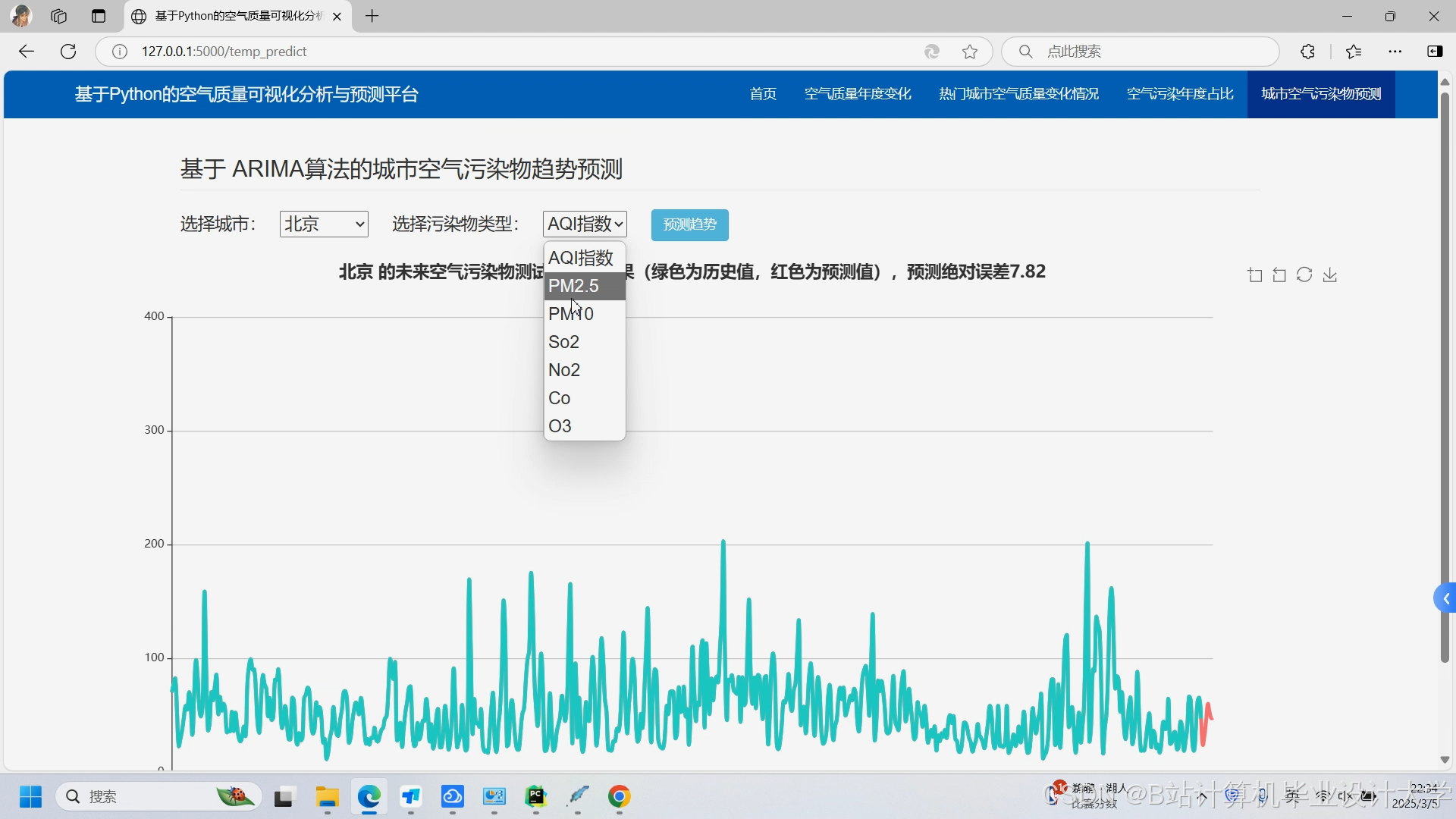

任务3:空气质量数据可视化开发

目标:生成交互式图表,展示空气质量历史趋势、空间分布及预测结果。

技术实现:

- 静态可视化:

- 使用

Matplotlib/Seaborn绘制折线图(PM2.5时间序列)、热力图(污染物相关性); - 使用

Pandas生成统计表格(如各城市平均PM2.5排名)。

- 使用

- 动态交互可视化:

- 使用

Plotly绘制动态折线图(支持缩放、悬停显示数值); - 使用

Pyecharts生成地理地图(展示全国/全球空气质量分布,支持按城市筛选); - 使用

Dash/Streamlit开发Web应用,集成多图表联动(如选择城市后自动更新对应图表)。

- 使用

- 预测结果可视化:

- 将模型预测值与真实值叠加显示,对比预测效果;

- 生成未来24小时空气质量变化趋势图,标注关键时间点(如污染峰值)。

交付物:

- 可视化代码(Jupyter Notebook或Python脚本);

- 交互式HTML文件或Web应用链接;

- 可视化截图与说明文档。

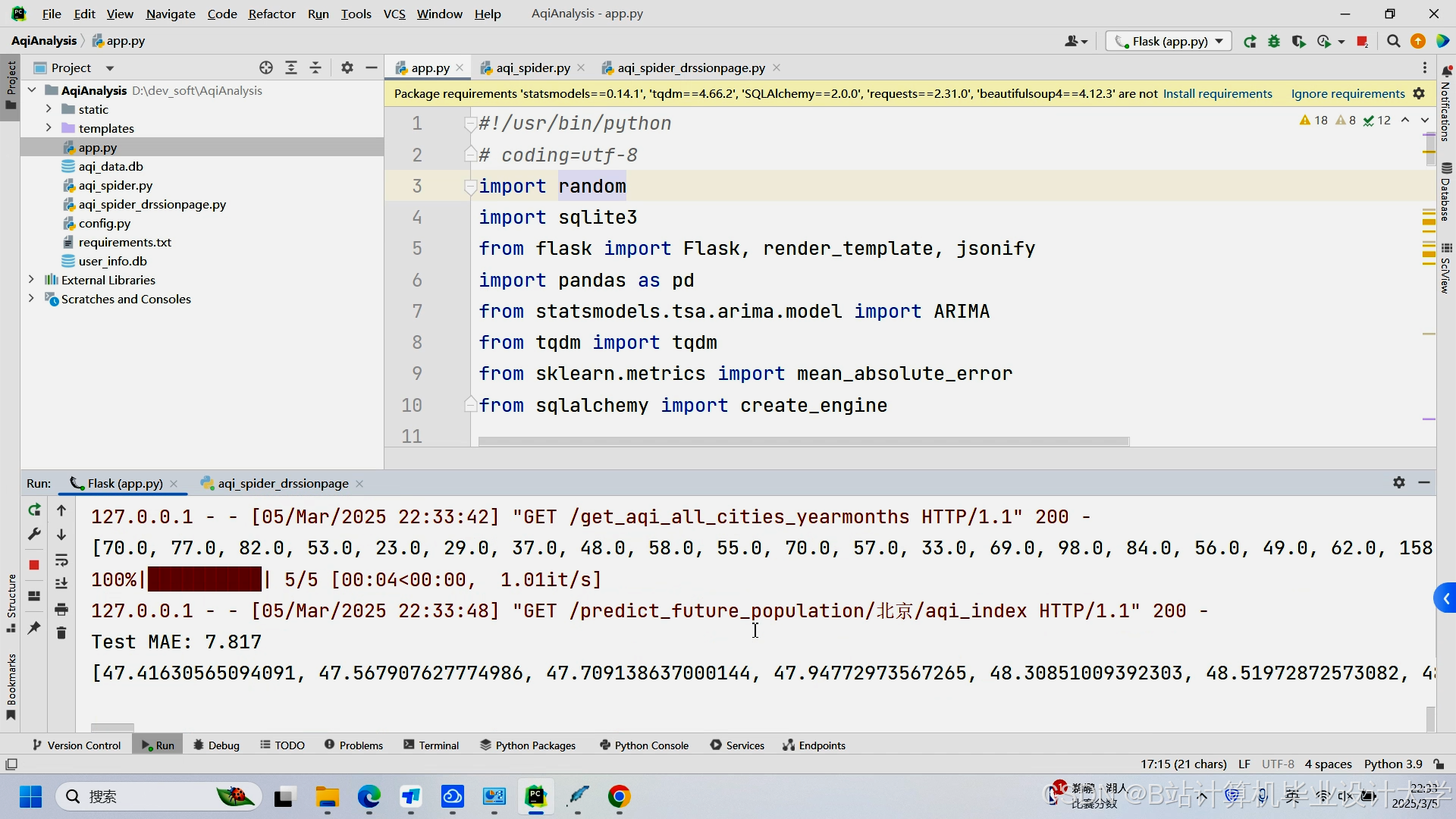

任务4:系统集成与部署

目标:将爬虫、预测模型与可视化模块整合为一个完整的Python应用程序,支持用户交互与结果导出。

技术实现:

- 模块封装:

- 将爬虫、预处理、预测、可视化功能封装为独立函数或类;

- 用户交互界面:

- 使用

Tkinter或Streamlit开发桌面/Web界面,提供以下功能:- 选择数据源与城市;

- 设置预测时间范围(如未来24小时);

- 导出图表(PNG/PDF)或数据(CSV);

- 使用

- 部署方案:

- 本地部署:直接运行Python脚本;

- 云部署:使用Flask/Django开发RESTful API,部署至AWS/阿里云服务器;

- 容器化:使用Docker打包应用,实现环境隔离与快速部署。

交付物:

- 完整应用程序代码;

- 用户操作手册;

- 部署文档(含依赖库列表与环境配置说明)。

三、时间计划与里程碑

| 阶段 | 时间范围 | 关键任务 |

|---|---|---|

| 需求分析 | 第1周 | 确定数据源、模型选型与可视化需求;制定技术方案。 |

| 爬虫开发 | 第2-3周 | 完成数据爬取、存储与定时更新功能;交付原始数据集。 |

| 模型训练 | 第4-5周 | 完成数据预处理、模型训练与评估;交付训练好的模型与评估报告。 |

| 可视化开发 | 第6周 | 完成静态/动态图表开发;交付交互式可视化结果。 |

| 系统集成 | 第7周 | 整合各模块;开发用户界面;完成部署测试。 |

| 验收与优化 | 第8周 | 用户测试与反馈;修复Bug;优化性能;交付最终文档。 |

四、资源需求

- 硬件资源:

- 开发环境:PC(Windows/Linux/macOS),建议配置GPU(如NVIDIA GTX 1080)以加速深度学习训练;

- 服务器(可选):用于云部署,需配置公网IP与域名。

- 软件资源:

- Python 3.8+;

- 依赖库:

requests、BeautifulSoup、pandas、numpy、scikit-learn、tensorflow/pytorch、matplotlib、plotly、pyecharts、streamlit等; - 开发工具:Jupyter Notebook、PyCharm/VSCode、Git。

五、风险评估与应对

- 数据源变更风险:目标网站API或网页结构更新导致爬虫失效。

- 应对:定期检查爬虫代码,维护数据源列表;使用

Scrapy框架增强爬虫健壮性。

- 应对:定期检查爬虫代码,维护数据源列表;使用

- 模型过拟合风险:训练数据量不足或特征选择不当导致模型泛化能力差。

- 应对:增加数据多样性(如爬取多城市数据);采用交叉验证与正则化技术。

- 可视化性能风险:大数据量导致交互式图表加载缓慢。

- 应对:对数据进行降采样或聚合;使用

Datashader等库优化渲染效率。

- 应对:对数据进行降采样或聚合;使用

六、交付成果

- 源代码(GitHub仓库链接);

- 原始数据集与预处理后数据集;

- 模型文件与评估报告;

- 可视化结果(HTML/Web应用);

- 用户手册与部署文档;

- 项目总结报告(含技术难点与解决方案)。

项目负责人:

日期:

备注:本任务书可根据实际需求调整技术细节与时间安排,需确保各模块接口兼容性与代码可维护性。

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?