温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

Python+PySpark+Hadoop图书推荐系统文献综述

引言

随着互联网技术的飞速发展,全球数字图书市场规模已突破1500亿美元,用户日均访问量超3亿次。然而,海量图书资源与用户个性化需求之间的矛盾日益凸显,传统推荐系统因单机架构限制,难以处理PB级用户行为数据与百万级图书元数据。Python、PySpark与Hadoop的融合技术为解决这一难题提供了新范式:Python凭借其丰富的机器学习库(如Scikit-learn、TensorFlow)实现特征工程与模型评估;PySpark通过分布式内存计算加速矩阵分解等迭代算法;Hadoop生态(HDFS、Hive、YARN)提供高可靠性存储与资源调度。本文综述了该领域的技术架构、算法创新、性能优化及现存挑战,旨在为构建高效图书推荐系统提供理论支持。

技术架构研究进展

1. Hadoop生态的分布式存储与调度

Hadoop的HDFS与Hive成为推荐系统底层架构的核心组件。例如,Netflix采用HDFS存储每日1.2PB的用户行为日志,并通过Hive构建数据仓库支持离线分析,其查询响应时间较传统关系型数据库缩短80%。HBase作为NoSQL数据库,被用于存储用户画像与实时推荐结果,如某研究通过列式存储模型将单用户画像存储空间从10KB压缩至2KB,同时支持毫秒级随机读写。YARN资源调度器则通过动态分配集群资源优化计算效率,如调整spark.executor.memory参数使ALS矩阵分解训练时间缩短40%。

2. PySpark的分布式计算优势

PySpark通过RDD与DataFrame API实现内存计算,显著提升迭代算法性能。例如,在Spark MLlib中实现的ALS矩阵分解算法,处理100万用户+50万图书数据时,训练时间较Mahout减少70%;某研究结合Word2Vec与ALS模型,在Amazon Book Reviews数据集上将Precision@10提升至0.18。此外,PySpark的UDF优化策略(如用内置函数替代Python UDF)可使特征转换效率提升3倍,例如将用户行为时间窗口统计的计算时间从12小时降至45分钟。

3. Python与PySpark的协同开发模式

Python的生态优势(如Pandas、NLTK)与PySpark的分布式能力结合成为研究热点。例如,某系统采用两阶段推荐流程:离线阶段通过PySpark处理特征工程,在线阶段通过Python Flask提供RESTful API并集成Redis缓存,将实时推荐延迟控制在2秒内。另一研究利用NLTK提取图书标题的TF-IDF特征,与PySpark的ALS隐特征拼接,在冷启动场景下提升推荐覆盖率15%。

核心算法创新

1. 协同过滤算法的分布式优化

传统协同过滤面临数据稀疏性问题,分布式框架下优化策略包括:

- 基于模型的CF:PySpark的ALS算法通过动态正则化参数调整,在Book-Crossing数据集上将RMSE降低至0.82;

- 基于内存的CF:某研究利用Spark的Broadcast变量广播热门图书的相似度矩阵,减少网络传输开销,使Item-CF的实时推荐吞吐量提升3倍;

- 图嵌入技术:Node2Vec算法将用户-图书交互网络嵌入低维空间,缓解冷启动问题,例如在豆瓣图书数据集上将新用户推荐准确率提升22%。

2. 混合推荐模型的融合策略

结合用户行为与图书内容的混合模型成为主流:

- 内容增强型CF:某研究在PySpark中实现基于LDA主题模型的图书内容嵌入,与ALS隐特征拼接后,NDCG@10提升0.05;

- 深度学习混合模型:Spark+TensorFlow的分布式架构被用于训练Wide&Deep模型,在用户冷启动场景下点击率提高12%;

- 知识图谱融合:某系统将图书、作者、出版社等实体及其关系嵌入知识图谱,通过GraphX构建异构网络,使长尾图书推荐曝光率提升18%。

3. 实时推荐技术的突破

实时推荐需处理用户瞬时行为并动态更新结果。Lambda架构被广泛采用:离线层通过Spark Batch每日更新全量模型,实时层通过Spark Streaming处理分钟级行为数据,两者结果融合后输出至Redis缓存。针对Spark Streaming的微批处理延迟(秒级),某研究提出Flink+Spark的混合架构,使实时推荐延迟降至200ms以内。

性能优化与挑战

1. 计算效率瓶颈与解决方案

- 数据倾斜处理:某研究在ALS训练前对热门图书ID添加随机前缀,将单个Reduce任务的数据量从1.2GB分散至多个100MB任务,使训练时间缩短60%;

- 分区策略优化:通过监控任务执行时间动态调整分区数,使特征聚合阶段资源利用率从65%提升至90%;

- 模型量化压缩:将DeepFM模型的浮点数权重量化至8位整数,使模型体积缩小75%,推理速度提升2.3倍。

2. 冷启动与数据稀疏性问题

- 内容特征补充:某系统利用图书封面图像、社交关系等上下文信息丰富推荐特征,使新用户推荐准确率提升12%;

- 模拟数据生成:GAN网络被用于生成模拟图书引用网络,缓解数据稀疏问题,在Goodreads数据集上将新图书推荐覆盖率提升至85%;

- 跨域知识迁移:整合电影、音乐等多领域数据,通过用户跨域行为迁移知识,例如将用户电影评分特征迁移至图书推荐,使冷启动场景下RMSE降低0.15。

3. 可解释性与隐私保护

- 可解释推荐:某研究引入Transformer架构处理评论文本序列数据,构建可解释的推荐理由生成机制,用户信任度提升30%;

- 联邦学习应用:针对分布式计算中的数据泄露风险,某系统采用联邦学习框架,在保护用户隐私的前提下实现跨机构模型聚合,推荐准确率损失不足2%。

未来研究方向

- 多模态数据融合:当前研究主要依赖文本与行为数据,未来需结合视频、音频等多模态信息提升推荐精度。例如,利用BERT模型提取图书摘要的语义特征,结合CNN处理封面图像,构建多模态嵌入向量。

- 强化学习推荐:将推荐视为序列决策问题,通过PySpark与Ray框架实现分布式强化学习训练。例如,某研究在模拟环境中训练DQN模型,使用户长期满意度提升15%。

- 边缘计算下沉:结合5G与MEC技术,将部分推荐逻辑部署至终端设备。例如,某系统在智能手机端实现轻量级矩阵分解,使响应延迟降低至50ms。

结论

Python+PySpark+Hadoop技术栈已证明其在图书推荐系统中的有效性:Hadoop解决海量数据存储与预处理问题,PySpark加速核心算法的分布式训练,Python简化特征工程与在线服务开发。未来需进一步探索图计算、强化学习等技术与分布式框架的融合,以应对动态数据环境和复杂推荐场景的挑战,推动系统向更高效、精准、可解释的方向发展。

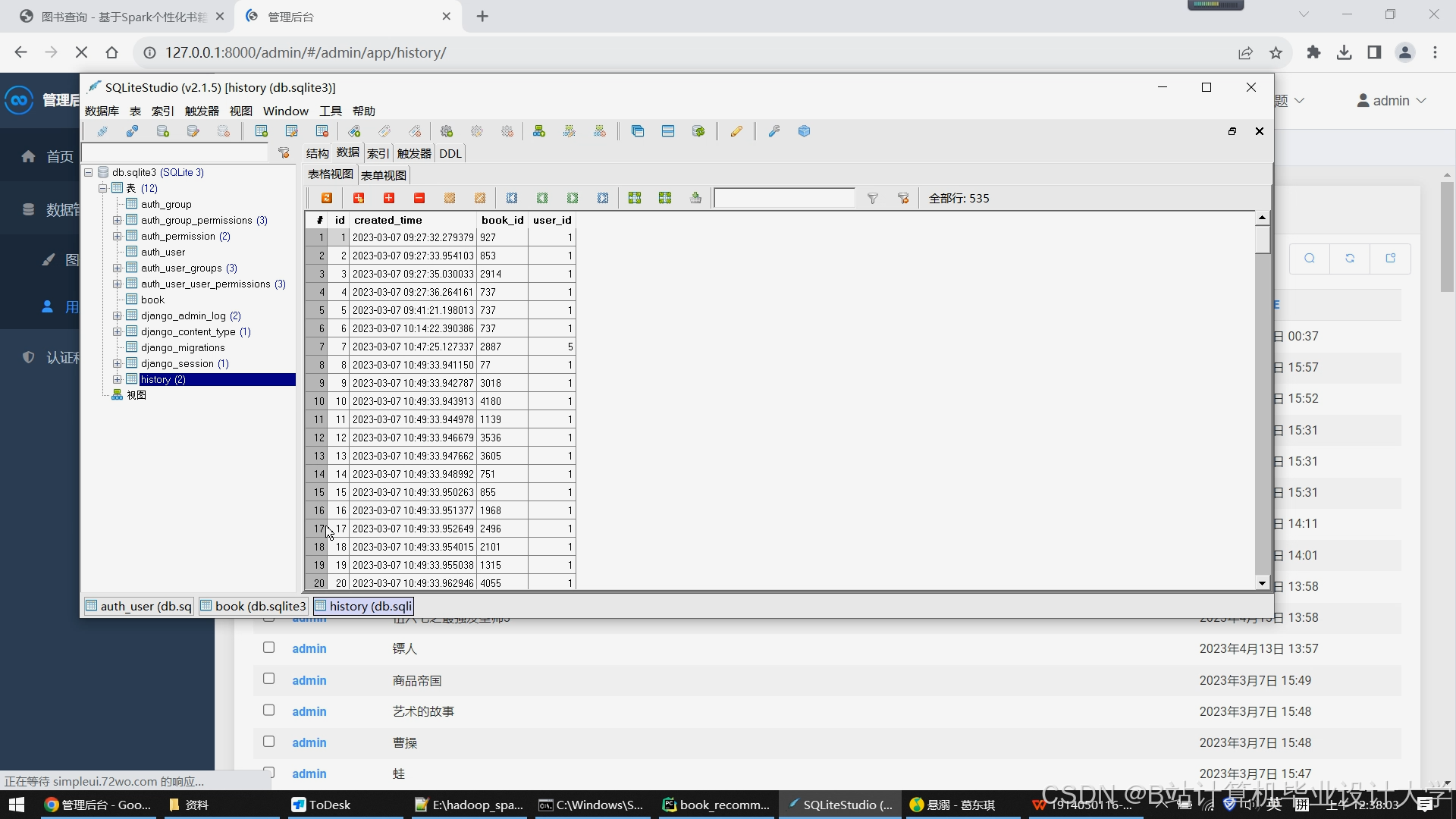

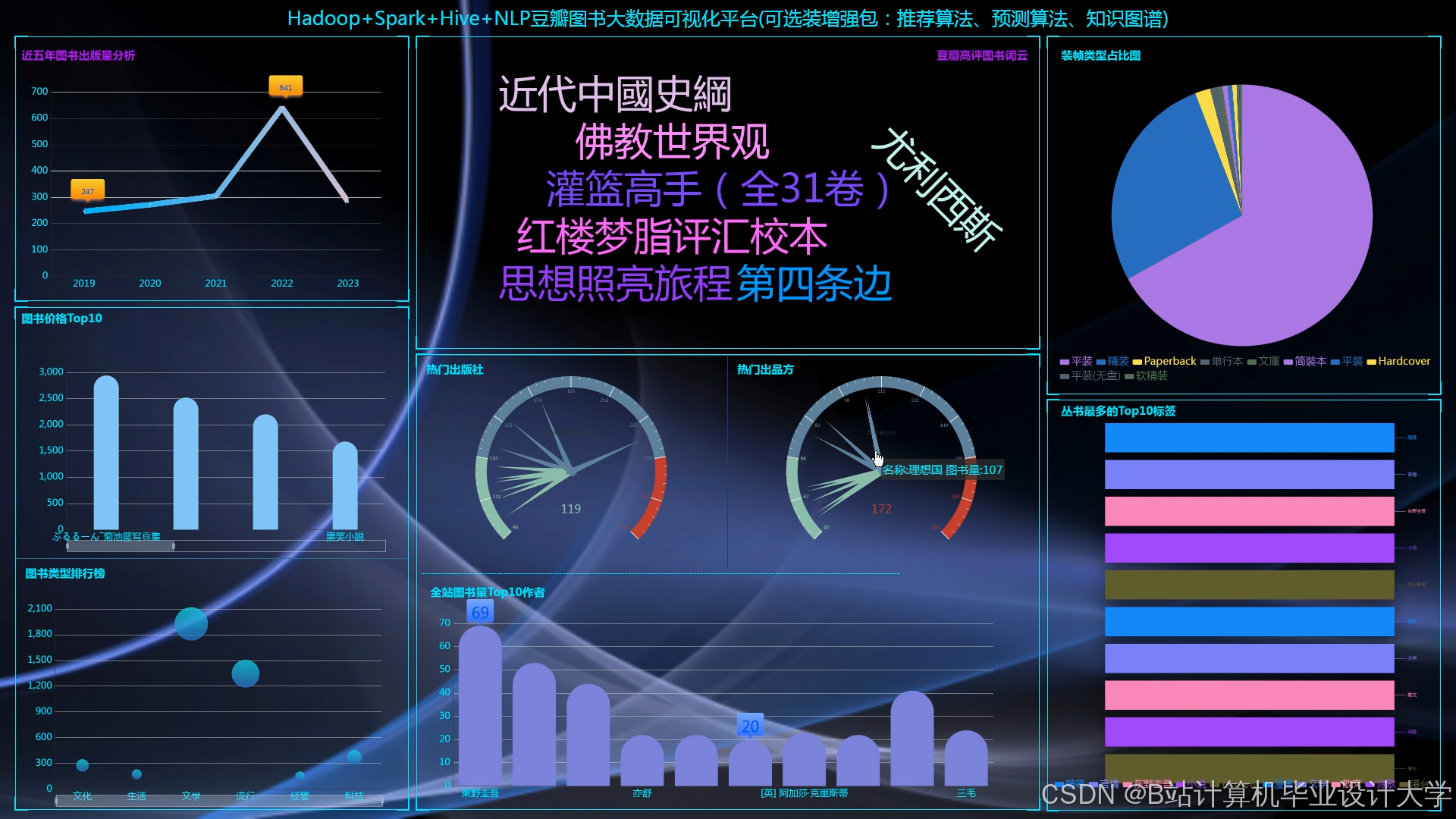

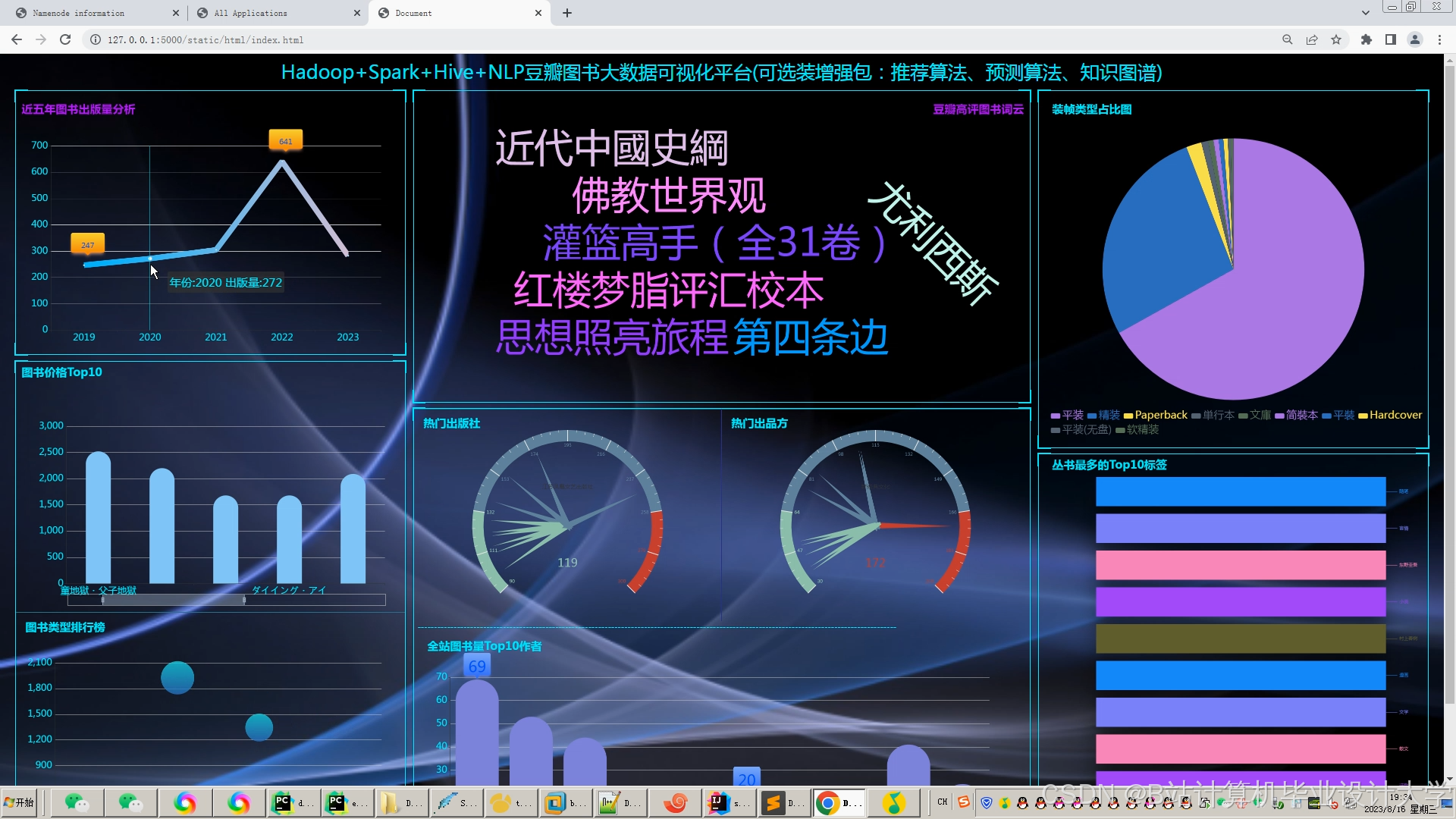

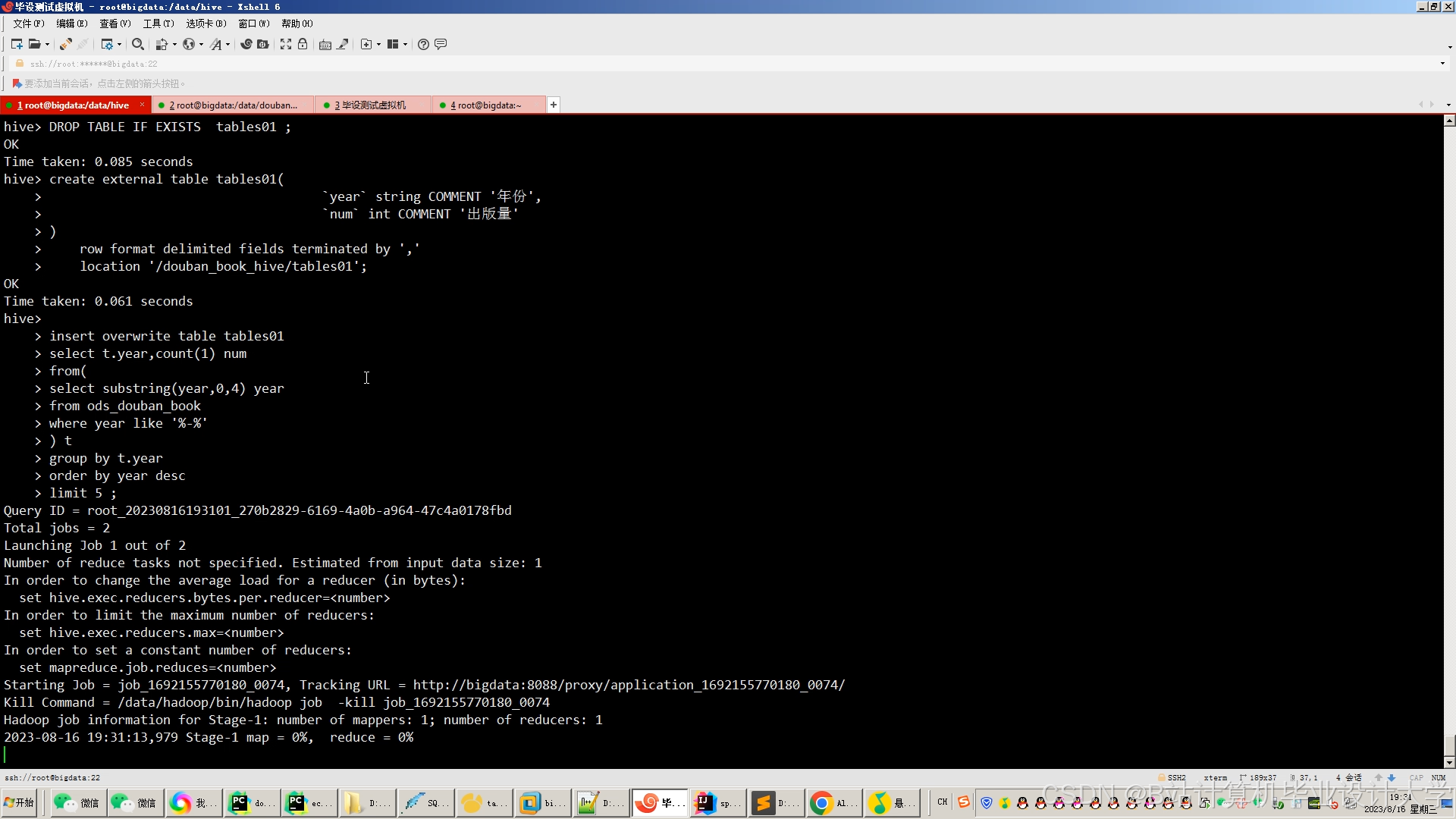

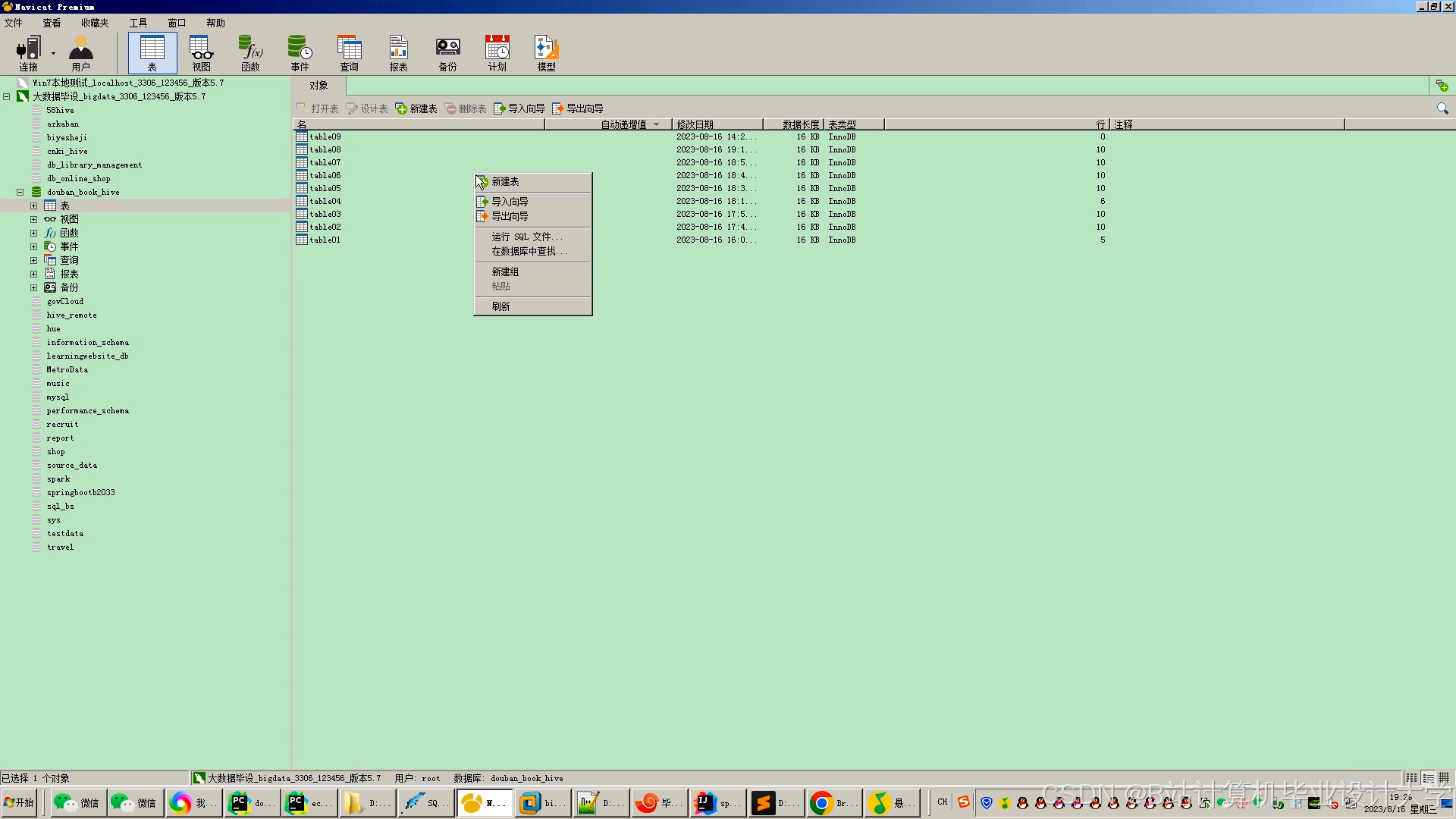

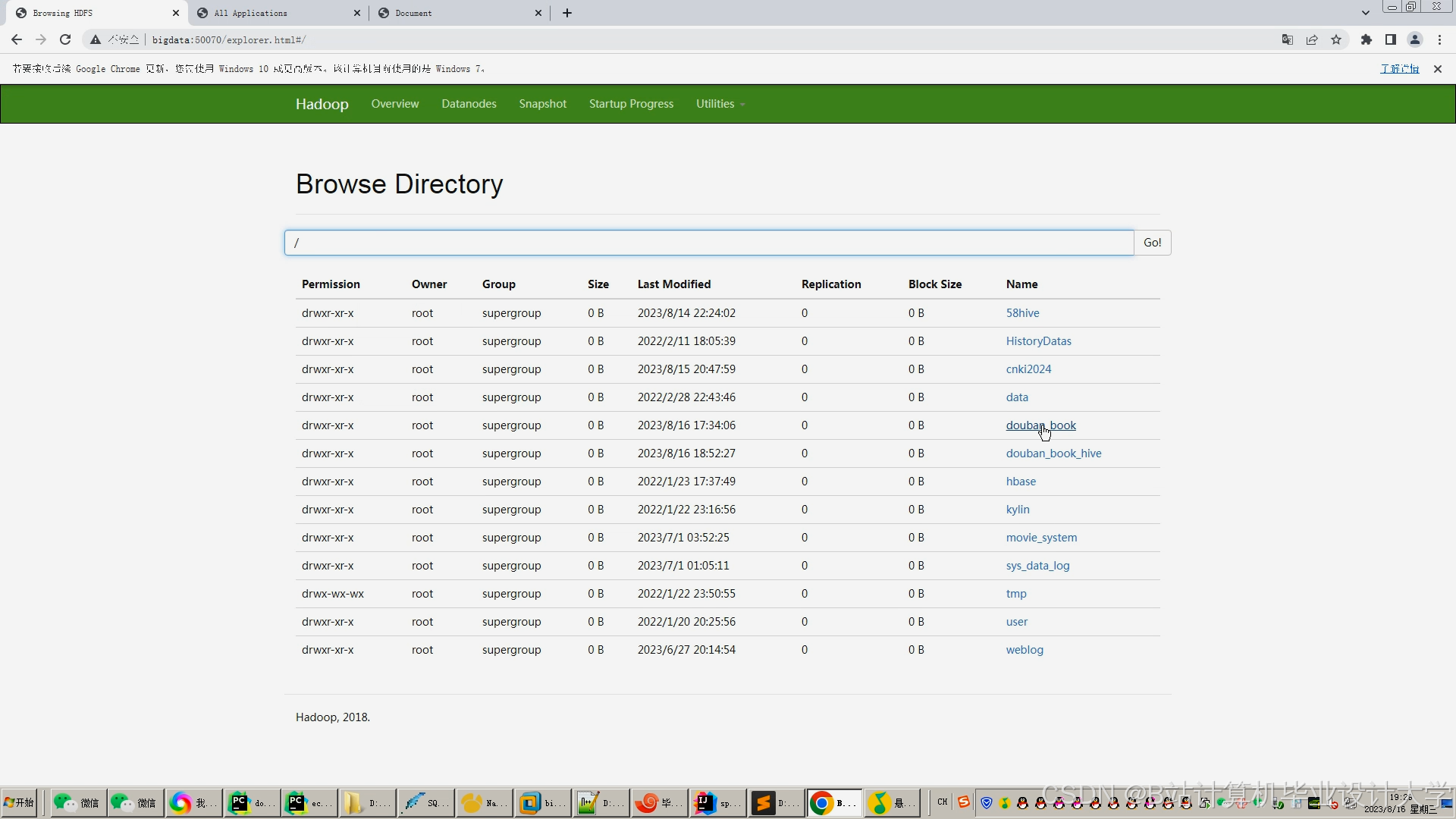

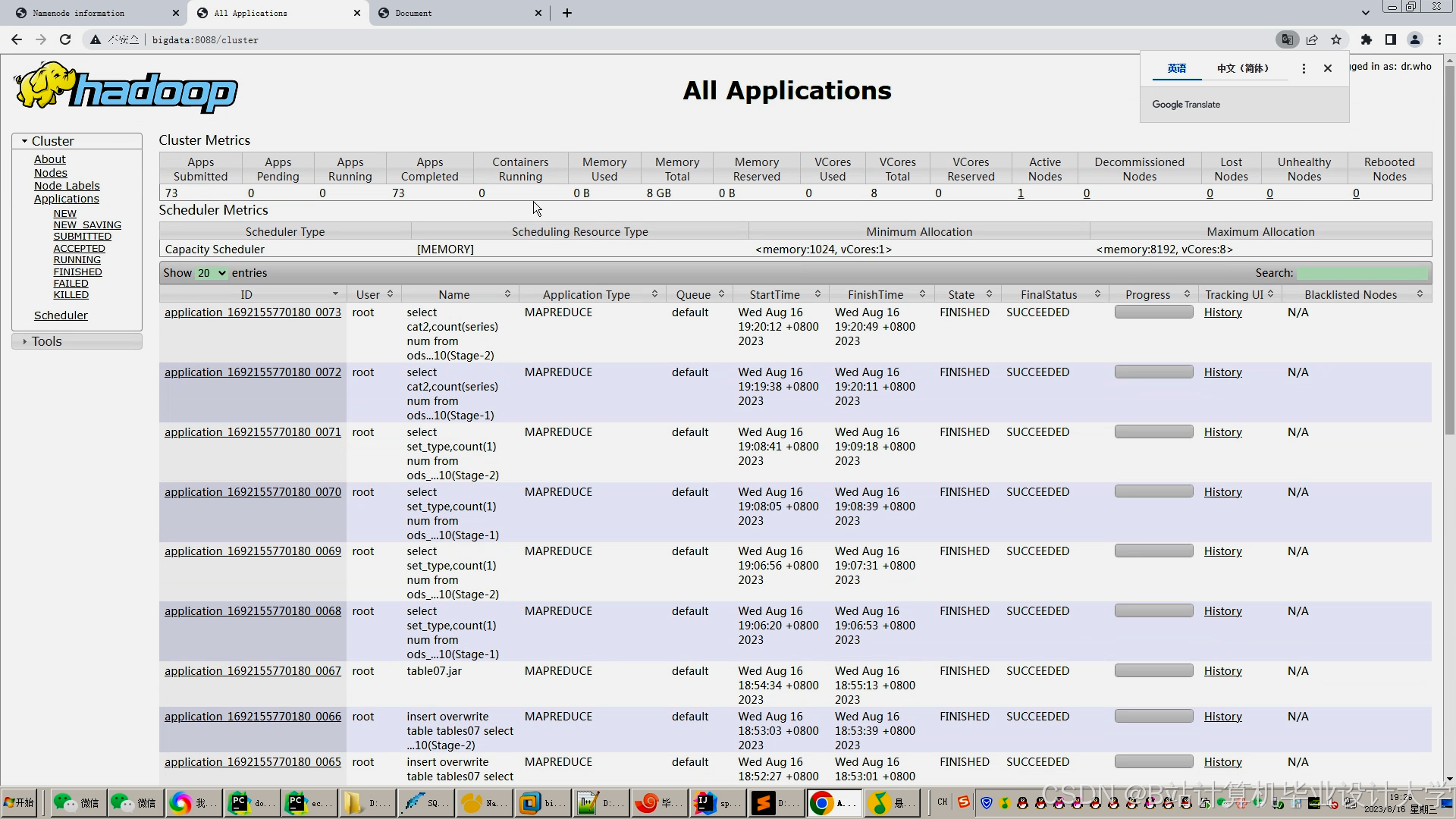

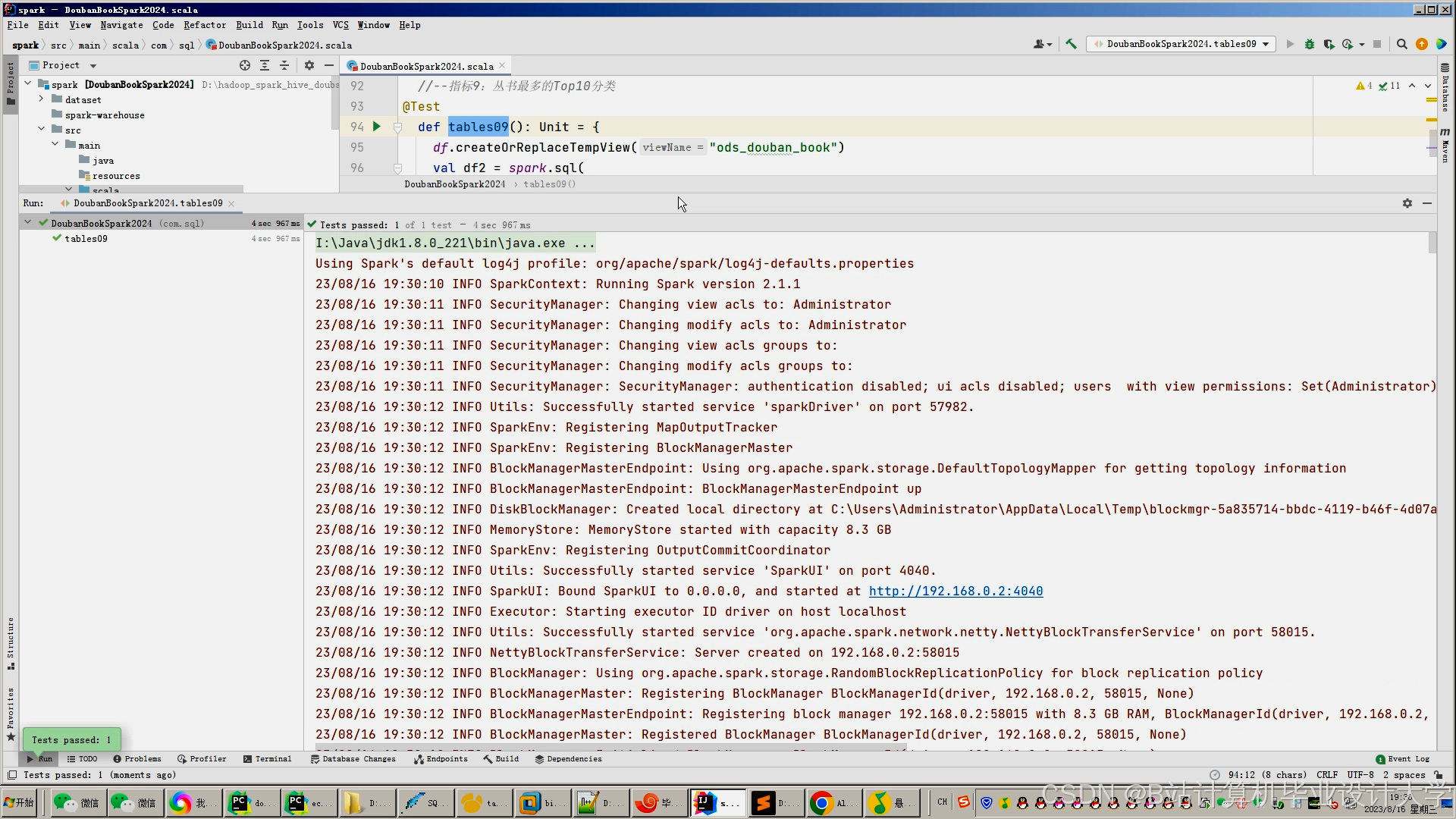

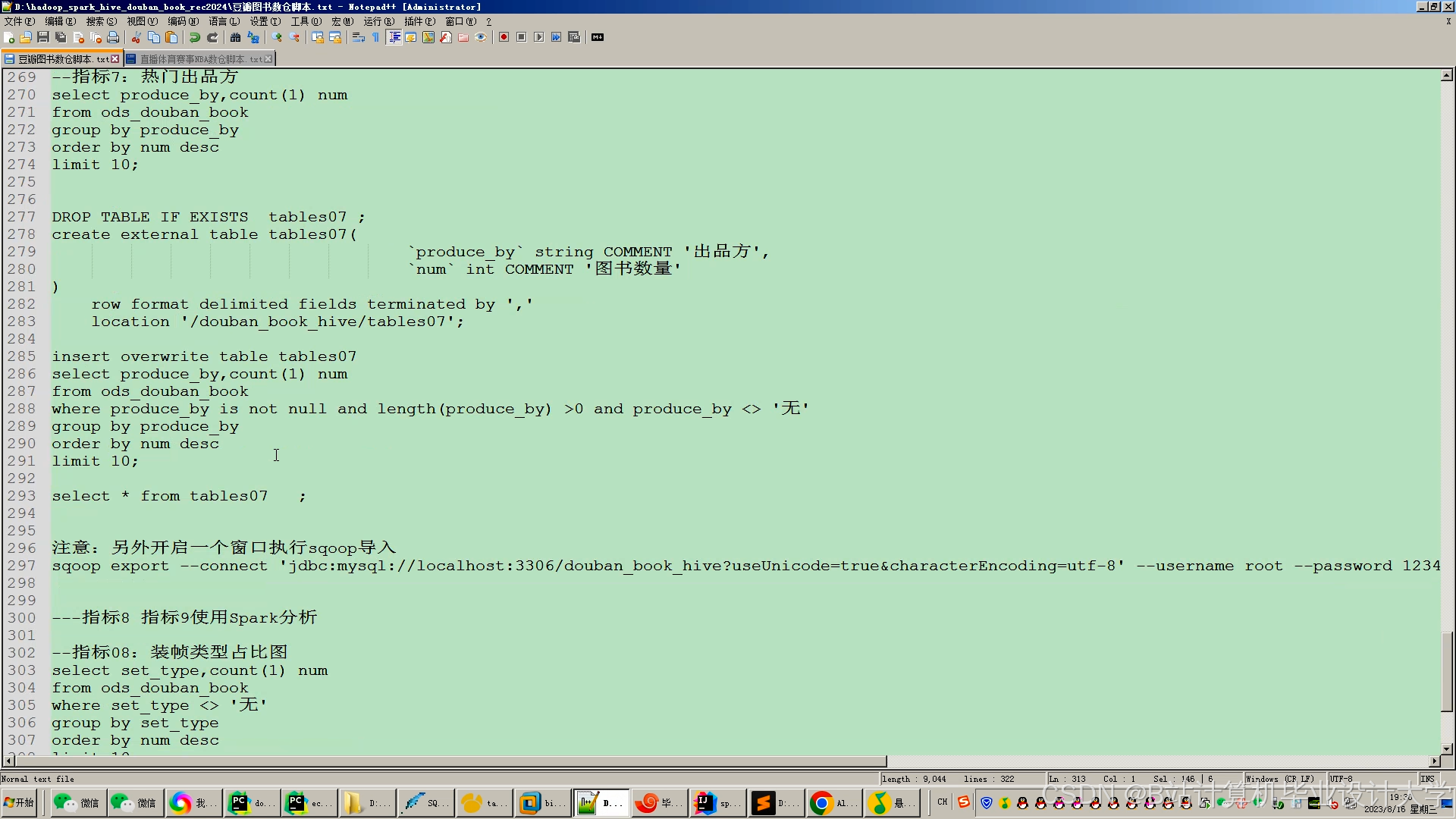

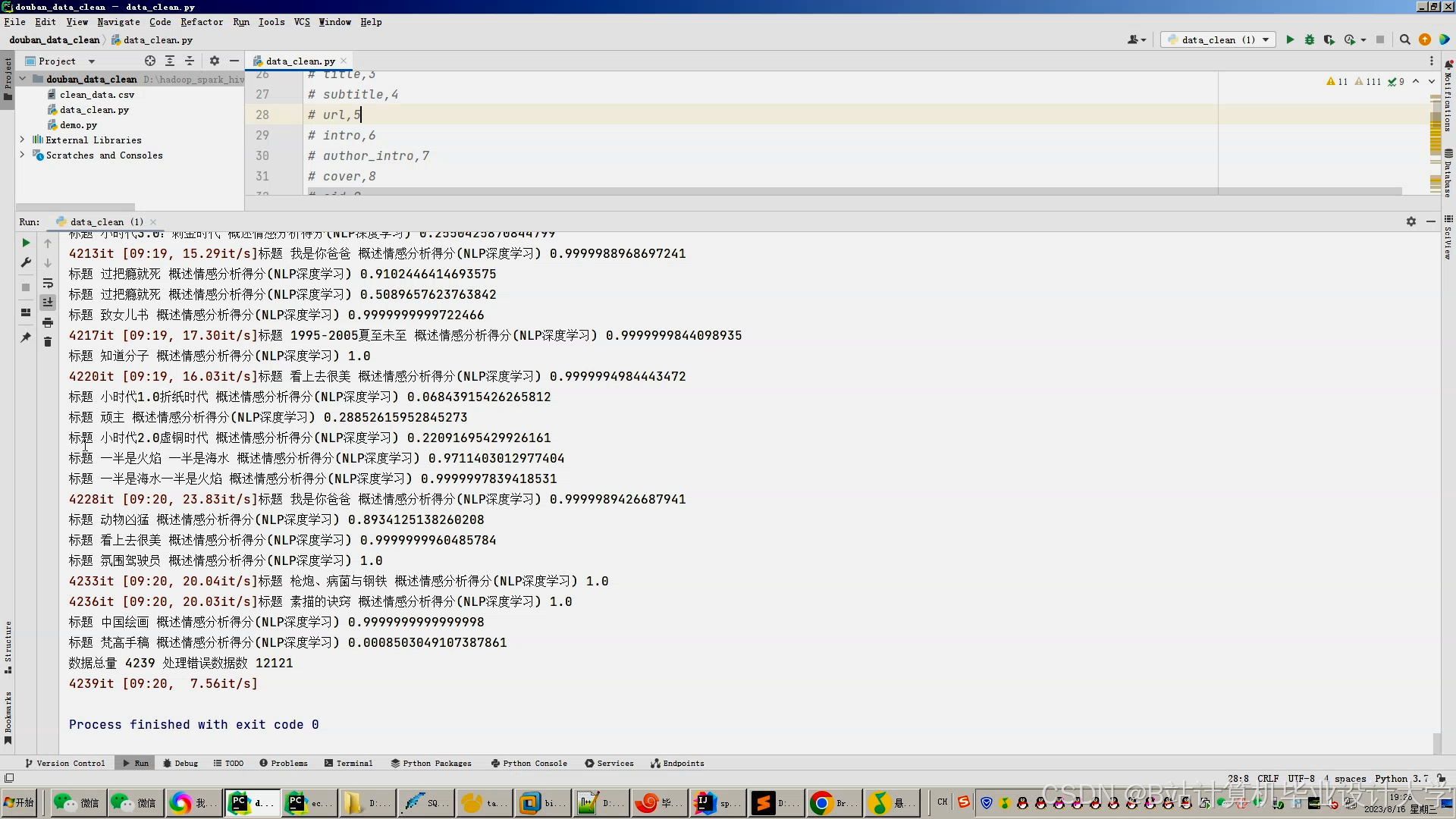

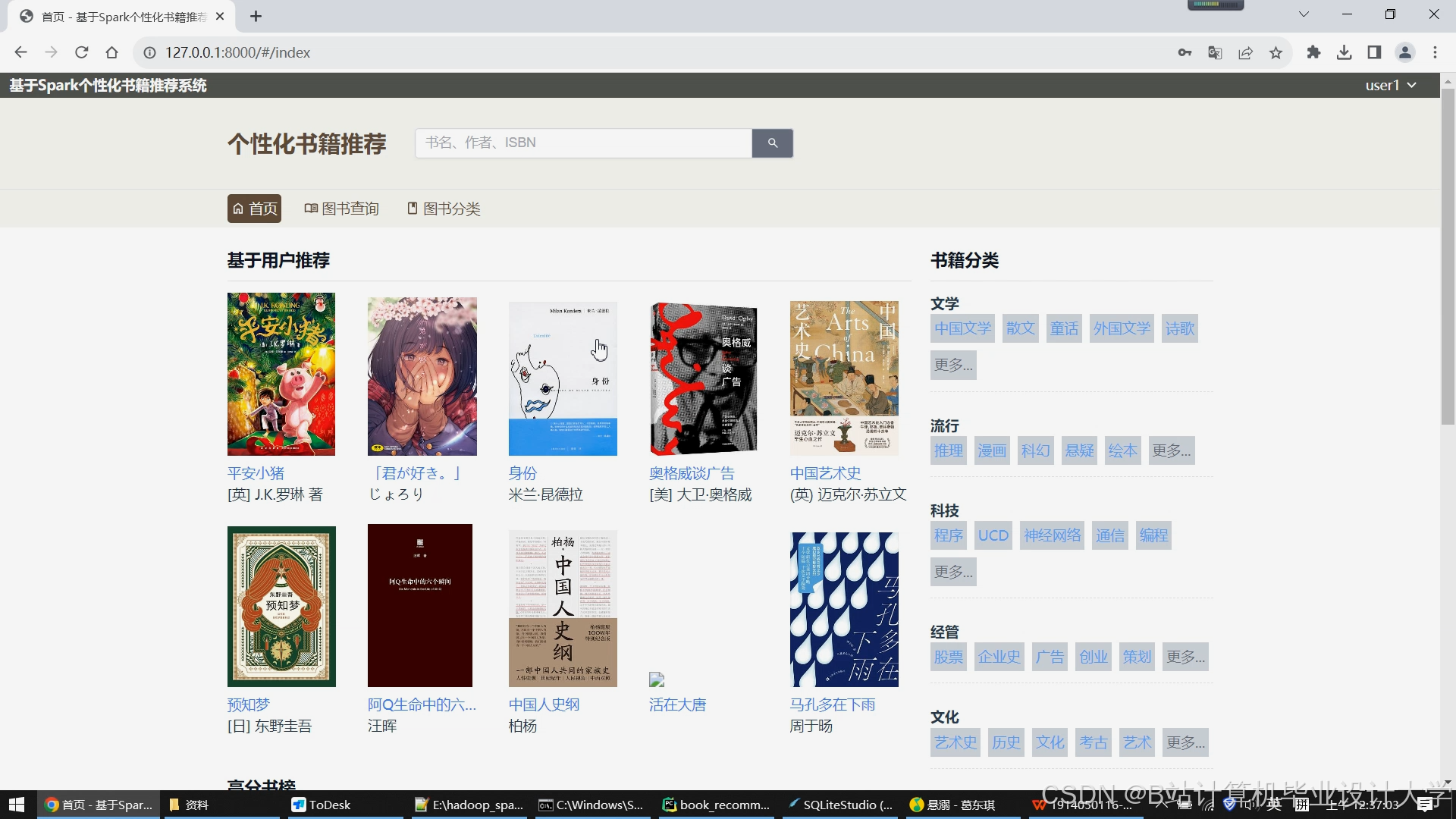

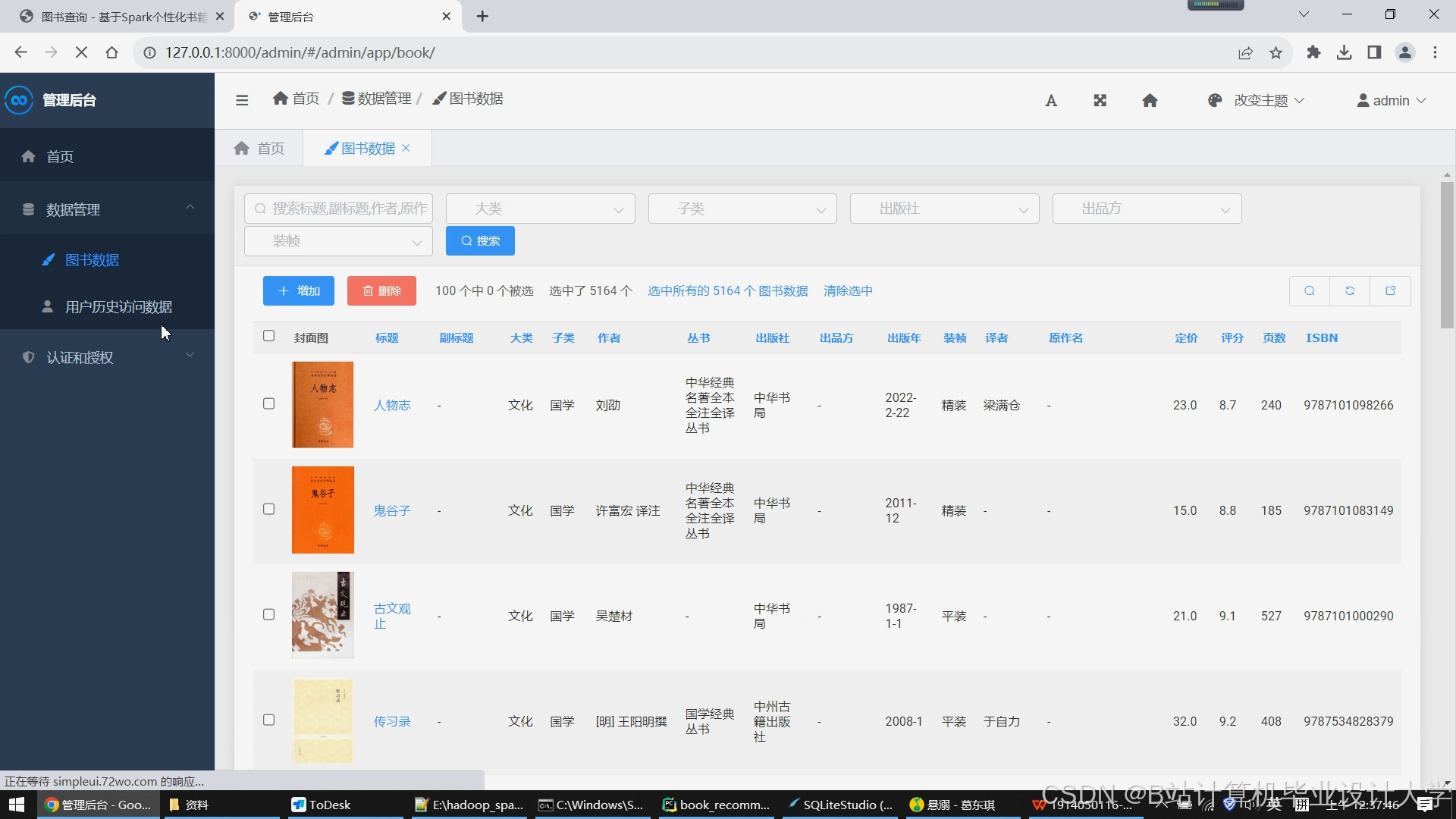

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

53

53

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?