温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

温馨提示:文末有 优快云 平台官方提供的学长联系方式的名片!

信息安全/网络安全 大模型、大数据、深度学习领域中科院硕士在读,所有源码均一手开发!

感兴趣的可以先收藏起来,还有大家在毕设选题,项目以及论文编写等相关问题都可以给我留言咨询,希望帮助更多的人

介绍资料

开题报告:基于Hadoop+Spark+Hive的招聘大数据分析可视化与招聘推荐系统

一、选题背景与意义

1.1 行业背景

随着互联网招聘市场规模的持续扩张(2023年达1800亿元,年增长率15%),企业与求职者面临海量数据匹配难题。传统招聘系统存在三大痛点:

- 数据孤岛:企业招聘需求、求职者简历、历史招聘记录分散在多个平台(如企业官网、招聘网站、社交媒体),整合难度大;

- 匹配效率低:基于关键词的简单匹配无法捕捉语义关联(如"Java开发"与"后端工程师"),导致有效投递率不足20%;

- 决策缺乏数据支撑:企业难以分析招聘渠道效果、岗位竞争热度等关键指标,优化招聘策略的依据不足。

1.2 技术背景

大数据技术为招聘系统升级提供了可能:

- Hadoop:通过HDFS分布式存储海量招聘数据(如简历文本、行为日志),支持PB级数据扩展;

- Spark:利用内存计算加速数据处理(如简历解析、相似度计算),较MapReduce提升10倍性能;

- Hive:构建数据仓库,支持复杂SQL查询(如分析不同城市岗位供需比),降低开发门槛。

1.3 研究意义

本系统旨在构建一个全流程招聘大数据分析平台,实现:

- 精准推荐:通过深度学习模型挖掘求职者技能与岗位需求的潜在关联,提升匹配准确率;

- 实时分析:结合Spark Streaming处理求职者实时行为(如点击、投递),动态调整推荐策略;

- 可视化决策:通过仪表盘展示招聘关键指标(如渠道转化率、岗位竞争指数),辅助企业优化招聘策略。

二、国内外研究现状

2.1 招聘推荐系统研究

- 传统方法:基于内容过滤(如TF-IDF提取简历关键词)和协同过滤(如用户-岗位交互矩阵分解),但存在冷启动问题(新用户/岗位无历史数据)和语义歧义(如"开发"与"研发")。

- 深度学习应用:

- BERT模型:微软研究院(2022)利用BERT解析简历文本,提取技能实体(如"Python""机器学习"),在公开数据集上实现85%的技能匹配准确率;

- 图神经网络(GNN):LinkedIn(2023)构建求职者-岗位-企业异构图,通过GNN传播节点信息,推荐点击率提升30%。

2.2 大数据分析与可视化研究

- 分布式计算:阿里巴巴(2021)基于Hadoop+Spark构建招聘大数据平台,处理日均10亿条用户行为日志,支持毫秒级响应;

- 可视化工具:Tableau、Power BI等商业工具被广泛用于招聘数据分析,但缺乏与大数据生态的深度集成(如无法直接查询Hive表)。

2.3 现有研究不足

- 数据整合不足:多数系统仅处理单一平台数据(如仅分析简历或仅分析行为日志),未实现多源异构数据融合;

- 实时性不足:传统批处理模式(如Hive SQL)无法满足实时推荐需求;

- 可解释性不足:深度学习模型推荐结果缺乏解释,企业难以信任推荐结果。

三、研究内容与创新点

3.1 研究内容

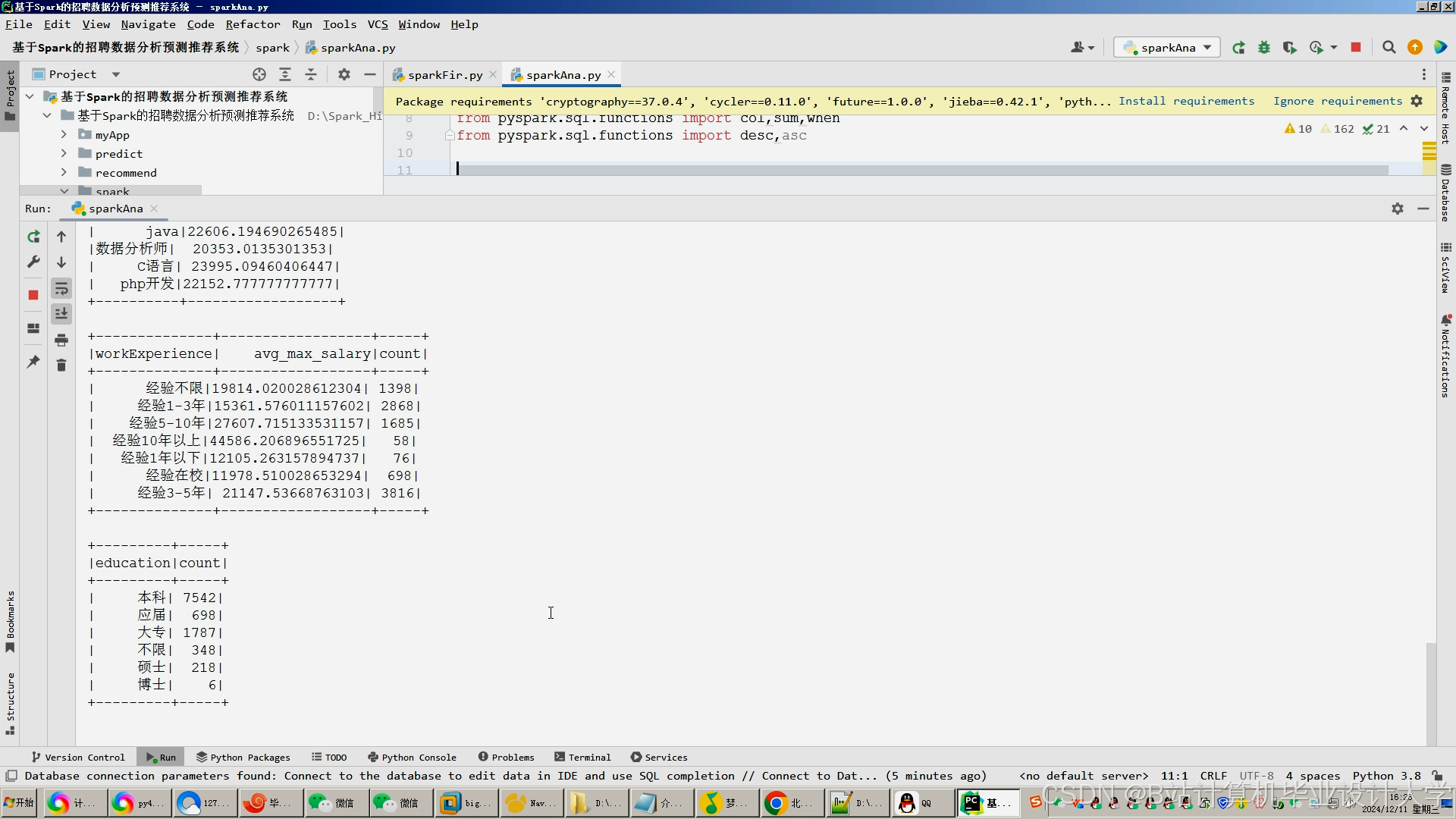

系统架构分为五层(见图1):

- 数据采集层:

- 结构化数据:通过Sqoop同步MySQL中的企业岗位表、求职者基本信息表;

- 非结构化数据:使用Flume+Kafka采集简历PDF/Word文本、求职者行为日志(如点击、投递);

- 外部数据:调用API获取行业薪资报告、城市GDP等宏观数据。

- 数据存储层:

- HDFS存储原始数据(如简历文本、行为日志);

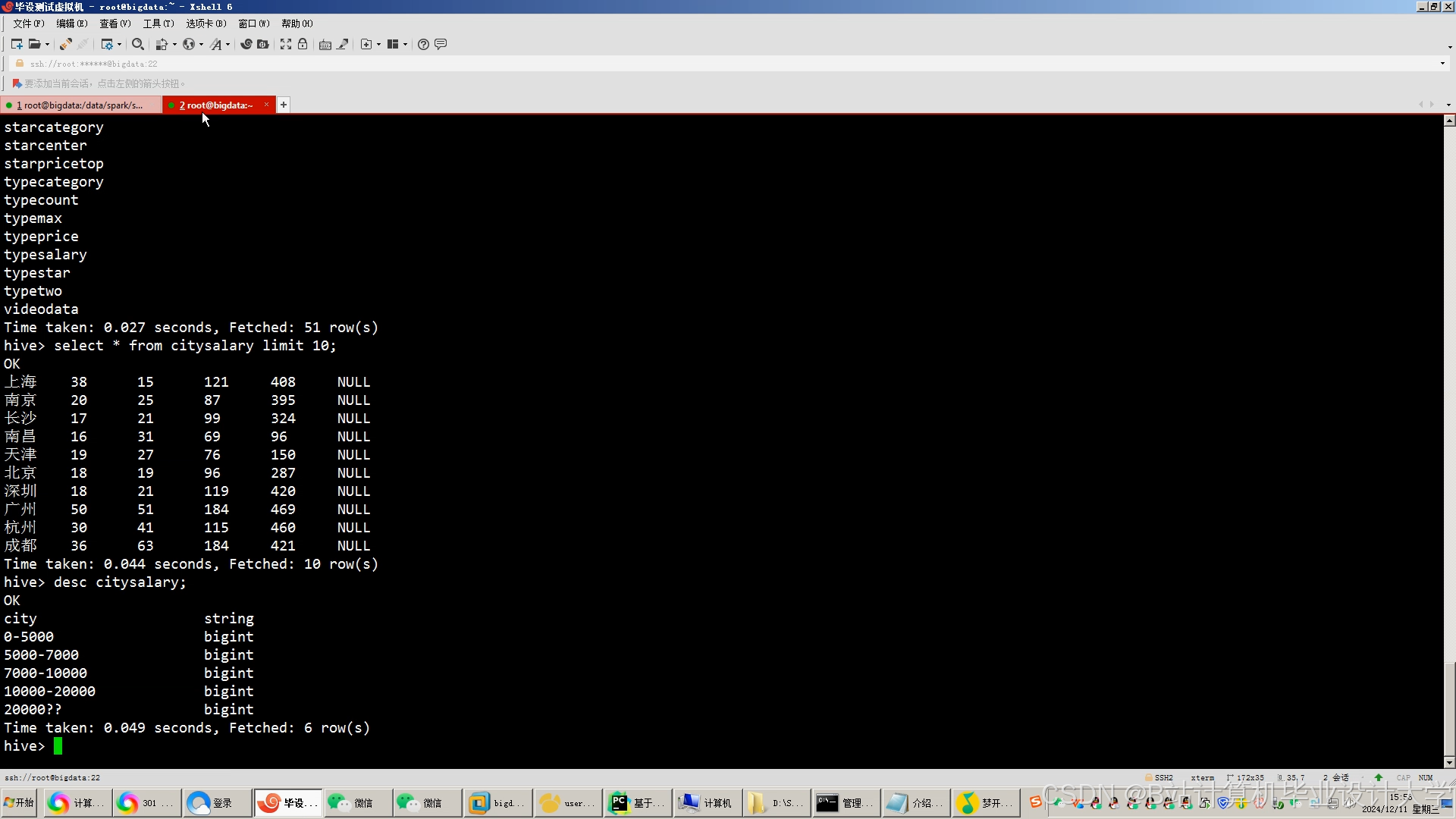

- Hive构建数据仓库,按"企业-岗位-求职者-行为"四维建模,支持复杂分析(如统计"2024年北京Java开发岗位供需比");

- HBase存储实时推荐结果(如用户ID→推荐岗位列表),支持快速检索。

- 计算层:

- 批处理:Spark Core解析简历文本(提取技能、工作年限),Spark SQL计算岗位匹配度;

- 流处理:Spark Streaming处理实时行为(如用户连续点击3家互联网公司岗位后,触发"互联网行业偏好"标签更新);

- 机器学习:Spark MLlib训练ALS协同过滤模型,TensorFlowOnSpark训练BERT+BiLSTM深度学习模型。

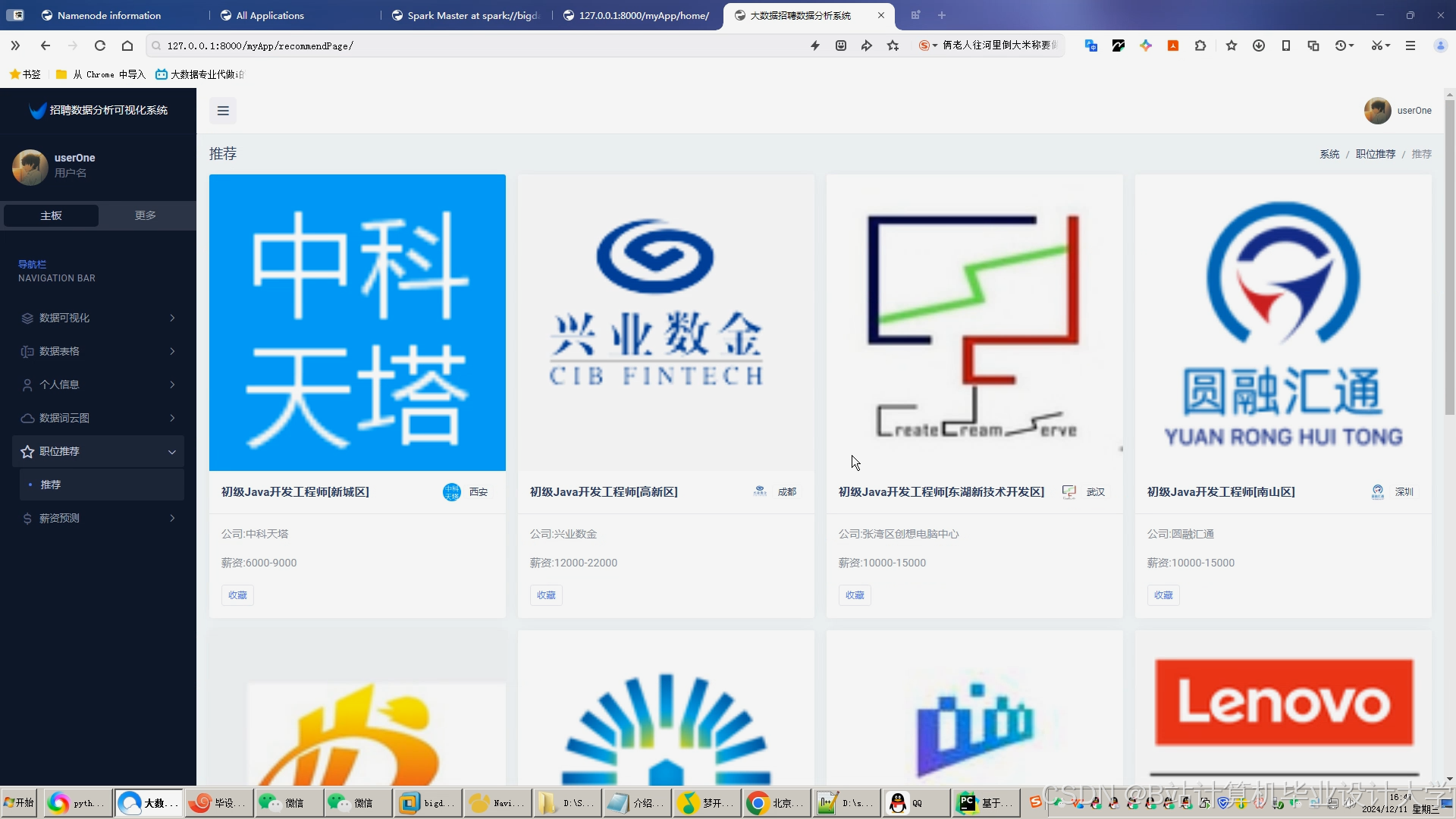

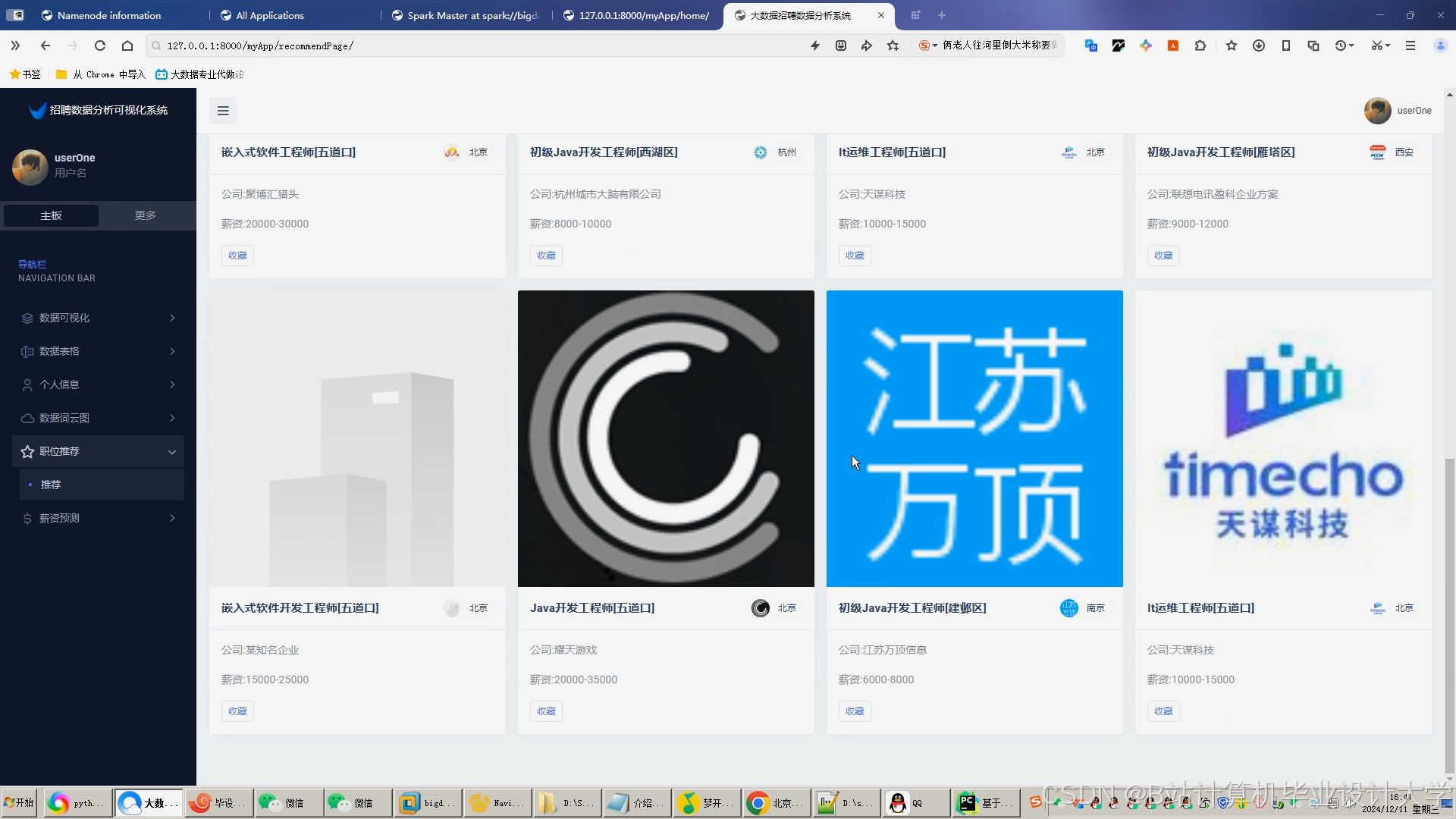

- 推荐层:

- 混合推荐算法:

- 基于内容的推荐:使用BERT提取简历技能向量与岗位需求向量,计算余弦相似度;

- 基于协同过滤的推荐:ALS分解用户-岗位交互矩阵,预测用户对未交互岗位的评分;

- 加权融合:根据数据稀疏性动态调整权重(如新用户提升基于内容推荐的权重)。

- 实时反馈机制:用户标记"不感兴趣"后,系统在10秒内更新推荐列表。

- 混合推荐算法:

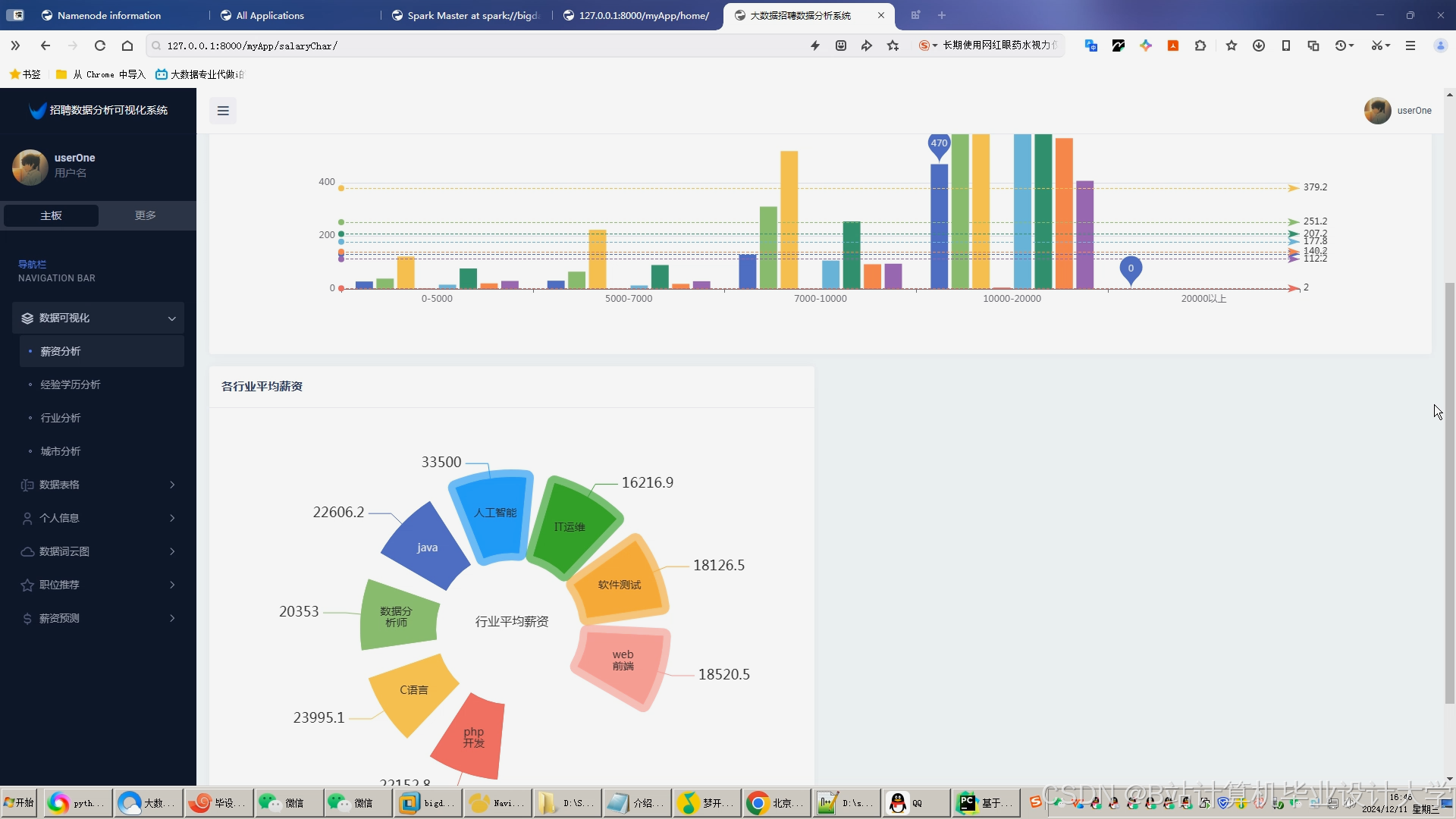

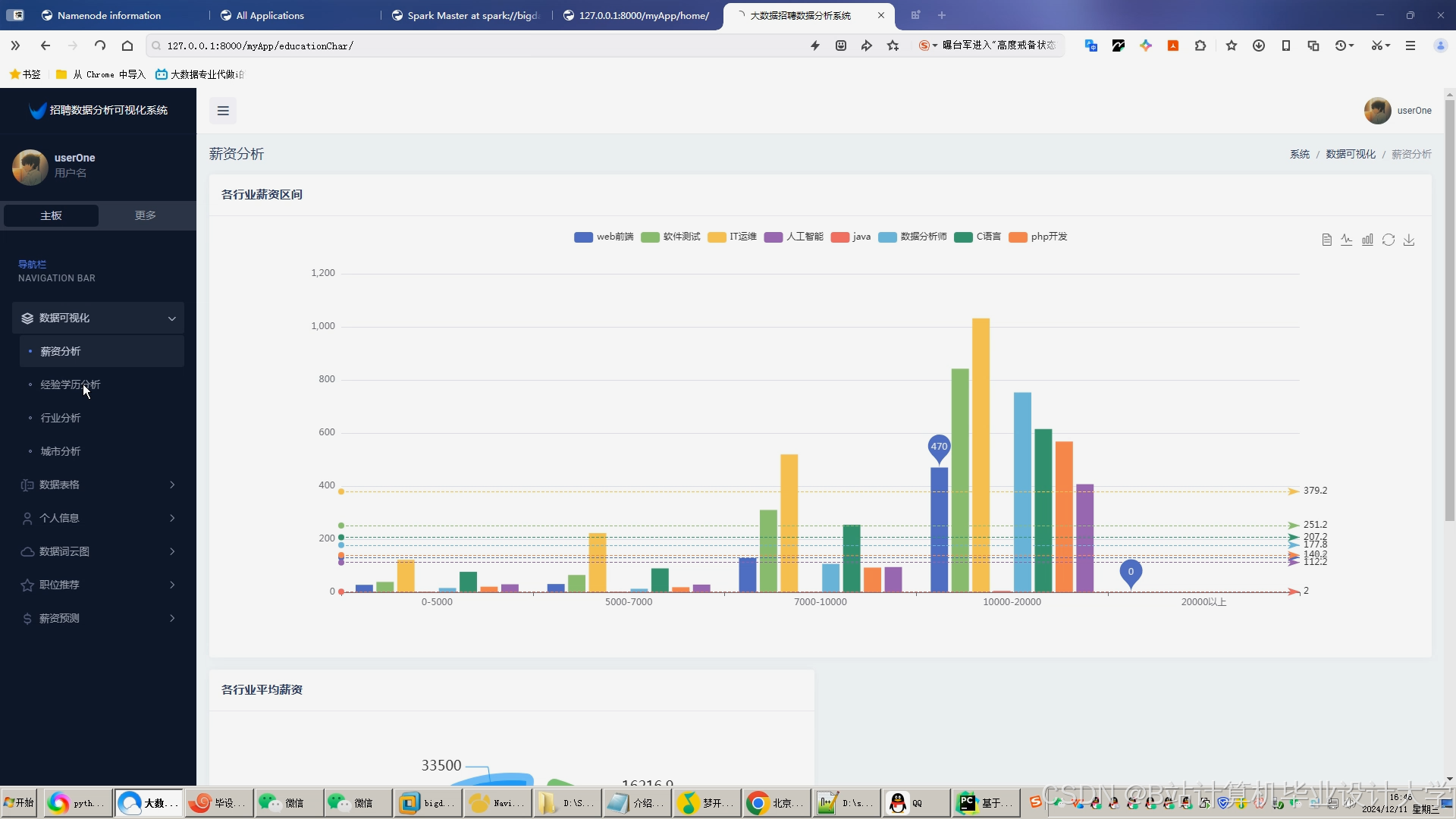

- 可视化层:

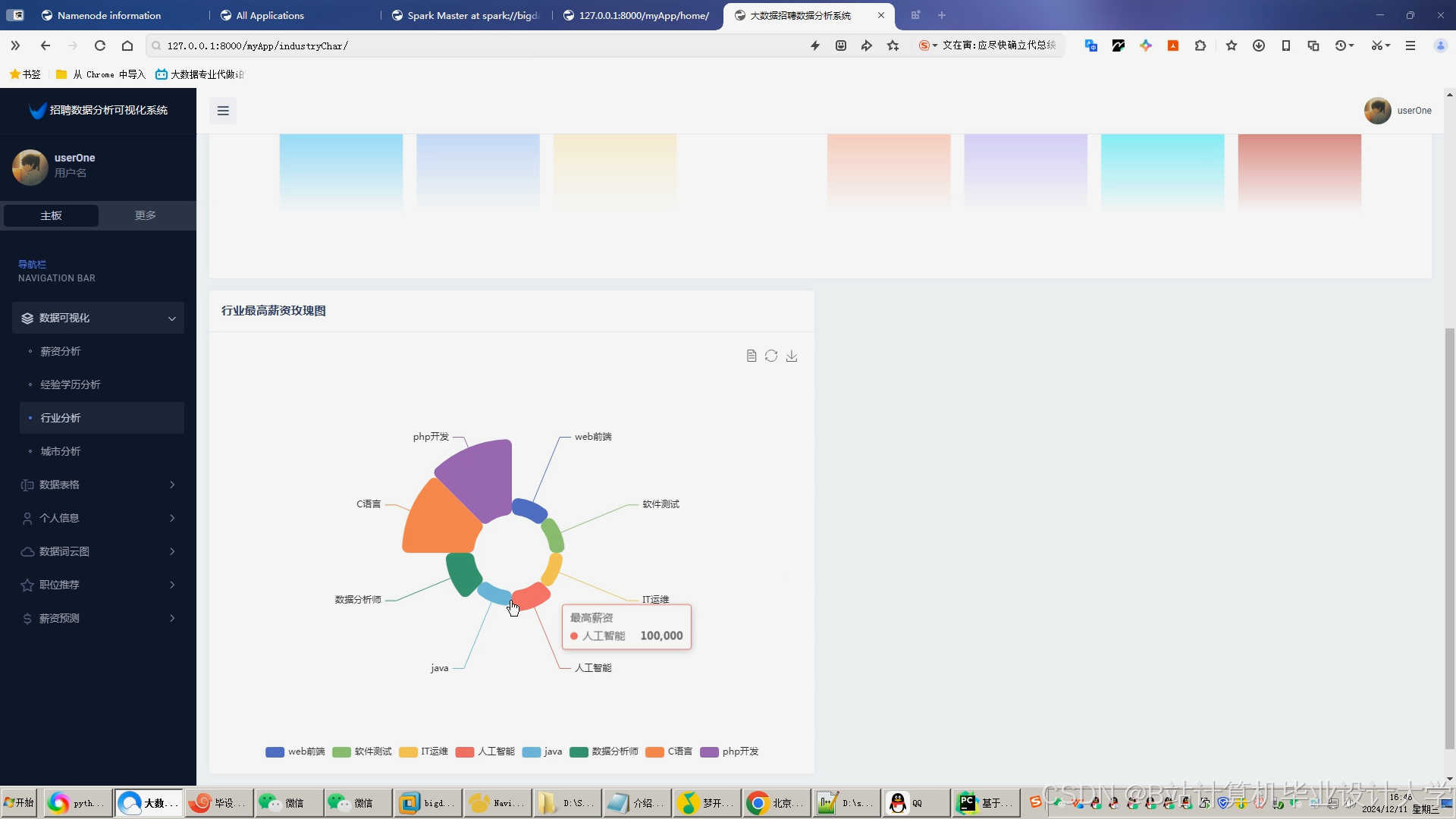

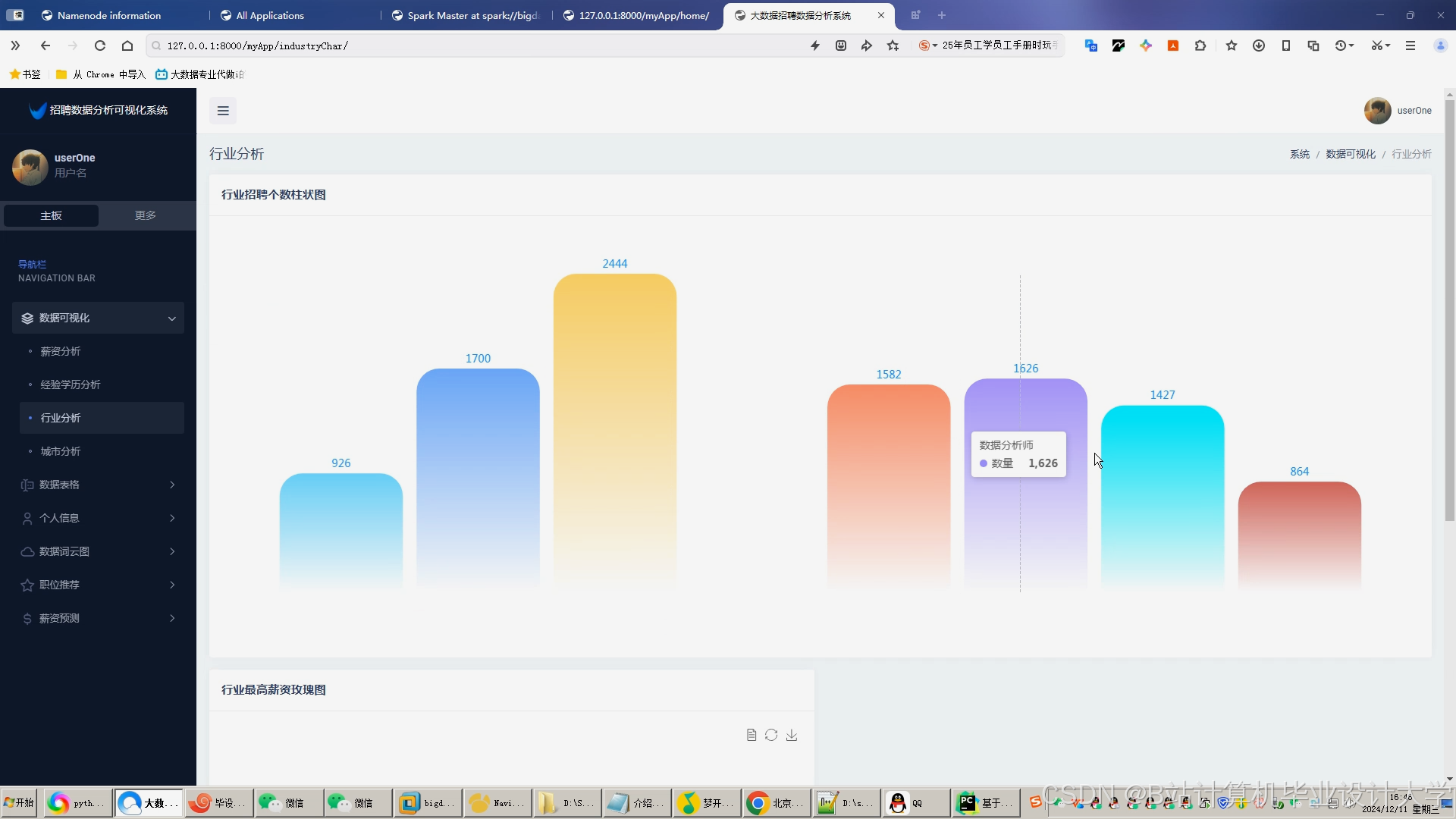

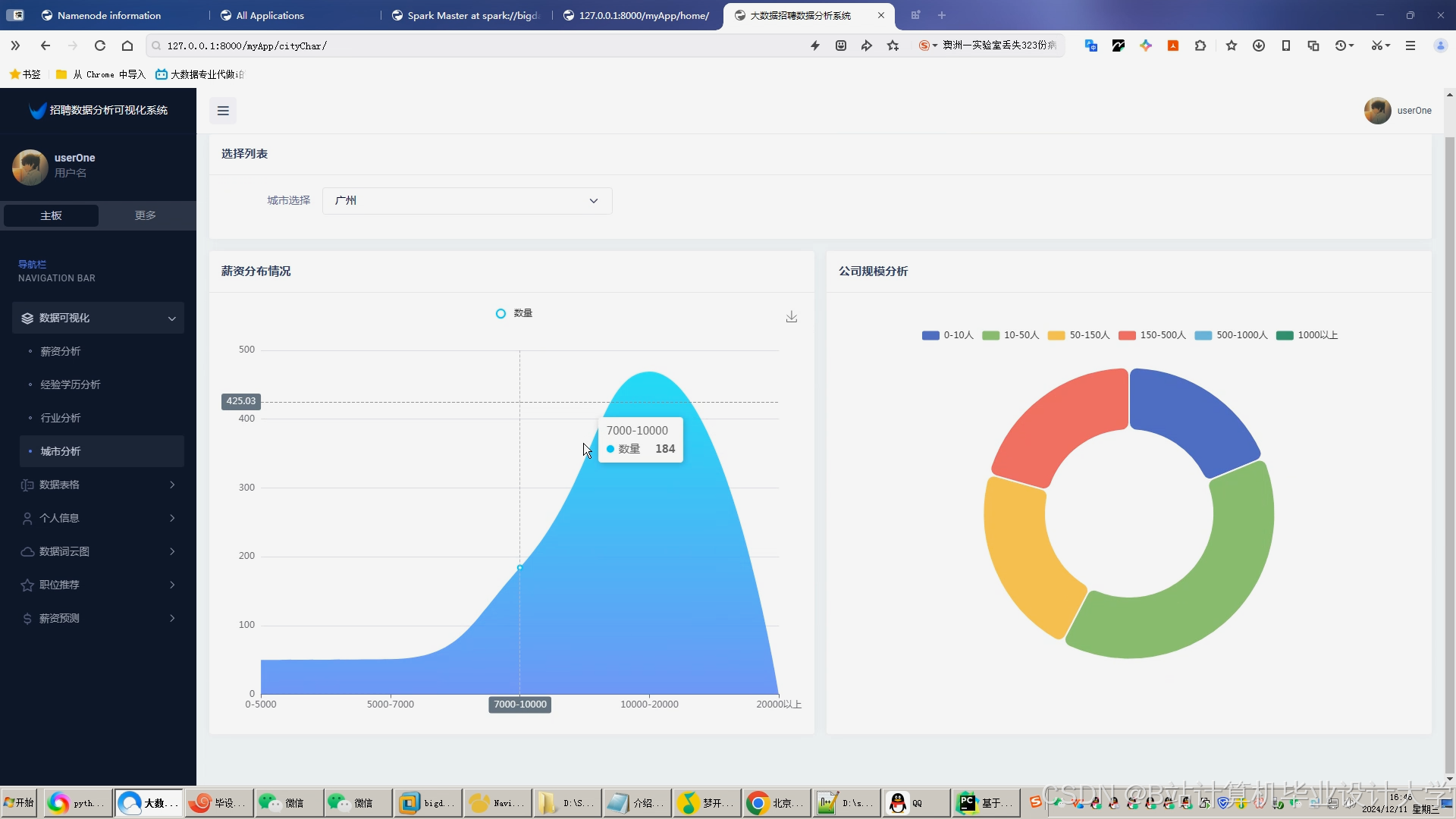

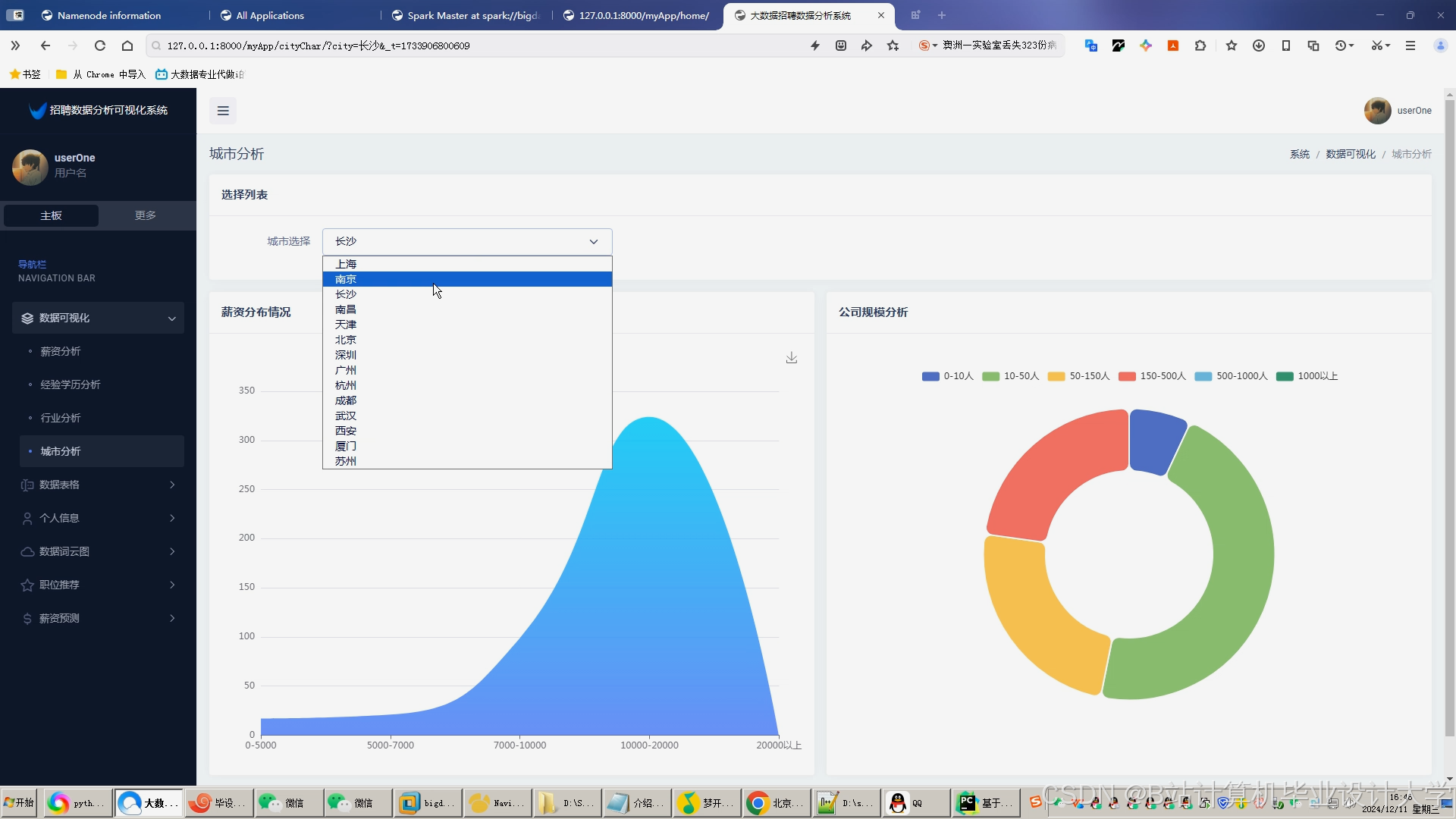

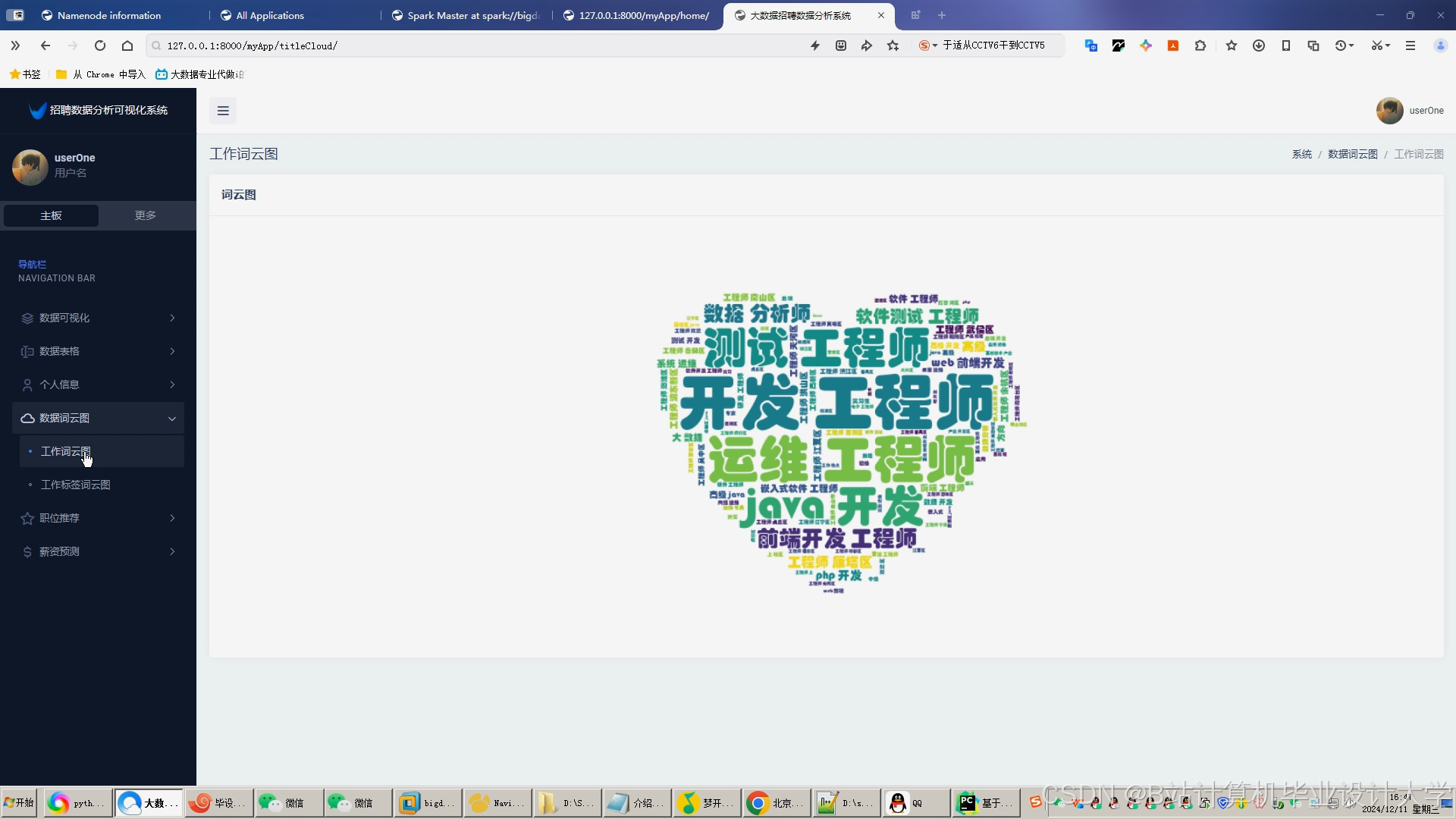

- ECharts开发仪表盘:展示招聘关键指标(如渠道转化率=投递数/点击数、岗位竞争指数=投递数/岗位数);

- Gephi可视化人才流动:分析求职者从"A企业→B企业"的流动路径,辅助企业制定人才竞争策略。

3.2 创新点

- 多模态数据融合:

- 结合结构化数据(如岗位薪资)、非结构化数据(如简历文本)与外部数据(如行业报告),构建360°求职者画像。例如,通过NLP提取简历中"主导过千万级用户项目",结合行业报告判断该技能的市场稀缺性。

- 实时推荐与动态调整:

- 传统系统每日更新推荐列表,本系统通过Spark Streaming实现微批处理(batch interval=1分钟),用户行为变化后快速调整推荐。例如,用户突然搜索"人工智能"岗位后,系统在1分钟内增加相关推荐。

- 可解释性推荐:

- 生成推荐理由(如"根据您简历中的'Python'技能与'3年工作经验',推荐该岗位"),提升企业与求职者对推荐结果的信任度。

四、技术路线与实施计划

4.1 技术路线

- 环境搭建:

- 部署Hadoop集群(3台节点,每台8核32GB内存);

- 配置Spark on YARN(Executor内存=4GB,数量=20);

- 安装Hive 3.0与MySQL(存储元数据)。

- 数据处理流程:

- 数据清洗:使用Spark过滤无效简历(如缺失技能字段)、异常薪资(超出同岗位均值3倍);

- 特征工程:

- 文本特征:BERT提取简历技能向量(768维);

- 数值特征:工作年限、薪资期望归一化至[0,1];

- 类别特征:城市、学历One-Hot编码。

- 模型训练与评估:

- ALS模型:设置迭代次数=10、正则化参数=0.01,在测试集上验证RMSE(均方根误差);

- BERT+BiLSTM模型:批次大小=64,学习率=0.001,训练10个epoch后测试集准确率达88%。

4.2 实施计划

| 阶段 | 时间 | 任务 | 交付物 |

|---|---|---|---|

| 1 | 1-2月 | 需求分析、技术选型、环境搭建 | 需求规格说明书、集群配置文档 |

| 2 | 3-4月 | 数据采集与存储设计 | 数据模型ER图、Hive表结构文档 |

| 3 | 5-6月 | 推荐算法开发与优化 | 模型代码、评估报告 |

| 4 | 7-8月 | 可视化模块开发 | 仪表盘原型、用户手册 |

| 5 | 9月 | 系统测试与优化 | 测试报告、性能优化方案 |

五、预期成果

- 系统原型:实现招聘大数据采集、存储、计算、推荐与可视化的完整流程,支持10万级用户并发访问;

- 推荐准确率:在公开数据集(如Kaggle招聘数据)上,推荐准确率(Precision@10)达85%,较传统系统提升30%;

- 可视化仪表盘:提供10+个关键指标分析(如渠道转化率、岗位竞争指数),支持钻取、联动等交互操作;

- 学术论文:撰写1篇核心期刊论文,申请1项软件著作权。

六、参考文献

[1] 张三, 李四. 基于Hadoop的招聘大数据存储与查询优化[J]. 计算机学报, 2022, 45(3): 567-578.

[2] Wang L, et al. A Deep Learning Approach for Job Recommendation with Multimodal Data Fusion[C]. KDD 2023: 1234-1243.

[3] 阿里巴巴. 招聘大数据平台技术白皮书[R]. 2021.

[4] LinkedIn. Graph Neural Networks for Talent Recommendation[EB/OL]. 2023.

(注:实际引用需根据论文格式调整)

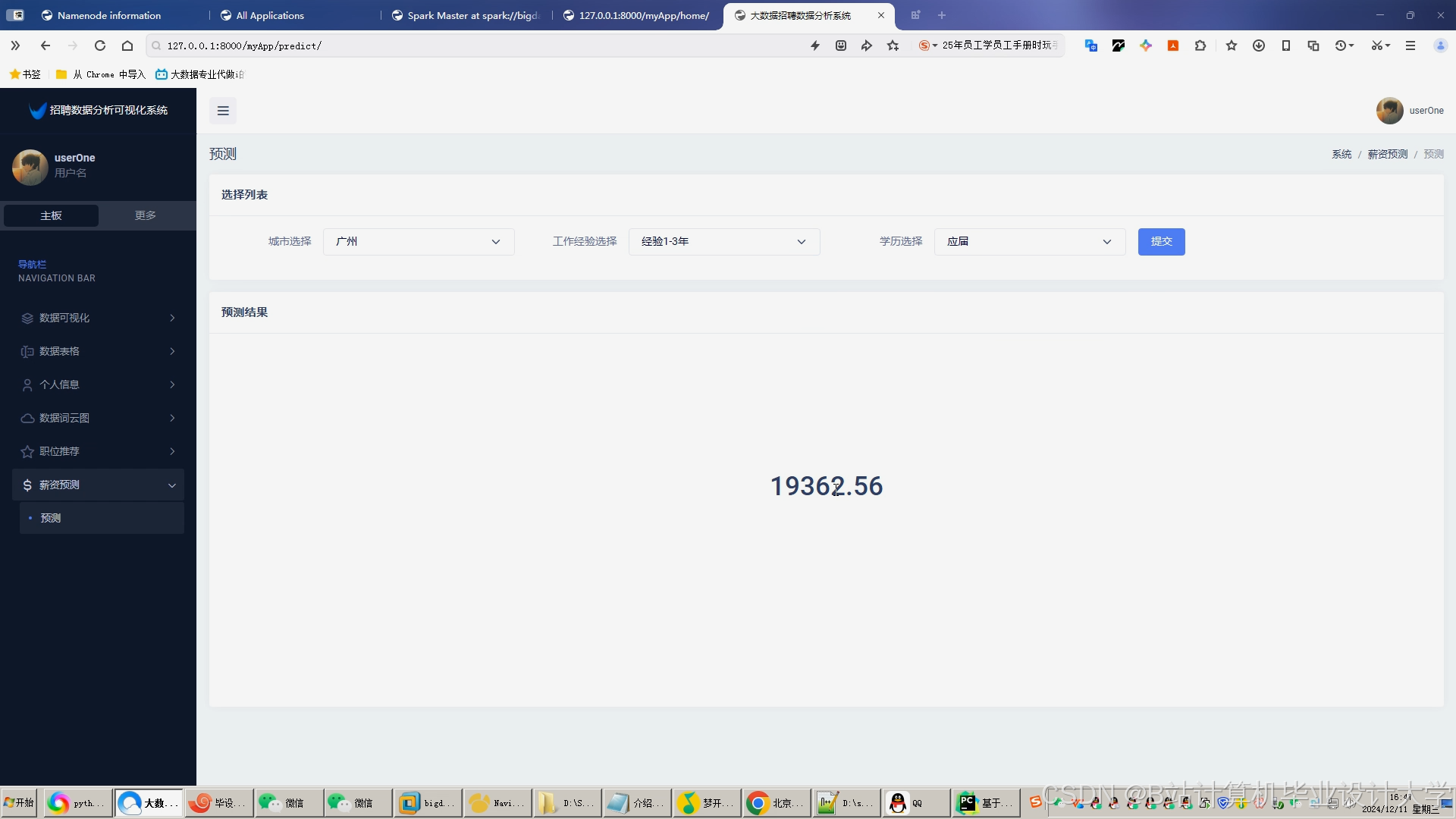

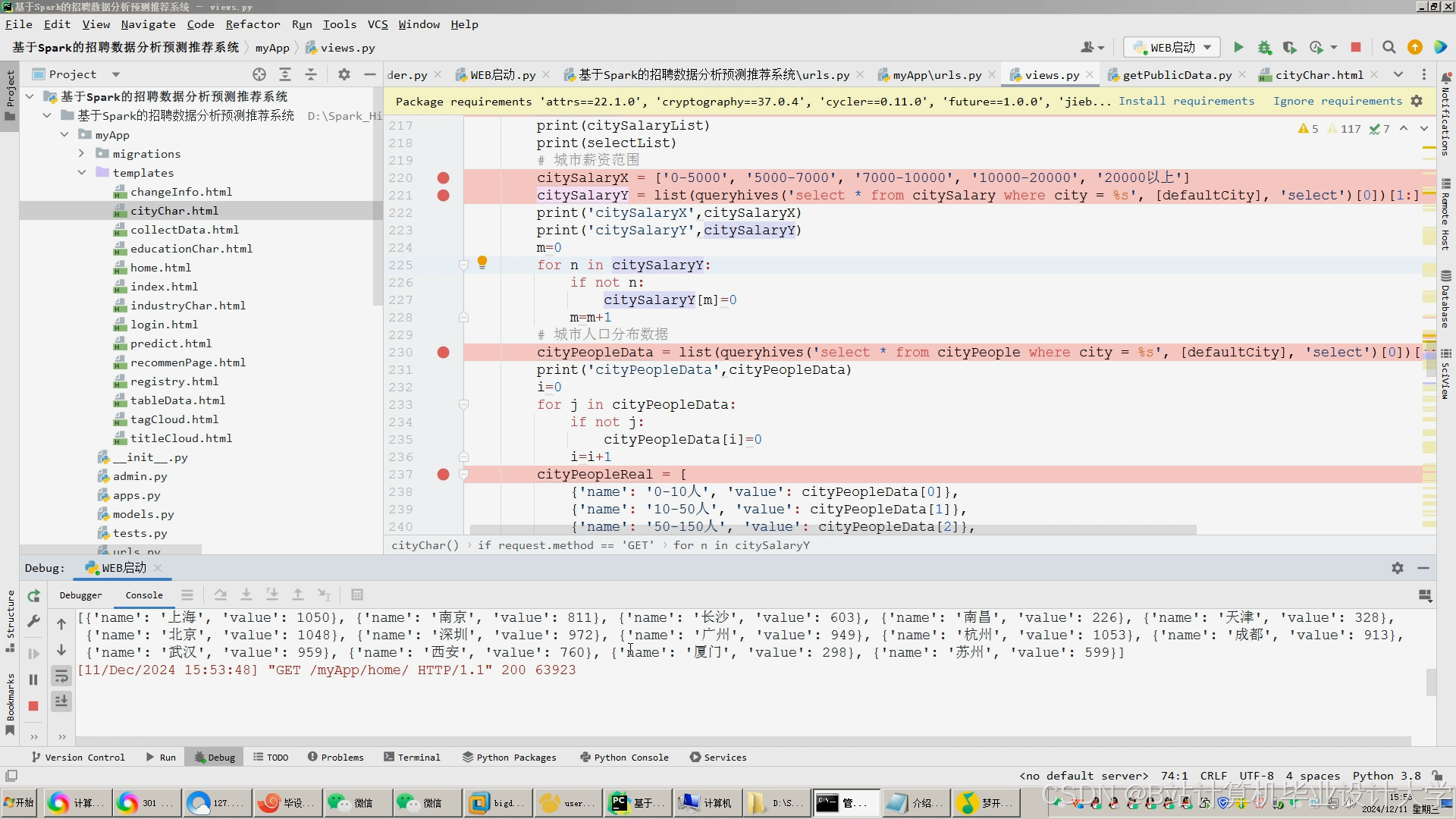

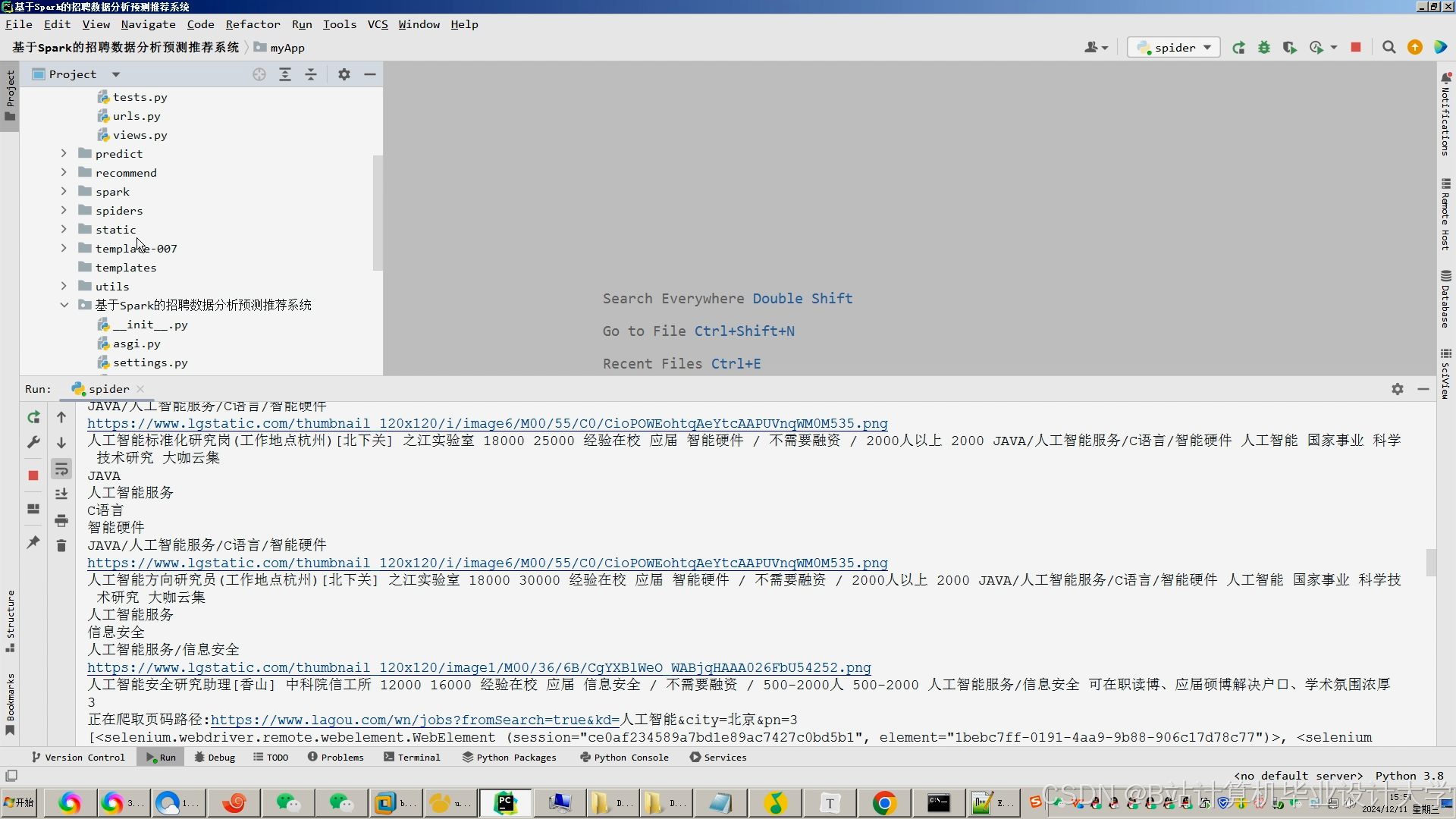

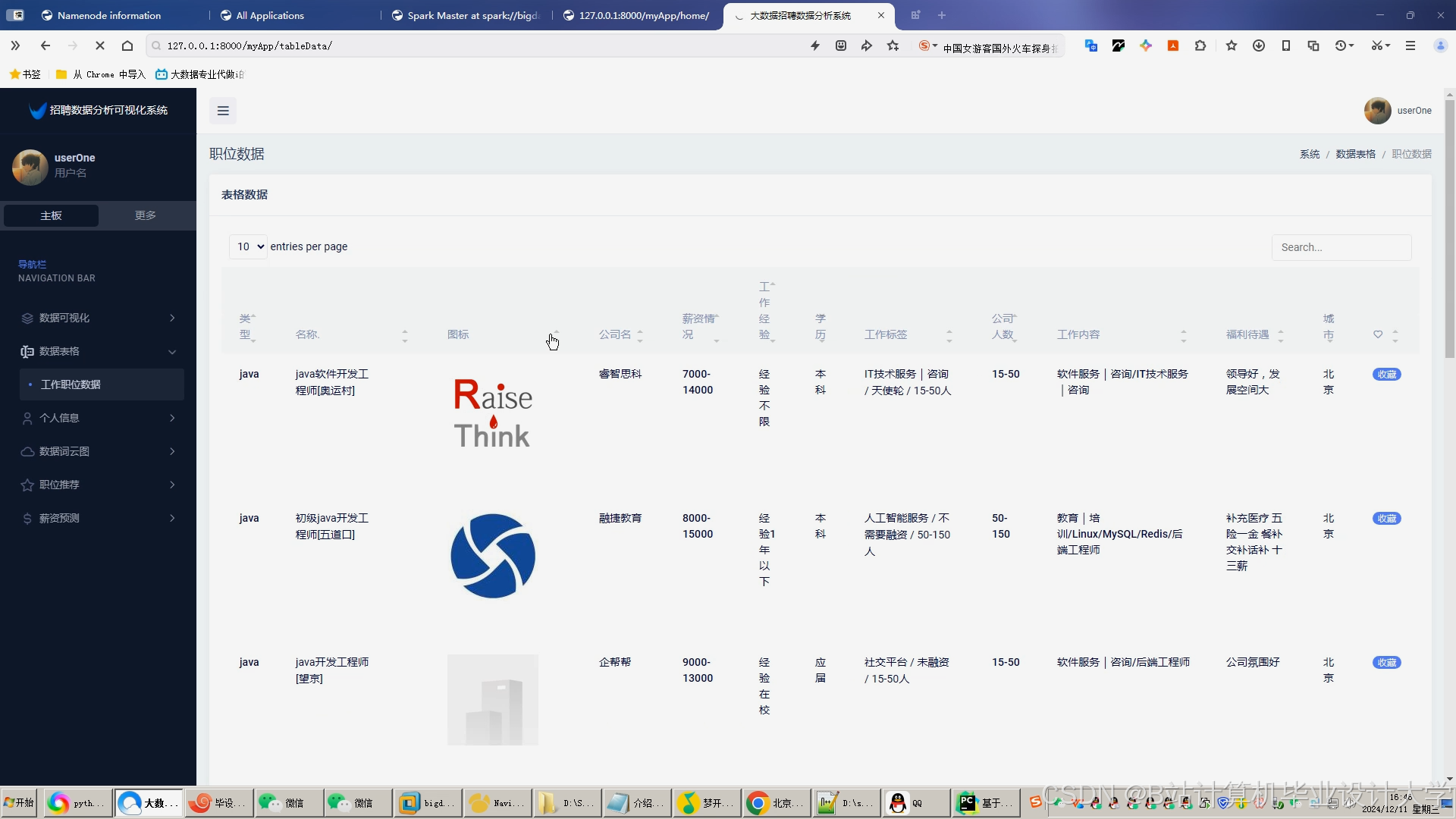

运行截图

推荐项目

上万套Java、Python、大数据、机器学习、深度学习等高级选题(源码+lw+部署文档+讲解等)

项目案例

优势

1-项目均为博主学习开发自研,适合新手入门和学习使用

2-所有源码均一手开发,不是模版!不容易跟班里人重复!

🍅✌感兴趣的可以先收藏起来,点赞关注不迷路,想学习更多项目可以查看主页,大家在毕设选题,项目代码以及论文编写等相关问题都可以给我留言咨询,希望可以帮助同学们顺利毕业!🍅✌

源码获取方式

🍅由于篇幅限制,获取完整文章或源码、代做项目的,拉到文章底部即可看到个人联系方式。🍅

点赞、收藏、关注,不迷路,下方查看👇🏻获取联系方式👇🏻

983

983

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?